2026年2月,亚马逊向全体工程团队下达了一纸"禁令":禁止使用Anthropic旗下顶级编程助手Claude Code ,要求所有开发者立即切换至亚马逊自研AI工具体系(Titan系列 + Bedrock内部版)。

这一决定,在亚马逊身为Anthropic最大外部投资方之一的背景下,显得格外刺眼。它不仅揭开了云巨头在AI时代"投资卡位 + 自研闭环"的深层战略,更将"效率 vs 安全""开放 vs 主权"的行业级矛盾推到了台前。

今天,我们从事件细节、技术对比、战略逻辑到行业启示,全方位拆解这场"内部禁令"的来龙去脉。

一、禁令落地:数据安全与知识产权的"硬核"理由

亚马逊官方给出的理由非常直接:

- 核心代码与工程流程不得流出外部模型服务器

- 避免知识产权泄露风险

- 防止敏感电商、物流、云服务数据被外部AI训练

内部邮件明确要求:所有使用Claude Code的历史对话、生成的代码片段,必须在规定时间内迁移或删除。

二、工程师"用脚投票":Claude Code到底有多强?

禁令一出,内部摩擦立即显现。多名资深工程师在匿名论坛和内部Slack中直言:

- Claude Code在复杂系统调试、遗留代码重构、大型架构设计 上的表现,远超当前亚马逊自研替代方案。

- 其200K+长上下文理解、多Agent协同编码、自动生成测试用例与文档能力,让开发周期缩短30%-50%。

- 强制切换后,不少团队反馈交付周期延长、Bug率上升,部分工程师甚至开始"偷偷"使用。

更讽刺的是:Claude至今仍是AWS Bedrock平台上向全球企业客户公开售卖的标准服务之一 。对内禁用、对外赚钱的双标,已被内部吐槽为"最懂AI的云厂商,却最怕用AI"。

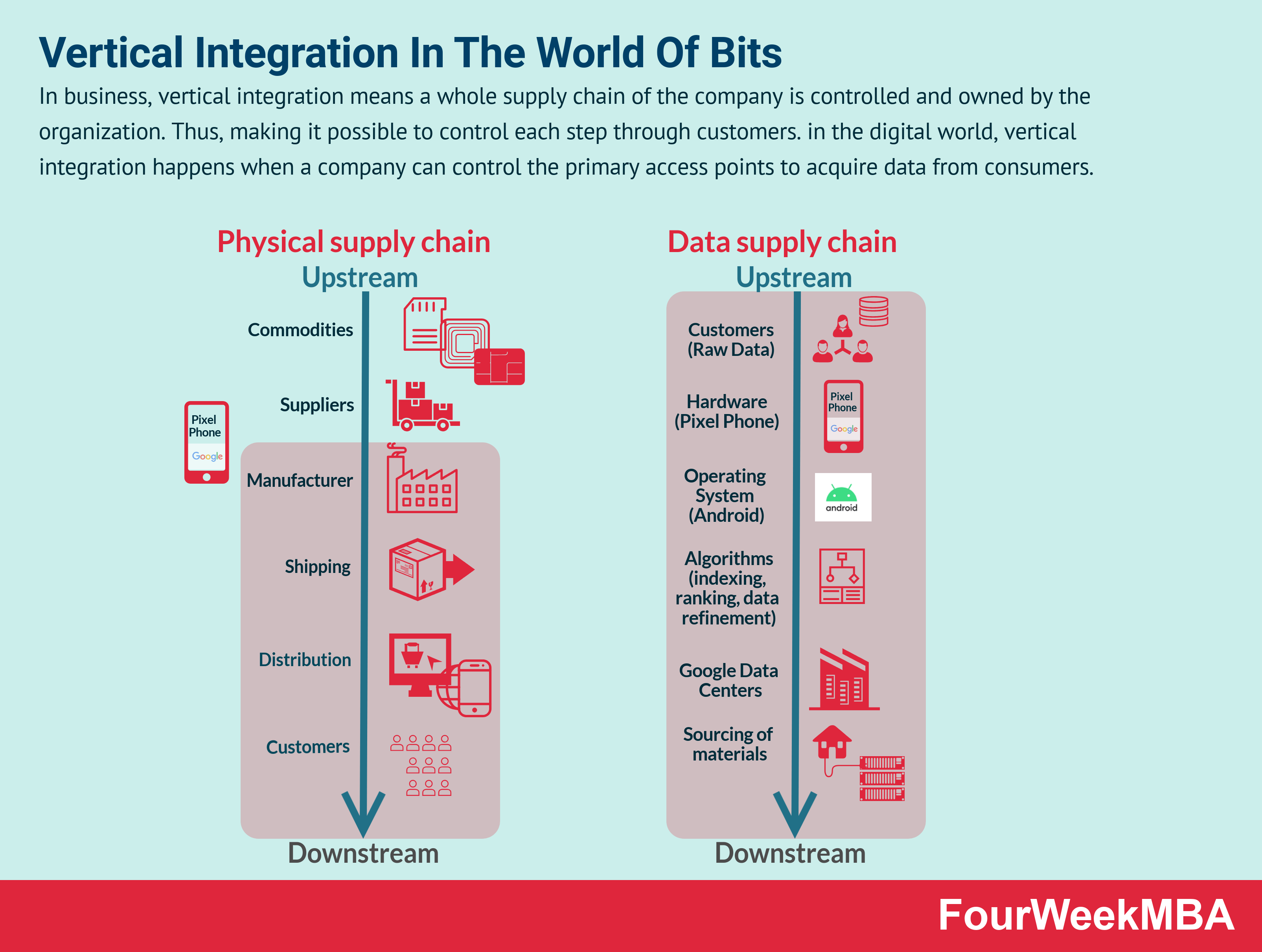

三、亚马逊AI战略全貌:全栈垂直整合的"封闭花园"

这场禁令并非一时冲动,而是亚马逊2026年AI主权战略的核心落地。

亚马逊的长期逻辑清晰可见:

关键布局包括:

- 自研芯片 :Trainium2(训练)、Inferentia3(推理),单卡性价比远超NVIDIA A100/H100。

- 超算集群 :Project Rainier等10万卡级AI训练集群。

- 自研模型 :Titan系列 + 内部增强版,强制数十万工程师真实使用,形成高质量反馈闭环。

- 数据主权 :所有核心数据(电商交易、物流路径、客户行为)严禁流出AWS生态。

通过"用资本换时间、用封闭换主权",亚马逊希望在不依赖外部前沿模型的前提下,快速缩小能力差距,同时将核心数据与技术壁垒牢牢锁在自家生态内。

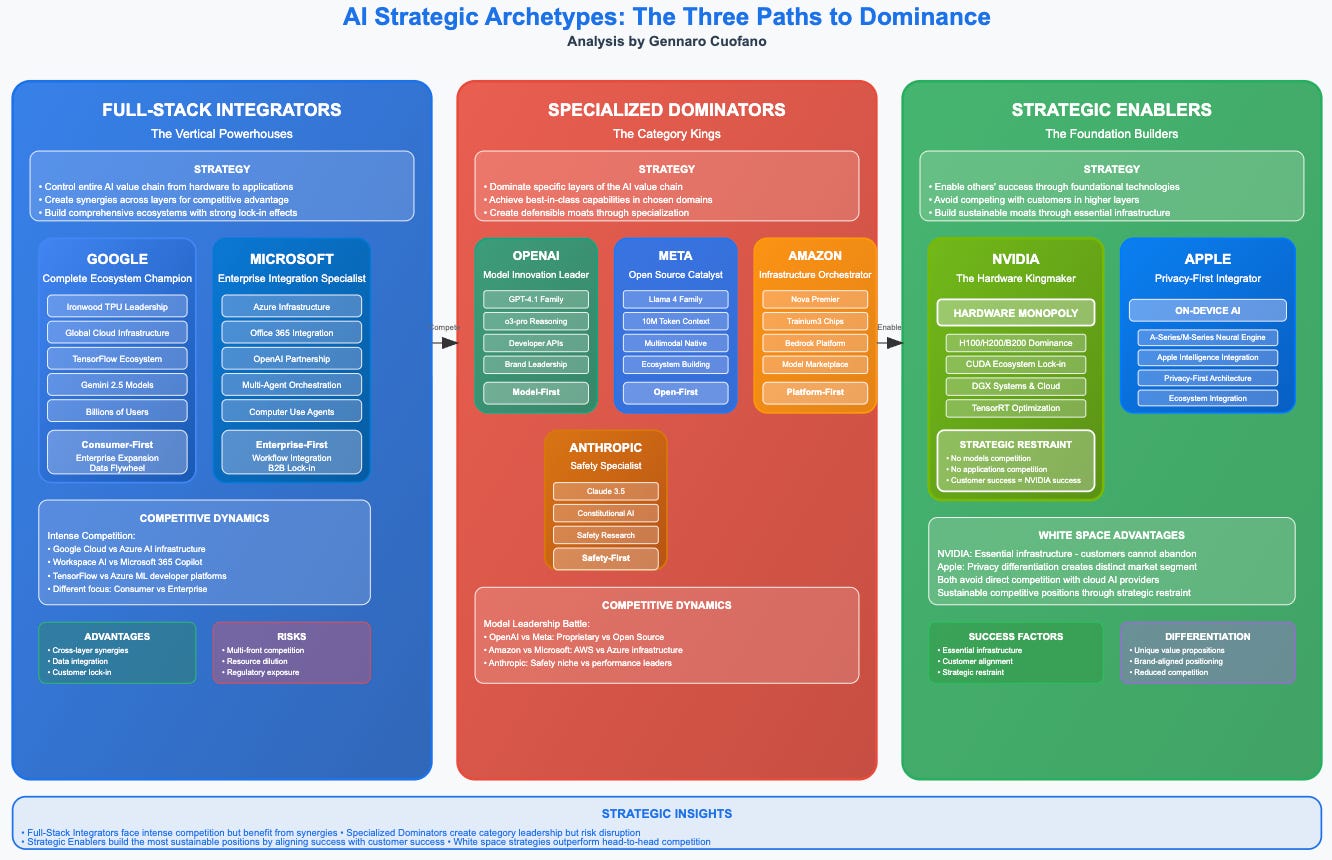

四、投资与自研的"既合作又对抗"博弈

亚马逊的AI布局充满矛盾美学:

这种"左手投资、右手筑墙"的姿态,已成为2026年科技巨头的生存共识:

- 对外开放 → 赚取基础设施租金(AWS Bedrock售卖Claude)

- 对内封闭 → 保护核心数据与长期壁垒

The Strategic Map of AI - by Gennaro Cuofano

五、行业共同难题:效率与安全的永恒拉锯战

亚马逊不是孤例。

微软(Copilot vs Azure OpenAI)、谷歌(Gemini内部优先 vs Vertex AI)、Meta(Llama开放 vs 内部闭环)都在面临同样的悖论:

亚马逊以"安全"为由强推自研,本质是把内部工具升级为战略资产 。但最终成败,只取决于一个硬指标------自研模型能否在6-12个月内真正满足工程师的真实生产力需求。

如果差距持续存在,亚马逊追求AI主权的代价,可能正是它最害怕失去的:顶尖技术人才与创新速度。

写在最后:2026,AI工具已成"战略核武器"

这场亚马逊内部禁令,只是AI竞赛进入"主权时代"的一个缩影。

对开发者而言:你更愿意在"安全但稍慢"的封闭生态中工作,还是"强大但有风险"的开放工具中冲刺?

对云巨头而言:究竟是继续"投资+借力",还是彻底"All in自研闭环"?

欢迎在评论区分享你的看法------你是支持亚马逊的"主权优先",还是更看好Anthropic/Claude Code的极致生产力?

AI竞赛的下一站,已不再是单纯的模型参数之争,而是谁能真正掌控自己的AI工具链。

(数据与案例来源于亚马逊官方声明、内部员工反馈、AWS Bedrock文档及行业公开报告,图片为相关技术可视化与场景示意)

你准备好迎接"自研AI工具"全面普及的时代了吗?🚀