📝 文本分类常见面试篇:从 fastText 到 TextCNN 的核心考点全解析

------NLP 入门必考基石,系统梳理经典模型与工程调优策略

作者 :石去皿|标签 :#NLP #文本分类 #fastText #TextCNN #面试宝典

更新时间:2026 年 2 月

🔖 前言:为什么文本分类是 NLP 面试的"守门员"?

文本分类(Text Classification)是自然语言处理中最基础、最经典的监督学习任务。无论是工业界的风控审核、客服意图识别,还是学术界的情感分析、主题建模,其核心逻辑都离不开分类。

💡 面试核心认知 :

面试官考察文本分类,不仅是为了测试你对经典模型(fastText/TextCNN)的理解,更是为了考察你的工程落地能力------如何处理不平衡数据?如何调参?如何选择评估指标?

🔹 一、应用场景与任务类型(业务视角)

1.1 常见应用场景

文本分类无处不在,面试中建议按业务价值分类阐述:

| 业务领域 | 典型场景 | 核心价值 |

|---|---|---|

| 内容理解 | 新闻分类、主题聚类、垃圾邮件识别 | 信息结构化、降低噪音 |

| 用户意图 | 客服意图识别、问答匹配、搜索 Query 分类 | 提升转化率、精准服务 |

| 风控安全 | 舆情情感分析、违禁内容识别、欺诈检测 | 规避风险、品牌保护 |

| 辅助决策 | 医疗病历分类、法律文书推断、简历筛选 | 效率提升、辅助人工 |

1.2 任务类型划分

根据标签体系的不同,需明确区分以下三类(面试易混点):

- 二分类 (Binary):如 情感正/负、垃圾/非垃圾。

- 多分类 (Multi-class):如 新闻类别(体育/财经/娱乐),样本属于且仅属于一个类别。

- 多标签 (Multi-label):如 文章打标(#AI #科技 #互联网),样本可同时属于多个类别。

🔹 二、文本分类的标准流程(工程 pipeline)

经典的文本分类 Pipeline 包含四个核心步骤,面试时可结合具体工具说明:

text

【Step 1: 文本预处理】

• 清洗:去除 HTML 标签、特殊符号、停用词

• 分词:中文需分词 (jieba / HanLP / LTP / pkuseg),英文可 tokenize

• 标准化:全角转半角、繁转简、大小写统一

▼

【Step 2: 特征提取 / 文本表示】

• 传统方法:TF-IDF、Bag-of-Words (Bow)

• 静态嵌入:Word2Vec、GloVe、FastText 词向量

• 动态嵌入:BERT、RoBERTa 上下文向量 (现代主流)

▼

【Step 3: 分类模型】

• 机器学习:LR、SVM、Naive Bayes

• 深度学习:fastText、TextCNN、TextRNN、BERT

▼

【Step 4: 输出与评估】

• 输出:类别概率分布

• 评估:Accuracy、F1、AUC 等✅ 面试话术:

"虽然预训练模型效果更强,但在数据量小、 latency 要求高的场景,预处理 + 静态词向量 + 轻量模型 仍是高性价比方案。"

🔹 三、fastText:轻量级分类基石

3.1 核心分类过程

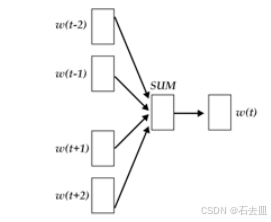

fastText 的结构极其简单高效,本质是 Bag of Embeddings + Linear Classifier:

- 输入层:将输入文本转化为词向量(可预训练或随机初始化)。

- 表示层 :对所有词向量取平均(Average),得到句子向量。

- 输出层 :经过线性变换 + Softmax/Hierarchical Softmax 得到类别概率。

3.2 为什么 fastText 这么快?(高频考点)

| 优化技术 | 原理说明 | 收益 |

|---|---|---|

| Hierarchical Softmax | 将扁平 Softmax 改为霍夫曼树结构,复杂度从 O(N) 降为 O(log N) | 大幅加速输出层计算 |

| N-gram 特征 | 引入字符级 n-gram 作为附加特征 | 解决 OOV(未登录词)问题,捕捉局部语序信息 |

| 异步 SGD | 多线程并行更新参数 | 充分利用 CPU 多核资源 |

3.3 优缺点总结

markdown

✅ 优点:

• 训练/测试速度极快,适合海量数据基线

• 无需预训练词向量,可端到端训练

• 对 OOV 词友好(得益于 char-level n-gram)

❌ 缺点:

• 忽略词序信息(Bag-of-Words 本质),无法捕捉长距离依赖

• 语义表达能力弱于 CNN/RNN/Transformer🔹 四、TextCNN:捕捉局部语义特征

4.1 核心分类过程

TextCNN 的核心思想是利用卷积核捕捉局部特征(类似 N-gram),并通过池化获得定长表示。

text

【输入层】

• 矩阵形状:(Sentence_Length, Embedding_Dim)

• 双通道策略 (可选):

- 通道 1:预训练词向量 (静态,不更新)

- 通道 2:随机初始化向量 (动态,随训练更新)

▼

【卷积层】

• 一维卷积:filter_size 通常为 (2, 3, 4),类似 2-gram, 3-gram, 4-gram

• 多通道输出:每个 filter_size 可设多个输出 channel

▼

【池化层】

• 1-max pooling:每个 filter 取最大值,将变长句子转为定长特征

• 优势:捕捉句子中"最显著"的特征,忽略位置信息

▼

【输出层】

• 全连接 + Dropout + Softmax4.2 关键参数调优指南(工程干货)

面试中被问到"TextCNN 怎么调参",可直接参考以下经验值:

| 参数项 | 建议范围/策略 | 调优逻辑 |

|---|---|---|

| 词向量来源 | Word2Vec / GloVe / BERT | 数据少用预训练,数据大可随机初始化 |

| 卷积核大小 | 1 ~ 10 (常用 2,3,4 组合) | 短句用小核,长句可尝试大核;组合核效果优于单核 |

| Feature Maps | 100 ~ 600 | 越多特征越强,但训练越慢;性能下降时需加强正则 |

| 激活函数 | ReLU / Tanh | ReLU 收敛更快,Tanh 有时泛化更好 |

| 池化策略 | 1-max pooling (首选) | 复杂任务可尝试 k-max pooling 保留更多特征 |

| 正则化 | Dropout (<0.5) / L2 | CNN 参数正则作用有限,建议小 Dropout + 大 L2 |

✅ 面试加分点:

"在实际项目中,我发现多尺寸卷积核组合(如 [2,3,4])通常比单一最佳尺寸效果更好,因为它能同时捕捉短语和句法片段信息。"

🔹 五、评估指标:如何选择正确的尺子?

单纯看"准确率"是面试大忌,需根据数据分布选择指标:

| 指标 | 公式/含义 | 适用场景 | 陷阱 |

|---|---|---|---|

| Accuracy (准确率) | 预测正确数 / 总数 | 类别平衡数据集 | 类别不平衡时失效(如 99% 负样本,全猜负也有 99% 准确率) |

| Precision (查准率) | TP / (TP+FP) | 关注"宁缺毋滥"(如风控) | 忽略漏报 |

| Recall (查全率) | TP / (TP+FN) | 关注"宁错杀不放过"(如疾病筛查) | 忽略误报 |

| F1-Score | 2 * P * R / (P+R) | 类别不平衡,需兼顾查准查全 | 最常用综合指标 |

| ROC / AUC | 真阳性率 vs 假阳性率 | 评估模型排序能力,对阈值不敏感 | 计算成本高,适合二分类 |

| 混淆矩阵 | TP/TN/FP/FN 分布表 | 分析具体错分类别 | 直观展示错误类型 |

💡 高频追问 :类别不平衡怎么处理?

→ 1. 数据层:过采样 (SMOTE) / 欠采样;2. 算法层:Focal Loss / 加权 CrossEntropy;3. 评估层:放弃 Accuracy,改用 F1 或 AUC。

🔹 六、模型对比与演进(面试扩展)

为了体现技术视野,建议准备一份模型对比表:

| 模型 | 特征提取能力 | 训练速度 | 推理速度 | 适用场景 |

|---|---|---|---|---|

| fastText | 弱 (Bag-of-Words) | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐⭐ | 海量数据基线、低延迟场景 |

| TextCNN | 中 (局部 N-gram) | ⭐⭐⭐⭐ | ⭐⭐⭐⭐ | 短句分类、情感分析、通用 baseline |

| TextRNN/LSTM | 强 (序列依赖) | ⭐⭐ | ⭐⭐ | 长文本、需捕捉上下文逻辑 |

| BERT/Transformer | 极强 (全局语义) | ⭐ | ⭐⭐ | 高精度需求、复杂语义理解、资源充足 |

🔚 结语:面试准备建议

1️⃣ 基础层 :能手画 TextCNN 结构图,解释 1-max pooling 作用

2️⃣ 原理层 :说清 fastText hierarchical softmax 如何加速

3️⃣ 实践层 :掌握类别不平衡下的指标选择与 loss 优化

4️⃣ 视野层:了解从 CNN 到 Transformer 的演进逻辑

🌟 终极心法 :

文本分类虽经典,但面试官更看重你针对业务场景选型的能力 ------

"为什么这里选 TextCNN 而不是 BERT?"

"数据不平衡时你的评估指标是什么?"