前言

在上两篇文章中,我们围绕Uniswap专家知识库打造AI助理。今天我们将以零代码的方式来实现,这要归功于Flowise。我们将使用Flowise构建的工作流,来实现一个同样的AI助理应用。

AI生态

随着AIGC的火爆,有很多非常优秀的框架、工具和服务,构建起来了良好的AI开发生态。Flowise 也是其中之一, 在介绍它之前,我们先来聊聊我们熟悉AI生态里的工具或服务,欢迎大家在评论区补充,好让我也快点学起来, 用起来。如何将这些优秀的AI生态成员工具接我们的项目,这会是我下一步写作的方向。  上图来自Flowise首页

上图来自Flowise首页

- LangChain

LangChain提供python和js两个语言版本,Flowise基于LangChainJS库,零代码完成LLMs应用非常方便。

- Chroma

Chroma是LangChain生态里的向量数据库。将用户查询和资料,使用LLM进行embedding后,计算cosin向量值,就可以快速完成自然语言相似性处理。Chroma封装了这一流程。

- OpenAI

最为常用的AI大模型,我们也可以使用其它代替。

- HuggingFace

&emsp全球最大LLMs 社区, 有着丰富的开源大模型、数据集和类似github page 一样的在线大模型服务。

😝有需要的小伙伴,可以V扫描下方二维码免费领取🆓

## Flowise

## Flowise

Flowise是使用非常广泛的AI零代码工具。不需要任何编码,就可以通过拖拽的方式,轻松实现一个chat bot,并支持一键布署。

- 安装Floise

在FlowiseAI/Flowise: Drag & drop UI to build your customized LLM flow (github.com)中有两种使用方式。在这里我们使用基于node的第一种方案,如果大家对docker比较熟悉,也可以使用第二种。

-

Install Flowise

复制代码npm install -g flowise -

Start Flowise

sqlsql 复制代码npx flowise startWith username & password

csscss 复制代码npx flowise start --FLOWISE_USERNAME=user --FLOWISE_PASSWORD=1234

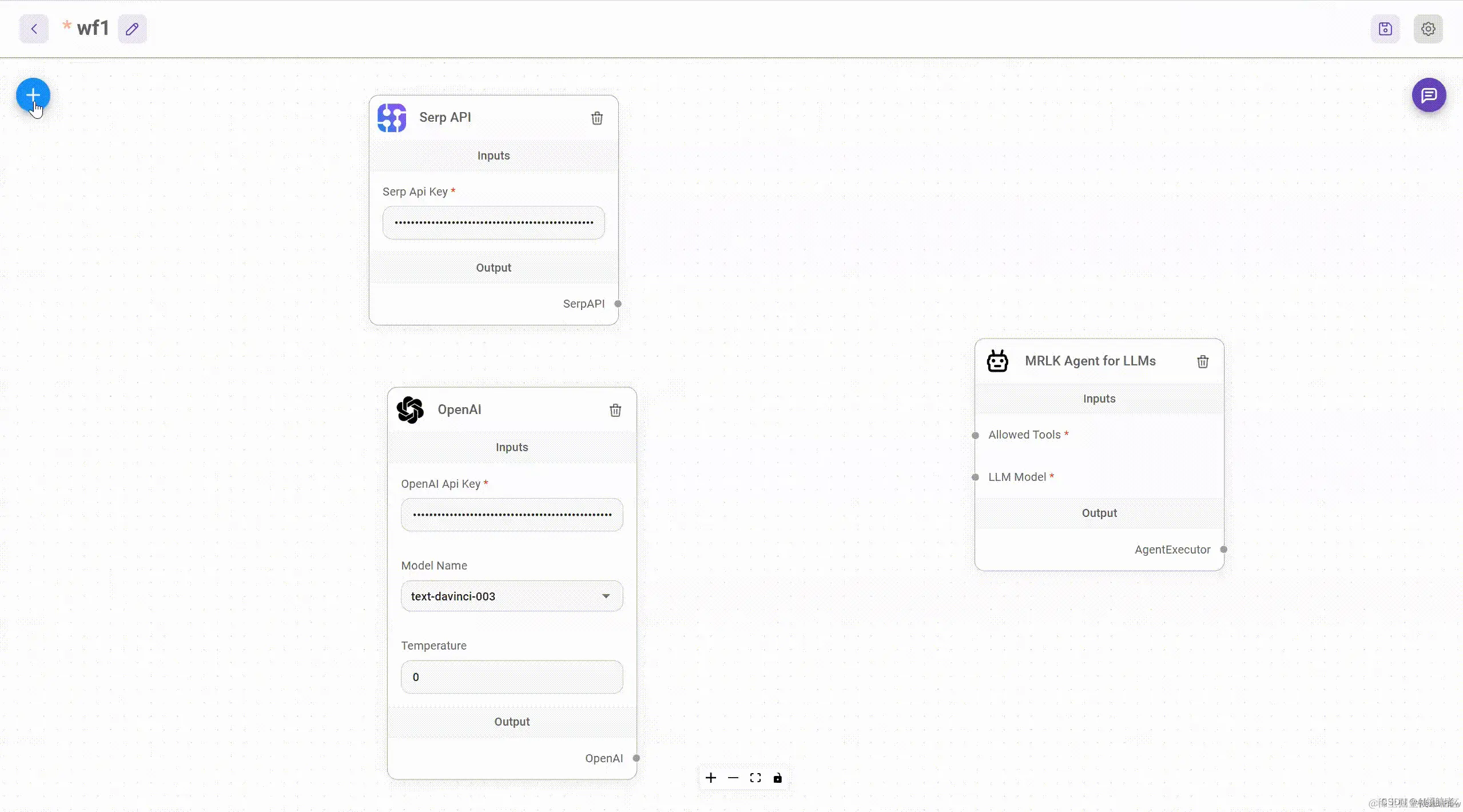

- AI助理要使用到的工作流组件

假定大家已经安装好flowise, 并在相关端口本地成功启动flowise。

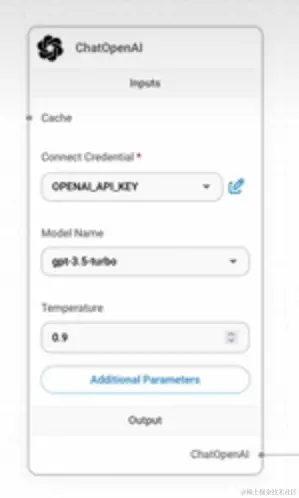

通过左上角的加号,我们添加了OPENAI 大模型模块。

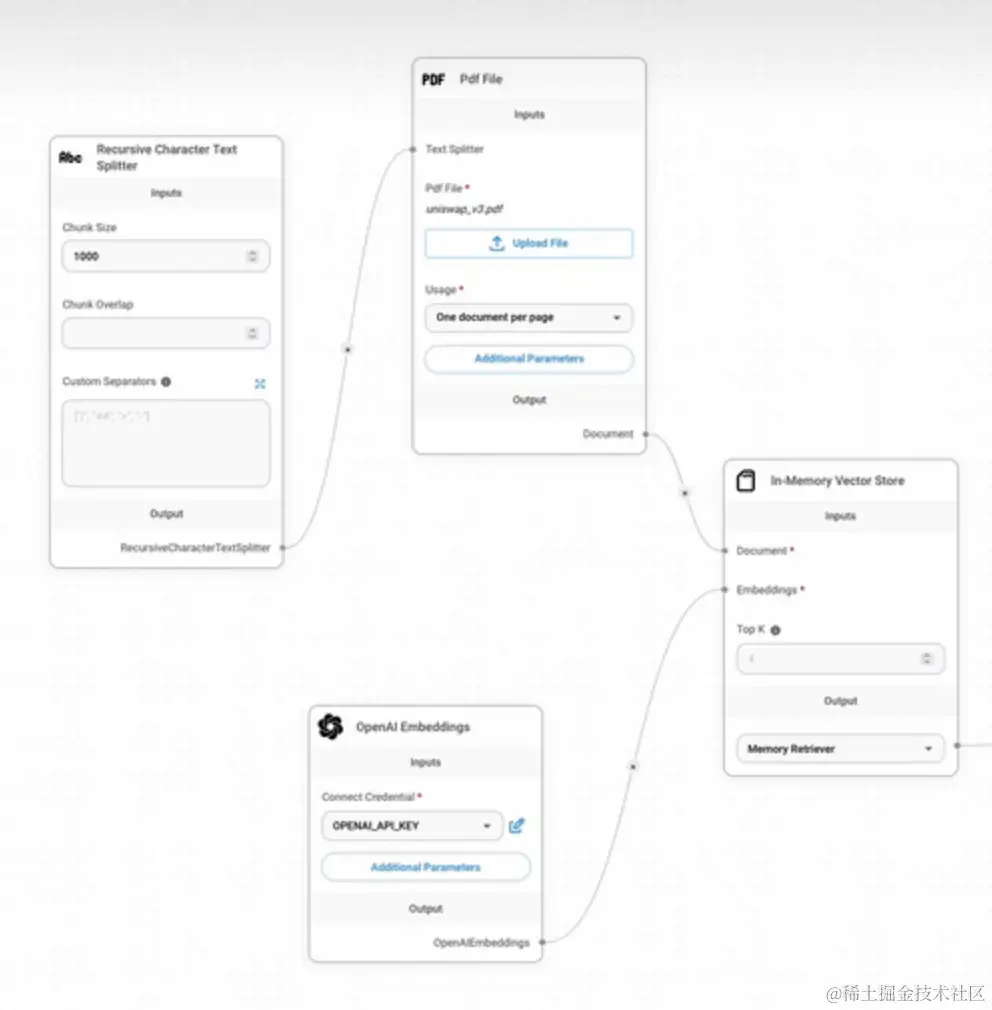

PdfFile、Recursive Character Text Spliter、OpenAI Embeddings、和 In-Momory Vector Store 四个模块的引入,分别解决了Uniswap 白皮书(pdf格式)的加载、1000字符一片的切片、切片的embedding计算和向量存储

LangChain的Conversational Retrieval QA Chain模块的加入,集合OPENAI、向量数据库、数据缓存一起,实现了chat boot。 保存并运行,我们就可以和AI聊天机器人QA对话了。

当我们了解了AI知识文档聊天机器人的各个功能模块和LangChain的工作方式后,使用Flowise可以快速搭建工作流,非常惊艳。

- 与AutoGen交流

点击右上角第二个按钮,会出现如上图的操作。我们选择python,打开之前的python note book, 交由AutoGen调用。

大家可以打开LangChain-Advanced/Integrations/AutoGen/autogen_flowise_ai_agent.ipynb at main · sugarforever/LangChain-Advanced (github.com)来看代码。前几篇文章中讲过的代码我这里就不再累述,这里只讲flowise_ai的增量部分

- 拷贝flowise 提供的代码, 放入ipynb文件。

ini

ini复制代码import requests

API_URL = "http://localhost:4000/api/v1/prediction/433ed37e-9546-4e73-a688-7352b78bf852"

def query(payload):

response = requests.post(API_URL, json=payload)

return response.json()

output = query({

"question": "Hey, how are you?",

})上面的代码使用requests请求库,向flowiseAI拖拽生成的AI代理应用发送了请求。并且调用并问了个问题,来测试是否引入成功。这个例子大家需要在本地运行python notebook哦,在远程colab里是运行不了的,注意看API_URL。

- 定义agents with function calls 函数

ini

ini复制代码import requests

API_URL = "http://localhost:4000/api/v1/prediction/433ed37e-9546-4e73-a688-7352b78bf852"

def answer_flowise_uniswap_question(question):

response = requests.post(API_URL, json={ "question": question })

return response.json()- 在llm_config和user_proxy中添加配置

python

python复制代码llm_config={

"request_timeout": 600,

"seed": 42,

"config_list": config_list,

"temperature": 0,

"functions": [

{

"name": "answer_flowise_uniswap_question",

"description": "Answer any Uniswap related questions",

"parameters": {

"type": "object",

"properties": {

"question": {

"type": "string",

"description": "The question to ask in relation to Uniswap protocol",

}

},

"required": ["question"],

},

}

],

}

user_proxy = autogen.UserProxyAgent(

name="user_proxy",

human_input_mode="NEVER",

max_consecutive_auto_reply=10,

code_execution_config={"work_dir": "."},

llm_config=llm_config,

system_message="""Reply TERMINATE if the task has been solved at full satisfaction.

Otherwise, reply CONTINUE, or the reason why the task is not solved yet.""",

function_map={"answer_flowise_uniswap_question": answer_flowise_uniswap_question}

)- use_proxy 开始工作

ini

ini复制代码user_proxy.initiate_chat(

assistant,

message="""

I'm writing a blog to introduce the version 3 of Uniswap protocol. Find the answers to the 3 questions below and write an introduction based on them.

1. What is Uniswap?

2. What are the main changes in Uniswap version 3?

3. How to use Uniswap?

Start the work now.

"""

)- autogen 返回

autogen工作流程和逐步掌握最佳Ai Agents框架-AutoGen 五 与LangChain手拉手 - 掘金 (juejin.cn)文章是一样的,大家可以点开查看, 这里就不粘代码了。

总结

本文继上篇之后,使用Flowise 低代码的方式,同样实现了基于Uniswap的专家知识库AI助理项目。有以下收获:

- agents with function calls 这一autogen的语法,是autogen与其它AI工具或服务连接的利器,这一想法再次加固

- Flowise AI工具,非常便捷和快速的帮助我们搭建了产品思路和实现,在AI原型阶段非常有必要

如何系统的去学习大模型LLM ?

作为一名热心肠的互联网老兵,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。

但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的 AI大模型资料 包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

😝有需要的小伙伴,可以V扫描下方二维码免费领取🆓

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

阶段1:AI大模型时代的基础理解

- 目标:了解AI大模型的基本概念、发展历程和核心原理。

- 内容 :

- L1.1 人工智能简述与大模型起源

- L1.2 大模型与通用人工智能

- L1.3 GPT模型的发展历程

- L1.4 模型工程

- L1.4.1 知识大模型

- L1.4.2 生产大模型

- L1.4.3 模型工程方法论

- L1.4.4 模型工程实践

- L1.5 GPT应用案例

阶段2:AI大模型API应用开发工程

- 目标:掌握AI大模型API的使用和开发,以及相关的编程技能。

- 内容 :

- L2.1 API接口

- L2.1.1 OpenAI API接口

- L2.1.2 Python接口接入

- L2.1.3 BOT工具类框架

- L2.1.4 代码示例

- L2.2 Prompt框架

- L2.2.1 什么是Prompt

- L2.2.2 Prompt框架应用现状

- L2.2.3 基于GPTAS的Prompt框架

- L2.2.4 Prompt框架与Thought

- L2.2.5 Prompt框架与提示词

- L2.3 流水线工程

- L2.3.1 流水线工程的概念

- L2.3.2 流水线工程的优点

- L2.3.3 流水线工程的应用

- L2.4 总结与展望

阶段3:AI大模型应用架构实践

- 目标:深入理解AI大模型的应用架构,并能够进行私有化部署。

- 内容 :

- L3.1 Agent模型框架

- L3.1.1 Agent模型框架的设计理念

- L3.1.2 Agent模型框架的核心组件

- L3.1.3 Agent模型框架的实现细节

- L3.2 MetaGPT

- L3.2.1 MetaGPT的基本概念

- L3.2.2 MetaGPT的工作原理

- L3.2.3 MetaGPT的应用场景

- L3.3 ChatGLM

- L3.3.1 ChatGLM的特点

- L3.3.2 ChatGLM的开发环境

- L3.3.3 ChatGLM的使用示例

- L3.4 LLAMA

- L3.4.1 LLAMA的特点

- L3.4.2 LLAMA的开发环境

- L3.4.3 LLAMA的使用示例

- L3.5 其他大模型介绍

阶段4:AI大模型私有化部署

- 目标:掌握多种AI大模型的私有化部署,包括多模态和特定领域模型。

- 内容 :

- L4.1 模型私有化部署概述

- L4.2 模型私有化部署的关键技术

- L4.3 模型私有化部署的实施步骤

- L4.4 模型私有化部署的应用场景

学习计划:

- 阶段1:1-2个月,建立AI大模型的基础知识体系。

- 阶段2:2-3个月,专注于API应用开发能力的提升。

- 阶段3:3-4个月,深入实践AI大模型的应用架构和私有化部署。

- 阶段4:4-5个月,专注于高级模型的应用和部署。

这份完整版的大模型 LLM 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

😝有需要的小伙伴,可以Vx扫描下方二维码免费领取🆓