目录

- [1. pooling池化层](#1. pooling池化层)

-

- [1.1 down sample](#1.1 down sample)

- [2.2 Max pooling](#2.2 Max pooling)

- [1.3 Avg pooling](#1.3 Avg pooling)

- [1.3 pooling pytorch实现](#1.3 pooling pytorch实现)

- [2. up sample上采样](#2. up sample上采样)

-

- [2.1 up sample](#2.1 up sample)

- [2.2 pytorch实现](#2.2 pytorch实现)

- [3. ReLU](#3. ReLU)

1. pooling池化层

1.1 down sample

见下图,隔行隔列采样

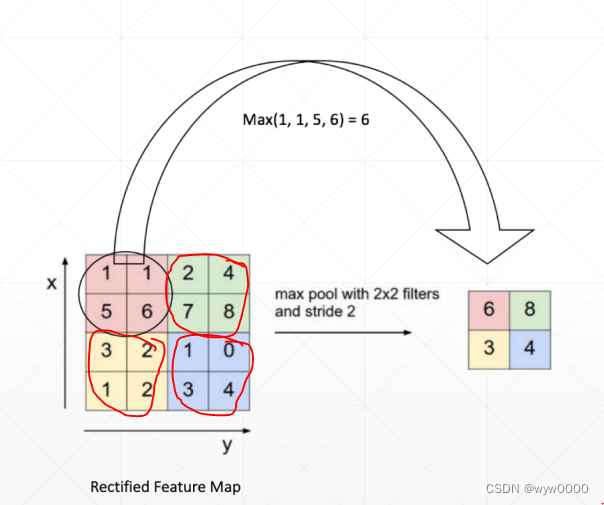

2.2 Max pooling

下图采用2x2的filter,步长是2,找到每个窗口的最大值

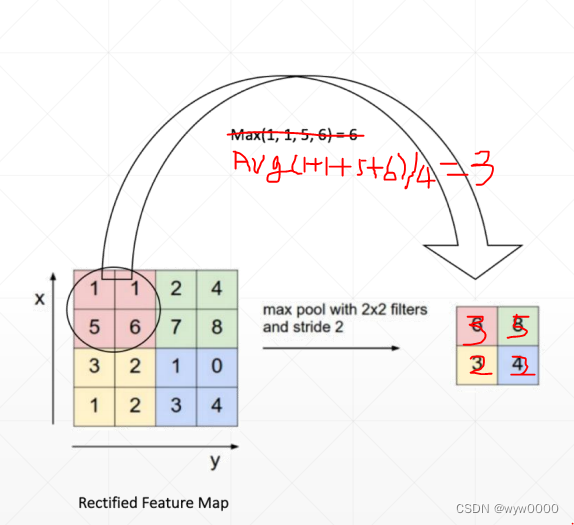

1.3 Avg pooling

下图采用2x2的filter,步长是2,求每个窗口的平均值值

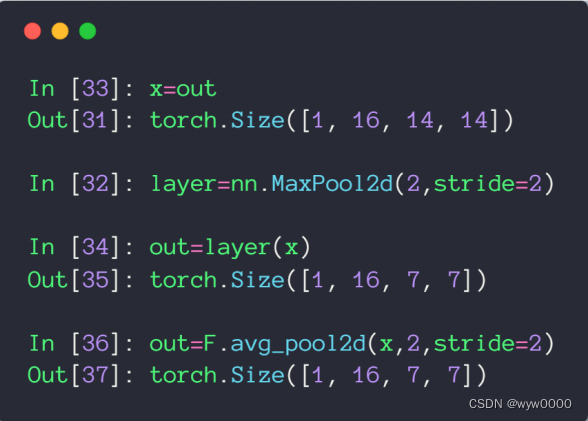

1.3 pooling pytorch实现

pooling在pytorch也有两种方法,一种是类方法nn.MaxPool2d,另一种是F.avg_pool2d

总结:池化层的作用就是下采样

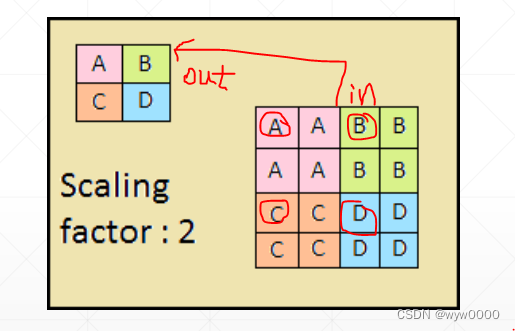

2. up sample上采样

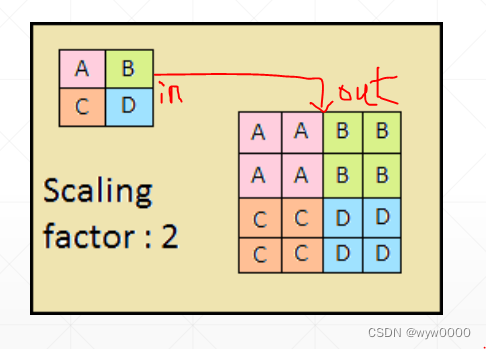

2.1 up sample

图像上采样类似下图

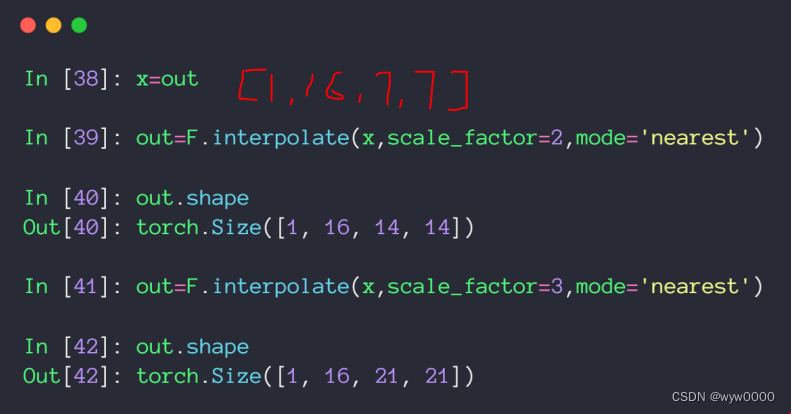

2.2 pytorch实现

上采样使用F.interpolate函数

scale_factor决定了上采样的倍数

mode参数是插值算法,具体见官方文档

3. ReLU

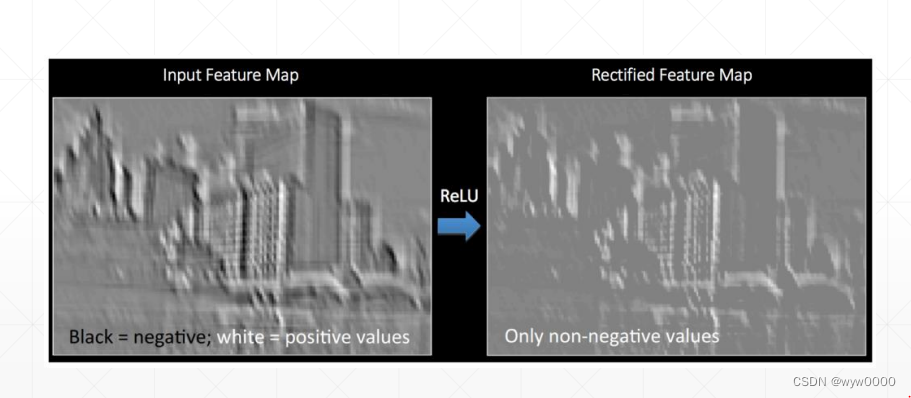

下图是ReLU前后的两张feature map

ReLu input>0时,out是个线性函数

input<0时,out = 0

从图中可以看出在ReLU的作用下,负值变为0

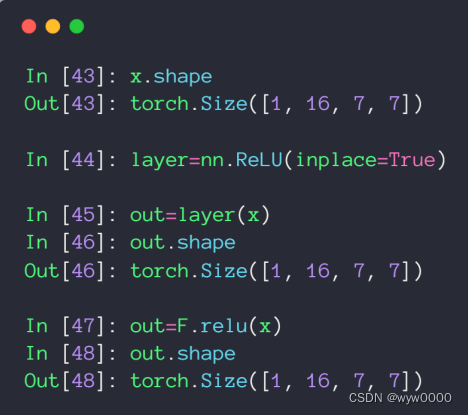

pytorch实现

ReLU在pytorch也有两种方法,一种是类方法nn.ReLU,另一种是F.relu