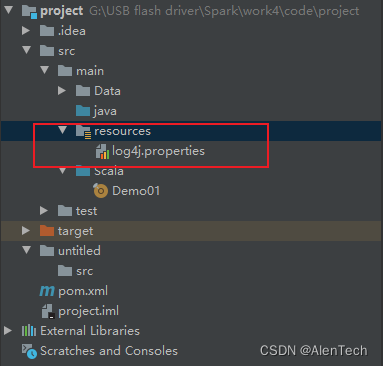

修改log4j配置文件,没有就创建:

内容:

java

# 设置日志记录器

log4j.rootCategory=WARN, console

log4j.appender.console=org.apache.log4j.ConsoleAppender

log4j.appender.console.target=System.err

log4j.appender.console.layout=org.apache.log4j.PatternLayout

log4j.appender.console.layout.ConversionPattern=%d{yy/MM/dd HH:mm:ss} %p %c{1}: %m%n

# 设置Spark相关组件的日志级别

log4j.logger.org.apache.spark=WARN

log4j.logger.org.apache.spark.sql=ERROR

log4j.logger.org.spark-project=ERROR

log4j.logger.org.apache.hadoop=ERROR

log4j.logger.io.netty=ERROR

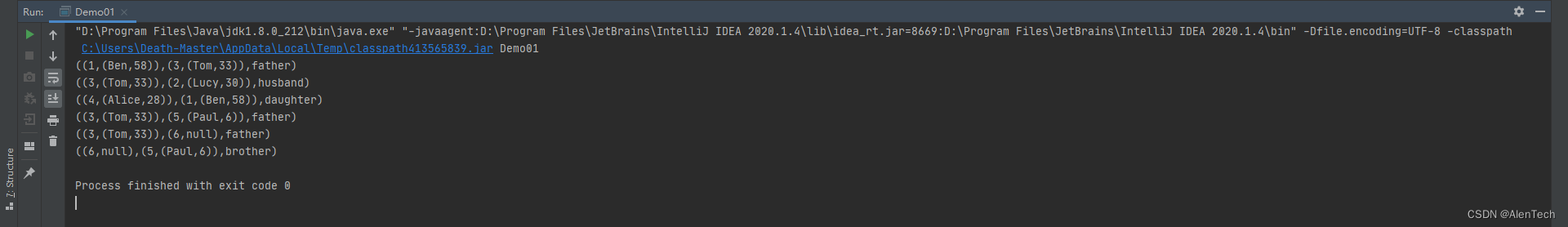

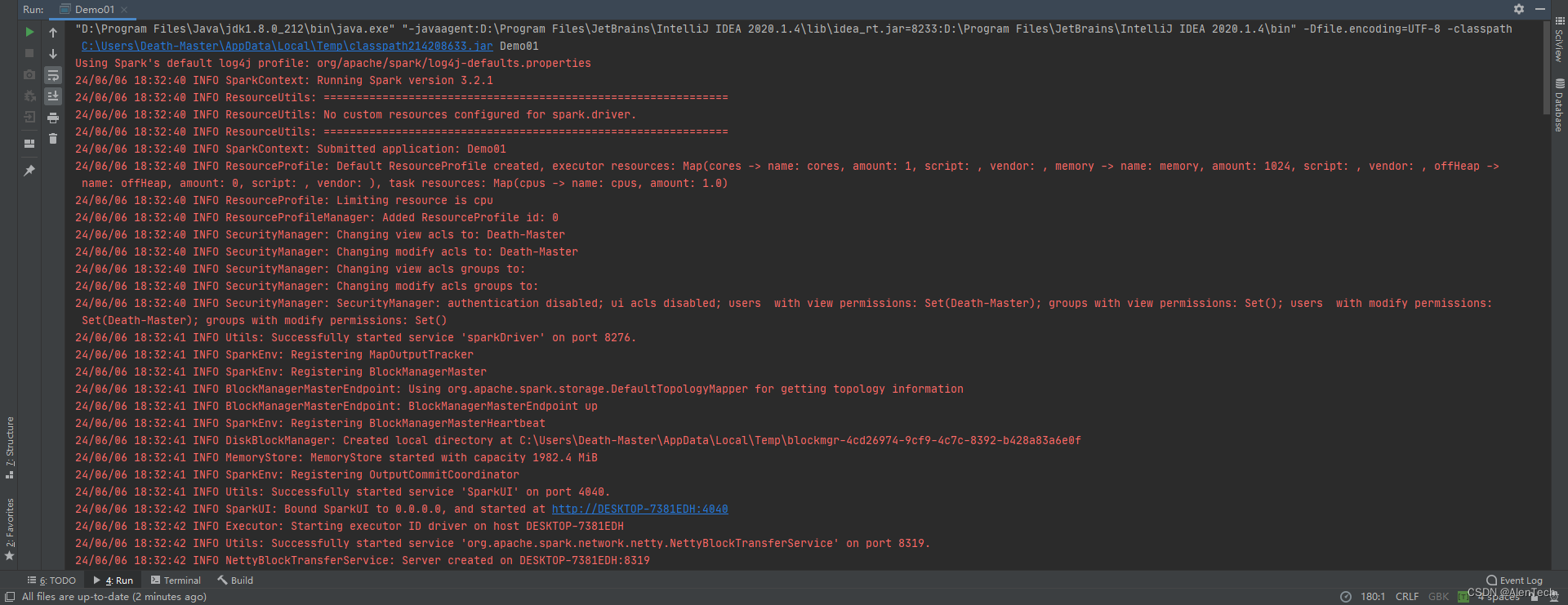

log4j.logger.org.apache.zookeeper=ERROR结果: