-

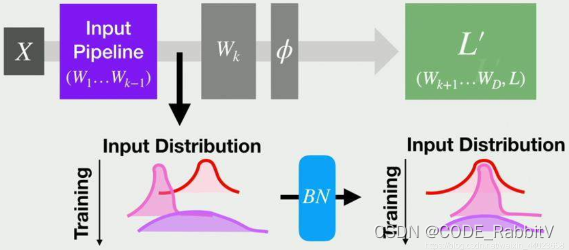

Batch Normalization 可以

改善梯度消失/爆炸问题:前面层的梯度经过多次传递后会变得非常小(大),从而导致网络收敛速度慢(不收敛),应用 BN 可缓解加速网络收敛:BN 使得每个神经元的输入分布更加稳定减少过拟合:BN 可减少由于数据分布的变化导致的模型性能下降提高模型泛化能力:BN 使得模型对输入的微小变化更加稳定缓解超参敏感:对于 learning rate 等超参数敏感性降低- ...

-

Batch Normalization(BN):使 feature map 满足均值为 0,方差为 1 的分布规律

- 如果batch size为m,则在前向传播过程中,网络中每个节点都有m个输出,所谓的Batch Normalization,就是对该层每个节点的这m个输出进行归一化再输出

- 数学表达:每个 channel 下统计一个对应的均值和方差

x norm = x − E [ x ] V a r [ x ] + ϵ ∗ γ + β x_{\text{norm}} = \frac{x - \mathbb{E}[x]}{\sqrt{Var[x]+\epsilon}} * \gamma + \beta xnorm=Var[x]+ϵ x−E[x]∗γ+β- 其中 γ , β \gamma, \beta γ,β 为可学习的参数

-

代码实践:

python3>>> import torch >>> import torch.nn as nn >>> >>> x = torch.rand(2,1,28,28) ## *0.创建输入 x >>> bn = nn.BatchNorm2d( ## *1. 创建 bn 层, 1, # -- 输入的 channel 数 training = False, # -- 是否为训练模式 affine = False) # -- 是否学习 γ β >>> out = bn(x) ## *2 获取输出 >>> # 查看相关数值 ------------------------------------------------ >>> bn.running_mean # 均值 tensor([0.0507]) >>> bn.running_var # 方差 tensor([0.9080]) >>> bn.weight # γ Parameter containing: tensor([1.], requires_grad=True) >>> bn.bias # β Parameter containing: tensor([0.], requires_grad=True)

PyTorch -- Batch Normalization(BN) 快速实践

CODE_RabbitV2024-06-16 5:05

相关推荐

是一碗螺丝粉7 分钟前

5分钟上手LangChain.js:用DeepSeek给你的App加上AI能力两万五千个小时15 分钟前

落地实现 Anthropic Multi-Agent Research System用户48159301959116 分钟前

揭秘GPT-4与LLaMA背后的加速黑科技:KV Cache、MQA、GQA、稀疏注意力与MoE全解析用户51914958484517 分钟前

Cisco SMA 暴露面检测工具 - 快速识别CVE-2025-20393风险碳基沙盒23 分钟前

AI工具的“超级外挂”:从零手把手教你搭建私人 MCP 服务器马腾化云东24 分钟前

Agent开发应知应会(langfuse):Langfuse Score概念详解和实战应用Baihai_IDP29 分钟前

HackerNews 热榜第一名:AGI 的 A,原来代表的是 Ads(广告)ma_king29 分钟前

claude+tmux 团队模式使用蓝桉_T1 小时前

Ollama 本地跑 DeepSeek-Coder V3 保姆级教程(Java 调用示例)风象南3 小时前

Token太贵?我用这个数据格式把上下文窗口扩大2倍