论文题目:DistPred: A Distribution-Free Probabilistic Inference Method for Regression and Forecasting

论文作者:Daojun Liang, Haixia Zhang,Dongfeng Yuan

论文地址:https://arxiv.org/abs/2406.11397

代码地址:https://github.com/Anoise/DistPred论文在线版本 --- 论文地址 --- Github代码地址

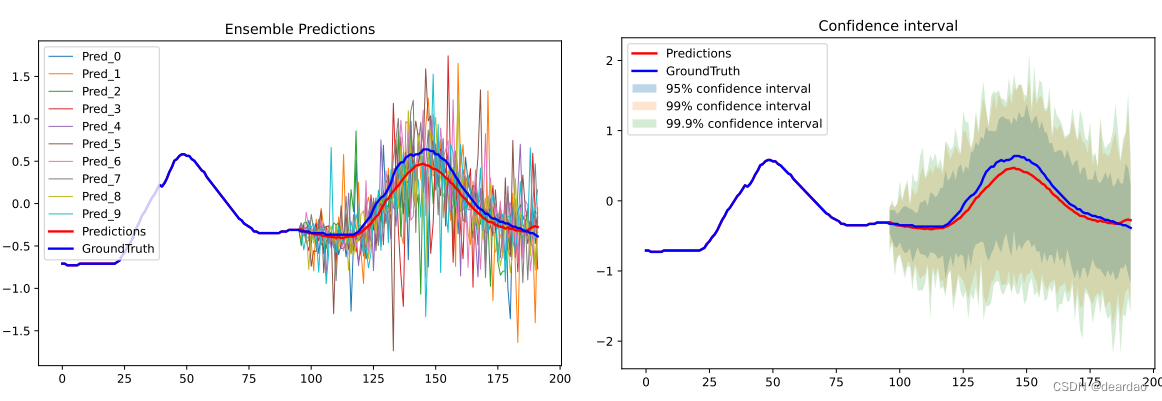

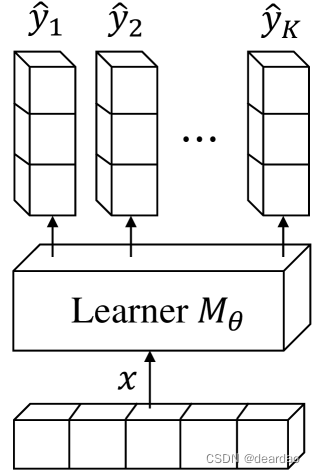

图 0:DistPred可在一次前向过程中给出N个预测,根据这N个预测可求得该点的分布。

摘要

传统的回归和预测任务通常只提供确定性的点估计。为了估计响应变量的不确定性或分布信息,通常使用贝叶斯推理、模型集成或MC Dropout等方法。这些方法要么假设样本的后验分布遵循高斯过程,要么需要数千次前向传递来生成样本。我们提出了一种新的方法,称为DistPred,用于回归和预测任务,它克服了现有方法的局限性,同时保持简单和强大。具体来说,我们将测量预测分布与目标分布之间差异的适当评分规则转换为可微离散形式,并将其用作损失函数来端到端训练模型 。这允许模型在单个前向传递中采样大量样本 ,以估计响应变量的潜在分布。我们已经将我们的方法与多个数据集上的几种现有方法进行了比较,并获得了最先进的性能。此外,我们的方法显著提高了计算效率。例如,与最先进的模型相比,DistPred的推理速度快了90x倍,训练速度提升230x倍 (考虑数据处理与指标计算等步骤)。实验结果可以通过这个Github库复现。

图1:DistPred可以在单个前向过程中给出预测变量的变量,给出响应变量的变量的 K K K预测值,表示为 y ^ \hat{y} y^,其中 y ^ \hat{y} y^表示的是一个最大似然样本。基于这个抽样,可以计算响应变量 y y y的质量分布的概率(PMD) P θ ( y ^ ∣ x ) P_{\theta}(\hat{y}|x) Pθ(y^∣x),累积分布函数(PDF) F θ ( y ^ ∣ x ) F_{\theta}(\hat{y}|x) Fθ(y^∣x),和信心曲线 C C θ ( y ^ ∣ x ) CC_{\theta}(\hat{y}|x) CCθ(y^∣x),从而产生 y y y全面统计量。例如,这包括任何期望水平上的置信区间(CI)以及p-value。

1 简介

在本文中,我们考虑了预测响应变量背后的潜在分布,因为它反映了所有水平的置信区间。例如,基于这个分布,我们可以计算任何级别的置信区间、覆盖率和不确定性量化。目前,预测响应变量的分布是一个挑战,因为在特定时刻,响应变量只能采取单一的确定性值。这个点可以看作是其潜在分布的最大似然样本,但它不能反映潜在分布的整体状态。

目前,在回归和预测任务中,用于解决分布预测和不确定性量化的主要方法是频率采样。这些方法包括通过干扰解释变量或模型来采样大量样本,以近似响应变量的潜在分布。例如,贝叶斯神经网络(bnn)通过假设其参数遵循高斯分布来模拟这种不确定性,从而捕获给定数据的模型的不确定性(Blundell et al., 2015)。同样,基于集成的方法也被提出,将多个具有随机输出的深度模型结合起来,以捕获预测的不确定性。MC Dropout (Gal和Ghahramani, 2016)表明,在每个测试过程中启用Dropout会产生类似于模型集成的结果。此外,还引入了基于GAN和扩散的条件密度估计和预测不确定性量化模型。这些模型利用产生或扩散过程中的噪声来获得不同的预测值,以估计响应变量的不确定性。

上述这些方法的共同特点是要求𝐾前向通过采样 K K K代表性样本。例如,基于贝叶斯框架的方法需要推断 K K K可学习的参数样本,以获得 K K K代表性样本;集成方法需要 K K K模型共同推断;MC Dropout需要 K K K向前通过随机Dropout激活;生成模型需要 K K K正向或扩散过程。然而,过多的向前传递会导致显著的计算开销和较慢的速度,对于具有高实时性要求的AI应用程序来说,这一缺点变得越来越明显。

为了解决这个问题,我们提出了一种新的方法,称为DistPred,它是一种用于回归和预测任务的无分布概率推理方法。DistPred是一种简单而强大的方法,可以估计单次正向传递中响应变量的分布。具体来说,我们考虑使用所有预测分位数来指定预测变量的潜在累积密度函数(CDF),并且我们表明,整个分位数的预测可以转化为计算响应变量和预测集合变量的最小期望值。在此基础上,我们将测量预测分布与目标分布之间差异的适当评分规则转换为可微离散形式,并将其用作损失函数来端到端训练模型。这允许模型在单个前向传递中采样大量样本,以估计响应变量的潜在分布。DistPred与其他方法是正交的,这使得它可以与其他方法相结合来增强估计性能。此外,我们还展示了DistPred可以提供对响应变量的全面统计见解,包括任何期望水平上的置信区间、p值和其他统计信息,如图1所示。实验结果表明,DistPred在精度和计算效率方面都优于现有方法。具体来说,DistPred的推理速度比最先进的模型快90倍,训练速度提升230x倍(考虑数据处理与指标计算等步骤)。

2 方法

假设数据集 D = { x i , y i } i = 1 N D=\{x_i,y_i\}_{i=1}^N D={xi,yi}i=1N由 N N N样本标签对组成。如果下标 i i i不会在上下文中引起歧义,则将被省略。我们的目标是利用具有参数 θ \theta θ的机器学习模型 M M M来预测响应变量 y y y从 D D D的潜在分布 P ( y ) P(y) P(y),旨在获得全面的统计见解,例如获得置信区间(CI)和在任何期望水平上量化不确定性。

直接预测分布 P P P是不可行的,因为:

- 如果没有分布假设,我们就不能给出预测分布 P θ ( y ^ ) P_\theta(\hat{y}) Pθ(y^)的PDF或CDF的有效表示。

- 对于响应变量 y y y,我们只能得到一个奇异的确定性值,无法获得其分布信息来指导模型学习。

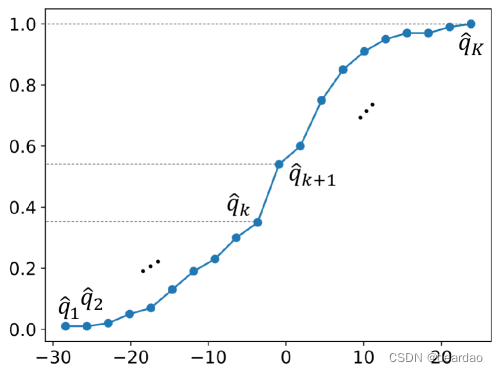

为了解决上述问题,我们考虑采用所有预测分位数 q ^ 1 , q ^ 2 , ⋯ \hat{q}_1, \hat{q}2, \cdots q^1,q^2,⋯,在水平 α 1 , α 2 , ⋯ \alpha_1, \alpha_2, \cdots α1,α2,⋯上指定预测变量 y ^ \hat{y} y^的潜在CDF F θ ( y ^ ) F\theta(\hat{y}) Fθ(y^)。这是因为如果我们知道随机变量的累积分布函数,我们可以通过设置 F ( y ) = q F(y) = q F(y)=q找到任何分位数。相反,如果我们有一个完整的分位数集,我们可以近似或重建随机变量的累积分布函数。如图2所示,分位数提供了分布的离散"快照",而CDF是这些快照的连续、平滑版本,提供了从最小值到最大值的累积概率的完整描述。

图2:CDF与所有预测分位数之间的关系。

接下来,我们将介绍前面概述的完整预测分位数作为响应变量CDF的适当近似值。全分位数预测可转化为计算响应变量和预测集合变量 Y ^ \hat{Y} Y^的最小期望值,其中 Y ^ = { Y ^ 1 , ⋯ , Y ^ K } \hat{Y} = \{\hat{Y} _1, \cdots, \hat{Y} _K \} Y^={Y^1,⋯,Y^K}。在深入研究此分析之前,我们将首先介绍用于评估预测分布的适当性的评分规则。

2.1 使用适当的评分规则作为损失函数

评分规则通过根据预测分布和预测结果分配数值分数,为评估概率预测提供了一个简明的度量\citep{gneiting2007strictly, jordan2017evaluating}。具体地说,设 Ω \Omega Ω表示感兴趣的数量的可能值的集合,设 P \mathcal{P} P表示 Ω \Omega Ω上概率分布的凸类。评分规则是一个函数

S : Ω × P → R ∪ { ∞ } ( 1 ) S: \Omega \times \mathcal{P} \rightarrow \mathbb{R} \cup \{\infty\} \quad \quad (1) S:Ω×P→R∪{∞}(1)

它将数值赋给预测 P ∈ P P \in \mathcal{P} P∈P和观测 y ∈ Ω y \in \Omega y∈Ω。我们用相关的CDF F F F或PDF F F F来识别概率预测 P P P,并认为评分规则是负向的,分数越低表示预测越准确。当预测与观测的真实分布一致时,则优化了适当的评分规则,即,如果,

E Y ∼ Q [ S ( Q , Y ) ] ≤ E Y ∼ Q [ S ( P , Y ) ] ( 2 ) E_{Y \sim Q} [S(Q, Y)] \leq E_{Y \sim Q} [S(P, Y)] \quad \quad (2) EY∼Q[S(Q,Y)]≤EY∼Q[S(P,Y)](2)

对于所有 P , Q ∈ P P, Q \in \mathcal{P} P,Q∈P。当只有在 P = Q P = Q P=Q时才达到相等时,评分规则被称为严格正确的。适当的评分规则(PSR)对于比较评价至关重要,特别是在排名预测中。在实践中,在多个预测案例中平均得分最低的预测者通常表现出最好的预测性能。适当的评分规则激励预测者准确地报告他们对这种情况下真实分布的看法。因此,PSR提供了有吸引力的损失和效用函数,可以针对回归或预测问题进行调整。为了估计 θ \theta θ,我们可以用均值来衡量拟合优度

S n ( θ ) = 1 N ∑ i = 1 N S ( P θ ( y ^ i ) , y i ) . ( 3 ) S_n(\theta) = \frac{1}{N} \sum_{i=1}^N S(P_{\theta}(\hat{y}_i), y_i). \quad \quad (3) Sn(θ)=N1i=1∑NS(Pθ(y^i),yi).(3)

设 θ ∗ \theta^* θ∗为真参数值,则渐近参数表明 argmin θ S n ( θ ) → θ ∗ \text{argmin}_\theta S_n(\theta) \rightarrow \theta^* argminθSn(θ)→θ∗为 n → ∞ n\rightarrow \infty n→∞。这提出了一种将PSR转换为训练模型损失函数的一般方法,该方法隐含地最小化了预测分布和真实分布之间的差异。

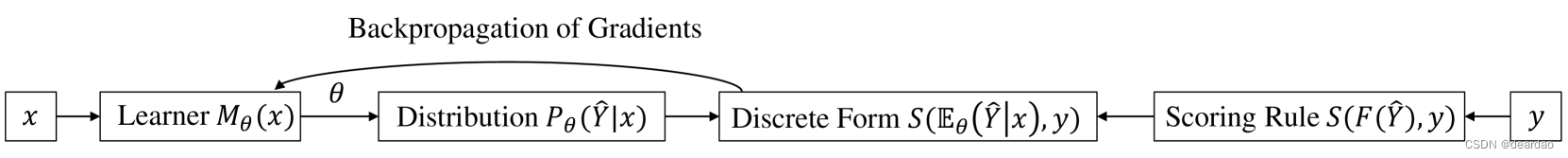

图3:DistPred的工作流程。在前向传递中推断预测变量 Y ^ \hat{Y} Y^的集合,并使用PSR S ( E ( Y ^ ∣ x ) , Y ) S(\mathbb{E}(\hat{Y}|x), Y) S(E(Y^∣x),Y)对学习器进行端到端训练。

2.2 全预测分位数的性质

我们考虑与连续量有关的概率预测,表现为完整的预测分位数 q ^ 1 , ⋯ , q ^ K \hat{q}_1, \cdots, \hat{q}_K q^1,⋯,q^K。对于 P ∈ P P\in \mathcal{P} P∈P,让 q 1 , ⋯ , q K q_1, \cdots, q_K q1,⋯,qK表示级别 α 1 , ⋯ , α K ∈ ( 0 , 1 ) \alpha_1, \cdots, \alpha_K \in (0,1) α1,⋯,αK∈(0,1)上的真实 P P P -分位数。则可将期望分数 S ( q 1 , ⋯ , q K ; P ) S(q_1, \cdots, q_K; P) S(q1,⋯,qK;P)定义为

S ( q ^ 1 , ⋯ , q ^ K ; P ) = ∫ S ( q ^ 1 , ⋯ , q ^ K ; y ) d P ( y ) . ( 4 ) S(\hat{q}_1, \cdots, \hat{q}_K; P) = \int S(\hat{q}_1, \cdots, \hat{q}_K; y) \,\text{d}P(y). \quad \quad (4) S(q^1,⋯,q^K;P)=∫S(q^1,⋯,q^K;y)dP(y).(4)

此外,评分规则S是适当的,如果 S ( q 1 , ⋯ , q K ; P ) ≥ S ( q ^ 1 , ⋯ , q ^ K ; P ) S(q_1, \cdots, q_K; P) \ge S( \hat{q}_1, \cdots, \hat{q}_K; P) S(q1,⋯,qK;P)≥S(q^1,⋯,q^K;P)。基于这个定义,我们假设 s k , i ∈ [ 1 , ⋯ K ] s_k, i \in [1,\cdots K] sk,i∈[1,⋯K] 是非递减的, h h h是任意的,那么得分规则

S ( q ^ 1 , ⋯ , q ^ K ; P ) = ∑ k = 1 K ( α i s k ( q ^ k ) + ( s k ( y ) − s k ( q k ^ ) 1 { y ≤ q ^ k } ) ) ( 5 ) S( \hat{q}_1, \cdots, \hat{q}K; P) = \sum{k=1}^K \left( \alpha_i s_k(\hat{q}_k) + (s_k(y) - s_k(\hat{q_k})\mathbb{1}\{y\le \hat{q}_k\} ) \right) \quad \quad (5) S(q^1,⋯,q^K;P)=k=1∑K(αisk(q^k)+(sk(y)−sk(qk^)1{y≤q^k}))(5)

是适当的预测分位数水平 α 1 , ⋯ , α K \alpha_1, \cdots, \alpha_K α1,⋯,αK当 K → ∞ K \rightarrow \infty K→∞。 1 { y ≤ q ^ k } \mathbb{1}\{y\le \hat{q}_k\} 1{y≤q^k}表示指示函数,如果 y ≤ q ^ k y \le \hat{q}_k y≤q^k为1,否则为0。

等式5表明,完整的预测分位数是合适的。本质上,描述预测CDF等同于指定所有预测分位数。因此,我们可以根据分位数的评分规则来制定预测分布的评分规则。具体来说,让 S α S_\alpha Sα表示级别 α \alpha α的分位数的适当评分规则,然后是评分规则

S ( F , y ) = ∫ 0 1 S α ( F − 1 ( α ) ; y ) d α = ∫ − ∞ ∞ S ( F ( y ^ ) , 1 { y ≤ y ^ } ) d y ^ ( 6 ) S(F,y) = \int_0^1 S_\alpha(F^{-1}(\alpha); y) \,\text{d}\alpha = \int_{-\infty}^{\infty} S(F(\hat{y}), \mathbb{1}\{y \le \hat{y} \}) \,\text{d}\hat{y} \quad \quad (6) S(F,y)=∫01Sα(F−1(α);y)dα=∫−∞∞S(F(y^),1{y≤y^})dy^(6)

是恰当的。在这里,我们可以发现,方程6的右侧对应于 S S S为二次或Brier分数的CRPS,定义为

C ( F , y ) = ∫ − ∞ ∞ ( F ( y ^ ) − 1 { y ≤ y ^ } ) 2 d y ^ . ( 7 ) C(F, y) = \int_{-\infty}^{\infty} (F(\hat{y}) - \mathbb{1}\{y \le \hat{y} \})^2 \,\text{d}\hat{y}. \quad \quad (7) C(F,y)=∫−∞∞(F(y^)−1{y≤y^})2dy^.(7)

如果 F F F的第一阶矩是有限的,则CRPS可以写成

C ( F , y ) = E F [ ∣ Y ^ − y ∣ ] − 1 2 E F F [ ∣ Y ^ − Y ^ ′ ∣ ] , ( 8 ) C(F, y) = \mathbb{E}F[|\hat{Y} - y|] - \frac{1}{2} \mathbb{E}{FF}[|\hat{Y} - \hat{Y}'|], \quad \quad (8) C(F,y)=EF[∣Y^−y∣]−21EFF[∣Y^−Y^′∣],(8)

其中 Y ^ \hat{Y} Y^和 Y ^ ′ \hat{Y}' Y^′表示具有分布 F F F的独立预测变量。

图4: DistPred的架构。

2.3 端到端集成推理

根据上面提供的分析,很明显,预测完整的分位数相当于最小化方程8 w.r.t E ( Y ^ ∣ y ) \mathbb{E}(\hat{Y}|y) E(Y^∣y)。因此,正如图3所示的工作流,我们可以开发一个带有参数 θ \theta θ的模型 M M M,该模型在向前传递中推断预测变量 Y ^ \hat{Y} Y^的集合,并利用方程8对其进行端到端训练。这允许模型在单个前向传递中采样大量样本,以通过预测集合变量估计经验CDF F ^ \hat{F} F^

C ( F ^ , y ) = 1 K ∑ k = 1 K ∣ y ^ k − y ∣ − 1 2 K 2 ∑ k = 1 K ∑ j = 1 K ∣ y ^ k − y ^ j ′ ∣ . ( 9 ) C(\hat{F},y) = \frac{1}{K}\sum_{k=1}^{K}|\hat{y}k - y| - \frac{1}{2K^2}\sum{k=1}^{K}\sum_{j=1}^{K}|\hat{y}k - \hat{y}'{j}|. \quad \quad (9) C(F^,y)=K1k=1∑K∣y^k−y∣−2K21k=1∑Kj=1∑K∣y^k−y^j′∣.(9)

值得注意的是,方程9是严格满足PSR的可微离散形式w.r.t Y ^ \hat{Y} Y^和 Y ′ ^ \hat{Y'} Y′^。然而,方程9的实现由于其计算复杂性 O ( K 2 ) O(K^2) O(K2)而表现出低效率。这可以通过使用基于广义分位数函数\citep{laio2007verification}和排序的预测集成变量的表示来增强

C ( F ^ , y ) = 1 2 K 2 ∑ k = 1 K ( y k → − y ) ( k 1 { y ≤ y k → } − i + 1 2 ) . ( 9 ) C(\hat{F},y) = \frac{1}{2K^2}\sum_{k=1}^{K}(\overrightarrow{y_k} - y)(k \mathbb{1}\{y \le \overrightarrow{y_k} \} -i + \frac{1}{2}). \quad \quad (9) C(F^,y)=2K21k=1∑K(yk −y)(k1{y≤yk }−i+21).(9)

由于涉及排序操作,公式10的计算复杂度为 O ( K l o g K ) O(KlogK) O(KlogK)。为了节省内存,我们还建议使用公式10作为损失函数,因为在长期预测任务中预测集成变量可能会导致GPU内存不足的问题。

2.4 结合其他方法

DistPred与其他方法是正交的,这使得它可以与其他方法相结合来增强估计性能。在这里,考虑到计算效率和内存保护,我们选择将MC Dropout与DistPred集成,从而将合并表示为DistPred-MCD。在我们的实验中,我们观察到DistPred-MCD可以进一步提高不确定性量化性能,尽管计算工作量略有增加。

3 实验

在本文中,我们的重点集中在回归(由Hernández-Lobato和Adams(2015)提出)和预测(由Zhou等人(2021a)提出)任务上,我们验证了所提出的DistPred方法在这些具体工作中的应用。

3.1 PICP和QICE指标

这两个指标都旨在经验地评估学习条件分布与真实条件分布之间的相似程度:

- PICP(预测区间覆盖概率)(Yao等人,2019)是衡量落在预测区间内的真实标签比例的度量。

- QICE (分位数间隔校准误差)(han2022card)是一个度量,用于测量给定水平上预测分位数与真实分位数之间的平均差异 α \alpha α。

PICP计算为:

P I C P : = 1 N ∑ n = 1 N 1 { y ^ n ≥ q α / 2 } ⋅ 1 { y ^ n ≤ q 1 − α / 2 } , ( 11 ) PICP := \frac{1}{N} \sum_{n=1}^{N} \mathbb{1}\{\hat{y}n \ge q{\alpha/2} \} \cdot \mathbb{1}\{\hat{y}n \le q{1-\alpha/2} \}, \quad \quad (11) PICP:=N1n=1∑N1{y^n≥qα/2}⋅1{y^n≤q1−α/2},(11)

其中 q α / 2 q_{\alpha/2} qα/2和 q 1 − α / 2 q_{1-\alpha/2} q1−α/2分别表示在相同的 x x x输入下,我们为预测的 y ^ \hat{y} y^输出选择的低百分位数和高百分位数。该指标评估与每个 x x x输入相对应的生成的 y ^ \hat{y} y^样本的百分位数范围内的准确观测值的比例。

Q I C E : = 1 M ∑ m = 1 M ∣ r m − 1 M ∣ , ( 12 ) where r m = 1 N ∑ n = 1 N 1 { y ^ n ≥ q α / 2 } ⋅ 1 { y ^ n ≤ q 1 − α / 2 } . QICE := \frac{1}{M}\sum_{m=1}^{M} | r_m - \frac{1}{M} |, \quad \quad (12) \\ \quad \text{where} \ \ r_m = \frac{1}{N} \sum_{n=1}^{N} \mathbb{1}\{\hat{y}n \ge q{\alpha/2} \} \cdot \mathbb{1}\{\hat{y}n \le q{1-\alpha/2} \}. QICE:=M1m=1∑M∣rm−M1∣,(12)where rm=N1n=1∑N1{y^n≥qα/2}⋅1{y^n≤q1−α/2}.

3.2 Toy 案例

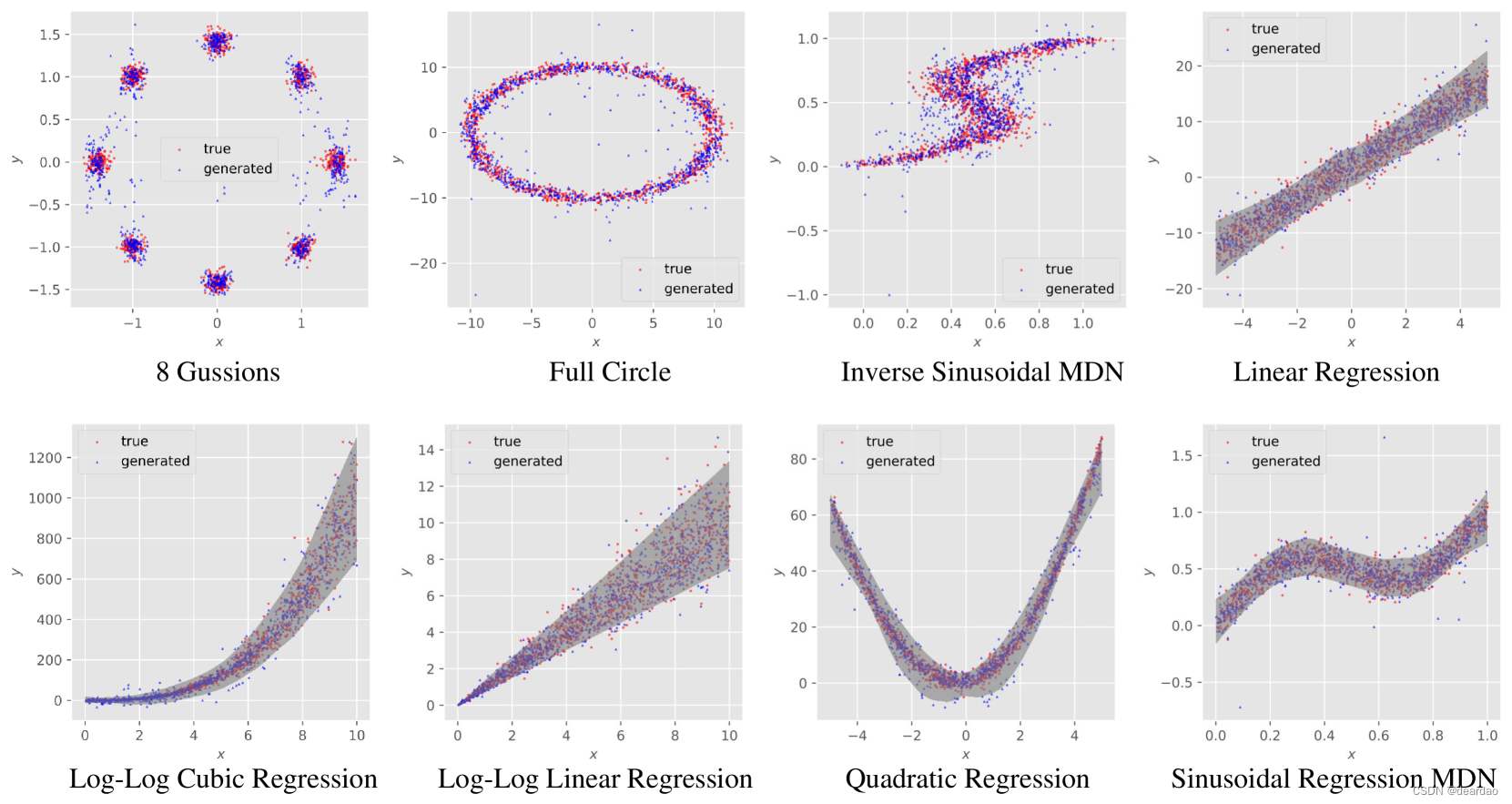

为了证明DistPred的有效性,我们首先在 8 8 8玩具示例上进行实验,如CARD 中所做的那样。这些例子在其数据生成函数中具有独特的统计特征:一些具有单模态对称分布的误差项(线性回归,二次回归,正弦回归),其他具有异方差(对数-对数线性回归,对数-对数三次回归)或多模态(反正弦回归,8高斯,全圆)。

图5:DistPred的回归结果,在8个Toy数据集上的例子。

实验表明,经过训练的DistPred模型具有产生与新协变量的真实响应变量非常相似的样本的能力。此外,它可以根据一定的汇总统计量定量地匹配真实分布。该研究将所有8个任务的真实数据和生成数据的散点图可视化,见图5。在任务涉及单峰条件分布的情况下,兴趣区域填充生成的 y ^ \hat{y} y^值的2.5-th和97.5-th百分位数之间的区域。

我们注意到,在每个任务中,生成的样本与真实的测试实例无缝集成,表明DistPred重构固有数据生成过程的潜力。该实验直观地表明,DistPred有效地重构了目标响应变量的样本电位分布。这表明DistPred的优势可以在分布预测中得到充分利用。

3.3 UCI回归任务

对于在真实世界数据集上进行的实验,我们使用相同的10个UCI回归基准数据集(Asuncion和Newman, 2007),并遵循Hernández-Lobato和Adams(2015)引入的实验协议,Gal和Ghahramani(2016)和Lakshminarayanan等人(2017)以及Han等人(2022)也遵循了该协议。数据集信息可在附录B的表5中找到。

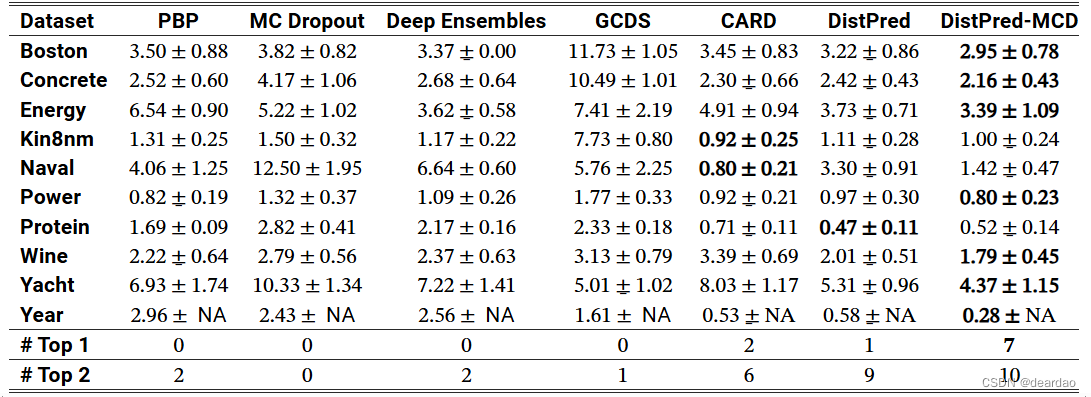

表1:UCI回归任务的QICE ↓ \downarrow ↓ ( % \% %)。

结果表明,DistPred方法优于现有的方法,通常有相当大的差距。值得注意的是,这些令人印象深刻的结果是在DistPred方法的一次向前传递中实现的。至关重要的是,利用DistPred- MCD(一种结合DistPred和MC Dropout的混合方法)可以进一步提高不确定量化的性能。

表2:UCI波士顿数据集上模型训练和推理时间(分钟)的比较。

很明显,与最先进的模型CARD相比,DistPred在训练方面快了大约230倍,在推理方面快了大约90倍。DistPred的推理速度比训练速度慢,因为它涉及到计算分布统计指标,如QICE和PICP。

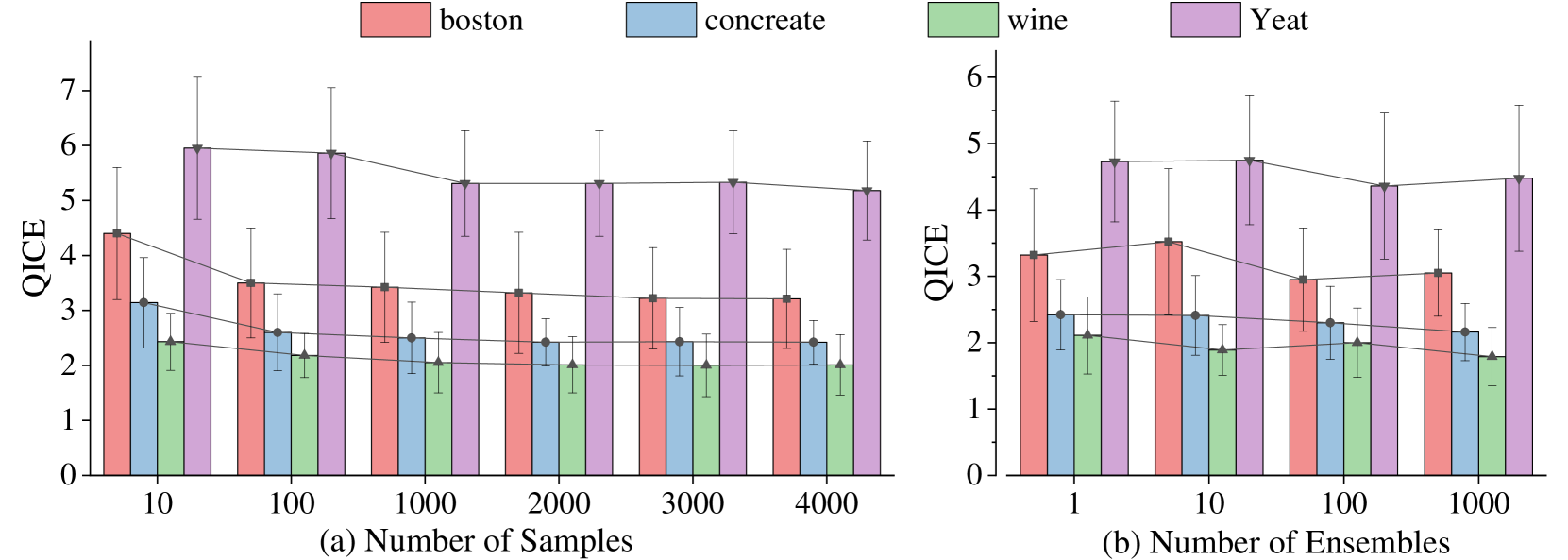

3.4 烧蚀研究的样品和集合的数量

我们研究了由DistPred生成的样本数量以及DistPred-MCD的集合数量对它们各自性能的影响。如图6所示,随着输出样本和集合数量的增加,模型的性能逐渐提高,最终达到饱和点。

图6: DistPred中样品数量(a)和DistPred- mcd中集合数量(b)的消融研究。

3.5 时间序列分布预测

我们扩展了时间序列预测(Zhou et al., 2021a;Wu et al., 2021;Zhou et al., 2022;Liu et al., 2023)从点估计到分布预测的任务,以推断出关于某个时刻的更多统计信息。

有关数据集的详细信息可以在附录中找到。在实验中使用的模型在广泛的预测长度范围内进行评估,以比较不同未来视界的表现:96、192、336和720。多变量和单变量任务的实验设置是相同的。我们使用MSE和MAE的平均值( M S E + M A E 2 \frac{MSE+MAE}{2} 2MSE+MAE)来评估模型的整体性能。值得注意的是,DistPred提供了响应变量的集合 Y ^ \hat{Y} Y^。因此,我们采用 Y ^ \hat{Y} Y^的平均值作为该时刻的点估计。

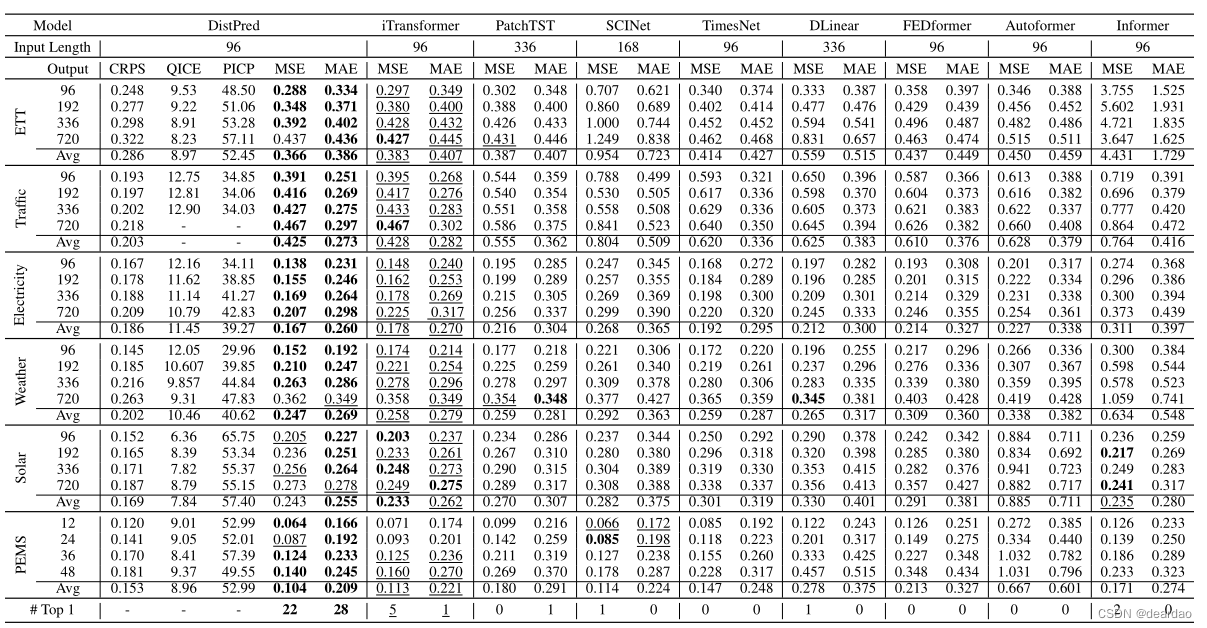

表3: 6个基准数据集的多元时间序列预测结果。

表3列出了多变量TS预测的结果,最优结果用粗体 突出显示,次优结果用下划线强调。可以发现,尽管没有使用MSE和MAE, DistPred在所有数据集和预测长度配置上都达到了最先进的性能。iTransformer和PatchTST以其卓越的平均性能脱颖而出,成为公认的最新型号。与它们相比,所提出的DistPred的平均性能分别提高了3.5%和16.5%,实现了实质性的性能提升。我们提供的指标,如CRPS, QICE, PICP,供未来的研究界比较。

4 结论

本文提出了一种新的方法,称为DistPred,它是一种用于回归和预测任务的无分布概率推理方法。我们将测量预测分布与目标分布之间差异的适当评分规则转换为可微离散形式,并将其用作损失函数来端到端训练模型。这允许模型在单个前向传递中采样大量样本,以估计响应变量的潜在分布。我们还提出了一种称为DistPred-MCD的混合方法,该方法将DistPred与MC Dropout相结合,进一步提高了不确定量化的性能。实验结果表明,DistPred优于现有的方法,通常有相当大的差距。我们还将时间序列预测从点估计扩展到分布预测,并在多变量和单变量时间序列预测任务上取得了最先进的性能。在未来,我们计划将DistPred扩展到其他任务,如分类和强化学习。

1\] Liang D, Zhang H, Yuan D, et al. DistPred: A Distribution-Free Probabilistic Inference Method for Regression and Forecasting\[J\]. arXiv preprint arXiv:2406.11397, 2024.