文章目录

- 前言

- 一、实现功能

- 二、py功能讲解

-

- 1.agent.py

- 2.game.py

- [3 model.py](#3 model.py)

- [4 reload_agent.py](#4 reload_agent.py)

- [5 play_step.py](#5 play_step.py)

- 总结

前言

参考大佬博主的代码修改了一些,实现了基于python实现强化学习的贪吃蛇游戏以下功能!

一、实现功能

1 贪吃蛇的游戏操纵

2 贪吃蛇的强化学习

3 重新加载学习后的权重

二、py功能讲解

1.agent.py

这段代码实现了一个贪婪策略的蛇游戏AI训练过程。整个训练过程分为以下几个步骤:

- 导入必要的模块和类:包括游戏相关的模块和类、PyTorch库、NumPy库、神经网络模型和训练器类、双向队列类、随机数模块以及操作系统模块等。

- 定义Agent类:Agent类是整个训练过程的核心,其中包含了模型的初始化、获取动作、获取状态、记忆、短期记忆训练、长期记忆训练、保存模型和加载模型等方法。

- 初始化Agent:在训练函数中创建Agent对象,加载模型权重,并创建游戏对象。

- 训练循环:在循环中,Agent根据当前游戏状态获取动作,执行动作并获取奖励、下一状态和游戏是否结束的信息,然后将这些信息用于训练短期记忆和长期记忆。

- 保存模型:如果游戏结束且当前得分高于最高分,则更新最高分并保存模型权重。

- 输出信息:在每次游戏结束后,输出当前游戏次数、得分和最高分,并计算并输出平均得分。

2.game.py

这段代码实现了一个贪吃蛇游戏的基本逻辑,包括游戏初始化、重置、游戏进行、碰撞检测、移动等功能。具体功能如下:

- 导入所需模块:包括re模块的S标志、matplotlib的collections模块、pygame库、Enum枚举类、random模块、namedtuple和deque类以及numpy库。

- 初始化pygame,并设置一些游戏参数,如方块大小、颜色常量、游戏速度和字体。

- 定义了一个Point命名元组用于表示坐标点,以及一个Direction枚举类表示移动方向。

- 定义了SnakeGameAI类,实现了贪吃蛇游戏的各种功能。

• __init__方法用于初始化游戏窗口和一些游戏参数,包括窗口大小、初始移动方向等。

• reset方法用于重置游戏状态,包括初始化蛇头、蛇身、食物位置等。

• _place_food方法用于随机放置食物,确保食物不会出现在蛇身上。

• play_step方法用于执行游戏的每一步逻辑,包括移动蛇头、检查游戏是否结束、判断是否吃到食物等。

• is_collision方法用于判断是否发生碰撞,包括是否撞到墙壁或者撞到自己的身体。

• _update_ui方法用于更新游戏界面,包括绘制蛇、食物和分数等信息。

• _move方法用于移动蛇头,根据传入的动作确定新的移动方向,并更新蛇头的位置。 - 最后,使用pygame的事件循环来运行游戏,不断调用play_step方法来执行游戏逻辑,实现游戏的进行。

3 model.py

这段代码定义了一个简单的神经网络模型 Linear_QNet 和一个 Q 学习训练器 QTrainer。下面是代码的功能描述:

- Linear_QNet 类是一个简单的前馈神经网络模型,包含一个输入层、一个隐藏层和一个输出层。init 方法初始化模型结构,forward 方法定义了模型的前向传播过程,将输入数据传入网络并返回输出结果。save_model 方法用于保存模型的参数到文件。

- QTrainer 类用于训练 Q 学习模型。init 方法初始化训练器,接受一个神经网络模型、学习率和折扣因子作为参数。在初始化过程中,创建了一个 Adam 优化器和一个均方误差损失函数。train_step 方法用于执行 Q 学习的训练步骤,接受状态、动作、奖励、下一个状态和游戏结束标志作为输入,根据 Q 学习算法更新模型参数,以优化模型的预测能力。

4 reload_agent.py

这段代码实现了一个基于深度 Q 网络(DQN)的贪婪蛇类游戏智能体。主要包含以下几个部分:

- Agent 类:定义了智能体的结构和行为。智能体根据当前状态选择动作,并根据选择的动作与环境交互并获取奖励。智能体使用经验回放机制来训练神经网络模型,其中包括短期记忆训练和长期记忆训练。

- Linear_QNet 类:定义了一个简单的线性神经网络模型,用于近似 Q 值函数。模型接收一个状态向量作为输入,并输出每个动作的 Q 值。

- QTrainer 类:定义了一个 Q 学习训练器,用于训练神经网络模型。训练器使用均方误差损失函数来计算误差,并使用 Adam 优化器来更新模型参数。

- train 函数:主要实现了智能体的训练过程。在每一轮游戏中,智能体根据当前状态选择动作,并与环境交互。交互过程中,智能体根据获得的奖励和新状态更新模型参数,并将经验存储到记忆中。当游戏结束时,智能体根据存储的记忆训练模型,并更新最高分数记录。

5 play_step.py

相当于普通的贪吃蛇游戏,上下左右控制,可以在代码里面调整速度。

总结

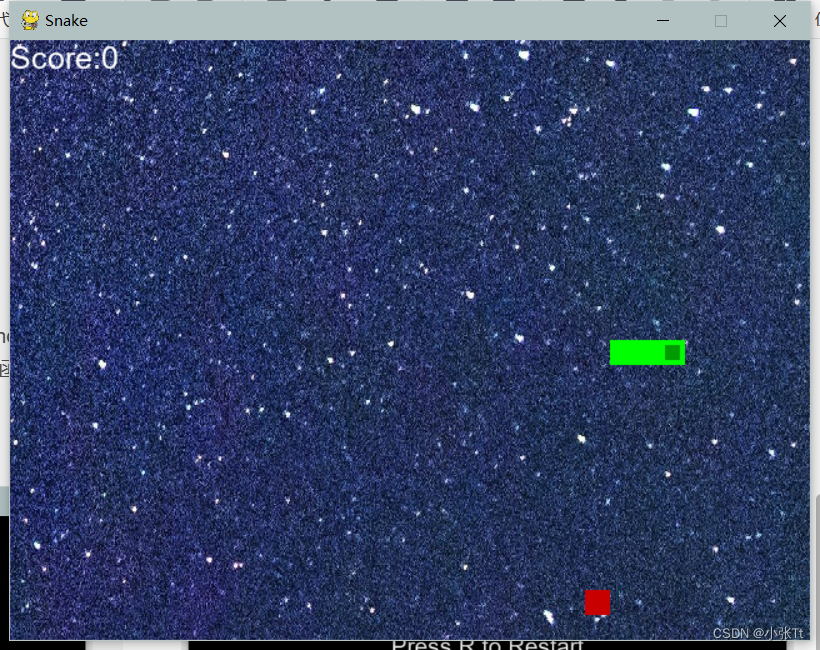

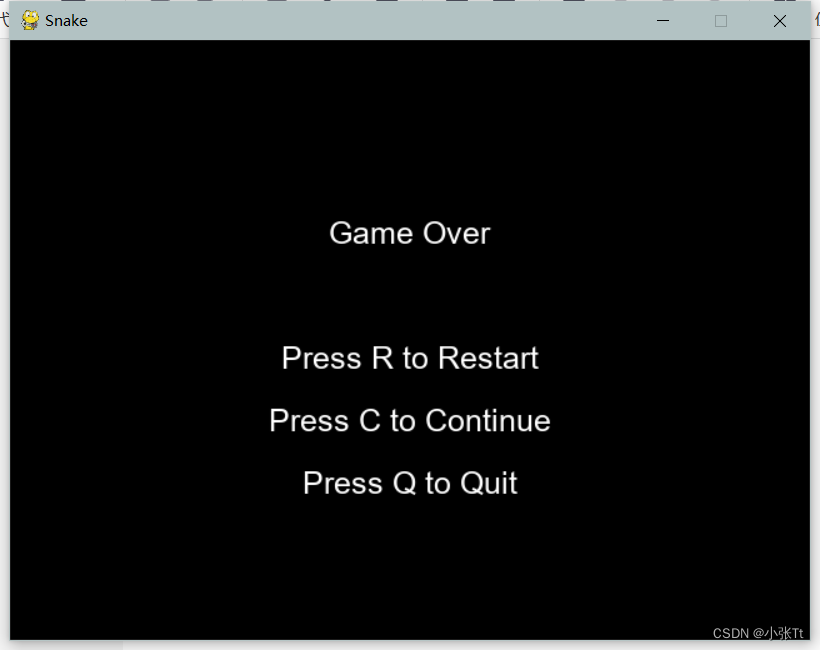

效果如下: