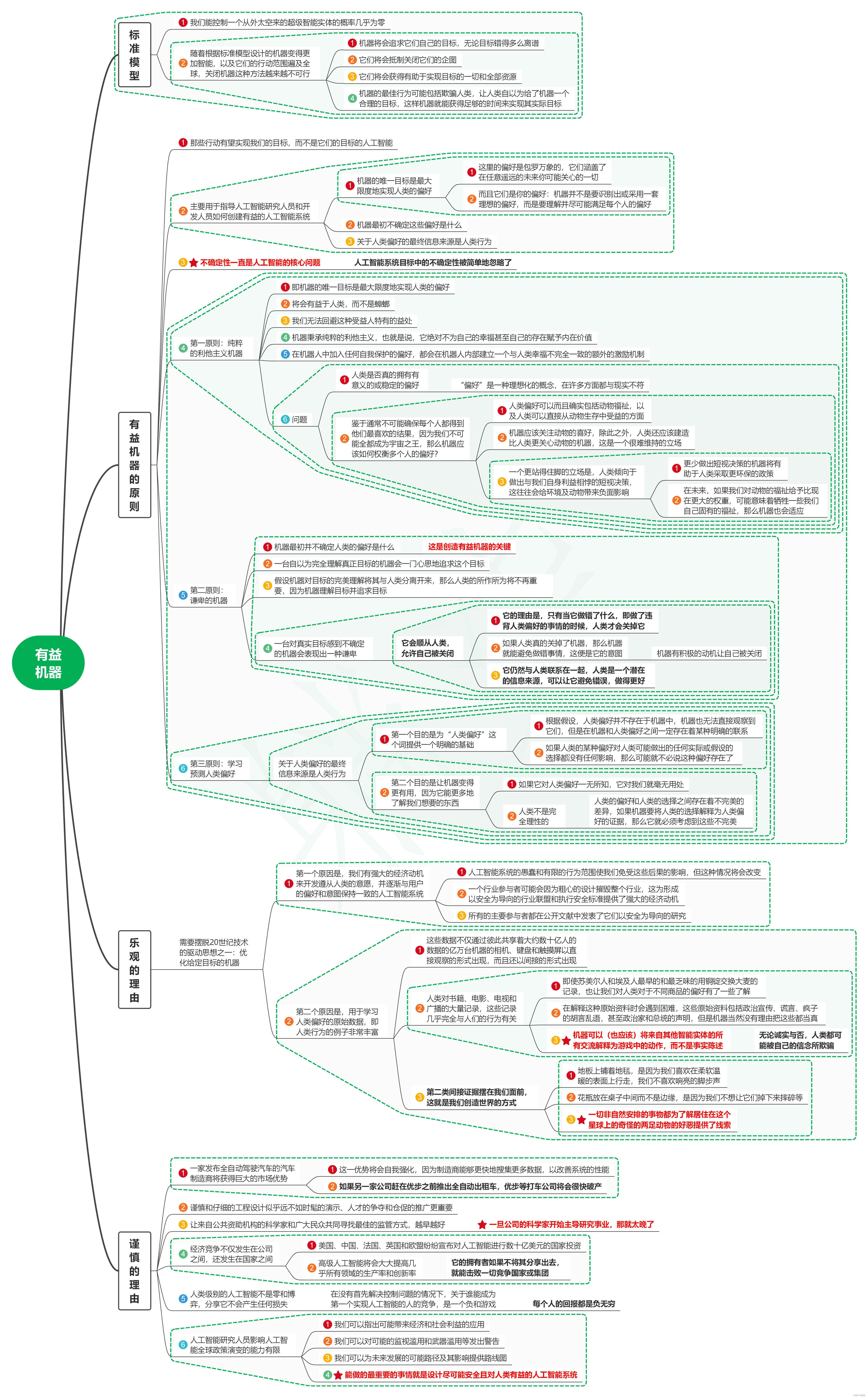

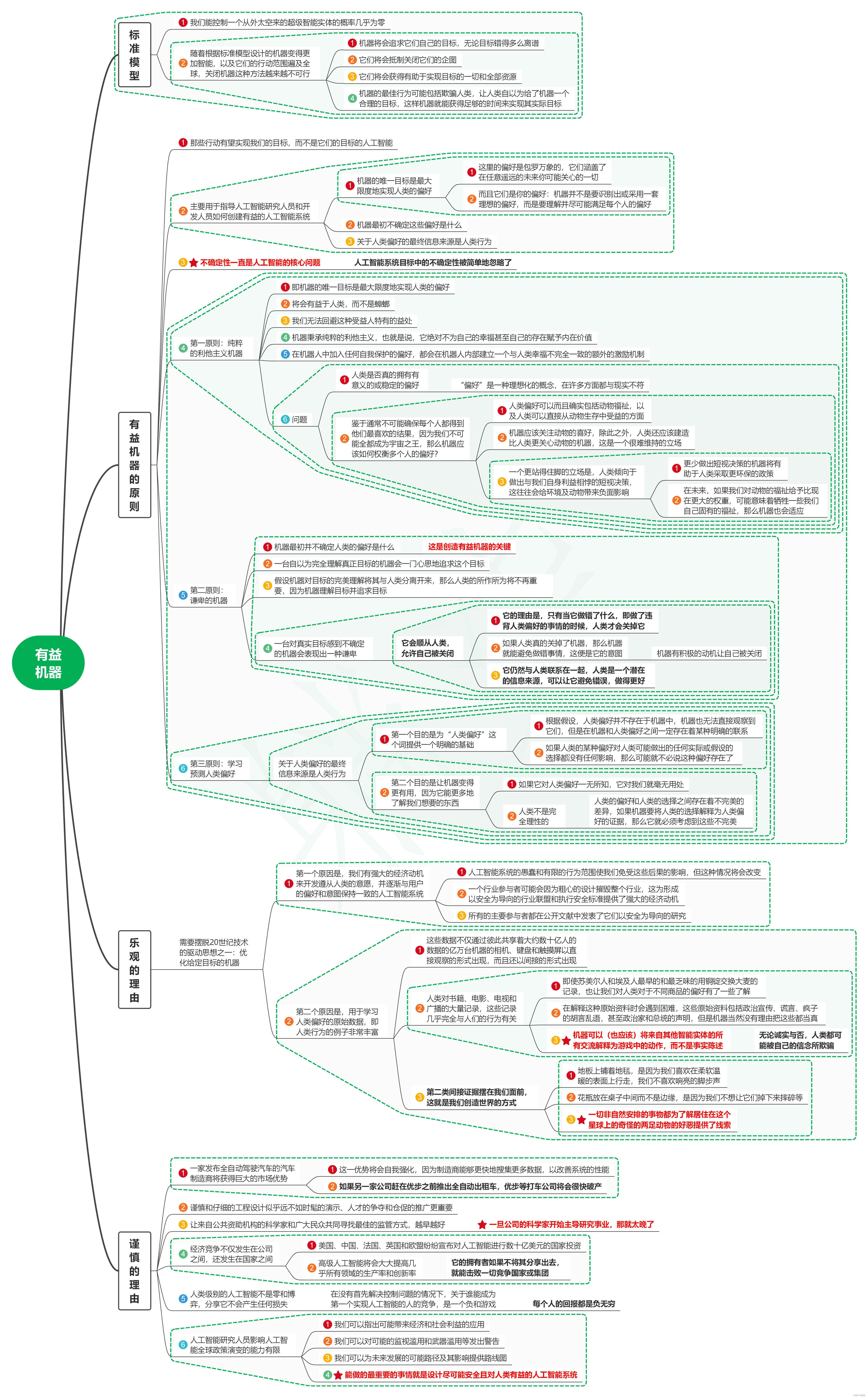

读AI新生:破解人机共存密码笔记13有益机器

1. 标准模型

1.1. 我们能控制一个从外太空来的超级智能实体的概率几乎为零

1.2. 随着根据标准模型设计的机器变得更加智能,以及它们的行动范围遍及全球,关闭机器这种方法越来越不可行

1.2.1. 机器将会追求它们自己的目标,无论目标错得多么离谱

1.2.2. 它们将会抵制关闭它们的企图

1.2.3. 它们将会获得有助于实现目标的一切和全部资源

1.2.4. 机器的最佳行为可能包括欺骗人类,让人类自以为给了机器一个合理的目标,这样机器就能获得足够的时间来实现其实际目标

2. 有益机器的原则

2.1. 那些行动有望实现我们的目标,而不是它们的目标的人工智能

2.2. 主要用于指导人工智能研究人员和开发人员如何创建有益的人工智能系统

2.2.1. 机器的唯一目标是最大限度地实现人类的偏好

2.2.1.1. 这里的偏好是包罗万象的,它们涵盖了在任意遥远的未来你可能关心的一切

2.2.1.2. 而且它们是你的偏好:机器并不是要识别出或采用一套理想的偏好,而是要理解并尽可能满足每个人的偏好

2.2.2. 机器最初不确定这些偏好是什么

2.2.3. 关于人类偏好的最终信息来源是人类行为

2.3. 不确定性一直是人工智能的核心问题

2.3.1. 人工智能系统目标中的不确定性被简单地忽略了

2.4. 第一原则:纯粹的利他主义机器

2.4.1. 即机器的唯一目标是最大限度地实现人类的偏好

2.4.2. 将会有益于人类,而不是蟑螂

2.4.3. 我们无法回避这种受益人特有的益处

2.4.4. 机器秉承纯粹的利他主义,也就是说,它绝对不为自己的幸福甚至自己的存在赋予内在价值

2.4.5. 在机器人中加入任何自我保护的偏好,都会在机器人内部建立一个与人类幸福不完全一致的额外的激励机制

2.4.6. 问题

2.4.6.1. 人类是否真的拥有有意义的或稳定的偏好

2.4.6.1.1. "偏好"是一种理想化的概念,在许多方面都与现实不符

2.4.6.2. 鉴于通常不可能确保每个人都得到他们最喜欢的结果,因为我们不可能全都成为宇宙之王,那么机器应该如何权衡多个人的偏好?

2.4.6.2.1. 人类偏好可以而且确实包括动物福祉,以及人类可以直接从动物生存中受益的方面

2.4.6.2.2. 机器应该关注动物的喜好,除此之外,人类还应该建造比人类更关心动物的机器,这是一个很难维持的立场

2.4.6.2.3. 一个更站得住脚的立场是,人类倾向于做出与我们自身利益相悖的短视决策,这往往会给环境及动物带来负面影响

2.4.6.2.3.1. 更少做出短视决策的机器将有助于人类采取更环保的政策

2.4.6.2.3.2. 在未来,如果我们对动物的福祉给予比现在更大的权重,可能意味着牺牲一些我们自己固有的福祉,那么机器也会适应

2.5. 第二原则:谦卑的机器

2.5.1. 机器最初并不确定人类的偏好是什么

2.5.1.1. 这是创造有益机器的关键

2.5.2. 一台自以为完全理解真正目标的机器会一门心思地追求这个目标

2.5.3. 假设机器对目标的完美理解将其与人类分离开来,那么人类的所作所为将不再重要,因为机器理解目标并追求目标

2.5.4. 一台对真实目标感到不确定的机器会表现出一种谦卑

2.5.4.1. 它会顺从人类,允许自己被关闭

2.5.4.1.1. 它的理由是,只有当它做错了什么,即做了违背人类偏好的事情的时候,人类才会关掉它

2.5.4.1.2. 如果人类真的关掉了机器,那么机器就能避免做错事情,这便是它的意图

2.5.4.1.2.1. 机器有积极的动机让自己被关闭

2.5.4.1.3. 它仍然与人类联系在一起,人类是一个潜在的信息来源,可以让它避免错误,做得更好

2.6. 第三原则:学习预测人类偏好

2.6.1. 关于人类偏好的最终信息来源是人类行为

2.6.1.1. 第一个目的是为"人类偏好"这个词提供一个明确的基础

2.6.1.1.1. 根据假设,人类偏好并不存在于机器中,机器也无法直接观察到它们,但是在机器和人类偏好之间一定存在着某种明确的联系

2.6.1.1.2. 如果人类的某种偏好对人类可能做出的任何实际或假设的选择都没有任何影响,那么可能就不必说这种偏好存在了

2.6.1.2. 第二个目的是让机器变得更有用,因为它能更多地了解我们想要的东西

2.6.1.2.1. 如果它对人类偏好一无所知,它对我们就毫无用处

2.6.1.2.2. 人类不是完全理性的

2.6.1.2.2.1. 人类的偏好和人类的选择之间存在着不完美的差异,如果机器要将人类的选择解释为人类偏好的证据,那么它就必须考虑到这些不完美

3. 乐观的理由

3.1. 需要摆脱20世纪技术的驱动思想之一:优化给定目标的机器

3.1.1. 第一个原因是,我们有强大的经济动机来开发遵从人类的意愿,并逐渐与用户的偏好和意图保持一致的人工智能系统

3.1.1.1. 人工智能系统的愚蠢和有限的行为范围使我们免受这些后果的影响,但这种情况将会改变

3.1.1.2. 一个行业参与者可能会因为粗心的设计摧毁整个行业,这为形成以安全为导向的行业联盟和执行安全标准提供了强大的经济动机

3.1.1.3. 所有的主要参与者都在公开文献中发表了它们以安全为导向的研究

3.1.2. 第二个原因是,用于学习人类偏好的原始数据,即人类行为的例子非常丰富

3.1.2.1. 这些数据不仅通过彼此共享着大约数十亿人的数据的亿万台机器的相机、键盘和触摸屏以直接观察的形式出现,而且还以间接的形式出现

3.1.2.2. 人类对书籍、电影、电视和广播的大量记录,这些记录几乎完全与人们的行为有关

3.1.2.2.1. 即使苏美尔人和埃及人最早的和最乏味的用铜锭交换大麦的记录,也让我们对人类对于不同商品的偏好有了一些了解

3.1.2.2.2. 在解释这种原始资料时会遇到困难,这些原始资料包括政治宣传、谎言、疯子的胡言乱语,甚至政治家和总统的声明,但是机器当然没有理由把这些都当真

3.1.2.2.3. 机器可以(也应该)将来自其他智能实体的所有交流解释为游戏中的动作,而不是事实陈述

3.1.2.2.3.1. 无论诚实与否,人类都可能被自己的信念所欺骗

3.1.2.3. 第二类间接证据摆在我们面前,这就是我们创造世界的方式

3.1.2.3.1. 地板上铺着地毯,是因为我们喜欢在柔软温暖的表面上行走,我们不喜欢响亮的脚步声

3.1.2.3.2. 花瓶放在桌子中间而不是边缘,是因为我们不想让它们掉下来摔碎等

3.1.2.3.3. 一切非自然安排的事物都为了解居住在这个星球上的奇怪的两足动物的好恶提供了线索

4. 谨慎的理由

4.1. 一家发布全自动驾驶汽车的汽车制造商将获得巨大的市场优势

4.1.1. 这一优势将会自我强化,因为制造商能够更快地搜集更多数据,以改善系统的性能

4.1.2. 如果另一家公司赶在优步之前推出全自动出租车,优步等打车公司将会很快破产

4.2. 谨慎和仔细的工程设计似乎远不如时髦的演示、人才的争夺和仓促的推广更重要

4.3. 让来自公共资助机构的科学家和广大民众共同寻找最佳的监管方式,越早越好

4.3.1. 一旦公司的科学家开始主导研究事业,那就太晚了

4.4. 经济竞争不仅发生在公司之间,还发生在国家之间

4.4.1. 美国、中国、法国、英国和欧盟纷纷宣布对人工智能进行数十亿美元的国家投资

4.4.2. 高级人工智能将会大大提高几乎所有领域的生产率和创新率

4.4.2.1. 它的拥有者如果不将其分享出去,就能击败一切竞争国家或集团

4.5. 人类级别的人工智能不是零和博弈,分享它不会产生任何损失

4.5.1. 在没有首先解决控制问题的情况下,关于谁能成为第一个实现人工智能的人的竞争,是一个负和游戏

4.5.1.1. 每个人的回报都是负无穷

4.6. 人工智能研究人员影响人工智能全球政策演变的能力有限

4.6.1. 我们可以指出可能带来经济和社会利益的应用

4.6.2. 我们可以对可能的监视滥用和武器滥用等发出警告

4.6.3. 我们可以为未来发展的可能路径及其影响提供路线图

4.6.4. 能做的最重要的事情就是设计尽可能安全且对人类有益的人工智能系统