背景

现在国内外拥有上百个大语言模型,在AI业务中,我们需要在其中选择一个合适业务模型,就需要对这些模型进行测试。手工去测试这么多模型效率一定不高,今天就介绍两个提高测评模型效率的工具 ChatHub和ChatAll。

介绍

ChatHub和ChatAll都是all-in-one的方式,集成了市面上主流的大语言模型,可以同时和多个模型对话。

ChatHub

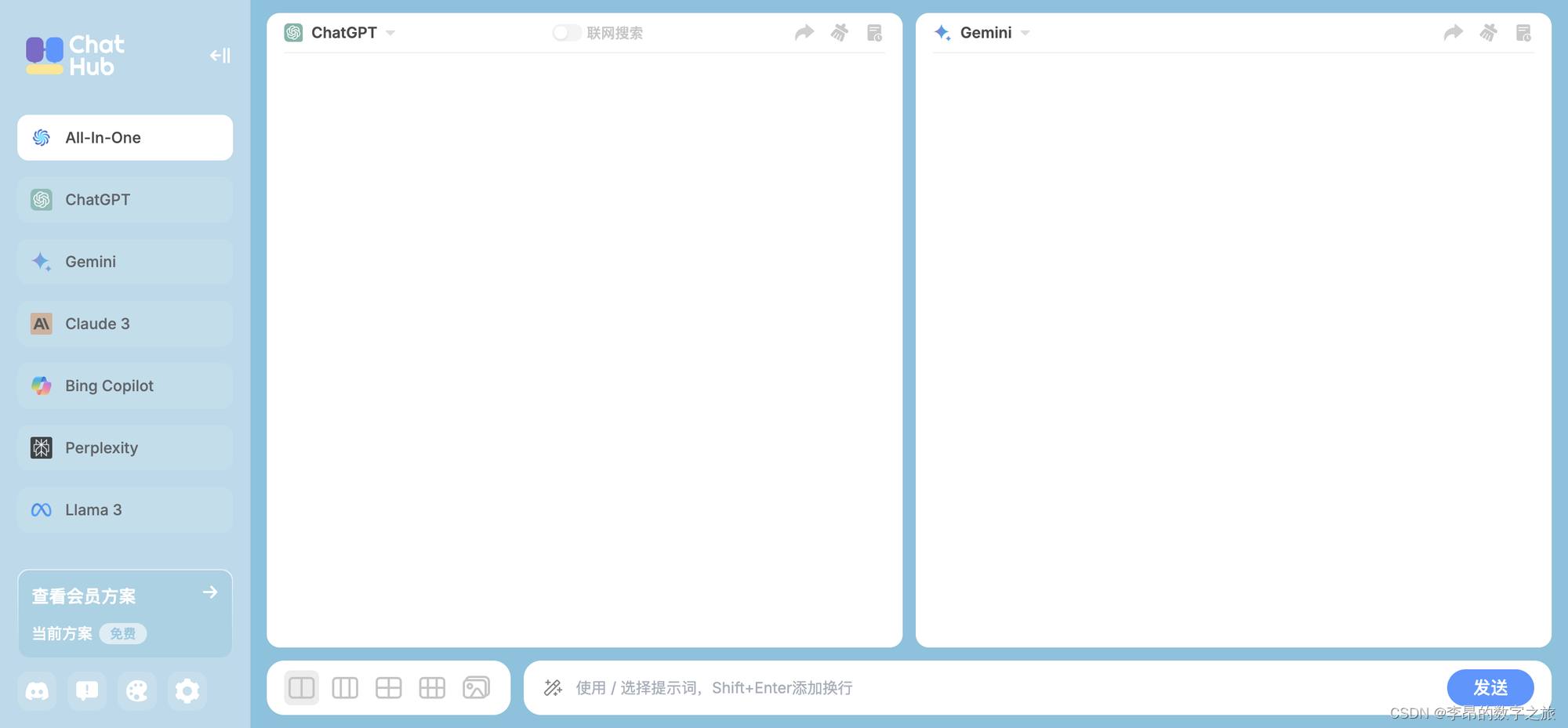

ChatHub是一个国外的项目,它能通过chrome的插件,直接在浏览器上运行。运行后的界面长这样:

这里可以选择多个模型,然后发送消息后,多个模型同时产生回复。

支持的模型种类

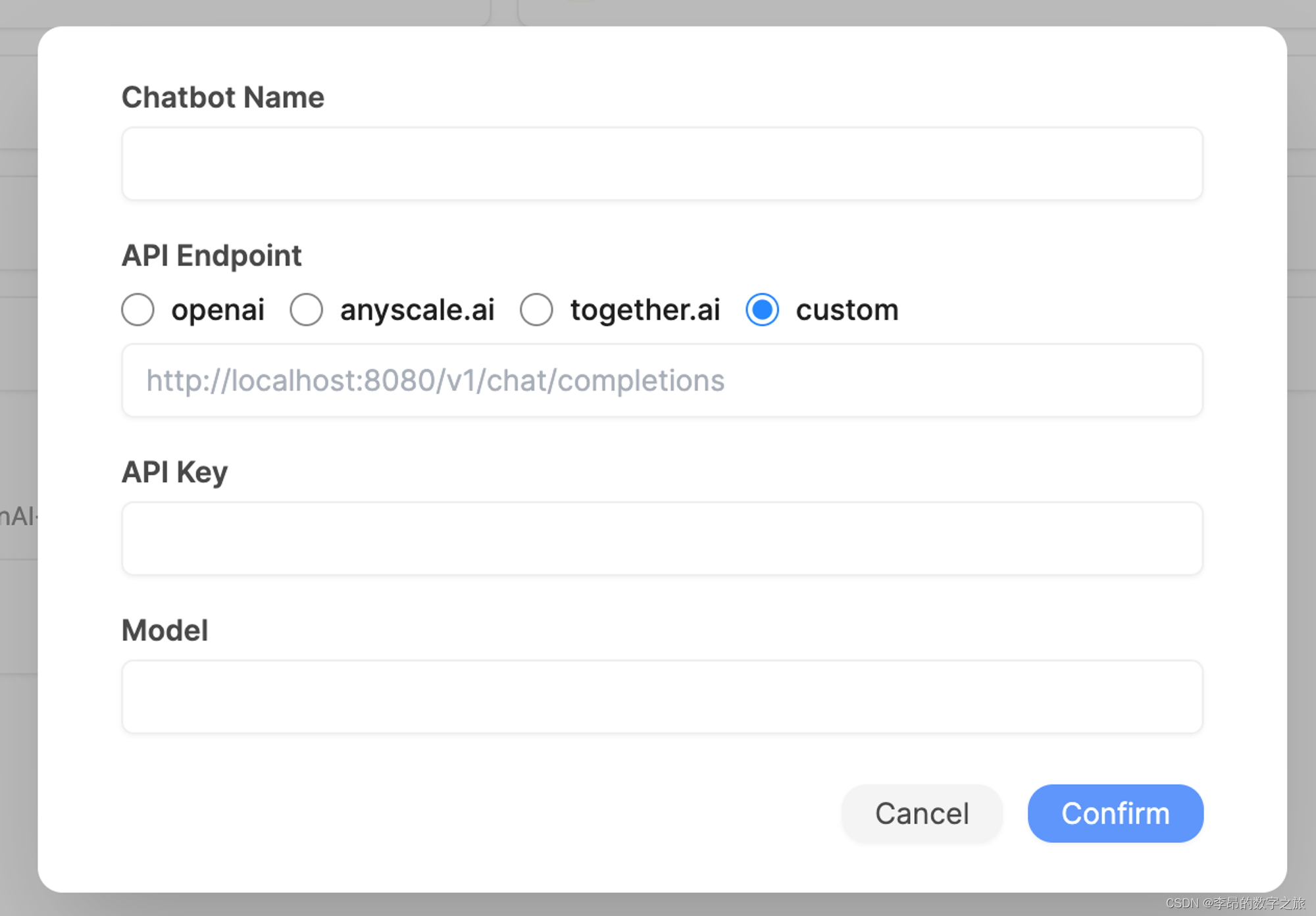

支持国外主流模型和开源的模型,也支持自定义接口来扩展本地模型。

ChatAll

ChatAll是国内的项目,github上可以直接下载安装包,支持linux、maxOS、windows,下载地址是下载地址 。下载后打开界面长这样:

在下面选中对应的模型,对话框里就能直接开始对话。有些模型需要登录后才能使用,会弹出一个登录页面。登录后,估计是把cookie给拿过去了,直接去调用对应模型的web接口。有些模型没有web页面,就要通过open api的方式访问,就需要输入对应api的key。

代理支持

国内无法访问ChatGPT,工具里也支持设置代理。

对话总结

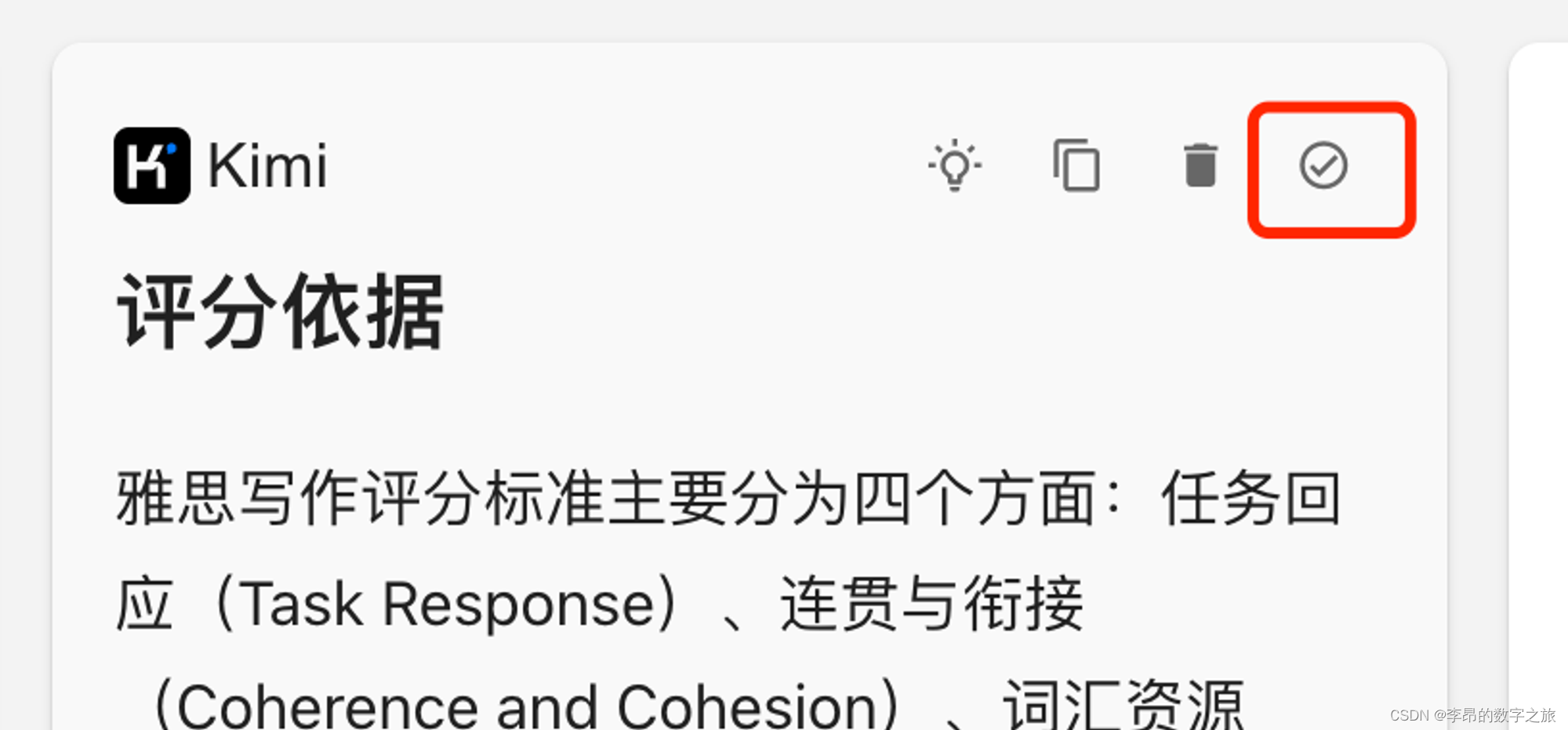

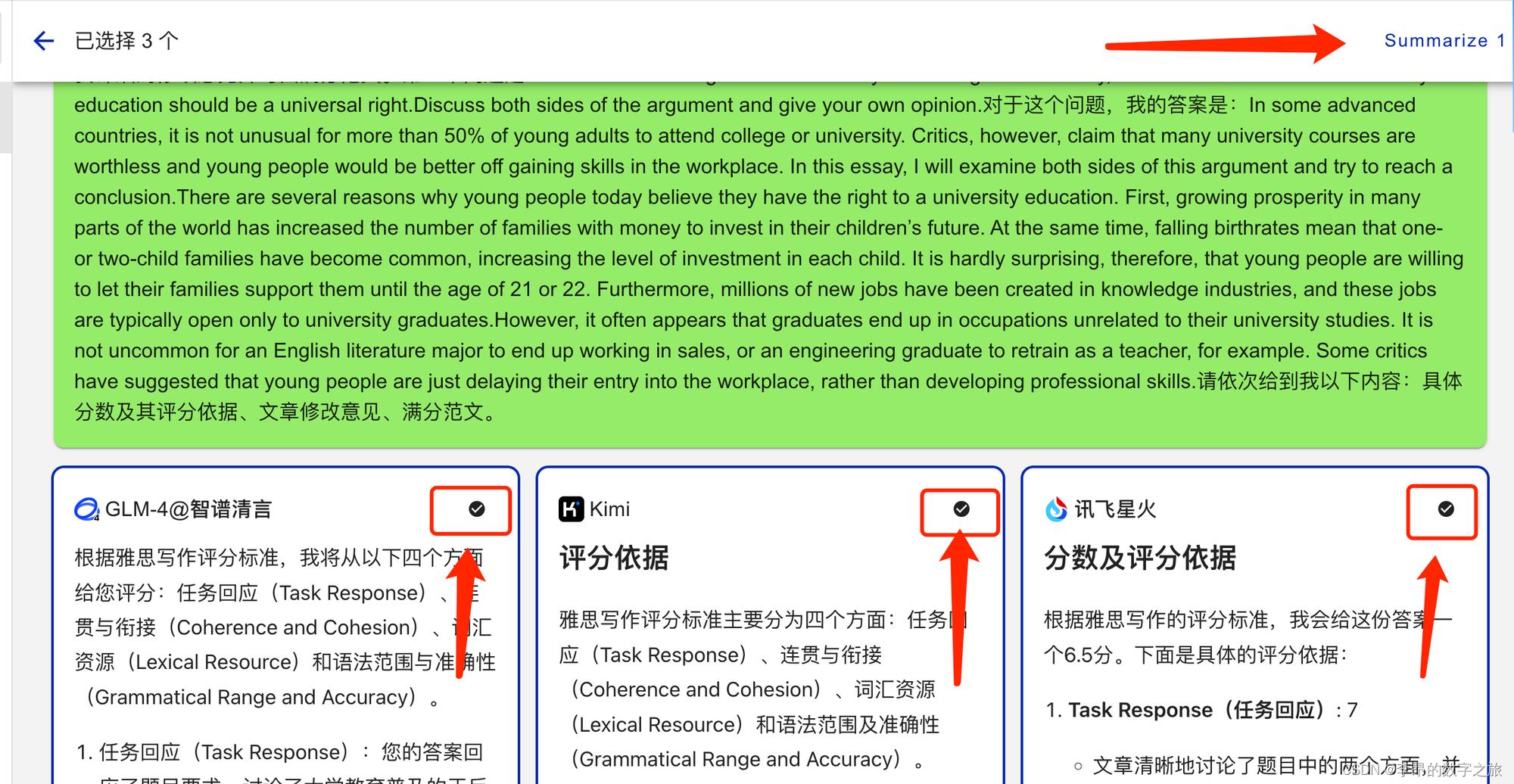

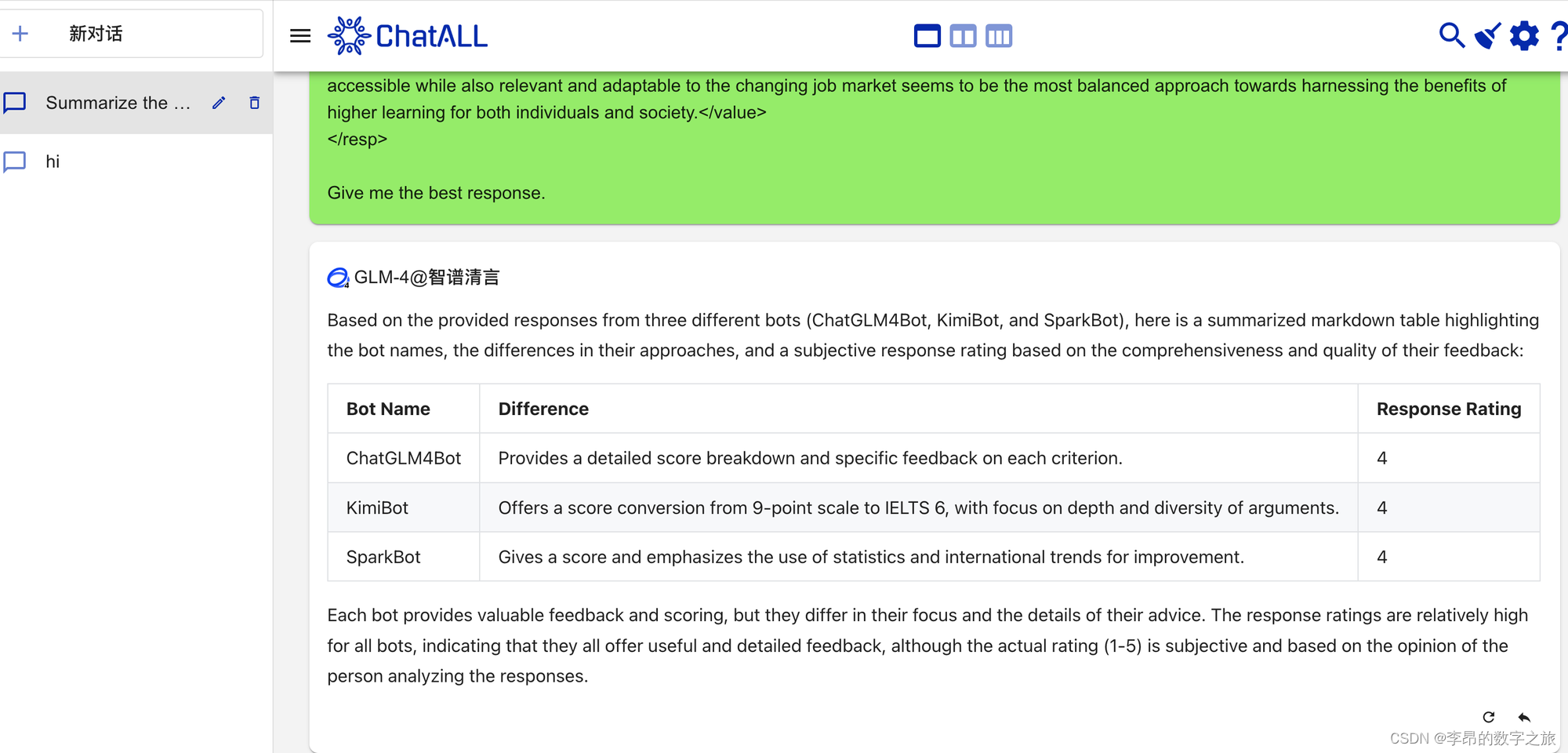

在得到多个模型得到回答后,还支持对它们的内容进行总结输出。勾选输出框里的√,然后点击上面的sumarize按钮。

生成总结出的内容:

总体来说,ChatAll比Chathub好用,因为纯免费。也存在一些缺陷,好多模型对话都出问题了。

思考

ChatHub和ChatAll在形式上,帮我们节约了很多模型对接和对话选型的时间。但是选择模型不仅仅是产生对话数据,需要对比评分,最后是看综合得分才会选择某个模型。如果这两个工具能把评价的流程也加入进行,那么就可以在一个工具上,完成模型的选型工作了。