炸裂!阿里巴巴的云计算部门刚刚发布了一款全新的 AI 模型 ------Qwen2-VL,而且一口气发布了20亿参数和70亿参数两个版本,还开放了最强720亿参数版本的API!

小伙伴们可能要问了,这个Qwen2-VL到底有多厉害?

01、 Qwen2-VL有多厉害?

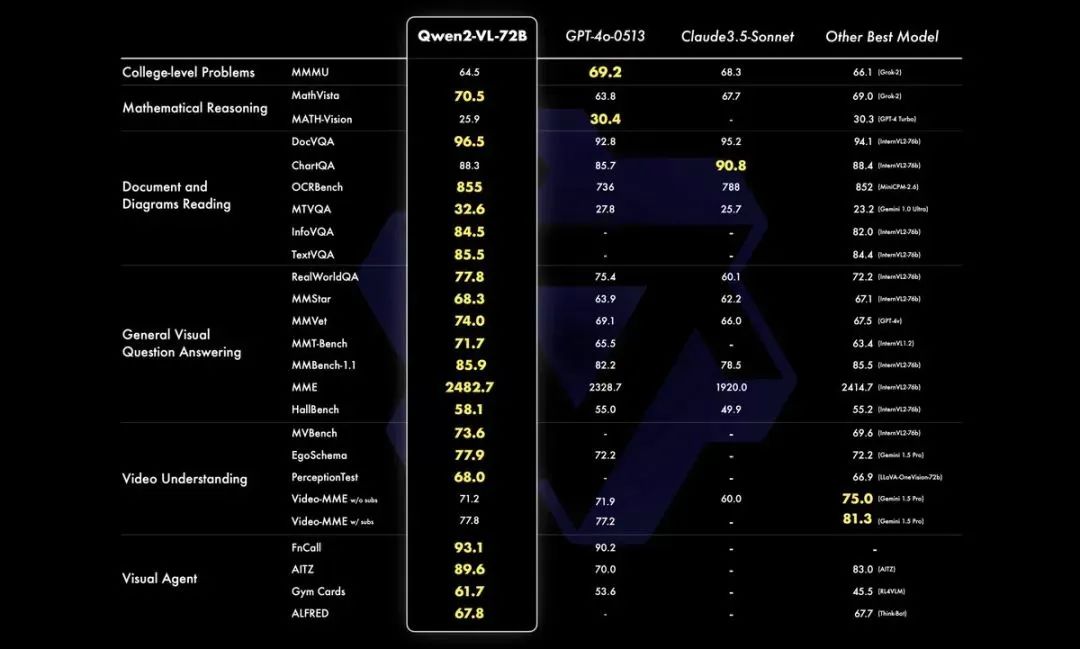

· 看得清,看得懂: Qwen2-VL 在各种视觉理解任务上都取得了 SOTA 成绩,包括 MathVista、DocVQA、RealWorldQA、MTVQA 等等。无论是图像分辨率还是长宽比,都难不倒它~

**· 20分钟长视频也不怕:**Qwen2-VL 能理解超过 20 分钟的视频,可以用来做高质量的视频问答、对话、内容创作等等。这意味着,无论是在线学习、技术支持,还是任何需要对视频内容进行理解的场合,Qwen2-VL 都可以成为得力助手。

· 可操作手机、机器人等的Agent: Qwen2-VL 还能跟手机、机器人等设备结合,实现自动操作!它强大的推理和决策能力,加上对视觉环境和文本指令的理解,让它成为真正的"智能管家"

· 多语言支持,全球用户都能用: 除了英语和中文,Qwen2-VL 现在还支持识别图像中的多种语言文本,包括大部分欧洲语言、日语、韩语、阿拉伯语、越南语等等,真正做到了面向全球用户!

02、 三个版本

这款新模型有三个不同参数的版本,分别是 Qwen2-VL-72B(720亿参数)、Qwen2-VL-7B 和 Qwen2-VL-2B。其中,7B 和2B 版本在开源宽松的 Apache2.0许可证下提供,允许企业随意将它们用于商业目的。

不过,最大的72B 版本目前还没有公开,只能通过专门的许可证和 API 获取。

03、 案例展示

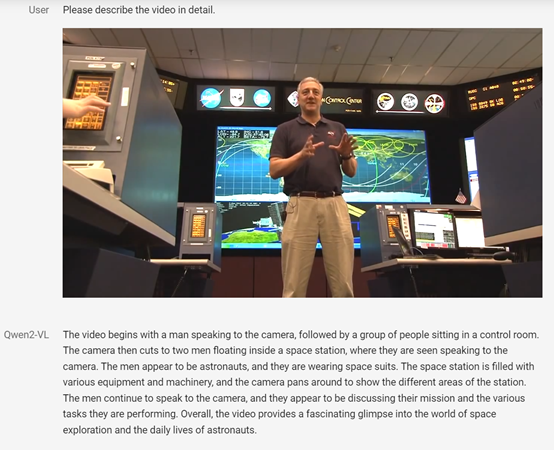

目前,阿里已经展示了Qwen2-VL的多个实际应用案例,例如,对一大段视频进行详细解读:

用户:请详细描述一下视频。

Qwen2-VL:视频开始时,一名男子对着镜头说话,后面是一群人坐在控制室里。然后镜头切换到两个漂浮在空间站内的男子,可以看到他们对着镜头说话。这些人似乎是宇航员,他们穿着太空服。

空间站里充满了各种设备和机械,镜头四处移动以显示空间站的不同区域。这些人继续对着镜头说话,他们似乎在讨论他们的使命和正在执行的各种任务。总的来说,该视频让人们对太空探索的世界和宇航员的日常生活有了一个有趣的了解。

用户还可以基于视频继续提问,两位宇航员穿的衣服是什么颜色的?Qwen2-VL回答:两名宇航员穿着蓝色和黑色的衣服。

产品入口:

https://qwenlm.github.io/blog/qwen2-vl/

在线demo:

https://huggingface.co/spaces/Qwen/Qwen2-VL

*西安觉醒元宇宙AI,是专注线上AI培训、AI绘画辅导、AI开发服务的专业教育平台!

▍扫描下方二维码进入AI交流学习群,获取超多AI前沿知识!