在linux上部署ollama+open-webu,且局域网访问教程

本文主要介绍如何在Windows系统快速部署Ollama开源大语言模型运行工具,并使用Open WebUI

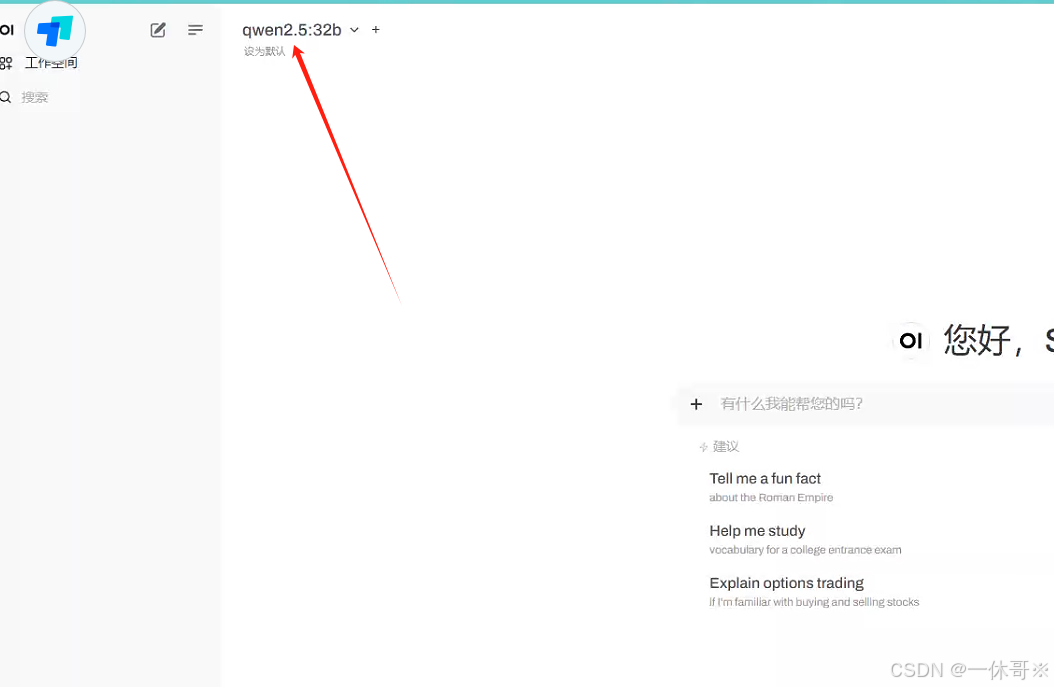

经使用,qwen2.5:32b模型效果很好,在24gb模型上速度很快

目录

Ollama支持当前主要的开源大模型, 比如llama2、千文qwen、mistral等,可以在Windows、Linux、MacOS系统上进行部署。稳定性和便利性都非常不错,下面就来分享一下它在Linux系统上的安装与应用。

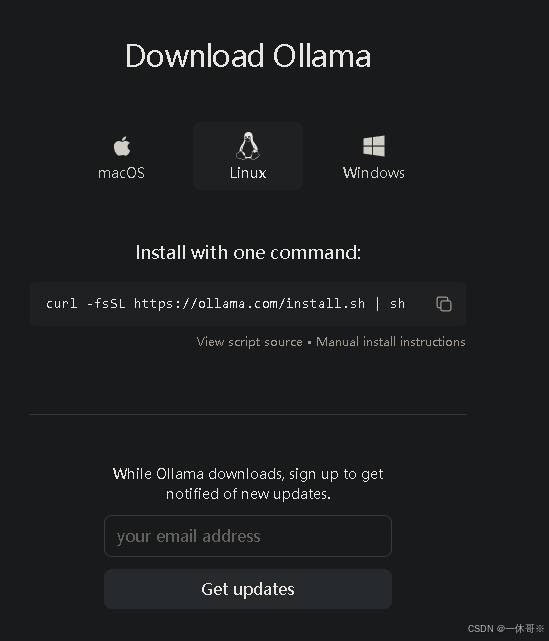

运行ollama

运行后直接自动安装

bash

curl -fsSL https://ollama.com/install.sh | sh

ollama运行

现在Ollama已经安装完了,我们需要在终端中输入下方命令运行一个大语言模型进行测试,这里以对在中文方面表现相对好些的千问为例,大家也可以使用其他的模型。

bash

ollama serve在另一个终端中,验证 Ollama 是否正在运行:

bash

ollama -v设置ollama的参数设置,/etc/systemd/system/ollama.service

bash

sudo vim /etc/systemd/system/ollama.service输入以下的参数:

bash

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/local/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="PATH=/home/lvting/anaconda3/bin:/home/lvting/anaconda3/bin:/home/lvting/anaconda3/condabin:/home/lvting/.vscode-server/cli/servers/Stable-384ff7382de624fb94dbaf6da11977bba1ecd427/server/bin/remote-cli:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/games:/usr/local/games:/snap/bin"

Environment="OLLAMA_MODELS=/data/lt/1/.ollama/" # 设置模型下载的路径

Environment="OLLAMA_HOST=0.0.0.0" #可访问

Environment="OLLAMA_ORIGINS=*"

[Install]

WantedBy=default.target然后启动服务:

bash

sudo systemctl daemon-reload

sudo systemctl enable ollama

sudo systemctl start ollama

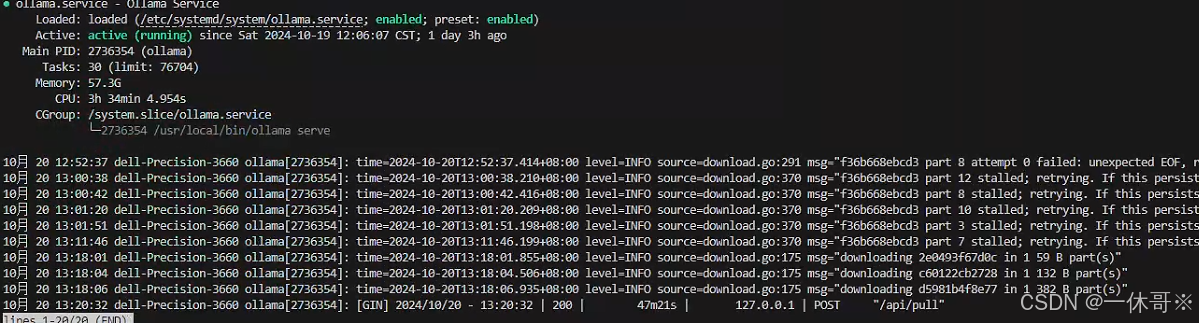

sudo systemctl status ollama

这样说明就启动了

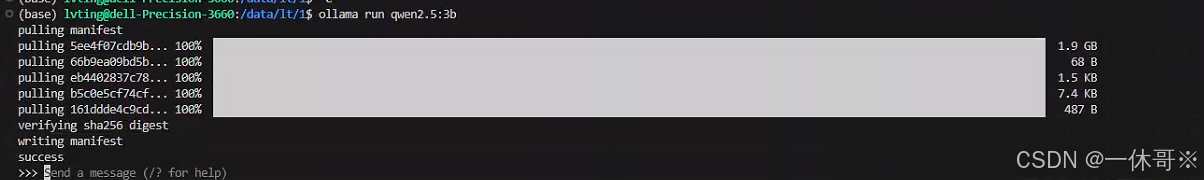

运行qwen2.5模型

bash

ollama run qwen2.5:3b

然后直接输入问题就可以回答了

open-webui

虽然直接使用ollama的方法可以用,但是不太方便,使用webui的可视化更简洁明了

安装open-webui

首先在linux中安装open-webui:

使用默认配置安装:

刚才 Ollama 在您的计算机上,请使用以下命令:

使用这个命令:

bash

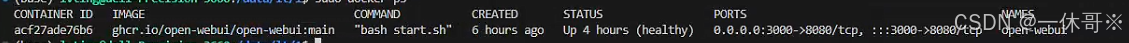

sudo docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main因为我已经安装完成了,且open-webui服务已经启动,所以输入命令后会提示

bash

sudo docker ps # 输入这个命令可以查看到正在运行的docker

以下为其他选项:

如果 Ollama 位于其他服务器上,请使用以下命令:

要连接到另一台服务器上的 Ollama,请将 更改为服务器的 URL:OLLAMA_BASE_URL:

这个此次不介绍,下次尝试使用

bash

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main要运行支持 Nvidia GPU 的 Open WebUI,请使用以下命令:

bash

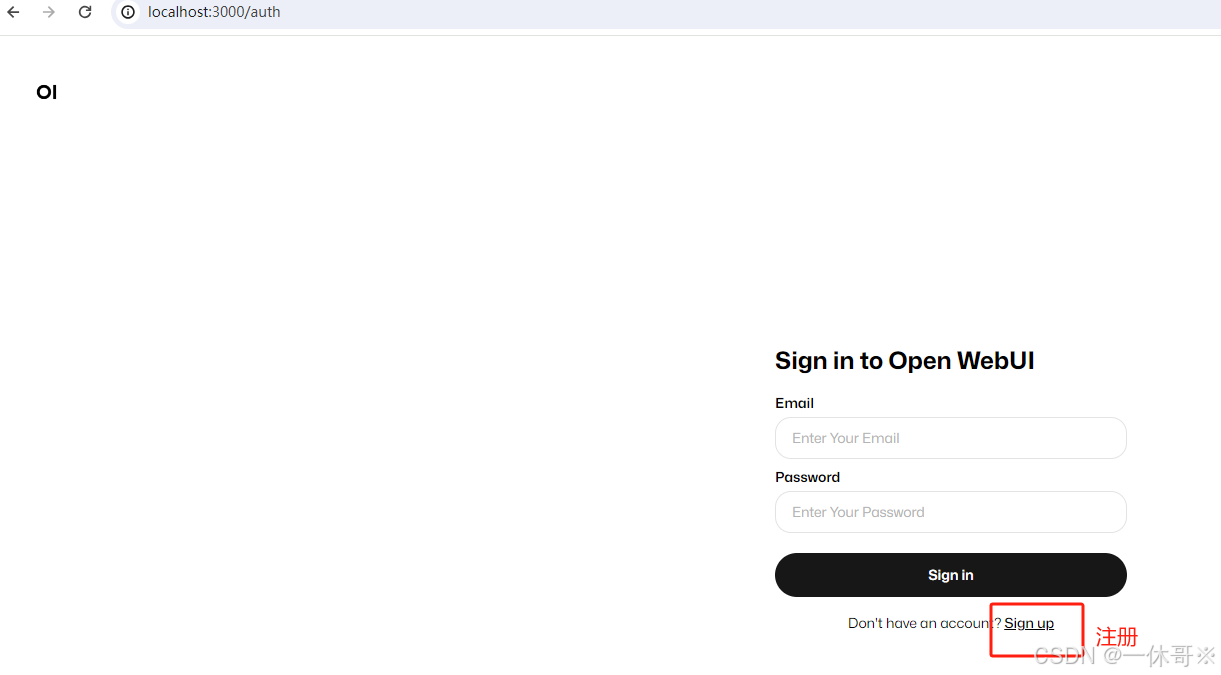

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda安装完成后,open-webui的网站为http://&{ip}:3000/

此处需要将网站的ip修改服务器内网的ip:

bash

ifconfig # 查看服务器ip

然后打开网站如:

http://192.168.1.23:3000/

这里可以选择模型