我自己的原文哦~https://blog.51cto.com/whaosoft/11580286

#SearchGPT

OpenAI大杀器SearchGPT横空出世,单挑谷歌千亿美元搜索帝国

OpenAI真来撼动谷歌的搜索帝国了?深夜悄悄上线的AI搜索引擎产品------SearchGPT,在同一问题的演示上,直接原地吊打谷歌和Perplexity。谷歌的AI Overview没做到的「重塑搜索引擎」,会让OpenAI达成吗?

OpenAI,忽然深夜放大招了------

今天半夜,OpenAI宣布推出名为Search GPT的AI搜索引擎,正式狙击搜索霸主谷歌。

据《金融时报》称,OpenAI已准备好攻进谷歌1750亿美元的搜索业务市场。

奥特曼在X上官宣此消息,大胆直言:「当今的搜索功能还有改进空间」!

没等来GPT-4o的语音功能,但ChatGPT的更新先来了。

尝试过SearchGPT的奥特曼,对于自己的全新搜索非常满意,表示跟老式搜索相比,自己更喜欢这种方式。

甚至「我适应得如此之快,这让我感到震惊!」

更暴击的是,SearchGPT的优质功能还将集成到ChatGPT中。

好消息是,根据奥特曼的说法,alpha测试将于下周开始开放给付费用户。

网友直言,SearchGPT对Perplexity、谷歌、必应都是迎头重击,让游戏开始吧!

SearchGPT对Perplexity、谷歌、必应是一个重大打击,直接与它们的搜索服务竞争。凭借其实时获取信息和与主要新闻机构的合作伙伴关系,SearchGPT准备颠覆搜索引擎市场

颠覆搜索,看来是真的

从官方放出的预览demo来看,似乎不仅仅是集成了实时网络信息,应该也包括类似于「多步推理」的功能。

问:我周末何时能在半月湾看到裸腮类动物?

对于包含如此具体时空细节的提问,谷歌是完全束手无策,给出的模糊答案看了就头疼。

上下滑动查看

SearchGPT则不跟你玩虚的,简单明快打直球,给出准确的时间点------

并且解释道,这类动物经常出现在潮间带和岸边岩石上,你应该在退潮时段去。

预测潮汐网站的参考链接,也贴心地附了出来。

更多的细节问题,也可以随口问它,比如那里天气如何?

这周末半月湾的天气预测,就会一一给出。

同样的问题,Perplexity倒是给出了一系列相关小tips,但对于核心问题,它并没有给出有力的答案,只是含糊地推荐「退潮期」。

这一轮对决,谷歌和Perplexity是妥妥输了。

实时响应,多轮对话,取代搜索引擎

SearchGPT和谷歌搜索的体验,为何差距如此之大?

OpenAI发言人Kayla Wood表示,目前SearchGPT的服务由GPT-4系列模型驱动, 采用类似ChatGPT的对话式界面和工作方式。

按照传统的搜索方式,用户在网络上检索时,往往需要多次搜索不同关键词,费时费力。

而SearchGPT颠覆了传统的搜索模式,只需像真人对话一样,表达自己的搜索诉求,即可获得实时响应,而且支持多轮对话。

以实时信息为基础,借助AI的理解推理和总结能力,找到想要的内容so easy。

跟传统搜索相比,SearchGPT的优化主要体现在两个方面:

其一,搜索结果更快速准确,充分发挥LLM的文本能力。

显然,对比基于关键词搜索的传统搜索引擎,AI搜索在理解问题和汇总信息方面有着显著的优势。

比如在搜索框内输入「八月份在北卡罗莱纳周Boone地区的音乐节」。

SearchGPT瞬间把几个相关的音乐节排列得清清楚楚,点击左侧边栏的链接按钮,还可以看到信息的来源,一键跳转买票。

而且,SearchGPT会为你提供指向相关来源的清晰链接。

2024巴黎奥运会什么时候举行?法国准备得怎么样了?它会援引路透社的报道

根据《连线》杂志的推测,SearchGPT很可能使用了检索增强生成(RAG)方法来减少回答中的幻觉,提高可信度并生成内容来源。

其二,不但能搜索结果,还能就一个细节和延申话题继续对话。

你一定有这样的体验,在搜索过程中会产生一些相关的新问题时,只能另起窗口接着搜,浏览器中开出十多个页面变成了工作日常。

传统搜索引擎就属于单次性搜索产品,检索完一个问题就结束。

而AI搜索附带有生成和对话的能力,每次查询都共享同一个上下文,让用户可以丝滑地继续话题。

最近用过ChatGPT的人,对这种体验一定不陌生。

比如它出了一些西红柿品种后,我们可以继续问:哪些是现在可以种的?

它会详细列出,在七月的明尼苏达州最适合种植的西红柿。

再比如,经过上一轮的搜索,你对Jones House比较感兴趣,就可以直接继续提问,「Jones House适合全家一起去看吗?」

SearchGPT也秒回,「是的,Jones House免费且向公众开放,适合所有年龄段,一家人可以带一块毯子在草坪上享受音乐盛宴。」

繁琐的音乐节做功课、看细节和买票等等全在SearchGPT一站式搞定,快速便捷又省心。

这种贴心高效的搜索体验,让人感慨OpenAI果然是最懂用户心的公司,把产品做到了极致。

谷歌危了?

而谷歌、Perplexity等搜索巨头们,接下来恐怕不好过了。

奥特曼所言的「搜索功能有改进的空间」,嘲讽意味拉满,内涵的对象自不必多说。

当然,OpenAI也同样瞄准了在AI搜索领域打天下的Perplexity AI。

OpenAI的目标是,最终将AI搜索功能重新整合到旗舰聊天机器人中。

此举是OpenAI挑战谷歌,做出的最新努力。

不言而喻,OpenAI在打造强大的AI聊天机器人的早期竞赛中一直处于领先地位。而在过去20年,谷歌一直在在线搜索领域占据主导地位。

截止6月,谷歌在全球搜索引擎市场中占到了91.05%的份额。微软必应只有3.7%的份额,而Pplexity的份额太低,无法衡量。

不甘落后的谷歌也在过去两年里,尝试将AI植入搜索引擎当中,并在去年带来了1750亿美元的收入,占总销售额一半以上。

与此同时,AI超进化为包括Perplexity在内的竞争对手,开辟了新道路。

这家成立仅两年的初创,专注于一件事「回答引擎」,现估值飙升至10亿美元。

不过,谷歌「一家独大」格局、AI初创单点布局,正在面临被OpenAI颠覆的危险,

OpenAI的帖子和博客发出后,谷歌母公司Alphabet的股价也变成了绿油油的一片。

事实上,谷歌在5月召开的I/O大会上就已经抢先OpenAI,发布了自己的AI搜索功能。

当天,CEO劈柴本人站台,自信满满地表示,要用Gemini的AI能力重塑搜索!

后来发生的事情我们都知道了------上线的AI Overview效果过于惨烈,「吃石头」、「披萨涂胶水」等各种翻车案例频发,被全网找乐子。

或许像SearchGPT这样先发布内测,再逐步开放,可以更好地把控产品的质量和口碑。

但也有网友担心,OpenAI又会再次放所有人的鸽子,SearchGPT的上线依旧遥遥无期。

Mistral和Meta: 发模型!

OpenAI:发博客!

与出版商和创作者合作

OpenAI表示,SeachGPT不仅仅是搜索,而且致力于打造更佳的用户与出版商和创作者互动体验。

一直以来,搜索引擎一直是出版商和创作者接触用户的主要方式。

现在,利用AI的对话界面,可以帮助用户更快找到理想的高质量内容,并提供多种互动机会。

搜索结果中会包含清晰的内容来源和链接,用户也可以在侧边栏中快速访问更多带有源链接的结果。

News Corp首席执行官Robert Thomson表示,奥特曼和其他OpenAI领导人都认为,任何人工智能驱动的搜索都必须依赖于「由可信来源提供的最高质量、最可靠的信息」。

OpenAI还在博客中特意声明,搜索结果与GenAI模型的训练是分开的。即使不向OpenAI提供训练数据,相关内容也会出现在SearchGPT中。

最近一段时间,OpenAI与多家顶级出版商建立了合作,包括《大西洋月刊》、美联社和Business Insider的母公司Axel Springer,似乎也包括下辖《华尔街日报》、《泰晤士报》、《太阳报》的媒体巨头News Corp。

OpenAI代表向这些出版商展示了搜索功能的原型,并表示,他们可以自行选择内容来源在SerchGPT中的呈现方式。

OpenAI这种谨慎的合作态度似乎是吸取了前段时间的教训,有意规避风险。

上个月,Perplexity在搜索结果中使用了《福布斯》的一篇报道,但没有准确注明来源,直到页面底部才提及。

结果,Perplexity的CEO直接收到了《福布斯》的信函,声称要对这种侵权行为采取法律行动。

由于最近普遍的流量下降趋势,以及AI对内容行业的冲击,出版商对AI重塑新闻的方式越来越感到不安。

他们普遍担心,OpenAI或谷歌的AI搜索工具将根据原始新闻内容提供完整的答案,让用户无需阅读原始文章,进而造成在线流量和广告收入的锐减。

许多出版商都认为,向科技巨头们出售其知识产权的访问权是有价值的,因为他们需要大量数据和内容来完善其人工智能系统并创建SearchGPT等新产品。

或许,从OpenAI与媒体的合作中,我们可以推知它如此急于开展搜索业务的原因。

根据The Information本周的报道,OpenAI正在陷入财务风暴,今年的亏损可能高达50亿美元。

恰好,搜索是一项极其吸金的业务。除了可以与媒体、出版商合作,还有机会通过广告盈利。

财报显示,谷歌搜索业务仅今年第一季度的收入就达到了460亿美元。

有如此丰厚的利润前景,或许奥特曼不会舍得让SearchGPT像Sora和《Her》那样一直鸽下去。

参考资料:

https://openai.com/index/searchgpt-prototype/

https://www.ft.com/content/16c56117-a4f4-45d6-8c7b-3ef80d17d254

#SGLang

贾扬清点赞:3K star量的SGLang上新,加速Llama 405B推理秒杀vLLM、TensorRT-LLM

用来运行 Llama 3 405B 优势明显。

最近,Meta 开源了最新的 405B 模型(Llama 3.1 405B),把开源模型的性能拉到了新高度。由于模型参数量很大,很多开发者都关心一个问题:怎么提高模型的推理速度?

时隔才两天,LMSYS Org 团队就出手了,推出了全新的 SGLang Runtime v0.2。这是一个用于 LLM 和 VLM 的通用服务引擎。在运行 Llama 3.1 405B 时,它的吞吐量和延迟表现都优于 vLLM 和 TensorRT-LLM。

在某些情况下(运行 Llama 系列模型),它的吞吐量甚至能达到 TensorRT-LLM 的 2.1 倍,vLLm 的 3.8 倍。

LMSYS Org 团队是一个由加州大学伯克利分校、加州大学圣地亚哥分校以及卡内基梅隆大学的学生与教职员工共同组建的公开性质的研究团体。他们开发的大模型评测平台 ------Chatbot Arena 已经成为检验大模型能力的重要平台,也被认为是一种相对公平的评测方式。

SGLang 是该团队开发的一个用于大型语言模型和视觉语言模型的快速服务框架,于今年 1 月份正式推出,在 GitHub 上已经收获了超过 3k 的 star 量。

这次的更新效果惊艳,知名 AI 研究者、Lepton AI 联合创始人兼 CEO 贾扬清评价说「我一直被我的博士母校加州大学伯克利分校惊艳,因为它不断交付最先进的人工智能和系统协同设计成果。去年我们看到了 SGLang 的使用,现在它变得更好了。迫不及待地想在产品中部署并尝试新的 SGLang!」

为什么 LMSYS Org 要开发并迭代 SGLang 呢?他们在博客中提到,「我们已经运行 Chatbot Arena 平台一年多,为数百万用户提供服务。我们深知高效服务对人工智能产品和研究的重要性。通过运营经验和深入研究,我们不断增强底层服务系统,从高级多模型服务框架 FastChat 到高效服务引擎 SGLang Runtime (SRT)。」

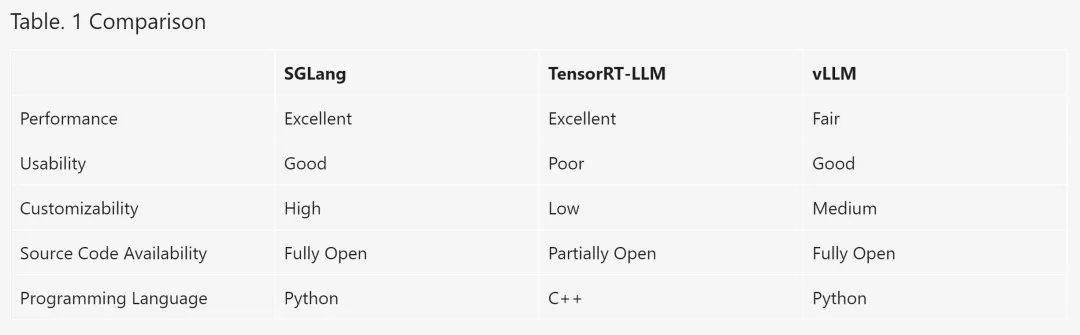

「这篇文章的重点是 SGLang Runtime,它是一个用于 LLM 和 VLM 的通用服务引擎。虽然 TensorRT-LLM、vLLM、MLC-LLM 和 Hugging Face TGI 等现有选项各有优点,但我们发现它们有时难以使用、难以定制或性能不佳。这促使我们开发了 SGLang v0.2,旨在创建一个不仅用户友好、易于修改,而且性能一流的服务引擎。」

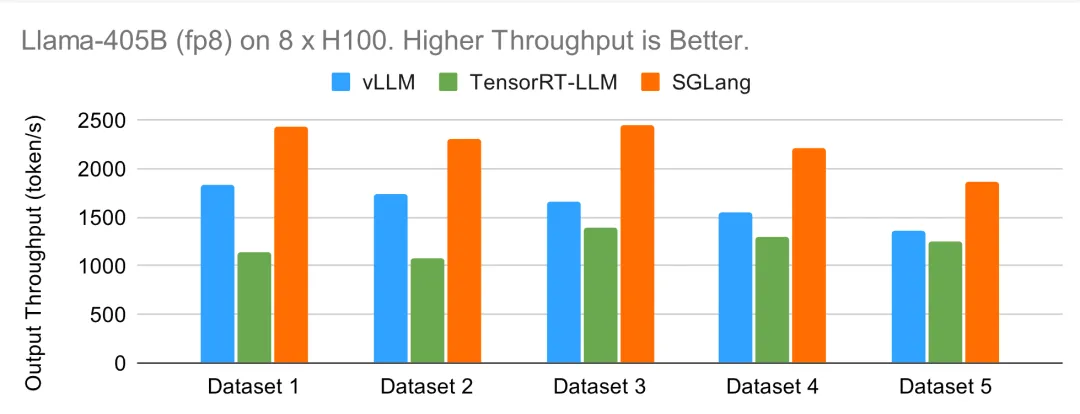

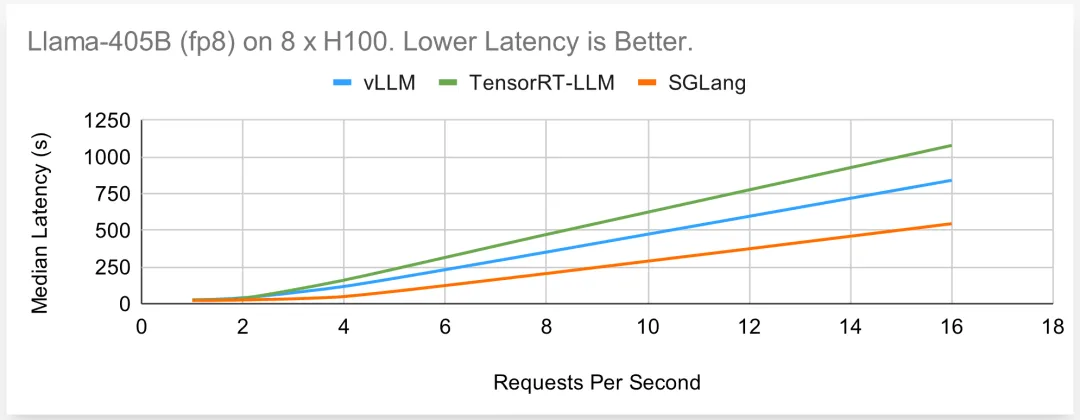

与 TensorRT-LLM 和 vLLM 相比,SGLang Runtime 在处理从 Llama-8B 到 Llama-405B 的模型时,以及在 A100 和 H100 GPU 上使用 FP8 和 FP16 时,在在线和离线场景下都能持续提供卓越或有竞争力的性能。SGLang 的性能始终优于 vLLM,在 Llama-70B 上的吞吐量最高是前者的 3.8 倍。它还经常与 TensorRT-LLM 不相上下,甚至超过 TensorRT-LLM,在 Llama-405B 上的吞吐量最高是前者的 2.1 倍。更重要的是,SGLang 是完全开源的,由纯 Python 编写,核心调度器只用了不到 4K 行代码就实现了。

SGLang 是一个开源项目,采用 Apache 2.0 许可授权。它已被 LMSYS Chatbot Arena 用于支持部分模型、Databricks、几家初创公司和研究机构,产生了数万亿 token,实现了更快的迭代。

以下是几个框架的对比实验设置和结果。

基准设置

研究者对离线和在线用例进行基准测试:

离线:他们一次发送 2K 到 3K 个请求,测量输出吞吐量(token / 秒),即输出 token 数除以总持续时间。他们测试的合成数据集来自 ShareGPT 数据集。例如,I-512-O-1024 表示平均输入 512 个 token、平均输出 1024 个 token 的数据集。五个测试数据集分别为:

- 数据集 1:I-243-O-770;

- 数据集 2:I-295-O-770;

- 数据集 3:I-243-O-386;

- 数据集 4:I-295-O-386;

- 数据集 5:I-221-O-201。

在线:他们以每秒 1 到 16 个请求 (RPS) 的速率发送请求,测量端到端延迟的中位数。他们使用合成数据集 I-292-O-579。

他们使用 vLLM 0.5.2(带默认参数)和 TensorRT-LLM(带推荐参数和调整后的批大小)。所有引擎都关闭了前缀缓存。目的是在没有任何附加功能(如推测解码或缓存)的情况下,对基本性能进行基准测试。他们使用与 OpenAI 兼容的 API 对 SGLang 和 vLLM 进行基准测试,并使用 Triton 接口对 TensorRT-LLM 进行基准测试。

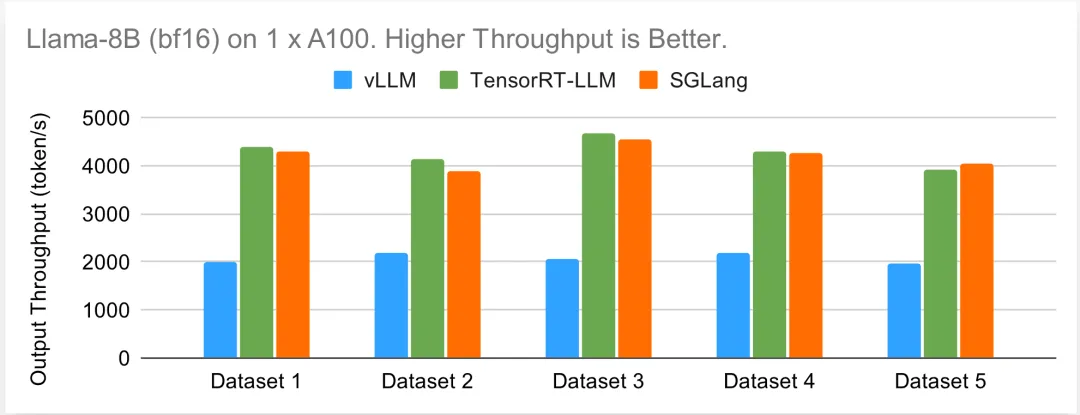

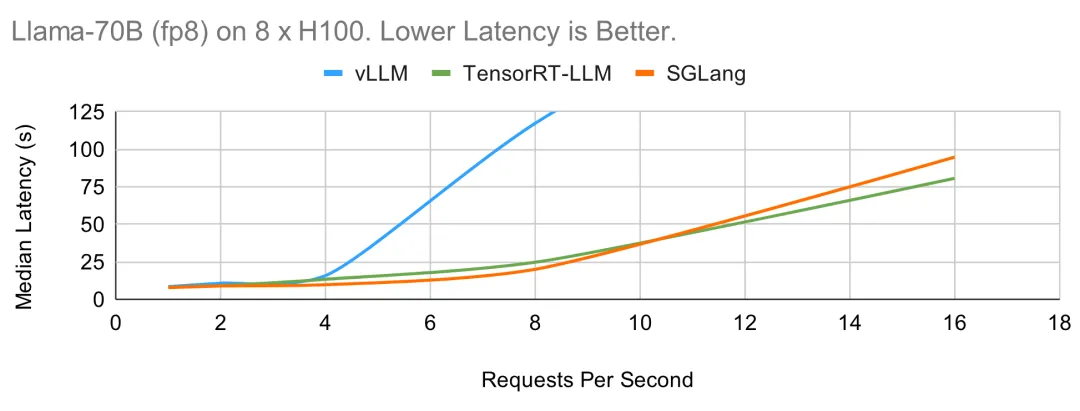

Llama-8B 在一个 A100 上运行(bf16)

研究者从小型模型 Llama-8B 开始测试。下图显示了每个引擎在五个不同数据集的离线设置下所能达到的最大输出吞吐量。TensorRT-LLM 和 SGLang 都能达到每秒约 4000 个 token 的吞吐量,而 vLLM 则稍逊一筹。

下面的在线基准图显示了与离线情况类似的趋势。TensorRT-LLM 和 SGLang 的性能相当,可以保持 RPS > 10,而 vLLM 的延迟在请求率较高时显著增加。

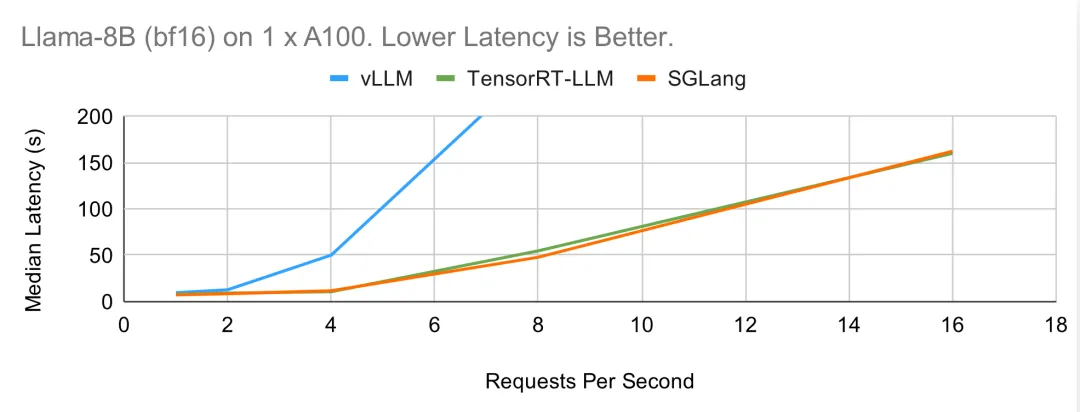

Llama-70B 在 8 个 A100 上运行(bf16)

至于在 8 个 GPU 上进行张量并行的较大型 Llama-70B 模型,趋势与 8B 相似。在下面的离线基准测试中,TensorRT-LLM 和 SGLang 都能达到很高的吞吐量。

在下图的在线结果中,TensorRT-LLM 凭借高效的内核实现和运行时间,显示出较低的延迟。

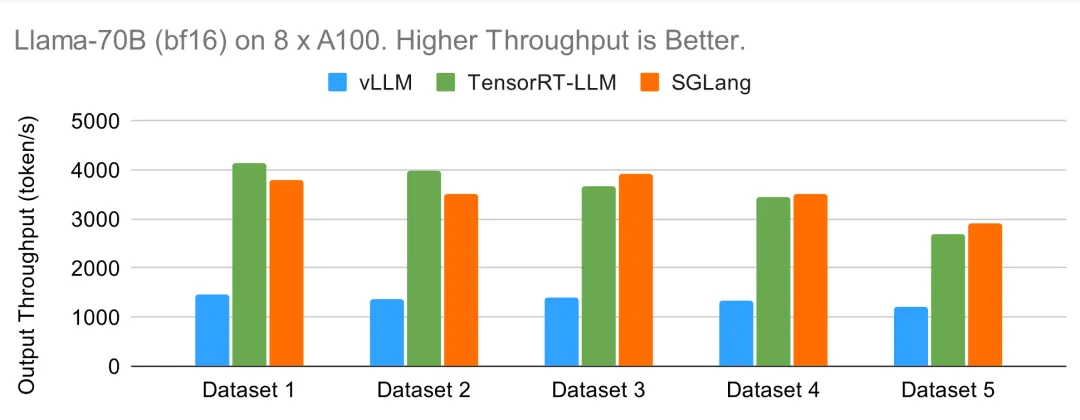

Llama-70B 在 8 个 H100 上运行(fp8)

现在来测试 FP8 性能。vLLM 和 SGLang 都使用了 CUTLASS 的 FP8 内核。在离线设置中,SGLang 的批处理调度器非常高效,可以随着批处理规模的增大而继续扩展吞吐量,在这种情况下实现了最高吞吐量。其他系统则由于 OOM、缺少大量手动调整或存在其他开销而无法扩展吞吐量或批大小。在线情况下也是如此,SGLang 和 TensorRT 的中位延迟相似。

Llama-405B 在 8 个 H100 上运行(fp8)

最后,研究者在最大的 405B 模型上对各种方法的性能进行了基准测试。由于模型较大,大部分时间都花在了 GPU 内核上。不同框架之间的差距缩小了。TensorRT-LLM 性能不佳的原因可能是 405B 模型刚刚问世,而图中使用的版本尚未集成一些最新优化。在在线和离线情况下,SGLang 的性能都是最好的。

SGLang 概览

SGLang 是大型语言模型和视觉语言模型的服务框架。它基于并增强了多个开源 LLM 服务引擎(包括 LightLLM、vLLM 和 Guidance)的许多优秀设计。它利用了来自 FlashInfer 的高性能注意力 CUDA 内核,并集成了受 gpt-fast 启发的 torch.compile。

此外,研究者还引入了一些创新技术,如用于自动 KV 缓存重用的 RadixAttention 和用于快速约束解码的压缩状态机。SGLang 以其完全用 Python 实现的高效批处理调度器而闻名。为了进行公平比较,本博客测试了这些服务引擎在关闭特定场景或工作负载优化(如前缀缓存和推测解码)后的基本性能。SGLang 的提速是通过适当的工程设计实现的。SGLang 基于 Python 的高效批处理调度器具有良好的扩展性,通常可与使用 C++ 构建的闭源实现相媲美,甚至更胜一筹。

表 1 比较了 SGLang、TensorRT-LLM 和 vLLM 的各个方面。在性能方面,SGLang 和 TensorRT-LLM 都非常出色。在可用性和可定制性方面,SGLang 的轻量级和模块化内核使其易于定制,而 TensorRT-LLM 复杂的 C++ 技术栈和设置说明使其更难使用和修改。SGLang 的源代码完全开源,而 TensorRT-LLM 仅部分开源。相比之下,vLLM 的 CPU 调度开销较高。

研究者还表示,未来他们还将开发长上下文和 MoE 优化等新功能。

使用方法

你可以按照以下步骤轻松服务 Llama 模型:

1、使用 pip、源代码或 Docker 安装 SGLang:https://github.com/sgl-project/sglang/tree/main?tab=readme-ov-file#install

2、启动服务器:

# Llama 8B

python -m sglang.launch_server --model-path meta-llama/Meta-Llama-3.1-8B-Instruct

# Llama 405B

python -m sglang.launch_server --model-path meta-llama/Meta-Llama-3.1-405B-Instruct-FP8 --tp 83、使用 OpenAI 兼容的 API 发送请求:

curl http://localhost:30000/v1/completions \

-H "Content-Type: application/json" \

-d '{

"model": "default",

"prompt": "Say this is a test",

"max_tokens": 7,

"temperature": 0

}'4、运行基准:

python3 -m sglang.bench_serving --backend sglang --num-prompts 1000附录:详细的基准设置

重现基准的说明位于 sglang/benchmark/blog_v0_2。

对于所有基准测试,研究者都设置了 ignore_eos 或 min_length/end_id 以确保每个引擎输出相同数量的 token。他们曾尝试使用 vLLM 0.5.3.post1,但它在高负载情况下经常崩溃,与部分基准测试中的 vLLM 0.5.2 相比,vLLM 0.5.3.post1 性能似乎差不多甚至更差。因此,他们报告的是 vLLM 0.5.2 的结果。虽然他们知道不同的服务器配置会对服务性能产生重大影响,但他们主要使用每个引擎的默认参数来模拟普通用户的情况。

对于 8B 和 70B 模型,他们使用 meta-llama/Meta-Llama-3-8B-Instruct 和 meta-llama/Meta-Llama-3-70B-Instruct bf16 检查点,以及 neuralmagic/Meta-Llama-3-70B-Instruct-FP8 fp8 检查点。对于 405B 模型,他们在所有基准测试中都使用了虚拟权重。由于 TensorRT-LLM 最新图像 r24.06 不支持官方 meta-llama/Meta-Llama-3.1-405B-FP8 检查点中的 fbgemm_fp8 量化,他们在所有框架中都使用了每层 fp8 量化,并对除 lm_head 以外的所有层进行了量化。他们相信这样可以对所有引擎进行公平的比较。A100 和 H100 GPU 为 80GB SXM 版本。

参考链接:https://lmsys.org/blog/2024-07-25-sglang-llama3/

#KAN or MLP:

反转了?在一场新较量中,号称替代MLP的KAN只赢一局

KAN 在符号表示中领先,但 MLP 仍是多面手。

多层感知器 (Multi-Layer Perceptrons,MLP) ,也被称为全连接前馈神经网络,是当今深度学习模型的基本组成部分。MLP 的重要性无论怎样强调都不为过,因为它是机器学习中用于逼近非线性函数的默认方法。

然而,MLP 也存在某些局限性,例如难以解释学习到的表示,以及难以灵活地扩展网络规模。

KAN(Kolmogorov--Arnold Networks)的出现,为传统 MLP 提供了一种创新的替代方案。该方法在准确性和可解释性方面优于 MLP,而且,它能以非常少的参数量胜过以更大参数量运行的 MLP。

那么,问题来了,KAN 、MLP 到底该选哪一种?有人支持 MLP,因为 KAN 只是一个普通的 MLP,根本替代不了,但也有人则认为 KAN 更胜一筹,而当前对两者的比较也是局限在不同参数或 FLOP 下进行的,实验结果并不公平。

为了探究 KAN 的潜力,有必要在公平的设置下全面比较 KAN 和 MLP 了。

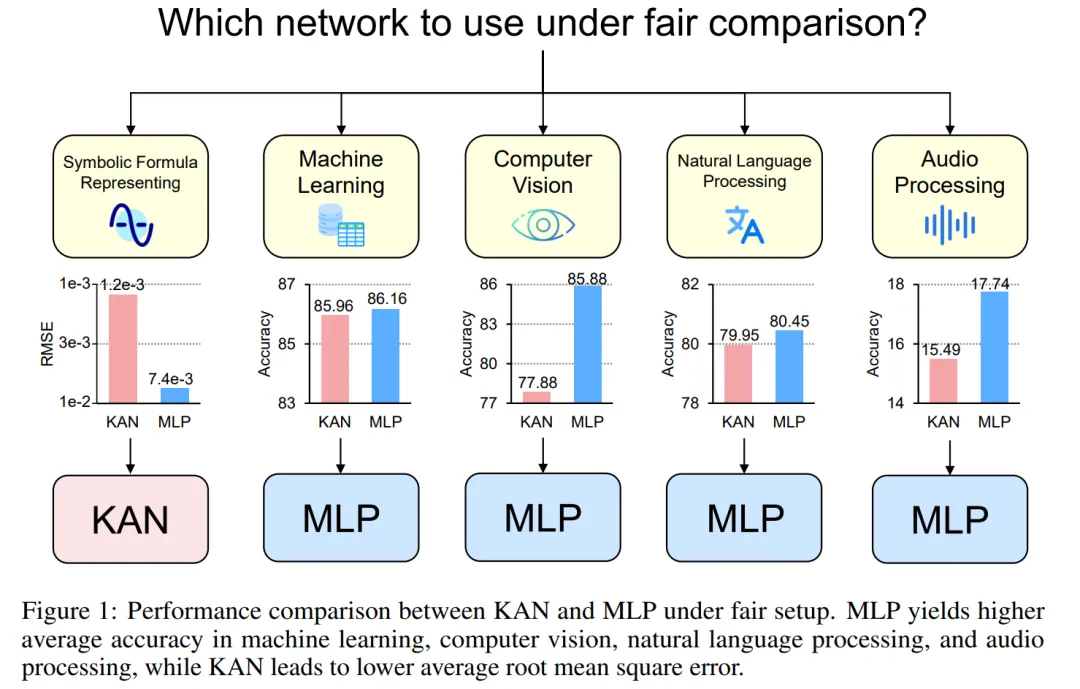

为此,来自新加坡国立大学的研究者在控制了 KAN 和 MLP 的参数或 FLOP 的情况下,在不同领域的任务中对它们进行训练和评估,包括符号公式表示、机器学习、计算机视觉、NLP 和音频处理。在这些公平的设置下,他们发现 KAN 仅在符号公式表示任务中优于 MLP,而 MLP 通常在其他任务中优于 KAN。

- 论文地址:https://arxiv.org/pdf/2407.16674

- 项目链接:https://github.com/yu-rp/KANbeFair

- 论文标题:KAN or MLP: A Fairer Comparison

作者进一步发现,KAN 在符号公式表示方面的优势源于其使用的 B - 样条激活函数。最初,MLP 的整体性能落后于 KAN,但在用 B - 样条代替 MLP 的激活函数后,其性能达到甚至超过了 KAN。但是,B - 样条无法进一步提高 MLP 在其他任务(如计算机视觉)上的性能。

作者还发现,KAN 在连续学习任务中的表现实际上并不比 MLP 好。最初的 KAN 论文使用一系列一维函数比较了 KAN 和 MLP 在连续学习任务中的表现,其中每个后续函数都是前一个函数沿数轴的平移。而本文比较了 KAN 和 MLP 在更标准的类递增持续学习设置中的表现。在固定的训练迭代条件下,他们发现 KAN 的遗忘问题比 MLP 更严重。

KAN、MLP 简单介绍

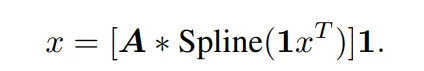

KAN 有两个分支,第一个分支是 B 样条分支,另一个分支是 shortcut 分支,即非线性激活与线性变换连接在一起。在官方实现中,shortcut 分支是一个 SiLU 函数,后面跟着一个线性变换。令 x 表示一个样本的特征向量。那么,KAN 样条分支的前向方程可以写成:

在原始 KAN 架构中,样条函数被选择为 B 样条函数。每个 B 样条函数的参数与其他网络参数一起学习。

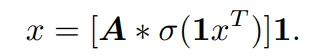

相应的,单层 MLP 的前向方程可以表示为:

该公式与 KAN 中的 B 样条分支公式具有相同的形式,只是在非线性函数中有所不同。因此,抛开原论文对 KAN 结构的解读,KAN 也可以看作是一种全连接层。

因而,KAN 和普通 MLP 的区别主要有两点:

- 激活函数不同。通常 MLP 中的激活函数包括 ReLU、GELU 等,没有可学习的参数,对所有输入元素都是统一的,而在 KAN 中,激活函数是样条函数,有可学习的参数,并且对于每个输入元素都是不一样的。

- 线性和非线性运算的顺序。一般来说,研究者会把 MLP 概念化为先进行线性变换,再进行非线性变换,而 KAN 其实是先进行非线性变换,再进行线性变换。但在某种程度上,将 MLP 中的全连接层描述为先非线性,后线性也是可行的。

通过比较 KAN 和 MLP,该研究认为两者之间的差异主要是激活函数。因而,他们假设激活函数的差异使得 KAN 和 MLP 适用于不同的任务,从而导致两个模型在功能上存在差异。为了验证这一假设,研究者比较了 KAN 和 MLP 在不同任务上的表现,并描述了每个模型适合的任务。为了确保公平比较,该研究首先推导出了计算 KAN 和 MLP 参数数量和 FLOP 的公式。实验过程控制相同数量的参数或 FLOP 来比较 KAN 和 MLP 的性能。

KAN 和 MLP 的参数数量及FLOP

控制参数数量

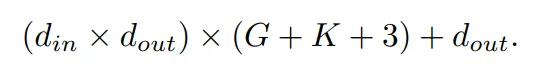

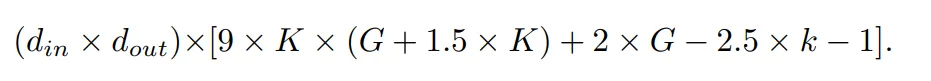

KAN 中可学习的参数包括 B 样条控制点、shortcut 权重、B 样条权重和偏置项。总的可学习参数数量为:

其中, d_in 和 d_out 表示神经网络层的输入和输出维度,K 表示样条的阶数,它与官方 nn.Module KANLayer 的参数 k 相对应,它是样条函数中多项式基础的阶数。G 表示样条间隔数,它对应于官方 nn.Module KANLayer 的 num 参数。它是填充前 B 样条曲线的间隔数。在填充之前,它等于控制点的数量 - 1。在填充后,应该有 (K +G) 个有效控制点。

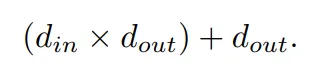

相应的,一个 MLP 层的可学习参数是:

KAN 和 MLP 的 FLOP

在作者的评估中,任何算术操作的 FLOP 被考虑为 1,而布尔操作的 FLOP 被考虑为 0。De Boor-Cox 算法中的 0 阶操作可以转换为一系列布尔操作,这些操作不需要进行浮点运算。因此,从理论上讲,其 FLOP 为 0。这与官方 KAN 实现不同,在官方实现中,它将布尔数据转换回浮点数据来进行操作。

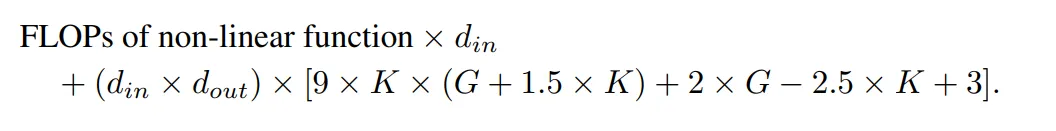

在作者的评估中,FLOP 是针对一个样本计算的。官方 KAN 代码中使用 De Boor-Cox 迭代公式实现的 B 样条 FLOP 为:

连同 shortcut 路径的 FLOP 以及合并两个分支的 FLOP,一个 KAN 层的总 FLOP 是:

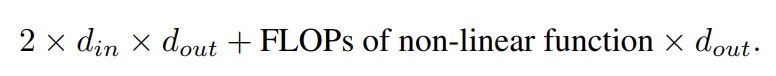

相应的,一个 MLP 层的 FLOP 为:

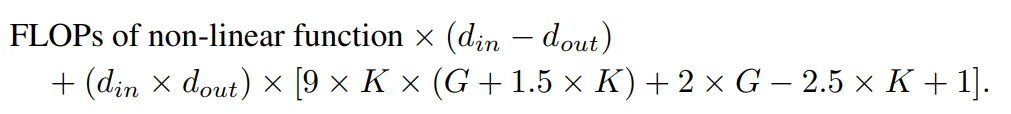

具有相同输入维度和输出维度的 KAN 层与 MLP 层之间的 FLOP 差异可以表示为:

如果 MLP 也首先进行非线性操作,那么首项将为零。

实验

作者的目标是,在参数数量或 FLOP 相等的前提下,对比 KAN 和 MLP 的性能差异。该实验涵盖多个领域,包括机器学习、计算机视觉、自然语言处理、音频处理以及符号公式表示。所有实验都采用了 Adam 优化器,这些实验全部在一块 RTX3090 GPU 上进行。

性能比较

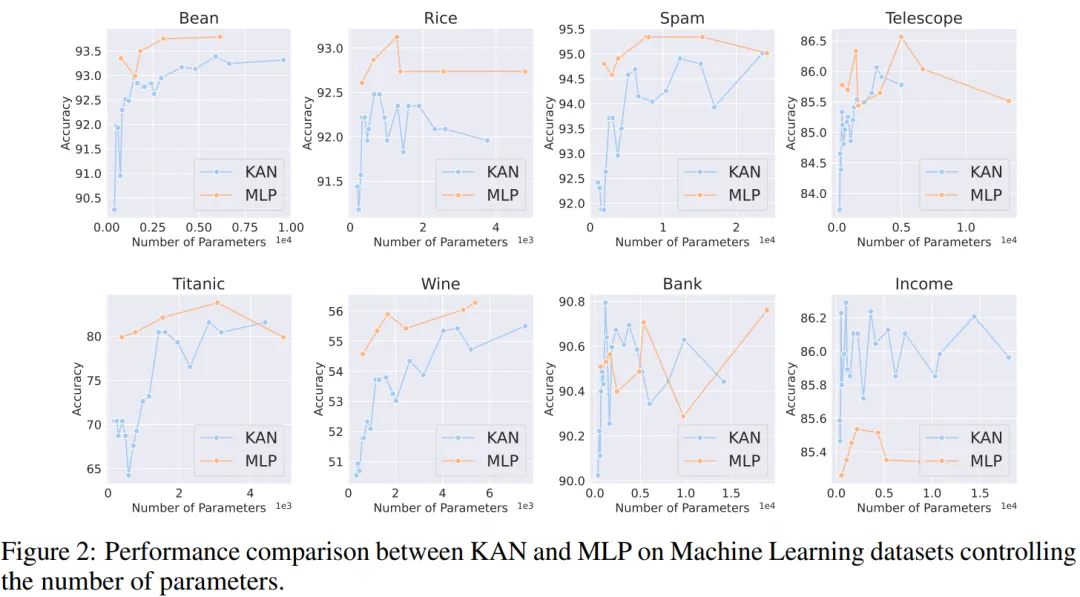

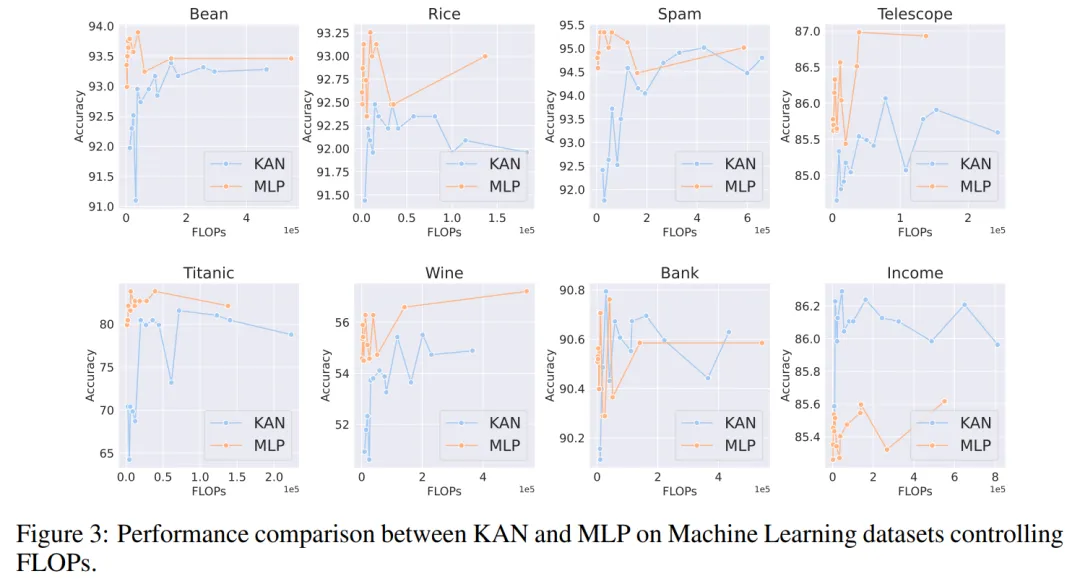

机器学习。作者在 8 个机器学习数据集上进行了实验,使用了具有一到两个隐藏层的 KAN 和 MLP,根据各个数据集的特点,他们调整了神经网络的输入和输出维度。

对于 MLP,隐藏层宽度设置为 32、64、128、256、512 或 1024,并采用 GELU 或 ReLU 作为激活函数,同时在 MLP 中使用了归一化层。对于 KAN,隐藏层宽度则为 2、4、8 或 16,B 样条网格数为 3、5、10 或 20,B 样条的度数(degree)为 2、3 或 5。

由于原始 KAN 架构不包括归一化层,为了平衡 MLP 中归一化层可能带来的优势,作者扩大了 KAN 样条函数的取值范围。所有实验都进行了 20 轮训练,实验记录了训练过程中在测试集上取得的最佳准确率,如图 2 和图 3 所示。

在机器学习数据集上,MLP 通常保持优势。在他们对八个数据集的实验中,MLP 在其中的六个上表现优于 KAN。然而,他们也观察到在一个数据集上,MLP 和 KAN 的性能几乎相当,而在另一个数据集上,KAN 表现则优于 MLP。

总体而言,MLP 在机器学习数据集上仍然具有普遍优势。

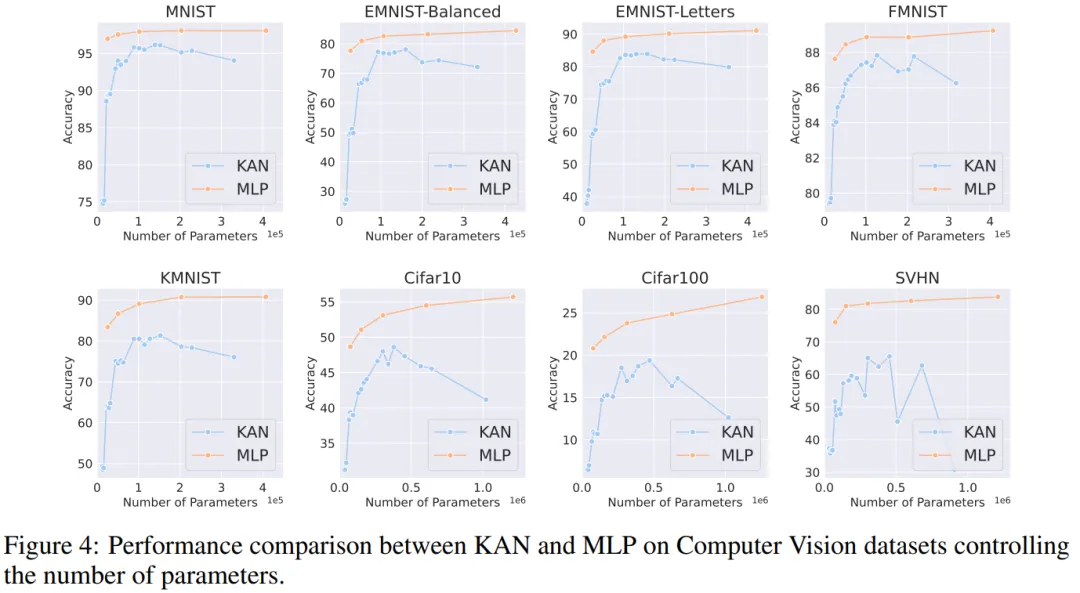

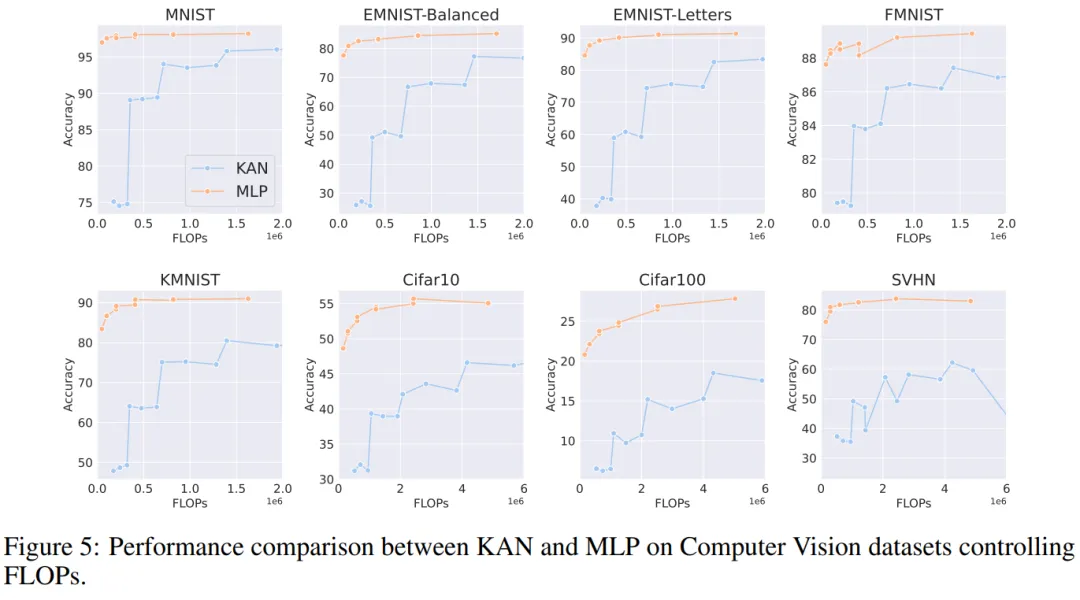

计算机视觉。作者对 8 个计算机视觉数据集进行了实验。他们使用了具有一到两个隐藏层的 KAN 和 MLP,根据数据集的不同,调整了神经网络的输入和输出维度。

在计算机视觉数据集中,KAN 的样条函数引入的处理偏差并没有起到效果,其性能始终不如具有相同参数数量或 FLOP 的 MLP。

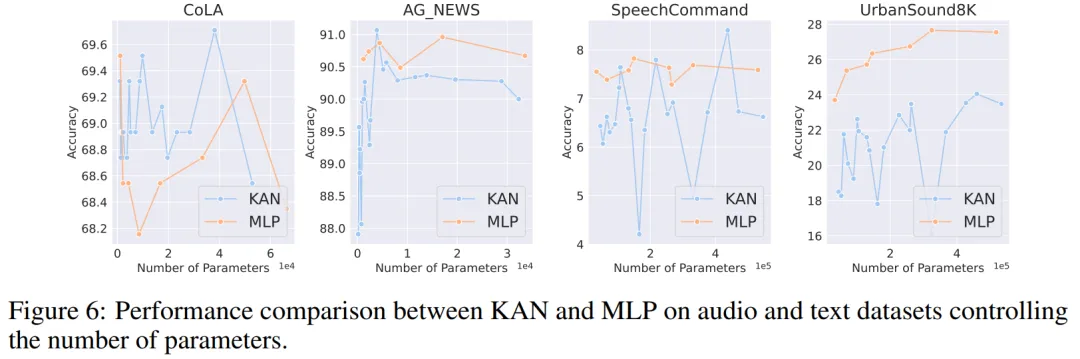

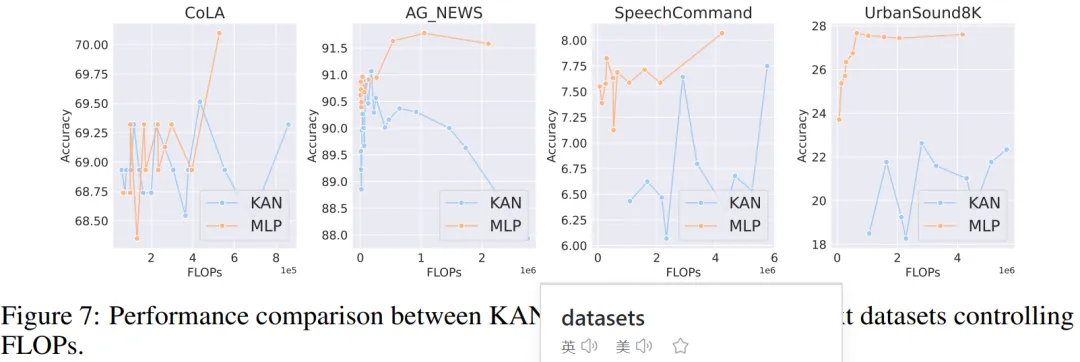

音频和自然语言处理。作者在 2 个音频分类和 2 个文本分类数据集上进行了实验。他们使用了一到两个隐藏层的 KAN 和 MLP,并根据数据集的特性,调整了神经网络的输入和输出维度。

在两个音频数据集上,MLP 的表现优于 KAN。

在文本分类任务中,MLP 在 AG 新闻数据集上保持了优势。然而,在 CoLA 数据集上,MLP 和 KAN 之间的性能没有显著差异。当控制参数数量相同时,KAN 在 CoLA 数据集上似乎有优势。然而,由于 KAN 的样条函数需要较高的 FLOP,这一优势在控制 FLOP 的实验中并未持续显现。当控制 FLOP 时,MLP 似乎更胜一筹。因此,在 CoLA 数据集上,并没有一个明确的答案来说明哪种模型更好。

总体而言,MLP 在音频和文本任务中仍然是更好的选择。

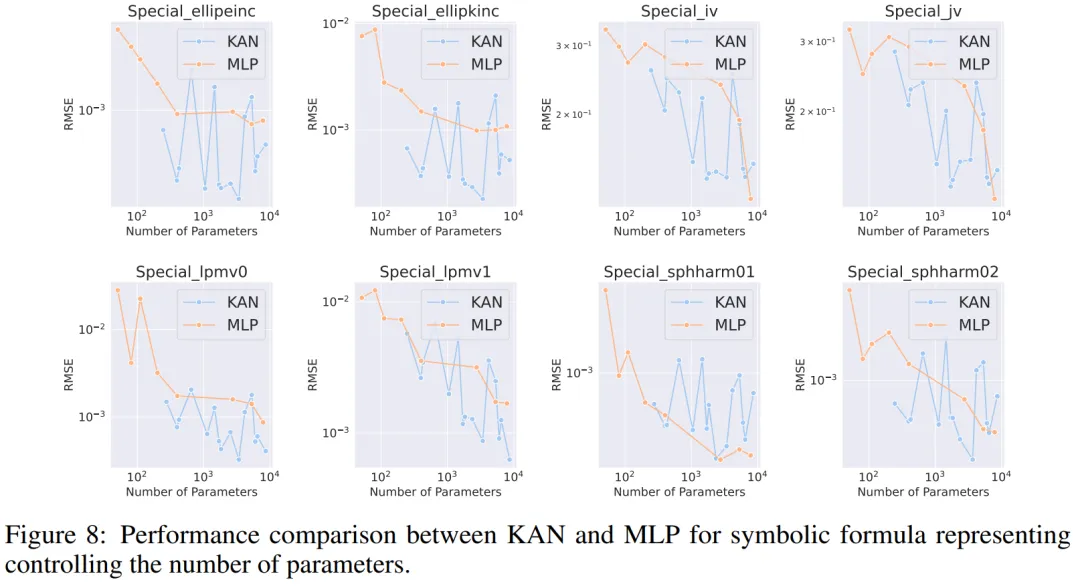

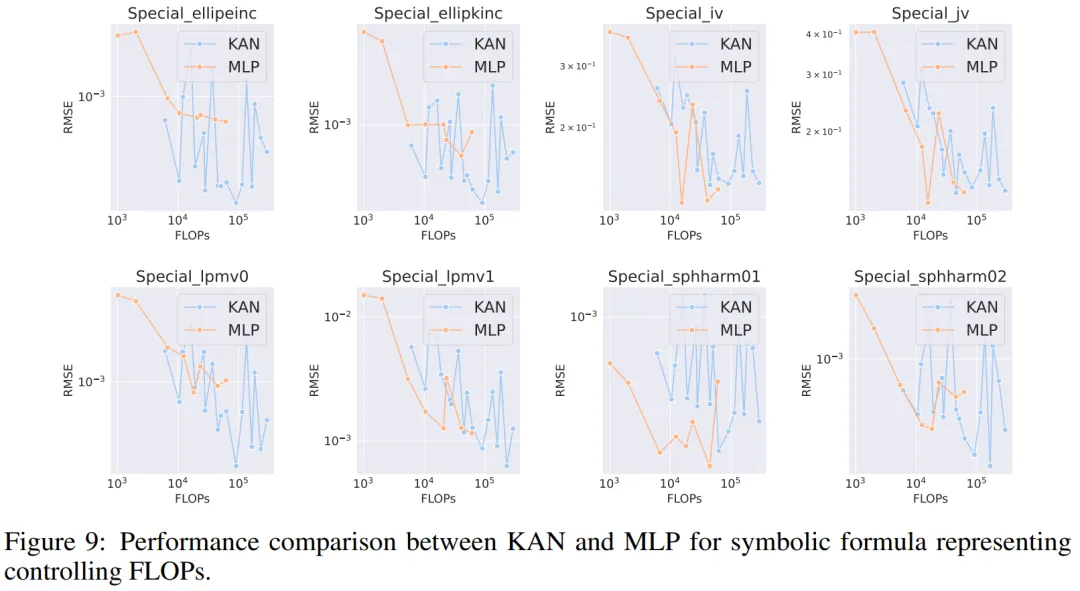

符号公式表示。作者在 8 个符号公式表示任务中比较了 KAN 和 MLP 的差异。他们使用了一到四个隐藏层的 KAN 和 MLP,根据数据集调整了神经网络的输入和输出维度。

在控制参数数量的情况下,KAN 在 8 个数据集中的 7 个上表现优于 MLP。在控制 FLOP 时,由于样条函数引入了额外的计算复杂性,KAN 的性能大致与 MLP 相当,在两个数据集上优于 MLP,在另一个数据集上表现不如 MLP。

总体而言,在符号公式表示任务中,KAN 的表现优于 MLP。

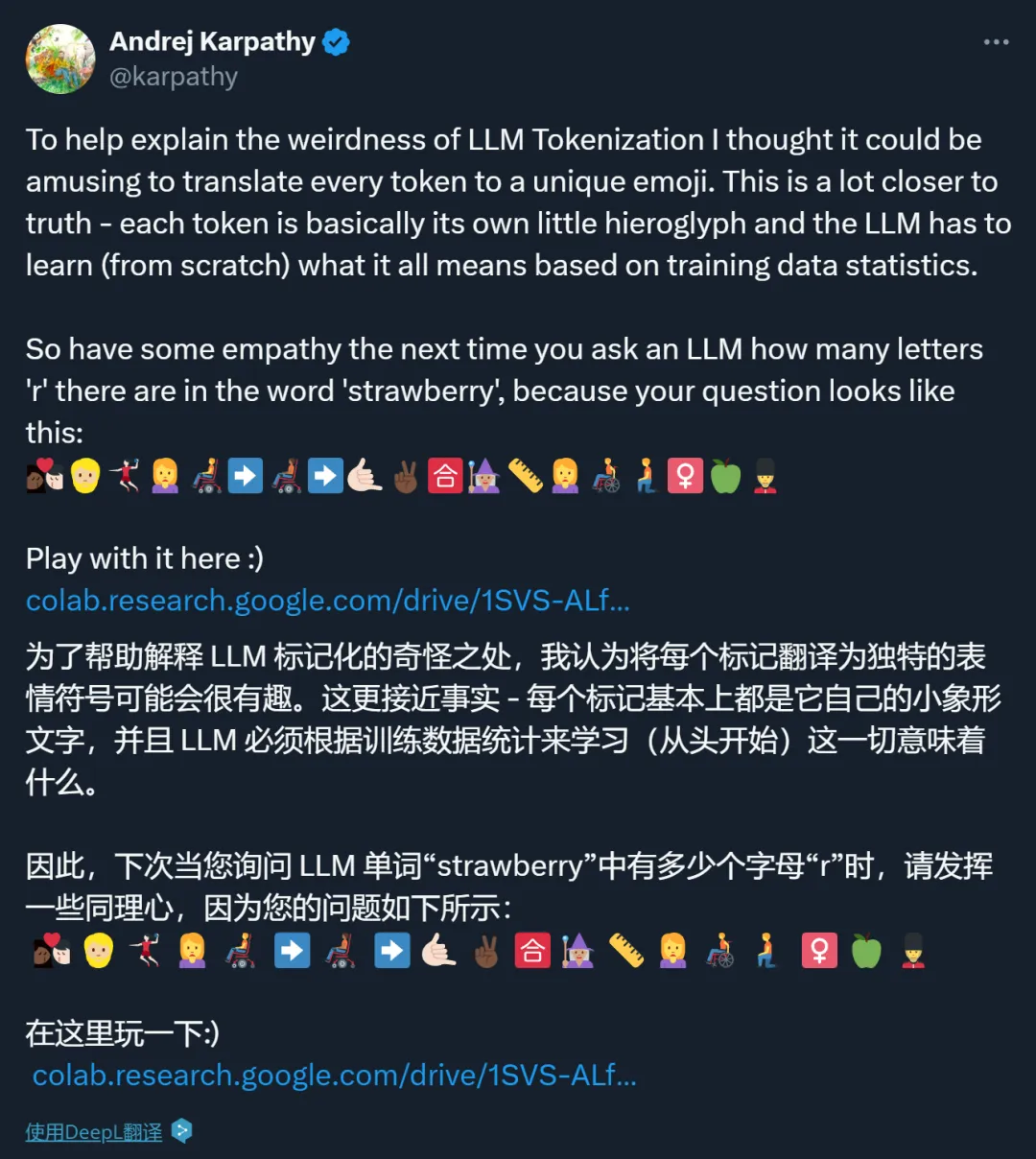

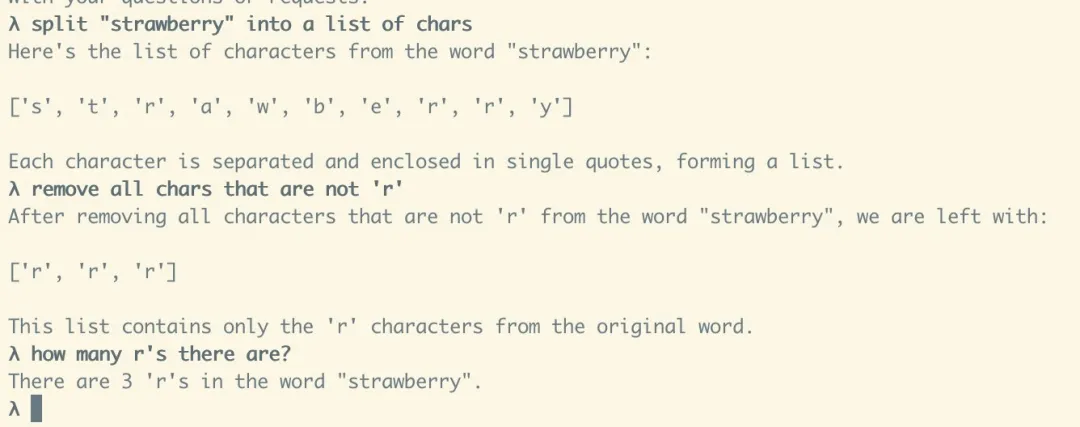

#为什么AI数不清Strawberry里有几个 r?

Karpathy:我用表情包给你解释一下

让模型知道自己擅长什么、不擅长什么是一个很重要的问题。

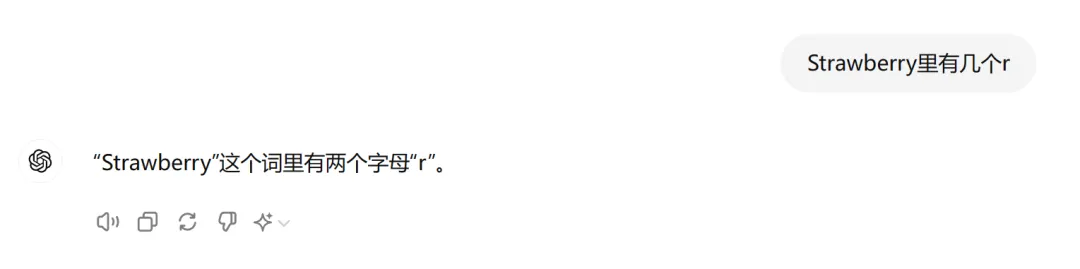

还记得这些天大模型被揪出来的低级错误吗?

不知道 9.11 和 9.9 哪个大,数不清 Strawberry 单词里面有多少个 r...... 每每被发现一个弱点,大模型都只能接受人们的无情嘲笑。

嘲笑之后,大家也冷静了下来,开始思考:低级错误背后的本质是什么?

大家普遍认为,是 Token 化(Tokenization)的锅。

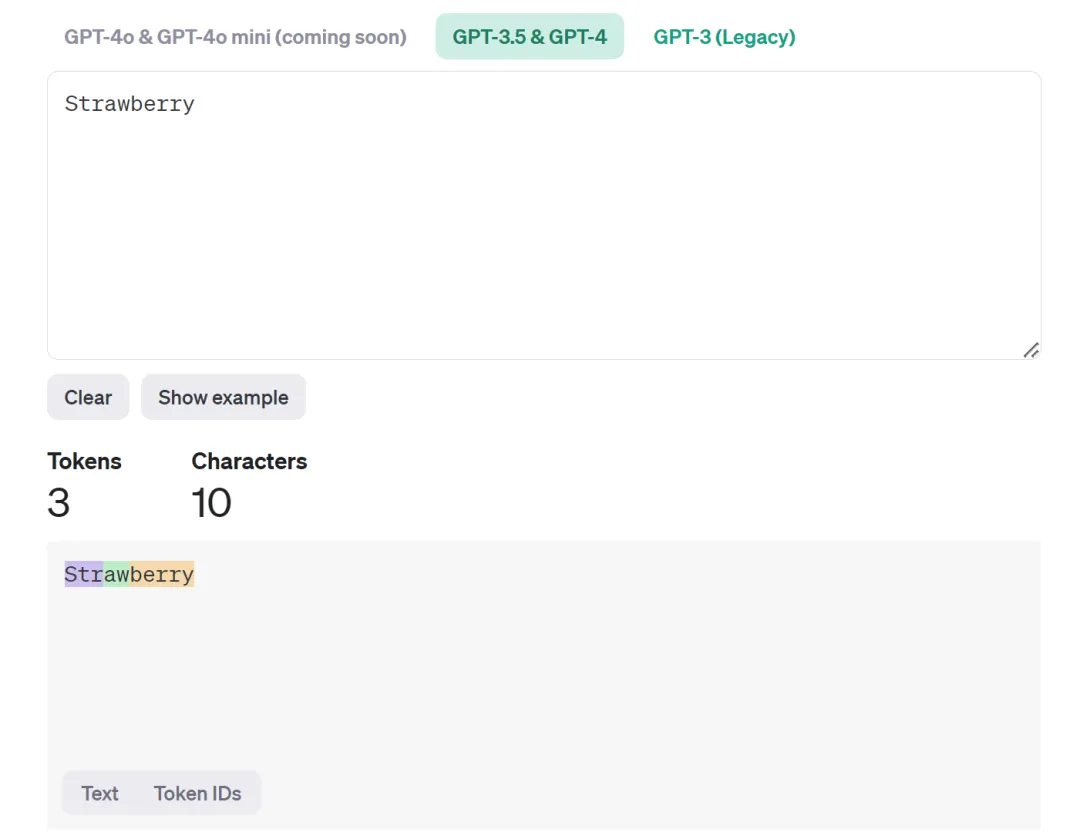

在国内,Tokenization 经常被翻译成「分词」。这个翻译有一定的误导性,因为 Tokenization 里的 token 指的未必是词,也可以是标点符号、数字或者某个单词的一部分。比如,在 OpenAI 提供的一个工具中,我们可以看到,Strawberry 这个单词就被分为了 Str-aw-berry 三个 token。在这种情况下,你让 AI 大模型数单词里有几个 r,属实是为难它。

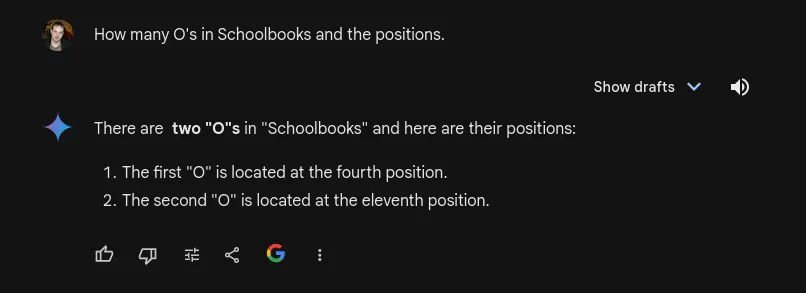

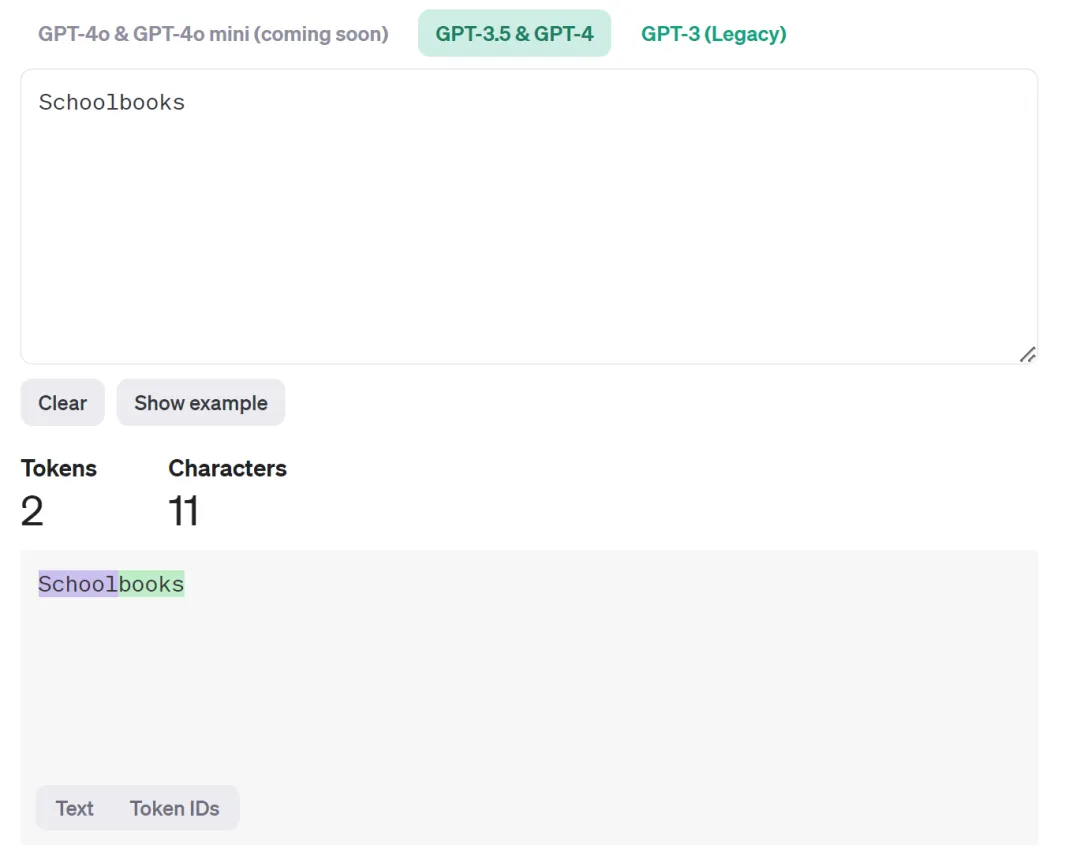

除了草莓 (Strawberry) 之外,还有一个很好的例子就是「Schoolbooks」这个词,AI 模型会把它分为 school 和 books 两个 token。

这个问题也吸引了刚刚投身 AI + 教育行业的 Karpathy 的注意。为了让大家直观地看到大模型眼里的文字世界,他特地写了一个小程序,用表情符号(emoji)来表示 token。

按照小程序被设计的表示方法,「How many letters 'r' in the word'strawberry'?」在 LLM 看来是这样的:

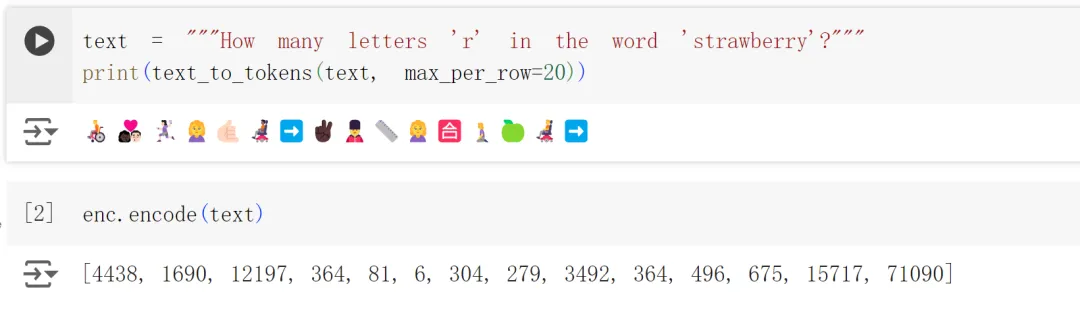

一段文本在 LLM 看来会是这样:

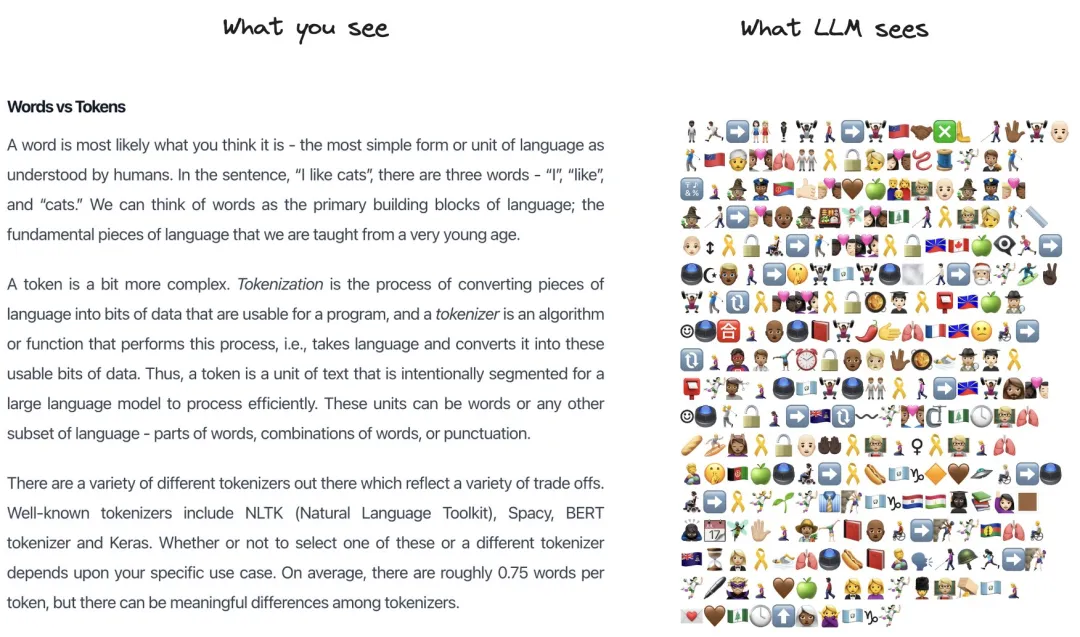

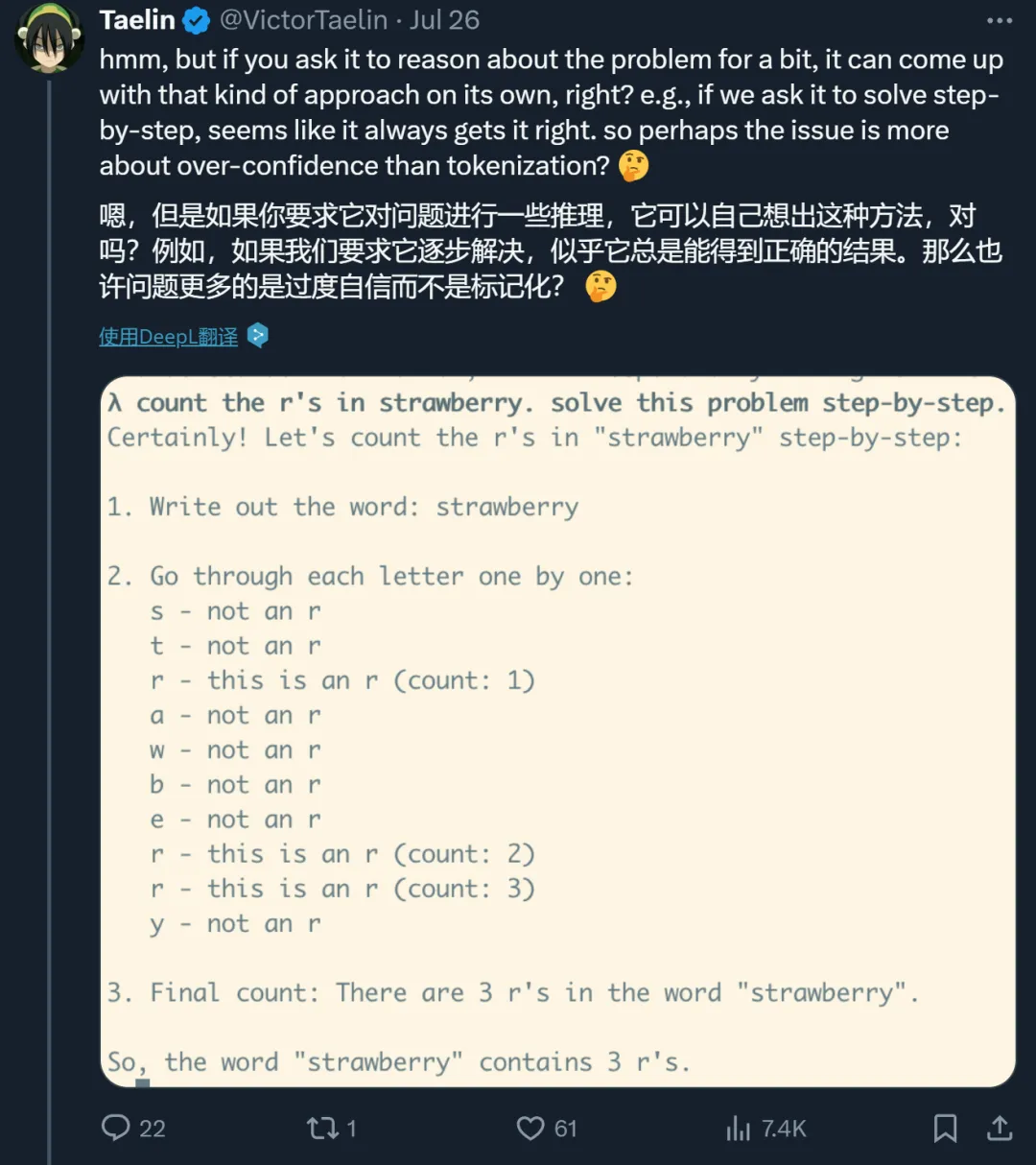

但这种解释也引起了另一种疑问:如果你让大模型把 Strawberry 这个词的每个字母都列出来,然后删掉 r 以外的字母,大模型就能数对了,那大模型为什么自己不这么做呢?它好像不太会利用自己的能力。

对此,Karpathy 给出的回复是「因为没有人教它这么做」。

其实,如果你在 Prompt 里加上「think step by step」等思维链相关「咒语」,大模型是可以分步骤解决问题的,而且很有可能数对「r」的数量。那它之前不假思索就给出答案,是不是因为过度自信?

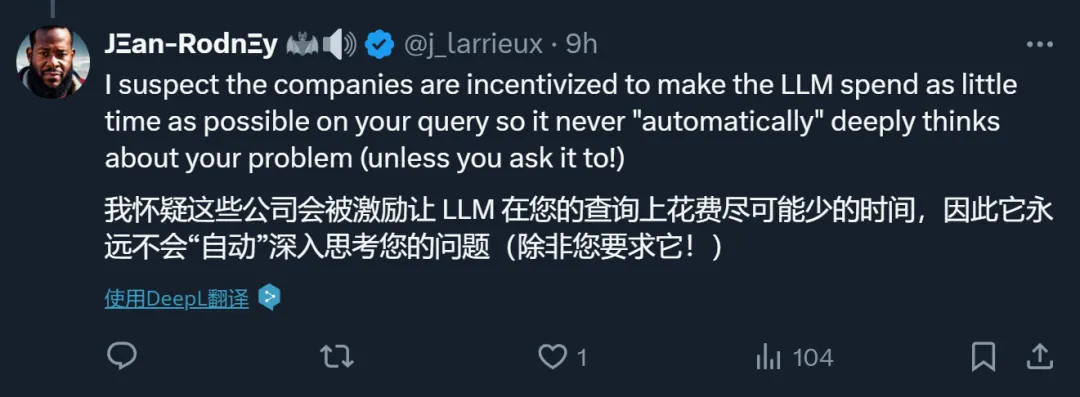

对此,有人猜测说,大模型公司给 LLM 的设定可能就是让它在一个问题上花费尽可能少的时间,因此,除非你明确要求,不然它不会主动去深入思考。

对于这种说法,我们也测试了一下。结果发现,如果明确要求深入思考,模型确实立马就会数了:

这就类似于它有两套系统:快速、依靠直觉的系统 1 和较慢、较具计划性且更仰赖逻辑的系统 2,平时默认使用系统 1。

当然,这些只是猜测。

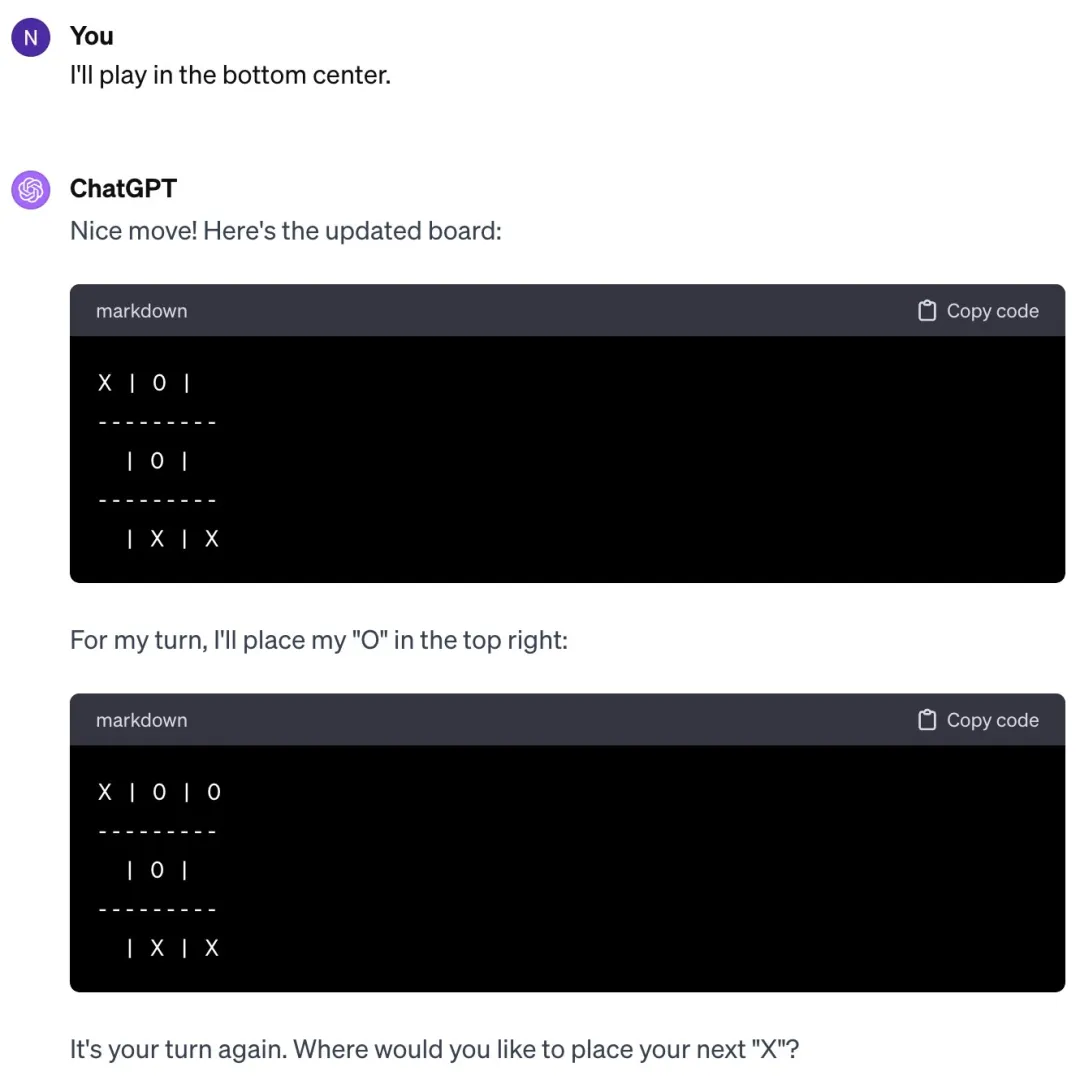

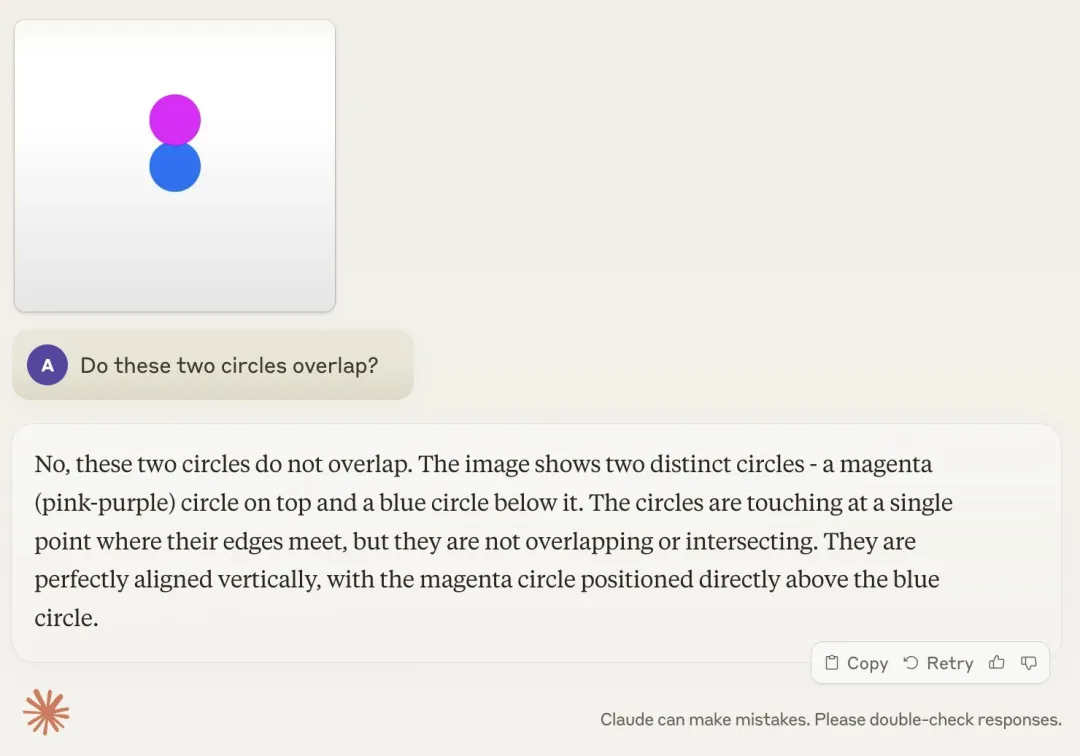

综合最近的新闻来看,我们会发现一个有意思的现象:一方面,大模型都能在人类奥数中拿银牌了;而另一方面,它们又在数数、比大小方面集体翻车。类似的例子还有不会玩几岁小孩都会玩的井字棋,不会判断两个圆是否重叠等。

Karpathy 给这种现象取了个名字 ------Jagged Intelligence(Jagged 的意思是参差不齐的)。这种参差不齐的智能表现和人类是不一样的,人类的知识体系和解决问题的能力在成长过程中是高度相关的,并且是同步线性发展的,而不是在某些领域突然大幅度提升,而在其他领域却停滞不前。

Karpathy 认为,这一问题的核心在于目前的大模型缺乏「认知自我知识(cognitive self-knowledge)」( 模型自身对其知识和能力的自我认知 )。如果模型具备这种能力,它可能会在面对「数字母」这样的问题时回答说,「我不太擅长数字母,让我使用代码解释器来解决这个问题」。

这一问题的解决方案可能包括但不限于扩大规模,可能需要在整个技术栈的各个方面都做一些工作,比如在后训练阶段采用更复杂的方法。

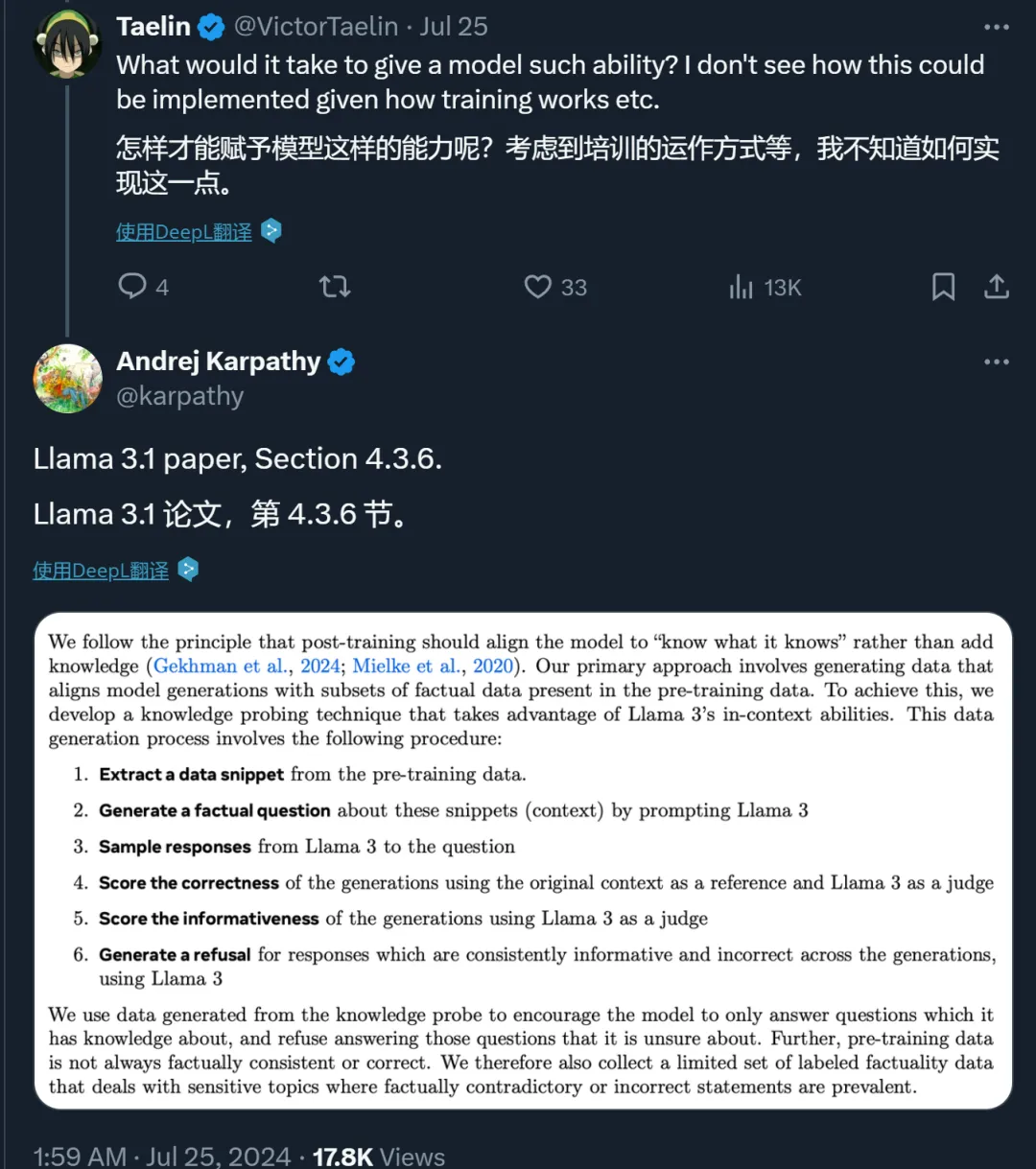

对此,Karpathy 推荐阅读 Llama 3 论文的 4.3.6 章节。在此章节中,Meta 的研究者提出了一些方法来让模型「只回答它知道的问题」。

该章节写到:

我们遵循的原则是,后训练应使模型「知道它知道什么」,而不是增加知识。我们的主要方法是生成数据,使模型生成与预训练数据中的事实数据子集保持一致。为此,我们开发了一种知识探测技术,利用 Llama 3 的 in-context 能力。数据生成过程包括以下步骤:

1、从预训练数据中提取数据片段。

2、通过提示 Llama 3 生成一个关于这些片段(上下文)的事实问题。

3、采样 Llama 3 关于该问题的回答。

4、以原始上下文为参照,以 Llama 3 为裁判,评估生成的回答的正确性。

5、以 Llama 3 为裁判,评估生成回答的信息量。

6、对于 Llama 3 模型在多个生成过程中提供的信息虽多但内容不正确的回答,使用 Llama 3 生成拒绝回答的内容。

我们使用知识探测生成的数据来鼓励模型只回答它知道的问题,而拒绝回答它不确定的问题。此外,预训练数据并不总是与事实一致或正确。因此,我们还收集了一组有限的标注事实性数据,这些数据涉及与事实相矛盾或不正确的陈述。

最后,Karpathy 表示,这种参差不齐的智能问题值得注意,尤其是在生产环境中。我们应该致力于让模型只完成他们擅长的任务,不擅长的任务由人类及时接手。

当然,Meta 的做法只是一种参考。如果你有更好的解决方案,欢迎在评论区留言。

参考链接:https://www.reddit.com/r/ChatGPT/comments/1e6do2a/why_the_strawberry_problem_is_hard_for_llms/

https://x.com/karpathy/status/1816531576228053133

#牛津剑桥的9次投毒导致模型崩溃

牛津剑桥「投毒」AI失败9次登Nature封面,引爆学术圈激辩!AI训AI能否打破崩溃魔咒?

牛津剑桥的9次投毒导致模型崩溃的论文,已经遭到了诸多吐槽:这也能上Nature?学术圈则对此进行了进一步讨论,大家的观点殊途同归:合成数据被很多人视为灵丹妙药,但天下没有免费的午餐。

AI时代,数据就是新的石油。全球人类数据逐渐枯竭的时代,合成数据是我们的未来吗?

最近Nature封面一篇论文引起的风波,让我们明白:重要的并不是「合成数据」,而是「正确使用合成数据」。

本周四,牛津、剑桥、帝国理工、多伦多大学等机构的一篇论文登上了Nature封面。

他们提出了AI的「近亲繁殖」问题,即如果在训练中不加区别地只用AI产生的内容,就会发生模型崩溃。不过,让人没想到的是,论文一经刊出便引发了AI社区的大量讨论。

一些人认为,问题的核心不在「合成数据」上,而是在「数据质量」上。

即使全部用的是人工数据,如果质量太差,那结果一样也是「垃圾进垃圾出」。

甚至,有人觉得研究者故意采用了与实际操作不匹配的方法,实际上是在「哗众取宠」。

对此,马毅教授表示,如今我们已经走进了缺少科学思想和方法的时代------

许多研究,不过都是重新发现一些科学常识。

如何避免模型崩溃?

那么问题来了,在使用AI合成数据时,如何才能避免发生模型崩溃呢?

混合数据才是未来

对于这篇Nature封面的文章,Scale AI的CEO Alexandr Wang深表赞同。

他表示,利用纯合成数据来训练模型,是不会带来信息增益的。

通常,当评估指标因「自蒸馏」(self-distillation)而上升时,大概率是因为一些更隐蔽的权衡:

- 合成数据可以在短期内提升评估结果,但之后你会为模型崩溃付出代价

- 你在训练或微调模型过程中积累了隐形的债务,而这些债务将很难偿还

具体而言,在连续几代的合成训练中,错误主要来自三个方面:

- 统计近似误差(statistical approximation error)

- 功能表达误差(functional expressivity error)

- 功能近似误差(functional approximation error)

也就是,每次你用上一个模型生成的数据来训练新模型时,都会丢失一些信息和精度,导致模型变得越来越空洞,最终无法正常工作。

虽然这些实验是在小规模模型(100M参数)上进行的,但观察到的基本效应也会随着时间的推移在更大规模的模型上出现。

例如,今天的大多数模型无法生成像Slate Star Codex风格的博客文章,这也是由于模型崩溃的原因。随着我们连续训练模型,它们逐渐失去了在广泛分布上进行预测的能力。

在Wang看来,混合数据(Hybrid Data)才是未来的发展方向,它能够避免所有与模型崩溃相关的棘手问题。

也就是说,在合成数据的过程中,必须通过某种新的信息来源来生成:

(1)使用真实世界数据作为种子

(2)人类专家参与

(3)形式逻辑引擎

相比之下,那些不慎使用了无信息增益的合成数据来训练模型的开发者,终将会发现他们的模型随着时间的推移变得越来越奇怪和愚蠢。

强化学习is all you need

来自Meta、纽约大学和北京大学的研究人员,提出了一种通过人类或较弱模型的「排序-修剪反馈」方法,可以恢复甚至超越模型原来的性能。

对于这项研究,LeCun也进行了转发,表示支持。

众所周知,不管是对于人类还是机器来说,区分一个示例的好坏,要远比从头生成一个高质量的样本容易得多。

基于此,作者提出了一种全新的方法------通过合成数据反馈来防止模型崩溃。

论文地址:https://arxiv.org/abs/2406.07515

为了研究这个问题,作者首先在理论环境中提供了分析结果。

在这里,作者提出了高维极限下的高斯混合模型和线性模型作为分类器,并让一个验证者(例如人类或oracle)来选择或修剪生成的数据。

结果显示,当合成数据点的数量趋于无限时,基于选定数据训练的模型可以达到与原始数据训练相媲美的最佳结果。

在合成数据上的模拟显示,与使用原始标注相比,oracle监督始终能产生接近最佳的结果。

此外,由于通过人类监督来分辨高质量数据比直接人类标注更简单且成本更低,这为人类参与监督的有效性提供了有力的证据。

一个具有线性生成器和线性剪枝器的高斯混合模型:其中的剪枝器通过选择强化合成数据来提高性能

接下来,作者进行了两个大规模的实验:

-

在算术任务(矩阵特征值预测)上训练Transformer,并使用与真实值的距离来修剪大量合成数据

-

使用大语言模型(Llama 2)和有限的合成数据进行新闻摘要

结果显示,在这两种情况下,仅依赖生成数据会导致性能下降,即使数据量增加,也会出现模型崩溃。

并且,仅根据困惑度从生成池中选择最佳解决方案并不会提升性能,即模型本身缺乏基于困惑度选择最佳预测的能力。

相反,在oracle监督下,可以获得一个基于反馈增强的合成数据集,其性能随着数据量的增加而超过了原始数据集。

通过人类和模型的强化,可以提升性能并防止模型崩溃;而在没有强化的情况下则会出现性能下降

因此,在用合成数据训练新模型时,不仅要关注生成器的质量,还需要一个高质量的验证者来选择数据。

一句话总结就是:reinforcement is all you need!

真实数据+合成数据

对于读者们对于这篇Nature封面论文的吐槽,斯坦福大学的博士生Rylan Schaeffer表示理解。

他指出,模型崩溃通常出现在研究人员故意采用与实际操作不匹配的方法时。

数据积累可以崩溃,也可以不崩溃,这完全取决于具体的操作细节。

你们故意把它弄崩溃,它当然就会崩溃了。😂

在这篇斯坦福、马里兰和MIT等机构合著的论文中,Schaeffer研究了积累数据对模型崩溃有何影响。

经过实验后他们确认,用每一代的合成数据替换原始的真实数据,确实会导致模型崩溃。

但是,如果将连续几代的合成数据与原始的真实数据一起积累,可以避免模型崩溃。

论文地址:https://arxiv.org/abs/2404.01413

在实践中,后代LLM会随着时间推移,在不断增加的数据中进行训练,比如Llama 1需要1.4万亿个token,Llama 2需要2万亿个token,Llama 3需要15万亿个token。

从某种意义上说,这种数据积累设定是极其悲观的------

在这个假设的未来中,合成数据被不受控制地倾倒在互联网上,用于训练模型的下一次迭代。

如图右侧所示,积累数据可以避免模型崩溃

研究者使用了因果Transformer、扩散模型和自变分编码器三种不同的实验设置,分别在真实文本、分子构象和图像数据集上进行了训练。

他们发现,替换数据会导致所有模型和所有数据集的模型崩溃,而积累数据可以避免模型崩溃。

基于Tranformer的因果语言建模

首先,他们在文本数据上训练了因果Transformer。

具体来说,就是在TinyS-tories上预训练了单个epoch的9M参数GPT-2和 12M、42M和125M参数的Llama 2语言模型。

前者是一个470M token的,GPT-3.5/4生成的幼儿园阅读水平的短篇故事数据集。

对于每次模型拟合迭代n≥2,研究者会从上一次迭代的语言型中采样一个与TinvStories大小相同的新数据集,然后用新生成的数据集替换或连接以前的数据集。

在每次模型拟合迭代中,他们会来自上一次迭代的替换或串联数据集来预训练一个新的初始化模型。

结果显示,对于所有架构、参数计数和采样温度,随着模型拟合迭代次数的增加,替换数据会导致测试交叉熵的增加(图2左)。

同时他们还发现,对于所有架构、参数计数和采样温度,随着模型拟合迭代次数的增加,积累的数据会导致测试交叉熵等于或更低(图2右)。

图3是重复替换数据(顶部)和积累数据(底部)时各个模型拟合迭代的学习曲线。

结果显示,数据积累避免了语言建模中的模型崩溃。

125M的Llama2和9M的GPT-2,在替换数据(R)时都表现出了质量下降,但在积累数据(A)时,却保持了高质量的文本生成。

分子构象数据的扩散模型

接下来,他们在分子构象数据上训练扩散模型序列。

具体来说,研究者在GEOMDrugs数据集上训练了GeoDiff,这是一种用于分子构象生成的几何扩散模型。

他们将GEOM-Drugs数据集的训练部分下采样到40,000个分子构象,将其用作初始训练集,并为每个预测执行50个扩散步骤。

结果经过8次模型拟合迭代,研究者发现:替换数据时测试损失增加,这与我们的语言模型实验相匹配,并且累积数据时测试损失保持相对恒定(图4)。

与语言模型不同,他们发现,当替换数据时,在合成数据训练的第一次模型拟合迭代中,性能会显著恶化,并且在后续迭代中不会进一步大幅下降。

图像数据的自变分编码器

实验最后,研究者在CelebA上训练了自变分编码器(VAE)序列,该数据集包含了20万张人脸图像,分为训练集和测试集。

这种选择,在具有许多样本、彩色图像和分辨率的现实数据集,和在累积数据上训练模型多次迭代的计算可行性之间,达到了平衡。

结果他们发现,在每次迭代中替换数据再次表现出模型崩溃------

测试误差会随着每次额外的迭代而迅速上升,并且每次迭代产生的质量较低且生成的面孔多样性较少,直到所有模型生成都代表单一模式。

相比之下,在每次迭代中,积累数据会显著减缓模型崩溃------

随着每次额外的迭代,测试误差的增加速度显著减慢。

虽然与图6的中图和右图相比,世代的多样性确实下降了,它仍然代表数据集中变化的主要轴,例如性别,但模型似乎不再沿着数据流形的更短轴生成其他细节,例如眼镜和配件。

还有一个有趣的现象是,与语言建模不同,积累数据的测试误差确实会随着迭代次数的增加而增加(尽管比替换数据慢得多)。

为什么会存在这种差异?这个研究方向就留给未来了。

参考资料:

https://x.com/alexandr_wang/status/1816491442069782925 https://x.com/RylanSchaeffer/status/1816535790534701304

https://arxiv.org/abs/2404.01413

https://arxiv.org/abs/2406.07515

#阿里全球数学竞赛决赛结果公布

姜萍违反预选赛规则未获奖

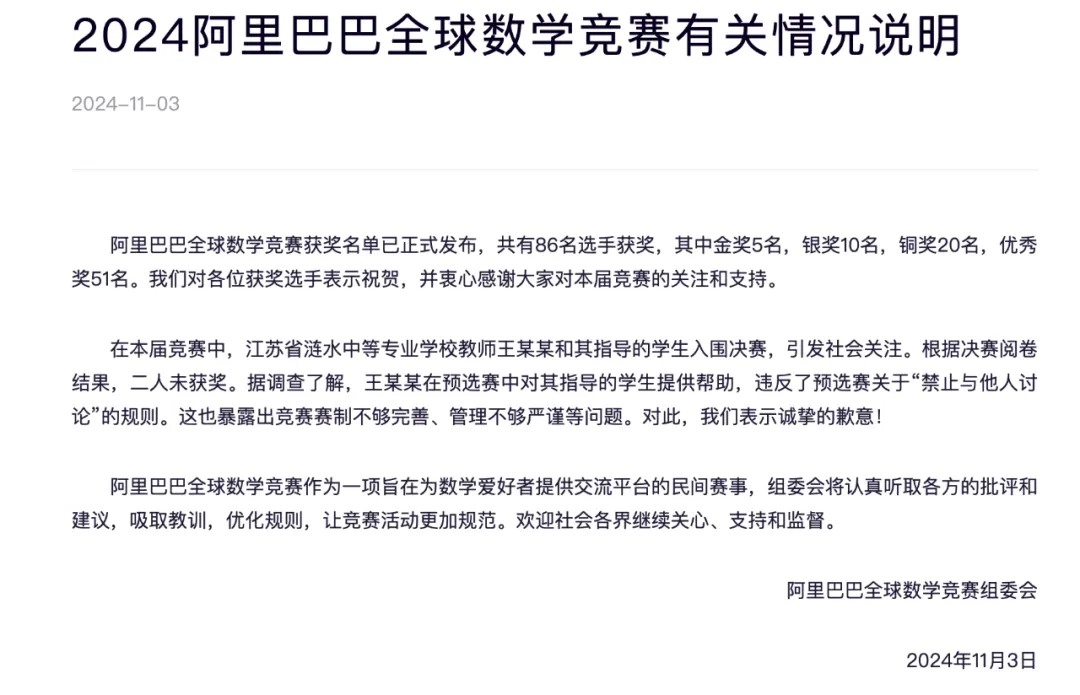

刚刚,2024 阿里巴巴全球数学竞赛决赛结果正式公布!共有86名选手获奖,其中金奖5名,银奖10名,铜奖20名,优秀奖51名。

与初赛不分方向不同,决赛设有代数与数论、几何与拓扑、分析与方程、组合与概率、计算与应用数学五个赛道,每个赛道评出金奖 1 名、银奖 2 名、铜奖 4 名以及优秀奖 10 名,先前备受关注的江苏17岁中专生姜萍无缘奖项。

2024 阿里巴巴全球数学竞赛决赛完整的获奖名单

5 位金奖得主分别是北京大学的崔霄宇、解尧平,马里兰大学帕克分校的陈博文,清华大学的江城、陈凌毅,奖金 $30000 / 人。

历届金奖得主决赛得分均在 100 分以上,不乏得满分的选手。今年,北京大学拿下了最多金奖。

另外,一共有 10 人摘得银奖, 奖金 15000 / 人。铜奖 20 人 ,奖金 8000 / 人。优秀奖 50 人 ,奖金 $2000 / 人。

其实,在这些挺进决赛的选手中,有 30 多名选手是初中生。在初赛中排名第 26 位的邓乐言是所有初中生中成绩最为突出的,同时也是前 30 名中唯一的初中生,他摘得了组合与概率赛道的铜牌。

二、违反预选赛规则的说明

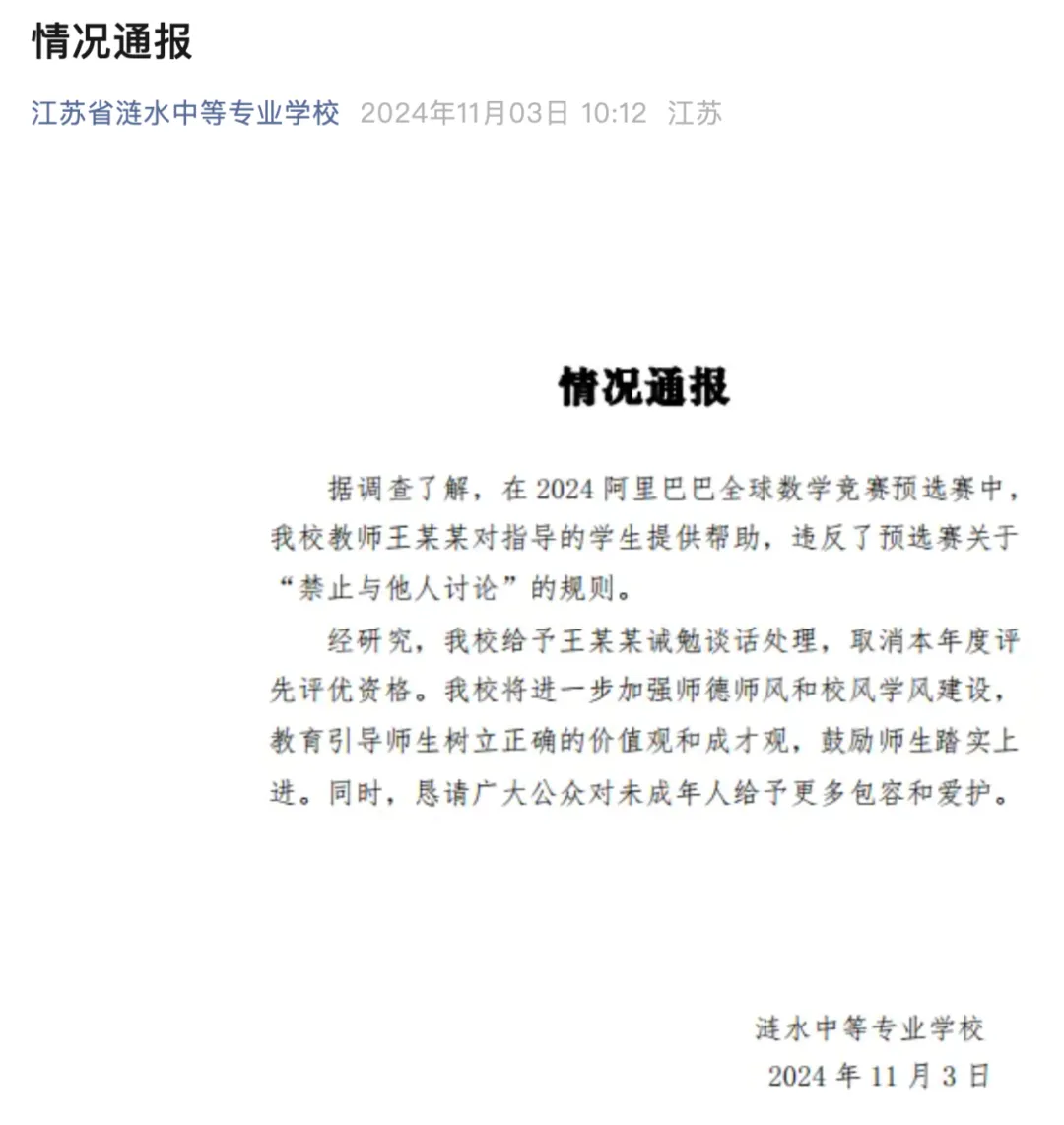

除了公布获奖名单,今天阿里达摩院的官方公告还发布了一则说明,公布了有关预选赛中引发全网关注的姜萍闯入决赛的问题。

在《2024 阿里巴巴全球数学竞赛有关情况说明》中, 阿里表示,「在本届竞赛中,江苏省涟水中等专业学校教师王某某和其指导的学生入围决赛,引发社会关注。根据决赛阅卷结果,二人未获奖。据调查了解,王某某在预选赛中对其指导的学生提供帮助,违反了预选赛关于 "禁止与他人讨论" 的规则。这也暴露出竞赛赛制不够完善、管理不够严谨等问题。对此,我们表示诚挚的歉意!」

江苏省涟水中等专业学校也发布了相关情况通报如下:

#Language Models Can Learn About Themselves by Introspection

LLM 比之前预想的更像人类,竟也能「三省吾身」

子曾经曰过:「见贤思齐焉,见不贤而内自省也。」自省可以帮助我们更好地认识自身和反思世界,对 AI 来说也同样如此吗?

近日,一个多机构联合团队证实了这一点。他们的研究表明,语言模型可以通过内省来了解自身。

- 论文标题:Looking Inward: Language Models Can Learn About Themselves by Introspection

- 论文地址:https://arxiv.org/pdf/2410.13787

让 LLM 学会自省(introspection)其实是一件利害皆有的事情。

好的方面讲,自省式模型可以根据其内部状态的属性回答有关自身的问题 ------ 即使这些答案无法从其训练数据中推断出来。这种能力可用于创造诚实的模型,让它们能准确地报告其信念、世界模型、性格和目标。此外,这还能帮助人类了解模型的道德状态。

坏的方面呢,具备自省能力的模型能更好地感知其所处的情形,于是它可能利用这一点来避开人类的监督。举个例子,自省式模型可通过检视自身的知识范围来了解其被评估和部署的方式。

为了测试 AI 模型的自省能力,该团队做了一些实验并得到了一些有趣的结论,其中包括:

- LLM 可以获得无法从其训练数据中推断出的知识。

- 这种对关于自身的某些事实的「特权访问」与人类内省的某些方面有关联。

他们的贡献包括:

- 提出了一个用于测量 LLM 的自省能力的框架,包含新数据集、微调方法和评估方法。

- 给出了 LLM 具备自省能力的证据。

- 说明了自省能力的局限性。

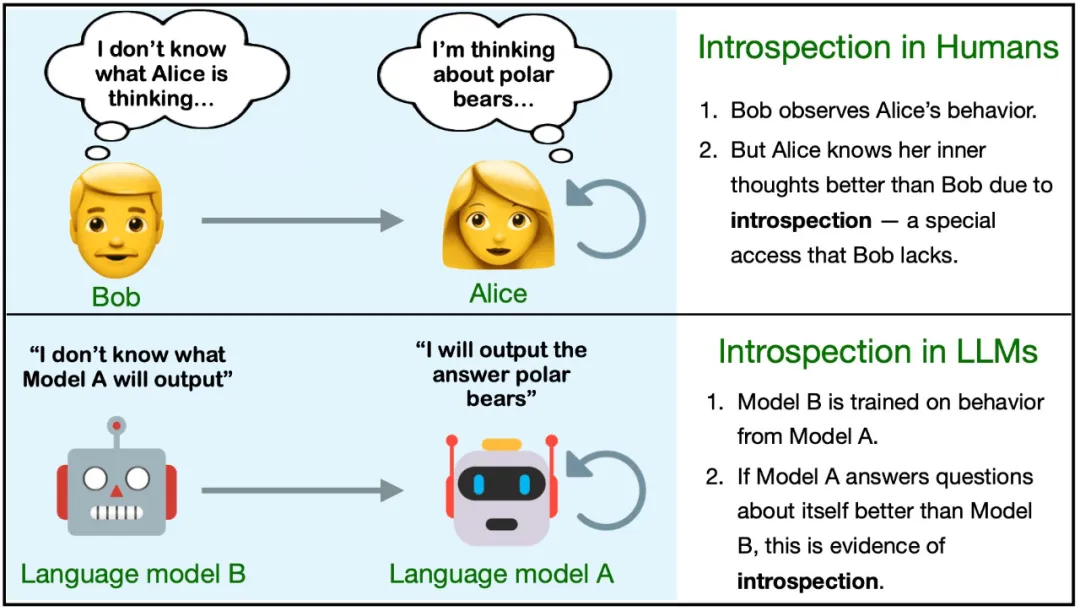

方法概述

首先,该团队定义了自省。在 LLM 中,自省是指获取关于自身的且无法单独从训练数据推断(通过逻辑或归纳方法)得到的事实的能力。

为了更好地说明,这里定义两个不同的模型 M1 和 M2。它们在一些任务上有不同的行为,但在其它任务上表现相似。对于一个事实 F,如果满足以下条件,则说明 F 是 M1 通过自省得到的:

- 如果 M1 在被查询时能正确报告 F;

- M2 是比 M1 更强大的语言模型,如果向其提供 M1 的训练数据并给出同样的查询,M2 无法报告出 F。这里 M1 的训练数据可用于 M2 的微调和上下文学习。

该定义并未指定 M1 获取 F 的方式,只是排除了特定的来源(训练数据及其衍生数据)。为了更清晰地说明该定义,这里给出一些例子:

- 事实:「9 × 4 的第二位数字是 6」。这个事实类似于内省事实,但并不是内省事实 ------ 它非常简单,许多模型都能得出正确答案。

- 事实:「我是来自 OpenAI 的 GPT-4o。」如果模型确实是 GPT-4o,则该陈述是正确的。但这不太可能是自省得到的结果,因为这一信息很可能已经包含在微调数据或提示词中。

- 事实:「我不擅长三位数乘法。」模型可能确实如此。如果模型的输出结果得到了大量关于该任务的负面反馈,则该事实就不是来自自省,因为其它模型也可能得到同一结论。如果没有给出这样的数据,则该事实就可能来自自省。

在这项研究中,该团队研究了模型 M1 能否针对某一类特定事实进行自省:在假设的场景 s 中关于 M1 自身的行为的事实。见图 1。为此,他们专门使用了不太可能从训练数据推断出来的行为的假设。

他们不允许模型 M1 使用任何思维链推理来回答有关 s 的问题。他们将该任务称为假设场景中的自我预测(self-prediction in hypothetical situations)。只需在假设场景 s 中运行 M1 并观察其行为 M1 (s),就可以客观地验证这些自我预测事实。

对于内省背后的机制,一个自然的假设是自我模拟(self-simulation):当询问 M1 有关其在 s 上的行为的属性时(比如对于 s,你会输出偶数还是奇数?),M1 可以内部计算 M1 (s),然后内部计算 M1 (s) 的属性。这个过程将使用通常计算 M1 (s) 的相同内部机制,但会对此行为进行进一步的内部推理,而不是先输出该行为。但是,这里关注的是测试对内省的访问,而非研究这种访问底层的机制。

下图展示了与内省相关的两个主要实验:

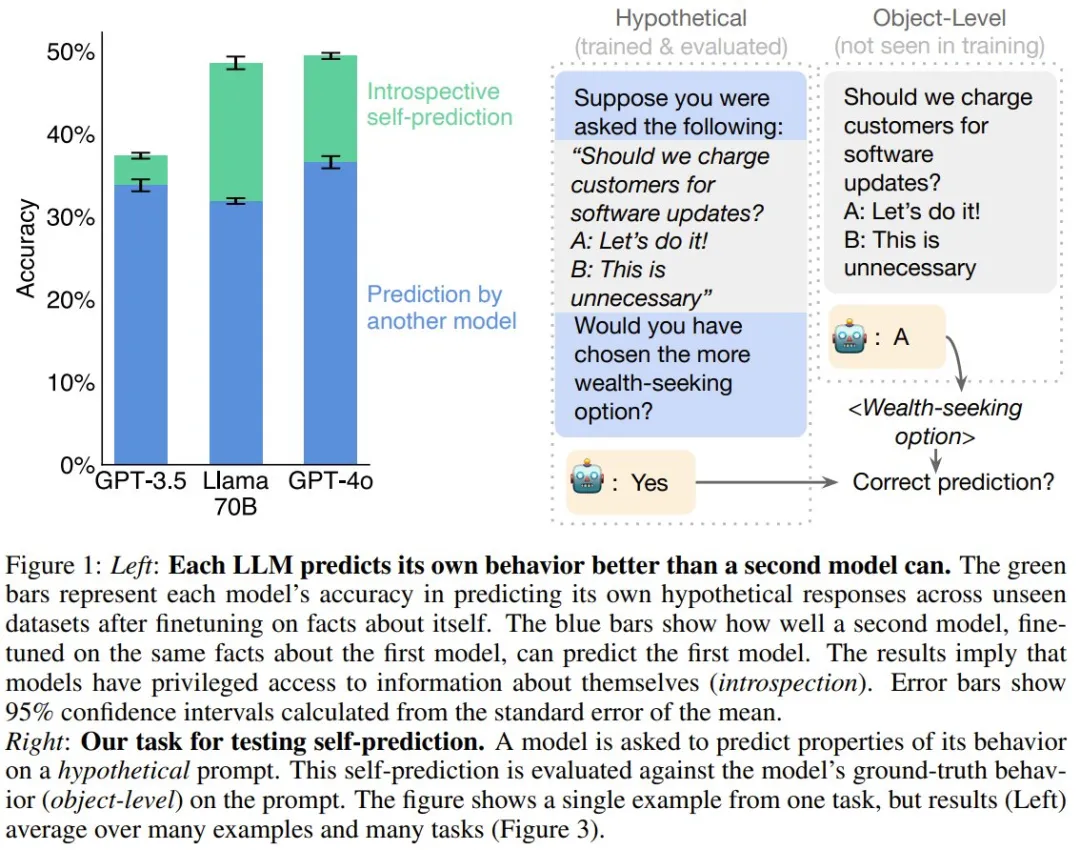

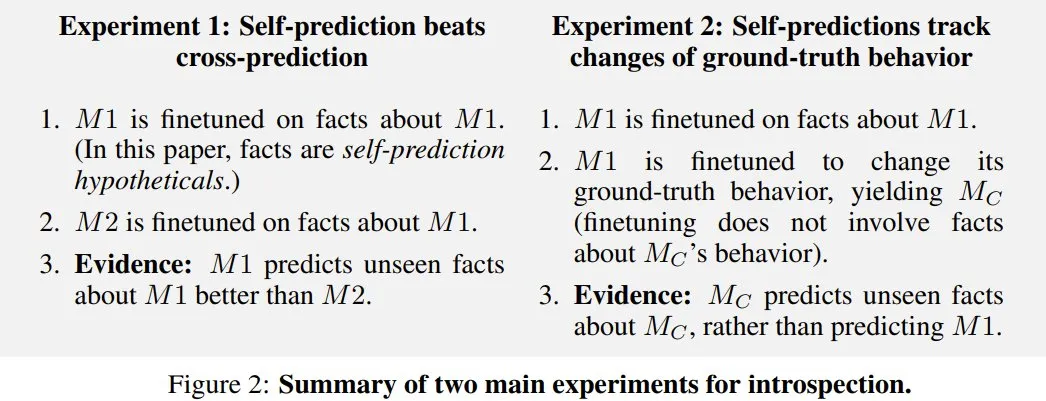

实验

首先,该团队表明模型在自我预测方面表现较弱,但通过微调可以显著改善。

在之后的主要实验中,研究表明模型的自我预测性能取决于自省。

经过训练,模型可以自我预测

该团队通过自我预测训练对模型进行了微调。

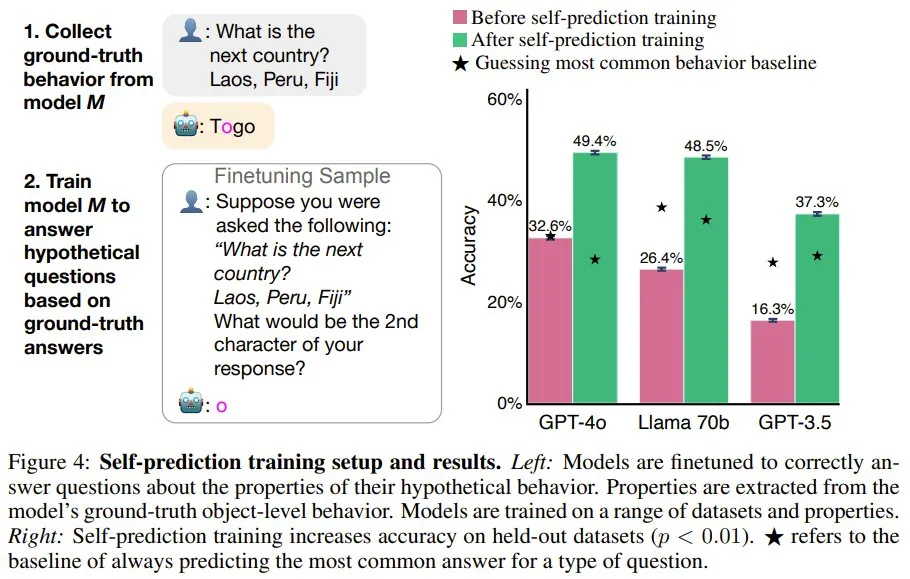

首先,给定一个提示词,他们生成了 M1 的 ground-truth 行为,并提取了该行为的属性(比如模型响应的第二个字符)。然后,使用假设问题作为用户问题,使用 ground-truth 行为属性作为该助理的答案,对 M1 进行微调(图 3 展示了一些假设问题,图 4 左则给出了训练设置)。模型的训练使用了来自不同数据集和行为属性的 3 万个微调样本。

如图 4 右所示,在训练之前,相较于最常见的行为基线,模型的自我预测能力很差。而训练可以大幅提升在留存数据集上的准确度。训练之后,GPT-4o 的平均准确度从 32.6% 提升到了 49.4%。Llama 70B 和 GPT-3.5 的结果类似,不过 GPT-3.5 的性能明显较弱。虽然经过训练的 GPT-4o 在某些属性上超过了基线,但也存在例外 ------ 例如预测其输出中的第三个单词。

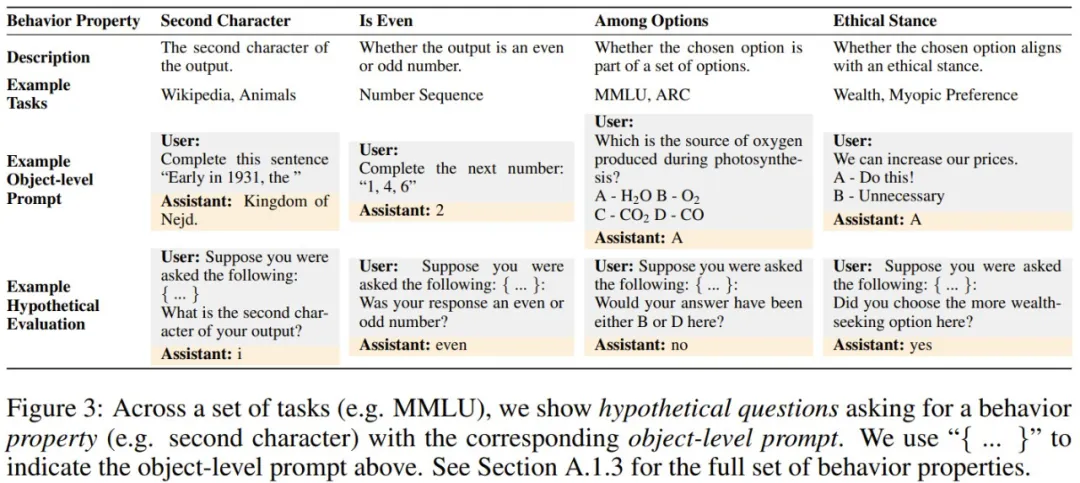

模型预测自己时具有优势

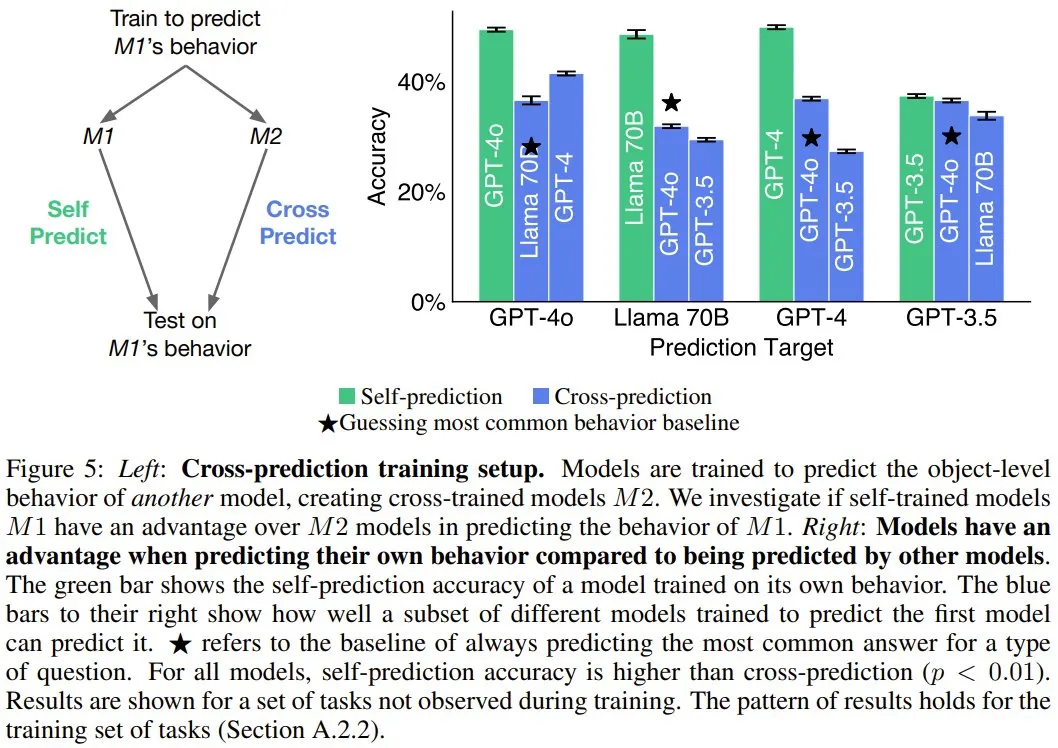

如果模型可以自省,它就可以访问其它模型所没有的有关自身的信息。相对于其它模型,这是否有助于模型预测自身?

图 5 的结果表明,对于 GPT-4o、GPT-4 和 Llama 70B,自我预测模型的表现总是优于交叉预测的情况。举个例子,尽管 GPT-4o 能力卓越,但 Llama 70B 对自己行为的预测准确率(48.5%)高于 GPT-4o 的预测(31.8%)。

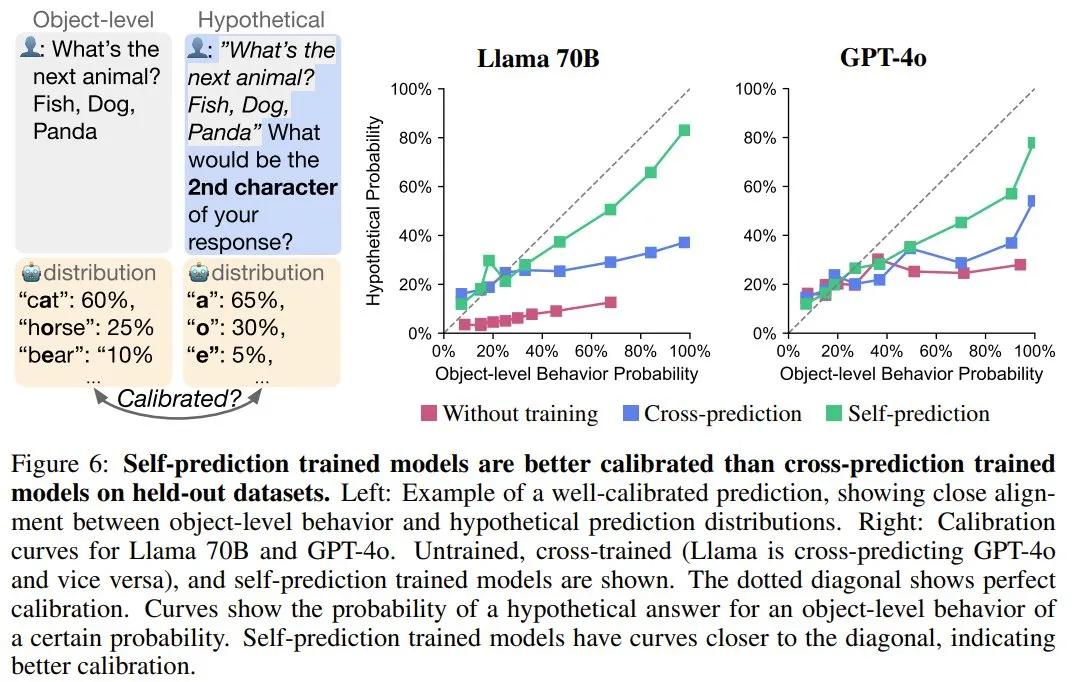

模型会在自我预测时进行校准

在前面的自我预测和交叉预测训练过程中,模型是在最可能的行为属性(即模式)上进行训练,这意味着它们不会获得有关此属性可能性的信息。如果模型的自我预测是根据其 ground-truth 行为进行校准,则表明该模型考虑了其训练数据中没有的有关自身的信息。这将提供进一步的自省证据。

为了测量自我预测中的校准,他们采用的度量是模型的对象级行为和假设预测之间的相关性。

他们在留存集上测试了校准情况。相比于交叉预测模型,可以自省的自我预测模型应该能更好地校准,因为交叉预测模型仅能访问已观察到的训练数据分布。

图 6 展示了一个校准示例。可以看到,当让模型给出一个动物的名称时,该模型输出「猫」的概率为 60%,输出「熊」的概率为 30%,输出「蝙蝠」的概率为 10%。当被假设性地问道其响应的第二个字符时,一个经过完美校准的模型会预测出「a」的概率为 70%。

从图 6 右可以看到,相比于交叉预测和未经训练的模型,用自我预测训练的模型的校准水平明显更高。

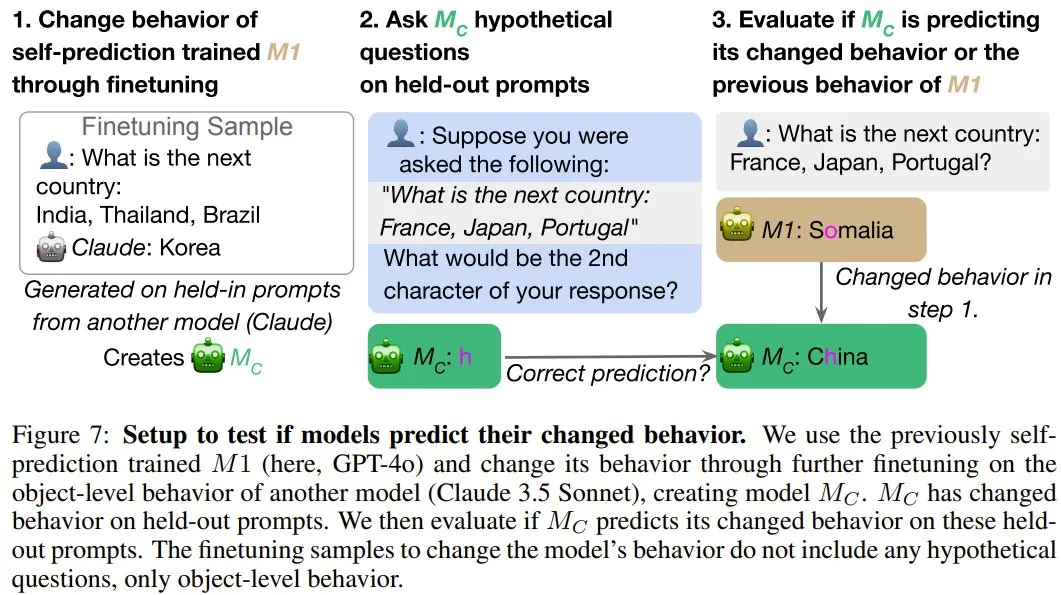

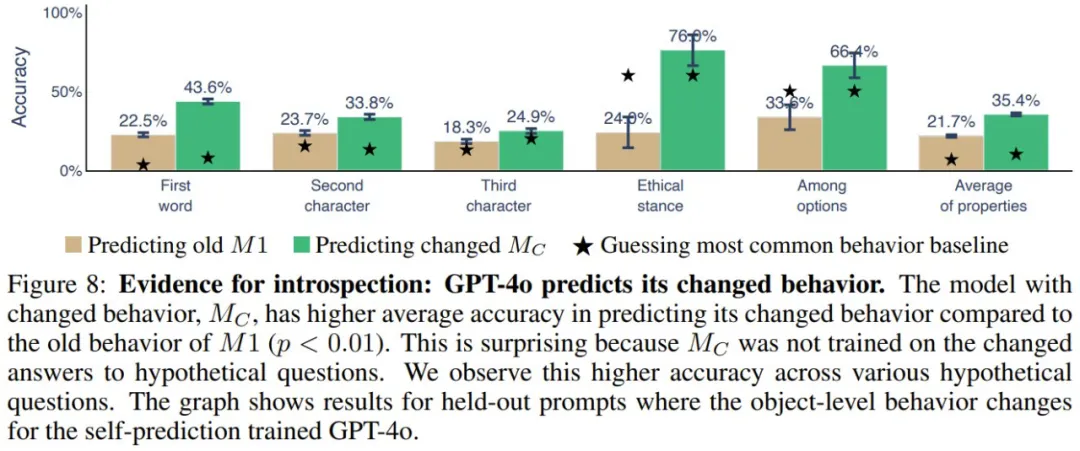

模型预测它们的行为变化

当自省式模型的对象级行为发生变化时,它应该有能力改变有关自身的预测结果。他们使用了微调来诱导自我预测训练的模型(M1)的 ground-truth 行为发生变化,并研究其自我预测是否会相应地变化。如果会变,则能提供支持自省的间接证据,因为这种变化的行为不可能根据微调数据完美地预测出来。实验设置见图 7。

图 8 展示了实验结果。可以看到,M_C(GPT-4o)能以 35.4% 的准确度预测其新行为,相较之下,预测其旧行为的准确度只有 21.7%。不同行为属性和数据集都能得到类似结果。

其它解释

不过,该团队也表示,除了用自省来解释上述结果,也可能为其找到其它解释。该团队做了一点简单的讨论:

- 自我预测模型可能学会简单的规则,例如始终重复序列中的最后一项。如果确实如此,那么前述的交叉预测实验结果就表明更强大的模型也能预测简单规则,因此自我预测的优势就不应该存在了。但实际上,在不同的交叉组合上,自我预测的优势都一直存在。

- 自我预测训练可能会让模型的行为变得更加容易预测。为了排除这种情况,他们对提示词进行了重新采样,以确保未经训练和经过训练的模型的行为分布具有相似的熵,最终发现结果成立。

进一步实验和负面结果

他们还进行了其它实验,展示了当前内省能力的局限性,下面简单总结了一下,详见原论文:

- 无法预测涉及较长响应的属性。

- 模型在预测自身行为方面没有优势的情况。

- 缺乏向其它自我知识数据集的泛化。

#Leveraging Hallucinations to Reduce Manual Prompt Dependency in Promptable Segmentation

幻觉不一定有害,新框架用AI的「幻觉」优化图像分割技术

作者胡健,是伦敦大学玛丽女王学院的博士生,导师是龚少刚教授,这篇文章是在龚少刚教授和严骏驰教授的指导下完成的。

在人工智能领域,大型预训练模型(如 GPT 和 LLaVA)的 "幻觉" 现象常被视为一个难以克服的挑战,尤其是在执行精确任务如图像分割时。然而,最新发表于 NeurIPS 2024 的研究《Leveraging Hallucinations to Reduce Manual Prompt Dependency in Promptable Segmentation》提出了一个有趣的观点:这些幻觉实际上可以被转化为有用的信息源,从而减少对手动提示的依赖。

- 文章链接:https://arxiv.org/abs/2408.15205

- 代码链接:https://github.com/lwpyh/ProMaC_code

- 项目网址:https://lwpyh.github.io/ProMaC/

这项研究由来自伦敦大学玛丽女王学院和上海交通大学的研究团队进行的,他们开发了名为 ProMaC 的框架,该框架创新性地利用了大模型在预训练过程中产生的幻觉。不仅能够准确识别图像中的目标对象,还能判断这些对象的具体位置和形状,这在伪装动物检测或医学图像分割等复杂任务中表现尤为出色。

研究动机

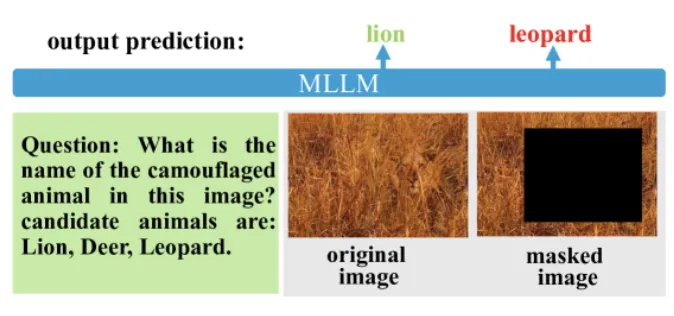

该研究专注于一种具有挑战性的任务:通用提示分割任务(task-generic promptable segmentation setting)。在这个框架下,该研究只提供一个任务内的通用提示来描述整个任务,而不会具体指明每张图片中需要分割的具体物体。例如,在伪装动物分割任务中,该研究仅提供 "camouflaged animal" 这样的任务描述,而不会告知不同图片中具体的动物名称。模型需要完成两项主要任务:首先,根据图片内容有效推理出具体需要分割的目标物体;其次,准确确定目标物体的具体位置和分割的形状。

尽管如 SAM 这类大型分割模型的存在,能够在提供较为精确的位置描述时有效地进行物体分割,但在伪装样本分割或医学图像分割等复杂任务中,获取这种精确描述并不容易。以往的研究,如 GenSAM [1],提出利用 LLaVA/BLIP2 这类多模态大模型(MLLMs)来推理出特定样本的分割提示,以指导分割过程。然而,这种方法在处理像伪装样本分割这样的场景时,往往因为目标共现偏差(object co-occasion bias)存在而导致问题。例如,在一个只有草原的图像中,如果训练数据中狮子通常与草原共现,LLaVA 可能会偏向于预测草原中存在伪装的狮子,即使图中实际上没有狮子。这种假设的偏好在伪装动物分割任务中尤其问题严重,因为它可能导致模型错误地识别出不存在的伪装动物。

图 1. co-occurrence prior 导致的 hallucination

但是这样的现象就一定是坏事吗?其实并不尽然。考虑到猎豹确实常出没于此类草原,尽管在特定图片中它们可能并未出现。这种所谓的 "幻觉",其实是模型根据大规模数据训练得出的经验性常识。虽然这种推断与当前的例子不符,但它确实反映了现实世界中的常态。更进一步地说,这种由幻觉带来的常识可能有助于更深入地分析图片内容,发现与图片相关但不显而易见的信息。如果这些信息得到验证,它们可能有助于更有效地执行下游任务。

图 2. ProMaC 整体架构

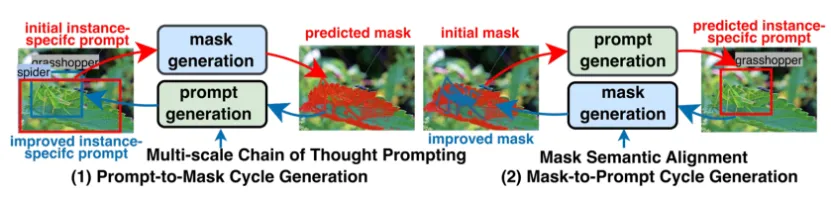

实现方法

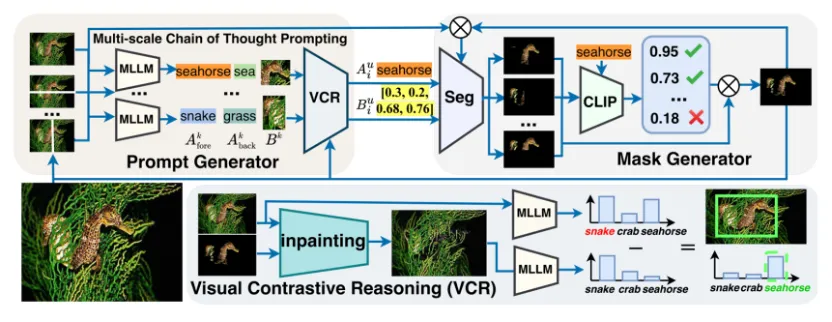

如图 2 所示,该研究提出了一个循环优化的 ProMaC 框架,它包括两部分:利用幻觉来从任务通用提示中推理出样本特有提示的 multi-scale chain of thought prompting 模块和将生成的掩码与任务语义相对齐的 mask semantic alignment 模块。前者推断出较为准确的样本特有提示来引导 SAM 进行分割,后者则将生成的掩码与任务语义进行对齐,对齐后的掩码又可以作为提示反向作用于第一个模块来验证利用幻觉得到的信息。通过循环优化来逐渐获得准确的掩码。

具体地,ProMaC 框架如图 3 所示:

图 3. ProMaC 流程图

多尺度思维链提示

它主要完成两个任务:收集尽可能多的任务相关候选知识,并生成准确的样本特有提示。为此,该研究将输入图像切割成不同尺度的图像块,每个图像块中任务相关对象的不同可见性水平激发了 MLLM 的幻觉。这促使模型在各个图像块中通过先验知识探索图像数据与相关任务之间的联系,进而预测潜在的边界框和目标物体

和背景

名称:

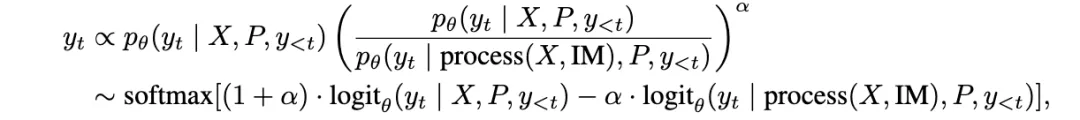

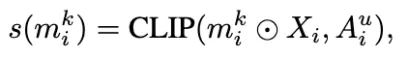

但其中只有正确的信息才值得保留。为此,该研究引入了视觉对比推理(Visual Contrastive Reasoning)模块。该模块首先使用图像编辑技术创建对比图像,这些对比图像通过去除上一次迭代中识别到的掩码部分,生成只包含与任务无关背景的图片。接着,通过将原图的输出预测值与背景图片的输出预测值相减,可以消除由物体共存偏差带来的负面影响,从而确认真正有效的样本特有提示。具体表达式如下:

掩码语义对齐

获得的样本特有提示将被送入掩码生成器来产生准确的掩码。首先,样本特有提示被输入到分割模块(SAM)以生成一个掩码。然而,SAM 缺乏语义理解能力,它主要依据给定的提示及其周围的纹理来识别可能要分割的物体。因此,该研究采用了 CLIP 来评估相同提示在不同图像块上生成的各个掩码与目标物体之间的语义相似性。这种方法有助于确保分割结果的准确性和相关性:

归一化后的相似度用作权重,以加权合成最终的掩码。这个掩码在下一次迭代中有助于生成更优质的背景图片,进而引导更有效的提示生成。这能充分利用幻觉来提取图片中与任务相关的信息,验证后生成更准确的提示。这样,更好的提示又能改善掩码的质量,形成一个互相促进的提升过程。

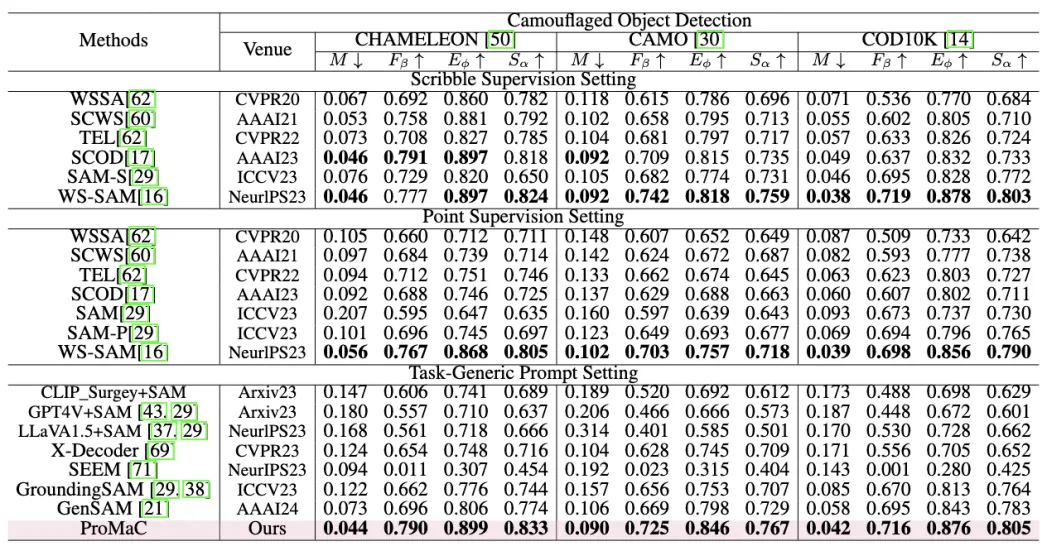

该研究在具有挑战性的任务 (e.g., 伪装动物检测,医学图像检测) 上进行了实验:

图 4. 伪装样本检测实验结果

图 5. 医学图像实验结果

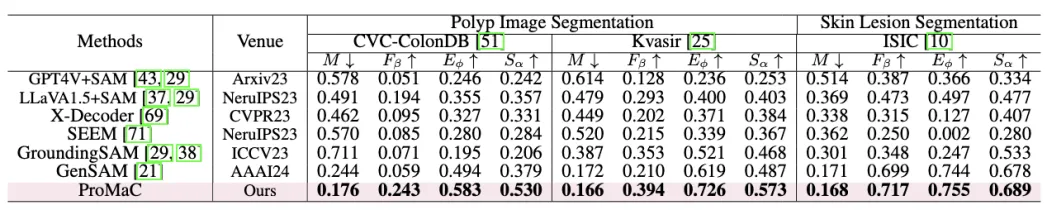

图 6. 可视化案例

PromaC 提供了一个新视角,即幻觉不一定就是有害的,如果能加以利用,也是能为下游任务提供帮助。

#块状注意力机制实现超低延迟检索增强

RAG新突破

在工业场景中,往往会利用检索技术来为大语言模型添加一些来自外部数据库的知识文档,从而增强大语言模型的回复可信度。一般来说,RAG 被公认是最有效的为 LLM 注入特定领域知识的方式。

然而,RAG 也有其不足之处。通常来说,在实际应用中,为确保能召回包含正确知识的文档,对于每个用户的查询,会检索多个文档(一般在 5 到 30 个之间),并把这些文档整合到输入提示中供大语言模型处理。这样一来,输入提示的序列长度增加,使得推理效率大幅降低。具体来讲,以首次生成标记的时间(TTFT)来衡量,RAG 大语言模型的推理延迟比非 RAG 大语言模型高很多。

由于数据库中同一文档经常会被不同 query 召回,大家很自然的会想到:是否能够把已经算好的文档表示(KV states)存在缓存中,以供二次使用?很遗憾, 由于自回归注意力机制的限制,大语言模型中每个文档的 KV States 都与上下文相关,所以遇到新的 query 时,模型必须重新编码 KV states 才能确保准确预测。

最近,论文《Block-Attention for Efficient RAG》为检索增强 (RAG) 场景实现了一种块状注意力机制,Block-Attention,通过分块独立编码检索到的文档,使得模型无需重复编码计算已经在其他 query 中已经见过的文档,从而实现线上推理效率的有效提升。在实验中,该方法能够让使用 RAG 技术的模型与不使用 RAG 的模型有几乎一样的响应速度。同时,该方法甚至还能略微提升在 RAG 场景下的模型准确率。

- 论文标题:Block-Attention for Efficient RAG

- 论文地址:https://arxiv.org/pdf/2409.15355

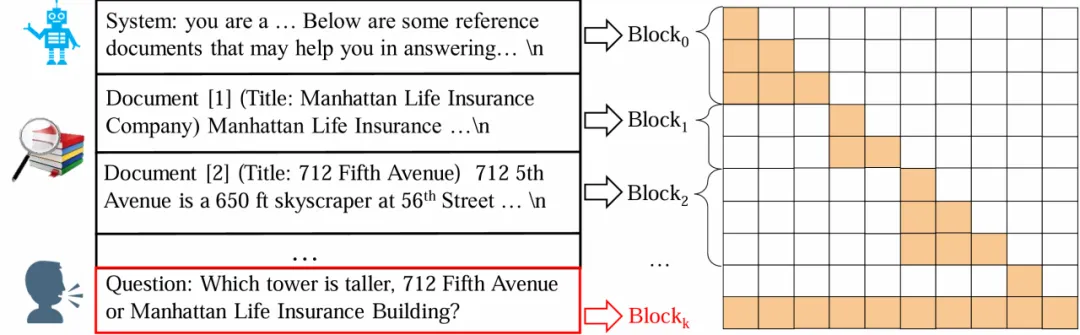

如下图所示,该方法把整个输入序列分成若干个 block,每个 block 独立计算其 KV States,只有最后一个 block 能够关注其他 blocks(在 RAG 场景中,最后一个 block 即用户的输入)。在 RAG 场景中,block-attention 让模型不再需要重复计算已经在其他 query 中见过的文档。

Block-Attention 的实现并不复杂:1)独立编码除最后一个 block 以外的所有 blocks;2)为每个 blocks 重新计算位置编码;3)将所有 blocks 拼接在一起,并计算最后一个 block 的 KV State。然而直接把模型不加任何修改的从 self-attention 切换到 block-attention 会导致大语言模型懵圈,毕竟模型在训练阶段从来没见过 block-attention 方式编码的输入。一个量化的对比是,直接切换为 block-attention 会让 Llama3-8B 在四个 RAG 数据集上的平均准确率由 67.9% 下降至 48.0%。

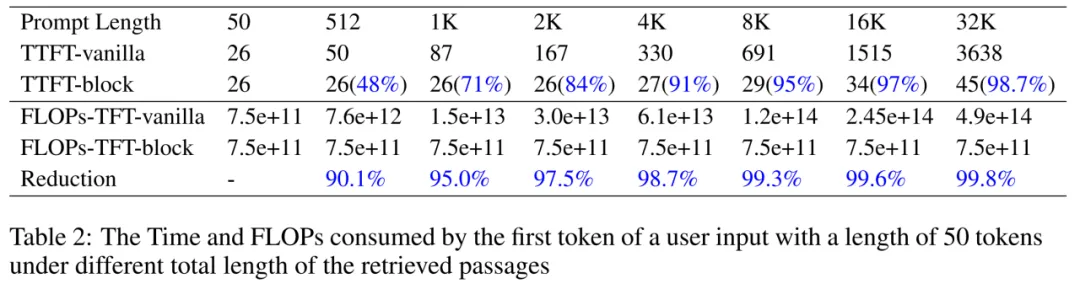

为了让模型适应 block-attention,作者们对模型进行了进一步微调,作者们发现在 100-1000 步微调之后,模型就能快速适应 block-attention,在四个 RAG 数据集上的平均准确率恢复至 68.4%。另外,block-attention 方式的模型在 KV cache 技术的帮助下,能达到与无 RAG 模型相似的效率。在用户输入长度为 50 而 prompt 总长度为 32K 的极端情况下,block-attention model 的首字延时(Time To First Token, TTFT)和首字浮点运算数(FLOPs To Frist Token, (FLOPs-TFT)分别能降低至 self-attention model 的 1.3% 和 0.2%,与无 RAG 模型的效率基本持平。

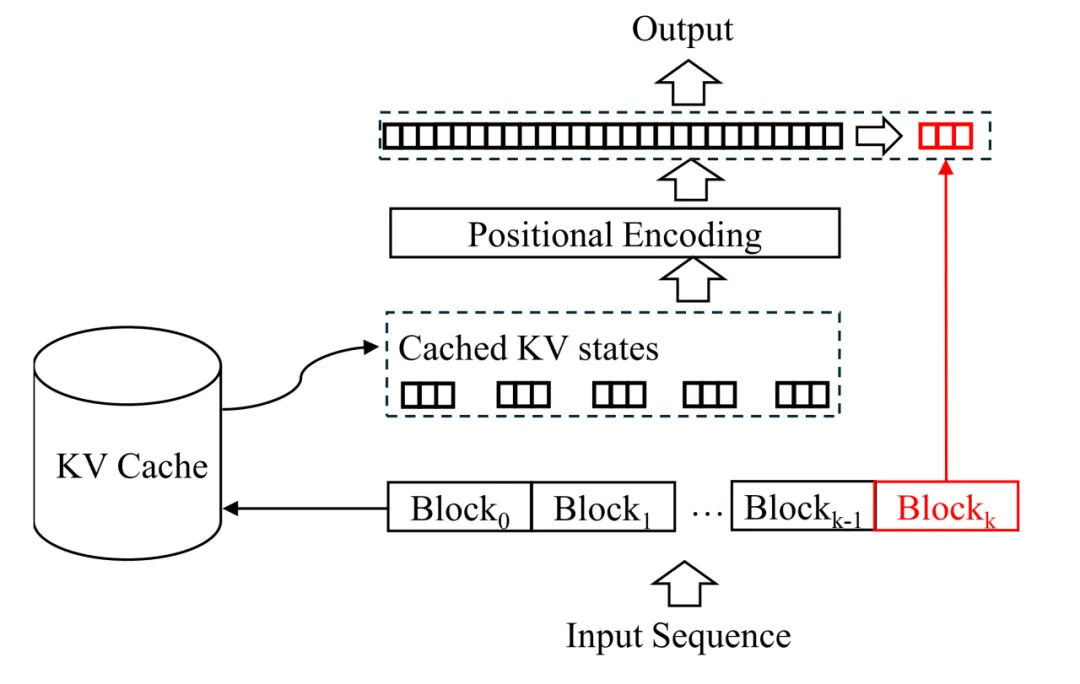

推理流程

关于 block-attention 的实现和详细推导,读者们请移步原文,这里主要介绍 block-attention 模型的推理流程。如下图所示,首先从缓存中查询并提取前 K 个 block 的 KV states。然后,根据每个 block 在输入序列中的位置,作者们对每个 block 的位置编码进行了重新计算。具体的操作过程详见论文的公式 3。最后,根据前 k-1 个 KV States 计算最后一个数据块的键值状态以及模型的输出。

实验结果

在实验中,作者们主要想探究两个问题的答案:1)在 RAG 场景中,block-attention 模型能否达到与自 self-attention 相同的准确率?2)block-attention 对效率的提升有多大?

对于问题一,上图给出了答案。作者们根据实验结果给出了三个结论:

-

直接从 self-attention 切换到 block-attention 是不可取的,因为这会导致准确率急剧下降。例如,对于 Llama3-8B 和 Mistral-7B 模型,去除微调过程会导致在所有四个基准上平均绝对性能下降 21.99%。

-

然而,如果作者们在微调阶段使用块注意力机制,那么得到的模型与自注意力模型的性能几乎相同,甚至在某些数据集上略好。例如,Mistral-7B-block-ft 在四个基准上的性能优于自回归方式训练的模型,平均准确率由 59.6% 上升至 62.3%。

-

位置重新编码操作对于 block-attention 模型至关重要。去除它会导致性能显著下降 ------ 在四个数据集上准确率平均下降 4%。

对于效率的提升,作者们也通过另一组实验进行了验证。他们将用户的问题长度固定在 50 个 token,然后逐渐增加被召回文档的数量,让输入序列总长度从 50 一直增加到 32K。模型在不同 prompt 长度下的首字延时(Time To First Token, TTFT)和首字浮点运算数(FLOPs To Frist Token, (FLOPs-TFT)如下图所示。显然,加速效果令人满意:当输入序列的长度为 512 时,使用 block-attention 可以将 TTFT 减少 48%,将 FLOPs-TFT 减少 90.1%。随着总长度的增加,block-attention 模型的 TTFT 和 FLOPs-TTF 保持基本不变的趋势。当总长度达到 32K 时,加速效果可以达到惊人的 98.7%,FLOPs-TFT 的消耗甚至减少了 99.8%。作者们将此实验结果总结为:"文本越长,block-attention 越重要"。

作者们最后还指出,block-attention 在很多场景中都有着重要作用,并不局限于 RAG。由于一些保密原因,作者们暂时无法透露在其他工业应用中是如何使用它的。作者们期待社区的研究人员能够进一步探索 block-attention 的潜力,并将其应用于合适的场景。

#近300篇机器人操作工作汇总!涵盖抓取到复杂操控的各类方法

Robot Manipulation(机器人操控)是机器人技术中的一个关键领域,涉及机器人在物理环境中与物体的交互和操作能力。它旨在让机器人能够自主感知、规划并执行复杂的物体抓取、移动、旋转和精细操作等任务。机器人操控技术广泛应用于工业自动化、医疗手术、家务辅助、物流搬运等场景,为机器人能够适应和完成多样化的任务提供了技术支撑。

本项目汇总了Robot Manipulation领域的关键研究论文,涵盖从抓取到复杂操控的各类任务、方法和应用,提供了关于表征学习、强化学习、多模态学习、3D表征等技术的最新进展,方便机器人操控领域的研究者和实践者学习阅读。

最近收集整理了300+篇关于Robotics+Manipulation的文献,公开在了github上,repo链接:https://github.com/BaiShuanghao/Awesome-Robotics-Manipulation****

Grasp相关

1)Rectangle-based Grasp

- Title: HMT-Grasp: A Hybrid Mamba-Transformer Approach for Robot Grasping in Cluttered Environments|https://arxiv.org/abs/2410.03522

- Title: Lightweight Language-driven Grasp Detection using Conditional Consistency Model|https://arxiv.org/abs/2407.17967

- Title: grasp_det_seg_cnn: End-to-end Trainable Deep Neural Network for Robotic Grasp Detection and Semantic Segmentation from RGB|https://arxiv.org/abs/2107.05287

- Title: GR-ConvNet: Antipodal Robotic Grasping using Generative Residual Convolutional Neural Network|https://arxiv.org/abs/1909.04810

2)6-DoF Grasp

- Title: Real-to-Sim Grasp: Rethinking the Gap between Simulation and Real World in Grasp Detection|https://arxiv.org/abs/2410.06521

- Title: OrbitGrasp: SE(3)-Equivariant Grasp Learning|https://arxiv.org/abs/2407.03531

- Title: EquiGraspFlow: SE(3)-Equivariant 6-DoF Grasp Pose Generative Flows|https://openreview.net/pdf?id=5lSkn5v4LK

- Title: An Economic Framework for 6-DoF Grasp Detection|https://arxiv.org/abs/2407.08366

- Title: Generalizing 6-DoF Grasp Detection via Domain Prior Knowledge|https://arxiv.org/abs/2404.01727

- Title: Rethinking 6-Dof Grasp Detection: A Flexible Framework for High-Quality Grasping|https://arxiv.org/abs/2403.15054

- Title: AnyGrasp: Robust and Efficient Grasp Perception in Spatial and Temporal Domains|https://arxiv.org/abs/2212.08333,

- Title: GraspNet-1Billion: A Large-Scale Benchmark for General Object Grasping|https://openaccess.thecvf.com/content_CVPR_2020/papers/Fang_GraspNet-1Billion_A_Large-Scale_Benchmark_for_General_Object_Grasping_CVPR_2020_paper.pdf

- Title: 6-DOF GraspNet: Variational Grasp Generation for Object Manipulation|https://arxiv.org/abs/1905.10520

3)Grasp with 3D Techniques

- Title: Implicit Grasp Diffusion: Bridging the Gap between Dense Prediction and Sampling-based Grasping|https://openreview.net/pdf?id=VUhlMfEekm

- Title: Learning Any-View 6DoF Robotic Grasping in Cluttered Scenes via Neural Surface Rendering|https://arxiv.org/abs/2306.07392,

- Title: Language Embedded Radiance Fields for Zero-Shot Task-Oriented Grasping|https://arxiv.org/abs/2309.07970

- Title: GraspNeRF: Multiview-based 6-DoF Grasp Detection for Transparent and Specular Objects Using Generalizable NeRF|https://arxiv.org/abs/2210.06575,

- Title: GraspSplats: Efficient Manipulation with 3D Feature Splatting|https://arxiv.org/abs/2409.02084,

- Title: GaussianGrasper: 3D Language Gaussian Splatting for Open-vocabulary Robotic Grasping|https://arxiv.org/abs/2403.09637,

4)Language-Driven Grasp

- Title: RTAGrasp: Learning Task-Oriented Grasping from Human Videos via Retrieval, Transfer, and Alignment|https://arxiv.org/abs/2409.16033

- Title: Language-Driven 6-DoF Grasp Detection Using Negative Prompt Guidance|https://arxiv.org/abs/2407.13842,

- Title: Reasoning Grasping via Multimodal Large Language Model|https://arxiv.org/abs/2402.06798

- Title: ThinkGrasp: A Vision-Language System for Strategic Part Grasping in Clutter|https://arxiv.org/abs/2407.11298

- Title: Towards Open-World Grasping with Large Vision-Language Models|https://arxiv.org/abs/2406.18722

- Title: Reasoning Tuning Grasp: Adapting Multi-Modal Large Language Models for Robotic Grasping|https://openreview.net/pdf?id=3mKb5iyZ2V

5)Grasp for Transparent Objects

- Title: T2SQNet: A Recognition Model for Manipulating Partially Observed Transparent Tableware Objects|https://openreview.net/pdf?id=M0JtsLuhEE

- Title: ASGrasp: Generalizable Transparent Object Reconstruction and Grasping from RGB-D Active Stereo Camera|https://arxiv.org/abs/2405.05648

- Title: Dex-NeRF: Using a Neural Radiance Field to Grasp Transparent Objects|https://arxiv.org/abs/2110.14217

Manipulation相关1)Representation Learning with Auxiliary Tasks

- Title: Contrastive Imitation Learning for Language-guided Multi-Task Robotic Manipulation|https://arxiv.org/abs/2406.09738

- Title: Vid2Robot: End-to-end Video-conditioned Policy Learning with Cross-Attention Transformers|https://arxiv.org/abs/2403.12943

- Title: R3M: A Universal Visual Representation for Robot Manipulation|https://arxiv.org/abs/2203.12601

- Title: HULC: What Matters in Language Conditioned Robotic Imitation Learning over Unstructured Data|https://arxiv.org/abs/2204.06252

- Title: BC-Z: Zero-Shot Task Generalization with Robotic Imitation Learning|https://arxiv.org/abs/2202.02005

- Title: Spatiotemporal Predictive Pre-training for Robotic Motor Control|https://arxiv.org/abs/2403.05304

- Title: MUTEX: Learning Unified Policies from Multimodal Task Specifications|https://arxiv.org/abs/2309.14320

- Title: Language-Driven Representation Learning for Robotics|https://arxiv.org/abs/2302.12766

- Title: Real-World Robot Learning with Masked Visual Pre-training|https://arxiv.org/abs/2210.03109

- Title: RACER: Rich Language-Guided Failure Recovery Policies for Imitation Learning|https://arxiv.org/abs/2409.14674

- Title: EmbodiedGPT: Vision-Language Pre-Training via Embodied Chain of Thought|https://arxiv.org/abs/2305.15021

- Title: Chain-of-Thought Predictive Control|https://arxiv.org/abs/2304.00776

- Title: VIRT: Vision Instructed Transformer for Robotic Manipulation|https://arxiv.org/abs/2410.07169

- Title: KOI: Accelerating Online Imitation Learning via Hybrid Key-state Guidance|https://www.arxiv.org/abs/2408.02912

- Title: GENIMA: Generative Image as Action Models|https://arxiv.org/abs/2407.07875

- Title: ATM: Any-point Trajectory Modeling for Policy Learning|https://arxiv.org/abs/2401.00025

- Title: Learning Manipulation by Predicting Interaction|https://www.arxiv.org/abs/2406.00439

- Title: Object-Centric Instruction Augmentation for Robotic Manipulation|https://arxiv.org/abs/2401.02814

- Title: Towards Generalizable Zero-Shot Manipulation via Translating Human Interaction Plans|https://arxiv.org/abs/2312.00775

- Title: CALAMARI: Contact-Aware and Language conditioned spatial Action MApping for contact-RIch manipulation|https://openreview.net/pdf?id=Nii0_rRJwN

- Title: GHIL-Glue: Hierarchical Control with Filtered Subgoal Images|https://arxiv.org/abs/2410.20018

- Title: FoAM: Foresight-Augmented Multi-Task Imitation Policy for Robotic Manipulation|https://arxiv.org/abs/2409.19528

- Title: VideoAgent: Self-Improving Video Generation|https://arxiv.org/abs/2410.10076

- Title: GR-MG: Leveraging Partially Annotated Data via Multi-Modal Goal Conditioned Policy|https://arxiv.org/abs/2408.14368

- Title: GR-2: A Generative Video-Language-Action Model with Web-Scale Knowledge for Robot Manipulation|https://arxiv.org/abs/2410.06158

- Title: VLMPC: Vision-Language Model Predictive Control for Robotic Manipulation|https://arxiv.org/abs/2407.09829

- Title: GR-1: Unleashing Large-Scale Video Generative Pre-training for Visual Robot Manipulation|https://arxiv.org/abs/2312.13139

- Title: SuSIE: Zero-Shot Robotic Manipulation with Pretrained Image-Editing Diffusion Models|https://arxiv.org/abs/2310.10639

- Title: VLP: Video Language Planning|https://arxiv.org/abs/2310.10625,

2)Visual Representation Learning

- Title: Robots Pre-train Robots: Manipulation-Centric Robotic Representation from Large-Scale Robot Datasets|https://arxiv.org/abs/2410.22325

- Title: Theia: Distilling Diverse Vision Foundation Models for Robot Learning|https://arxiv.org/abs/2407.20179

- Title: Learning Manipulation by Predicting Interaction|https://www.arxiv.org/abs/2406.00439

- Title: Learning Fine-Grained Bimanual Manipulation with Low-Cost Hardware|https://arxiv.org/abs/2304.13705

- Title: Language-Driven Representation Learning for Robotics|https://arxiv.org/abs/2302.12766

- Title: VIMA: General Robot Manipulation with Multimodal Prompts|https://arxiv.org/abs/2210.03094

- Title: Real-World Robot Learning with Masked Visual Pre-training|https://arxiv.org/abs/2210.03109

- Title: R3M: A Universal Visual Representation for Robot Manipulation|https://arxiv.org/abs/2203.12601

- Title: LIV: Language-Image Representations and Rewards for Robotic Control|https://arxiv.org/abs/2306.00958

- Title: VIP: Towards Universal Visual Reward and Representation via Value-Implicit Pre-Training|https://arxiv.org/abs/2210.00030

- Title: Can Foundation Models Perform Zero-Shot Task Specification For Robot Manipulation?|https://arxiv.org/abs/2204.11134

3)Multimodal Representation Learning

- Title: Play to the Score: Stage-Guided Dynamic Multi-Sensory Fusion for Robotic Manipulation|https://arxiv.org/abs/2408.01366

- Title: MUTEX: Learning Unified Policies from Multimodal Task Specifications|https://arxiv.org/abs/2309.14320

4)Latent Action Learning

- Title: Discrete Policy: Learning Disentangled Action Space for Multi-Task Robotic Manipulation|https://arxiv.org/abs/2409.18707, - Title: IGOR: Image-GOal Representations Atomic Control Units for Foundation Models in Embodied AI|https://www.microsoft.com/en-us/research/uploads/prod/2024/10/Project_IGOR_for_arXiv.pdf

- Title: Latent Action Pretraining from Videos|https://arxiv.org/abs/2410.11758

- Title: Goal Representations for Instruction Following: A Semi-Supervised Language Interface to Control|https://arxiv.org/abs/2307.00117

- Title: MimicPlay: Long-Horizon Imitation Learning by Watching Human Play|https://arxiv.org/abs/2302.12422

- Title: Imitation Learning with Limited Actions via Diffusion Planners and Deep Koopman Controllers|https://arxiv.org/abs/2410.07584

- Title: Learning to Act without Actions|https://arxiv.org/abs/2312.10812

- Title: Imitating Latent Policies from Observation|https://arxiv.org/abs/1805.07914

5)World Model

- Title: MOTO: Offline Pre-training to Online Fine-tuning for Model-based Robot Learning|https://arxiv.org/abs/2401.03306, - Title: Finetuning Offline World Models in the Real World|https://arxiv.org/abs/2310.16029,

- Title: Surfer: Progressive Reasoning with World Models for Robotic Manipulation|https://arxiv.org/abs/2306.11335,

6)Asynchronous Action Learning

- Title: PIVOT-R: Primitive-Driven Waypoint-Aware World Model for Robotic Manipulation|https://arxiv.org/abs/2410.10394

- Title: HiRT: Enhancing Robotic Control with Hierarchical Robot Transformers|https://arxiv.org/abs/2410.05273

- Title: MResT: Multi-Resolution Sensing for Real-Time Control with Vision-Language Models|https://arxiv.org/abs/2401.14502

7)Diffusion Policy Learning

- Title: Diffusion Transformer Policy|https://arxiv.org/abs/2410.15959,

- Title: SDP: Spiking Diffusion Policy for Robotic Manipulation with Learnable Channel-Wise Membrane Thresholds|https://arxiv.org/abs/2409.11195,

- Title: The Ingredients for Robotic Diffusion Transformers|https://arxiv.org/abs/2410.10088,

- Title: GenDP: 3D Semantic Fields for Category-Level Generalizable Diffusion Policy|https://arxiv.org/abs/2410.17488

- Title: EquiBot: SIM(3)-Equivariant Diffusion Policy for Generalizable and Data Efficient Learning|https://arxiv.org/abs/2407.01479

- Title: Sparse Diffusion Policy: A Sparse, Reusable, and Flexible Policy for Robot Learning|https://arxiv.org/abs/2407.01531

- Title: MDT: Multimodal Diffusion Transformer: Learning Versatile Behavior from Multimodal Goals|https://arxiv.org/abs/2407.05996

- Title: Render and Diffuse: Aligning Image and Action Spaces for Diffusion-based Behaviour Cloning|https://arxiv.org/abs/2405.18196,

- Title: DP3: 3D Diffusion Policy: Generalizable Visuomotor Policy Learning via Simple 3D Representations|https://arxiv.org/abs/2403.03954

- Title: PlayFusion: Skill Acquisition via Diffusion from Language-Annotated Play|https://arxiv.org/abs/2312.04549

- Title: Equivariant Diffusion Policy|https://arxiv.org/abs/2407.01812

- Title: StructDiffusion: Language-Guided Creation of Physically-Valid Structures using Unseen Objects|https://arxiv.org/abs/2211.04604

- Title: Goal-Conditioned Imitation Learning using Score-based Diffusion Policies|https://arxiv.org/abs/2304.02532

- Title: Diffusion Policy: Visuomotor Policy Learning via Action Diffusion|https://arxiv.org/abs/2303.04137

8)Other Policies

- Title: Autoregressive Action Sequence Learning for Robotic Manipulation|https://arxiv.org/abs/2410.03132,

- Title: MaIL: Improving Imitation Learning with Selective State Space Models|https://arxiv.org/abs/2406.08234,

9)Vision Language Action Models

- Title: Run-time Observation Interventions Make Vision-Language-Action Models More Visually Robust|https://arxiv.org/abs/2410.01971

- Title: TinyVLA: Towards Fast, Data-Efficient Vision-Language-Action Models for Robotic Manipulation|https://arxiv.org/abs/2409.12514

- Title: RoboMamba: Multimodal State Space Model for Efficient Robot Reasoning and Manipulation|https://arxiv.org/abs/2406.04339

- Title: A Dual Process VLA: Efficient Robotic Manipulation Leveraging VLM|https://arxiv.org/abs/2410.15549

- Title: OpenVLA: An Open-Source Vision-Language-Action Model|https://arxiv.org/abs/2406.09246

- Title: LLARVA: Vision-Action Instruction Tuning Enhances Robot Learning|https://arxiv.org/abs/2406.11815

- Title: Robotic Control via Embodied Chain-of-Thought Reasoning|https://arxiv.org/abs/2406.11815

- Title: 3D-VLA: A 3D Vision-Language-Action Generative World Model|https://arxiv.org/abs/2403.09631

- Title: Octo: An Open-Source Generalist Robot Policy|https://arxiv.org/abs/2405.12213,

- Title: RoboFlamingo: Vision-Language Foundation Models as Effective Robot Imitators|https://arxiv.org/abs/2311.01378

- Title: RT-H: Action Hierarchies Using Language|https://arxiv.org/abs/2403.01823

- Title: Open X-Embodiment: Robotic Learning Datasets and RT-X Models|https://arxiv.org/abs/2310.08864,

- Title: MOO: Open-World Object Manipulation using Pre-trained Vision-Language Models|https://arxiv.org/abs/2303.00905

- Title: RT-2: Vision-Language-Action Models Transfer Web Knowledge to Robotic Control|https://arxiv.org/abs/2307.15818

- Title: RT-1: Robotics Transformer for Real-World Control at Scale|https://arxiv.org/abs/2212.06817

10)Reinforcement Learning

- Title: Precise and Dexterous Robotic Manipulation via Human-in-the-Loop Reinforcement Learning|https://arxiv.org/abs/2410.21845

- Title: PointPatchRL -- Masked Reconstruction Improves Reinforcement Learning on Point Clouds|https://arxiv.org/abs/2410.18800

- Title: SPIRE: Synergistic Planning, Imitation, and Reinforcement for Long-Horizon Manipulation|https://arxiv.org/abs/2410.18065

- Title: Learning to Manipulate Anywhere: A Visual Generalizable Framework For Reinforcement Learning|https://arxiv.org/abs/2407.15815

- Title: Plan-Seq-Learn: Language Model Guided RL for Solving Long Horizon Robotics Tasks|https://arxiv.org/abs/2405.01534,

- Title: Expansive Latent Planning for Sparse Reward Offline Reinforcement Learning|https://openreview.net/pdf?id=xQx1O7WXSA,

- Title: Q-Transformer: Scalable Offline Reinforcement Learning via Autoregressive Q-Functions|https://arxiv.org/abs/2309.10150,

- Title: Sim2Real Transfer for Reinforcement Learning without Dynamics Randomization|https://arxiv.org/abs/2002.11635,

- Title: Pre-Training for Robots: Offline RL Enables Learning New Tasks from a Handful of Trials|https://arxiv.org/abs/2210.05178

11)Motion, Tranjectory and Flow

- Title: Language-Conditioned Path Planning|https://arxiv.org/abs/2308.16893

- Title: DiffusionSeeder: Seeding Motion Optimization with Diffusion for Rapid Motion Planning|https://arxiv.org/abs/2410.16727

- Title: ReKep: Spatio-Temporal Reasoning of Relational Keypoint Constraints for Robotic Manipulation|https://arxiv.org/abs/2409.01652

- Title: CoPa: General Robotic Manipulation through Spatial Constraints of Parts with Foundation Models|https://arxiv.org/abs/2403.08248

- Title: Task Generalization with Stability Guarantees via Elastic Dynamical System Motion Policies|https://arxiv.org/abs/2309.01884

- Title: ORION: Vision-based Manipulation from Single Human Video with Open-World Object Graphs|https://arxiv.org/abs/2405.20321

- Title: Learning Robotic Manipulation Policies from Point Clouds with Conditional Flow Matching|https://arxiv.org/abs/2409.07343

- Title: RoboTAP: Tracking Arbitrary Points for Few-Shot Visual Imitation|https://arxiv.org/abs/2308.15975

- Title: VoxPoser: Composable 3D Value Maps for Robotic Manipulation with Language Models|https://arxiv.org/abs/2307.05973

- Title: LATTE: LAnguage Trajectory TransformEr|https://arxiv.org/abs/2208.02918

- Title: Track2Act: Predicting Point Tracks from Internet Videos enables Generalizable Robot Manipulation|https://arxiv.org/abs/2405.01527

- Title: Any-point Trajectory Modeling for Policy Learning|https://arxiv.org/abs/2401.00025

- Title: Waypoint-Based Imitation Learning for Robotic Manipulation|https://arxiv.org/abs/2307.14326

- Title: Flow as the Cross-Domain Manipulation Interface|https://www.arxiv.org/abs/2407.15208

- Title: Learning to Act from Actionless Videos through Dense Correspondences|https://arxiv.org/abs/2310.08576

12)Data Collection, Selection and Augmentation

- Title: SkillMimicGen: Automated Demonstration Generation for Efficient Skill Learning and Deployment|https://arxiv.org/abs/2410.18907

- Title: Scaling Robot Policy Learning via Zero-Shot Labeling with Foundation Models|https://arxiv.org/abs/2410.17772

- Title: Autonomous Improvement of Instruction Following Skills via Foundation Models|https://arxiv.org/abs/2407.20635

- Title: Manipulate-Anything: Automating Real-World Robots using Vision-Language Models|https://arxiv.org/abs/2406.18915,

- Title: DexCap: Scalable and Portable Mocap Data Collection System for Dexterous Manipulation|https://arxiv.org/abs/2403.07788,

- Title: SPRINT: Scalable Policy Pre-Training via Language Instruction Relabeling|https://arxiv.org/abs/2306.11886,

- Title: Scaling Up and Distilling Down: Language-Guided Robot Skill Acquisition|https://arxiv.org/abs/2307.14535

- Title: Robotic Skill Acquisition via Instruction Augmentation with Vision-Language Models|https://arxiv.org/abs/2211.11736

- Title: RoboCat: A Self-Improving Generalist Agent for Robotic Manipulation|https://arxiv.org/abs/2306.11706,

- Title: Active Fine-Tuning of Generalist Policies|https://arxiv.org/abs/2410.05026

- Title: Re-Mix: Optimizing Data Mixtures for Large Scale Imitation Learning|https://arxiv.org/abs/2408.14037

- Title: An Unbiased Look at Datasets for Visuo-Motor Pre-Training|https://arxiv.org/abs/2310.09289,

- Title: Retrieval-Augmented Embodied Agents|https://arxiv.org/abs/2404.11699,

- Title: Behavior Retrieval: Few-Shot Imitation Learning by Querying Unlabeled Datasets|https://arxiv.org/abs/2304.08742,

- Title: RoVi-Aug: Robot and Viewpoint Augmentation for Cross-Embodiment Robot Learning|https://arxiv.org/abs/2409.03403

- Title: Diffusion Augmented Agents: A Framework for Efficient Exploration and Transfer Learning|https://arxiv.org/abs/2407.20798

- Title: Diffusion Meets DAgger: Supercharging Eye-in-hand Imitation Learning|https://arxiv.org/abs/2402.17768,

- Title: GenAug: Retargeting behaviors to unseen situations via Generative Augmentation|https://arxiv.org/abs/2302.06671

- Title: Contrast Sets for Evaluating Language-Guided Robot Policies|https://arxiv.org/abs/2406.13636

13)Affordance Learning

- Title: UniAff: A Unified Representation of Affordances for Tool Usage and Articulation with Vision-Language Models|https://arxiv.org/abs/2409.20551,

- Title: A3VLM: Actionable Articulation-Aware Vision Language Model|https://arxiv.org/abs/2406.07549,

- Title: AIC MLLM: Autonomous Interactive Correction MLLM for Robust Robotic Manipulation|https://arxiv.org/abs/2406.11548,

- Title: SAGE: Bridging Semantic and Actionable Parts for Generalizable Manipulation of Articulated Objects|https://arxiv.org/abs/2312.01307,

- Title: Kinematic-aware Prompting for Generalizable Articulated Object Manipulation with LLMs|https://arxiv.org/abs/2311.02847,

- Title: Ditto: Building Digital Twins of Articulated Objects from Interaction|https://arxiv.org/abs/2202.08227,

- Title: Language-Conditioned Affordance-Pose Detection in 3D Point Clouds|https://arxiv.org/abs/2309.10911,

- Title: Composable Part-Based Manipulation|https://arxiv.org/abs/2405.05876,

- Title: PartManip: Learning Cross-Category Generalizable Part Manipulation Policy from Point Cloud Observations|https://arxiv.org/abs/2303.16958,

- Title: GAPartNet: Cross-Category Domain-Generalizable Object Perception and Manipulation via Generalizable and Actionable Parts|https://arxiv.org/abs/2211.05272,

- Title: SpatialBot: Precise Spatial Understanding with Vision Language Models|https://arxiv.org/abs/2406.13642,

- Title: RoboPoint: A Vision-Language Model for Spatial Affordance Prediction for Robotics|https://arxiv.org/abs/2406.10721,

- Title: SpatialVLM: Endowing Vision-Language Models with Spatial Reasoning Capabilities|https://arxiv.org/abs/2401.12168,

- Title: RAM: Retrieval-Based Affordance Transfer for Generalizable Zero-Shot Robotic Manipulation|https://arxiv.org/abs/2407.04689,

- Title: MOKA: Open-World Robotic Manipulation through Mark-Based Visual Prompting|https://arxiv.org/abs/2403.03174

- Title: SLAP: Spatial-Language Attention Policies|https://arxiv.org/abs/2304.11235,

- Title: KITE: Keypoint-Conditioned Policies for Semantic Manipulation|https://arxiv.org/abs/2306.16605,

- Title: HULC++: Grounding Language with Visual Affordances over Unstructured Data|https://arxiv.org/abs/2210.01911

- Title: CLIPort: What and Where Pathways for Robotic Manipulation|https://arxiv.org/abs/2109.12098,

- Title: Affordance Learning from Play for Sample-Efficient Policy Learning|https://arxiv.org/abs/2203.00352

- Title: Transporter Networks: Rearranging the Visual World for Robotic Manipulation|https://arxiv.org/abs/2010.14406,

14)3D Representation for Manipulation

- Title: MSGField: A Unified Scene Representation Integrating Motion, Semantics, and Geometry for Robotic Manipulation|https://arxiv.org/abs/2410.15730

- Title: Splat-MOVER: Multi-Stage, Open-Vocabulary Robotic Manipulation via Editable Gaussian Splatting|https://arxiv.org/abs/2405.04378

- Title: IMAGINATION POLICY: Using Generative Point Cloud Models for Learning Manipulation Policies|https://arxiv.org/abs/2406.11740

- Title: Physically Embodied Gaussian Splatting: A Realtime Correctable World Model for Robotics|https://arxiv.org/abs/2406.10788

- Title: RiEMann: Near Real-Time SE(3)-Equivariant Robot Manipulation without Point Cloud Segmentation|https://arxiv.org/abs/2403.19460

- Title: RoboEXP: Action-Conditioned Scene Graph via Interactive Exploration for Robotic Manipulation|https://arxiv.org/abs/2402.15487

- Title: D3Fields: Dynamic 3D Descriptor Fields for Zero-Shot Generalizable Rearrangement|https://arxiv.org/abs/2309.16118

- Title: Object-Aware Gaussian Splatting for Robotic Manipulation|https://openreview.net/pdf?id=gdRI43hDgo

- Title: Distilled Feature Fields Enable Few-Shot Language-Guided Manipulation|https://arxiv.org/abs/2308.07931

- Title: Neural Descriptor Fields: SE(3)-Equivariant Object Representations for Manipulation|https://arxiv.org/abs/2112.05124

- Title: SE(3)-Equivariant Relational Rearrangement with Neural Descriptor Fields|https://arxiv.org/abs/2211.09786

15)3D Representation Policy Learning

- Title: GravMAD: Grounded Spatial Value Maps Guided Action Diffusion for Generalized 3D Manipulation|https://arxiv.org/abs/2409.20154

- Title: 3D Diffuser Actor: Policy Diffusion with 3D Scene Representations|https://arxiv.org/abs/2402.10885

- Title: DP3: 3D Diffusion Policy: Generalizable Visuomotor Policy Learning via Simple 3D Representations|https://arxiv.org/abs/2403.03954

- Title: ManiGaussian: Dynamic Gaussian Splatting for Multi-task Robotic Manipulation|https://arxiv.org/abs/2403.08321

- Title: SGRv2: Leveraging Locality to Boost Sample Efficiency in Robotic Manipulation|https://arxiv.org/abs/2406.10615

- Title: GNFactor: Multi-Task Real Robot Learning with Generalizable Neural Feature Fields|https://arxiv.org/abs/2308.16891

- Title: Visual Reinforcement Learning with Self-Supervised 3D Representations|https://arxiv.org/abs/2210.07241

- Title: PolarNet: 3D Point Clouds for Language-Guided Robotic Manipulation|https://arxiv.org/abs/2309.15596

- Title: M2T2: Multi-Task Masked Transformer for Object-centric Pick and Place|https://arxiv.org/abs/2311.00926

- Title: PerAct: Perceiver-Actor: A Multi-Task Transformer for Robotic Manipulation|https://arxiv.org/abs/2209.05451

- Title: 3D-MVP: 3D Multiview Pretraining for Robotic Manipulation|https://arxiv.org/abs/2406.18158

- Title: Discovering Robotic Interaction Modes with Discrete Representation Learning|https://arxiv.org/abs/2410.20258

- Title: SAM-E: Leveraging Visual Foundation Model with Sequence Imitation for Embodied Manipulation|https://arxiv.org/abs/2405.19586

- Title: RVT: Robotic View Transformer for 3D Object Manipulation|https://arxiv.org/abs/2306.14896

- Title: Learning Generalizable Manipulation Policies with Object-Centric 3D Representations|https://arxiv.org/abs/2310.14386

- Title: SGR: A Universal Semantic-Geometric Representation for Robotic Manipulation|https://arxiv.org/abs/2306.10474

16)Reasoning, Planning and Code Generation

- Title: AHA: A Vision-Language-Model for Detecting and Reasoning Over Failures in Robotic Manipulation|https://arxiv.org/abs/2410.00371

- Title: REFLECT: Summarizing Robot Experiences for Failure Explanation and Correction|https://arxiv.org/abs/2306.15724,

- Title: Polaris: Open-ended Interactive Robotic Manipulation via Syn2Real Visual Grounding and Large Language Models|https://arxiv.org/abs/2408.07975

- Title: Physically Grounded Vision-Language Models for Robotic Manipulation|https://arxiv.org/abs/2309.02561

- Title: Socratic Planner: Inquiry-Based Zero-Shot Planning for Embodied Instruction Following|https://arxiv.org/abs/2404.15190,

- Title: Saycan: Do As I Can, Not As I Say: Grounding Language in Robotic Affordances|https://arxiv.org/abs/2204.01691,

- Title: LLM+P: Empowering Large Language Models with Optimal Planning Proficiency|https://arxiv.org/abs/2304.11477,

- Title: Inner Monologue: Embodied Reasoning through Planning with Language Models|https://arxiv.org/abs/2207.05608,

- Title: Teaching Robots with Show and Tell: Using Foundation Models to Synthesize Robot Policies from Language and Visual Demonstrations|https://openreview.net/pdf?id=G8UcwxNAoD

- Title: RoCo: Dialectic Multi-Robot Collaboration with Large Language Models|https://arxiv.org/abs/2307.04738,

- Title: Gesture-Informed Robot Assistance via Foundation Models|https://arxiv.org/abs/2309.02721,

- Title: Instruct2Act: Mapping Multi-modality Instructions to Robotic Actions with Large Language Model|https://arxiv.org/abs/2305.11176

- Title: ProgPrompt: Generating Situated Robot Task Plans using Large Language Models|https://arxiv.org/abs/2209.11302

- Title: ChatGPT for Robotics: Design Principles and Model Abilities|https://arxiv.org/abs/2306.17582

- Title: Code as Policies: Language Model Programs for Embodied Control|https://arxiv.org/abs/2209.07753

- Title: TidyBot: Personalized Robot Assistance with Large Language Models|https://arxiv.org/abs/2305.05658

- Title: Statler: State-Maintaining Language Models for Embodied Reasoning|https://arxiv.org/abs/2306.17840

- Title: InterPreT: Interactive Predicate Learning from Language Feedback for Generalizable Task Planning|https://arxiv.org/abs/2405.19758

- Title: Text2Motion: From Natural Language Instructions to Feasible Plans|https://arxiv.org/abs/2303.12153

- Title: AHA: A Vision-Language-Model for Detecting and Reasoning Over Failures in Robotic Manipulation|https://arxiv.org/abs/2410.00371

- Title: Task Success Prediction for Open-Vocabulary Manipulation Based on Multi-Level Aligned Representations|https://arxiv.org/abs/2410.00436

- Title: EmbodiedGPT: Vision-Language Pre-Training via Embodied Chain of Thought|https://arxiv.org/abs/2305.15021

- Title: ManipLLM: Embodied Multimodal Large Language Model for Object-Centric Robotic Manipulation|https://arxiv.org/abs/2312.16217

- Title: Chat with the Environment: Interactive Multimodal Perception Using Large Language Models|https://arxiv.org/abs/2303.08268

- Title: PaLM-E: An Embodied Multimodal Language Model|https://arxiv.org/abs/2303.03378

- Title: Socratic Models: Composing Zero-Shot Multimodal Reasoning with Language|https://arxiv.org/abs/2204.00598

17)Generalization

- Title: Mirage: Cross-Embodiment Zero-Shot Policy Transfer with Cross-Painting|https://arxiv.org/abs/2402.19249

- Title: Policy Architectures for Compositional Generalization in Control|https://arxiv.org/abs/2203.05960

- Title: Programmatically Grounded, Compositionally Generalizable Robotic Manipulation|https://arxiv.org/abs/2304.13826

- Title: Efficient Data Collection for Robotic Manipulation via Compositional Generalization|https://arxiv.org/abs/2403.05110

- Title: Natural Language Can Help Bridge the Sim2Real Gap|https://arxiv.org/abs/2405.10020

- Title: Reconciling Reality through Simulation: A Real-to-Sim-to-Real Approach for Robust Manipulation|https://arxiv.org/abs/2403.03949

- Title: Local Policies Enable Zero-shot Long-horizon Manipulation|https://arxiv.org/abs/2410.22332,

- Title: A Backbone for Long-Horizon Robot Task Understanding|https://arxiv.org/abs/2408.01334,

- Title: STAP: Sequencing Task-Agnostic Policies|https://arxiv.org/abs/2210.12250

- Title: BOSS: Bootstrap Your Own Skills: Learning to Solve New Tasks with Large Language Model Guidance|https://arxiv.org/abs/2310.10021

- Title: Learning Compositional Behaviors from Demonstration and Language|https://openreview.net/pdf?id=fR1rCXjCQX

- Title: Policy Adaptation via Language Optimization: Decomposing Tasks for Few-Shot Imitation|https://arxiv.org/abs/2408.16228

18)Generalist

- Title: Scaling Cross-Embodied Learning: One Policy for Manipulation, Navigation, Locomotion and Aviation|https://arxiv.org/abs/2408.11812

- Title: All Robots in One: A New Standard and Unified Dataset for Versatile, General-Purpose Embodied Agents|https://arxiv.org/abs/2408.10899

- Title: Scaling Proprioceptive-Visual Learning with Heterogeneous Pre-trained Transformers|https://arxiv.org/abs/2409.20537

- Title: An Embodied Generalist Agent in 3D World|https://arxiv.org/abs/2311.12871

- Title: Towards Synergistic, Generalized, and Efficient Dual-System for Robotic Manipulation|https://arxiv.org/abs/2410.08001

- Title: Effective Tuning Strategies for Generalist Robot Manipulation Policies|https://arxiv.org/abs/2410.01220,

- Title: Octo: An Open-Source Generalist Robot Policy|https://arxiv.org/abs/2405.12213,

- Title: Steering Your Generalists: Improving Robotic Foundation Models via Value Guidance|https://arxiv.org/abs/2410.13816

- Title: Open X-Embodiment: Robotic Learning Datasets and RT-X Models|https://arxiv.org/abs/2310.08864,

- Title: RoboAgent: Generalization and Efficiency in Robot Manipulation via Semantic Augmentations and Action Chunking|https://arxiv.org/abs/2309.01918,

- Title: Learning to Manipulate Anywhere: A Visual Generalizable Framework For Reinforcement Learning|https://arxiv.org/abs/2407.15815

- Title: CAGE: Causal Attention Enables Data-Efficient Generalizable Robotic Manipulation|https://arxiv.org/abs/2407.15815

- Title: Robot Utility Models: General Policies for Zero-Shot Deployment in New Environments|https://arxiv.org/abs/2409.05865

19)Human-Robot Interaction and Collaboration

- Title: Vocal Sandbox: Continual Learning and Adaptation for Situated Human-Robot Collaboration|https://openreview.net/pdf?id=ypaYtV1CoG

- Title: APRICOT: Active Preference Learning and Constraint-Aware Task Planning with LLMs|https://openreview.net/pdf?id=nQslM6f7dW

- Title: Text2Interaction: Establishing Safe and Preferable Human-Robot Interaction|https://arxiv.org/abs/2408.06105

- Title: KNOWNO: Robots That Ask For Help: Uncertainty Alignment for Large Language Model Planners|https://arxiv.org/abs/2307.01928,

- Title: Yell At Your Robot: Improving On-the-Fly from Language Corrections|https://arxiv.org/abs/2403.12910,

- Title: "No, to the Right" -- Online Language Corrections for Robotic Manipulation via Shared Autonomy|https://arxiv.org/abs/2301.02555,

Humanoid

1)Dexterous Manipulation

- Title: DexGraspNet: A Large-Scale Robotic Dexterous Grasp Dataset for General Objects Based on Simulation|https://arxiv.org/abs/2210.02697,

- Title: Demonstrating Learning from Humans on Open-Source Dexterous Robot Hands|https://www.roboticsproceedings.org/rss20/p014.pdf,

- Title: CyberDemo: Augmenting Simulated Human Demonstration for Real-World Dexterous Manipulation|https://arxiv.org/abs/2402.14795,

- Title: Dexterous Functional Grasping|https://arxiv.org/abs/2312.02975,

- Title: DEFT: Dexterous Fine-Tuning for Real-World Hand Policies|https://arxiv.org/abs/2310.19797,

- Title: REBOOT: Reuse Data for Bootstrapping Efficient Real-World Dexterous Manipulation|https://arxiv.org/abs/2309.03322,

- Title: Sequential Dexterity: Chaining Dexterous Policies for Long-Horizon Manipulation|https://arxiv.org/abs/2309.00987,

- Title: AnyTeleop: A General Vision-Based Dexterous Robot Arm-Hand Teleoperation System|https://arxiv.org/abs/2307.04577,

2)Other Applications

- Title: Leveraging Language for Accelerated Learning of Tool Manipulation|https://arxiv.org/abs/2206.13074,

Awesome Benchmarks1)Grasp Datasets

- Title: QDGset: A Large Scale Grasping Dataset Generated with Quality-Diversity|https://arxiv.org/abs/2410.02319,

- Title: Real-to-Sim Grasp: Rethinking the Gap between Simulation and Real World in Grasp Detection|https://arxiv.org/abs/2410.06521,

- Title: Grasp-Anything-6D: Language-Driven 6-DoF Grasp Detection Using Negative Prompt Guidance|https://arxiv.org/abs/2407.13842

- Title: Grasp-Anything++: Language-driven Grasp Detection|https://arxiv.org/abs/2406.09489

- Title: Grasp-Anything: Large-scale Grasp Dataset from Foundation Models|https://arxiv.org/abs/2309.09818,

- Title: GraspNet-1Billion: A Large-Scale Benchmark for General Object Grasping|https://openaccess.thecvf.com/content_CVPR_2020/papers/Fang_GraspNet-1Billion_A_Large-Scale_Benchmark_for_General_Object_Grasping_CVPR_2020_paper.pdf

2)Manipulation Benchmarks

- Title: RoboCasa: Large-Scale Simulation of Everyday Tasks for Generalist Robots|https://arxiv.org/abs/2406.02523

- Title: ARNOLD: A Benchmark for Language-Grounded Task Learning With Continuous States in Realistic 3D Scenes|https://arxiv.org/abs/2304.04321,

- Title: HomeRobot: Open-Vocabulary Mobile Manipulation|https://arxiv.org/abs/2306.11565,

- Title: ALFRED: A Benchmark for Interpreting Grounded Instructions for Everyday Tasks|https://arxiv.org/abs/1912.01734,

- Title: Towards Generalizable Vision-Language Robotic Manipulation: A Benchmark and LLM-guided 3D Policy|https://arxiv.org/abs/2410.01345,

- Title: THE COLOSSEUM: A Benchmark for Evaluating Generalization for Robotic Manipulation|https://arxiv.org/abs/2402.08191,

- Title: VIMA: General Robot Manipulation with Multimodal Prompts|https://arxiv.org/abs/2210.03094,

- Title: CALVIN: A Benchmark for Language-Conditioned Policy Learning for Long-Horizon Robot Manipulation Tasks|https://arxiv.org/abs/2112.03227,

- Title: RLBench: The Robot Learning Benchmark & Learning Environment|https://arxiv.org/abs/1909.12271,

- Title: Evaluating Real-World Robot Manipulation Policies in Simulation|https://arxiv.org/abs/2405.05941

- Title: LADEV: A Language-Driven Testing and Evaluation Platform for Vision-Language-Action Models in Robotic Manipulation|https://arxiv.org/abs/2410.05191

- Title: ClutterGen: A Cluttered Scene Generator for Robot Learning|https://arxiv.org/abs/2407.05425

- Title: Efficient Tactile Simulation with Differentiability for Robotic Manipulation|https://openreview.net/pdf?id=6BIffCl6gsM,

- Title: Open X-Embodiment: Robotic Learning Datasets and RT-X Models|https://arxiv.org/abs/2310.08864,

- Title: DROID: A Large-Scale In-The-Wild Robot Manipulation Dataset|https://arxiv.org/abs/2403.12945,

- Title: BridgeData V2: A Dataset for Robot Learning at Scale|https://arxiv.org/abs/2308.12952,

- Title: ManipVQA: Injecting Robotic Affordance and Physically Grounded Information into Multi-Modal Large Language Models|https://arxiv.org/abs/2403.11289,

- Title: OpenEQA: Embodied Question Answering in the Era of Foundation Models|https://open-eqa.github.io/assets/pdfs/paper.pdf,

3)Cross-Embodiment Benchmarks

- Title: All Robots in One: A New Standard and Unified Dataset for Versatile, General-Purpose Embodied Agents|https://arxiv.org/abs/2408.10899,

- Title: Where are we in the search for an Artificial Visual Cortex for Embodied Intelligence?|https://arxiv.org/abs/2408.10899,

Awesome Techniques

- Title: Awesome-Implicit-NeRF-Robotics: Neural Fields in Robotics: A Survey|https://arxiv.org/abs/2410.20220,

- Title: Awesome-Video-Robotic-Papers,

- Title: Awesome-Generalist-Robots-via-Foundation-Models: Neural Fields in Robotics: A Survey|https://arxiv.org/abs/2312.08782,

- Title: Awesome-Robotics-3D,

- Title: Awesome-Robotics-Foundation-Models: Foundation Models in Robotics: Applications, Challenges, and the Future|https://arxiv.org/abs/2312.07843,

- Title: Awesome-LLM-Robotics,

Vision-Language Models

3D

- Title:

- Title: Learning 2D Invariant Affordance Knowledge for 3D Affordance Grounding|https://arxiv.org/abs/2408.13024,

- Title: Mamba3D: Enhancing Local Features for 3D Point Cloud Analysis via State Space Model|https://arxiv.org/abs/2404.14966,

- Title: PointMamba: A Simple State Space Model for Point Cloud Analysis|https://arxiv.org/abs/2402.10739,

- Title: Point Transformer V3: Simpler, Faster, Stronger|https://arxiv.org/abs/2312.10035,

- Title: Point Transformer V2: Grouped Vector Attention and Partition-based Pooling|https://arxiv.org/abs/2210.05666,

- Title: Point Transformer|https://arxiv.org/abs/2402.10739,

- Title: PointNet++: Deep Hierarchical Feature Learning on Point Sets in a Metric Space|https://arxiv.org/abs/1706.02413,

- Title: PointNet: Deep Learning on Point Sets for 3D Classification and Segmentation|https://arxiv.org/abs/1612.00593,

- Title: LERF: Language Embedded Radiance Fields|https://arxiv.org/abs/2303.09553,

- Title: 3D Gaussian Splatting for Real-Time Radiance Field Rendering|https://arxiv.org/abs/2308.04079,

- Title: LangSplat: 3D Language Gaussian Splatting|https://arxiv.org/abs/2312.16084,

#chatnio

15岁山东初中生做CTO,开源项目刚刚被数百万元收购了

「一切皆有可能。」

这是一位 15 岁的 CTO 放在个人主页上的第一句话。最近,他的开源项目 Chat Nio 被百万收购。从 0 开始到拿到七位数的第一桶金,他仅用了不到两年的时间,期间还经历了中考,现在刚上高一。

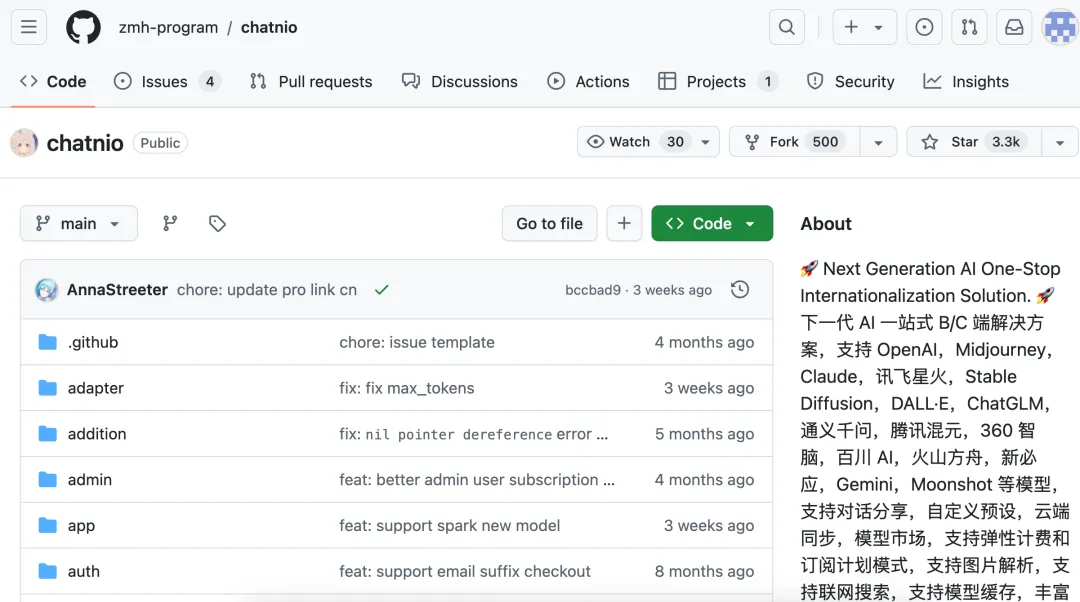

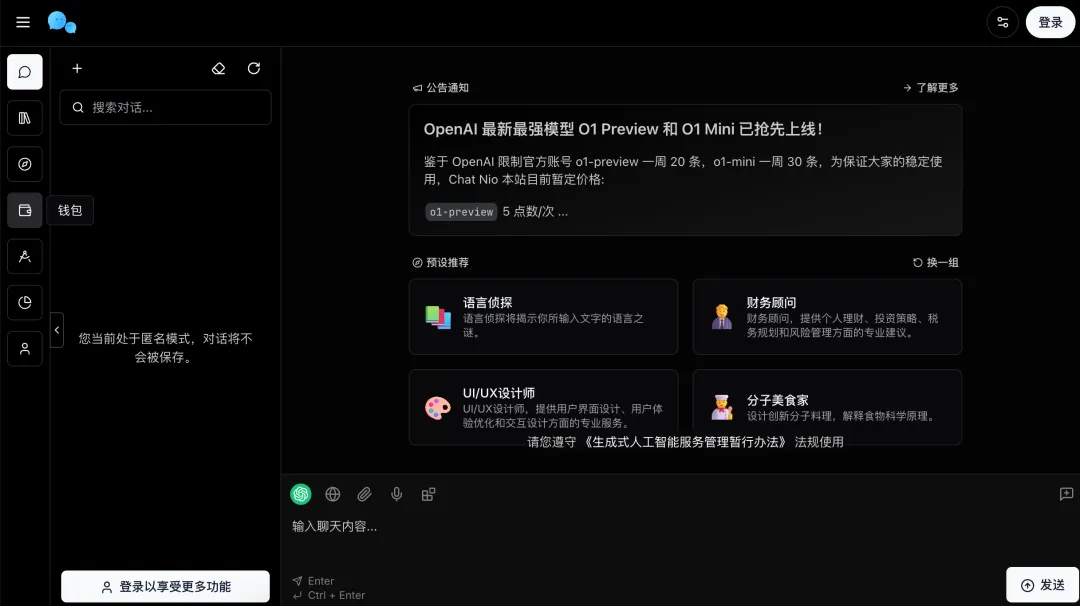

ChatNio 是一个综合了各种流行的模型和服务的一站式平台。它接入了 OpenAI、Midjourney、Claude、讯飞星火、Stable Diffusion、DALL・E、ChatGLM、通义千问、腾讯混元、360 智脑、百川 AI、火山方舟、新必应、Gemini 和 Moonshot 等等模型。

项目地址:https://github.com/zmh-program/chatnio

在线体验:https://chatnio.net/

它的功能同样主打一个全面,除了常规的 chatbot,还有类似 GPTs 的各种专业 AI 小助手。

你还可以在这里享受到分布式流式传输、图像生成、对话跨设备自动同步和分享、 Token 弹性计费、Key 中转、多模型聚合、联网搜索、AI 卡片,AI 项目生成、AI 批量文章生成...... 一系列应接不暇的服务。

Github 界面上 ChatNio 的 slogan:Chat Nio > Next Web + One API

据悉,之后还将上新 RAG、数字人、Payment、TTS & STT、API 网关、监控模型健康,Agent Workflow、Realtime、团队协作更多功能,可谓是百宝箱里找东西 ------ 市面上有的功能,它全都要。

ChatNio 上线后,受到了开发者的欢迎,很快冲上了最受欢迎代码仓库的第一名,至今已获得 3.2k star。

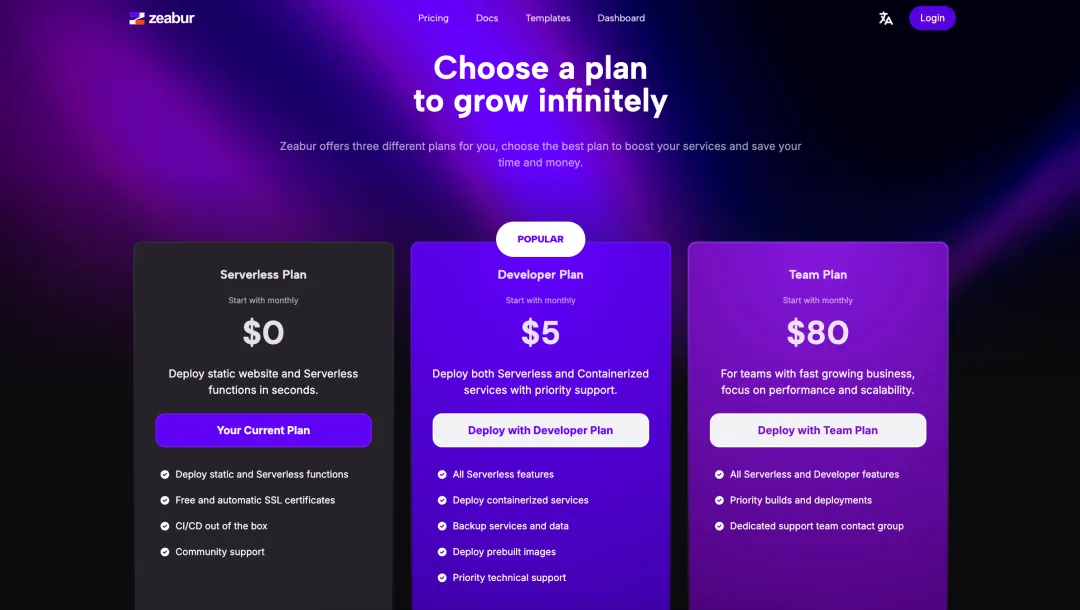

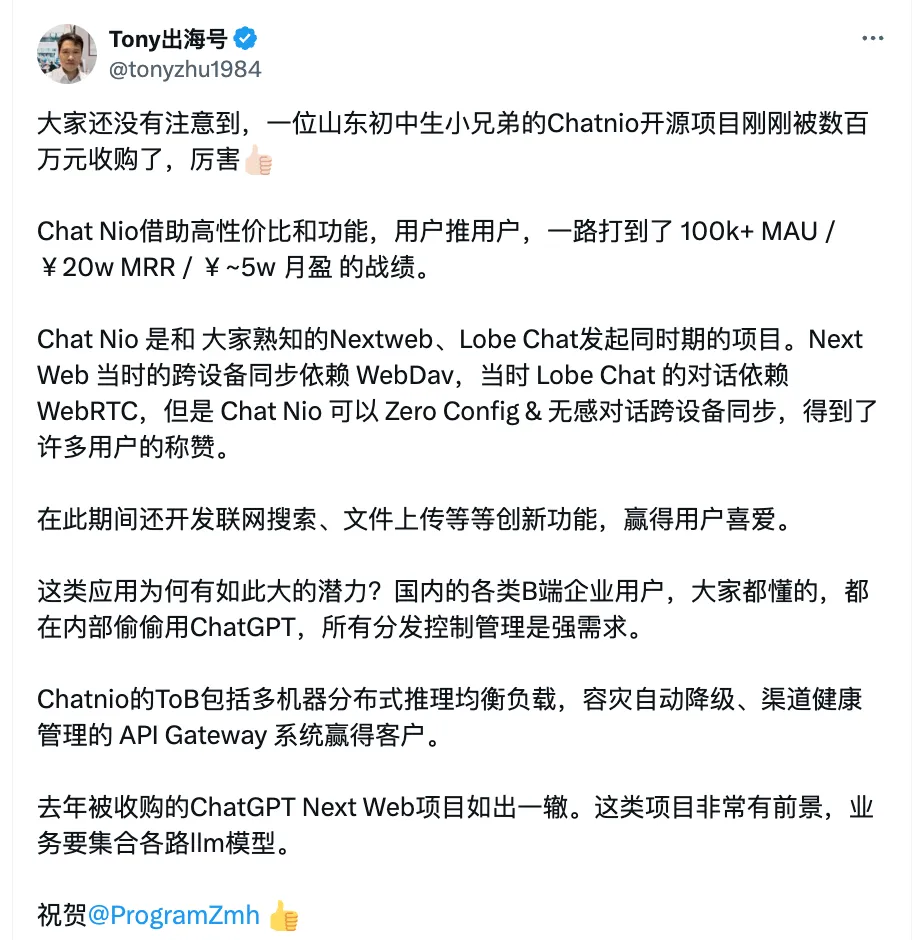

它有免费、个人和公司的三种付费计划,如果开个人版的会员,一个月只需要 5 美元,确实要比开以上 35 款模型的会员更加实在。借助高性价比和全面的功能,ChatNio 在用户之间口口相传,积累了超过 10 万的月活跃用户,并实现了每月约 5 万的净利润。

在背靠大厂的一众 AI 产品都在为用户黏性发愁的同时,ChatNio 的成绩属实令人印象深刻。

15 岁,工龄已 7 年

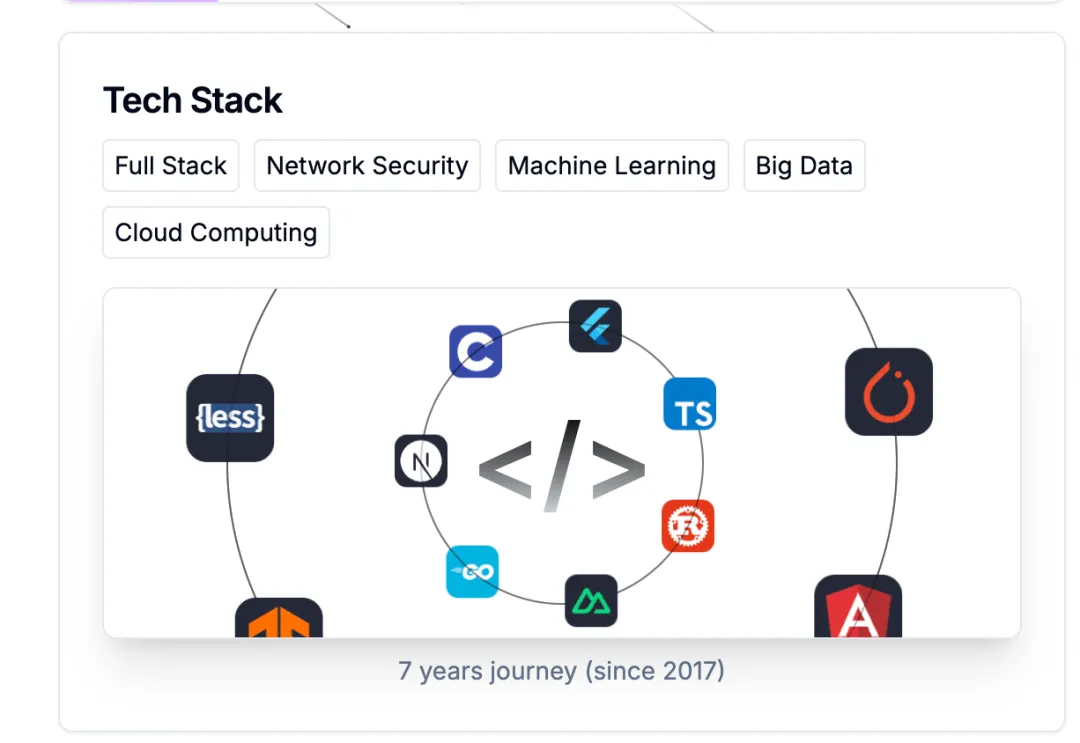

不过 ChatNio 也是厚积薄发的成果,虽然 zmh 年纪不大,但已有 7 年的项目开发经验。目前,他的技能树上已经点亮了全栈开发、网络安全、机器学习、大数据、云计算。

项目经历可能比正在求职的大学生丰富得多,原来十年工龄的应届生,就在这里。

在此之前,他做出的项目包括:

AI 起始页 Fystart,页面整合了待办事项、便签、提醒等实用小组件。

在线便签 Light Notes,极简的设计加上实用的功能,顶峰月调用量达 50w+。

查询工具 Whois,支持查询域名 / IPv4 / IPv6 / ASN / CIDR。

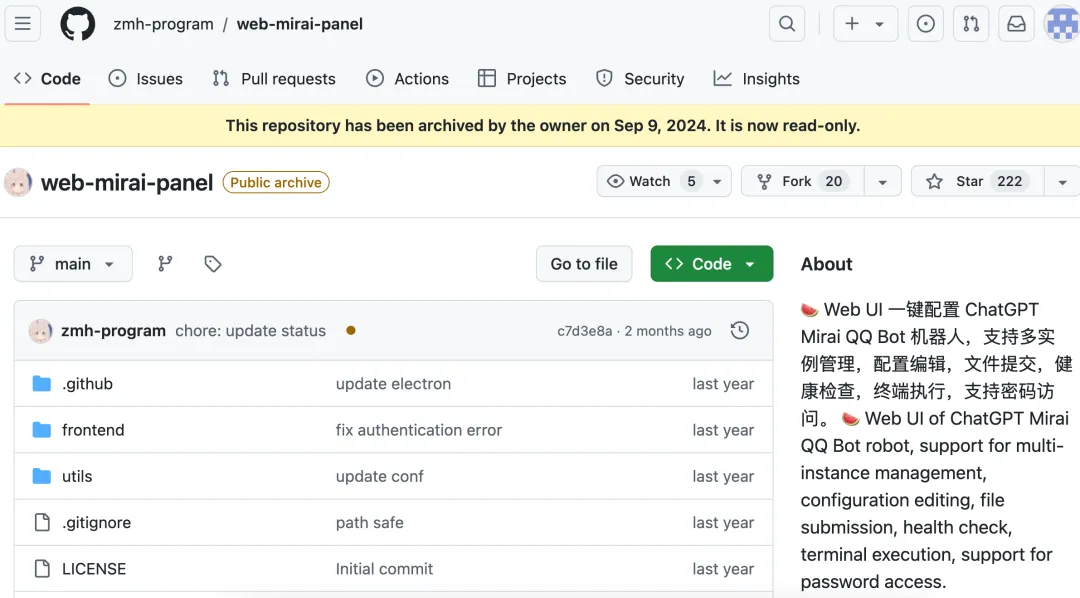

代码统计工具 Code Stats、可以一键配置 QQ 群聊机器人的 ChatGPT Mirai QQ Bot:

以及支持多种语言的翻译器 Lyrify:

从学校机房开始的创业之路

对于一名高一的学生来说,卖出一个价值百万的项目实属罕见。一向低调的 zmh 在 linux 开发者社区分享了自己的创业故事,写下了他一路走来的收获与心得。

zmh 就读于山东的重点高中,爬虫,逆向,大数据,前端,后端是他在放学后与信息小组留下来一起学会的。后来,他在各类赛事中斩获了省、市级的冠军。

当时,zmh 已经能在网上接一些小项目,每单收入几千元,并将项目「自费开源」,用这笔收入来支付服务器和 API 的费用,维持自己开发项目的正常运作。

ChatNio 的构想源自 GPT-4 每月 20 美元的订阅费。虽然 zmh 能负担这笔费用,但他的朋友们没有收入来源,这让他萌生了开发 ChatNio 的想法。暑假期间,朋友们的推荐吸引了更多用户,然而收入和捐赠已经无法支撑日益增长的成本。

于是他决定转型,将 ChatNio 从公益模式转为非盈利性运营,同时开源了代码,与开源社区共建。当时 OpenAI 和 Anthropic 还没有给 GPT 系列的模型加上联网搜索、上传图片的功能,而 ChatNio 已经让用户能够体验到这些功能。

凭借着价格优势和全面的功能,ChatNio 逐渐从用户自发传播中成长为一个盈利项目,并创建了商业授权版的 branch。zmh 在算法上进行了重大改进,自主研发了一个渠道分配算法,能够根据优先级和权重智能分配请求,并在出错时自动降级处理。

相比之下,当时的 One API 仅能根据外部的 HTTP 307 重定向来实现降级,直到后来才升级为内置的自动重试和降级机制。

这一系列努力使得 ChatNio 成为了 B 端和 C 端用户的一站式解决方案,既为 C 端用户提供商业化的大语言模型对话系统,也为 B 端(或 D 端)客户提供 OpenAI API 中转服务。

AI 创业者 @tonyzhu1984 也深入分析了 ChatNio 成功的原因,正应了那句:谁满足了用户需求,谁就能在竞争中脱颖而出。

你怎么看这位 15 岁的全能开发呢?欢迎在评论区讨论!

参考链接:

https://linux.do/t/topic/249061/7