一、论文简介

论文讨论了大规模预训练产生的视觉基础模型在处理任意图像时的强大能力,这些模型不仅能够完成训练任务,其中间表示还对其他视觉任务(如检测和分割)有用。研究者们提出了一个问题:这些模型是否能够表示物体的三维结构。他们通过一系列实验,使用特定任务的探针和零样本推理程序来分析这些模型的3D感知能力,并发现当前模型存在一些限制。在论文《Probing the 3D Awareness of Visual Foundation Models》中,作者探讨了视觉基础模型(visual foundation models)对于三维(3D)结构的意识,特别是它们在多视图一致性(multiview consistency)方面的表现。

二、实验设置

评估模型:包括多种大规模预训练的视觉模型,如MAE、iBOT、DeiT III、CLIP、MiDaS、DINO、DINOv2、StableDiffusion、SigLIP和SAM等。

数据集:使用Paired ScanNet数据集评估室内场景的表现,以及NAVI数据集评估单个对象的表现。

输入:

- 展示了同一对象或场景,但是从不同的视角拍摄的一对图像。例如,在NAVI数据集中,可能包括同一物体在不同环境中的视图;在Paired ScanNet数据集中,则可能是室内场景的不同视角。

- 能够从图像中提取特征预训练的视觉模型。在实验中,研究人员使用了多种不同的预训练模型,如DINO、CLIP、StableDiffusion等。

输出

- 对应点匹配:对于每一对图像,输出是两图像间像素点的对应关系。具体来说,就是识别出在两个不同视图中代表同一3D点的像素点对。

- 召回率:评估模型识别对应点的准确性,通过计算召回率来衡量,即正确匹配的对应点占所有可能对应点的比例。

三、实验步骤

1.特征提取 (密度特征图)

使用预训练的视觉模型(如DINO、CLIP、StableDiffusion等)的冻结特征(不改变模型权重),从每张图像中提取密集特征图。这些特征基于深度学习架构,如卷积神经网络(CNN)或视觉变换器(ViT),能够捕捉图像中的视觉信息,如纹理、颜色和形状等。特征提取通常在模型的中间层进行,以获得对图像内容的丰富表示。

2.特征匹配 (像素之间的匹配)

不依赖于传统的特征点检测和描述符匹配,而将两个视图的密集特征图进行比较,以找到相互之间的对应点。这通常涉及到计算特征之间的相似度,如通过余弦相似度等度量。对于每个像素点,找到另一个视图中与之最相似的像素点,从而建立对应关系。

3.对应点优化:

给定同一对象或场景的两个视图,目标是识别在不同视图中代表同一3D点的像素点。为了提高匹配的准确性,可能需要进一步的优化步骤,如空间变换模型(Homography)或基础矩阵(Fundamental Matrix)的估计,这些模型能够考虑几何约束来优化对应点。使用几何一致性检查来移除错误的匹配,如RANSAC算法,它能够识别并排除异常值。

4.性能评估:

通过地面真实数据(ground truth)来比较预测的对应点。,计算召回率来评估匹配的准确性,即预测的对应点中有多少比例与真实对应点在一定距离阈值内。

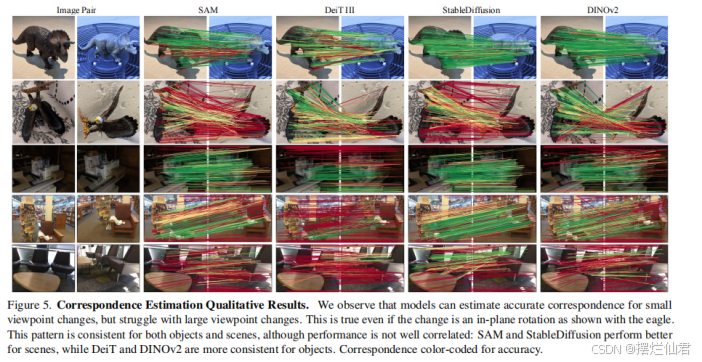

5.结果分析:

分析模型在不同视图变化条件下的性能,如小视图变化和大视图变化。通过定性和定量的结果来评估模型的3D意识能力,即它们是否能够准确地识别和匹配不同视图中的相同3D点。

四、相关示例代码分析

以下提供一些简单的Python示例代码以展示多视图一致性的概念。这些示例将使用假设的数据和简单的逻辑来模拟多视图一致性的基本思想。

1.简单的多视图一致性检查

这个示例将检查两幅图像是否具有一致的3D结构表示。

python

import numpy as np

def check_multiview_consistency(image1, image2, threshold=0.5):

"""

检查两幅图像是否具有多视图一致性。

:param image1: 第一幅图像的特征向量

:param image2: 第二幅图像的特征向量

:param threshold: 一致性阈值

:return: 布尔值,表示是否一致

"""

# 计算两幅图像特征向量之间的余弦相似度

dot_product = np.dot(image1, image2)

norm1 = np.linalg.norm(image1)

norm2 = np.linalg.norm(image2)

similarity = dot_product / (norm1 * norm2)

# 如果相似度大于阈值,则认为两幅图像具有多视图一致性

return similarity > threshold

# 假设的图像特征向量

image1_features = np.array([1, 2, 3, 4, 5])

image2_features = np.array([1.1, 2.1, 2.9, 4.1, 5.1])

# 检查一致性

is_consistent = check_multiview_consistency(image1_features, image2_features)

print(f"The images are {'consistent' if is_consistent else 'not consistent'}.")2.多视图一致性的平均视图重建

这个示例将展示如何使用多个视图的平均特征来重建一个一致的3D视图。

python

import numpy as np

def average_views(*views):

"""

计算多个视图的平均特征向量。

:param views: 多个视图的特征向量

:return: 平均特征向量

"""

# 计算平均特征向量

average_feature = np.mean(views, axis=0)

return average_feature

# 假设的多个视图特征向量

view1 = np.array([1, 2, 3])

view2 = np.array([1, 2, 3.5])

view3 = np.array([1, 2, 2.5])

# 计算平均视图

average_view = average_views(view1, view2, view3)

print("Average view features:", average_view)3.多视图一致性的特征匹配

这个示例将展示如何在两个视图之间找到一致的特征点。

python

import numpy as np

from scipy.spatial import distance

def match_features(view1, view2, threshold=0.5):

"""

在两个视图中匹配特征点。

:param view1: 第一个视图的特征点

:param view2: 第二个视图的特征点

:param threshold: 匹配阈值

:return: 匹配的特征点对

"""

matches = []

for feature1 in view1:

for feature2 in view2:

# 计算两个特征点之间的欧氏距离

if distance.euclidean(feature1, feature2) < threshold:

matches.append((feature1, feature2))

return matches

# 假设的两个视图特征点

view1_features = np.array([[1, 2], [3, 4], [5, 6]])

view2_features = np.array([[1.1, 2.1], [3.1, 4.1], [6, 7]])

# 匹配特征点

matched_features = match_features(view1_features, view2_features)

print("Matched feature pairs:", matched_features)这些示例提供了多视图一致性的基本框架和概念。在实际应用中,您可能需要使用更复杂的算法和数据集来处理真实的图像和3D数据。