一、介绍

unCLIP 模型是 SD 模型的版本,经过专门调整,除了文本提示之外,还可以接收图像概念作为输入。使用这些模型附带的 CLIPVision 对图像进行编码,然后在采样时将其提取的概念传递给主模型。

它并不是按照传统意义将图像混合在一起,而是实际上从两者中挑选了一些概念并制作了一个连贯的图像。

二、容器构建说明

本文档针对 ComfyUI 进行部署使用,因此在正式部署之前需要部署 ComfyUI

1. 部署 ComfyUI

(1)使用命令克隆 ComfyUI

git clone https://github.com/comfyanonymous/ComfyUI.git

cd ComfyUI(2)安装 conda(如已安装则跳过)

下面需要使用 Anaconda 或 Mimiconda 创建虚拟环境,可以输入 conda --version 进行检查。下面是 Mimiconda 的安装过程:

-

下载 Miniconda 安装脚本

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

-

运行安装脚本

bash Miniconda3-latest-Linux-x86_64.sh

-

遵循安装提示并初始化

按 Enter 键查看许可证条款,阅读完毕后输入 yes 接受条款,安装完成后,脚本会询问是否初始化 conda 环境,输入 yes 并按 Enter 键。

- 运行

source ~/.bashrc命令激活 conda 环境 - 再次输入

conda --version命令来验证是否安装成功,如果出现类似conda 4.10.3这样的输出就成功了。

(3)创建虚拟环境

输入下面的命令:

conda create -n comfyui python=3.10

conda activate comfyui(4)安装 pytorch

pip install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu121(5)安装项目依赖

pip install -r requirements.txt此时所需环境就已经搭建完成,通过下面命令进行启动:

python main.py访问网址得到类似下图界面即表示成功启动:

2. 部署 unclip 模型

(1)下载 sd21-unclip-h 模型

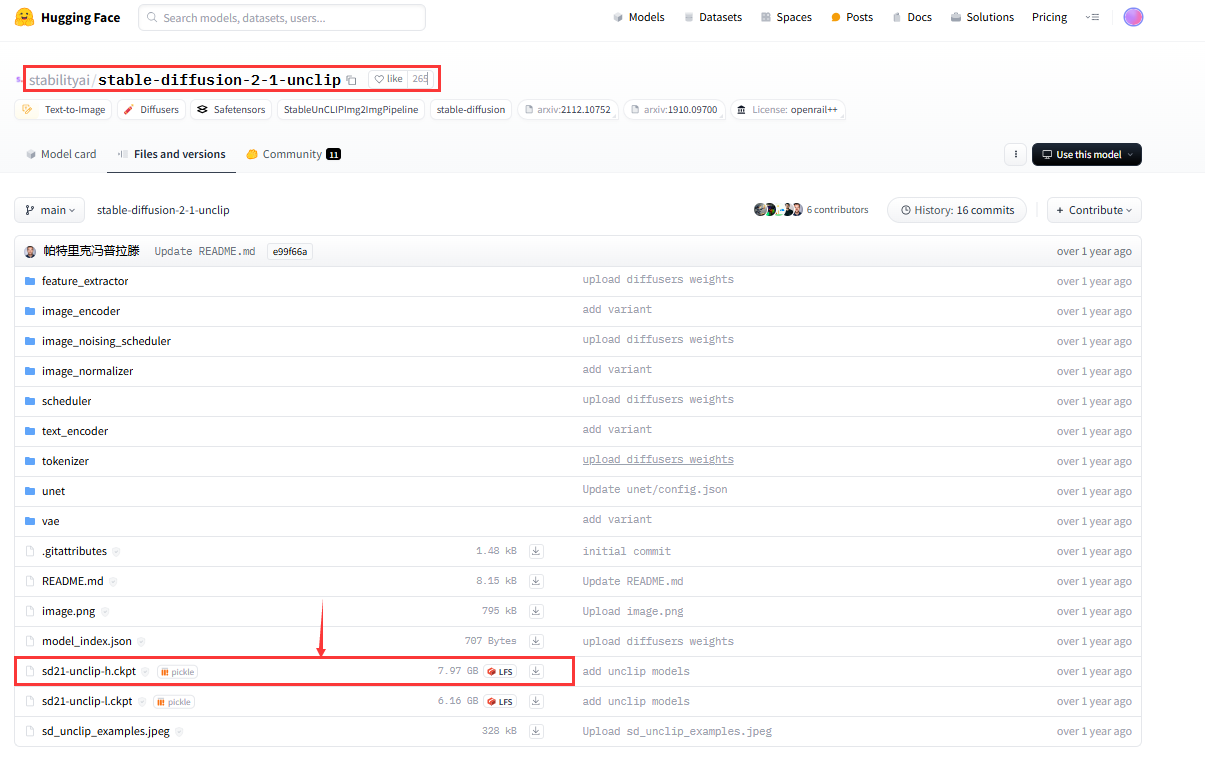

访问 Hugging Face 搜索"stabilityai/stable-diffusion-2-1-unclip"下载下图的模型,也可以点击这里进入。首次访问该页面时,可能需要同意用户协议才能看到模型下载页。

(2)下载工作流

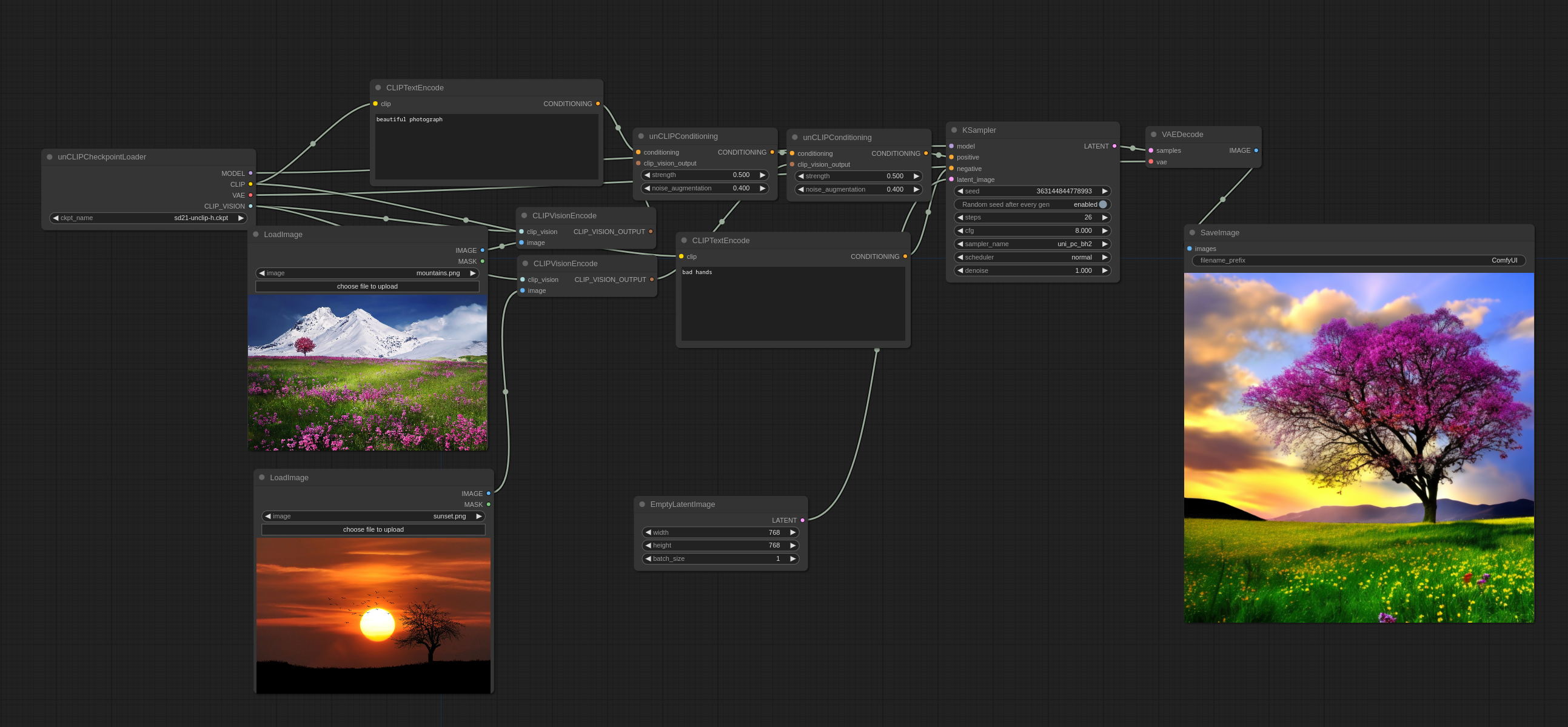

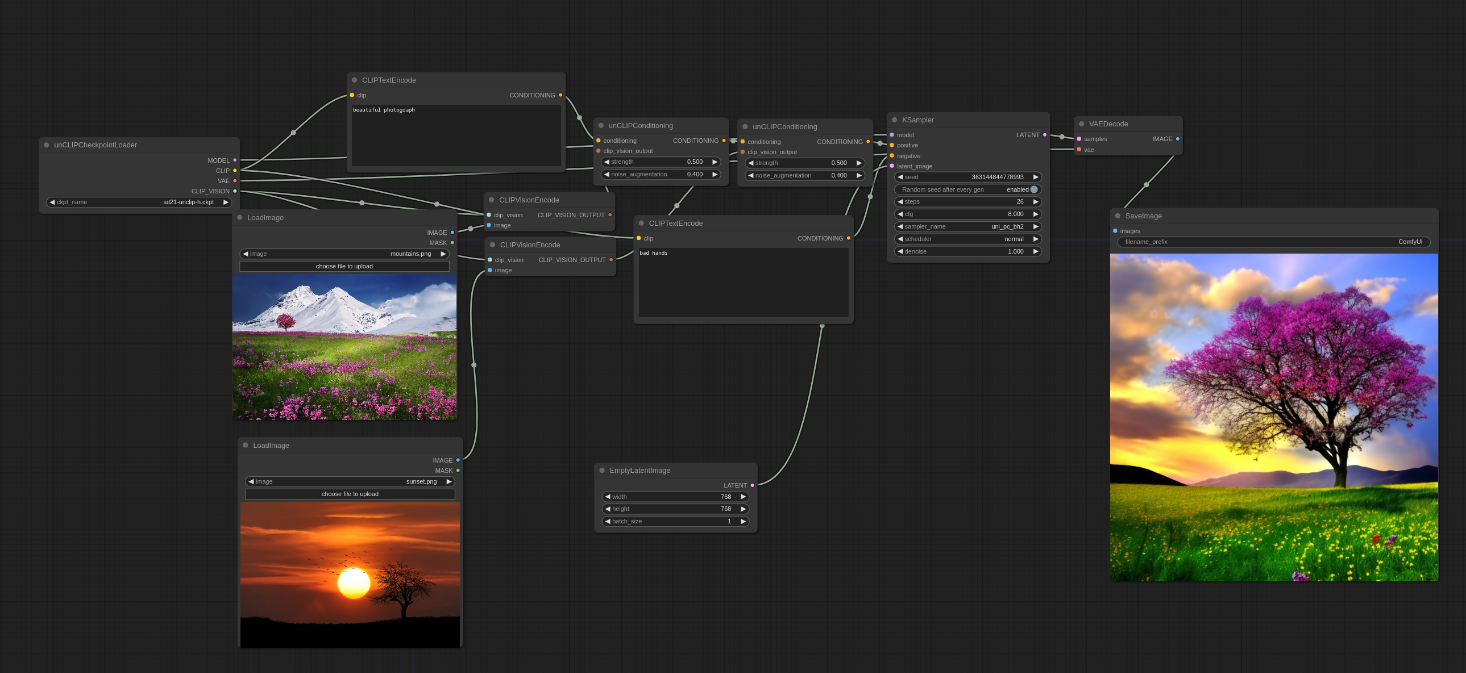

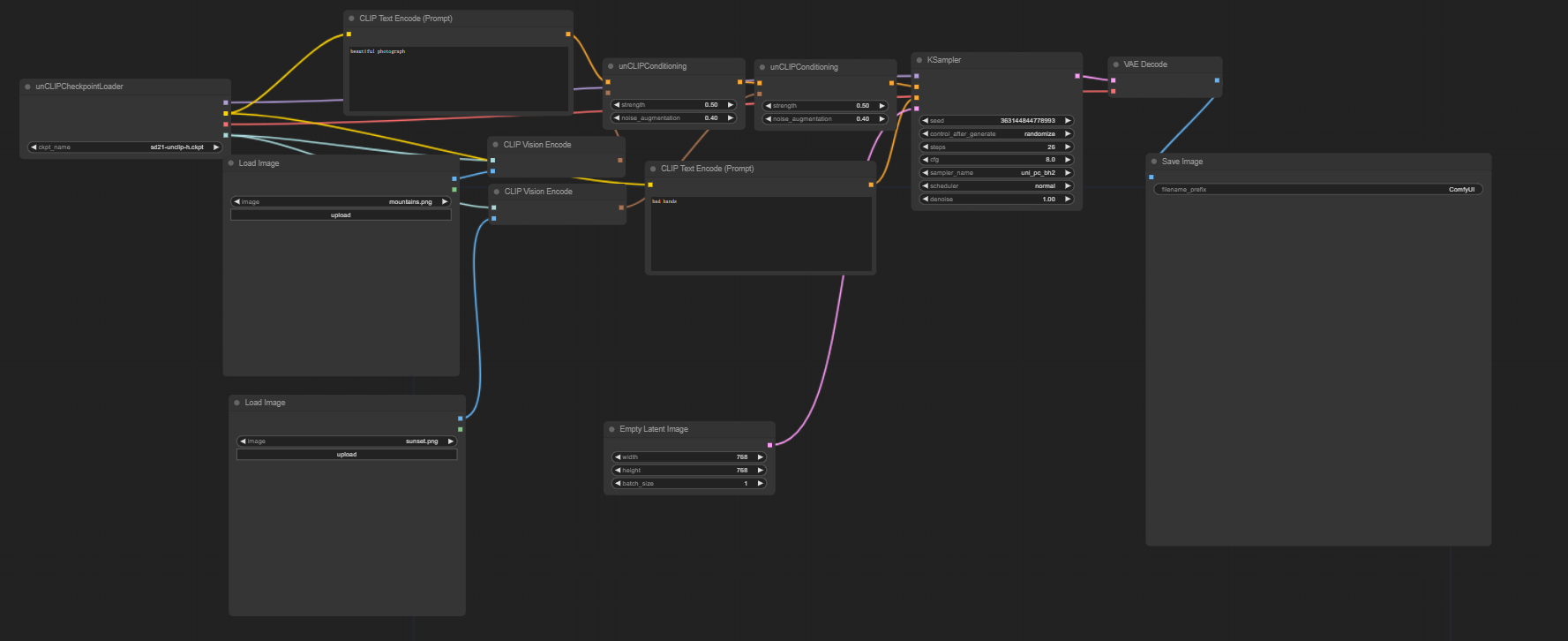

进入网站:unCLIP 模型示例 |ComfyUI_examples (comfyanonymous.github.io)并将下图下载,然后拖入 Comfy UI 中:

然后你的 ComfyUI 中应该会出选相应的工作流,类似下图:

至此unclip就可以实现了