从 Google Cloud Next 25 发来的第一手报道。

RTE 开发者社区联合发起人 Richard 林旅强以开发者的视角,分享了他在大会期间的观察与思考。除了对备受瞩目的 A2A 协议的深度解读,Richard 还详细梳理了大会期间发布的新产品,包括与实时多模态 AI 开发相关的音频模型 Chirp 3、音乐模型 Lyria 以及 ADK 智能体开发工具等。

随着底层基础设施的日趋成熟,以及开发者体验和工具的不断完善,中国的开发者们,你们准备好扬帆出海了吗?

每年的 Google Cloud Next 大会都是云计算世界的风向标,展示技术趋势,也为开发者指明方向。这次我有幸以思否观察团成员身份,亲临 2025 年 4 月 9 -- 11 日在拉斯维加斯举办的 Google Cloud Next 25 大会,三天满满的议程中,最让我感受到冲击与启发的,是第一天的主题演讲。

本文我将从开发者视角出发,分享我在 Keynote 中听到的重点内容,并结合出海需求讲讲:Google Cloud 为中国开发者考虑了些什么。

如果要一句话来总结,我会说:本次主题演讲清晰展现了 Google Cloud「以开发者为中心」的技术战略,其核心方向有三点: (1) 全面拥抱人工智能;(2) 持续提升底层基础设施能力;以及 (3) 不断优化开发者体验和生产力。

全球基础设施升级:构建全球产品的底座

Google Cloud CEO Thomas Kurian 一开场就带来了几个关键数字:全球已有 400 万开发者使用 Gemini 构建应用,Vertex AI 使用量在一年内增长 20 倍。

这些成果背后,是 Google 在基础设施上的长期投入------目前已建成覆盖 200 多个国家和地区的 42 个云区域,配套超过 200 万英里的海底和陆地光缆,打造出几乎零延迟的「Google 速度」网络。

特别值得一提的是 Cloud Wide Area Network (WAN),已全面开放给企业客户,官方表示它可将延迟和成本各降低约 40%。对开发者来说,这意味着部署在全球不同地区的服务能更快、更稳、更便宜。

对于我来说,400 万开发者和 20 倍增长本身或许只是表象,更值得关注的是: 它的能力是否够强?是否匹配我的需求?是否稳定?是否能让我专注在构建产品,而不用担心底层问题?

📌 对中国出海开发者而言,这种网络与算力覆盖,是构建全球产品的底层前提。我们可以将服务部署在靠近目标市场的地理区域,大幅降低延迟,带来更好的用户体验。这也是很多出海产品最关注的第一步。

Ironwood TPU 与 AI 超级计算:把 AI 性能推到极致

接着登台的 Google CEO Sundar Pichai 在现场公布了第七代 TPU ------ Ironwood ,预计将在今年晚些时候正式推出。这一硬件是 Google 为了满足 AI 推理与训练日益增长的需求所打造的重磅升级。

与第一代 TPU 相比,Ironwood 的性能提升了惊人的 3600 倍 ;即便是与前一代 Trillium 相比,其峰值算力也提升了 5 倍 ,同时 高带宽内存(HBM)容量提升 6 倍 ,能效更是达到了 Trillium 的两倍。换句话说,用更少的电,做更多的事。

每个 Ironwood pod 最多可搭载 9216 颗芯片,整体算力高达 42.5 exaflops ,并通过高度优化的数据通路设计,将芯片间的数据移动与延迟降至最低。这对于像 Gemini 2.5 Pro、Veo 2 这类需要巨量计算支撑的思维模型与多模态模型来说,是不可或缺的基建后盾。

这还只是第一层。在大会上,Google 还公布了 AI Hypercomputer 的全面增强:

-

集成 Ironwood TPU,成为支撑 AI 的超级计算平台;

-

全新推出 400G Cloud Interconnect,是上一代 100G 的 4 倍带宽,适配大模型高速通信;

-

引入 Anywhere Cache 与 Rapid Storage ,其中 Rapid Storage 是业界首个支持区域级对象存储的架构,随机读写延迟比业界最快方案低 5 倍;

-

支持 vLLM(高效推理框架)与大规模推理负载调度。

更贴近开发者的部分是:GKE(Google Kubernetes Engine)现在也原生支持 AI 推理优化。根据 Google 现场分享的测试数据:使用 GKE 新功能后,服务成本可降低高达 30%,尾部延迟减少 60%,吞吐量提升 40%。

📌 对 AI 开发者来说,这意味着三件事:

1.大模型的部署成本正在快速下降;

2.开发者可以借助现成的容器工具(如 GKE)部署高性能推理服务;

3.从底层硬件到上层平台,Google 正在打通一条「从想法到上线」的最短路径,真正实现云原生 AI。

📌 这场关于硬件和基础设施的更新,表面看是技术参数的叠加,实则是 Google 向开发者递出的强有力承诺 ------ 如果你选择在这里构建 AI,Google 已经替你铺好了地基。

Vertex AI:从模型到智能体的统一平台

Vertex AI 是 Google Cloud 上用于训练、部署和管理 AI 模型的一站式平台。本次大会宣布了不少升级,比如:

-

正式支持 Meta 的 Llama 4 模型;

-

全新的 Vertex AI Dashboards 可以更方便地监控延迟、吞吐等运行状态;

-

Model Optimizer 会根据请求特性,自动选择最优模型;

-

Live API 让我们可以将实时音视频流接入 Gemini,进行实时互动。

更值得一提的是,Vertex AI 现在也支持「多智能体系统」的构建 ------ 一个系统中可包含多个 AI 智能体,相互协作,完成更复杂的工作流。

📌 对开发者来说,Vertex AI 的这些能力意味着:你不需要自己搭建复杂的训练、部署、监控平台,也不用担心服务稳定性和多区域访问的问题;对于初创团队来说更是重要。

Gemini 2.5 Pro 与 Flash 双引擎上阵

在这次 Keynote 上,Google 展示了 Gemini 2.5 系列的两款核心推理模型:Gemini 2.5 Pro 和即将上线的 Gemini 2.5 Flash 。这对组合各有所长:Pro 面向高精度任务,Flash 面向低延迟高频交互。它们支持「思维链式推理(Thought Chaining)」,能一步步推理出结论,几乎覆盖了从复杂推理到实时互动的所有主流 AI 应用场景。

🧠 Gemini 2.5 Pro 是主打精度与深度的旗舰模型,支持文本与图像等多模态输入。超长的上下文使得它特别适用于代码审查、长文本总结、法律或金融场景的推理辅助等对记忆与逻辑要求极高的任务。

⚡ Gemini 2.5 Flash 则是 Google 为追求高响应、高频调用、高性价比而打造的轻量级推理模型,预计不久之后(现在还没)在 Vertex AI 上开放使用。它的最大特点是:响应快、成本低、还能动态调节复杂度。

并且,Flash 模型还会自动根据问题复杂度调整回答逻辑!例如遇到简单常识型问题就会快速回应,不再「认真地进行五段式推理」,而当面临复杂任务时也能适当延长处理时间,确保输出质量。对于需要高并发调用的客服系统、摘要生成器、问答机器人等业务,这种智能调节机制非常实用,也能极大降低使用成本。

此外,Flash 模型还允许开发者自定义「推理预算」------简单来说,你可以设定更偏向快一点、准一点,还是省一点钱,Google 帮你在不同目标间找到最优解。

📌 这两款模型未来都将在 Vertex AI 中稳定提供服务,支持与其他 Google 模型与服务无缝集成。你可以根据产品需求灵活切换:复杂问题交给 Pro,高频响应交给 Flash,从容应对不同规模和节奏的 AI 应用需求。

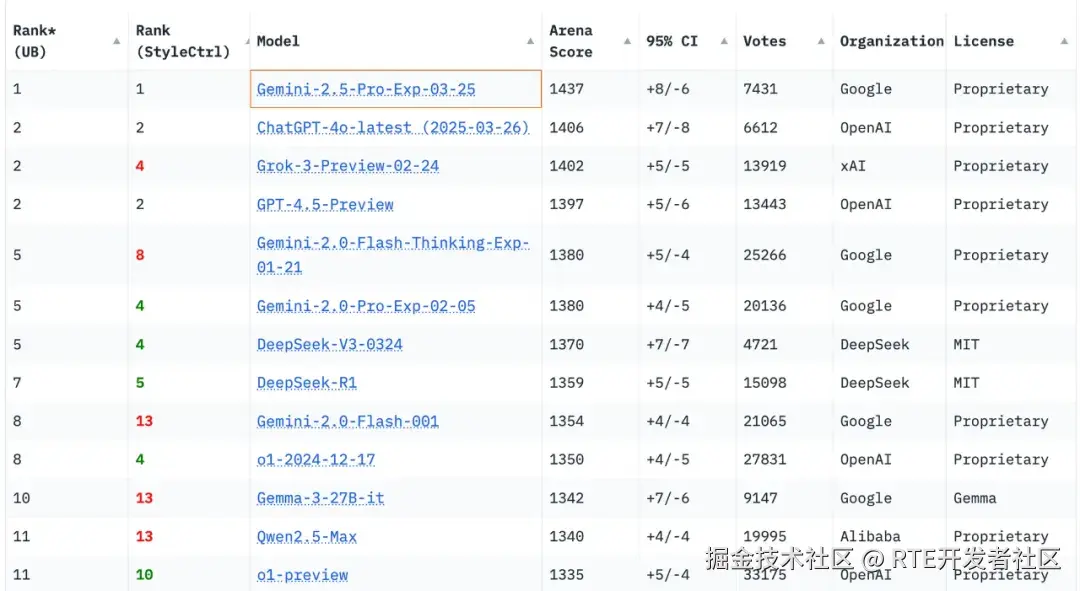

这里也补充一点:很多开发者可能还不知道的是,在以人类偏好作为评测标准的权威大语言模型的测评榜单 Chatbot Arena 中,Gemini-2.5-Pro-Exp-03-25 的排名是全球第一,这是经过真人实测的结果,也是许多模型推出前会参与进行测评的首选榜单。

多模态生成的 AI 创作工具箱再进化:图像、音频、音乐、视频全面升级

除了 Gemini 系列模型,Google 也在本次 Keynote 中展示了旗下多模态生成模型矩阵的全面升级:图像生成的 Imagen 3、音频生成的 Chirp 3、音乐生成的 Lyria,以及视频生成的 Veo 2,每一个都直指一个特定的创意工作场景。

📸 Imagen 3:作为 Google 最新的文本生成图像模型,它不仅支持高保真图像生成,还强化了对图像局部的修复与再创作能力(inpainting/outpainting)。其对 prompt 的理解程度业界领先,适合用于产品视觉、广告、插图生成等场景。

🎤 Chirp 3:仅需 10 秒音频,即可生成定制语音语音风格!应用在客服语音、品牌人设、可访问内容生成等领域。它延续了 Chirp 系列对自然音色与语义表达的高保真要求。

🎵 Lyria:这是 Google 推出的企业级文本生成音乐模型,只要输入一句描述,即可生成 30 秒音乐片段,适合创作配乐、短影音 BGM、游戏音效等内容。现已开放申请内测(申请入口: docs.google.com/forms/d/1Yk...

🎬 Veo 2:本次最值得关注的,是 Google 的旗舰级文本生成视频模型 Veo 2,它不再只是视频生成工具,而是一个视频创作与编辑平台,包含以下强大功能:

-

P 视频(去除元素): 可自动删除视频中不需要的物体(如路人),提升画面纯净度;

-

关键帧生成: 通过输入起始帧和结束帧,自动生成中间段落,保持画面流畅自然;

-

扩展画面: 将原有横屏视频自然扩展为竖屏,便于社媒平台分发(如抖音、小红书);

-

镜头控制: 可以指定摄像机移动方向、构图风格,甚至模拟延时摄影或无人机跟拍。

值得一提的是,Google 自家的 VideoFX 服务正是基于 Veo 2 构建,未来这项能力有望进入 Workspace 与 YouTube 创作者工具中。

同样的,Veo 2 目前已开放候补名单申请(申请入口: docs.google.com/forms/d/e/1...

📌 对于内容创作者、品牌出海团队、媒体机构来说, 这组四件套让我们能从一段文字、一条语音出发,可以快速生成图像、音频、音乐和视频; 当然,坊间也有许多这类的工具,也希望大家也都能比较尝试,并且在社区反馈你的体验和推荐。

智能体(Agent)生态系统:从概念走向实用,开发者可以立即上手

这次 Google 用 "Agents for everyone" 概括它的新愿景,背后是多个已上线的功能组件,正式将「多智能体系统(Multi-agent Systems)」带入开发者可用的阶段。

更具体地说,开发者现在可以通过 Vertex AI 的以下能力,构建具协作能力的 AI 智能体系统:

-

Agent Development Kit(ADK): 这是一个开源的开发框架,用户仅需不到 100 行 Python代码,就能完成他第一个智能体,并且支持工作记忆、对话状态、外部 API 插件调用等功能。非常适合快速开发客服助手、业务流程机器人等场景。

-

Agent2Agent 协议(A2A): Google 是首家发布开放 Agent 协议的主流云平台,支持多个 Agent之间基于标准协议交换信息。例如,一个智能体可以调用另一个智能体的能力,实现「AI 调用 AI」。这对于构建复杂任务处理流程至关重要。

-

Agent Garden: 这是一个智能体样例和连接器集合,包含 100 多个可用的预构建模块,支持连接 BigQuery、Google Workspace、Slack、GitHub 等常用工具和服务,大大降低集成成本。

-

Chrome & Workspace 集成: Agentspace 已整合进 Chrome Enterprise 和 GoogleWorkspace,普通员工也可以直接在浏览器或文档中调用智能体,快速搜索、对话与执行任务。

这些能力目前已可以通过 Vertex AI 访问使用,ADK 的开源项目也已经上线(可在 GitHub 上获取),其中部分进阶功能(如复杂智能体协调)虽然还处于预览阶段,但基本能力已经可以在真实项目中使用。

📌 适用场景举例:

-

在跨国客服系统中,同时部署订单查询智能体、翻译智能体与风险识别智能体,三者协作响应用户问题;

-

构建一个面向内部团队的"多 AI 工具箱",一键生成报告、摘要邮件、提取数据,提升员工效率;

-

在游戏、教育、金融等领域构建具备脚本调用能力的 AI 角色。

📌 对于出海开发团队而言,这样的多智能体能力正是扩展产品差异化体验、提升本地服务效率的关键武器。以往我们可能需要组建一整套微服务 + 对话系统 + 插件机制,现在 Google Cloud 提供了一套统一、开箱即用的解决方案,能让中小团队以极低成本快速验证与迭代,就连运营、市场、销售等非技术开发员工,也能通过低代码方式使用 AI 工具。

数据智能、部署效率与国际化支持:开发者在出海路上的三大底气

本次主题演讲,在大数据分析方面,BigQuery 推出了 Conversational Analytics API(预览版)和 BigQuery Knowledge Engine(预览版)。前者让用户能以自然语言与数据交互,后者则利用 Gemini 的能力智能分析数据模式并推荐业务术语。Looker 也集成了 Gemini,支持自然语言的数据分析和仪表盘创建。强大的数据分析能力是驱动全球业务增长的关键,BigQuery 和 Looker 的 AI 增强,能更加助力中国开发者更高效地获取和利用数据洞察,更好地理解全球用户行为,优化产品和运营策略。

在无服务器和容器化方面,Cloud Run 提供了更好的容器化应用部署能力,Cloud Functions 则让开发者能更轻松地构建可扩展的后端服务。Google Kubernetes Engine (GKE) 也新增了针对生成式 AI 工作负载的优化,包括自动缩放和负载均衡,这对于降低全球分布式应用的成本和提升性能非常有帮助。

除了技术创新,Google Cloud 在国际化支持方面也做得非常出色。Translation API 支持多种语言,Firebase Hosting 的 i18n 重写功能方便开发者根据用户偏好或地理位置交付特定语言的内容。更重要的是,Google Cloud 提供了广泛的合规性服务,满足全球各地的监管要求。这对于想要在全球市场合规运营的中国企业至关重要。

合规、安全与主权云:解决出海最大隐忧

主题演讲中也宣布了 Google 全球主权云布局,目前已覆盖 14 个国家、32 个区域,支持本地数据驻留与合规运营,配合 Deloitte 德勤、Accenture 埃森哲 等伙伴共同提供服务。

📌 这对中国企业尤其关键:我们常在出海过程中遇到数据合规、隐私保护等挑战,尤其是在对数据主权高度敏感的地区,例如欧洲(GDPR)、中东和东南亚市场。Google Cloud 推出的主权云方案,配合其全球合作伙伴生态,不仅能帮助企业符合法规要求,还能保障数据不出境、访问路径可控,大幅降低出海合规风险。

全新上线的 Google Unified Security(GUS)平台,也为企业带来真正统一的安全视图。它整合了端点、网络、云服务与应用的威胁检测能力,所有数据会自动与 Google 的威胁情报服务(Threat Intelligence)结合分析,搭配 Gemini 实现半自动化的响应与防护。

📌 对于开发者来说,这意味着两件事:

我们不再需要东拼西凑各种安全工具,就能获得一个集成的安全防护体系;安全不再只是「后期补救」的麻烦事,而是从 Day 1 起就可以融入应用生命周期。

这是一种「内建安全、合规随行」的开发范式,特别适合对隐私与法规要求严苛的行业,比如医疗、教育、金融,以及各类 B2B SaaS 出海产品。

📌 在此,我也想分享一句关于「出海」的心里话:

真正能走出去的,不只是产品和技术,也不只是我们所在的物理位置,还包括我们对世界不同文化的好奇、对市场和用户的理解、以及和全球技术生态的深度连接。

出海,永远不只是「把产品翻译成英文」,而是要重新用世界多元的视角看清楚我们提供的核心价值。

后记:谷歌在 Agent 正在下一盘大旗?

看到 Google 推出 A2A(Agent-to-Agent 协议)和 ADK(Agent Developer Kit),我立刻联想到当年的 Docker 与 Kubernetes。

当初 Docker 是第一个将容器技术真正落地并普及的革命性工具。开发者开始用它来打包、部署应用,但本质上它还是一个工具层,虽然一度风靡,却没能发展成一整套完整的管理系统。

后来,Google 主导推出了 Kubernetes(k8s),不仅解决了「怎么运行容器」的问题,更是一口气搞定了「如何大规模管理容器」的难题:部署、扩容、负载均衡、自我修复......整个系统完全掌控。

更关键的是,Google 在开源 Kubernetes 之后,将其交由 CNCF 管理,打造了一个中立的开源社区,使得 AWS、Azure、IBM 等云服务巨头也愿意加入共建,最终成为事实标准。

结果就是:Docker 领风骚,Kubernetes 定江山。

现在回到 AI 世界。虽然 Anthropic 的 MCP 抢占了先机,定义了模型(Model)如何调用外部 API 和应用,但 Google 推出的 A2A + ADK + AgentSpace 看起来不仅是「补上拼图」,更像是想主导下一代 Agent 生态。

特别是 ADK,虽然它是通过 MCP 来访问外部 API 和资源的,但开发者在实际使用时是直接接入 ADK,对 MCP 的感知可能会变弱。MCP 可能悄然成为默认的底层通道,逐渐在生态中被边缘化。

如果再往远了想,假如 Google 按照当年 Kubernetes 的路径,再打造一个面向 AI 的"CNCF"式开源组织------不仅定义 A2A 协议,还推动开发工具、框架、生态治理的一整套体系,会不会又是一场关于标准制定权的战役呢?就留待与各位一同见证未来吧!本文作者:Richard 林旅强 ------ Google Cloud Next 25 思否观察团成员、开源社联合创始人、RTE开发者社区主理人,Dev.Together 开发者生态峰会 2025 联席主席。

如果你对于开源、AI、开发者生态等议题感兴趣,欢迎在社区和我继续交流!

更多 Voice Agent 学习笔记:

a16z 最新报告:AI 数字人应用层即将爆发,或将孕育数十亿美金市场丨 Voice Agent 学习笔记

a16z合伙人:语音交互将成为AI应用公司最强大的突破口之一,巨头们在B2C市场已落后太多丨Voice Agent 学习笔记

ElevenLabs 33 亿美元估值的秘密:技术驱动+用户导向的「小熊软糖」团队丨Voice Agent 学习笔记

端侧 AI 时代,每台家居设备都可以是一个 AI Agent丨Voice Agent 学习笔记

世界最炙手可热的语音 AI 公司,举办了一场全球黑客松,冠军作品你可能已经看过

对话 TalktoApps 创始人:Voice AI 提高了我五倍的生产力,语音输入是人机交互的未来

a16z 最新语音 AI 报告:语音将成为关键切入点,但非最终产品本身(含最新图谱)

对话式 AI 硬件开发者都关心什么?低延迟语音、视觉理解、Always-on、端侧智能、低功耗......丨 RTE Meetup 回顾

写在最后:

我们欢迎更多的小伙伴参与 「RTE 开发者日报」 内容的共创,感兴趣的朋友请通过开发者社区或公众号留言联系,记得报暗号「共创」。

对于任何反馈(包括但不限于内容上、形式上)我们不胜感激、并有小惊喜回馈,例如你希望从日报中看到哪些内容;自己推荐的信源、项目、话题、活动等;或者列举几个你喜欢看、平时常看的内容渠道;内容排版或呈现形式上有哪些可以改进的地方等。