文章目录

-

- 前言

- [1. 安装Ollama](#1. 安装Ollama)

- 2.Gemma3模型安装与运行

- [3. 安装Open WebUI图形化界面](#3. 安装Open WebUI图形化界面)

-

- [3.1 Open WebUI安装运行](#3.1 Open WebUI安装运行)

- [3.2 添加模型](#3.2 添加模型)

- [3.3 多模态测试](#3.3 多模态测试)

- [4. 安装内网穿透工具](#4. 安装内网穿透工具)

- [5. 配置固定公网地址](#5. 配置固定公网地址)

- 总结

前言

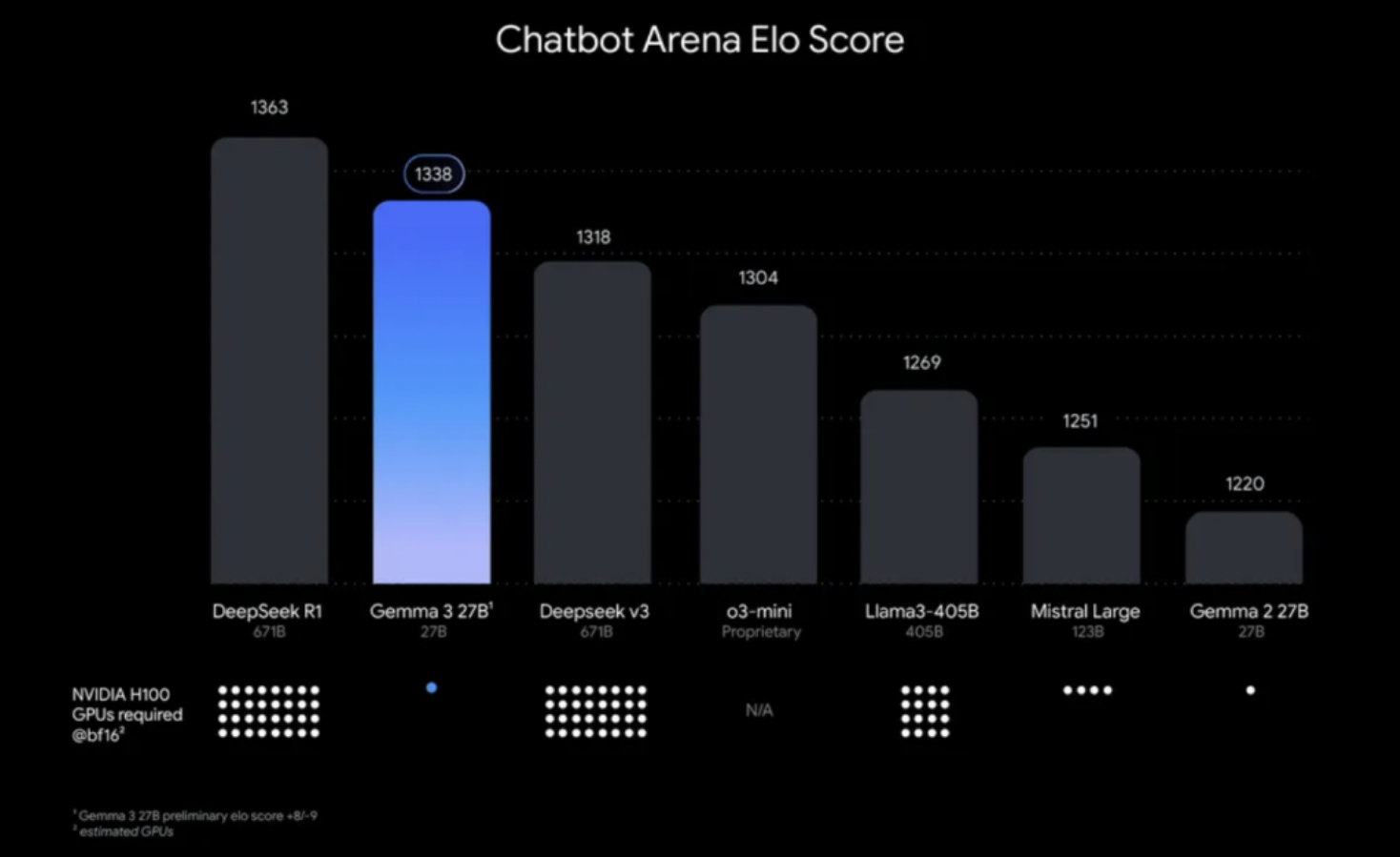

如今各家的AI大模型厮杀得如火如荼,每天都有新的突破。今天我要给大家安利一款来自谷歌的Gemma3开源大模型。这款模型有10亿、40亿、120亿和270亿参数等多个版本,让你可以根据自己的需求自由选择。

在多项基准测试中,Gemma 3系列的表现相当抢眼,尤其是27B参数的版本更是力压群雄,击败了o1-preview、o3-mini high和DeepSeek V3等强敌。它不仅支持140多种语言,中文表现也十分出色,更令人惊喜的是其强大的多模态能力------能够处理视觉输入并生成文本输出。

接下来,就让我们一起动手,在家用级Windows电脑上安装部署Gemma3:27B大模型,并搭配一个酷炫的WebUI界面,让你与AI互动更加得心应手。

1. 安装Ollama

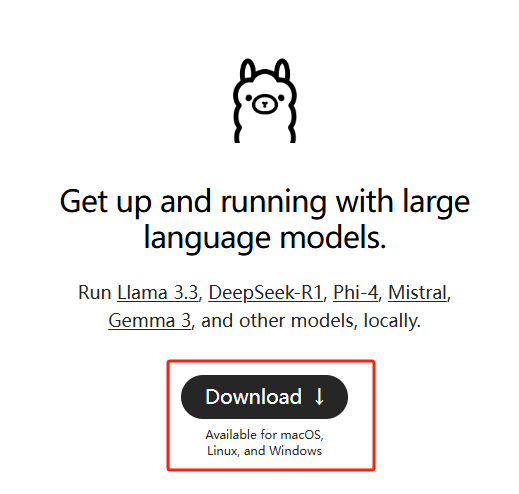

本例中使用的是Windows11系统专业版,通过Ollama运行Gemma3:27B大模型,之前曾经发布过如何在Windows安装Ollama的教程,有需要的同学可以看看这篇文章:Windows本地部署Deepseek-R1大模型并使用Web界面远程交互

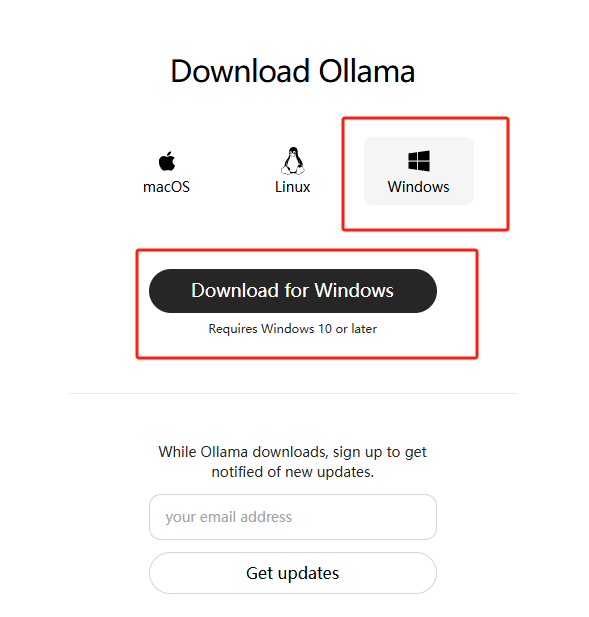

简单来说,就是访问Ollama的官网:Download Ollama on Windows

下载对应版本的ollama安装程序并安装:

2.Gemma3模型安装与运行

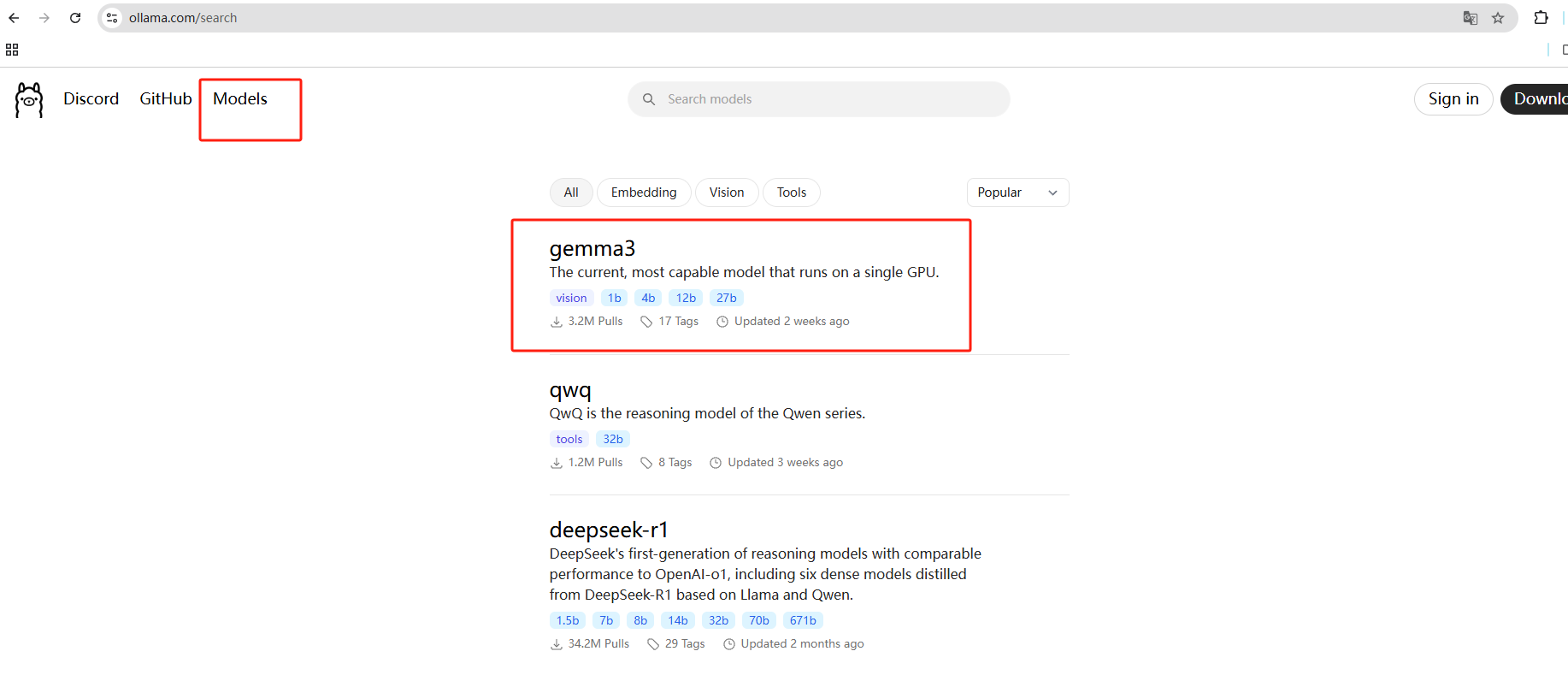

然后在Ollama的官网点击Models,可以看到排在最上边的就是Gemma3模型全家桶:

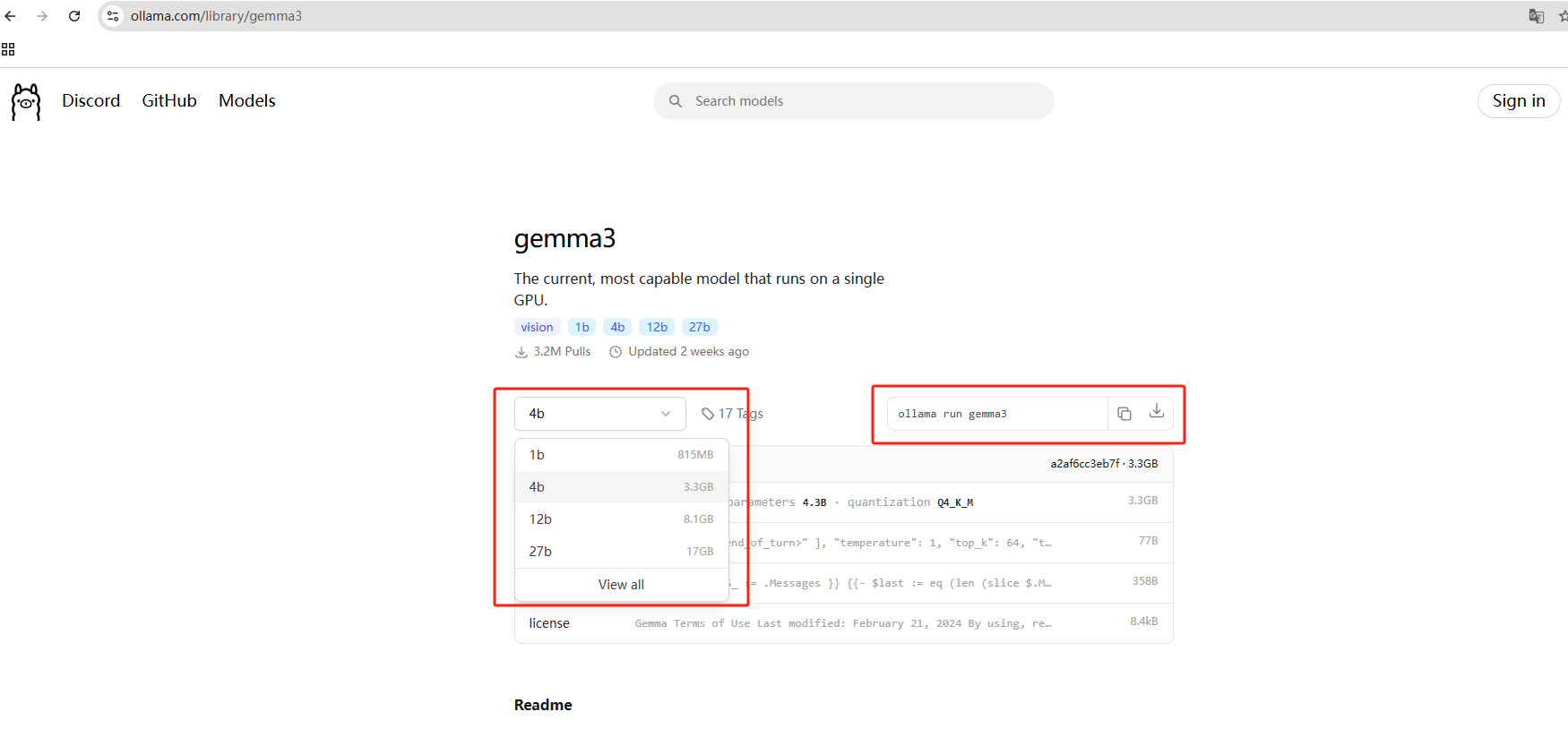

点进去之后,在左侧的下拉选项中能看到目前有4个量级的模型,分别是1b/4b/12b/27b和对应所需的储存空间:

本例使用gemma3:27b模型进行演示,**支持多模态(视觉)**27B 参数模型(128k 上下文窗口),需要准备20G以上硬盘空间,右边是运行命令:

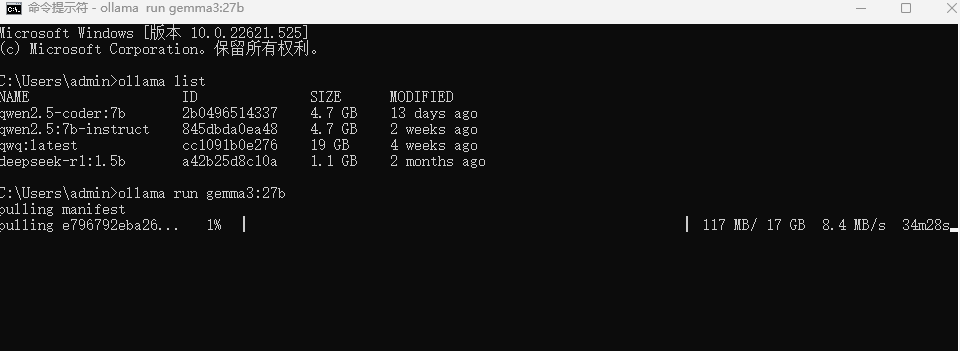

Ollama安装完成之后,打开cmd或者powershell等终端工具,执行命令就可以下载模型了:

shell

ollama run gemma3:27bPS:默认会下载模型到C盘,如果想修改下载位置,可以在终端中执行下方命令来指定模型文件的存放目录,这里以d:\ollama为例,大家可以自定义:

shellset OLLAMA_MODELS=d:\ollama

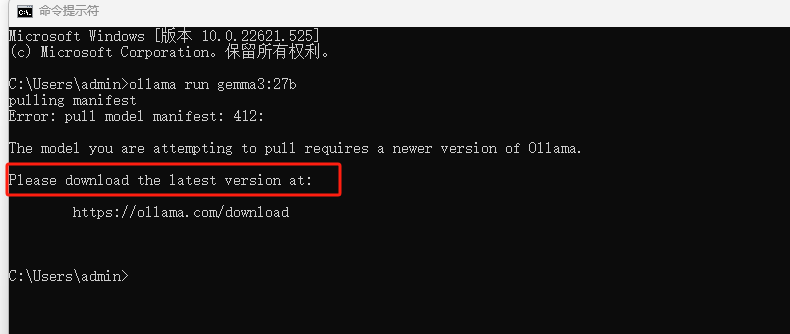

如果你之前安装过ollama,在执行命令后出现如下图提示,那么关闭终端,请先升级ollama到最新版本。

更新后,即可正常下载:

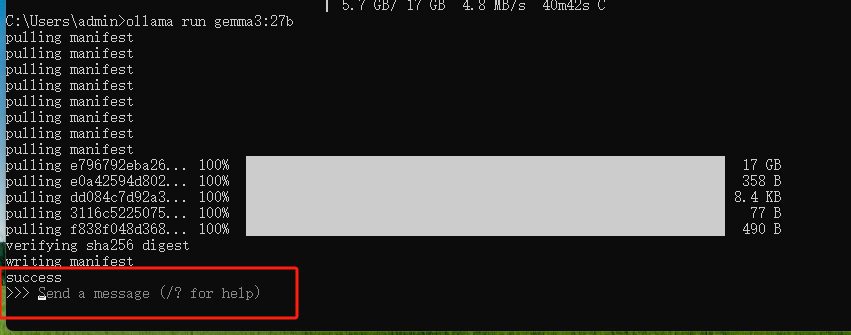

模型下载完成之后,安装成功后会提示success:

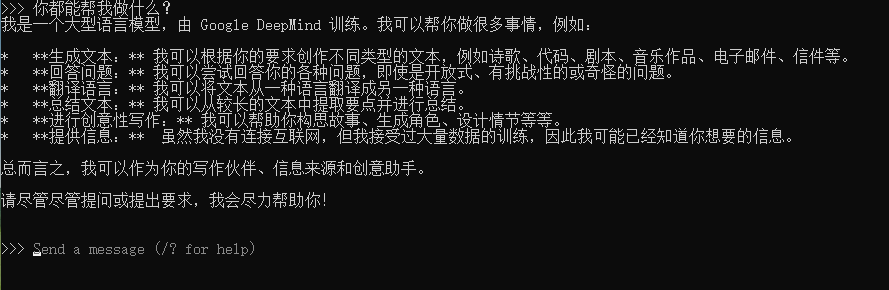

自动进入对话状态,直接输入内容就能提问了:

3. 安装Open WebUI图形化界面

现在我们已经能够在本地Windows电脑上使用Gemma3 27B模型解答问题了,但在命令行中对话可能不是很美观,在复制回答时也不太方便,我们可以通过安装一个图形化界面来解决这个问题。

不过在此之前,我们需要配置Ollama的环境变量,在终端中分别执行下方命令以便后续远程调用大模型:

shell

setx OLLAMA_HOST "0.0.0.0"

shell

setx OLLAMA_ORIGINS "*"然后点击电脑桌面右下角的ollama图标退出并重启服务。

本例以Open WebUI 这个图形化界面为例,使用Docker进行安装,它的界面和平时在网页中和其他大模型聊天非常相似。当然,大家也可以选择其他的方式,比如使用page assist浏览器插件,lobechat,cherry studio等。

如果大家之前未安装过Docker,可以参考下方教程进行Docker安装 :Docker安装------Linux、Windows、MacOS

3.1 Open WebUI安装运行

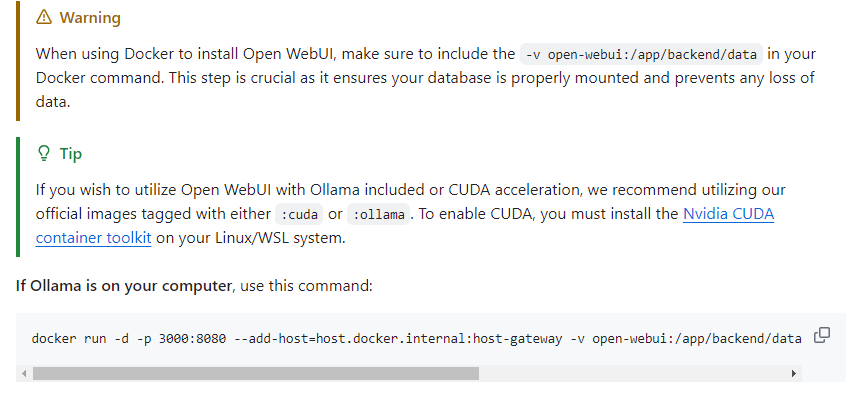

访问Open WebUI的github页面: https://github.com/open-webui/open-webui

如果你的Ollama和Open WebUI在同一台主机,执行这行命令在cmd终端中就可以在本地快速进行部署:

shell

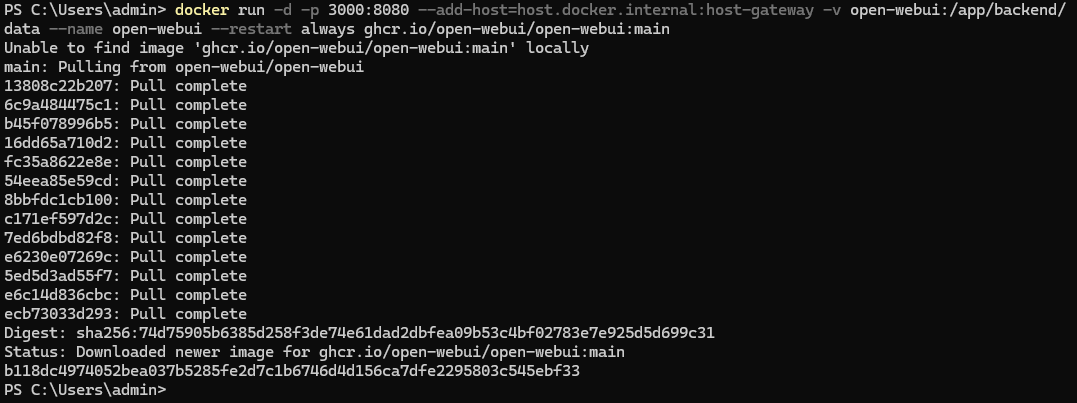

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main将上边在Docker中部署Open WebUI的命令复制后粘贴到终端中,回车:

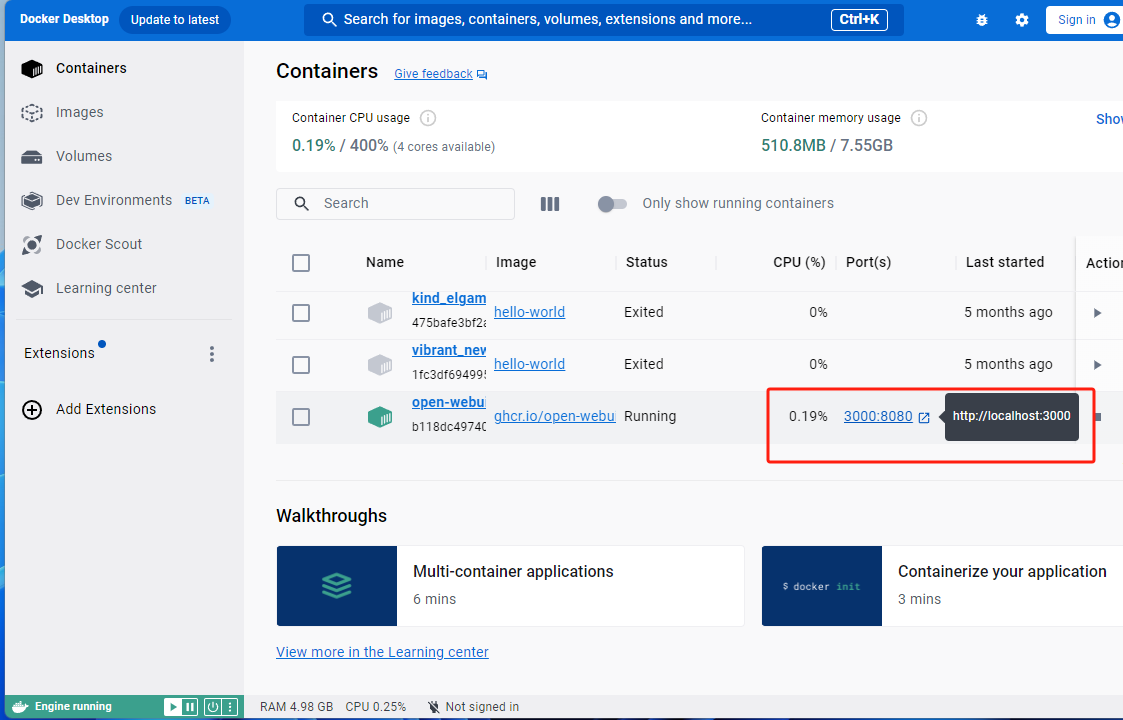

安装完成后,打开Docker Desktop,可以看到Open WebUI的web界面地址为:https://localhost:3000

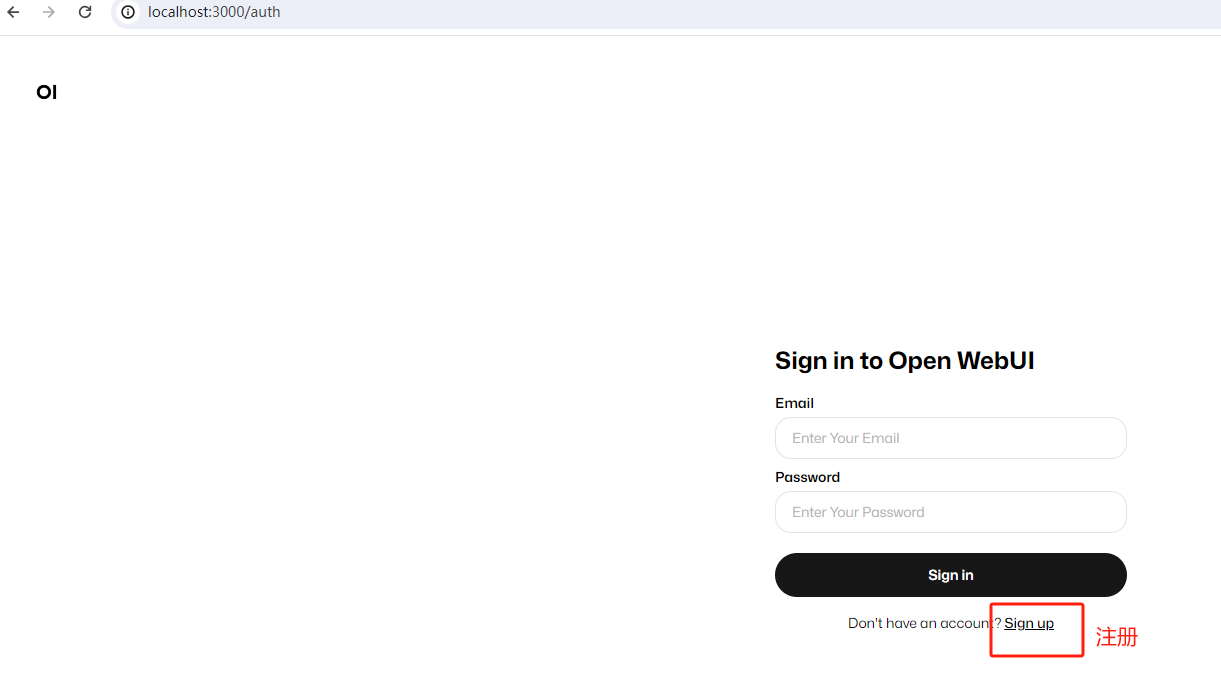

点击后会在浏览器打开登录界面:

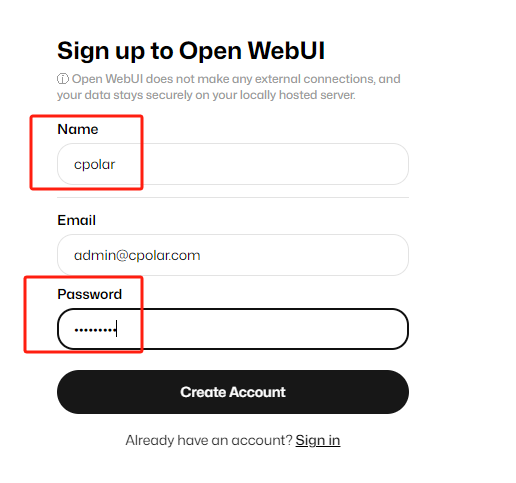

使用自己的邮箱注册账号,密码要记好,下次登录时需要用到:

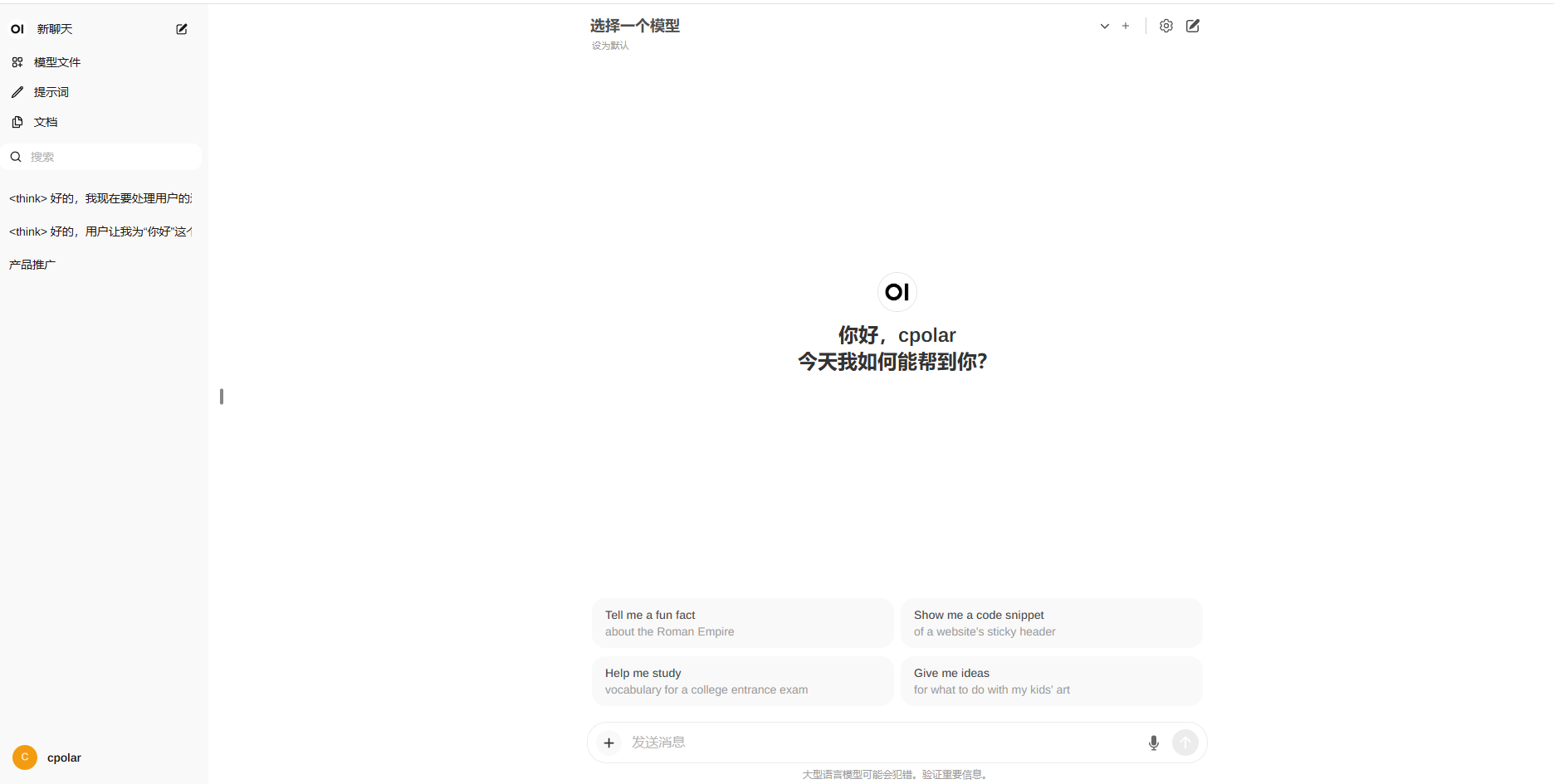

添加模型后就能在浏览器中使用web界面来和Gemma3 27B模型聊天了!

3.2 添加模型

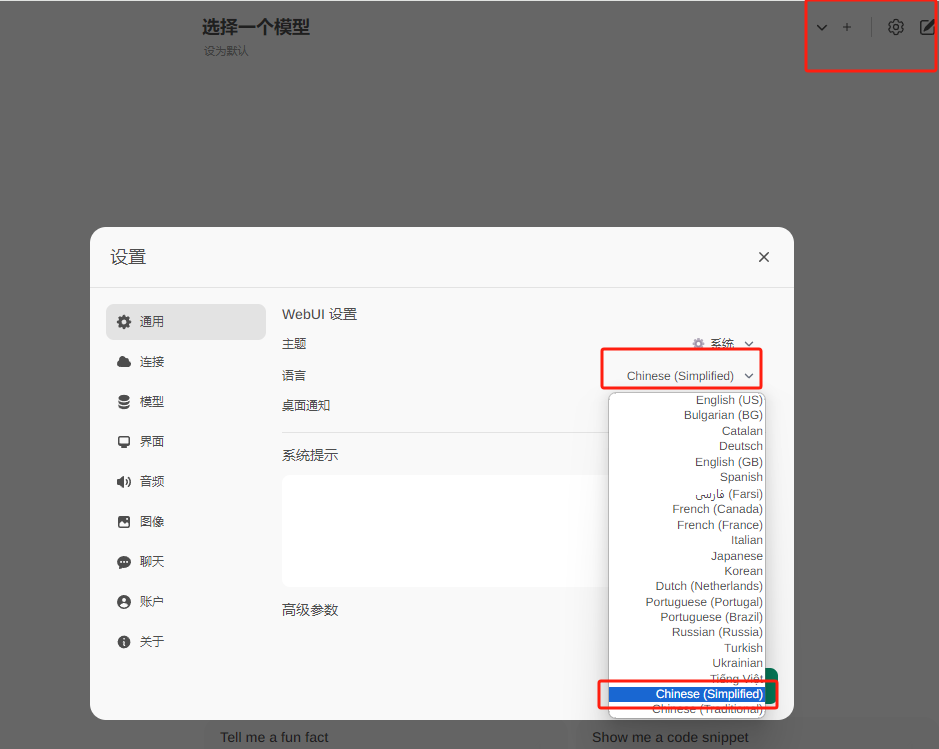

点击右上角的设置,可以修改当前界面的语言为简体中文:然后点击保存即可。

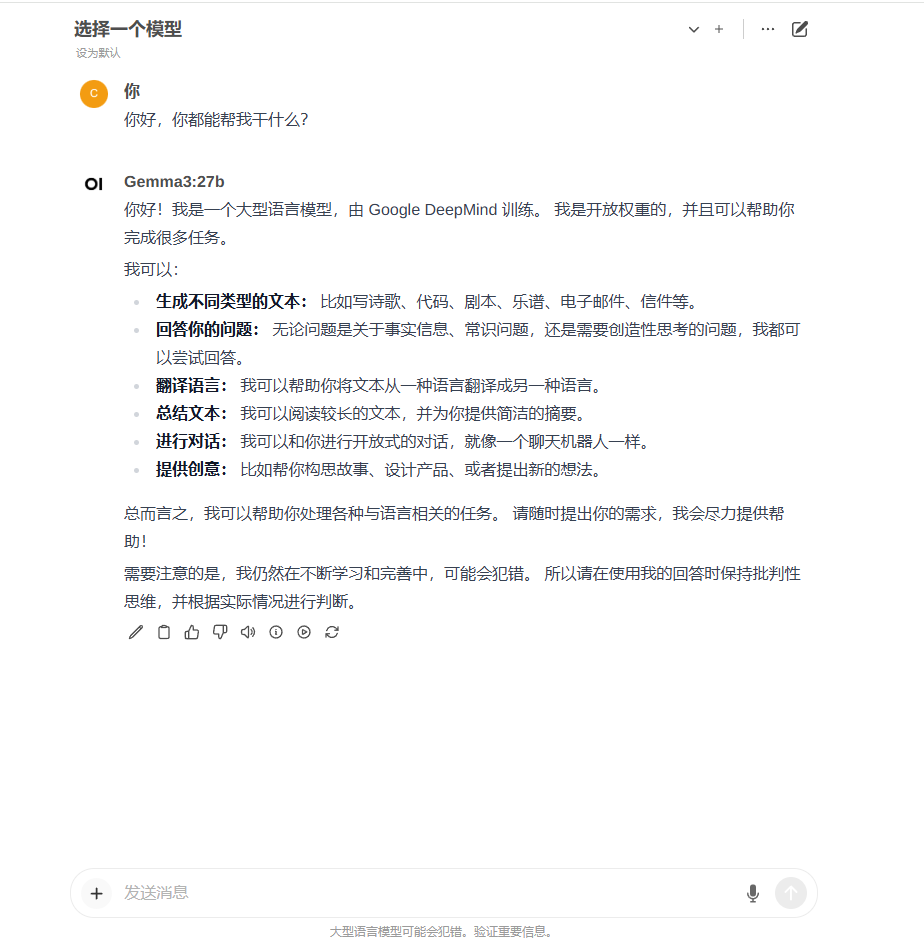

点击上方选择一个模型旁边的加号+可以增加大模型,点击下拉按钮可以选择当前使用哪一个已安装的模型,这里选择刚才安装的gemma3:27b,接下来就可以愉快的跟大模型在网页中聊天了!

到这里就成功在Windows电脑本地部署了gemma3:27b模型并使用Open WebUI在网页中与AI交互啦。

3.3 多模态测试

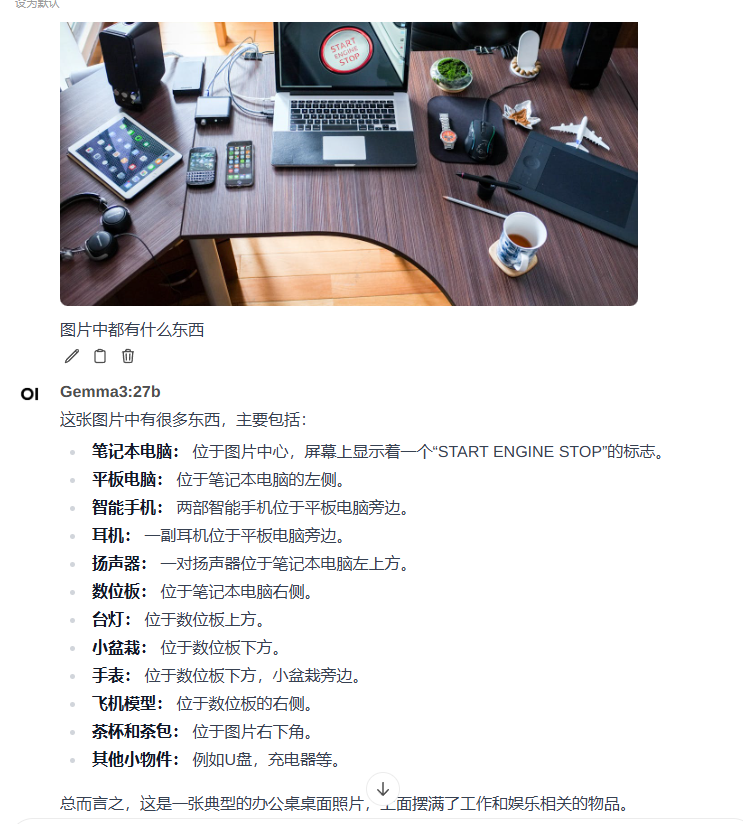

现在我们上传一张图片测试一下效果:(点击对话框左侧加号即可上传图片)

确实有点东西,识别物品的效果还是不错的,还给出了一个结论。

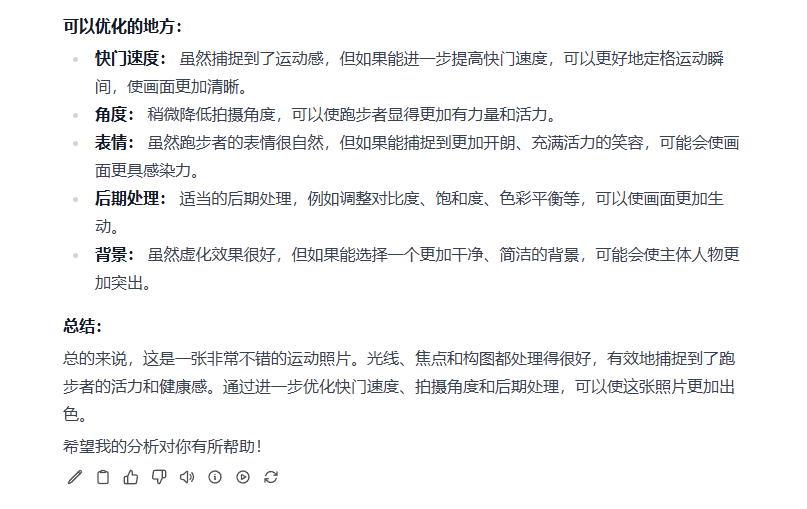

再来测试上传一张人物照片给它,让它分析一下拍摄效果并给出优化建议:

感觉似乎分析的也还行,大家感兴趣的话也可以稍后自己部署一下进行测试。

4. 安装内网穿透工具

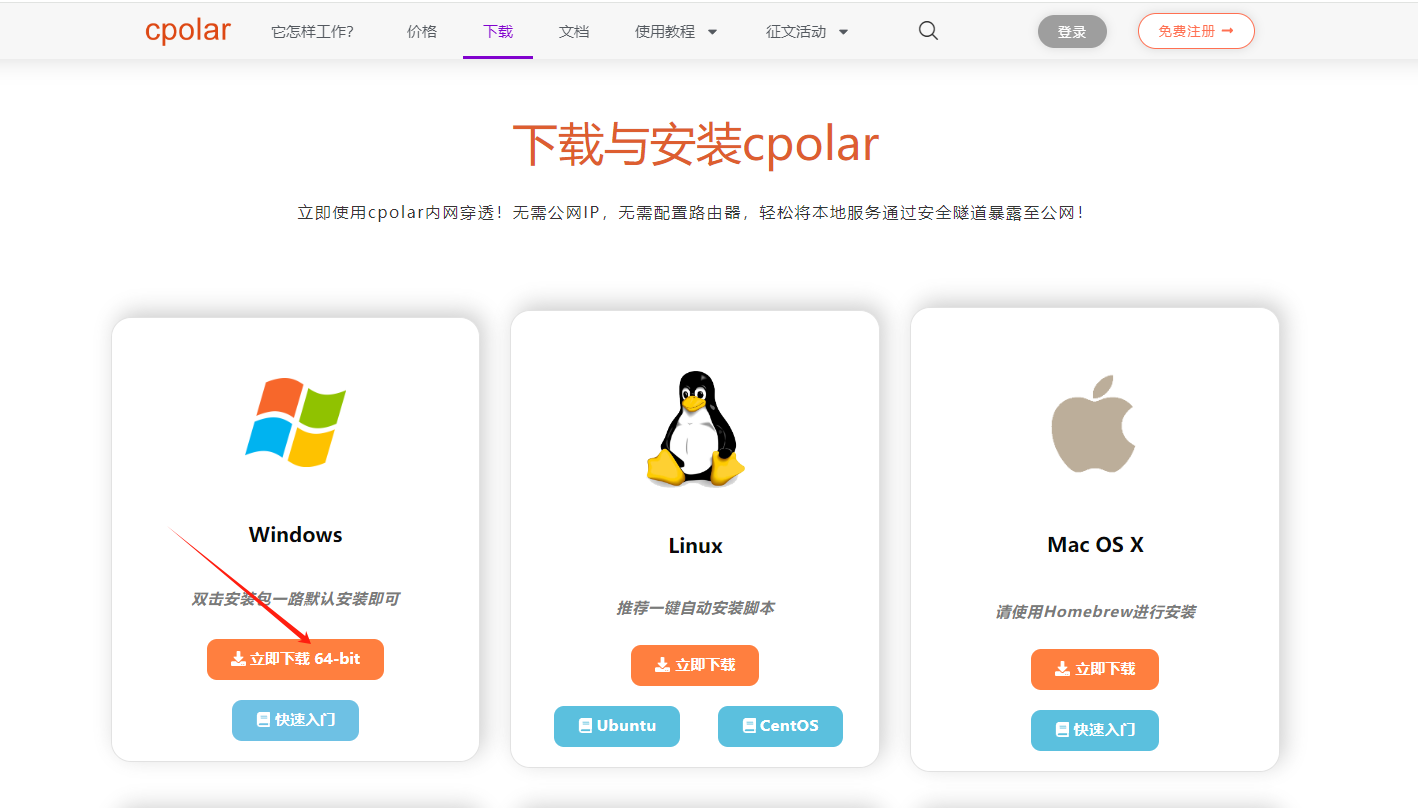

但如果想实现不在同一网络环境下,也能随时随地在浏览器中使用Open WebUI与本地部署的gemma3:27b大模型在网页中聊天,那就需要借助cpolar内网穿透工具来实现公网访问了!接下来介绍一下如何安装cpolar内网穿透,过程同样非常简单:

首先进入cpolar官网:

cpolar官网地址: https://www.cpolar.com

点击免费使用注册一个账号,并下载最新版本的cpolar:

登录成功后,点击下载cpolar到本地并安装(一路默认安装即可)本教程选择下载Windows版本。

登录成功后,点击下载cpolar到本地并安装(一路默认安装即可)本教程选择下载Windows版本。

cpolar安装成功后,在浏览器上访问http://localhost:9200,使用cpolar账号登录,登录后即可看到配置界面,结下来在WebUI管理界面配置即可。

接下来配置一下 Open WebUI 的公网地址:

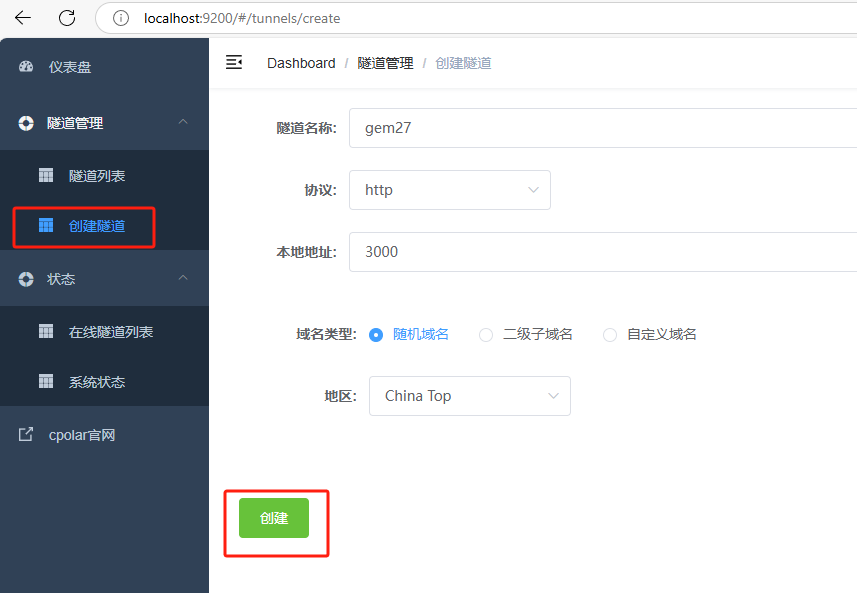

登录后,点击左侧仪表盘的隧道管理------创建隧道,

- 隧道名称:gem27(可自定义命名,注意不要与已有的隧道名称重复)

- 协议:选择 http

- 本地地址:3000 (本地访问的地址)

- 域名类型:选择随机域名

- 地区:选择China Top

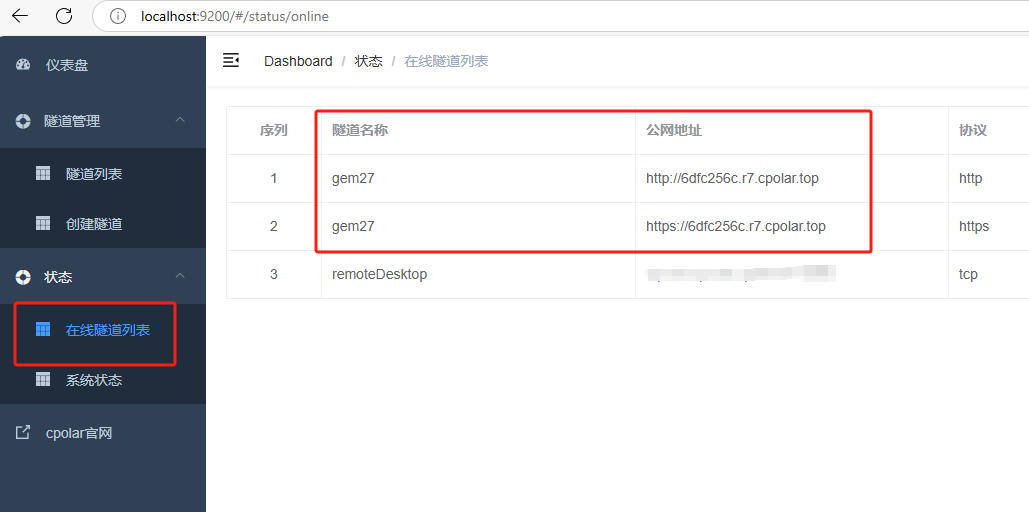

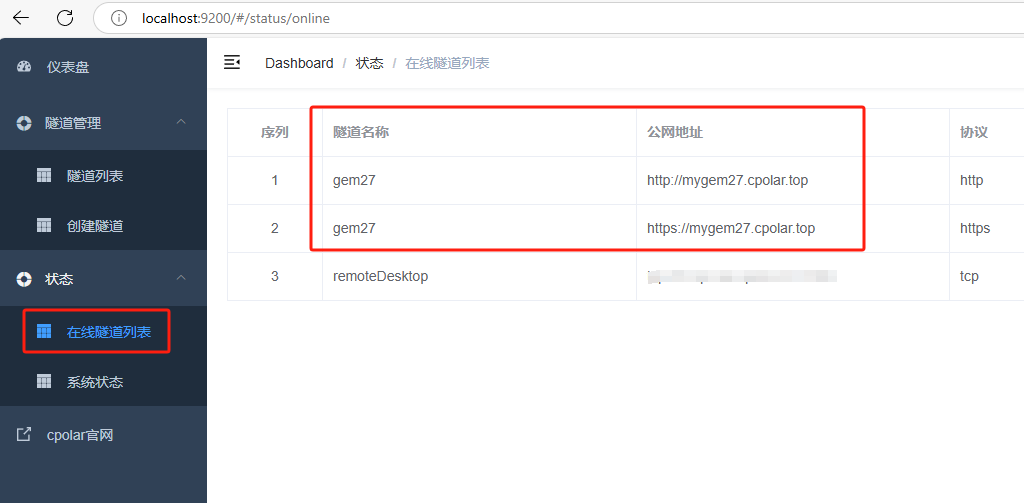

隧道创建成功后,点击左侧的状态------在线隧道列表,查看所生成的公网访问地址,有两种访问方式,一种是http 和https:

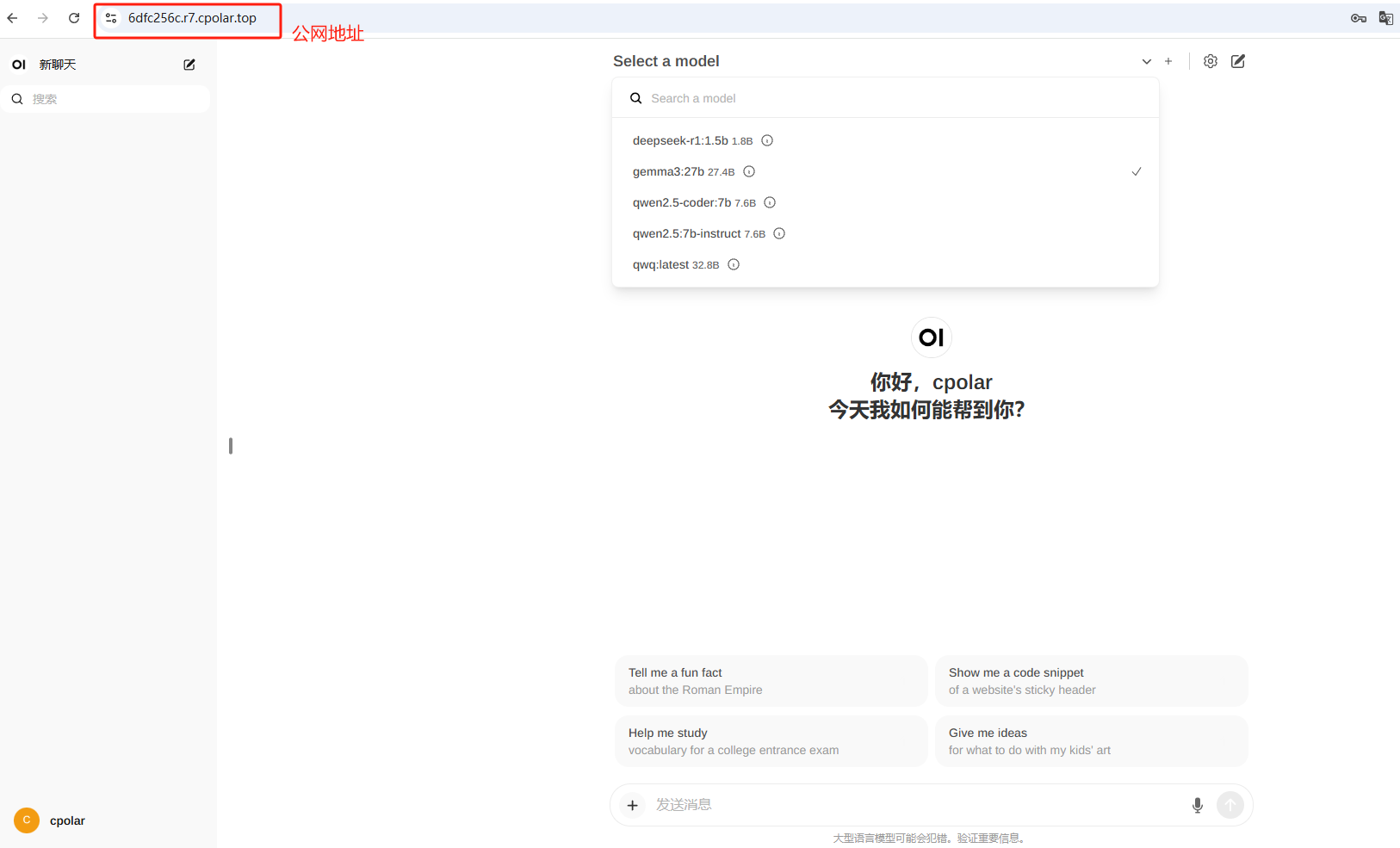

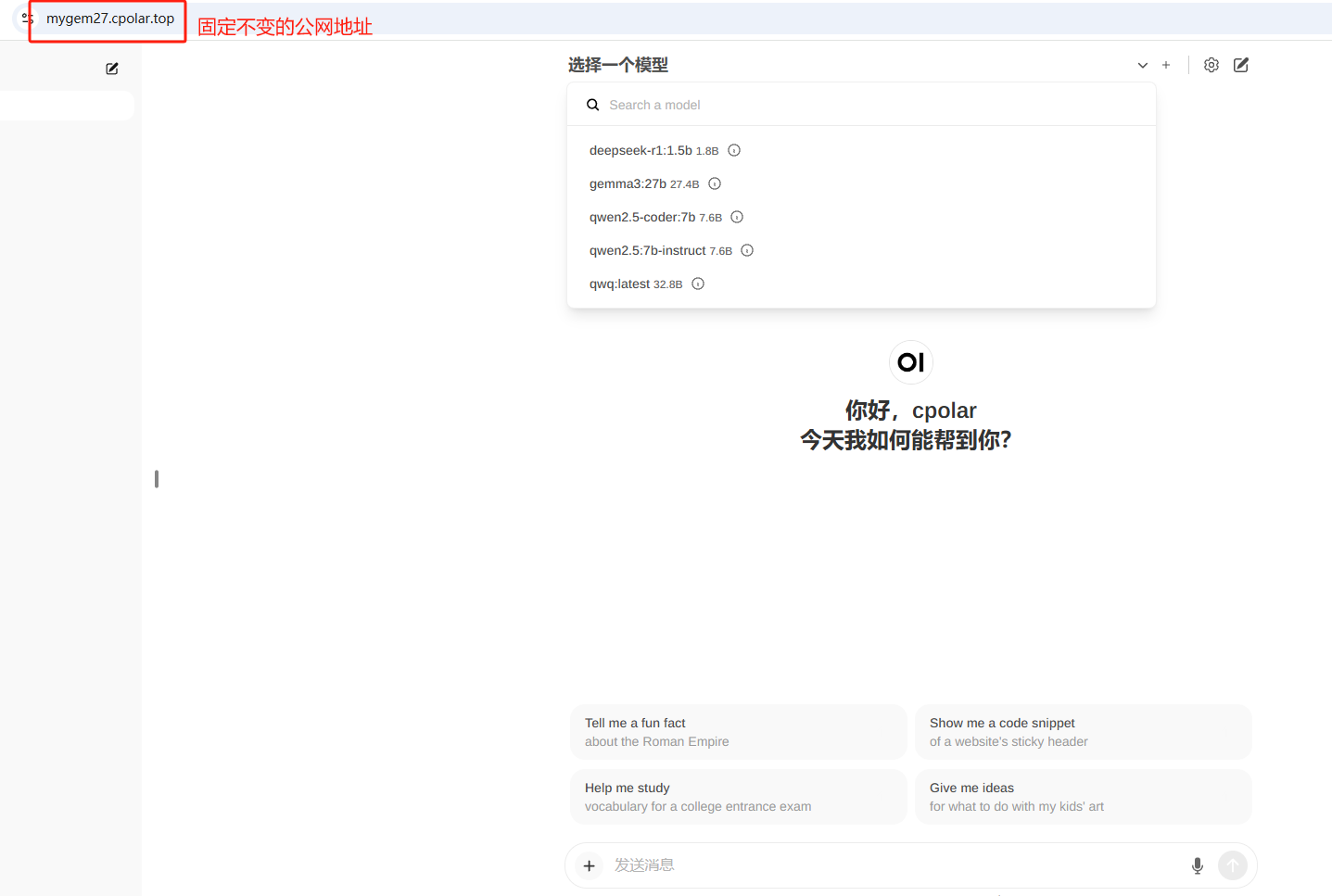

使用上面的任意一个公网地址,在手机或任意设备的浏览器进行登录访问,即可成功看到 Open WebUI 界面,这样一个公网地址且可以远程访问就创建好了,使用了cpolar的公网域名,无需自己购买云服务器,即可到随时在线访问Open WebUI来在网页中使用本地部署的gemma3:27b大模型了!

小结

为了方便演示,我们在上边的操作过程中使用cpolar生成的HTTP公网地址隧道,其公网地址是随机生成的。这种随机地址的优势在于建立速度快,可以立即使用。然而,它的缺点是网址是随机生成,这个地址在24小时内会发生随机变化,更适合于临时使用。

如果有长期远程访问Open WebUI使用gemma3:27b模型,或者异地访问与使用其他本地部署的服务的需求,但又不想每天重新配置公网地址,还想让公网地址好看又好记并体验更多功能与更快的带宽,那我推荐大家选择使用固定的二级子域名方式来为Open WebUI配置一个公网地址。

5. 配置固定公网地址

接下来演示如何为其配置固定的HTTP公网地址,该地址不会变化,方便分享给别人长期查看你部署的项目,而无需每天重复修改服务器地址。

配置固定http端口地址需要将cpolar升级到专业版套餐或以上。

登录cpolar官网,点击左侧的预留,选择保留二级子域名,设置一个二级子域名名称,点击保留:

保留成功后复制保留成功的二级子域名的名称:mygem27,大家也可以设置自己喜欢的名称。

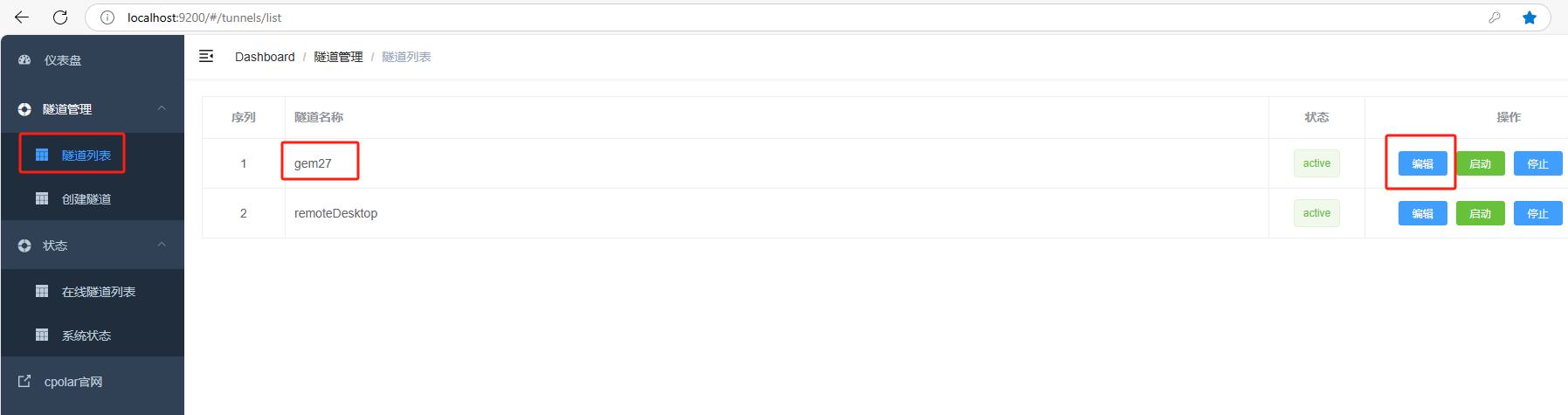

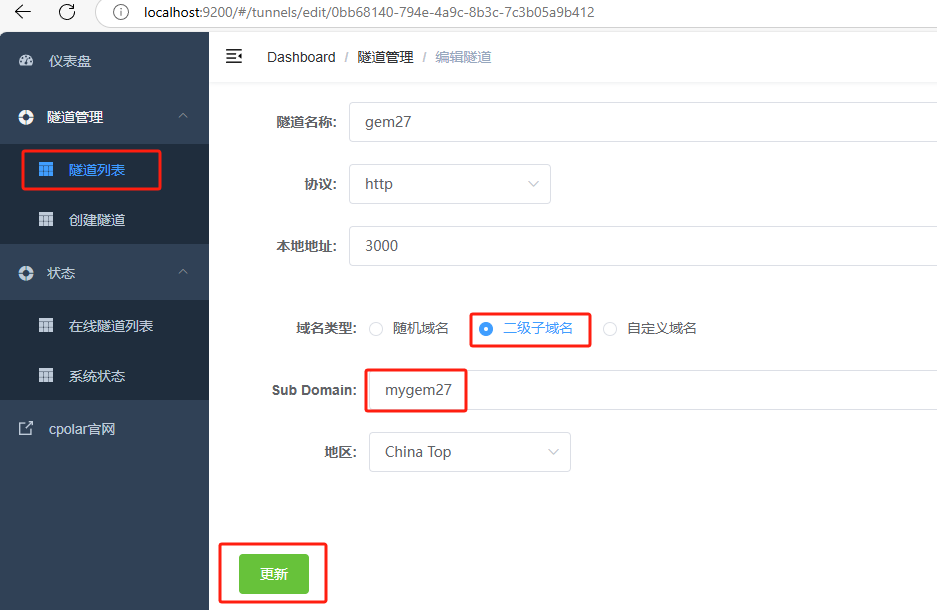

返回Cpolar web UI管理界面,点击左侧仪表盘的隧道管理------隧道列表,找到所要配置的隧道:gem27,点击右侧的编辑:

修改隧道信息,将保留成功的二级子域名配置到隧道中

- 域名类型:选择二级子域名

- Sub Domain:填写保留成功的二级子域名:

mygem27

点击更新(注意,点击一次更新即可,不需要重复提交)

更新完成后,打开在线隧道列表,可以看到公网地址已经发生变化,地址名称也变成了固定的二级子域名名称的域名:

最后,我们使用上边任意一个固定的公网地址访问,可以看到访问成功,这样一个固定且永久不变的公网地址就设置好了,可以随时随地在公网环境异地在线访问本地部署的Open WebUI来使用gemma3:27b大模型了!

总结

经过简单的测试,这款多模态大模型的表现确实令人惊艳,不仅在性能上表现优异,而且还能在家用级硬件上轻松运行。这无疑大大降低了普通用户接触和使用高端AI技术的门槛。未来,Gemma3的发展潜力无限,让我们拭目以待吧!如果你也对这个项目感兴趣,不妨动手试试看,有任何疑问欢迎随时留言交流,我们共同探讨、一起成长!