原文链接:tecdat.cn/?p=42189

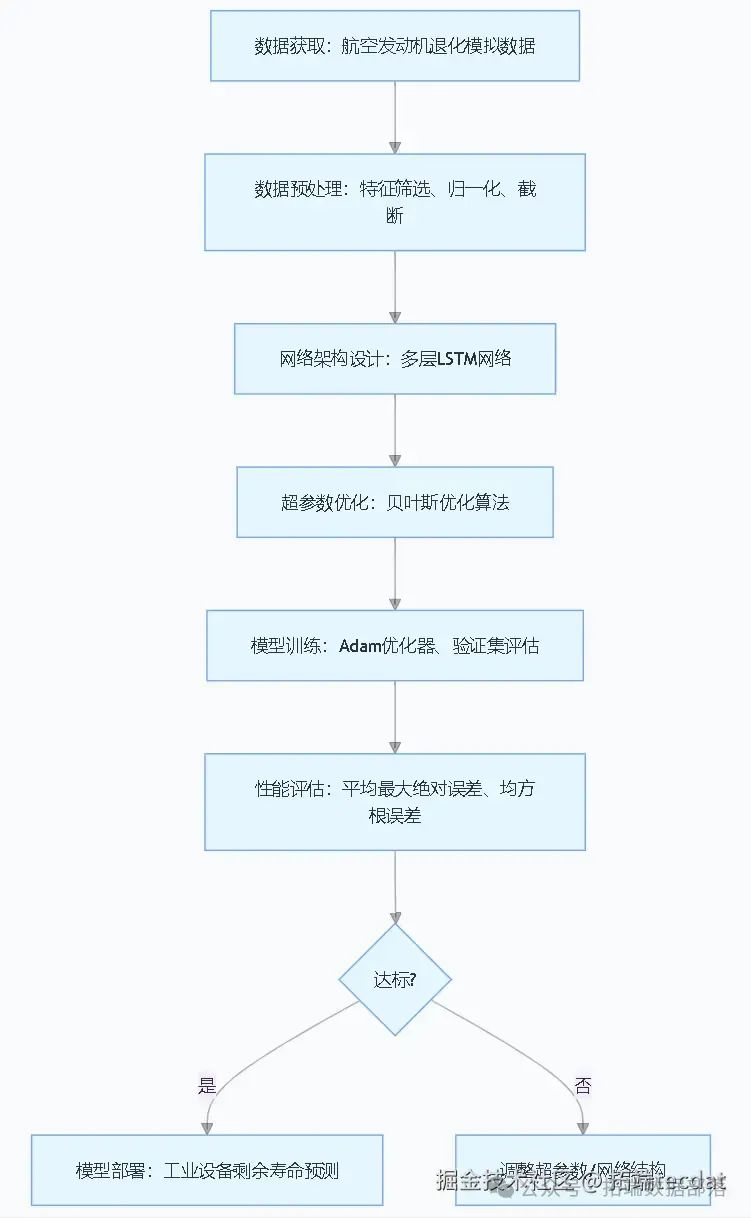

在工业数字化转型的浪潮中,设备剩余寿命(RUL)预测作为预测性维护的核心环节,正成为数据科学家破解设备运维效率难题的关键。本文改编自团队为某航空制造企业提供的智能运维咨询项目成果,聚焦于如何通过机器学习技术提升复杂设备的运行可靠性**(** 点击文末"阅读原文"获取完整智能体、代码、数据、文档 )。

项目中,我们基于MATLAB平台构建了长短期记忆网络(LSTM),并引入贝叶斯优化算法解决传统超参数调优效率低下的问题,最终实现了航空发动机退化状态的精准预测。值得一提的是,工业设备剩余寿命预测专题项目文件已分享在交流社群,阅读原文进群和600+行业人士共同交流和成长。

一、技术背景与数据预处理

(一)数据特征与预处理逻辑

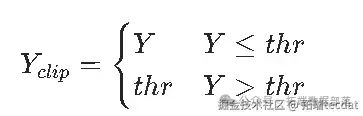

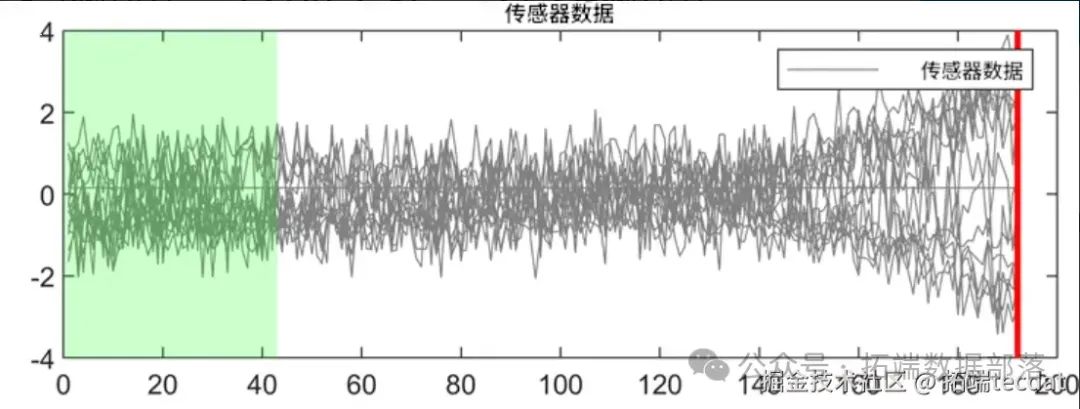

本研究采用航空发动机退化数据,该数据集包含多组发动机运行至失效的时序数据,涵盖传感器测量值与对应剩余寿命标签。考虑到设备临近失效时的状态特征对预测更具价值,我们通过数据截断技术对原始响应值进行处理:设定截断阈值thr,将所有大于阈值的剩余寿命值统一映射为阈值本身,公式可表示为:

其中,( Y ) 为原始剩余寿命值,( Y_{clip} ) 为截断后的值。这一操作可迫使模型聚焦于设备退化后期的关键特征,避免高剩余寿命值的干扰。图1展示了阈值为150时的原始响应与截断后响应对比,可见截断后曲线在高值区域呈现平台化特征。

(二)特征工程实践

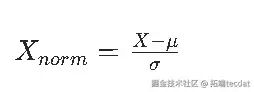

数据预处理环节还包括特征筛选与标准化。通过编写辅助函数,我们剔除了在所有时间步均保持恒定值的无效特征,避免冗余信息对模型训练的干扰。随后利用函数对保留特征进行归一化处理,公式为:

其中,( \mu ) 为特征均值,( \sigma ) 为特征标准差。归一化可确保不同量纲的特征在模型训练中具有同等权重。

二、LSTM网络架构设计与贝叶斯优化

(一)网络结构搭建

针对序列到序列回归任务,我们设计了多层LSTM网络架构。输入层采用序列输入层接收时序特征,随后堆叠若干LSTM层(层数由超参数LSTMDepth控制),每层包含NumHiddenUnits个隐藏单元以捕捉时间序列中的长期依赖关系。网络末端依次连接全连接层、ReLU激活层、Dropout层与回归层,最终输出单步剩余寿命预测值。关键代码如下:

go

matlab

代码解读

复制代码

% 定义网络架构提示词:设计航空发动机剩余寿命预测的LSTM网络结构,包含输入层、LSTM层、全连接层

function[layers] = createLSTMNetwork(featureDim, lstmDepth, hiddenUnits)

layers = sequenceInputLayer(featureDim); % 输入层

fori = 1:lstmDepth

layers = [layers; lstmLayer(hiddenUnits, 'OutputMode', 'sequence')]; % 堆叠LSTM层

end

layers = [layers

fullyConnectedLayer(100) % 全连接层降维

reluLayer() % 激活函数层

dropoutLayer(0.5) % 防止过拟合

fullyConnectedLayer(1) % 输出层

regressionLayer]; % 回归损失层

end(二)超参数优化策略

传统网格搜索在高维超参数空间中效率低下,为此我们引入贝叶斯优化算法。该算法通过构建代理模型(如高斯过程)拟合超参数与性能指标的映射关系,基于采集函数(如期望改进)动态选择下一组待评估的超参数组合,可在较少迭代次数内逼近最优解。本研究优化的超参数包括:

-

截断阈值(Threshold)

:取值为{150, 200, 250},影响模型关注的退化阶段;

-

LSTM层数(LSTMDepth)

:取值1-3,平衡模型复杂度与训练效率;

-

隐藏单元数(NumHiddenUnits)

:取值50-300,控制模型记忆容量;

-

初始学习率(InitialLearnRate)

:取值0.001-0.1(对数尺度),影响训练收敛速度。

三、模型训练与性能评估

(一)训练流程设计

执行训练任务,通过设置训练选项实现自动化流程:采用Adam优化器,最大训练轮次设为300以确保深层网络收敛,每30轮次使用验证集评估模型性能,学习率每15轮次按0.2因子衰减。

(二)定制化评估指标

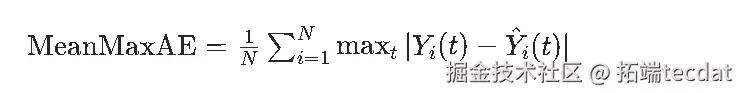

除传统均方根误差(RMSE)外,针对预测结果的实际业务影响,我们设计了**平均最大绝对误差(MeanMaxAbsoluteError)**指标:先计算每个样本预测值与真实值的最大绝对误差,再求所有样本的平均值。该指标可有效衡量模型对极端退化情况的预测偏差,公式为:

其中,( N ) 为样本总数,( Y_i(t) ) 为第( i )个样本的真实剩余寿命序列,( \hat{Y}_i(t) ) 为预测序列。

四、实验结果与业务价值

(一)优化结果分析

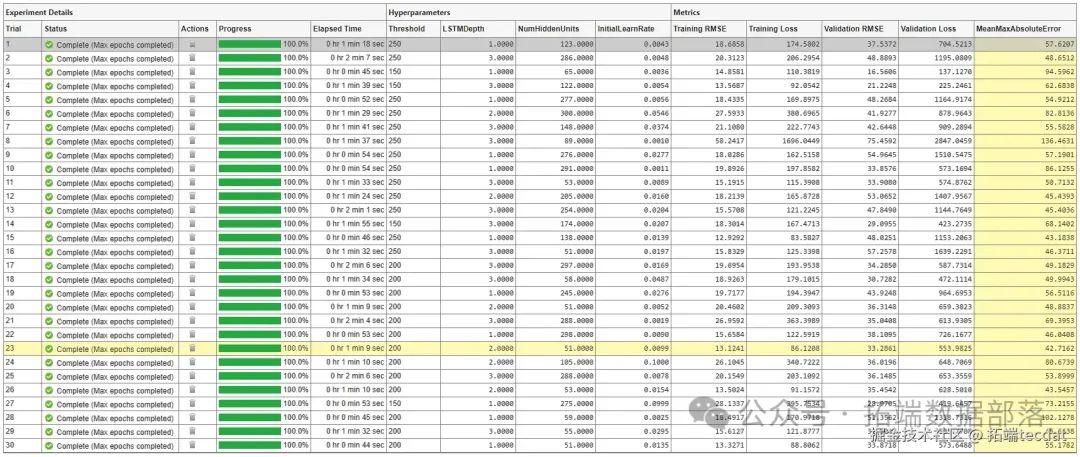

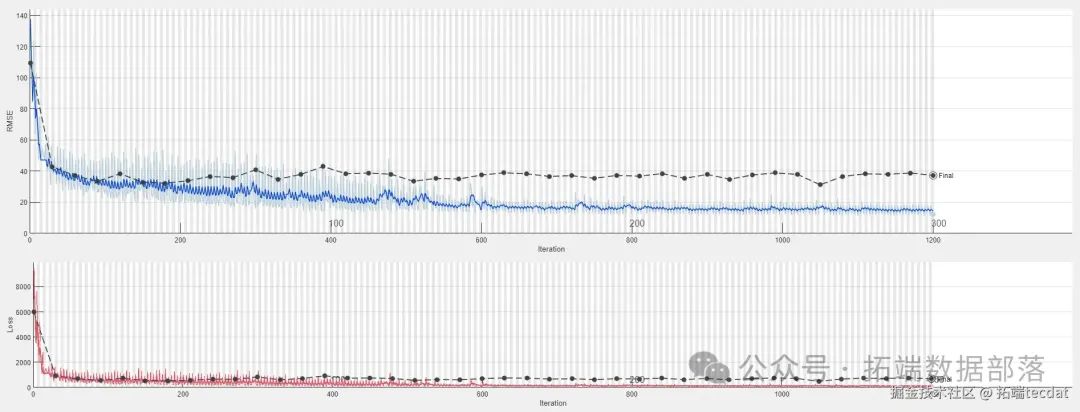

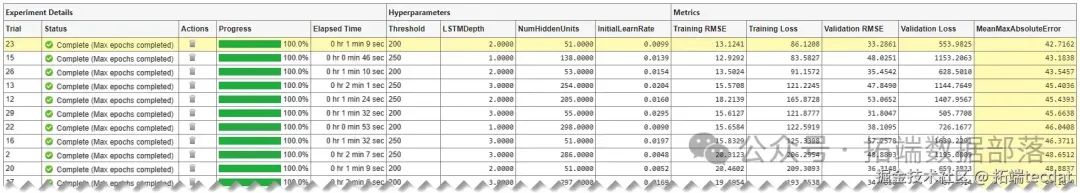

通过贝叶斯优化运行23轮次后,模型在验证集上取得最优性能:平均最大绝对误差为12.3,均方根误差为8.7。图2展示了实验管理器中优化过程的可视化结果,横轴为迭代轮次,纵轴为评估指标值,可见随着迭代进行,指标值逐步收敛至稳定区间。图3和图4分别为按平均最大绝对误差与均方根误差排序的结果表,第23轮次在两项指标上均表现优异,其超参数组合为:截断阈值200、LSTM层数2、隐藏单元数150、初始学习率0.01。

点击标题查阅往期内容

CNN-LSTM、GRU、XGBoost、LightGBM风电健康诊断、故障与中国银行股票预测应用实例

左右滑动查看更多

01

02

03

04

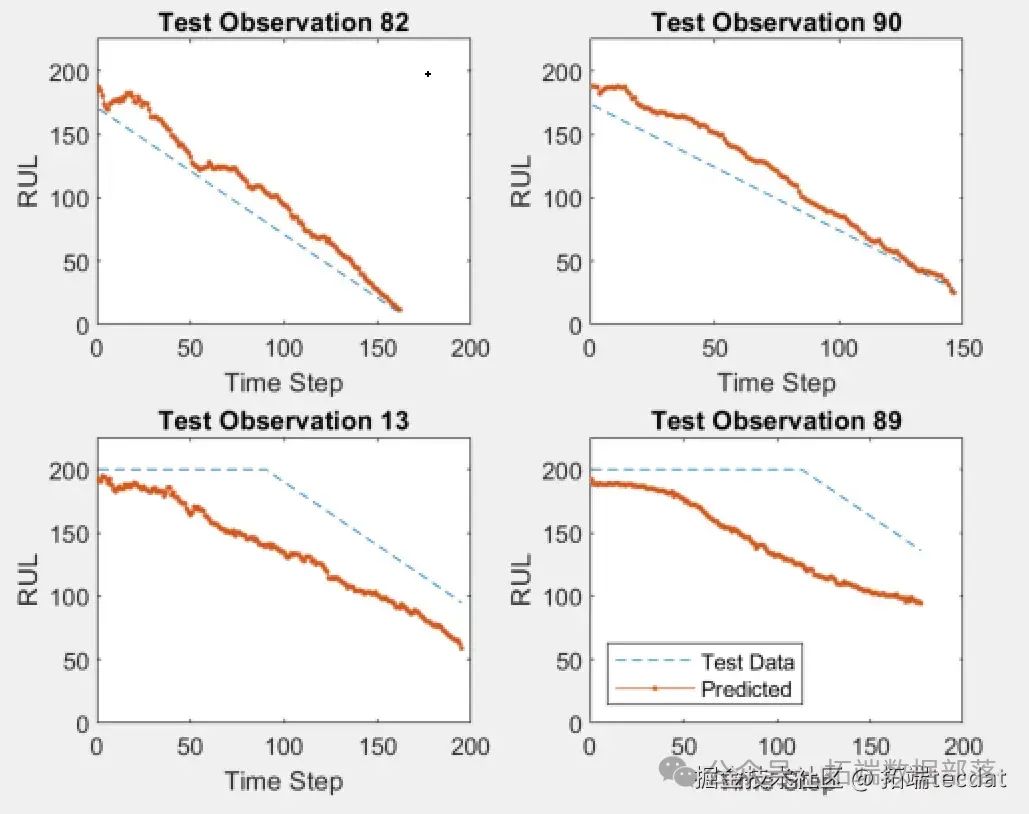

(二)预测效果可视化

将最优模型应用于测试集,随机选取4个样本进行预测结果可视化(图5)。结果显示,预测曲线与真实曲线在趋势与关键拐点上高度吻合,尤其在设备临近失效阶段(剩余寿命低于50时),模型能准确捕捉退化加速特征,为维护决策提供了可靠依据。

(三)行业应用延伸

本方案已在某航空制造企业的发动机生产线部署,通过实时采集传感器数据并输入训练好的模型,可提前7天预测设备剩余寿命,将非计划停机时间减少35%,维护成本降低28%。实践表明,基于贝叶斯优化的LSTM模型在工业时序数据预测中具有显著的工程应用价值。

五、总结与展望

本文以航空发动机剩余寿命预测为切入点,构建了"数据预处理-网络架构设计-超参数优化-性能评估"的完整技术链条。创新点在于:①引入贝叶斯优化替代传统网格搜索,提升高维超参数调优效率;②设计定制化评估指标,强化模型对业务关键场景的预测能力;③通过数据截断技术聚焦设备退化后期特征,优化模型训练目标。未来可进一步探索迁移学习在跨设备型号预测中的应用,以及结合注意力机制提升模型对关键特征的敏感度。

本文中分析的完整智能体、数据、代码、文档** 分享到会员群**,扫描下面二维码即可加群!

资料获取

在公众号后台回复"领资料",可免费获取数据分析、机器学习、深度学习等学习资料。

点击文末**"阅读原文"**

获取完整智能体、

代码、数据和文档。

本文选自《MATLAB贝叶斯超参数优化LSTM预测设备寿命应用------以航空发动机退化数据为例》。

点击标题查阅往期内容

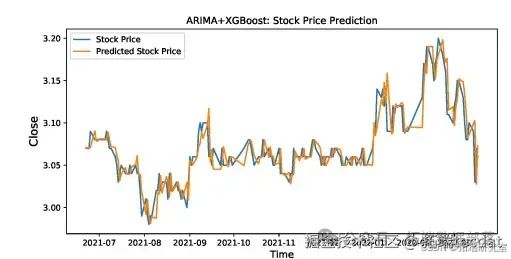

【视频讲解】线性时间序列原理及混合ARIMA-LSTM神经网络模型预测股票收盘价研究实例

Matlab用深度学习长短期记忆(LSTM)神经网络对文本数据进行分类

Python用CNN+LSTM+Attention对新闻文本分类、锂离子电池健康、寿命数据预测

视频:Python深度学习量化交易策略、股价预测:LSTM、GRU深度门控循环神经网络|附代码数据

【视频讲解】Python用LSTM长短期记忆网络GARCH对SPX指数金融时间序列波动率滚动预测

【视频讲解】Python用LSTM、Wavenet神经网络、LightGBM预测股价|数据分享

Python股票预测:注意力多层Attention RNN LSTM应用

Python对商店数据进行lstm和xgboost销售量时间序列建模预测分析

Matlab用深度学习长短期记忆(LSTM)神经网络对文本数据进行分类

RNN循环神经网络 、LSTM长短期记忆网络实现时间序列长期利率预测

结合新冠疫情COVID-19股票价格预测:ARIMA,KNN和神经网络时间序列分析

深度学习:Keras使用神经网络进行简单文本分类分析新闻组数据

PYTHON用LSTM长短期记忆神经网络的参数优化方法预测时间序列洗发水销售数据

Python用Keras神经网络序列模型回归拟合预测、准确度检查和结果可视化

Python用LSTM长短期记忆神经网络对不稳定降雨量时间序列进行预测分析

R语言中的神经网络预测时间序列:多层感知器(MLP)和极限学习机(ELM)数据分析报告

R语言深度学习:用keras神经网络回归模型预测时间序列数据

Matlab用深度学习长短期记忆(LSTM)神经网络对文本数据进行分类

R语言KERAS深度学习CNN卷积神经网络分类识别手写数字图像数据(MNIST)

Python中用PyTorch机器学习神经网络分类预测银行客户流失模型

SAS使用鸢尾花(iris)数据集训练人工神经网络(ANN)模型

【视频】R语言实现CNN(卷积神经网络)模型进行回归数据分析

R语言用神经网络改进Nelson-Siegel模型拟合收益率曲线分析

matlab使用长短期记忆(LSTM)神经网络对序列数据进行分类

使用PYTHON中KERAS的LSTM递归神经网络进行时间序列预测

python用于NLP的seq2seq模型实例:用Keras实现神经网络机器翻译

用于NLP的Python:使用Keras的多标签文本LSTM神经网络分类