序章:一个前端的「AI梦」

作为一个只会切图的前端仔,我一直有个梦想------让网页拥有「智能」。直到有一天,设计师小姐姐甩给我一张图:

"这个产品图的背景太丑了,帮我P掉"

我:"???我是前端不是美工啊!" 设计师:"听说你会JavaScript?那AI抠图对你来说不是有手就行?"

于是,这个基于React+ONNX Runtime的本地背景移除工具就诞生了。这篇文章记录了我从「AI小白」到「半吊子炼丹师」的踩坑之旅,以及如何用前端技术栈实现本该后端干的事。

技术选型:前端工程师的「武器库」

核心技术栈

- React:UI框架(毕竟我只会这个)

- Vite:构建工具(比Webpack快到飞起,谁用谁知道)

- ONNX Runtime Web:在浏览器中运行AI模型的黑科技

- RMBG-1.4模型:来自Bria AI的背景移除模型,效果比某些收费软件还好

- Stable Diffusion XL:AI图像生成功能,让用户可以"无中生有"

为什么选择本地运行?

Privacy is the new luxury(隐私是新的奢侈品)。当我看到某在线抠图网站的隐私政策时,我的内心是崩溃的:

"我们有权使用您上传的图片用于AI训练..."

于是我下定决心:必须让所有计算都在用户本地完成!就算用户上传「不可描述」的图片,也只有他自己知道。

虽然项目已经部署到GitHub Page(在线体验),但由于模型文件高达200MB+,在线加载会非常缓慢(实测首次加载需30秒以上)。强烈建议克隆代码到本地运行(npm run dev),既能获得更快的加载速度(本地读取文件仅需3-5秒),还能避免网络传输带来的隐私风险。

开发血泪史:那些与bug搏斗的日夜

1. 模型加载:当「召唤神龙」失败时

第一次加载ONNX模型的场景,至今历历在目:

javascript

// 理想很丰满

const model = await ort.InferenceSession.create('model.onnx');

// 现实很骨感

Uncaught (in promise) Error: Failed to load model: 404 Not Found原来模型文件有200多MB,直接放public目录导致Vite启动崩溃。解决方案?用rollup-plugin-copy插件在构建时自动将模型和WASM文件复制到dist目录,确保生产环境能正确加载。

2. 图像处理:像素级的「找茬游戏」

预处理图片时,我天真地以为:

"不就是把图片转成张量吗?so easy!"

结果被现实狠狠打脸。图片缩放、通道转换、归一化...每一步都可能让输出变成「抽象画」。最后不得不祭出「暴力调试法」:

javascript

// 为了调试,我打印了每个像素值

console.log('Pixel R:', r, 'G:', g, 'B:', b);

// 然后控制台就炸了...3. 性能优化:与时间赛跑

最初版本处理一张图片需要10秒+,用户体验堪比PPT。目前已实现的优化手段:

- 优化ONNX Runtime配置,启用图优化和内存管理

- 采用高效的图像预处理算法,减少不必要的像素操作

- 固定模型输入尺寸为1024px,在质量和速度间取得平衡

这些优化让处理时间降到了5秒以内,虽然离"丝滑流畅"还有距离,但已经是肉眼可见的进步!

功能亮点:不止于「抠图」

1. 摄像头快照抠图

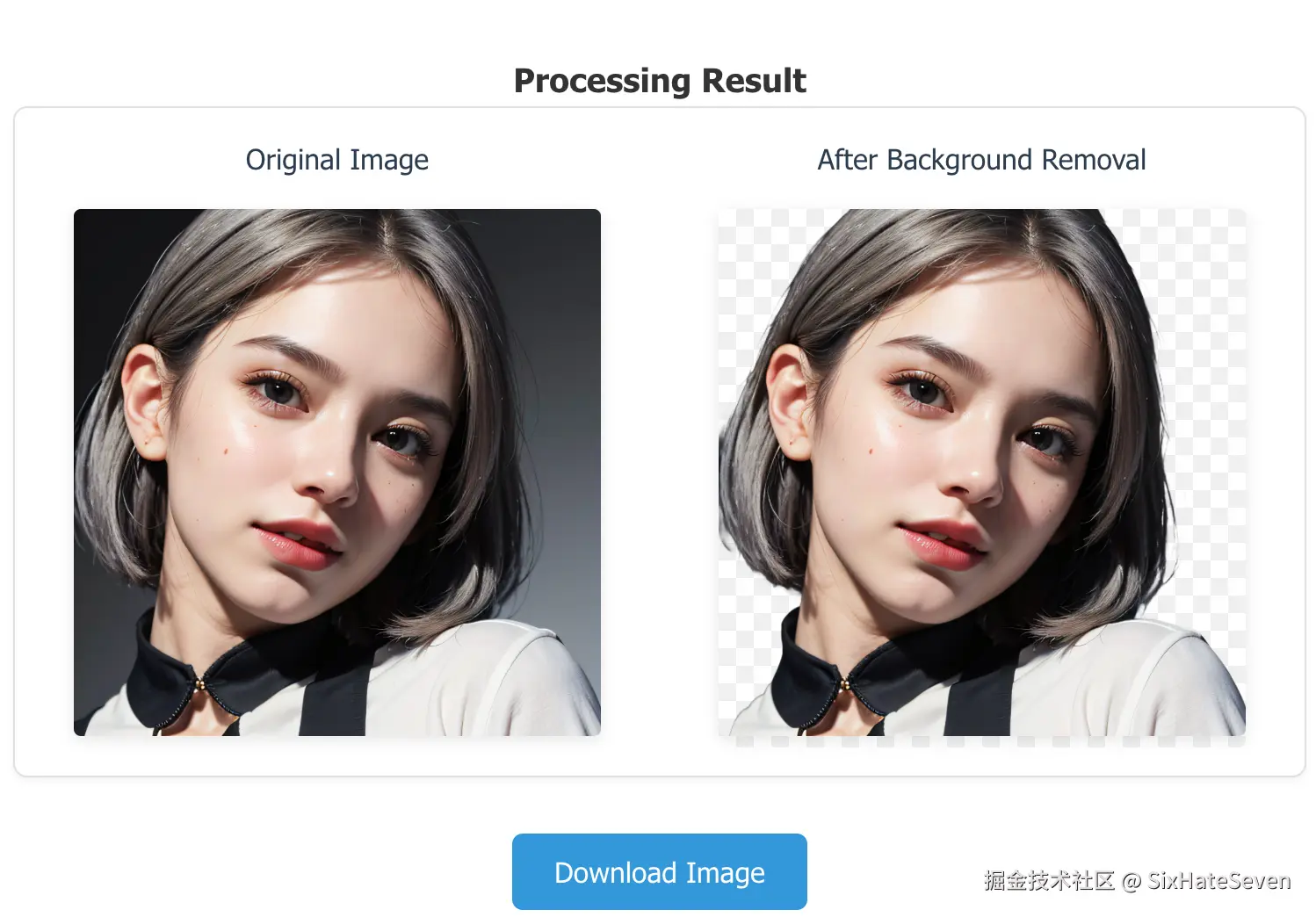

目前实现的是摄像头快照功能:打开摄像头预览,摆好姿势后拍照,然后对拍摄的照片进行背景移除。虽然不是真正的"实时"处理,但胜在操作简单,适合快速抠图需求。效果如下:

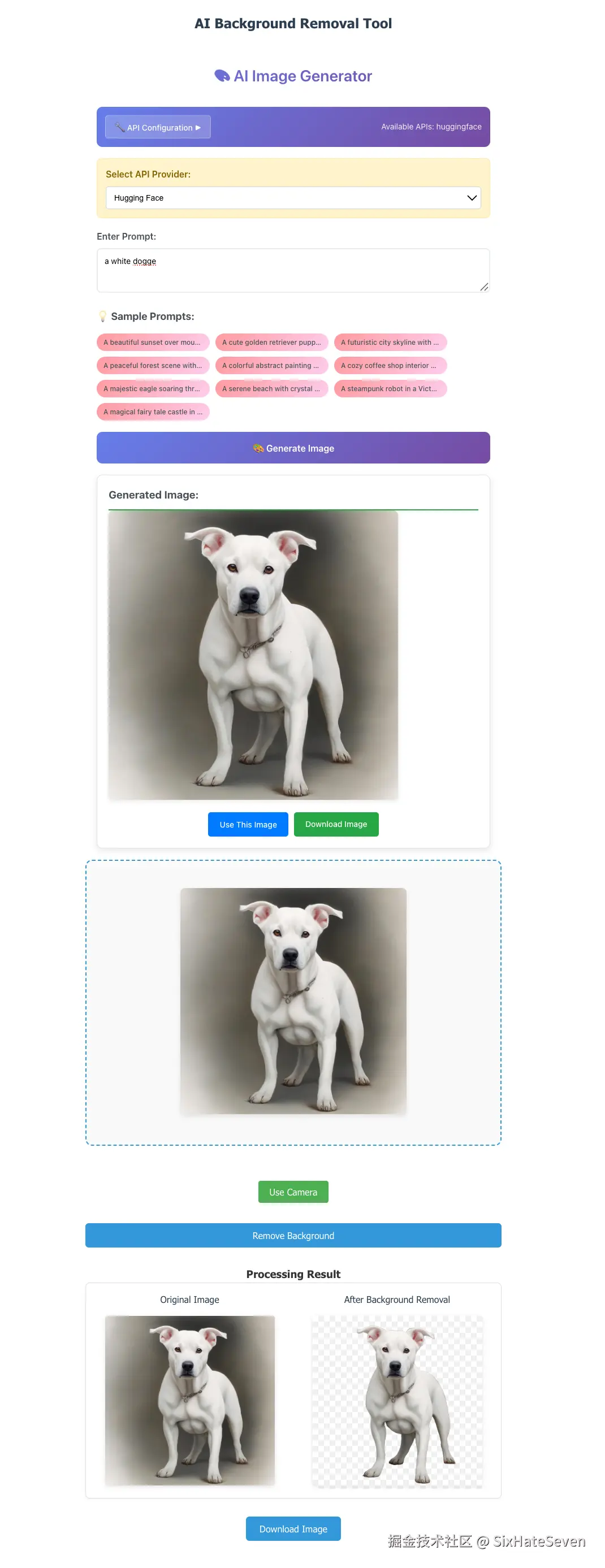

2. AI图像生成集成(开发中)

代码中已初步集成了三种AI图像生成API的接口封装(Hugging Face、Replicate、Stability AI),但目前处于开发测试阶段,尚未完全实现"生成+抠图一条龙"功能。大致效果如下:

没有API Key的用户可以使用本地Canvas生成的简单图形作为演示,这部分主要用于验证界面交互流程。

心路历程:从「我不行」到「关我屁事」

开发这个项目的过程,用四个字总结就是:就那样吧。

刚开始加载模型失败时,我看了眼报错信息,哦,404啊,然后继续摸鱼。反正总会有办法的,大不了换个工具。 预处理图片把人像变成抽象画时,我哦了一声,然后随便改了改参数。抽象就抽象吧,说不定用户就喜欢这种艺术感呢? 优化性能遇到瓶颈时,我想:"算了,就这样吧,反正能用就行。"用户嫌慢?那是他们电脑不行,关我屁事。

每次想放弃的时候,我就点根烟,刷会儿手机。等心情好了,再随便改改。问题解决了?哦,挺好的,不过也没什么值得高兴的。

现在回头看,才发现:所谓开发,就是随便搞搞,能跑就行。我还是那个对AI一窍不通的前端仔,唯一的变化就是------现在对报错信息已经麻木了。

结语:前端的未来

当浏览器能运行越来越复杂的AI模型,当WebGPU释放出惊人算力,前端工程师将不再只是「页面仔」,而是「全栈AI开发者」。

最后,放个项目地址求Star:rmbg-tool (如果觉得好用,记得给设计师小姐姐也安利一下哦~)

PS:如果你也想入门前端AI开发,我的建议是:先跑通一个demo,再慢慢优化。