开源软件中的GenAI自白:开发者如何用、项目如何管、代码质量受何影响?

论文:Self-Admitted GenAI Usage in Open-Source Software

arXiv:2507.10422

Self-Admitted GenAI Usage in Open-Source Software

Tao Xiao, Youmei Fan, Fabio Calefato, Christoph Treude, Raula Gaikovina Kula, Hideaki Hata, Sebastian Baltes

Comments: 17 pages, 8 tables, 1 figures, currently under review

Subjects: Software Engineering (cs.SE)

一段话总结:

该研究以自承认的GenAI使用(开发者在代码注释、提交信息和文档中明确提及使用GenAI工具)为视角,分析了25万+GitHub开源仓库,识别出156个仓库中的1292次相关提及。通过混合方法研究,得出包含32项任务、10种内容类型和11种使用目的的分类体系;分析了13项GenAI使用政策及开发者调查,揭示项目对GenAI的规范;同时发现GenAI采用后代码 churn 未普遍增加,与流行观点相悖。

研究背景:当AI写代码成常态,我们却看不清它的"真面目"

打开GitHub,你可能会看到一段完美运行的代码,但你很难分辨:这是开发者一行行敲出来的,还是ChatGPT、GitHub Copilot"一键生成"的。

近年来,生成式AI(GenAI)工具像一阵旋风席卷了软件开发圈。开发者用它们写代码、查bug、翻文档,甚至自动生成提交信息------但问题来了:这些AI生成的代码和人工代码长得太像,我们根本不知道它在开源项目里到底被用了多少、怎么用的,更说不清它对代码质量是好是坏。

就像我们吃外卖时,想知道食材是否新鲜、烹饪是否卫生,但如果商家不标注"半成品加热"还是"现做",我们永远只能猜。开源项目里的AI代码也是如此:没有明确的"自白",开发者、维护者和使用者都像在"盲盒"里开发。

这篇论文就想解决这个问题:通过开发者主动"承认"使用GenAI的痕迹(比如代码注释里写"这段由ChatGPT生成"),来揭开GenAI在开源世界的真实面貌。

主要作者及单位信息

- Tao Xiao(九州大学,日本)

- Youmei Fan(奈良先端科学技术大学院大学,日本)

- Fabio Calefato(巴里大学,意大利)

- Christoph Treude(新加坡管理大学,新加坡)

- Raula Gaikovina Kula(大阪大学,日本)

- Hideaki Hata(信州大学,日本)

- Sebastian Baltes(拜罗伊特大学,德国,通讯作者)

创新点:从"被动猜测"到"主动承认",换个角度看GenAI

这篇论文最亮的地方,是提出了**"自承认的GenAI使用"**这个概念------简单说,就是开发者在代码注释、提交信息或项目文档里,明确写了"我用了ChatGPT""这段由Copilot生成"。

以前研究GenAI在开发中的使用,要么靠工具厂商的内部数据(普通人拿不到),要么靠猜(因为AI代码和人工代码难区分)。但这次,研究者直接"抓"那些主动"坦白"的案例,相当于让开发者自己告诉我们:"我用了AI,用它做了这些事"。

这种视角的好处是:真实、直接,能绕过"区分AI和人工代码"这个技术难题,直接聚焦开发者的真实行为。

研究方法:从25万+仓库里,"挖"出1292条GenAI的"自白"

研究者的步骤很清晰,像在"筛沙子找金子":

-

选仓库:缩小范围,锁定有价值的样本

从73万多个GitHub仓库里,先挑出用Python、JavaScript等5种热门语言的项目,再排除掉没许可证、没发布过、贡献者太少的"不活跃"仓库,最后留下14785个"正经"开源项目。

-

找"自白":捕捉开发者的明确提及

用脚本搜索这些仓库里的代码注释、文档和提交信息,找包含"ChatGPT""Copilot"的内容。但不是所有提及都算------比如代码里调用ChatGPT的API不算,只有"用它生成了内容"才算。最后手动筛选出1292条"真·自白"(来自156个仓库)。

-

做分析:给"自白"分类,看政策,测代码质量

- 定性分析:给1292条"自白"贴标签,总结出用GenAI做什么任务(比如写代码、翻译)、生成什么内容(比如源文件、文档)、为什么提它(比如承认使用、提醒注意)。

- 政策研究:从"自白"里找出13个项目的GenAI使用规则(比如"禁止用AI""必须说清楚用了AI"),再 survey 开发者了解背后的原因。

- 代码质量分析:用"代码churn"(14天内被修改或回滚的代码比例)当指标,对比项目用GenAI前后的变化,看AI是否让代码更"短命"。

主要贡献:这3个发现,让我们重新认识GenAI在开源中的角色

-

搞懂了开发者用GenAI干些啥

总结出32种任务(最常见的是写代码、翻译文字、重构代码)、10种生成内容(主要是源文件和文档)、11种目的(最多的是"承认用了AI",还有提醒"这段AI生成的可能有问题")。

举个例子:有开发者在注释里写"这段几何变换代码由ChatGPT生成,prompt是......",也有人说"ChatGPT翻译的文档,我英语不好请多包涵"。

-

摸清了开源项目对GenAI的"规矩"

项目态度两极分化:有的完全禁止(比如怕版权纠纷),有的要求必须说清楚用了AI(比如PR里要注明),还有的鼓励用(比如用AI写PR描述)。开发者最担心的是:AI训练数据的版权、生成内容的许可证、敏感信息泄露(比如用AI时不小心把密码传上去了)。

-

推翻了"AI让代码质量下降"的传言

之前有报告说"用了AI后,代码churn上升,质量变差",但这里的研究发现:大部分项目用了AI后,代码churn没涨,甚至降了。只有少数项目有上升,但不是普遍现象------也就是说,AI没那么"坑",关键看怎么用。

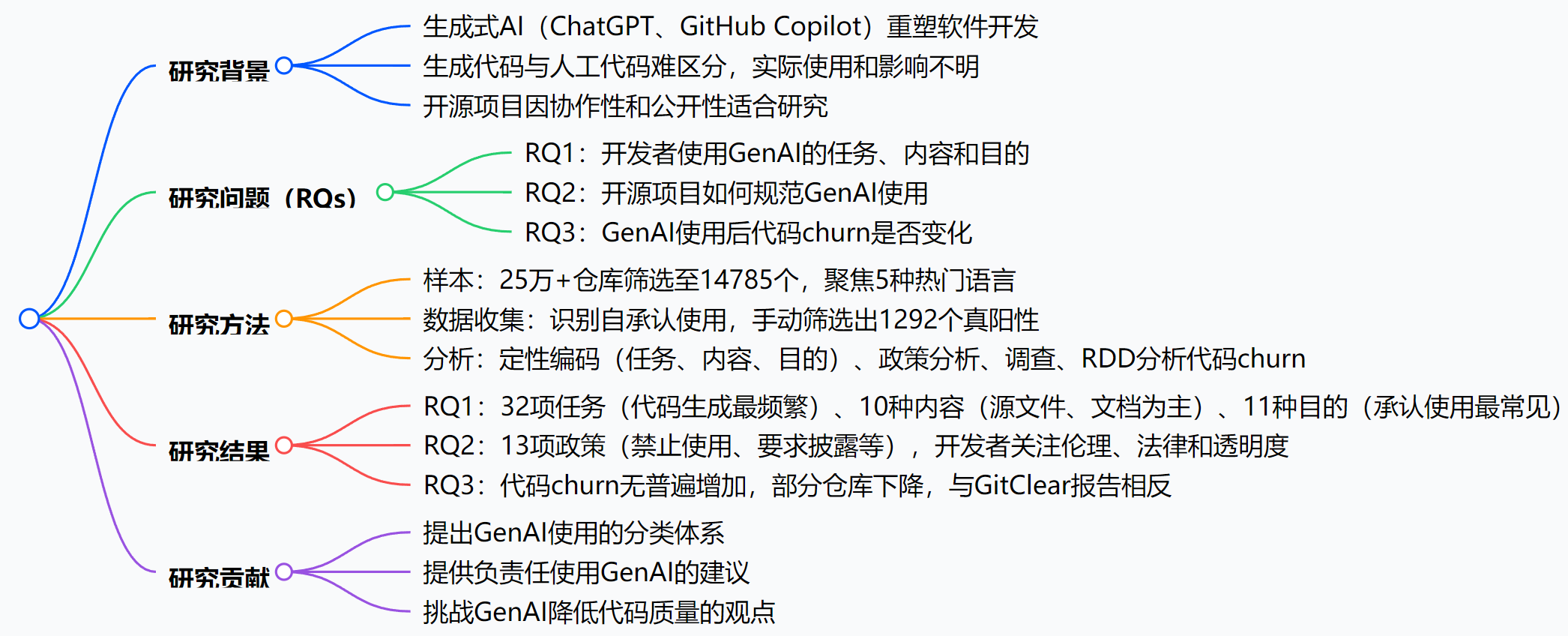

思维导图:

详细总结:

-

引言

- 背景:生成式AI工具(如ChatGPT、GitHub Copilot)改变软件开发,但实际使用模式研究较少,因生成代码与人工代码难区分。

- 核心概念:自承认的GenAI使用(开发者明确提及使用GenAI),类比自承认的技术债务。

- 研究问题:聚焦三个RQ,旨在理解GenAI使用场景、规范及对代码质量的影响。

-

研究方法

- 样本选取:从735,669个仓库筛选,最终保留14,785个,涵盖Python、JavaScript等5种语言,排除非标准许可、无发布等仓库。

- 数据收集:检索ChatGPT和GitHub Copilot的提及,通过Python脚本搜索代码注释、文档、提交信息,手动筛选出1292个真阳性提及(来自156个仓库)。

- 分析方法:定性编码(任务、内容、目的)、政策分析、开发者调查、回归不连续性设计(RDD)分析代码churn。

-

RQ1:GenAI使用的任务、内容和目的

- 任务:32项,主要包括代码生成(105次)、翻译(50次)、代码重构(29次)等,且存在人类后续修正行为(如修复AI生成代码的bug)。

- 内容类型:10种,主要为源文件(176次)、文档文件(106次)、提交信息(1003次,多来自单一仓库)。

- 目的:11种,主要为承认使用(1236次)、质量保证(如请求同行评审)、规范使用等。

-

RQ2:GenAI使用的现有规范

- 政策与指南:13项,分为两类:

- 禁止使用:如jqwik-team/jqwik禁止GenAI生成内容,因版权问题。

- 规范使用:如graycoreio/daffodil要求PR中披露GenAI使用;avaloniaui/avalonia鼓励用GenAI写PR描述。

- 开发者调查:开发者对规范需求存在分歧,部分关注版权、数据隐私,部分担忧限制创新。

- 政策与指南:13项,分为两类:

-

RQ3:GenAI使用对代码churn的影响

- 代码churn定义:14天内被修改或回滚的代码比例。

- 结果:与GitClear报告相反,151个仓库中,整体代码churn平均下降(文件级从0.17→0.06,行级从0.68→0.50),仅少数仓库上升。

- RDD分析:149个仓库中,仅26-30个有显著趋势,无系统性上升。

-

研究贡献

- 提出GenAI使用的分类体系(32任务、10内容、11目的)。

- 基于13项政策和调查,提供负责任使用建议。

- 揭示GenAI对代码churn的多样化影响,挑战质量下降观点。

关键问题:

-

什么是"自承认的GenAI使用"?其在研究中的作用是什么?

答:"自承认的GenAI使用"指开发者在代码注释、提交信息或项目文档中明确提及使用GenAI工具(如ChatGPT、GitHub Copilot)进行内容创作的行为,灵感来自"自承认的技术债务"概念。其作用是作为研究GenAI在开源项目中实际使用的视角,帮助识别GenAI的使用场景、规范及影响,因生成代码与人工代码难以区分,需依赖开发者的明确提及。

-

开源项目对GenAI使用的规范主要有哪些类型?各有什么代表性案例?

答:主要分为两类:

- 禁止使用:如jqwik-team/jqwik在贡献者协议中禁止使用GitHub Copilot等工具,因版权问题;shoelace-style/shoelace禁止AI生成代码,担忧伦理和许可问题。

- 规范使用:如graycoreio/daffodil要求PR中披露GenAI使用;avaloniaui/avalonia鼓励用GenAI翻译PR描述;owasp/wrongsecrets警告GenAI可能导致敏感信息泄露。

-

该研究关于GenAI使用对代码churn的影响与GitClear报告有何不同?原因可能是什么?

答:差异在于:GitClear报告称GenAI采用后代码churn增加,暗示代码质量下降;而该研究发现代码churn无普遍增加,整体平均下降,仅少数仓库上升。原因可能是方法不同:GitClear使用全球截止日期,而该研究以仓库首次自承认GenAI使用为时间点,更精细;且该研究区分了文件级和行级churn,并分析了具体仓库模式。

总结:GenAI在开源里的"自白",告诉我们什么?

这篇论文通过"开发者主动承认用GenAI"的痕迹,第一次清晰地展示了:

- 开发者用GenAI做的最多的是写代码、翻译和重构,而且会主动提醒"这是AI生成的,注意检查";

- 开源项目对GenAI的态度从"完全禁止"到"鼓励使用"都有,核心是怕法律风险和质量问题;

- 说"AI让代码质量下降"太绝对,实际影响五花八门,没有统一的"变坏"趋势。

简单说,GenAI已经成了开源开发的"常规工具",但怎么用好、管好,还需要更多规范------而开发者的"自白",正是透明化的第一步。