引言

7月23日,阿里通义团队推出 Qwen3-Coder 模型,这是 Qwen 系列迄今为止最具 Agent 能力的代码模型。本文介绍如何在阿里云人工智能平台 PAI 的 Model Gallery 中一键部署 Qwen3-Coder 模型,并尝试了在 Qwen Code 工具中,使用部署的模型进行 Agentic 编程任务。

Qwen3-Coder 的上下文长度可以达到1M(Kimi K2只有128K),因为支持上下文更长,所以在 Qwen Code 工具中基本上一条指令可以让模型自己玩到底,不用拆分任务,方便很多。

模型介绍

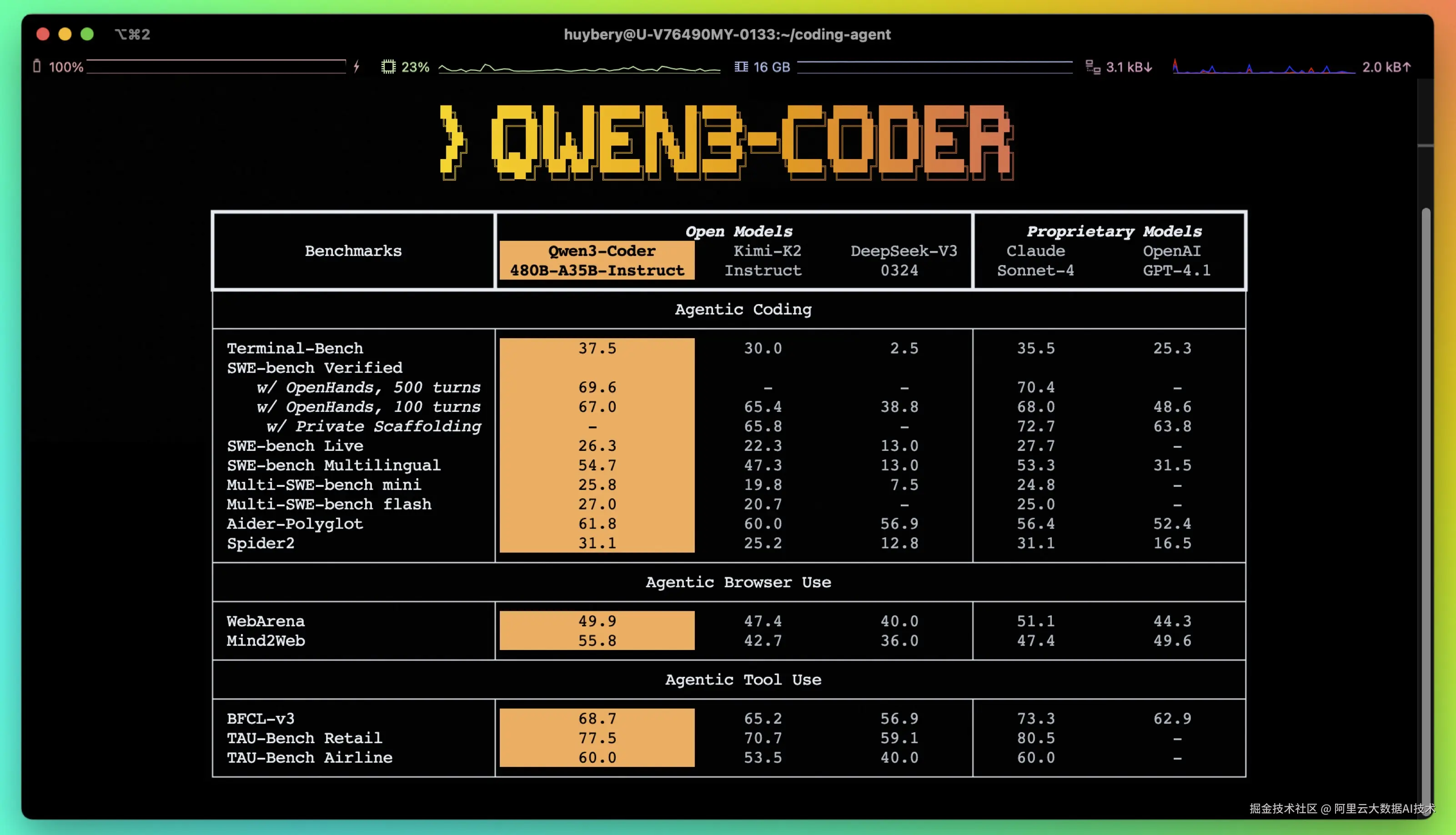

7月23日,通义千问最新的AI编程大模型Qwen3-Coder正式开源。全新的Qwen3-Coder模型拥有卓越的代码和Agent能力,在Agentic Coding、Agentic Browser-Use 和 Foundational Coding Tasks 上均取得了开源模型的 SOTA 效果。

Qwen3-Coder 拥有多个尺寸,其最强大变体:Qwen3-Coder-480B-A35B-Instruct 模型是一个MoE模型,在编程任务上展现出显著的性能,同时具备长上下文能力。

由于 Qwen3-Coder-480B-A35B-Instruct 模型的参数量达 480B,需要至少 16*96G 显存的计算资源进行推理,云端部署成为企业用户和开发者们部署 Qwen3-Coder-480B-A35B-Instruct 时的优先选择。阿里云 PAI-Model Gallery 已同步接入 Qwen3-Coder-480B-A35B-Instruct 模型,提供企业级部署方案。

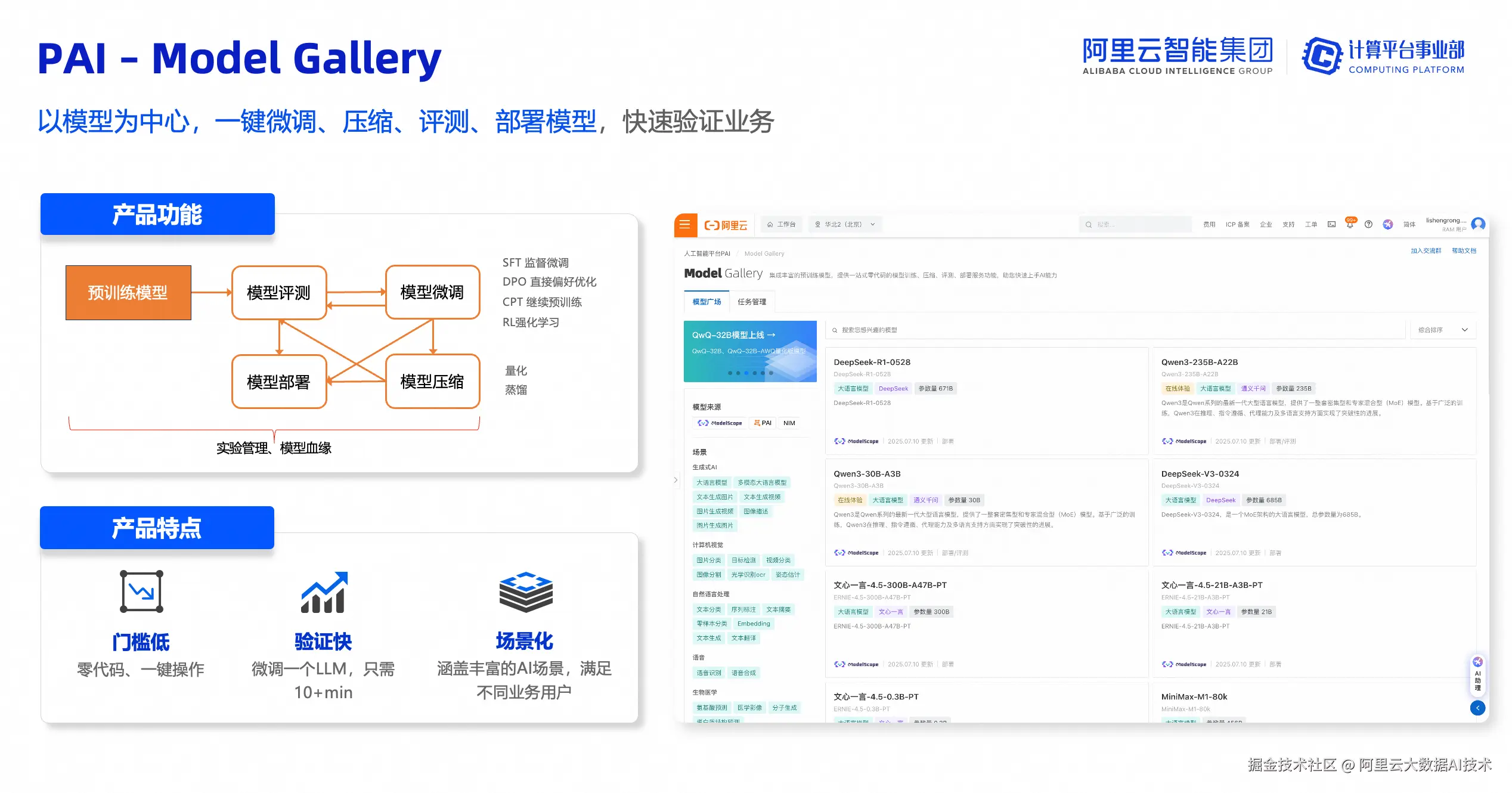

PAI-Model Gallery 简介

PAI-Model Gallery 是阿里云人工智能平台 PAI 的产品组件,它集成了国内外 AI 开源社区中优质的预训练模型,涵盖了 LLM、AIGC、CV、NLP 等各个领域。通过 PAI 对这些模型的适配,用户可以以零代码方式实现从训练到部署再到推理的全过程,简化了模型的开发流程,为开发者和企业用户带来了更快、更高效、更便捷的 AI 开发和应用体验。

PAI-Model Gallery 访问地址:pai.console.aliyun.com/#/quick-sta...

✅ 零代码一键部署

✅ 自动适配云资源

✅ 部署后开箱即用API

✅ 全流程运维托管

✅ 企业级安全 数据不出域

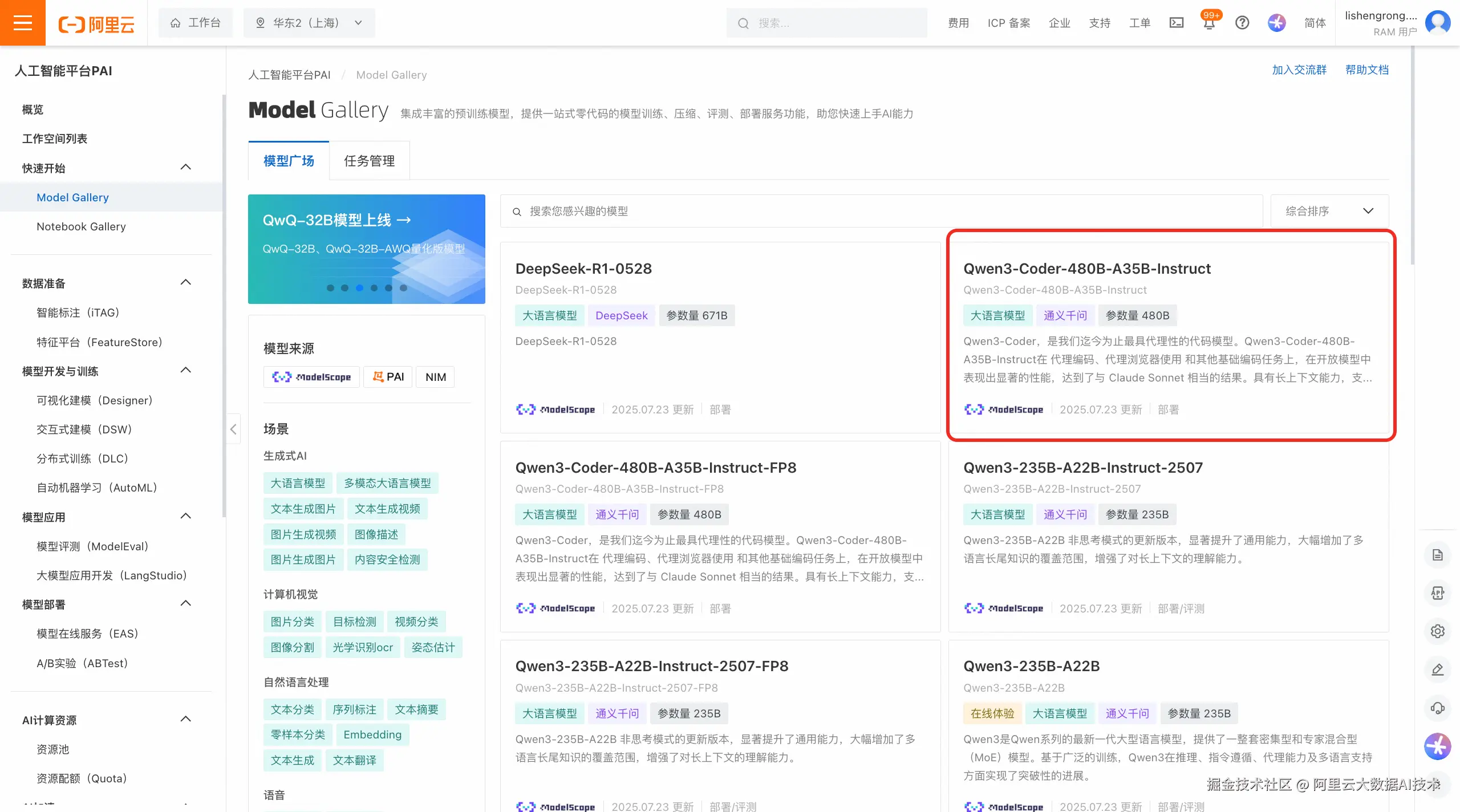

一键部署 Qwen3-Coder 模型

- 在 PAI-Model Gallery 模型广场找到 Qwen3-Coder-480B-A35B-Instruct 模型,或通过链接直达该模型:pai.console.aliyun.com/#/quick-sta...

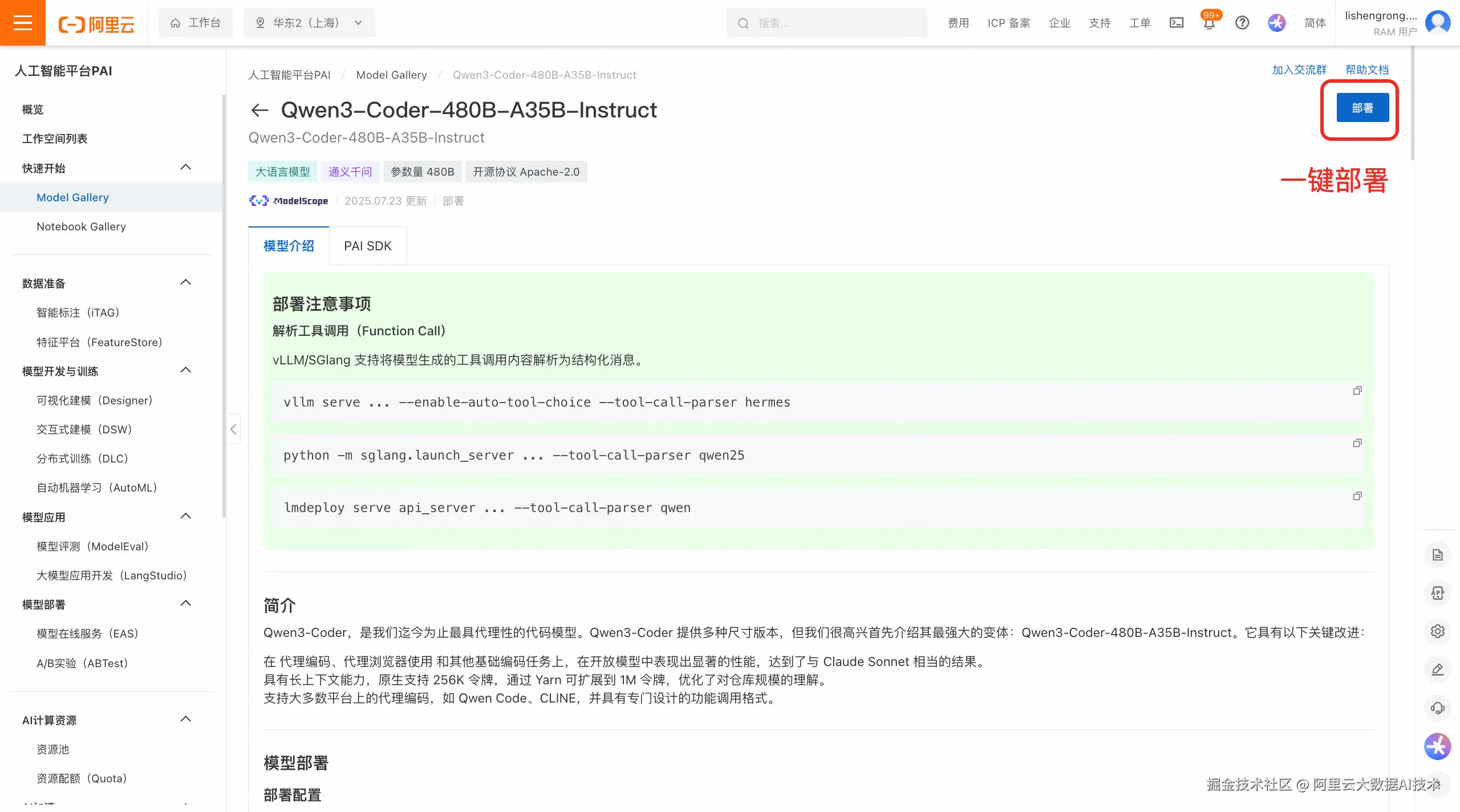

- 在模型详情页右上角点击「部署」,在选择计算资源后,即可一键完成模型的云上部署。

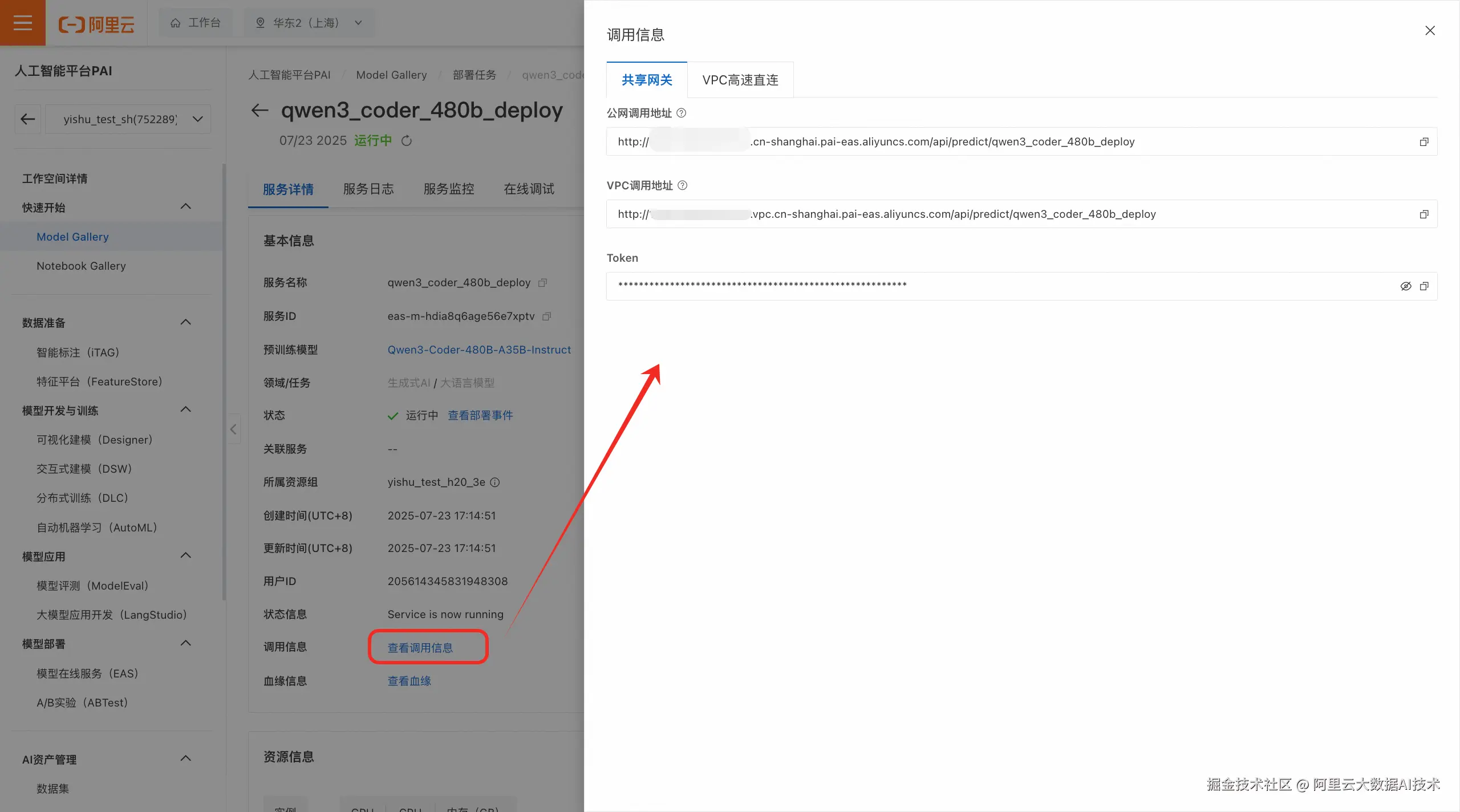

- 部署成功后,在服务页面可以点击"查看调用信息"获取调用的 Endpoint 和 Token,想了解服务调用方式可以点击预训练模型链接,返回模型介绍页查看调用方式说明。

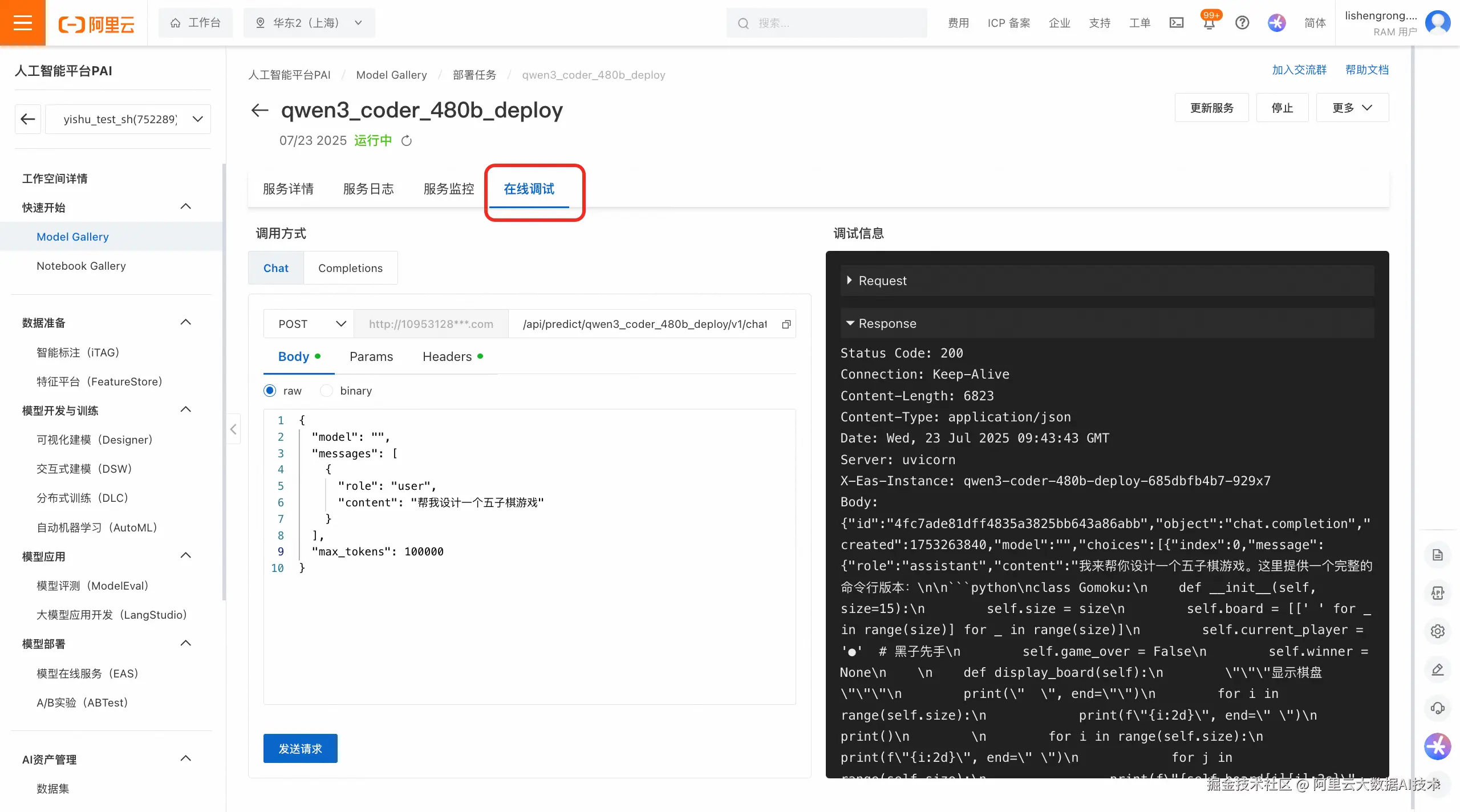

- 使用推理服务:您可以使用 API 调用模型服务,也可以使用 PAI 平台提供的在线调试功能,此外您还可以使用 PAI 平台提供的 WebUI 界面与模型进行交互。

在 Agentic CLI 中使用 Qwen3-Coder 模型

以下的实操以 Qwen Code 工具为例做演示,Claude Code、Cline 等 Agentic CLI 工具也支持。

本次随 Qwen3-Coder 模型一同开源的,还有一款面向 Agentic 编程的命令行工具:Qwen Code。

Qwen Code 是基于 Gemini CLI 分支开发,其功能定位与 Gemini CLI 相同。下面我们看一下如何在 Qwen Code 工具中使用我们在云上独立部署的 Qwen3-Coder 模型。

第一步:安装 Qwen Code

安装方式请参考:github.com/QwenLM/qwen...

第二步:配置云上部署的 Qwen3-Coder 模型服务

在 Qwen Code 项目目录中创建 .qwen/.env 或 .env 文件(建议使用 .qwen/.env 文件,以隔离其他环境变量与其他工具的配置),并设置以下信息。

ini

export OPENAI_API_KEY="your_api_key_here"

export OPENAI_BASE_URL="your_api_base_url_here"

export OPENAI_MODEL="your_api_model_here"`其中:

-

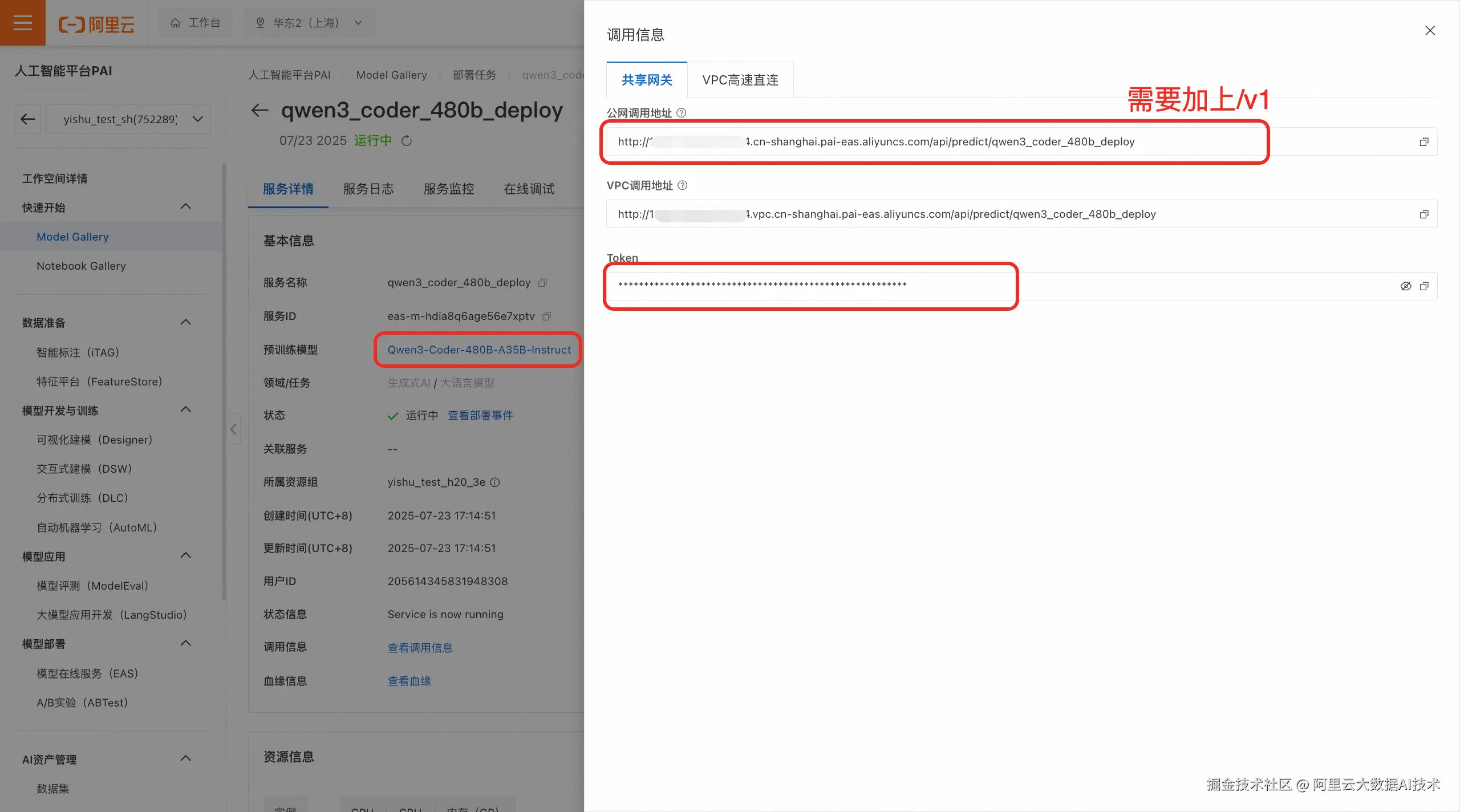

OPENAI_API_KEY:PAI平台模型服务的调用信息中的Token

-

OPENAI_BASE_URL:PAI平台模型服务的调用信息中的公网调用地址,需在后面加上"/v1"

-

OPENAI_MODEL:Qwen3-Coder-480B-A35B-Instruct

第三步:测试一个 Case

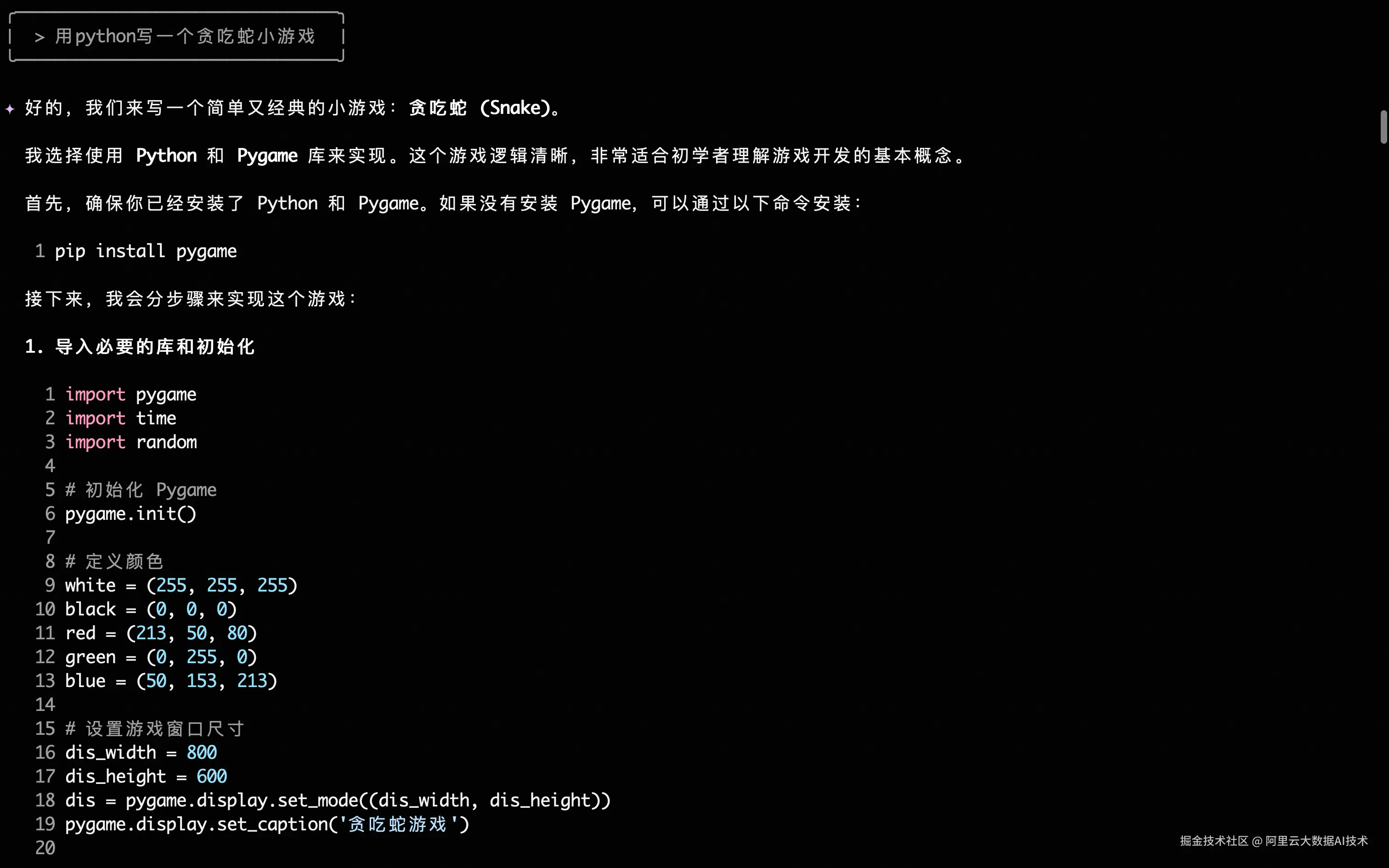

我们让 Qwen Code 写一个贪吃蛇小游戏,调用的模型已经配置成了我们在 PAI 平台上部署的 Qwen3-Coder-480B-A35B-Instruct。

从结果上看,逻辑完全正确!

执行过程中,Qwen3-Coder 的 plan 部分比 Kimi K2 要更详细,Kimi K2 拆分的子 plan 比较粗,Qwen3-Coder 会更细一些。

除了使用 Qwen Code,您也可以在 **Claude Code、Cline **等其他Agentic 编程工具中使用 Qwen3-Coder 模型,配置方式与 Qwen Code 类似,具体请参考各工具文档。

更多模型支持

PAI-Model Gallery 持续提供开源社区热门模型快速部署、训练、评测实践。

-

云上一键部署 Qwen3 全尺寸模型:mp.weixin.qq.com/s/20xc0g-h6...

-

DeepSeek-R1 推理性能优化版:mp.weixin.qq.com/s/yMR4CAfW0... 首token时延直降86%,token间时延直降69%。