当LangChain成为技术债:你的AI架构还撑得过明年吗?

本文较长,建议点赞收藏以免遗失。由于文章篇幅有限,更多涨薪知识点,也可在主页查看。最新AI大模型应用开发学习资料免费领取。飞书右侧蓝色字体「链接」

引言

在过去的18个月里,LangChain无疑成为AI工程领域的耀眼明星------GitHub星标爆炸性增长、开发者峰会座无虚席、各种基于LangChain的创业公司如雨后春笋涌现。作为深度参与AI工程化的实践者,我亲眼见证它如何改变我们构建LLM应用的方式,但也深刻感受到整个行业正在经历一场痛苦的拐点:LangChain正从解决方案本身演变为新问题的来源。

一、LangChain的原始魅力:AI工程的"第一次抽象"

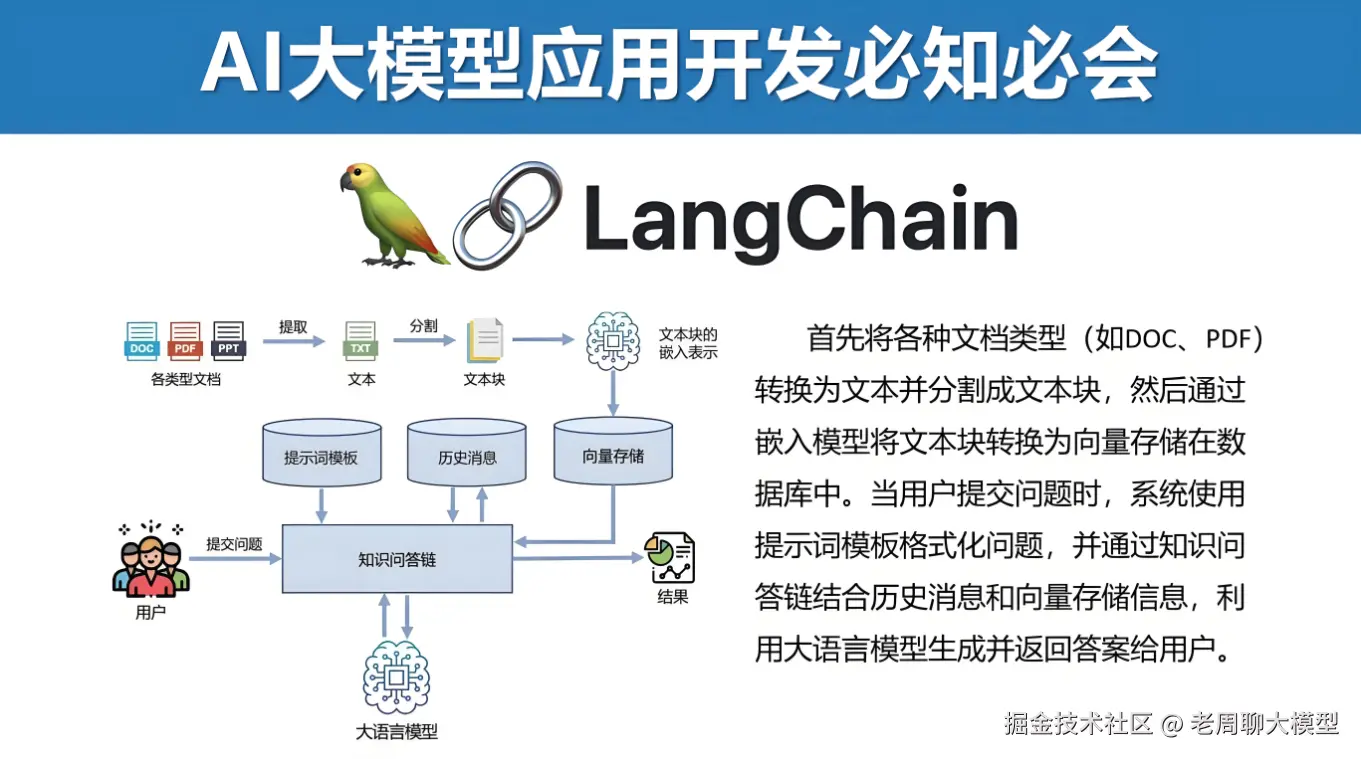

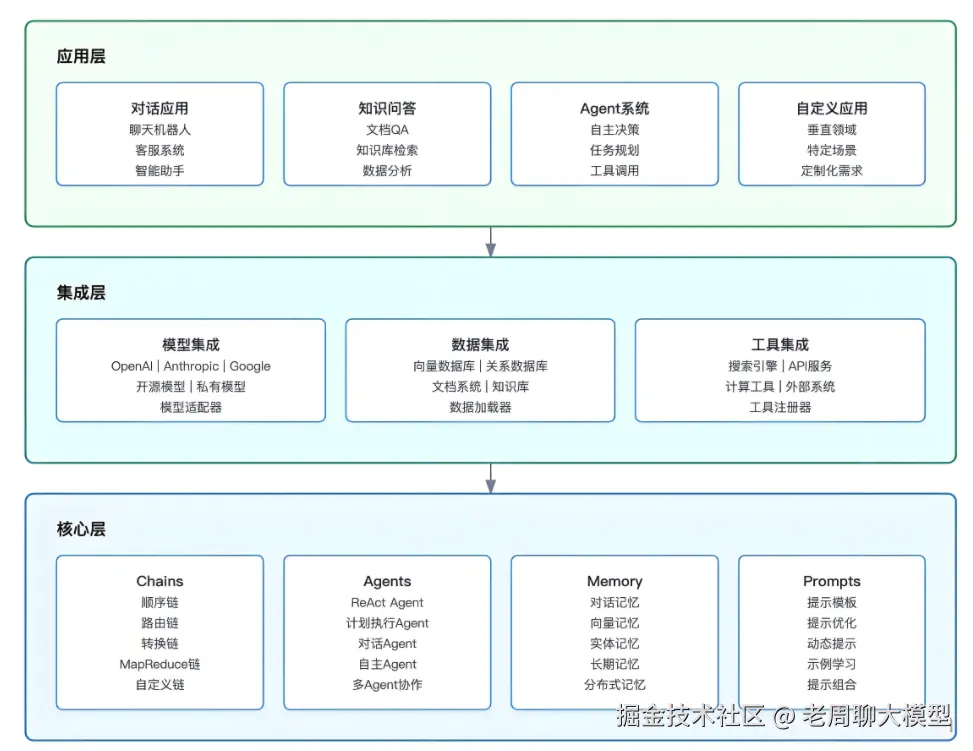

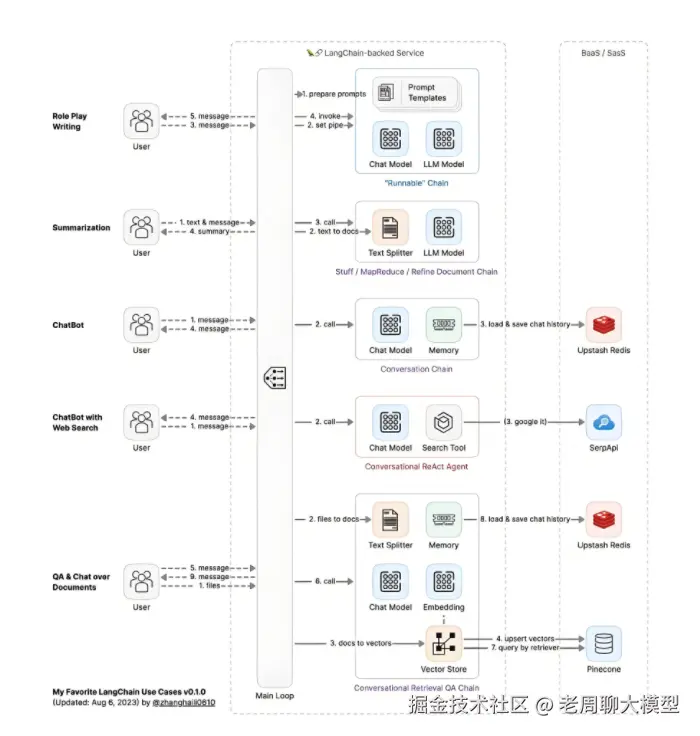

LangChain的核心价值在于解决了LLM应用的三大基础问题:

- 组件化思维:通过Chain、Agent、Memory等抽象概念,将复杂的语言模型交互拆解为可组合单元

ini

# 经典Chain结构示例

from langchain.chains import LLMChain

chain = LLMChain(

llm=ChatOpenAI(temperature=0),

prompt=ChatPromptTemplate.from_template("将{input}翻译成{language}"),

output_parser=StrOutputParser()

)- 基础设施连接器 :提供超过260种官方集成的数据源和工具 3. 向量数据库(Pinecone, Chroma) 4. 文档加载器(PDF, HTML, Markdown) 5. 外部API工具(Wolfram, Wikipedia) 6. 执行流水线:通过SequentialChain, TransformChain等构建复杂工作流

但在实际大型项目中,这些设计开始显露出结构性缺陷。

二、LangChain的技术债:当抽象层成为性能瓶颈

2023年LangChain的Python包月下载量突破2000万次,而同期GitHub仓库的issue数量增长了470%。其中三个致命问题日益凸显:

| 痛点维度 | 具体表现 | 实际案例 |

|---|---|---|

| 抽象泄漏 | 底层API变更导致链条崩溃 | OpenAI API版本升级造成RetrievalQA失效 |

| 嵌套黑洞 | 多层抽象导致的调试灾难 | 4层Chain结构错误定位耗时6人日 |

| 资源消耗 | 过度包装带来的性能损耗 | Agent调用延迟增加300% |

更令人担忧的是,某头部AI公司的工程效能报告显示:

- LangChain应用的平均启动时间达到17.3秒

- 内存占用比裸API实现高出42%

- debug复杂度指数级增长

三、新范式崛起:从重型框架到轻型组配

行业正在发生静默转向,两种创新模式正在重构LLM工程栈:

1. 微核架构(Microkernel Architecture)

python

# 轻量化链式处理示例

def research_agent(question: str) -> str:

search = GoogleSerpAPI()(question)

processed = gpt4(clean_prompt(search))

return process_output(processed)特征:

- 无全局框架依赖

- 纯函数式编排

- 显式状态管理

2. DSPy的革命(华盛顿大学新框架)

ruby

# DSPy的声明式编程

class QA(dspy.Module):

def __init__(self):

self.generate_answer = dspy.Predict("context, question -> answer")

def forward(self, context, question):

return self.generate_answer(context=context, question=question)突破点:

- 参数化提示优化

- 编译时自动调优

- 零抽象泄漏风险

四、新工程原则:LLM时代的生产力密码

基于30+个企业级AI项目的重构经验,我们提炼出四条核心原则:

- 透明性优先

- 禁止超过2层的链式嵌套

- 强制记录每个环节的输入/输出快照

- 无状态设计

python

# 状态显式传递

def process_doc(content: str, metadata: dict) -> ProcessResult:

# 避免隐式Memory依赖

...- 成本感知架构 6. Token消耗实时监控 7. 失败重试熔断机制 8. 热拔插兼容

python

# 可替换LLM实现

def get_llm(model_name: str) -> Callable:

if model_name == "claude3":

return claude3_api

elif model_name == "gpt4-turbo":

return gpt4_turbo五、未来战场:AI工程生态位的重构

随着GPT-5、Claude 3等新一代模型突破百万token上下文,传统链式结构将加速解构:

- 核心理念迁移

- 从"组装链条"到"编排能力"

- 从"流程驱动"到"意图驱动"

- 基础设施变革

- 向量数据库 → 超长上下文管理

- 复杂工具链 → 原生多模态理解

- 开发范型进化

- 提示工程 → 模型自优化

- 人工编排 → 自主智能体

尾声:LangChain后的黎明

LangChain的历史功绩毋庸置疑------它像Spring框架之于Java世界,为混沌初开的LLM开发建立了第一代秩序。但当我们站在2025年回望,它的最大遗产恰恰是教会了我们何时需要打破抽象枷锁。

真正的AI工程高手已不再争论框架优劣,而是深入理解:任何技术范式都只是实现业务价值的临时脚手架。那些正在默默采用轻量级组合、声明式编程和显式状态管理的团队,正以数倍效能构建着下一代智能应用。