在人工智能加速渗透各行各业的今天,传统"静态处理、离线识别"的模式已无法满足对实时感知与智能响应的需求。新一代 AI 系统正向"感知-决策-控制"一体化闭环演进,尤其在以下关键场景中表现尤为突出:

-

安防监控:需实现秒级乃至毫秒级的入侵检测与预警;

-

工业质检:需对高速产线上的缺陷、异常进行实时识别;

-

交通治理:需对车辆违停、逆行、拥堵等行为即时感知;

-

智慧农业:需实时识别作物状态、病虫害变化等动态要素;

-

无人巡检:需在复杂环境中完成目标识别与智能决策。

上述场景的共性需求是:如何将多源高清视频流,快速、稳定地输入 AI 模型,并驱动后续动作执行或结果推送。

而现实挑战也非常严峻:网络抖动、终端异构、传输延迟高、数据格式不统一、AI模型调用流程繁复......这些因素极大限制了系统的响应速度和部署效率。

为解决这些痛点,将专业级实时视频传输能力与高性能目标检测模型深度融合成为关键突破方向。

本文将以大牛直播SDK × YOLO(You Only Look Once)算法的融合方案为核心,系统讲解如何构建一套:

-

✅ 端到端低延迟

-

✅ 多实例高并发处理

-

✅ 跨平台通用部署(支持 Android/iOS/Windows/Linux)

-

✅ 支持裸码流/YUV/RGB等多格式数据回调的 AI 视频感知系统

使每一帧视频都具备"被分析"的能力,让视觉真正成为 AI 系统的"第一输入口",从而推动 AI 感知系统走向更强的实用性与实时性,开启 AI 感知协调的新纪元。

一、🎯 传统视频与AI结合的关键瓶颈

尽管"视频 + AI识别"已经广泛应用于安防、工业、交通等领域,但在实际工程落地过程中,仍面临一系列制约性能与效率的结构性问题。尤其在对实时性、稳定性、可扩展性提出更高要求的应用场景中,传统做法暴露出明显短板:

🕒 1. 高延迟链路,无法满足实时响应

-

视频通常先通过播放器或采集卡展示,再经过转码处理或保存为文件,最后输入 AI 模型;

-

整个链路延迟高达数秒,严重影响对突发事件或动态目标的快速识别与处置;

-

结果导致"看到很快、识别很慢",感知闭环无法形成。

🔗 2. 数据链路割裂,格式不统一

-

视频源设备繁多,输出格式五花八门(H.264/H.265、RTSP、RTMP、本地MP4等);

-

多数AI模型仅支持图片/YUV/RGB格式输入,需开发者手动完成繁琐的解码与转帧流程;

-

视频与算法之间缺乏高效、稳定的"桥梁"。

🧩 3. 接入复杂,难以跨平台部署

-

不同平台(如 Android、Linux、Windows)对视频解码、渲染接口不统一;

-

AI 识别模块的部署与视频处理流程高度耦合,移植成本高;

-

系统集成难度大,阻碍智能识别在边缘设备或轻量终端的普及。

📉 4. 并发能力弱,难以支撑多路视频同时分析

-

在需要对多通道视频进行同步分析(如多个摄像头、多个工位等)时,传统方案资源开销大、性能瓶颈明显;

-

缺乏统一的资源管理与实例控制,容易出现卡顿、掉帧、崩溃等问题。

❗总结:

传统的视频处理方案往往是为"人看"而设计,而非为"AI识别"而优化。缺乏面向AI的实时性、可调用性与数据适配能力,导致"视频+AI"的结合效果大打折扣,难以支撑真正的智能系统闭环运行。

为此,需要一个具备稳定解码、灵活回调、低延迟传输、多平台兼容 等特性的"视频智能入口层",而这正是大牛直播SDK × YOLO结合方案的切入点与价值所在。

二、🤝 YOLO × 大牛直播SDK:重塑感知链路的黄金组合

在构建实时智能系统的过程中,**"视频感知入口层"+"AI识别引擎"**的高效协同,是整个系统能否具备快速响应与决策能力的关键。而将这两者深度融合,必须具备两个核心能力:

-

📡 一个具备高并发、低延迟、强适配性的视频输入通道;

-

🧠 一个能高效处理图像并输出语义结果的智能分析模块。

🧠 YOLO:实时视觉识别的核心引擎

YOLO(You Only Look Once)作为当前主流的目标检测算法之一,具备以下显著优势:

-

🔄 端到端检测:输入图像即可输出物体位置与类别,无需分阶段处理;

-

⚡ 毫秒级推理速度:适用于移动设备、边缘设备等算力受限场景;

-

🧩 模型轻量可部署:可通过 TensorRT、ONNX、NCNN 等优化方式部署于多平台;

-

🌍 场景适应性强:广泛用于人脸识别、口罩检测、工业瑕疵识别、交通目标分析等任务。

🎥 大牛直播SDK:为 AI 准备的视频输入层

而大牛直播SDK正好填补了从"视频源"到"AI入口"的关键链路空白,提供以下能力:

-

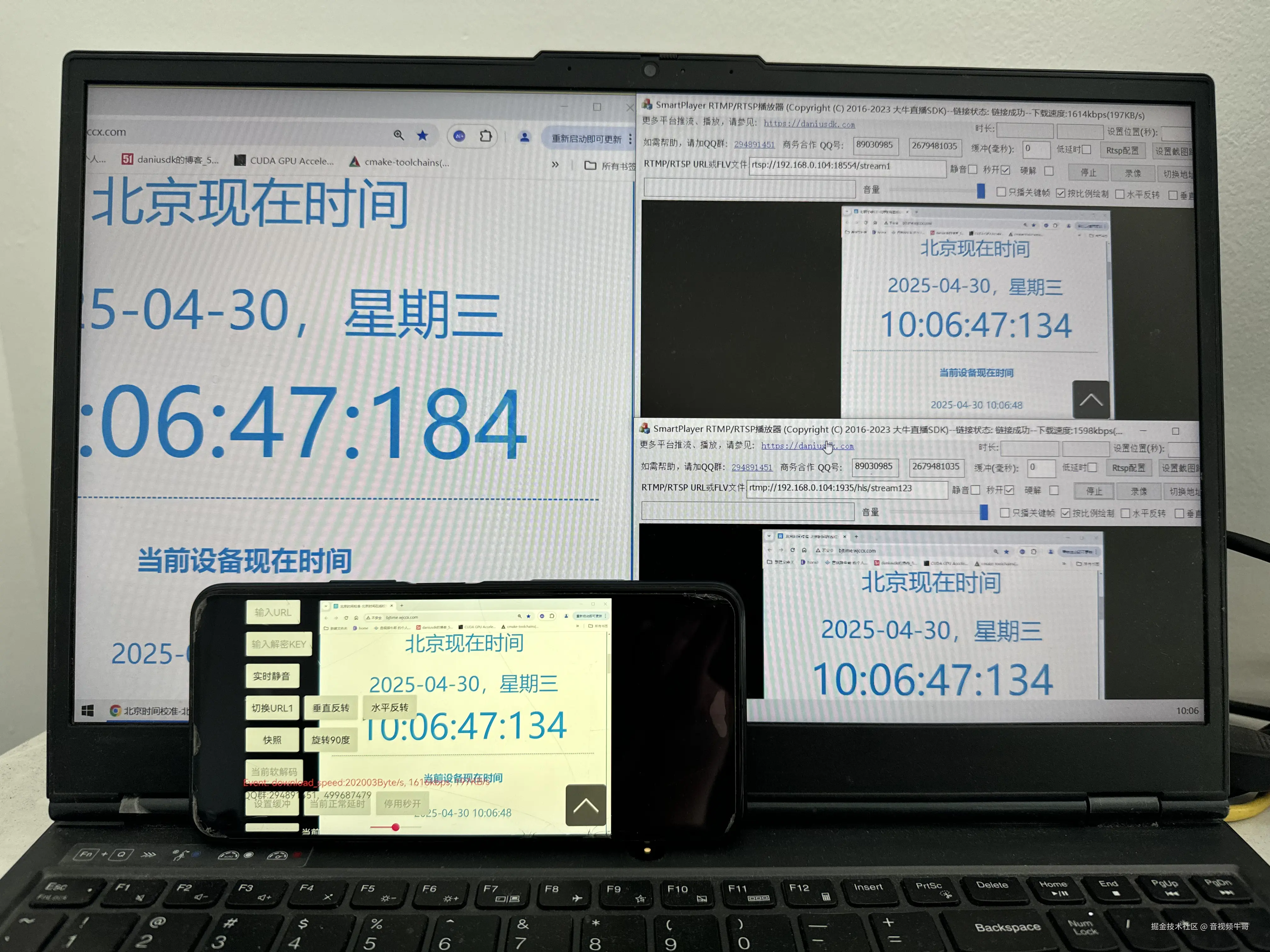

✅ 超低延迟解码传输:端到端延迟控制在 100~250ms,保障及时识别;

-

✅ 多格式数据回调支持:直接输出 YUV、RGB、裸码流等 AI 模型友好的图像数据;

-

✅ 多协议支持:兼容 RTSP / RTMP / HTTP-FLV多种视频输入方式;

-

✅ 多平台高适配性:支持 Android / iOS / Windows / Linux / Unity3D / Python 等环境;

-

✅ 多实例并发播放:轻松管理多通道视频流,适配大型监控与工业集成场景;

-

✅ 轻量化部署架构:支持边缘计算节点、本地终端一键集成,助力智能前移。

🧩 理想组合:形成高效稳定的"感知第一入口层"

通过大牛直播SDK对视频流进行稳定采集、快速解码与图像回调,结合 YOLO 在图像域的实时目标检测能力,可构建一套闭环快速、模块解耦、弹性部署的智能感知系统。

这不仅解决了传统方案中"播放系统为人服务、AI系统难接入"的割裂问题,更真正让视频成为 AI 系统的实时神经输入通道,实现毫秒级响应能力与工程级可扩展性。

三、🧩 构建闭环智能的系统架构与应用链路

将大牛直播SDK与 YOLO 深度融合,不仅是算法能力与传输通道的简单拼接,更是一次针对**"视觉输入 → 实时分析 → 事件响应"的系统级优化。一个稳定可落地的 AI 感知架构,必须兼顾性能、灵活性、易用性与扩展性**。

以下是典型的系统架构图与应用链路:

📊 系统架构图:

markdown

┌──────────────┐

│ 视频采集端 │ ← 摄像头 / 工业相机 / 移动设备

└────┬─────────┘

│ 多协议推流 (RTSP / RTMP / 本地)

▼

┌──────────────┐

│ 大牛直播SDK模块 │ --- 解码、格式转换、YUV/RGB帧回调

└────┬─────────┘

│

▼

┌──────────────┐

│ YOLO识别模块 │ --- 实时目标检测 / 行为识别 / 区域判断

└────┬─────────┘

│

▼

┌──────────────┐

│ 联动执行模块 │ --- 可视化标注 / 告警输出 / 控制信号

└──────────────┘🚀 应用链路示例:工业安防场景(越线检测)

目标: 实时监测人员是否进入高危作业区,联动声光报警器或云平台告警。

✅ 工作流程:

-

视频采集:部署 RTSP 摄像头实时推送画面;

-

视频解码:大牛直播SDK接收流并快速解码,输出连续帧(YUV/RGB);

-

目标检测:YOLO 模型实时识别"人"目标,输出边框与置信度;

-

规则判断:判断目标是否进入预设禁入区域;

-

结果联动:若越界,自动触发本地报警或通过 MQTT/HTTP 上报云端平台;

-

视频留证:并行录像/截图,由大牛SDK本地保存或推送。

🌐 典型拓展场景

应用场景

视频来源

AI任务

联动动作

智能交通

路口摄像头

车辆识别、逆行检测

抓拍、上云、计数分析

工业检测

产线摄像头

产品缺陷识别

触发剔除 / 停机

智慧校园

校园监控

校园闯入/聚集检测

安保联动 / 云端记录

智慧农业

农田监控

动物入侵识别

播放驱逐声波或记录

无人巡检

移动终端(机器人/无人机)

安全帽识别、跌倒检测

实时语音提示或后台告警

🎯 小结:

通过将大牛直播SDK打造成 AI 的"视频入口引擎",并以 YOLO 为核心识别模型,整个系统实现了从视觉采集 → 实时分析 → 智能联动的完整闭环,具备高效性、稳定性与工程落地能力。

✅ 视频接得进、数据拉得出、模型跑得快、事件能响应。

这正是"视频 × AI"迈入实战部署阶段所需要的关键组合能力。

四、📦 模块能力矩阵:打造标准化的视频AI感知底座

为了实现高可用、易接入、可拓展的 AI 感知系统,系统各模块需要明确职责划分与功能对接。下表为YOLO × 大牛直播SDK架构中各核心模块的能力矩阵:

模块名称

核心功能

技术亮点

对接方式

🎥 视频采集模块

摄像头/无人机/工控终端实时采集

支持轻量级RTSP、RTMP推流、本地录像

通过地址拉流或本地输入

🚀 大牛直播SDK

解码、格式转换、数据帧回调

超低延迟、稳定高并发、支持 YUV/RGB/raw

提供 API/SDK 接口(C++ / Java / Python)

🧠 YOLO推理模块

图像实时识别、目标检测

多模型版本(YOLOv5/v8/Nano),可裁剪加速

通过内存图像帧输入,Tensor/CUDA/NCNN/ONNX等

📡 联动输出模块

告警推送、事件回传、控制执行

MQTT/HTTP 回调、事件入库、联动设备响应

自定义接口适配、支持边缘或云联动

💾 存储/展示模块

视频录像、抓图存证、识别结果展示

支持本地或云端存储、多端可视化输出

可集成录像系统/前端Web可视化组件

✅ 说明:以上各模块可按需灵活组合,支持"端到端部署"、"边缘轻量部署"、"中心化接入识别"等多种模式。

五、🧪 实战落地建议:从Demo到大规模部署的关键路径

1️⃣ 明确业务场景与识别目标

-

是做越界识别 、行为分析 、缺陷检测 还是通用目标检测?

-

对识别帧率、准确率的需求是否在秒级 / 毫秒级?

-

明确场景复杂度,有助于模型选择和设备布控。

2️⃣ 从单路视频识别开始验证闭环链路

-

使用本地MP4文件或 RTSP 摄像头模拟实际采集端;

-

基于大牛直播SDK + YOLO 快速构建单路数据处理链路;

-

验证图像回调 → 推理 → 响应时间是否满足需求;

-

并行测试抓图/录像/告警等辅助功能。

3️⃣ 启用多实例、并发通路的性能压测

-

使用直播SDK的"多路播放器实例"能力测试并发上限;

-

结合线程池/Yolo轻量模型部署,实现多路流识别调度;

-

建议将 YOLO 模型与播放器线程逻辑解耦,避免卡顿。

4️⃣ 部署环境优化与模型加速

-

边缘部署场景建议使用 Jetson Nano、X86嵌入式设备;

-

配合 TensorRT / ONNX Runtime / NCNN 实现推理加速;

-

视频SDK侧推荐开启硬件解码(如 MediaCodec、FFmpeg hwaccel)。

5️⃣ 联动模块建议模块化封装

-

将"识别 → 告警 → 控制"逻辑通过事件驱动模型封装;

-

告警输出可选择 MQTT(边缘总线)或 HTTP(云接口);

-

预留"标注数据存证"通路,便于系统回溯与训练集扩充。

✅ 工程经验总结:

关键环节

建议做法

视频解码

使用大牛直播SDK替代传统播放器或OpenCV,性能更稳、接口更适合AI

数据对接

使用 YUV/RGB 图像帧格式,避免文件中转,节省延迟

模型选择

YOLOv5-Nano/V8-fast 在边缘场景更实用;YOLOv8 + TensorRT 适合高性能场景

系统调度

解码与推理线程独立,推理建议用队列调度缓冲图像帧

平台选型

多路识别建议使用支持 CUDA / Vulkan / NPU 的边缘AI设备

六、🔚 总结与展望:让视觉成为 AI 协调体系的神经起点

随着人工智能系统对"时效性、感知力、协同效率"提出更高要求,视觉系统的实时性与可调度性正逐渐取代传统"离线图像处理"范式,成为支撑智慧化应用落地的关键。

通过本篇文章所述的实践探索,我们可以清晰看到:

-

📥 大牛直播SDK 作为 AI 感知系统的视频输入层,不仅具备高并发、低延迟、跨平台的技术优势,还以其稳定的数据帧回调机制打通了"视频→算法"的关键接口;

-

🧠 YOLO 系列模型则以优秀的推理速度与识别准确率,为目标检测、事件识别等任务提供了轻量、灵活、实用的算法核心;

-

🤝 两者结合,形成一套结构清晰、部署弹性强、落地速度快的智能视觉系统方案,适用于从 Demo 到行业级部署的全流程。

🚀 面向未来,YOLO × 大牛直播SDK 有望支撑更多智能系统:

发展趋势

结合价值

边缘智能普及化

支持在低功耗终端部署识别模型 + SDK,降低运维与布控成本

多模态感知系统融合

视频识别可作为视觉主干,联动音频、雷达、Lidar等信息通道

实时决策闭环构建

支撑从"发现问题"到"发出控制"之间的毫秒级响应

场景定制化需求增强

结合私有部署、模型定制、联动控制系统构建高度适配方案

AI能力下沉到每一个摄像头

每一路摄像头视频不仅"可看",更要"可识别"、"可反馈"

✅ 小结:

感知,不止于"看见";

智能,始于"理解";

协调,成于"响应"。

YOLO × 大牛直播SDK 不仅是一次技术集成,更是一次工程理念的跃迁------

让每一帧视频,不再只是图像,而是 AI 系统的"实时神经输入";

让视觉能力,从感知延伸到决策,为智能化体系注入敏捷响应力。

这,正是视频智能感知进入"新纪元"的关键起点。