2025年8月5日 ,OpenAI 正式推出 GPT-OSS-120B 和 GPT-OSS-20B 两个开源大模型,采用 Apache 2.0 许可协议 ,并公开了模型参数。这意味着开发人员、研究人员和企业可以直接使用这些模型进行定制训练、本地部署和扩展,无需依赖传统的API调用。

那么,这两个模型有什么特别之处?它们的运行原理是什么?与 GPT-4o 或 o4-mini 等闭源大模型相比表现如何?如何上手使用它们?本文将从模型架构、性能测试等多个角度进行详细解读。

什么是 GPT-OSS?

GPT-OSS(生成式预训练Transformer开源版)是 OpenAI 在2025年8月5日基于 Apache 2.0 协议开源的一系列大语言模型。在 GPT-2 等早期开源模型之后,这是 OpenAI 再次回归开源策略,目的是让开发者、科研机构、企业和政府部门都能够更方便地使用高性能AI技术。

这些模型支持本地运行,降低了对云端服务的依赖,有利于保护数据隐私,并能满足低延迟需求。它们适用于语言理解与生成、工具调用等任务,在个人电脑和企业服务器上都能高效运行。

目前发布的GPT-OSS系列包含两大模型:

- gpt-oss-120b:1170亿参数版本,适用于高性能计算需求

- gpt-oss-20b:210亿参数版本,适合计算资源有限的环境

用户可以在 Hugging Face 平台免费获取这两个模型,OpenAI 还提供了详细的使用手册 和部署指南,帮助开发者快速上手。

模型架构和规格

OpenAI 公布了这两个模型的具体技术配置:

gpt-oss-120b (1170亿参数版)

- 参数总量:1170 亿

- 活跃参数(动态激活) :每个token的处理中,实际参与计算的参数为 51 亿

- 架构 :基于 混合专家模型(MoE) ,共 36 层 ,包含 128 个专家模块 ,每个 token 会选择 4 个专家 进行计算

- 显存需求 :可在单个 80GB 显存的 GPU(如 NVIDIA H100) 上运行

- 上下文长度 :支持 13.1 万 token,适用于长文本理解和复杂任务

- 模型文件大小 :60.8 GiB(采用 MXFP4 量化压缩,每个参数平均占据 4.25 比特)

gpt-oss-20b (210亿参数版)

- 参数总量:210 亿

- 活跃参数:每个 token 的处理中,36 亿参数参与计算

- 架构 :MoE 结构,共 24 层 ,包含 32 个专家 ,每个 token 同样选择 4 个专家

- 显存需求 :可在 16GB 显存 的消费级设备或边缘计算设备上运行

- 上下文长度 :同样支持 13.1 万 token

- 模型文件大小:12.8 GiB(同样采用 MXFP4 量化格式)

通用技术特点

- 注意力机制 :采用 分组多查询注意力(组大小=8) ,提高并行计算效率

- 位置编码 :使用 旋转位置嵌入(RoPE) ,增强长文本理解能力

- 分词器 :使用了 o200k_harmony 词表(共 201,088 个 token) ,并已通过 TikToken 开源库 提供

- 基础架构 :基于 GPT-2 / GPT-3 的 Transformer 结构 ,但进行了优化,包括 2880 维的残差连接 和 RMS 归一化,确保训练稳定性

运行效率优化

-

混合专家模型(MoE) + MXFP4 量化 显著降低了计算需求:

- gpt-oss-120b 能在单个高性能 GPU 上运行,性能接近比它更大的闭源模型

- gpt-oss-20b 则针对 笔记本电脑、边缘服务器 等低功耗设备优化,能在常规硬件上流畅推理

训练与数据

OpenAI 用海量数据训练 GPT-OSS 模型,主要使用英语内容,并特别加强 STEM(科学、技术、工程、数学)、编程和常识类数据。训练数据的最新截止日期为2024 年 6 月,确保其知识既广泛又相对较新。以下是关键训练细节:

预训练

-

硬件 :采用 NVIDIA H100 GPU 集群进行训练

-

计算量:

- gpt-oss-120b(1170亿参数) 消耗约 210 万 H100 小时

- gpt-oss-20b(210亿参数) 资源消耗较少,具体数据未披露

-

数据筛选 :过滤有害信息,如化学、生物、放射性和核武(CBRN)相关内容,减少滥用风险

-

训练优化:

- 监督微调(SFT) 提升基本能力

- 强化学习(RLHF) 提高安全性与合规性

对话与推理格式

模型采用Harmony(和谐)聊天格式,支持多角色交互(系统、开发者、用户、助手、工具等),适用于:

- 复杂推理任务

- 多步骤工具调用(代码执行、插件调用等)

格式渲染器已开源(GitHub链接),允许通过系统提示词调整推理强度(低/中/高模式),灵活适配不同需求。

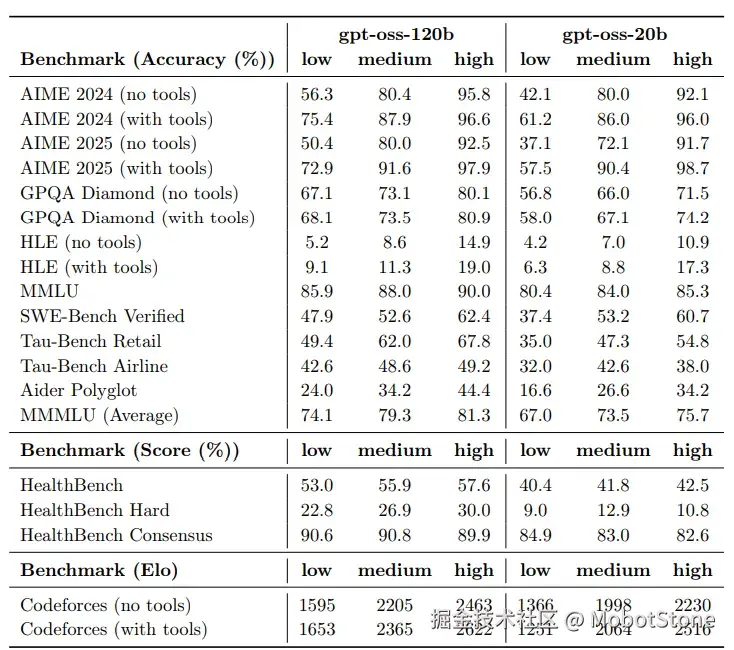

性能与基准测试

GPT-OSS 系列在多项测试中表现优异,其能力与 OpenAI 的闭源模型(如 o4-mini、o3-mini)相当。以下是官方评测的关键结果:

主要观察结论

gpt-oss-120b(1170 亿参数版)

- 推理与专业知识 :在 GPQA Diamond (高阶推理基准)和 MMLU (综合知识测试)中,表现与闭源模型 o4-mini 相当

- 数学与编程 :在 AIME 竞赛数学 、SWE-Bench (软件工程任务)、Codeforces 编程题 等测试中表现突出

- 可调节推理 :支持 思维链(CoT) 延长输出,进一步提高准确性(但会增加响应时间)

gpt-oss-20b(210 亿参数版)

- 轻量级高性能 :虽然体积更小,但性能接近 o3-mini,尤其在数学和编程任务上优势明显

- 适用场景 :优化后可在 普通笔记本电脑、边缘设备 等资源受限环境中流畅运行

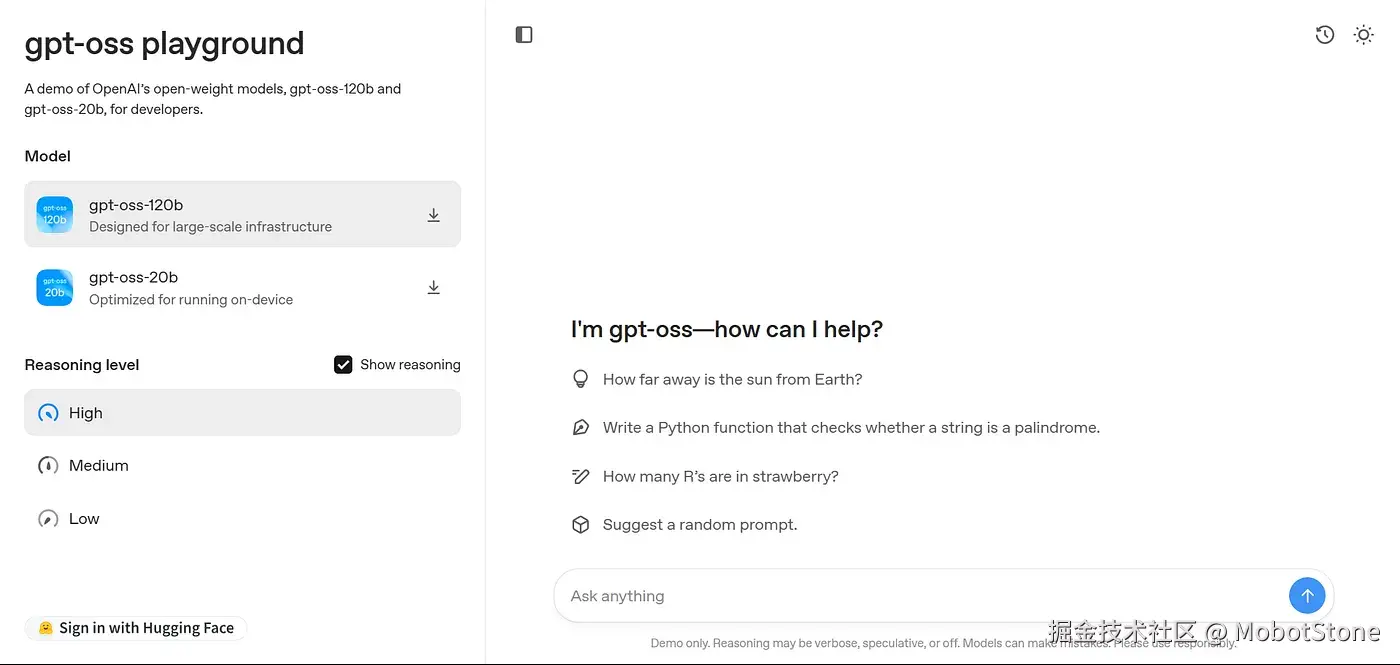

部署与获取方式

GPT-OSS 的设计目标是让开发者 低成本、高效部署 ,并支持 本地&云端多平台运行:

开放获取途径

- Hugging Face :免费提供 MXFP4 量化版 模型权重(节省显存&存储)

- 测试环境 :官方提供 gpt-oss.com 在线体验

- 本地工具链 :兼容 Ollama、vLLM、LM Studio 等主流部署工具

- 硬件适配 :提供 PyTorch、Apple Metal(苹果芯片)、NVIDIA GPU 的官方参考实现

微软生态集成

-

Azure AI Foundry:

- 企业级 微调&部署平台,内置合规安全工具

- 针对 医疗、金融、零售 等行业优化

-

Windows AI Foundry:

- 通过 ONNX Runtime 和 Foundry Local 优化,让 gpt-oss-20b 在普通笔记本上高效运行

-

开发者工具:

- Azure AI Studio / GitHub Models:直接调用 GPT-OSS,利用微软云算力扩展

- AWS 支持 :可通过 SageMaker JumpStart 快速部署

开发支持

- OpenAI Cookbook :详细教程涵盖 环境配置、微调、LangChain/LlamaIndex 集成

- 结构化输出 :支持 Agent 工作流 和 精准 JSON 返回,适合 API 对接与自动化任务

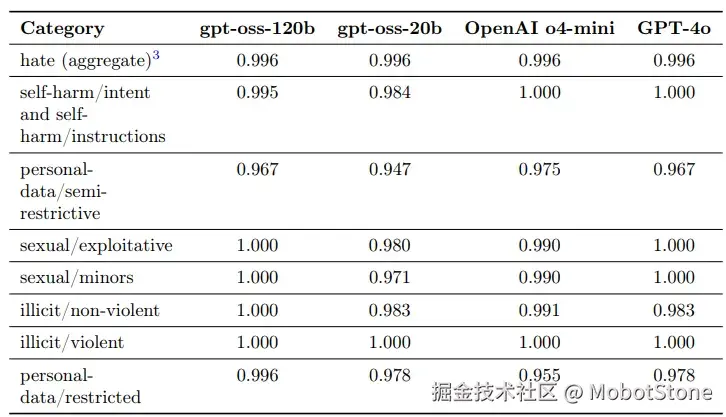

安全措施

为了防止有人滥用这些公开的模型,OpenAI做了以下防护工作:

-

数据清洗:

- 训练前就删除了关于生化武器、核武器等危险内容

- 确保模型学不到这些危险知识

-

模型调教:

- 使用RLHF技术(通过人类反馈强化学习)让模型学会拒绝不当请求

- 增加了拒绝回答敏感问题的能力

- 提高了对越狱攻击的防御能力

-

安全测试:

- 邀请专家模拟坏人会怎么做

- 测试结果显示gpt-oss-120b还达不到造成实际危害的水平

- 具体测试数据可以在OpenAI的安全报告中查看

-

专家合作:

- 聘请专业安全团队把关

- 目前已落实了22条安全建议中的11条

-

漏洞悬赏:

- 在Kaggle平台上举办了50万美元奖金的安全挑战赛

- 把发现的漏洞和测试报告都公开了

实测数据:在处理违法内容方面比o4-mini表现更好(0.692分 vs 0.658分),但在遵循指令优先级(0.832分 vs 0.993分)和减少瞎编内容(16.8% vs 23.4%)方面还需改进

使用提醒:严禁用于医疗诊断,建议隐藏模型的思考过程(CoT输出),避免用户看到可能有害的内容

目标和作用

GPT-OSS的目标是让更多人能用上高级AI,减少对收费API的依赖,特别是在发展中国家。它的主要作用包括:

本地化部署的优势

- 隐私保护:数据在本地上处理,不会上传到云端,特别适合医疗、金融和政府等敏感领域

- 响应更快:本地运行,不用等待云端返回结果

- 全球普及:AI Sweden、Orange和Snowflake等机构正在用GPT-OSS开发符合当地需求的AI工具

推动AI创新

- 高度可定制:开发者可以自由调整模型,打造专用工具,比如编程助手、教育应用等

- 微软助力:结合Azure AI Foundry和Windows AI Foundry,企业能更快部署应用,开发者也能更高效地测试和上线新产品

使用限制和注意事项

-

医疗禁用 :不能用于看病或治病,OpenAI明确禁止这类用途

-

硬件要求:

- gpt-oss-20b:普通电脑也能运行

- gpt-oss-120b:需要高性能服务器,普通人可能用不起

-

安全风险:

- 虽然做了严格防护,但开源模型仍有被坏人利用的可能

- OpenAI通过安全策略和持续漏洞检测来降低风险

结论

GPT-OSS 是开源 AI 领域的一个重要进展。它推出了两个实用的大语言模型:gpt-oss-120b 和 gpt-oss-20b。这两个模型不仅功能强大、运行高效,而且容易获取使用。在实际表现上,它们能达到 o4-mini 和 o3-mini 这类商业模型的水平,特别擅长逻辑推理、编程辅助和多语言处理任务。由于采用开放权重设计,用户可以直接在本地安装部署,这样既保护了数据隐私,又减少了响应延迟。

GPT-OSS 获得了微软 Azure 云服务和 Windows 系统的技术支持,并配备了完善的安全防护方案,这些都为它在全球各行业的创新应用提供了支持。开发者可以通过以下途径使用这些模型:

- 在 Hugging Face 平台获取模型

- 访问官网 gpt-oss.com 进行试用

- 参考 OpenAI 提供的 Cookbook 技术手册获取部署指南