本文系作者 [架构精进之路] 原创,著作权归作者所有,未经授权禁止任何形式的转载、抄袭或盗用,违者必究。

一、背景介绍

上一篇我们介绍了:多智能体系统架构解析

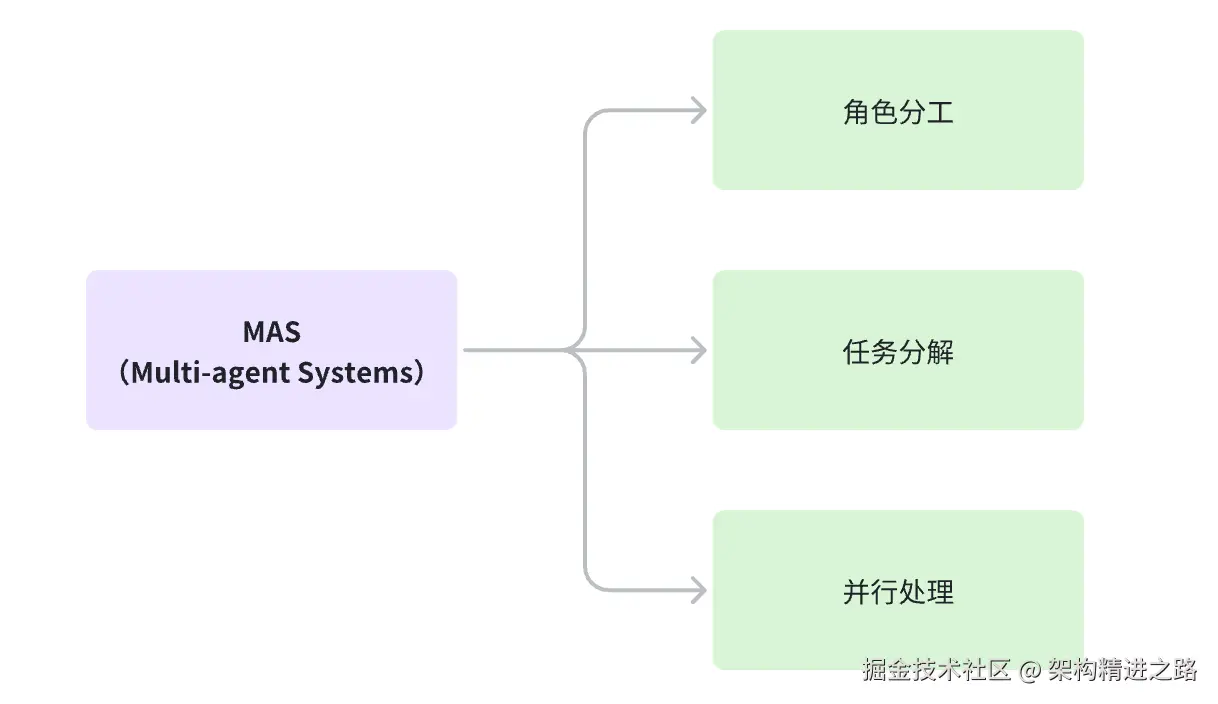

可以了解到多智能体系统,正是通过独特的架构设计,让 AI 突破单智能体的能力边界,实现更复杂的任务协作。

多智能体组成虚拟团队,模拟人类专业协作模式,以解决超越单智能体能力边界的复杂问题。

在众多多智能体框架中,LangGraph 的多智能体架构设计极具代表性,堪称实践典范。除了 LangGraph,还有几个优秀框架值得关注:

-

AutoGen 靠对话灵活调整

-

CrewAI 重角色分工和流程

-

MetaGPT 则强调标准化步骤

选择时要结合任务的灵活性、流程固定性来判断。

二、多智能体系统不是银弹

我们需要明确的是:多智能体不是银弹,存在很多隐藏的挑战。

2.1 多智能体系统研究

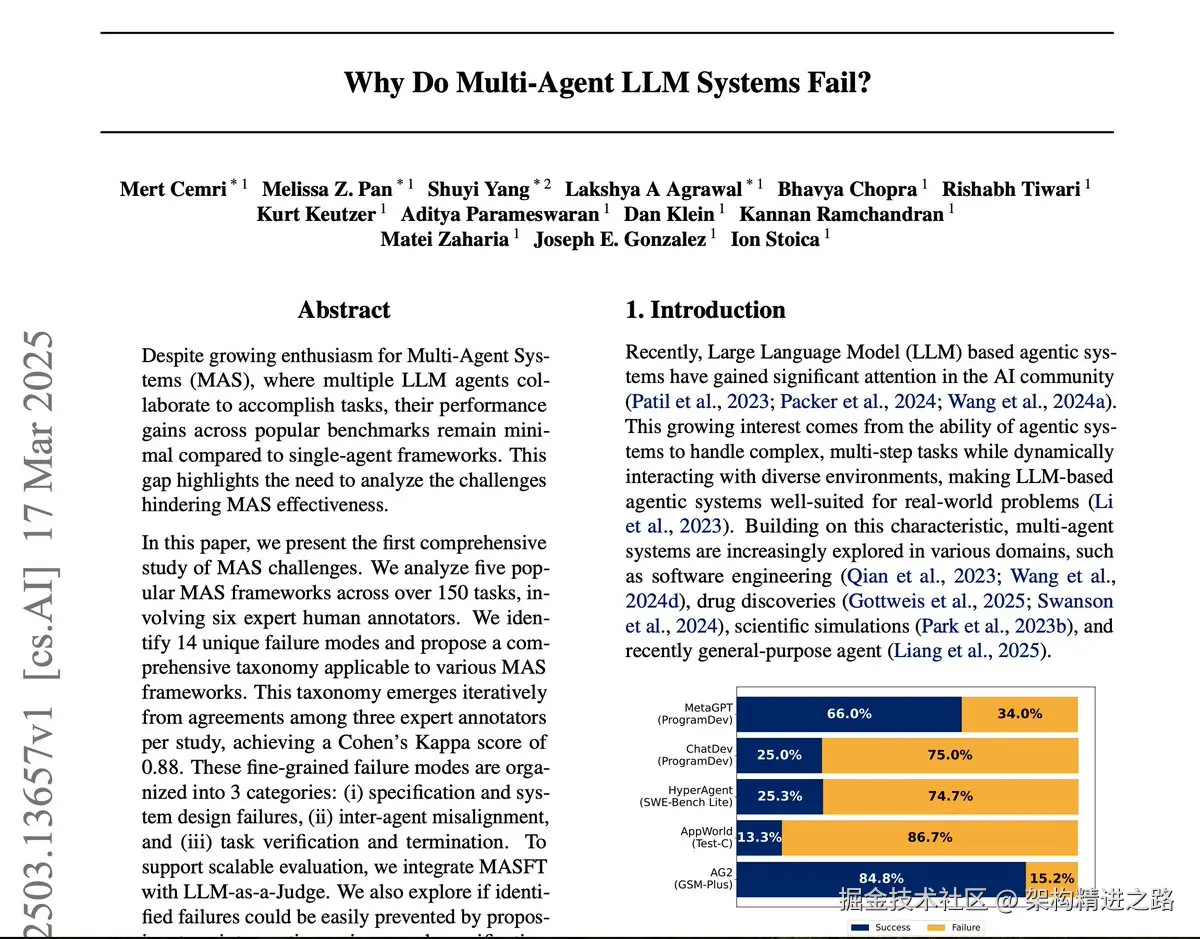

加州伯克利大学的一项有趣研究指出了由大语言模型驱动的多智能体系统(MAS)中的关键失败模式。

首个全面研究「多智能体系统有效性」的挑战:

分析了 5 个主流 MAS 框架、超 150 项任务,并由 14 位专家人工标注;识别出 14 种独特的 "失败模式",提出了适用于各类 MAS 框架的综合分类法

从研究结果来看:尽管MAS的潜力巨大,开源框架ChatDev在某些任务中的正确率仅25%

这一现象引发核心问题:为何多智能体系统频繁翻车?

2.2 失败模式分类

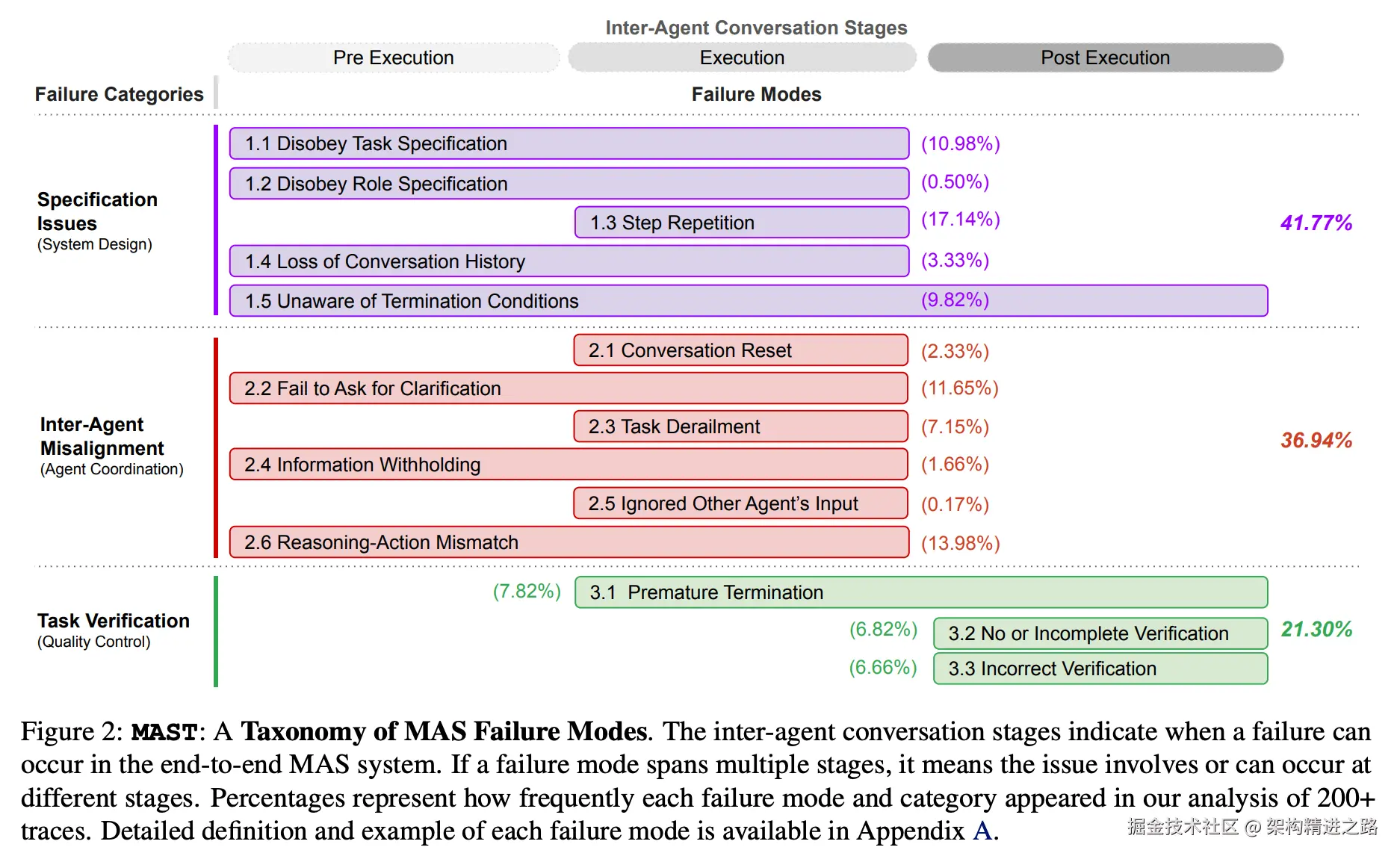

研究者将失败模式分为三大类别:

-

系统设计问题(Specification Issues)

典型问题:任务/角色违反设定、步骤重复、对话历史丢失、终止条件不明确

-

智能体协调问题(Inter-Agent Misalignment)

典型问题:对话重置、未澄清模糊信息、任务偏离、信息隐瞒、忽略其他智能体输入

-

任务验证问题(Task Verification)

典型问题:过早终止、验证缺失或错误

2.3 多智能体架构的缺陷

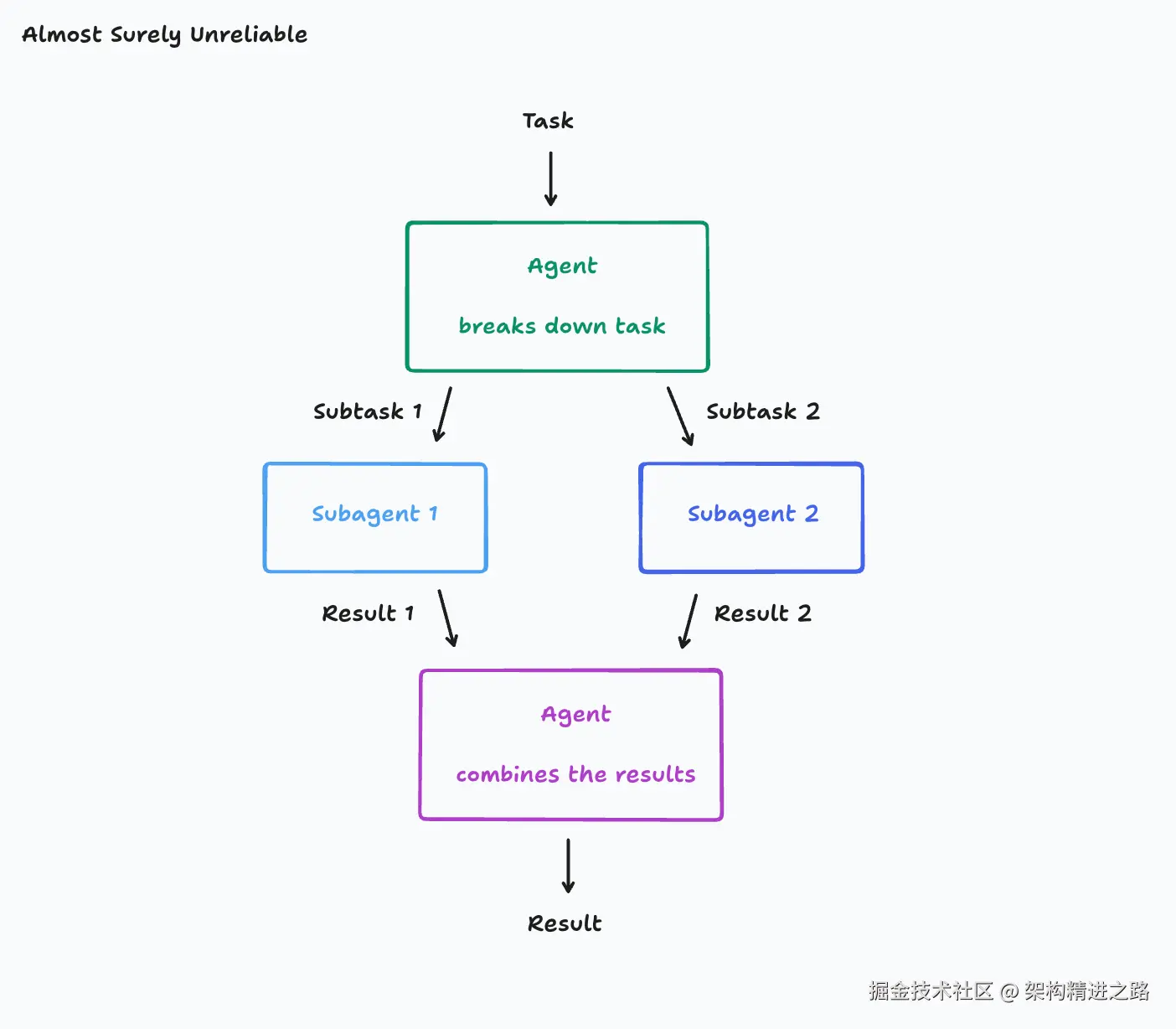

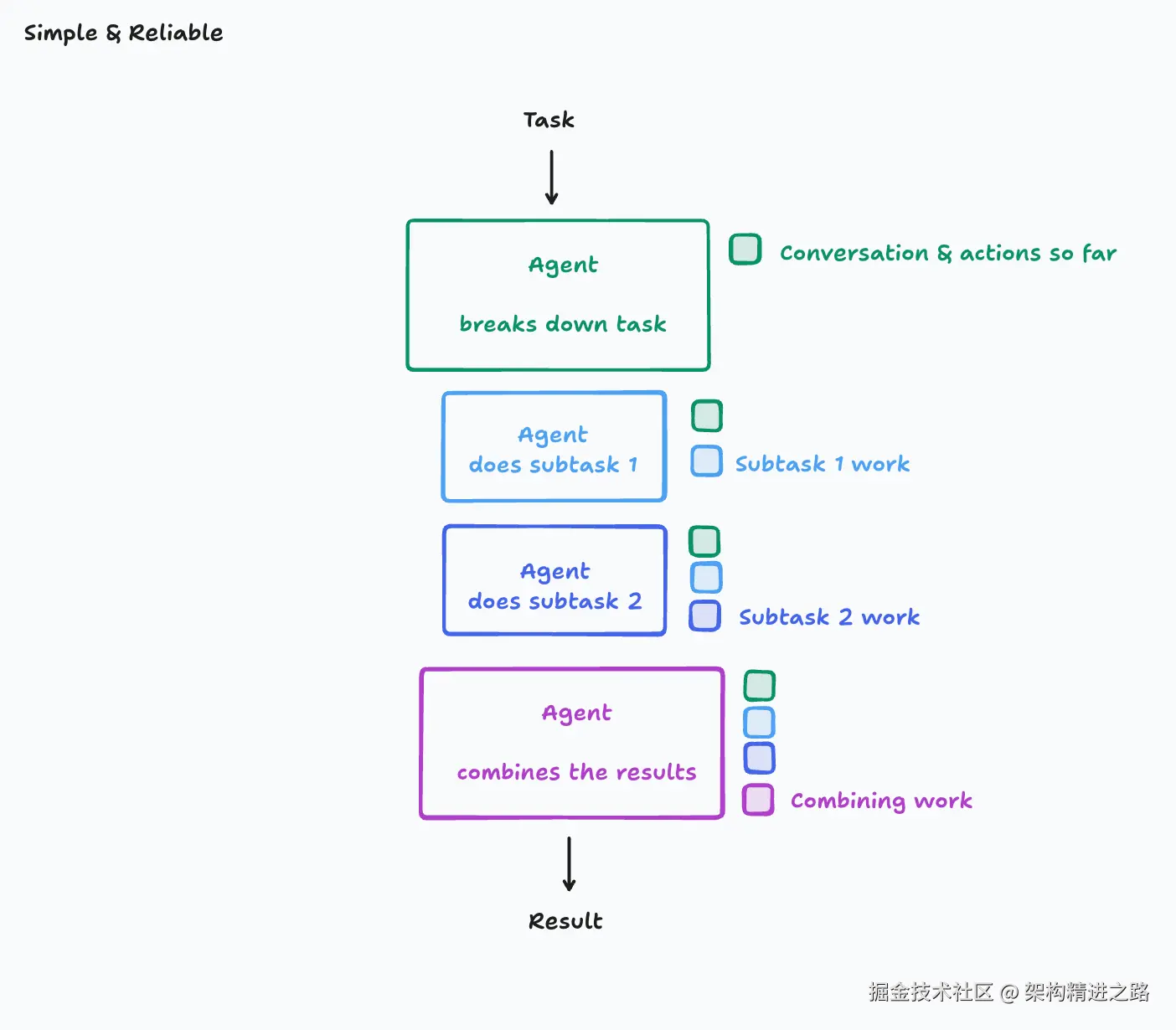

多智能体的任务处理流程(主要基于:分治思想)

- 缺陷1:上下文碎片化悖论

LLM 的决策质量与上下文完整性正相关

- **缺陷2:**决策熵增定律

并行系统决策节点数与系统混乱度呈指数关系

2.4 可靠的基本准则

- 原则1:全局上下文共享(Full-context Tracing)

智能体的每个动作必须基于系统中所有相关决策的完整上下文

所有动作在单一连续上下文中执行(全量上下文无损),避免决策分散

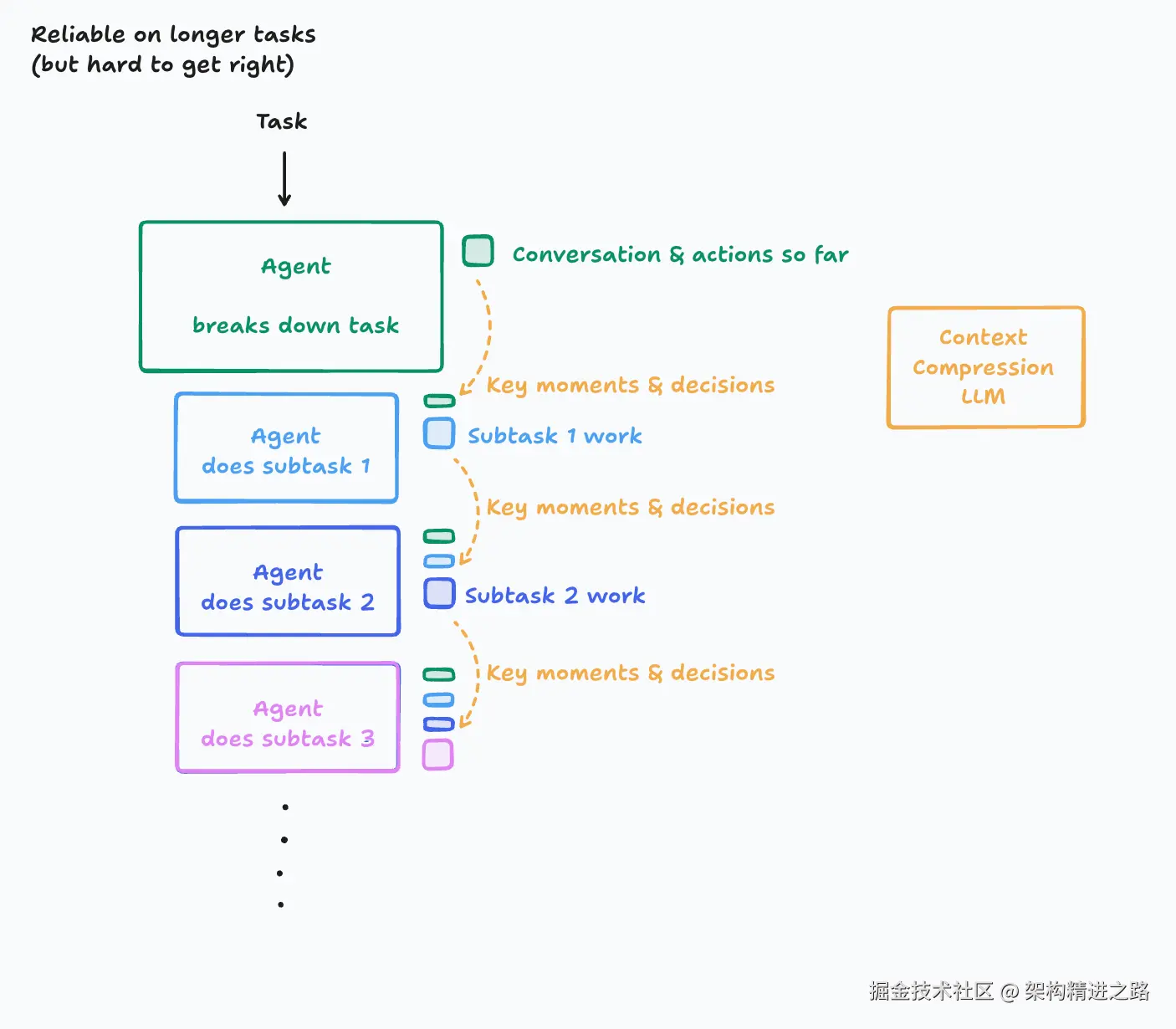

- 原则2:决策一致性约束(Implicit Decision Coherence)

动作中隐含未明说的决策,冲突会导致系统崩溃

引入LLM 压缩历史对话,提炼关键事件和决策

结论:违反以上两原则的架构本质上是脆弱的!

三、我们到底需要多少智能体?

当协调成本(通信延迟、冲突消解)的指数增长超过智能体能力总和时,系统效能断崖式下降。

- 效能临界点公式:

System IQ ∝ (∑Agent Capability) / (Coordination Cost)^n (n≥1.5)

- 场景验证:

- 总结:

增加 Agent 不盲目:

-

简单任务:一个精英Agent 单干可能更快

-

复杂任务:动态组队+投票机制

四、结语

多智能体系统的失败区别于单一 LLM 缺陷(如幻觉)的产物,而是系统设计、交互协议与验证机制的综合结果。

多智能体系统失败分类(MASF)为未来研究提供了结构化框架,结合组织理论与工程技术,推动MAS从实验性工具向可靠系统的演进。

后续 AI 内容学习,持续更新,欢迎关注~

·END·

希望今天的讲解对大家有所帮助,谢谢!

Thanks for reading!

作者:架构精进之路,十年研发风雨路,大厂架构师,CSDN 博客专家,专注架构技术沉淀学习及分享,职业与认知升级,坚持分享接地气儿的干货文章,期待与你一起成长。

关注并私信我回复"01",送你一份程序员成长进阶大礼包,欢迎勾搭。