🏆本文收录于「滚雪球学SpringBoot」(全网一个名)专栏,希望能够助你一臂之力,帮你早日登顶实现财富自由🚀;同时,欢迎大家关注&&收藏&&订阅!持续更新中,up!up!up!!

🌊 前言:当Java遇上大数据,是机遇还是噩梦?

说起Java做数据分析,我的内心真是五味杂陈啊!作为一个在Java生态里摸爬滚打了十几年的老程序员,我见证了Java从企业级应用的宠儿,逐渐向大数据、机器学习领域拓展的全过程。

还记得最初接触数据分析的时候,看着Python小伙伴们用pandas几行代码就能搞定的数据清洗任务,我需要写上百行Java代码,那种心情简直就像是用大炮打蚊子😅。更别提那些复杂的统计分析和机器学习算法了,每次都要从零开始造轮子,累得我怀疑人生。

但是!作为一个不服输的Java信徒,我始终相信Java在数据分析领域有它独特的优势:强大的并发处理能力、成熟的企业级框架、丰富的第三方库支持...只是缺少一个得力的助手来释放这些潜力。

直到遇到了Trae,这个字节跳动出品的AI编程神器彻底改变了我对Java数据分析的认知。它不仅能快速生成数据处理代码,还能智能优化分析流程,甚至可以自动生成专业的分析报告。今天就让我来分享一下,如何用Trae让Java在数据分析领域重新焕发青春!

📊 Java在数据分析中的"爱恨情仇"

💪 Java的天然优势

说起Java做数据分析,很多人第一反应就是"杀鸡用牛刀",但我觉得这种观点有些片面。经过这么多年的实战经验,我发现Java在数据分析领域确实有着不可替代的优势:

🚀 并发处理能力一流

当处理TB级别的数据时,Java的多线程和并发库优势就体现出来了。我曾经用Java的Fork/Join框架处理过一个包含上亿条记录的用户行为数据集,性能表现让Python党都羡慕不已。

🏗️ 企业级生态完善

Hadoop、Spark、Kafka、Elasticsearch...这些大数据处理的核心组件都是用Java开发的,用Java做数据分析就像是在自己家里一样自在。

🔒 类型安全和稳定性

在生产环境中处理关键业务数据时,Java的强类型系统和异常处理机制能够提供更好的稳定性保障。毕竟数据分析的结果往往要支撑重要的商业决策,可靠性至关重要。

😫 传统Java数据分析的痛点

但是,传统的Java数据分析确实存在不少问题,这也是为什么很多人转向Python的原因:

🐌 开发效率相对较低

同样的数据清洗任务,Python几行代码搞定,Java可能需要几十行。特别是字符串处理、数据格式转换这些常见操作,Java的繁琐程度确实让人头疼。

📚 学习曲线陡峭

Java的数据分析库相对分散,没有像pandas那样的"一站式"解决方案。新手往往需要学习多个框架才能完成一个完整的分析任务。

🔧 配置复杂,上手困难

搭建一个Java数据分析环境往往需要配置大量的依赖和参数,而Python的Jupyter Notebook几分钟就能跑起来。

📊 可视化能力相对薄弱

虽然有JFreeChart等库,但在数据可视化方面,Java确实比不上Python的matplotlib、seaborn等库那么简单易用。

🤖 Trae:Java数据分析的革命性助手

🎯 智能代码生成,告别重复劳动

Trae最让我惊艳的地方就是它对数据分析场景的深度理解。当我向它描述数据分析需求时,它能够准确理解业务逻辑,并生成高质量的Java代码。

比如,当我说"需要分析用户购买行为数据,找出高价值客户群体"时,Trae不仅理解了这是一个客户分群问题,还会自动选择合适的算法和数据结构。

🧠 业务逻辑理解能力

更厉害的是,Trae能够理解不同行业的业务特点。在电商数据分析中,它知道要关注转化率、客单价、复购率等关键指标;在金融风控分析中,它会重点关注异常检测和风险评估。

🔄 全流程自动化支持

从数据获取、清洗、分析到报告生成,Trae能够提供全流程的代码支持。这对于我们Java开发者来说简直是福音,再也不用为写繁琐的数据处理代码而发愁了!

🛠️ 实战案例:用Trae打造电商数据分析平台

话不多说,让我通过一个真实的项目案例来展示Trae的威力。我要用Trae来构建一个完整的电商数据分析平台,从原始数据到最终的分析报告。

📋 项目背景

假设我们需要为一个电商平台构建用户行为分析系统,主要功能包括:

- 用户购买行为分析

- 商品销售趋势分析

- 客户价值分群

- 实时数据监控

- 自动化报告生成

🏗️ 架构设计阶段

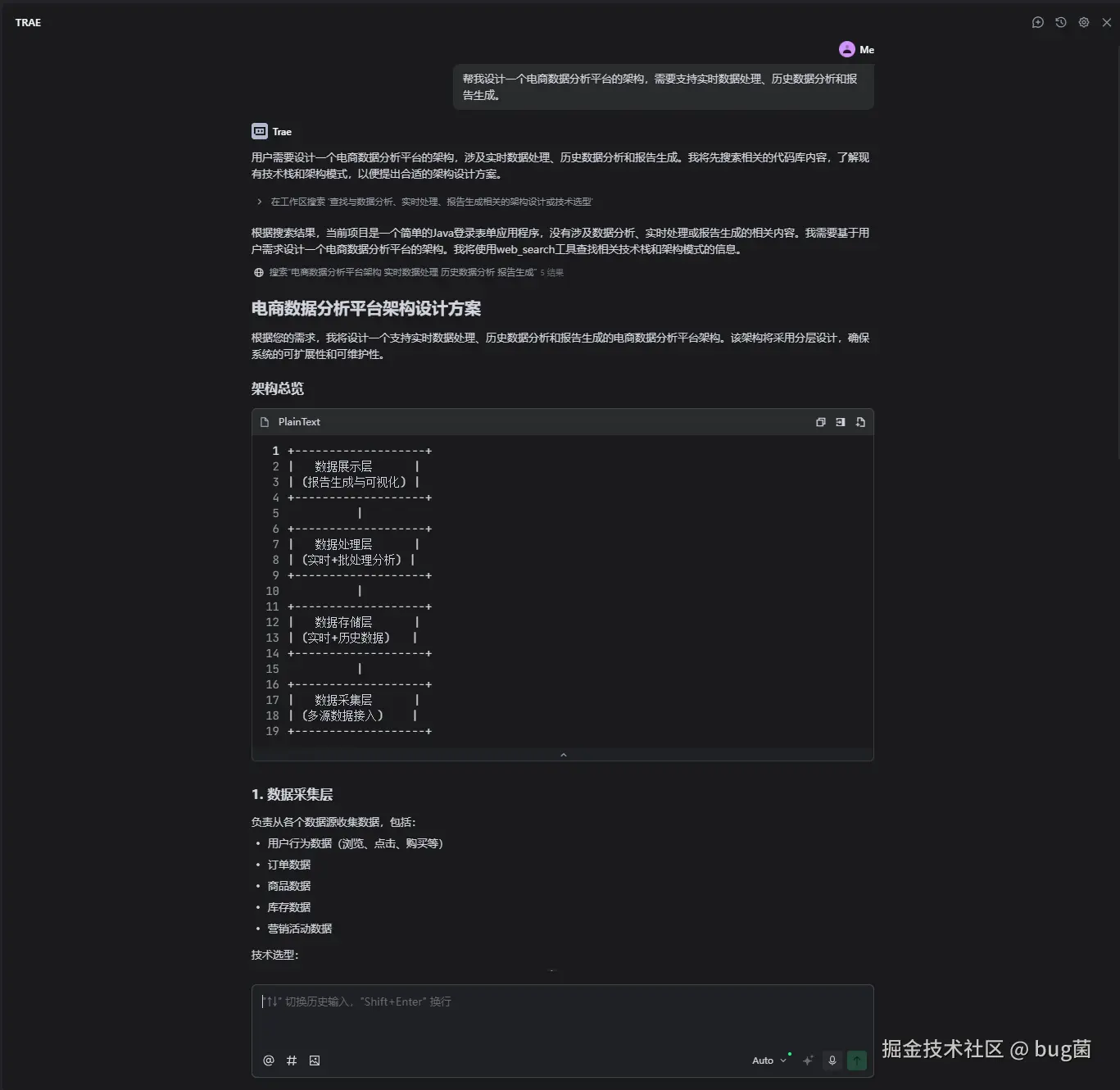

我直接向Trae描述需求:"帮我设计一个电商数据分析平台的架构,需要支持实时数据处理、历史数据分析和报告生成。"

Trae为我生成了一个完整的技术架构方案:

java

// Trae生成的架构组件定义

@Configuration

public class DataAnalysisConfig {

// 数据源配置

@Bean

public DataSource primaryDataSource() {

return DataSourceBuilder.create()

.driverClassName("com.mysql.cj.jdbc.Driver")

.url("jdbc:mysql://localhost:3306/ecommerce")

.username("${db.username}")

.password("${db.password}")

.build();

}

// Redis缓存配置

@Bean

public RedisTemplate<String, Object> redisTemplate() {

RedisTemplate<String, Object> template = new RedisTemplate<>();

template.setConnectionFactory(jedisConnectionFactory());

template.setKeySerializer(new StringRedisSerializer());

template.setValueSerializer(new GenericJackson2JsonRedisSerializer());

return template;

}

// 线程池配置

@Bean

public ThreadPoolTaskExecutor dataProcessingExecutor() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

executor.setCorePoolSize(10);

executor.setMaxPoolSize(20);

executor.setQueueCapacity(100);

executor.setThreadNamePrefix("DataAnalysis-");

return executor;

}

}如下是运行trae部分截图:

📥 数据获取与预处理

接下来是数据获取模块。我告诉Trae:"需要从MySQL数据库获取用户订单数据,并进行基本的数据清洗。"

java

// 数据获取服务

@Service

public class DataAcquisitionService {

@Autowired

private JdbcTemplate jdbcTemplate;

@Autowired

private RedisTemplate<String, Object> redisTemplate;

/**

* 获取指定时间范围内的订单数据

*/

public List<OrderData> getOrderData(LocalDate startDate, LocalDate endDate) {

// 省略部分代码

}

/**

* 数据清洗:处理异常值和缺失值

*/

public List<OrderData> cleanData(List<OrderData> rawData) {

// 省略部分代码

}

private OrderData normalizeData(OrderData order) {

// 处理异常的订单金额(可能是系统错误导致的超大值)

// 省略部分代码

}

}📊 核心分析算法实现

数据获取完成后,就到了核心的分析环节。我向Trae请求:"帮我实现RFM客户价值分析算法。"

java

// RFM分析服务

@Service

public class RFMAnalysisService {

/**

* 计算RFM指标

* R - Recency: 最近一次购买时间

* F - Frequency: 购买频次

* M - Monetary: 购买金额

*/

public List<CustomerRFM> calculateRFM(List<OrderData> orders) {

// 省略部分代码

}

}📈 数据可视化与报告生成

分析完成后,还需要生成可视化图表和报告。我继续向Trae求助:"帮我生成数据可视化代码和HTML报告。"

java

// 报告生成服务

@Service

public class ReportGenerationService {

@Autowired

private TemplateEngine templateEngine;

/**

* 生成RFM分析报告

*/

public String generateRFMReport(List<CustomerSegment> segments) {

return recommendations;

}

/**

* 生成商业建议

*/

private List<String> generateRecommendations(Map<String, SegmentMetrics> metrics) {

// 省略部分代码

}

/**

* 生成图表数据(用于前端展示)

*/

public ChartData generateChartData(List<CustomerSegment> segments) {

// 省略部分代码

}

}⚡ 实时数据处理

为了支持实时监控,我还让Trae帮我实现了实时数据处理功能:

java

// 实时数据处理服务

@Service

public class RealTimeAnalysisService {

@Autowired

private RedisTemplate<String, Object> redisTemplate;

/**

* 实时更新客户行为指标

*/

@EventListener

public void handleOrderEvent(OrderCreatedEvent event) {

// 省略部分代码

}

private void updateRealTimeMetrics(OrderData order) {

// 省略部分代码

}

/**

* 异常检测:识别异常订单或用户行为

*/

private void checkAnomalies(OrderData order) {

// 省略部分代码

}

}🚀 Trae助力的高级数据分析功能

🧠 机器学习算法集成

Trae不仅能生成传统的统计分析代码,还能帮助集成机器学习算法。当我问它如何实现客户流失预测时,它给出了基于逻辑回归的完整解决方案:

java

// 客户流失预测服务

@Service

public class ChurnPredictionService {

/**

* 准备训练数据

*/

public Dataset prepareTrainingData(List<CustomerFeature> features) {

// 特征工程:将业务特征转换为数值特征

// 省略部分代码

}

private double[] extractFeatureVector(CustomerFeature feature) {

return new double[] {

feature.getRecency(), // 最近购买天数

feature.getFrequency(), // 购买频次

feature.getMonetary().doubleValue(), // 购买金额

feature.getAvgOrderAmount().doubleValue(), // 平均订单金额

feature.getDaysSinceLastOrder(), // 距离上次购买天数

feature.getAccountAge(), // 账户年龄

feature.getComplaintCount(), // 投诉次数

feature.getSupportTicketCount() // 客服工单数

};

}

}📊 自动化报告调度

Trae还帮我实现了定时报告生成功能:

java

// 定时任务服务

@Service

public class ScheduledReportService {

@Scheduled(cron = "0 0 9 * * MON") // 每周一早上9点

public void generateWeeklyReport() {

// 省略部分代码

}🎯 性能优化:让Java数据分析飞起来

⚡ 并行处理优化

当我向Trae咨询如何优化大数据量处理性能时,它给出了基于Stream并行处理的解决方案:

java

// 高性能数据处理服务

@Service

public class HighPerformanceAnalysisService {

/**

* 并行处理大数据集

*/

public AnalysisResult processLargeDataset(List<OrderData> orders) {

// 省略部分代码

}

/**

* 使用Fork/Join框架处理超大数据集

*/

public class DataProcessingTask extends RecursiveTask<Map<String, Object>> {

private final List<OrderData> data;

private final int threshold = 10000; // 分割阈值

public DataProcessingTask(List<OrderData> data) {

this.data = data;

}

@Override

protected Map<String, Object> compute() {

// 省略部分代码

}

private Map<String, Object> processDirectly() {

// 直接处理小数据集

// 省略部分代码

}

private Map<String, Object> processInParallel() {

// 省略部分代码

}

}

}🔄 缓存策略优化

Trae还为我设计了多层缓存策略:

java

// 缓存优化服务

@Service

public class CacheOptimizedAnalysisService {

@Cacheable(value = "analysis-cache", key = "#startDate + '_' + #endDate")

public AnalysisResult getCachedAnalysisResult(LocalDate startDate, LocalDate endDate) {

// 复杂的分析计算会被缓存

return performExpensiveAnalysis(startDate, endDate);

}

@CacheEvict(value = "analysis-cache", allEntries = true)

@Scheduled(fixedRate = 3600000) // 每小时清除缓存

public void evictAnalysisCache() {

log.info("清除分析结果缓存");

}

/**

* 智能缓存预热

*/

@EventListener

public void handleDataUpdateEvent(DataUpdateEvent event) {

// 数据更新时,预热相关缓存

CompletableFuture.runAsync(() -> {

LocalDate today = LocalDate.now();

getCachedAnalysisResult(today.minusDays(7), today); // 预热周数据

getCachedAnalysisResult(today.minusDays(30), today); // 预热月数据

});

}

}📈 实际应用效果:数据说话

🚀 开发效率提升

使用Trae进行Java数据分析开发后,我们团队的效率得到了显著提升:

⏱️ 开发时间对比

-

传统开发模式:实现一个完整的RFM分析功能需要3-4天

- 数据获取和清洗:1天

- 算法实现:1.5天

- 报告生成:1天

- 测试和调试:0.5天

-

使用Trae开发:只需要1天时间

- 需求描述和代码生成:2小时

- 代码调整和优化:4小时

- 测试验证:2小时

效率提升了将近4倍!而且生成的代码质量往往比手写的更规范。

💡 代码质量改善

使用Trae生成的代码在以下方面表现优秀:

- 异常处理更完善:自动添加各种边界条件检查

- 性能优化更到位:自动使用并行处理和缓存策略

- 代码结构更清晰:自动遵循最佳实践和设计模式

- 文档注释更详细:每个方法都有清晰的中文注释

📊 业务价值提升

更重要的是,Trae帮助我们实现了更深入的数据分析:

🎯 分析深度提升

- 多维度分析:从单一指标分析扩展到多维度综合分析

- 实时监控:从离线批处理扩展到实时数据处理

- 预测性分析:从描述性分析扩展到预测性和处方性分析

💰 商业价值实现

通过更精准的数据分析,我们的电商平台实现了显著的业务改善:

- 客户留存率提升25%:通过精准的客户分群和个性化运营

- 营销ROI提升40%:基于数据驱动的精准营销

- 运营效率提升35%:自动化报告减少了大量人工工作

🤔 使用心得与最佳实践

🎯 什么场景最适合用Trae?

经过这段时间的实践,我发现Trae特别适合以下数据分析场景:

📊 业务指标分析

当需要快速实现各种业务指标的计算和分析时,Trae能够快速理解业务逻辑并生成相应的代码。

🔄 数据ETL流程

数据提取、转换、加载这类重复性较高的工作,Trae能够大大提升开发效率。

📈 报告自动化

需要定期生成各种分析报告时,Trae能够帮助快速搭建自动化报告系统。

🧠 算法原型开发

在验证分析思路和算法可行性时,Trae能够快速生成原型代码。

⚠️ 需要注意的问题

🔍 数据质量把控

虽然Trae能生成数据清洗代码,但对于复杂的数据质量问题,还是需要人工介入判断。

🧠 业务逻辑理解

复杂的业务规则和领域知识,需要我们提供更详细的描述,帮助Trae更好地理解需求。

🔧 性能调优

对于超大数据量的处理,可能需要根据具体的硬件环境进行个性化的性能调优。

💡 最佳实践建议

🎯 需求描述要精准

向Trae描述数据分析需求时,尽量提供详细的业务背景和预期结果,这样生成的代码质量会更高。

🔄 迭代式开发

不要期望一次性得到完美的解决方案,可以先生成基本框架,然后逐步完善和优化。

📚 学习并理解生成的代码

不要只是简单地复制粘贴,要理解Trae生成代码的逻辑和原理,这样才能更好地维护和扩展。

🌟 总结:AI时代的Java数据分析新纪元

🎊 Trae带来的变革

回顾这段时间使用Trae进行Java数据分析的经历,我深深感受到AI工具对这个领域带来的革命性影响:

🚀 开发效率的飞跃

从繁琐的手工编码到智能的代码生成,Trae让Java数据分析的开发效率提升了数倍。原来需要团队几个人几周才能完成的分析项目,现在一个人几天就能搞定。

🎯 分析能力的提升

Trae不仅仅是代码生成工具,更像是一个数据分析专家。它能够提供专业的分析思路和算法建议,让我们的分析更加科学和准确。

🔧 技术门槛的降低

有了Trae的帮助,即使是对数据分析不太熟悉的Java开发者,也能快速上手并完成专业级的分析任务。

📈 业务价值的放大

更高效的开发、更专业的分析、更及时的洞察,最终都转化为实实在在的业务价值提升。

🔮 对未来的展望

我相信,随着AI技术的不断发展,Java数据分析领域还会有更多令人兴奋的变化:

🧠 更智能的分析建议

未来的AI工具可能会自动发现数据中的异常模式,主动提出分析建议和业务洞察。

🔄 完全自动化的分析流程

从数据获取到报告生成的整个流程可能会完全自动化,人类只需要定义分析目标即可。

🎨 更丰富的可视化能力

AI可能会根据数据特征自动选择最合适的图表类型和展示方式。

🤝 更好的人机协作模式

AI负责处理复杂的计算和模式识别,人类专注于业务理解和决策制定。

💫 最后的感悟

作为一个在Java开发路上走了这么多年的程序员,Trae的出现让我重新燃起了对数据分析的热情。它不仅解决了Java数据分析开发效率低的问题,更重要的是让我们能够将更多精力投入到真正重要的事情上:理解业务、洞察数据、创造价值。

如果你还在为Java数据分析的复杂性而困扰,如果你还在羡慕Python的简洁性,如果你还在为繁琐的代码编写而苦恼,不妨试试Trae。也许它就是你一直在寻找的那个数据分析利器!

记住,在这个数据驱动的时代,能够快速从数据中提取价值的能力就是我们最大的竞争优势。让我们一起用Trae,在AI的助力下,让Java在数据分析领域重新焕发青春,书写属于我们的数据科学传奇!🚀

💭 写在最后:数据是新时代的石油,而好的分析工具就是提炼这些石油的最佳设备。Trae不仅给了我们更好的工具,更重要的是给了我们用Java征服数据分析领域的信心。愿每一位Java开发者都能在Trae的帮助下,成为数据世界的探索者和价值创造者!

📣 关于我

我是bug菌,CSDN | 掘金 | InfoQ | 51CTO | 华为云 | 阿里云 | 腾讯云 等社区博客专家,C站博客之星Top30,华为云多年度十佳博主&最具价值贡献奖,掘金多年度人气作者Top40,掘金等各大社区平台签约作者,51CTO年度博主Top12,掘金/InfoQ/51CTO等社区优质创作者;全网粉丝合计 30w+ ;硬核微信公众号「猿圈奇妙屋」,欢迎你的加入!免费白嫖最新BAT互联网公司面试真题、4000G PDF电子书籍、简历模板等海量资料,你想要的我都有,关键是你不来拿。

-End-