css

相信我,在Claude Code中接入国内主流编程大模型(含deepseek-v3.1,qwen3-coder,glm-4.5,kimi k2),看这篇文章就够了,点赞,转发,收藏起来呀,你一定用得上!最近真是越来越依赖 Claude Code 了,连 Cursor 都快被我"闲置"啦[破涕为笑]~强烈推荐大家在 AI 编程时都来试试它!

如果你也想用,可以通过 claude-code-router 进行中转,接入国内大模型。比如魔搭社区的 qwen3-coder 推理接口,每天有 500 次免费调用,非常划算。

我之前写过一篇文章,详细介绍了如何在 Claude Code 中接入免费的魔搭 Qwen3-Coder 推理 API,感兴趣可以看看: 3 分钟讲透 Win 版 Claude Code部署:整合 Qwen-Coder + GLM-4.5,零翻墙平替 Cursor!

如果想使用 Claude 官方模型,也可以通过国内的中转 API,或者选择 OpenRouter 提供的服务,它还支持支付宝支付,对国内用户特别友好。

我个人的使用习惯是:复杂或高难度任务交给 Claude 接口,一般编程任务用国内模型就足够了。

如果不想通过 claude-code-router 中转,是否可以直接在官方 Claude Code 里接入国内大模型呢?

答案是:可以的!

接下来,我就来详细介绍如何将 GLM-4.5、Kimi K2、Qwen3-Coder、DeepSeek-V3.1 这些优秀的国产编程大模型,一一接入到 Claude Code 中!

一、安装 Claude Code

一)安装

bash

npm install -g @anthropic-ai/claude-code二)启动

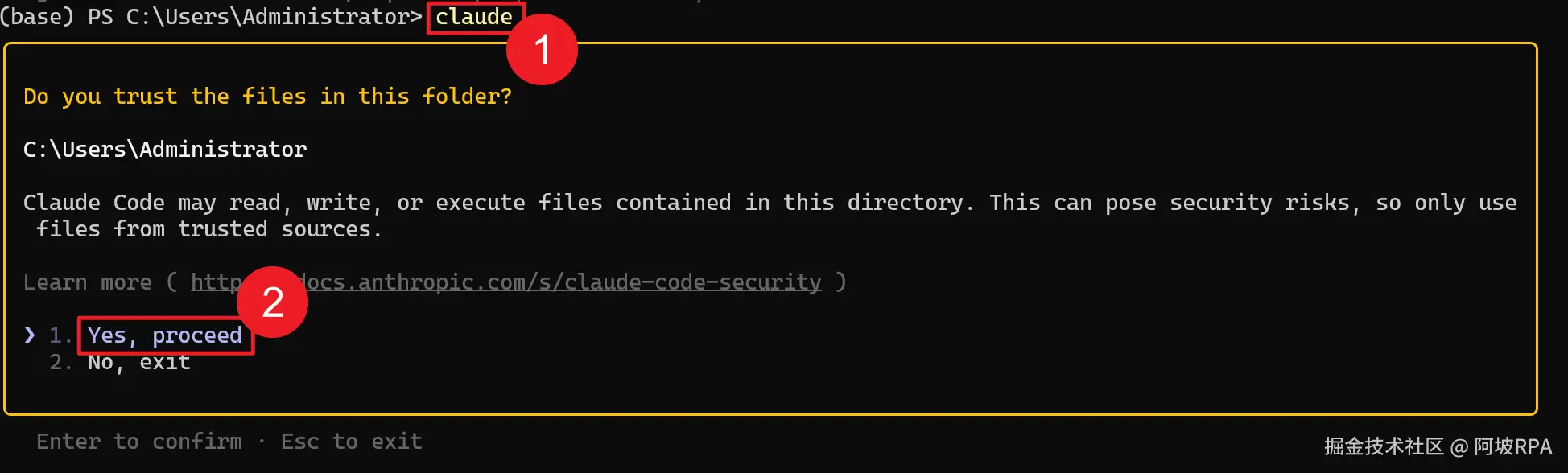

在命令行输入指令 claude ,然后回车即可启动

三)配置大模型API KEY

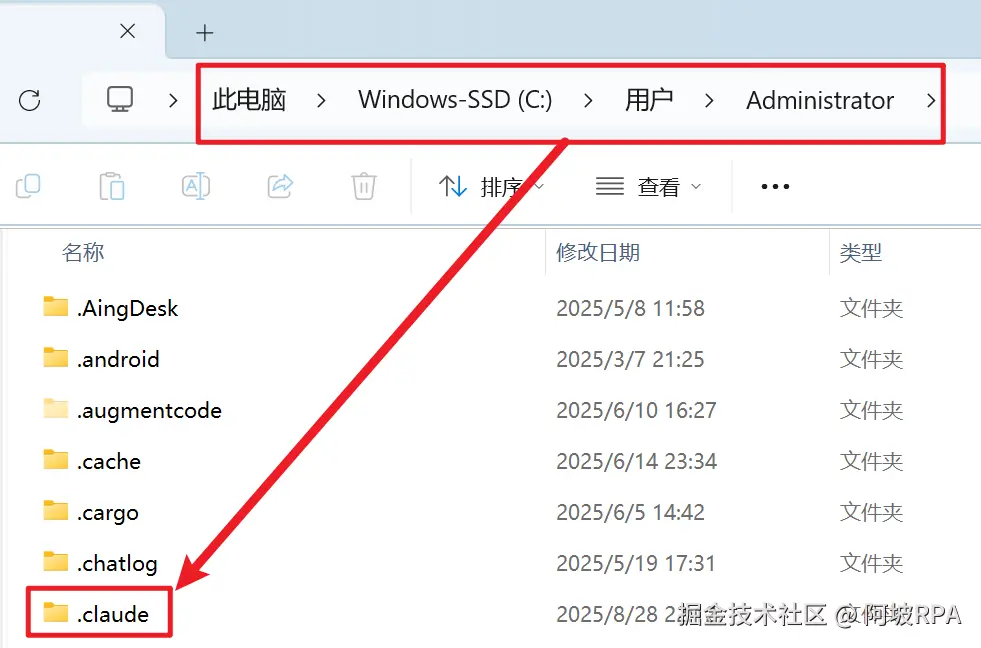

来到系统用户home目录下会看到有一个 .claude 文件夹

由于以 . 开头的是隐藏文件夹,所以需要设置将隐藏文件显示出来

win 用户操作方式是:

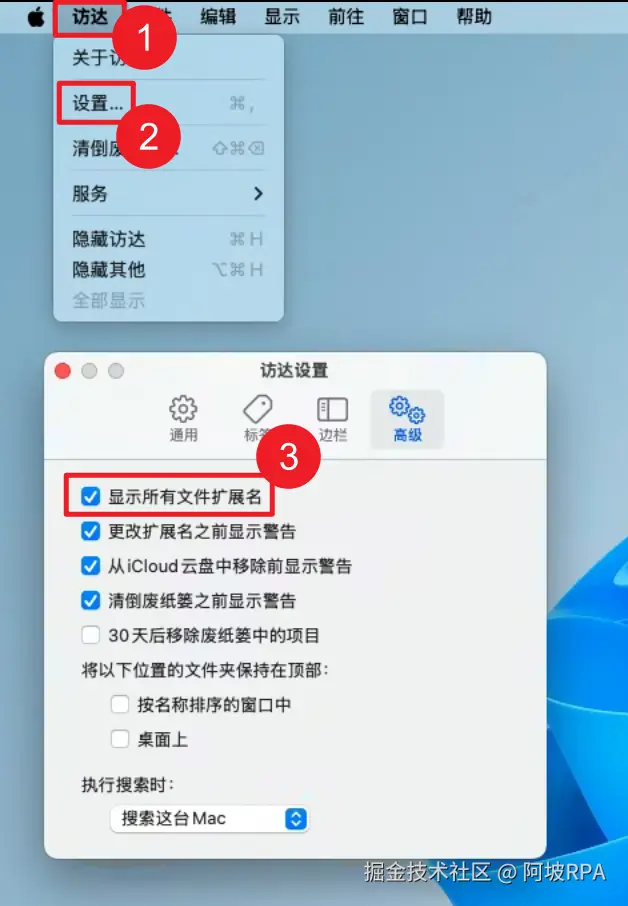

MAC 用户操作方式是:

-

在 Mac 上的 "访达" 中,选取"访达">"设置",然后点按"高级"。

-

请选择或取消选择"显示所有文件扩展名"。

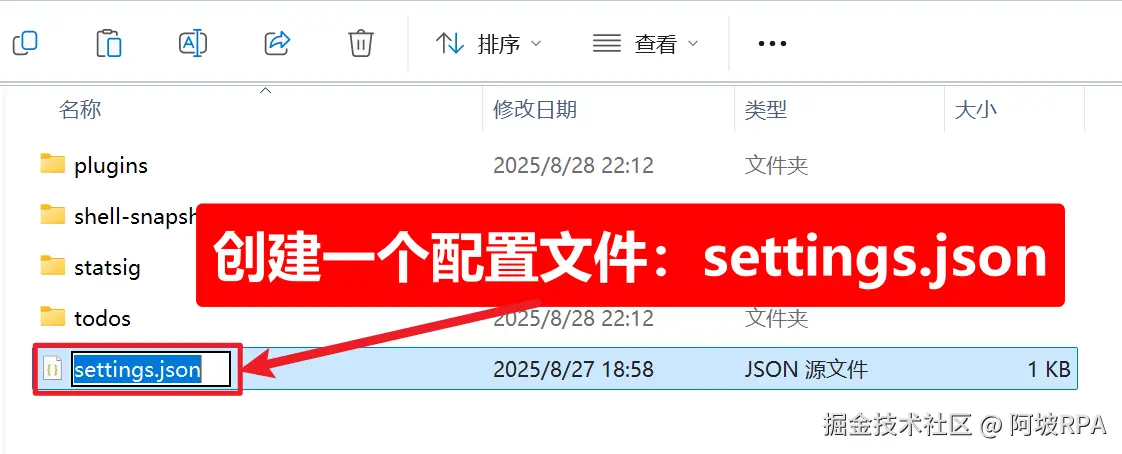

在 .claude 文件夹内创建一个 settings.json 配置文件

填入如下模型配置信息(以deepseek为例):

json

{

"env": {

"ANTHROPIC_BASE_URL": "https://api.deepseek.com/anthropic",

"ANTHROPIC_AUTH_TOKEN": "你的API KEY",

"ANTHROPIC_MODEL": "deepseek-reasoner",

"ANTHROPIC_SMALL_FAST_MODEL": "deepseek-reasoner"

}

}这个配置文件是配置你的大模型信息的,不只是可以配置 claude 一家的大模型,还可以配置国内主流编程大模型的 API KEY ,因为他们官方都支持将自家大模型 api 接入 Claude Code,后面逐个为大家详细介绍。

四)重新进入claude

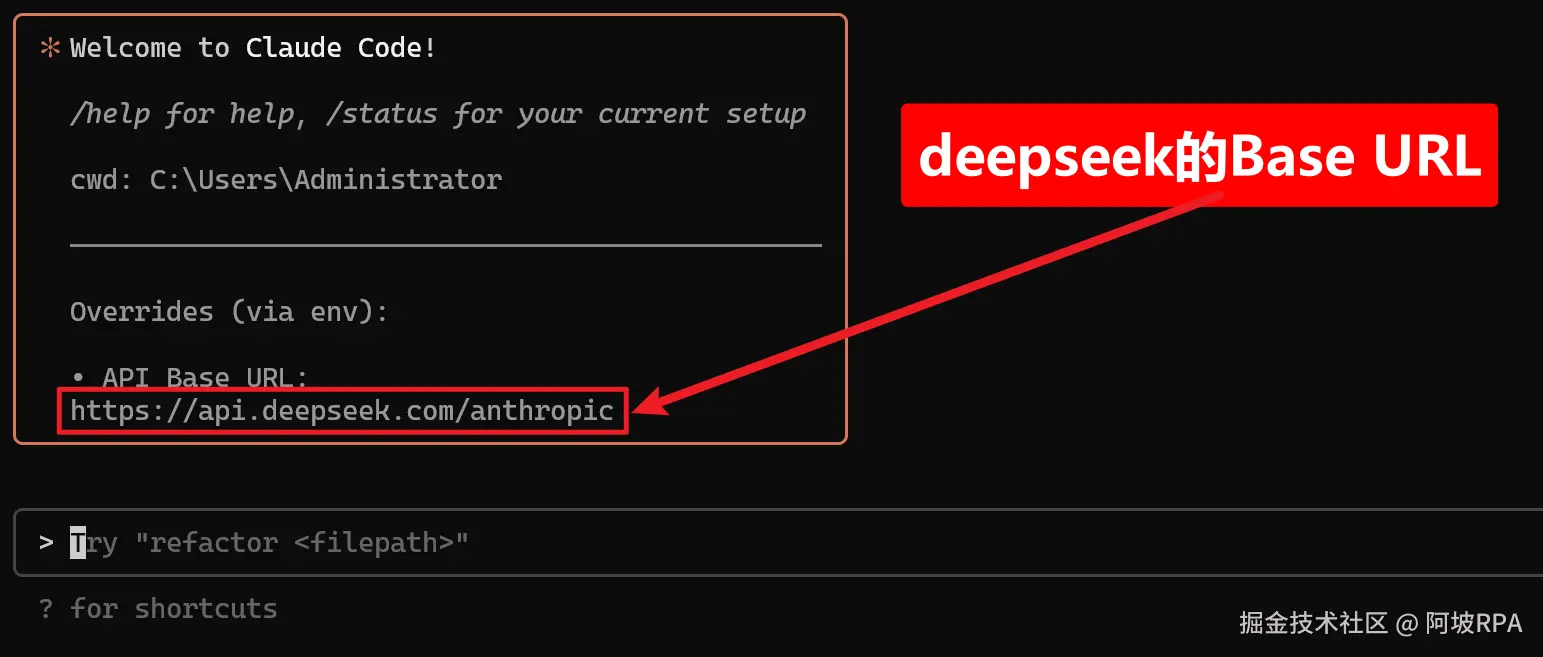

配置好自己的模型信息后,重新进入 claude 可以看到接入模型成功:

这样,我们就可以在 Claude Code 上愉快地使用国内大模型了!

二、接入国内主流编程大模型

国内大模型虽然和Claude模型相比有一点差距,但是应对普通场景,足够胜任了,并且完成的非常好,关键是便宜!

使用原则是:复杂度高的场景,使用Claude接口来完成,普通场景,使用国内大模型,claude 和 国内大模型轮换着用,有效控制成本!

一)deepseek-v3.1

2025年08月21日,deepseek悄悄发布 DeepSeek V3.1,具体更新了啥,可以看官方文档:DeepSeek-V3.1 发布

这里只关注和本文有关的信息:

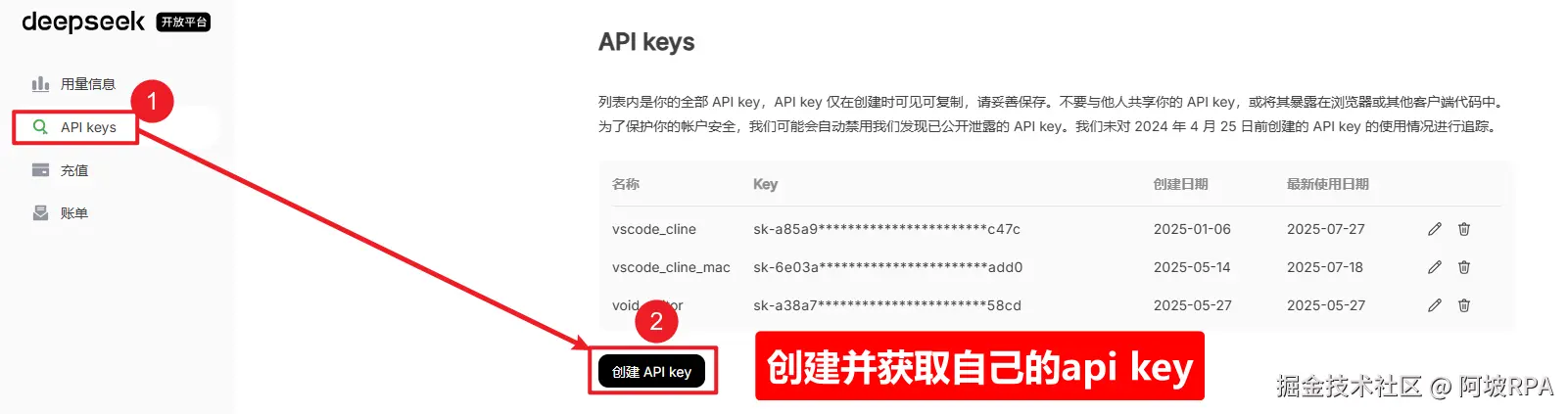

1、获取deepseek的api key

注册账号并获取自己的api key

2、获取接口配置信息

deepseek v3.1 官方是支持接入 Claude Code ,教程:api-docs.deepseek.com/zh-cn/guide...

我这里讲重点信息提炼出来,大家直接复制到自己用户目录下的 .claude/settings.json 文件内即可:

json

{

"env": {

"ANTHROPIC_BASE_URL": "https://api.deepseek.com/anthropic",

"ANTHROPIC_AUTH_TOKEN": "你的API KEY",

"ANTHROPIC_MODEL": "deepseek-reasoner",

"ANTHROPIC_SMALL_FAST_MODEL": "deepseek-reasoner"

}

}二)Qwen3-coder

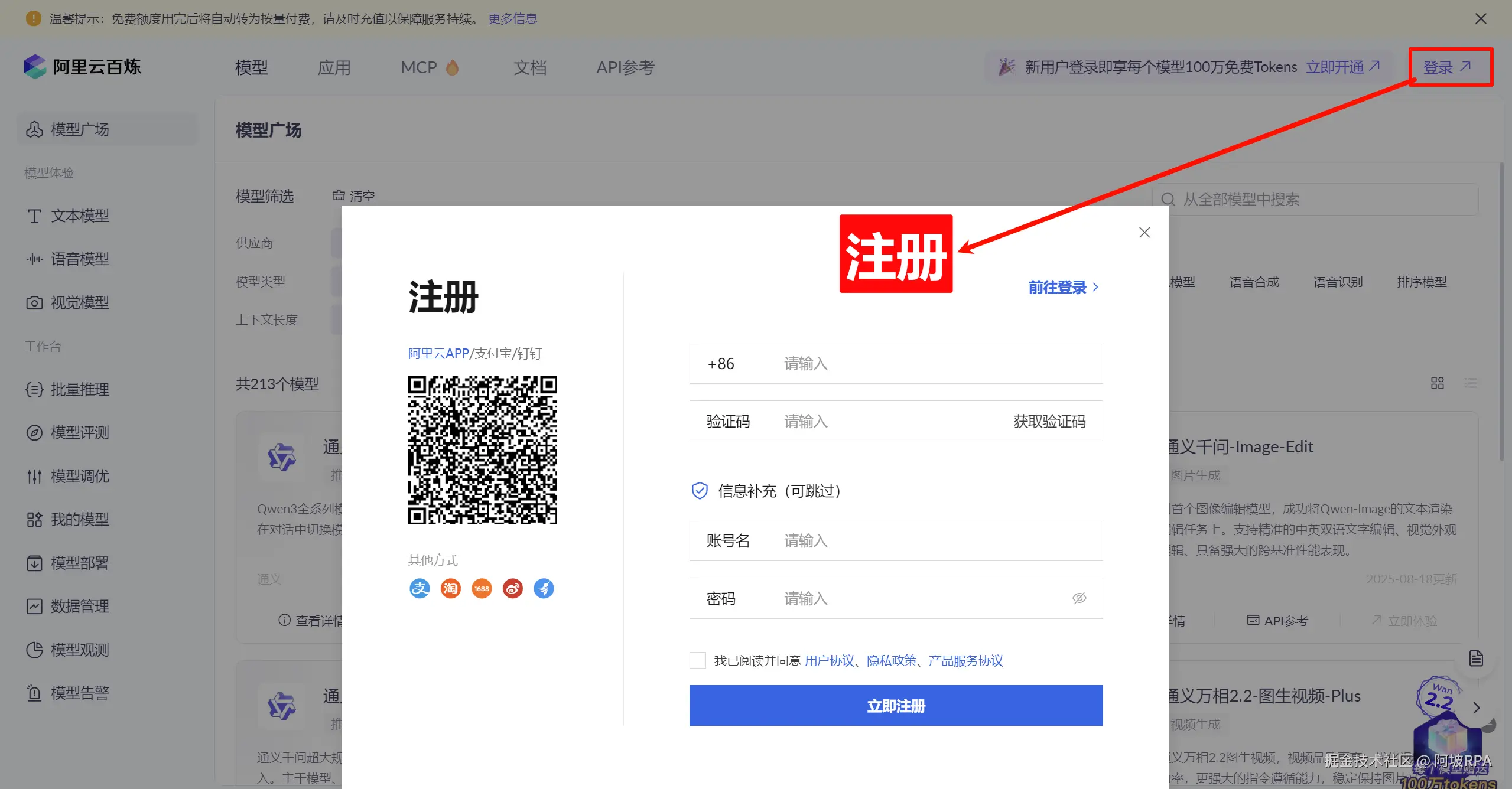

1、注册一个阿里的账号

地址:bailian.console.aliyun.com/?tab=model#...

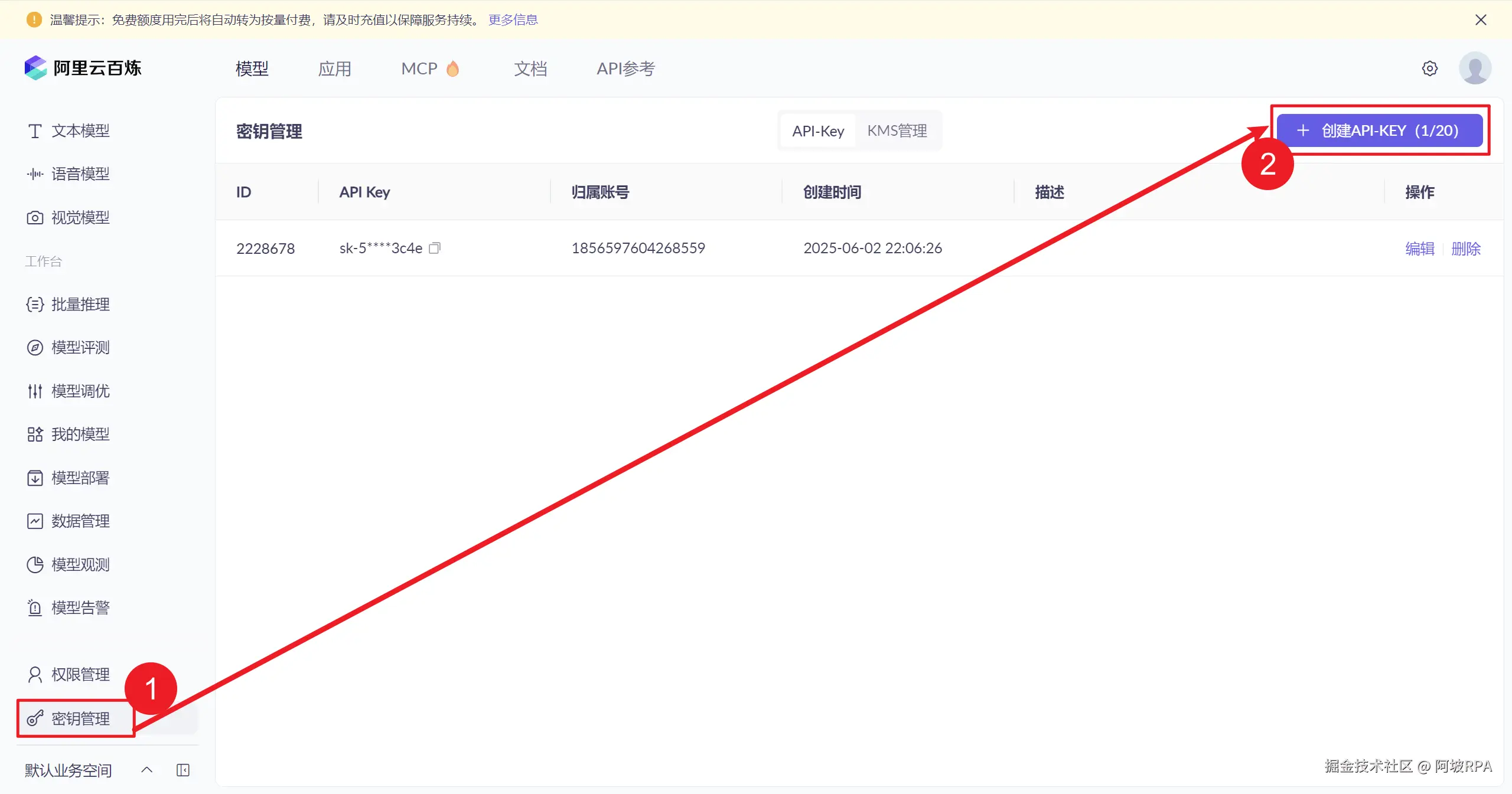

2、创建API KEY

3、接口配置信息获取

百炼官方文档有讲如何讲api接入 claude code ,地址:bailian.console.aliyun.com/?tab=doc#/d...

我这里讲重点信息提炼出来,大家直接复制即可:

json

{

"env": {

"ANTHROPIC_BASE_URL": "https://dashscope.aliyuncs.com/api/v2/apps/claude-code-proxy",

"ANTHROPIC_AUTH_TOKEN": "你的API KEY",

"ANTHROPIC_MODEL": "qwen3-coder-plus",

"ANTHROPIC_SMALL_FAST_MODEL": "qwen3-coder-plus"

}

}Claude Code 界面仅会显示其默认的模型名称( 如 Claude-3-5-haiku 等),而非实际调用的 qwen3-coder-plus,这属于正常现象,可以直接忽略。如果想进一步确认,可以在阿里云百炼的模型观测中查询是否有 qwen3-coder-plus 的调用记录。

请注意:百炼api接入Claude Code 当前仅支持 qwen3-coder-plus,无法通过

ANTHROPIC_MODEL环境变量修改调用模型。

三)智谱GLM 4.5

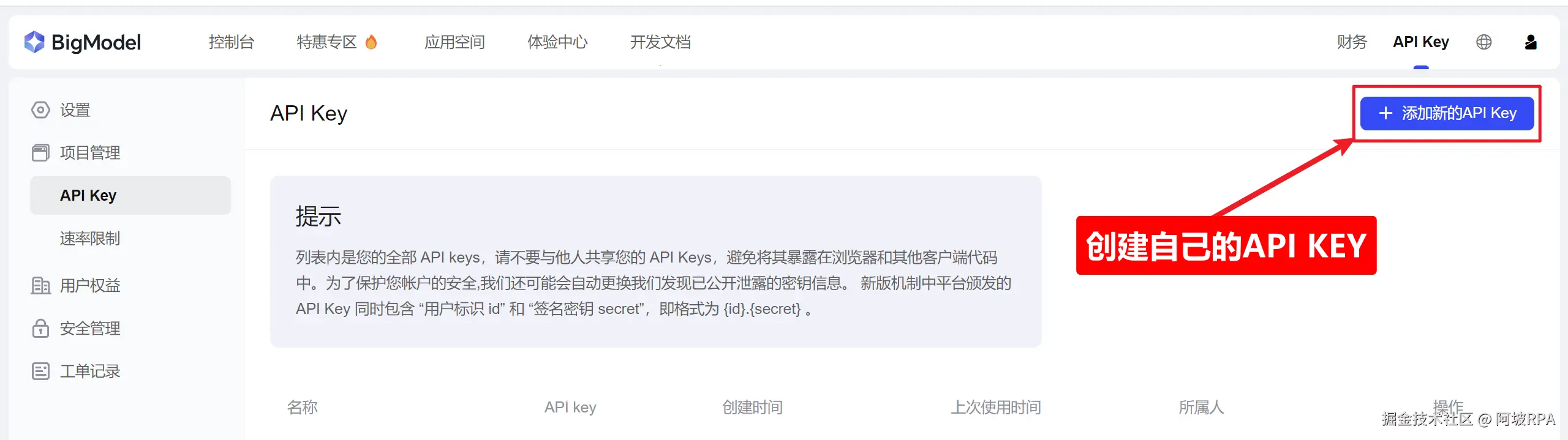

1、注册并获取API KEY

地址:bigmodel.cn/

注册一个账户,进入个人中心页面,或者直达下面地址,来创建自己的 api key:

2、接口配置信息获取

官方也对如何将api接入 Claude Code 写了教程:docs.bigmodel.cn/cn/guide/de...

老规矩,我这里讲重点信息提炼出来,大家直接复制即可:

json

{

"env": {

"ANTHROPIC_BASE_URL": "https://open.bigmodel.cn/api/anthropic",

"ANTHROPIC_AUTH_TOKEN": "你的API KEY"

}

}请注意:默认接口使用的模型为 GLM-4.5 和 GLM-4.5-Air,具体根据任务复杂程度自动路由,也是我们推荐的使用方式,兼顾性能、速度与价格,暂不支持其它模型(如 GLM-4.5-X/AirX/Flash 等),因此,此处不必显式配置具体模型。

四)Kimi K2

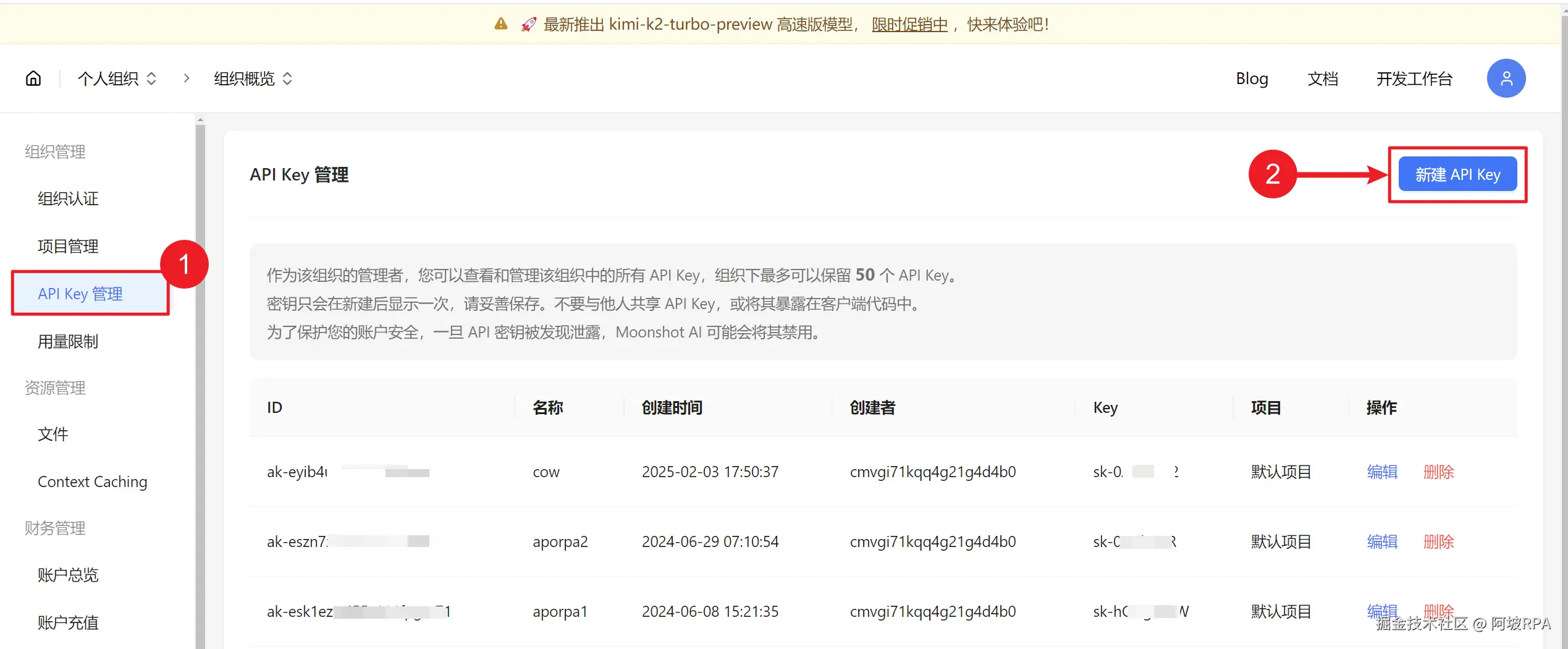

1、注册一个账号

2、创建API KEY

进入API KEY管理页面:platform.moonshot.cn/console/api...

3、接口配置信息获取

官方教程地址:platform.moonshot.cn/docs/guide/...

这里重点信息提炼出来,大家直接复制即可:

json

{

"env": {

"ANTHROPIC_BASE_URL": "https://api.moonshot.cn/anthropic",

"ANTHROPIC_AUTH_TOKEN": "你的API KEY",

"ANTHROPIC_MODEL": "kimi-k2-turbo-preview",

"ANTHROPIC_SMALL_FAST_MODEL": "kimi-k2-turbo-preview"

}

}三、想切换模型怎么办?

讲了这么多,这几家国产大模型我都注册了,想切换着用怎么办?

目前 Claude Code 并不支持添加多个自定义模型,大家可以参考我的方法来切换模型使用,大家若有更好的方法也欢迎评论区告诉我:

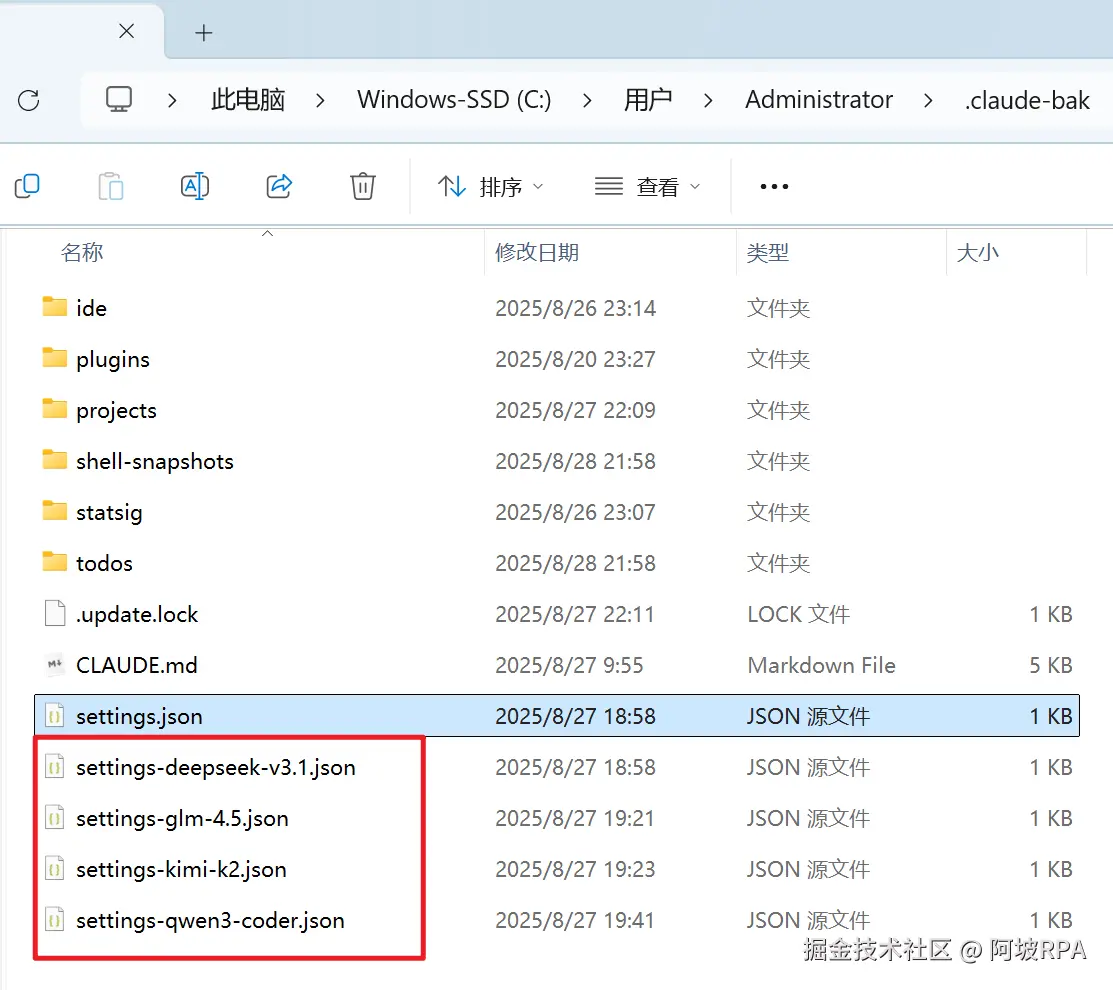

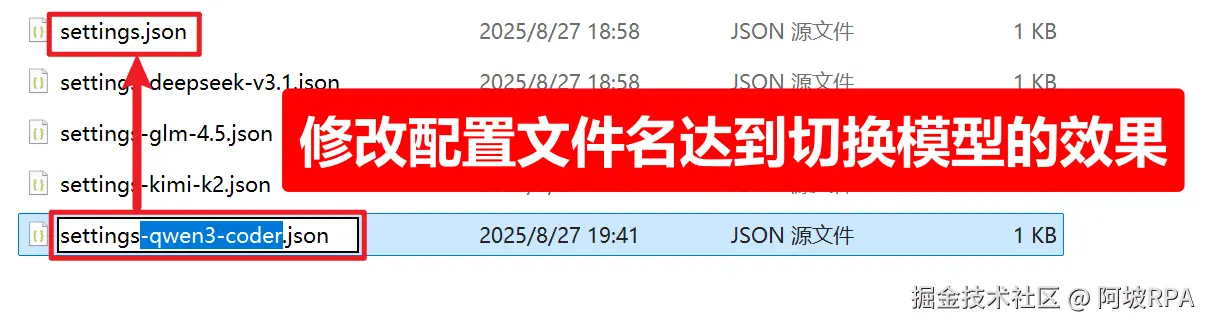

一)每个模型配置一个文件

通过配置文件配置大模型的,可以先将每个模型配置一个文件:

二)切换模型

希望用哪个大模型的话,可以通过切换文件名来达到切换模型的效果,不过记得切换完配置文件,记得重启claude,配置才能生效!

好啦,以上就是关于在 Claude Code 中接入 DeepSeek、Qwen3-Coder、GLM-4.5 和 Kimi K2 这四款主流国产编程大模型的完整教程了。

灵活搭配不同模型处理不同任务,既能享受 Claude 级别的代码能力,又能用好国内模型的免费额度和高性价比,开发效率直接拉满!

有任何问题,欢迎滴滴我: ao-ai-coding