引言:预见未来,代码为证

每年的苹果全球开发者大会(WWDC)都是一场技术风暴的前夜,预示着未来一年甚至数年的开发范式变革。WWDC24已经为我们勾勒出了以Apple Intelligence为核心的宏大蓝图,而WWDC25必将在此基础上,将人工智能、空间计算和系统级框架深度融合,推向一个新的高峰。

本文将基于苹果现有的技术轨迹和行业趋势,对WWDC25可能发布的"开发秘技"进行前瞻性揭秘。我们将不仅仅停留在理论层面,而是通过实战代码 、清晰的Mermaid流程图 、高效的Prompt示例 和技术架构图,带你提前窥探并掌握下一代苹果生态开发的精髓。从Swift 6的并发革命,到RealityKit 3的沉浸世界,再到Xcode的革命性AI辅助编程,让我们开始这场探索之旅。

第一章:核心语言与工具的革命 - Swift 6与Xcode 17

1.1 Swift 6:并发范式的最终章与所有权宏

WWDC25将是Swift 6正式亮相的舞台。它不仅是语法上的迭代,更是一次从"现代语言"向"下一代系统级语言"的跃迁。

秘技一:完全数据隔离(Full Data Isolation)与并发安全

Swift 6将彻底完成Swift Concurrency的愿景,引入"完全数据隔离",确保编译时即可捕获数据竞争,而不是在运行时崩溃。

代码示例:@MainActor与nonisolated的深化

swift

// WWDC25 Swift 6 预测代码

// 定义一个严格运行在主线程的数据模型

@MainActor

class StrictUserProfile: ObservableObject {

@Published var name: String = "John Appleseed"

@Published var age: Int = 30

// 这个更新方法隐式地运行在主线程

func updateName(to newName: String) {

name = newName

}

// 一个‘nonisolated’的 computed property,表示它不会触及隔离数据,可以在任何线程安全访问

nonisolated var formattedProfile: String {

return "A profile instance" // 这里不能访问 `name` 或 `age`,否则编译报错!

}

// 一个需要访问数据但希望异步调用的方法,必须明确标注为异步

func updateAgeAsync(newAge: Int) async {

// 因为方法是 `async`,Swift 会自动将其调度到 MainActor 上

age = newAge

}

}

// 在其他非主线程的上下文中使用

Task {

let profile = StrictUserProfile()

await profile.updateName(to: "Jane Appleseed") // 必须 'await',确保主线程安全

print(profile.formattedProfile) // 无需 'await',因为 'nonisolated'

await profile.updateAgeAsync(newAge: 31)

}这段代码展示了Swift 6中MainActor的使用将更加严格和直观,编译器会强制执行线程安全。

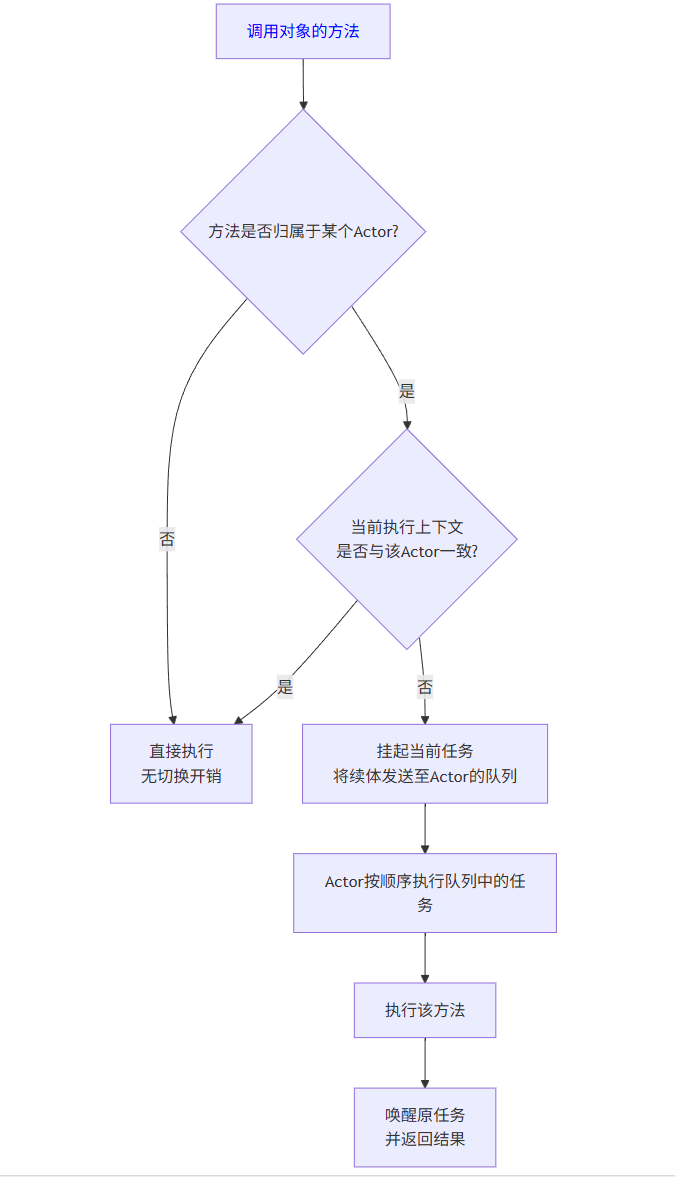

Mermaid流程图:Swift 6并发方法调用决策流

flowchart TD

A[调用对象的方法] --> B{方法是否归属于某个Actor?}

B -- 否 --> C[直接执行<br>无切换开销]

B -- 是 --> D{当前执行上下文<br>是否与该Actor一致?}

D -- 是 --> C

D -- 否 --> E[挂起当前任务<br>将续体发送至Actor的队列]

E --> F[Actor按顺序执行队列中的任务]

F --> G[执行该方法]

G --> H[唤醒原任务<br>并返回结果]

该流程图清晰地展示了Swift Concurrency底层如何智能地处理Actor之间的线程切换,开发者无需手动管理,既安全又高效。

秘技二:所有权宏(Ownership Macros)

Swift可能会引入类似于Rust的所有权系统,但通过宏(Macros)来实现,为性能敏感的代码提供无垃圾回收的内存管理能力。

代码示例:预测性的~Copyable宏

swift

// 预测代码:定义一个不可复制、只能移动的缓冲区

@~Copyable

struct Buffer {

private var pointer: UnsafeMutableRawPointer

private var size: Int

init(size: Int) {

self.size = size

pointer = UnsafeMutableRawPointer.allocate(byteCount: size, alignment: 1)

}

// 析构器负责释放内存

deinit {

pointer.deallocate()

}

// 定义一个‘ consuming ’方法,表示调用后self失效

consuming func consume() -> [UInt8] {

let bytes = Array(UnsafeMutableBufferPointer(start: pointer.bindMemory(to: UInt8.self, capacity: size), count: size))

pointer = nil // 使自身无效,防止重复释放

return bytes

}

}

// 使用方式

func processData() {

var uniqueBuffer = Buffer(size: 1024)

// let anotherBuffer = uniqueBuffer // ❌ 编译错误:'Buffer' 是不可复制的

let data = uniqueBuffer.consume() // ✅ 移动所有权

// print(uniqueBuffer.size) // ❌ 编译错误:'uniqueBuffer' 在此之后已失效

}此特性将极大增强Swift在系统编程、游戏引擎、高频交易等领域的应用能力,同时保持高级语言的安全性。

1.2 Xcode 17:AI原生开发环境

Xcode 17将深度集成Apple Intelligence,成为一个真正的AI结对编程伙伴(AI Pair Programmer)。

Prompt示例:与Xcode智能对话

| 你的目标 (Goal) | 高效的Prompt示例 (Effective Prompt) | 低效的Prompt示例 (Ineffective Prompt) |

|---|---|---|

| 代码生成 | "为SwiftUI创建一个视图,显示一个从网络获取的用户列表。使用AsyncImage显示用户头像,列表有下拉刷新功能。" |

"做个用户列表" |

| 代码解释 | "解释下面reduce方法的工作原理:[粘贴代码片段]" |

"这代码干嘛的?" |

| 错误修复 | "分析这个编译错误:'Type '()' cannot conform to 'View''。在我的Button的action闭包里,我漏写了什么?" |

"代码错了,修一下。" |

| 代码优化 | "重构下面这个dataFetching方法,使用新的Swift Concurrency替代传统的 completion handler。[粘贴代码]" |

"让这代码更好" |

| UI设计建议 | "为我的健康饮食App的'食谱详情页'提供三个符合iOS设计规范的UI布局创意。" | "做个好看的页面" |

图表:Xcode 17 AI工作流

text

[用户输入自然语言Prompt]

|

v

[Xcode AI引擎解析意图]

|

+--> [检索API文档 & 示例代码库]

|

+--> [分析项目上下文 & 现有代码]

|

+--> [生成代码建议 & 解释]

|

v

[用户选择、审核并插入代码]Xcode AI不再是简单的代码补全,而是基于对整个项目上下文、官方最佳实践和海量代码库的理解,提供智慧的、上下文相关的建议。

第二章:空间计算2.0 - visionOS与RealityKit 3

WWDC25将是visionOS成熟化的关键节点,开发体验将从"探索"转向"深耕"。

2.1 共享空间(Shared Space)API

多用户协作是空间计算的杀手锏。苹果将开放更强大的Shared Space API,让多个用户无缝地在同一个虚拟空间中交互。

代码示例:预测性的多用户体验

swift

// WWDC25 visionOS 预测代码

import RealityKit

import MultipeerConnectivity

@MainActor

class SharedSessionManager: ObservableObject {

private let session: NetworkSession // 预测的新网络会话API

@Published var connectedPeers: [PeerID] = []

@Published var sharedEntities: [Entity] = []

init() {

session = NetworkSession(serviceType: "myapp-shared-space")

session.delegate = self

}

func placeSharedObject(model: Entity, at position: SIMD3<Float>) {

// 1. 在本地放置实体

let anchor = AnchorEntity(world: position)

anchor.addChild(model)

arView.scene.addAnchor(anchor)

// 2. 序列化实体数据(类型、位置、方向等)

let objectData = encodeEntityData(model)

// 3. 通过会话广播给所有连接的设备

session.send(data: objectData, to: .allPeers, reliably: true)

}

}

extension SharedSessionManager: NetworkSessionDelegate {

// 收到其他用户放置对象的消息

func session(_ session: NetworkSession, didReceiveData data: Data, from peer: PeerID) {

let entityData = decodeEntityData(data)

let entity = createEntity(from: entityData)

// 在所有参与者(包括自己)的同一世界坐标位置渲染该实体

let anchor = AnchorEntity(world: entityData.position)

anchor.addChild(entity)

arView.scene.addAnchor(anchor)

sharedEntities.append(entity)

}

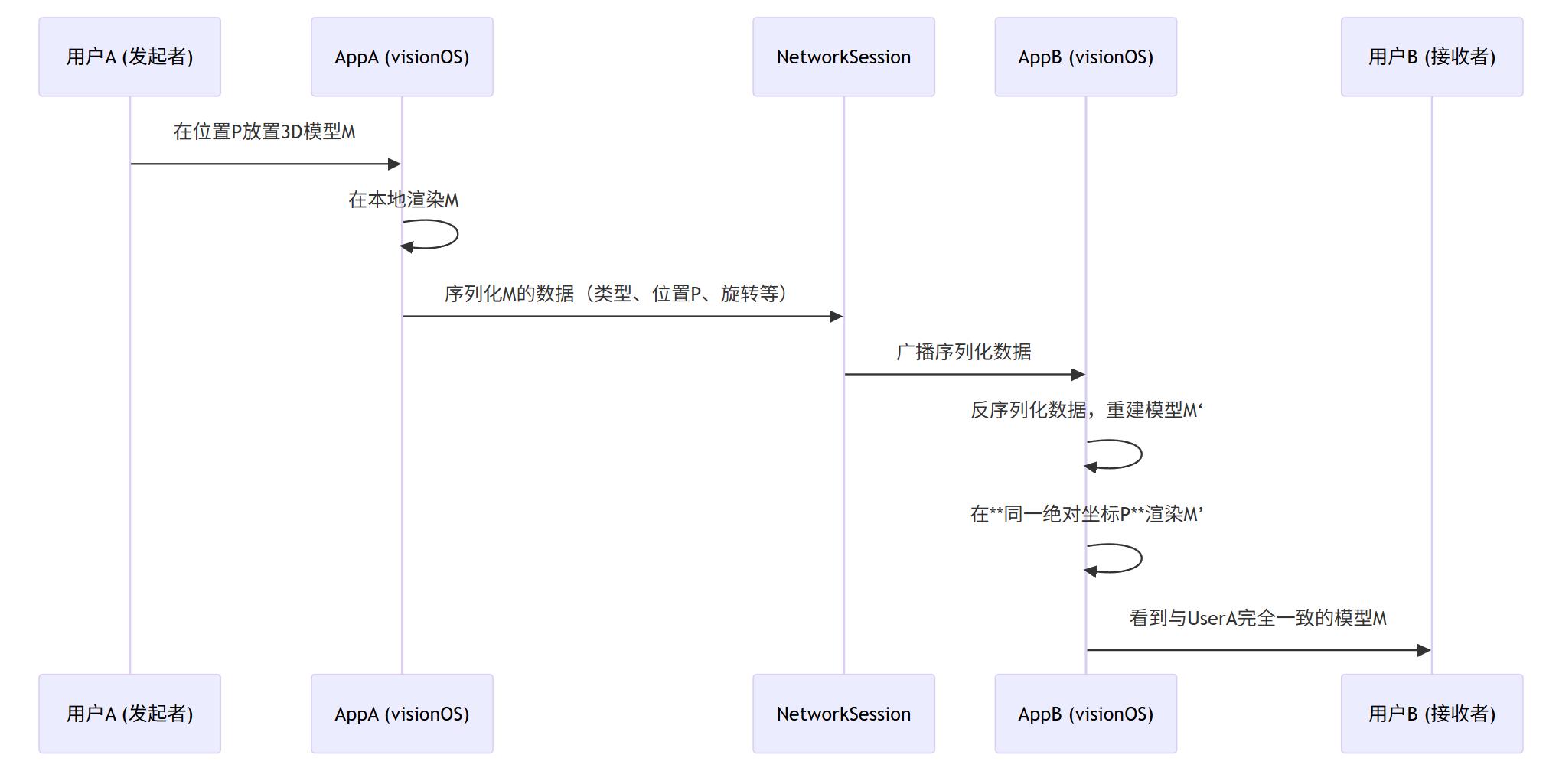

}Mermaid流程图:多用户对象同步

sequenceDiagram

participant UserA as 用户A (发起者)

participant AppA as AppA (visionOS)

participant NetworkSession

participant AppB as AppB (visionOS)

participant UserB as 用户B (接收者)

UserA->>AppA: 在位置P放置3D模型M

AppA->>AppA: 在本地渲染M

AppA->>NetworkSession: 序列化M的数据(类型、位置P、旋转等)

NetworkSession->>AppB: 广播序列化数据

AppB->>AppB: 反序列化数据,重建模型M‘

AppB->>AppB: 在**同一绝对坐标P**渲染M’

AppB->>UserB: 看到与UserA完全一致的模型M

该序列图揭示了低延迟、高保真的空间同步背后的核心流程,确保所有用户共享"一个真相"。

2.2 RealityKit 3:动态场景与物理增强

RealityKit 3将引入更强大的物理引擎和动态光照系统,让虚拟世界更加逼真和可交互。

秘技:程序化网格生成与破坏效果

代码示例:预测性的动态几何体创建

swift

// 预测代码:使用新的ProceduralMeshComponent创建地形

import RealityKit

func generateProceduralTerrain(width: Int, depth: Int, heightScale: Float) -> Entity {

var meshDescriptors: [MeshDescriptor] = []

var heights: [Float] = .init(repeating: 0, count: width * depth)

// 1. 使用噪声函数生成高度图

for z in 0..<depth {

for x in 0..<width {

let index = z * width + x

let noiseValue = perlinNoise(x: Float(x), y: Float(z)) // 假设的噪声函数

heights[index] = noiseValue * heightScale

}

}

// 2. 创建网格描述符(WWDC25新API预测)

let terrainDescriptor = MeshDescriptor.generateTerrain(

width: width,

depth: depth,

heights: heights

)

meshDescriptors.append(terrainDescriptor)

// 3. 创建模型实体

var material = PhysicallyBasedMaterial()

material.baseColor = .texture(try! .load(named: "grass.jpg"))

material.roughness = 0.8

let meshResource = try! MeshResource.generate(from: meshDescriptors)

let modelEntity = ModelEntity(mesh: meshResource, materials: [material])

// 4. 添加碰撞体和物理体

modelEntity.collision = CollisionComponent(shapes: [.generateConvex(from: meshResource)])

modelEntity.physicsBody = PhysicsBodyComponent(mode: .static)

return modelEntity

}

// 在ARView中添加地形

let terrain = generateProceduralTerrain(width: 100, depth: 100, heightScale: 2.0)

let anchor = AnchorEntity(world: [0, -5, 0])

anchor.addChild(terrain)

arView.scene.addAnchor(anchor)此代码预测了通过API直接生成复杂动态网格的能力,为游戏和模拟应用打开大门。

第三章:AI无处不在 - 设备端大模型与新框架

Apple Intelligence的核心是设备端运行的高效大语言模型(LLM)。WWDC25将向开发者开放更多与此相关的API。

3.1 App Intents框架强化

App Intents将成为集成系统级AI功能的核心桥梁。

代码示例:深度AI集成

swift

// WWDC25 预测代码:自定义AI动作

import AppIntents

struct GenerateRecipeImageIntent: AppIntent {

static var title: LocalizedStringResource = "Generate Recipe Image"

static var description = IntentDescription("Generates an image of a dish based on its name.")

@Parameter(title: "Dish Name")

var dishName: String

// 预测:声明需要调用Image Generation服务

@RequiresService(type: ImageGenerationService.self)

var imageGenService

func perform() async throws -> some IntentResult & ReturnsValue<IntentFile> {

// 1. 调用设备端或私密云端的AI图像生成服务

let generatedImage = try await imageGenService.generateImage(withPrompt: "A professional photo of \(dishName)")

// 2. 将图像保存到临时文件

let imageData = generatedImage.pngData()!

let tempURL = FileManager.default.temporaryDirectory.appendingPathComponent(UUID().uuidString).appendingPathExtension("png")

try imageData.write(to: tempURL)

// 3. 返回IntentFile结果,可供Shortcuts或其他系统功能使用

return .result(value: IntentFile(fileURL: tempURL))

}

}通过App Intents,你的应用功能可以成为系统AI"大脑"的一部分,被Siri、快捷指令等全局调用。

3.2 设备端ML模型微调

Core ML将引入新工具,允许开发者在保护隐私的前提下,利用用户设备上的数据对预训练模型进行轻量级微调(Fine-Tuning)。

图表:设备端微调流程

text

[开发者提供基础模型(.mlpackage)]

|

v

[应用运行,安全地收集匿名化/本地化数据]

|

v

[Core ML引擎在设备上运行<br>差分隐私保护的微调算法]

|

v

[生成用户个性化的模型副本<br>(永远不上传云端)]

|

v

[应用使用个性化模型提供更精准的服务]这一特性对于个性化推荐、健康分析等场景具有革命性意义,真正实现了"AI为你而生",且隐私无忧。

第四章:跨平台统一与性能新纪元

4.1 SwiftUI 5:真正的"一次编写,随处运行"

SwiftUI将进一步弥合iOS、macOS、visionOS和watchOS之间的差距,并引入强大的新功能。

秘技:3D集成与高级效果

代码示例:在SwiftUI视图中嵌入3D模型

swift

// WWDC25 SwiftUI 预测代码

import SwiftUI

import RealityKit

struct ProductView: View {

var body: some View {

VStack {

Text("Magical Widget Pro")

.font(.title)

// 预测:原生SwiftUI 3D视图修饰符

RealityView { scene in

// 异步加载USDZ模型

if let model = try? await ModelEntity.load(named: "widget_pro.usdz") {

scene.addAnchor(model)

}

}

.frame(height: 300)

.cornerRadius(20)

.hoverEffect() // 在Mac和Vision Pro上提供悬停反馈

// 预测:跨平台一致的3D旋转手势

.rotation3DEffect(.degrees(rotationAngle), axis: (x: 0, y: 1, y: 0))

.gesture(

DragGesture()

.onChanged { value in

rotationAngle += value.translation.width

}

)

Button("Add to AR Room") {

// 使用上一章提到的SharedSessionManager分享此模型

sharedSessionManager.placeSharedObject(model: model, at: [0,0,-1])

}

}

}

}SwiftUI 5将使得嵌入交互式3D内容变得像显示一张图片一样简单,极大降低了空间计算的开发门槛。

4.2 Metal 4:为Apple Silicon与AI终极优化

Metal将进一步释放M系列芯片的潜力,专注于AI计算和光线追踪。

图表:Metal 4 AI推理流水线 vs. 传统流程

text

传统通用GPU推理:

[CPU准备数据] -> [GPU等待] -> [GPU执行内核] -> [CPU等待结果] -> [CPU处理结果]

Metal 4 预测的AI流水线:

[GPU与AI引擎协同准备数据] -> [AI专用加速器执行模型推理] -> [GPU后处理结果(着色等)]这种深度异构计算将带来极致的AI推理性能和能效,让复杂的实时AI效果在移动设备上成为可能。

结论:拥抱变化,持续学习

WWDC25所揭示的"开发秘技",其核心脉络清晰可见:AI原生(AI-Native) 、空间融合(Spatial Integration) 和隐私至上(Privacy-Preserving)。这不仅是技术的迭代,更是开发理念的升级。

对于开发者而言,这意味着:

-

深化Swift语言知识:尤其是Swift Concurrency和可能到来的所有权模型,这是未来性能和安全的基础。

-

拥抱声明式UI与跨平台思维:SwiftUI是未来,投资SwiftUI就是投资所有苹果平台。

-

学习AI与ML集成:无需成为数据科学家,但要学会如何利用设备端AI能力增强你的应用。

-

探索空间计算设计范式:思考如何为无边界画布设计应用,如何利用深度、尺度和共享体验。

未来的代码,将是与AI协作写成、在三维空间中运行、并安全地守护着用户每一个比特数据的代码。WWDC25将是我们迈向这个未来的关键一步。现在,就是开始准备的最佳时机。