今天给大家演示一个结合 ControlNet 深度信息的 ComfyUI 建筑可视化工作流。整个流程通过引入建筑专用的权重模型和深度控制网络,使得生成的建筑图像不仅具备高质量和超写实的细节,还能精确遵循输入图片的结构特征。在这个案例中,模型加载、文本条件、深度控制以及最终图像生成保存环环相扣,构建出一个完整的高效工作流,能够帮助用户实现从文本到图像的精准建筑表现。

文章目录

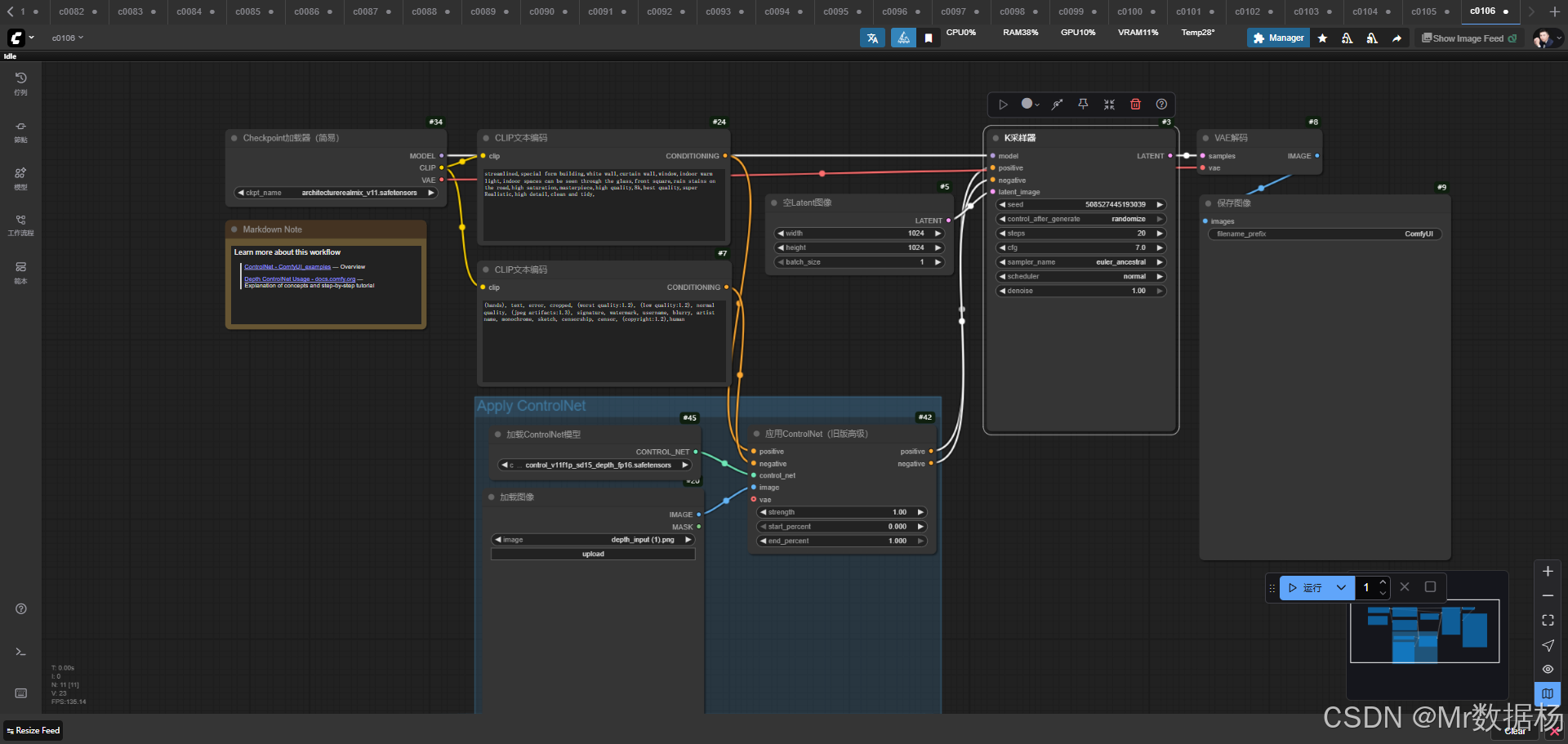

工作流介绍

在该工作流中,核心的建筑混合模型与深度 ControlNet 共同发挥作用。CheckpointLoaderSimple 节点负责加载 architecturerealmix_v11.safetensors,这一模型针对建筑风格进行了专门优化,结合 CLIP 编码后的文本提示与负面提示输入,确保图像生成方向符合预期。ControlNetLoader 与 ControlNetApplyAdvanced 节点则为整个流程引入深度约束,使生成的画面精准保持输入图像的空间结构。通过 EmptyLatentImage 初始化潜空间,再由 KSampler 进行迭代采样,最终由 VAEDecode 解码成高质量图像并保存输出。整体来看,这一工作流充分体现了 ComfyUI 在灵活调度模型与节点方面的优势。

核心模型

在核心模型部分,本工作流采用了 architecturerealmix_v11.safetensors 作为主力模型,该模型适用于建筑类生成任务,能够在细节表现与写实风格之间保持平衡。同时结合 control_v11f1p_sd15_depth_fp16.safetensors 深度控制模型,使生成结果能够遵循输入图像的深度结构特征,确保最终建筑影像不仅美观而且真实可靠。

| 模型名称 | 说明 |

|---|---|

| architecturerealmix_v11.safetensors | 针对建筑风格优化的核心生成模型,保证细节与写实感 |

| control_v11f1p_sd15_depth_fp16.safetensors | 基于深度信息的 ControlNet 模型,用于约束生成图像的空间结构 |

Node节点

在节点层面,本工作流通过 CheckpointLoaderSimple 加载核心模型及 VAE 与 CLIP,利用 CLIPTextEncode 编码正向与负向提示词,再由 ControlNetLoader 和 ControlNetApplyAdvanced 将深度图像与条件信息融合,形成受控的生成语境。随后通过 EmptyLatentImage 初始化潜空间,KSampler 对潜变量进行迭代采样,最后由 VAEDecode 将潜空间结果转化为可见图像,并通过 SaveImage 节点完成落地。整个节点链路紧密配合,实现了从条件设定到结果输出的全流程覆盖。

| 节点名称 | 说明 |

|---|---|

| CheckpointLoaderSimple | 加载核心模型、CLIP 和 VAE |

| CLIPTextEncode | 编码正向与负向提示词 |

| ControlNetLoader | 加载深度 ControlNet 模型 |

| ControlNetApplyAdvanced | 应用 ControlNet 深度约束条件 |

| EmptyLatentImage | 初始化潜空间图像 |

| KSampler | 基于条件和潜变量进行采样生成 |

| VAEDecode | 将潜空间结果解码为图像 |

| SaveImage | 输出并保存最终生成图像 |

工作流程

该工作流的执行流程从模型与输入条件的准备开始,到最终的高质量图像生成结束,环环相扣,形成完整的生成闭环。首先通过 CheckpointLoaderSimple 加载建筑优化的主模型及 CLIP 和 VAE 模块,随后 CLIPTextEncode 节点将用户输入的提示语和负面提示语转化为条件向量。接着,ControlNetLoader 载入深度约束模型,并在 ControlNetApplyAdvanced 节点中结合正负向提示与深度图像信息,将结构约束叠加到生成过程之中。EmptyLatentImage 节点生成初始潜空间,提供图像生成的基础框架。KSampler 则在这一潜空间上依据条件反复采样,使得图像逐步趋近目标效果。最终的潜变量由 VAEDecode 解码为可见图像,并通过 SaveImage 节点导出结果,完成整条生成链路。整个流程实现了从输入到输出的精准控制,兼顾画面质量与结构一致性。

| 流程序号 | 流程阶段 | 工作描述 | 使用节点 |

|---|---|---|---|

| 1 | 模型加载 | 加载建筑专用核心模型及 CLIP、VAE 模块 | CheckpointLoaderSimple |

| 2 | 文本条件设定 | 对提示词与负面提示进行编码生成条件向量 | CLIPTextEncode |

| 3 | 控制约束 | 加载并应用深度 ControlNet,将输入图像的结构信息引入生成流程 | ControlNetLoader / ControlNetApplyAdvanced |

| 4 | 潜空间初始化 | 创建潜空间作为图像生成的基础 | EmptyLatentImage |

| 5 | 迭代采样 | 在潜空间中依据条件进行反复采样优化图像 | KSampler |

| 6 | 图像解码 | 将潜变量解码为清晰可见的图像结果 | VAEDecode |

| 7 | 结果输出 | 输出并保存最终成品图像 | SaveImage |

应用场景

该工作流的应用场景主要聚焦在建筑表现和可视化生成领域。它能够帮助设计师、建筑师或可视化艺术家通过文本提示与深度信息结合,快速生成高质量的建筑图像。用户不仅可以通过正向提示指定风格、光影和细节,还能借助深度图像确保生成结果严格遵循原始结构,使作品既具备艺术表现力又保持真实的空间逻辑。其输出可用于建筑设计初期的概念图、房地产项目的展示效果图,或是游戏、影视中的场景构建。整体来看,这一工作流既适用于专业创作者的高标准需求,也能够满足普通用户在建筑可视化方面的快速生成需求。

| 应用场景 | 使用目标 | 典型用户 | 展示内容 | 实现效果 |

|---|---|---|---|---|

| 建筑设计可视化 | 快速生成建筑概念图 | 建筑师、设计师 | 建筑立面、空间效果 | 精准结构控制下的高质量建筑图像 |

| 房地产展示 | 输出效果图用于项目推广 | 房地产开发商、营销团队 | 小区建筑、商业综合体效果图 | 真实感强、符合结构的宣传图 |

| 数字内容创作 | 用于游戏、影视场景构建 | 游戏美术、影视制作团队 | 虚拟城市、场景背景 | 写实且可控的建筑环境生成 |

开发与应用

更多 AIGC 与 ComfyUI工作流 相关研究学习内容请查阅:

更多内容桌面应用开发和学习文档请查阅:

AIGC工具平台Tauri+Django环境开发,支持局域网使用

AIGC工具平台Tauri+Django常见错误与解决办法

AIGC工具平台Tauri+Django内容生产介绍和使用

AIGC工具平台Tauri+Django开源ComfyUI项目介绍和使用

AIGC工具平台Tauri+Django开源git项目介绍和使用