论文地址:https://arxiv.org/pdf/2503.06671

代码地址:https://github.com/dslisleedh/ESC

关注UP CV缝合怪,分享最计算机视觉新即插即用模块,并提供配套的论文资料与代码。

https://space.bilibili.com/473764881

摘要

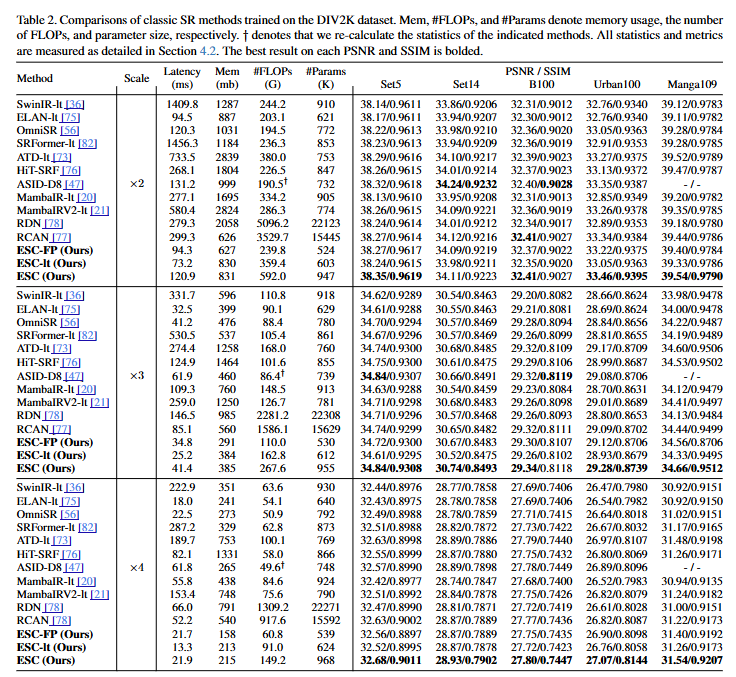

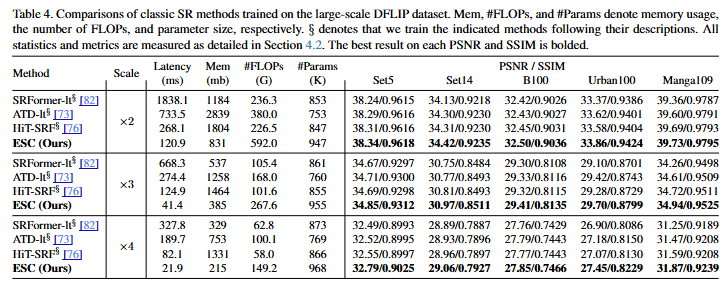

本研究解决了Transformer在高效图像超分辨率(SR)任务中的高计算开销 问题。基于对自注意力层间重复性 的观察,本研究引入了一个名为卷积注意力(ConvAttn)的卷积化自注意力模块,它利用单个共享的大核和动态核 来模拟自注意力的远程建模能力和依赖于实例的加权 。通过利用ConvAttn模块,本研究显著减少了对自注意力及其相关内存密集型操作的依赖 ,同时保持了Transformer的表征能力 。此外,本研究克服了将Flash Attention集成到轻量级SR机制中的挑战 ,有效地缓解了自注意力固有的内存瓶颈 。本研究使用Flash Attention将窗口大小扩展到32×32 ,而不是提出复杂的自注意力模块,在Urban100 ×2上将PSNR显著提高了0.31dB ,同时将延迟和内存使用量分别降低了16倍和12.2倍 。基于这些方法,本研究提出的网络称为ESC(Emulating Self-attention with Convolution) ,与HiT-SRF相比,在Urban100 ×4上PSNR显著提高了0.27dB ,同时延迟和内存使用量分别降低了3.7倍和6.2倍 。大量实验表明,尽管大多数自注意力被ConvAttn模块取代,但本研究的ESC仍然保持了Transformer的远程建模能力、数据可扩展性和表征能力 。

引言

图像超分辨率(SR)旨在从低分辨率(LR)输入重建高分辨率(HR)图像,在计算机视觉领域中仍然是一个活跃的研究方向。随着多媒体内容和生成模型需求的显著增长,SR显得尤为重要,因为它使用户能够在资源受限的条件下享受高质量的内容。因此,实际部署已成为SR任务中的一个关键考虑因素,促使大量SR研究致力于在提高性能的同时降低计算复杂度(浮点运算;FLOPs)和参数大小 。近来,Transformer 在SR任务中获得了极大的关注,因为它们在实现优于卷积神经网络(CNNs)的性能同时,需要更低的FLOPs和更少的参数。通过自注意力机制捕获长距离依赖关系并执行依赖于输入的加权,Transformer展现出强大的表征能力和增强的性能,尤其是在训练数据量增加的情况下。因此,许多基于Transformer的方法被提出,以利用自注意力的优势,同时减少FLOPs和参数数量。

然而,许多工作忽略了由自注意力引起的内存访问开销过高 的问题,这个问题源于分数矩阵(S=QKT)的具体化 以及利用内存密集型操作(如张量重塑和窗口掩码)。在SR架构中,内存访问问题进一步恶化,因为SR架构需要处理没有patchify stem或下采样阶段的大特征图。例如,即使SwinIR-light的FLOPs和参数大小分别比CNNs少14.5倍和17倍,但它在×2尺度上重建高清图像的延迟是CNNs的4.7倍,内存使用量是CNNs的2倍。因此,尽管Transformer具有良好的性能,但它们难以部署在资源受限的设备上,例如消费级GPU。

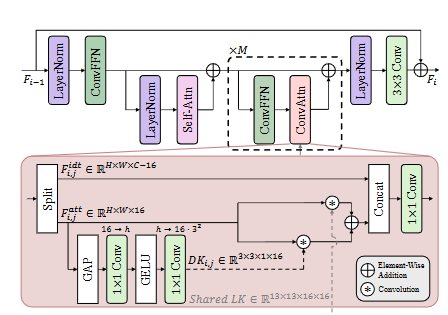

本研究旨在设计一个针对轻量级SR任务的高效Transformer ,在提高性能的同时降低内存开销。本研究首先对自注意力进行了初步分析,观察到自注意力执行的相似性建模和提取的特征在多个层之间保持高度一致。这一发现表明自注意力可能提取了重叠的特征,这意味着可以通过使用高效的替代方案来降低计算开销而不损害表征能力。基于这一发现,本研究建立了一种设计策略,即仅在每个块的第一层保留自注意力,而用本研究提出的高效替代方案------卷积注意力(ConvAttn)模块 ------替换其余层。为了有效地模拟自注意力的长距离建模和依赖于输入的加权,ConvAttn模块采用双重机制运作。首先,它通过在整个网络中应用具有共享的13×13大核的卷积 来简化自注意力的长距离交互,仅针对一部分通道。其次,生成动态核以捕获依赖于输入的加权,模仿自注意力的自适应特性。通过结合这些组件,ConvAttn模块显著减少了对内存密集型自注意力的依赖,同时保持了Transformer的表征能力。

由于大多数自注意力层被ConvAttn取代,本研究利用这种效率来进一步增强剩余的自注意力层。具体来说,本研究增大了自注意力的窗口大小 ,在FLOPs仅略微增加的情况下显著提高了性能。然而,增加窗口大小会导致分数矩阵变大,从而大幅提高峰值内存使用量。为了解决这个问题,本研究将Flash Attention 引入轻量级SR任务中,以避免具体化分数矩阵。本研究优化的实现允许将窗口大小扩展到32×32,同时将延迟和内存使用量分别减少16倍和12.2倍。

论文创新点

🎉 本研究提出了一个名为ESC的高效图像超分辨率网络,旨在解决Transformer高计算开销的问题。 🎉 本研究的创新点如下:

-

✨ 基于卷积的注意力机制(ConvAttn): ✨

- 本研究观察到自注意力机制在不同层之间存在重复提取特征的现象。基于此,本研究设计了ConvAttn模块,该模块使用一个共享的大核卷积和动态卷积来模拟自注意力的长距离建模能力和实例依赖的加权。

- ConvAttn模块的引入显著减少了对自注意力及其相关内存密集型操作的依赖,同时保持了Transformer的表示能力。

-

⚙️ 大核卷积与动态核卷积的结合: ⚙️

- ConvAttn模块采用双重机制有效模拟自注意力。

- 其一,它通过在整个网络中应用共享的13x13大核卷积来简化自注意力的长距离交互,并仅针对部分通道进行操作。

- 其二,它生成动态卷积核以捕获依赖于输入的加权,模拟自注意力的自适应特性。

-

🚀 在轻量级超分辨率任务中成功集成Flash Attention: 🚀

- 本研究将Flash Attention引入到轻量级超分辨率任务中,有效缓解了自注意力固有的内存瓶颈。

- 通过Flash Attention,本研究能够将窗口大小扩展到32x32,而无需设计复杂的自注意力模块,在Urban100 x2数据集上PSNR提升了0.31dB,同时延迟和内存使用量分别降低了16倍和12.2倍。

-

🏗️ 独特的网络结构设计: 🏗️

- ESC网络由浅层特征提取、深层特征提取、图像跳跃连接和上采样模块组成。

- 深层特征提取模块由多个ESC Block构成,每个ESC Block中仅在第一层使用自注意力,其余层均使用ConvAttn模块。

- 这种设计在保持Transformer优势的同时,显著降低了计算成本。

-

🛡️ 保留了Transformer的优点: 🛡️

- 大量的实验表明,尽管大部分自注意力被ConvAttn模块取代,ESC仍然保持了Transformer的长距离建模能力、数据可扩展性和表示能力。

- 通过深入的实验,本研究也进一步证明了ConvAttn模块提取的特征与自注意力相似。

论文实验