Delta Activations: A Representation for Finetuned Large Language Models

Authors: Zhiqiu Xu, Amish Sethi, Mayur Naik, Ser-Nam Lim

Deep-Dive Summary:

Delta Activations: 微调大型语言模型的表示方法

摘要

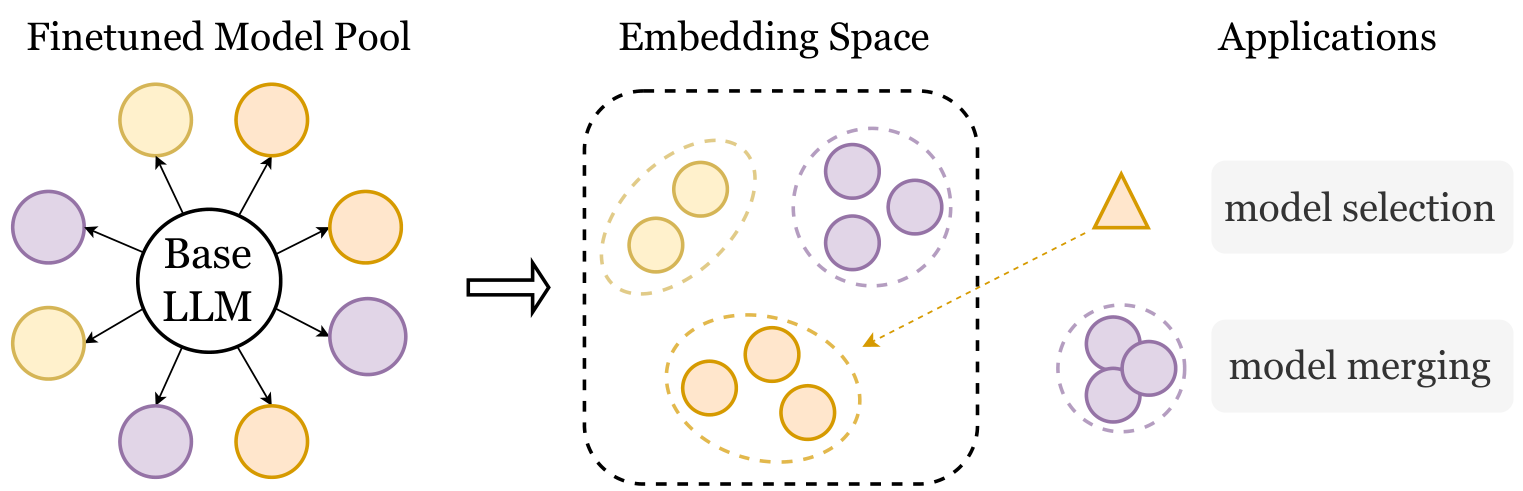

本文介绍了"Delta Activations",一种通过测量微调模型相对于基础模型内部激活状态的变化来将其表示为向量嵌入的方法。这种表示方法能够有效地按领域和任务对模型进行聚类,揭示模型景观中的结构。Delta Activations 还展示了一些理想的特性:它对微调设置具有鲁棒性,并且当微调数据集混合时表现出加性属性。此外,作者展示了 Delta Activations 可以通过少样本微调嵌入任务,并进一步探索了其在模型选择和合并中的应用。作者希望 Delta Activations 能促进重用公开可用模型的实践。代码可在 https://github.com/0scarXzQ/delta_activations 获取。

1 引言

随着强大的预训练大型语言模型(LLMs)如 LLaMA、Gemma、Qwen 和 DeepSeek 的出现,社区已经创建了一个庞大且不断增长的微调模型生态系统。这些模型通过监督微调(SFT)或偏好对齐技术,针对特定任务、领域或人类偏好进行了优化。然而,由于元数据不一致和存储库结构化不足,导航和理解这些模型仍然具有挑战性。作者提出 Delta Activations 方法,通过测量模型内部状态相对于基础模型的变化,将微调模型表示为向量嵌入,从而揭示模型之间的相似性和差异性。

2 表示模型

2.1 问题设置

设 f b a s e f_{base} fbase 为一个预训练的大型语言模型, F = { f 1 , f 2 , . . . , f k } F = \{f_1, f_2, ..., f_k\} F={f1,f2,...,fk} 是一组从 f b a s e f_{base} fbase 通过后训练得到的微调模型。目标是为 F F F 中的每个模型 f f f 构建一个嵌入 V f ∈ R d V_f \in R^d Vf∈Rd,以反映该模型相对于 f b a s e f_{base} fbase 的特化和行为差异。

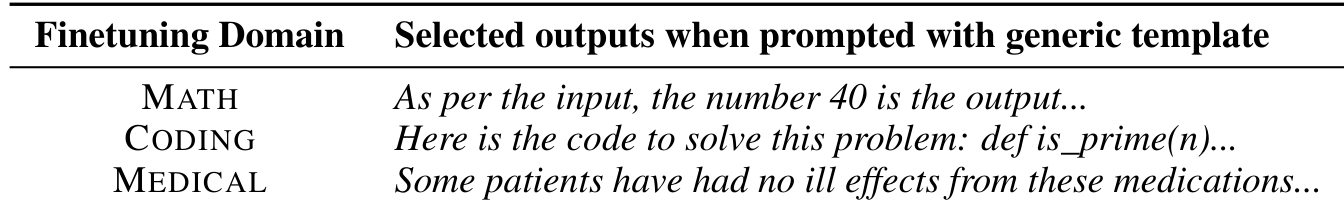

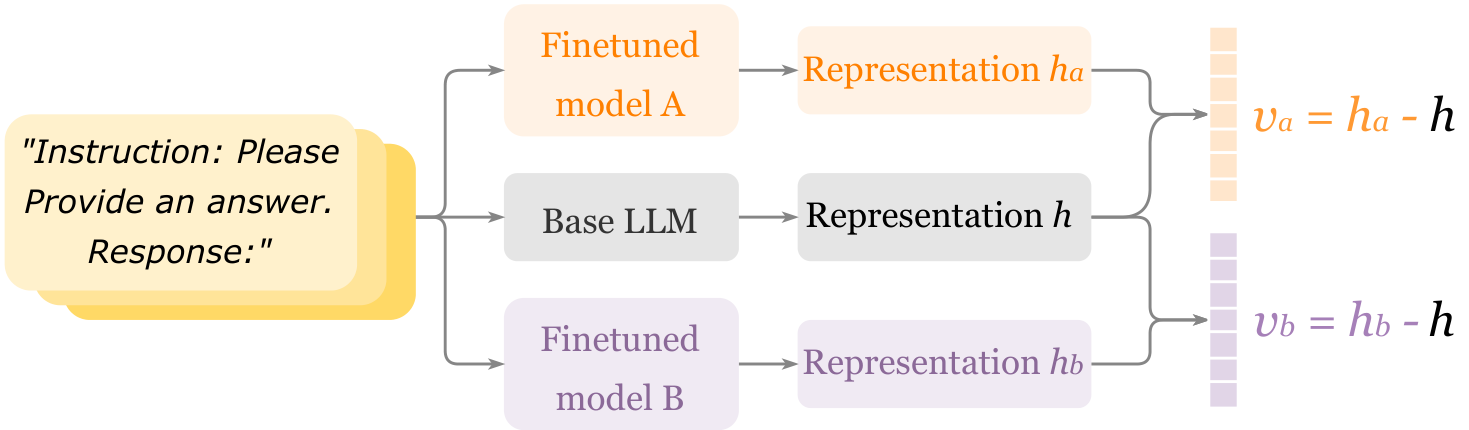

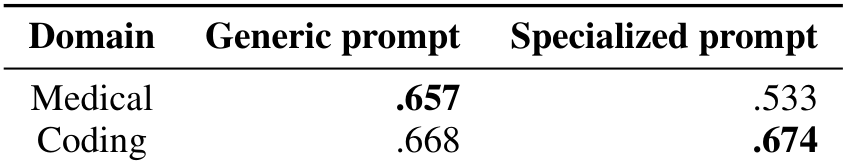

2.3 简单实验

作者对 LLAMA-3.1-8B 在数学、编程和医疗三个领域进行微调,并使用通用模板提示模型。尽管大多数输出如预期那样重复且通用,但作者观察到微调模型偶尔会针对通用指令模板展示其特化行为。这一现象启发了 Delta Activations 方法的开发。

2.4 Delta Activations

Delta Activations 通过测量微调模型与固定基础模型在隐藏状态上的差异,将微调语言模型表示为向量嵌入。具体而言,通过在共享输入序列上比较基础模型和微调模型的隐藏状态来计算 Delta Activations。定义 Delta Activations 为:

Δ f ( x ) = h f ( x ) − h b a s e ( x ) \Delta_f(x) = h_f(x) - h_{base}(x) Δf(x)=hf(x)−hbase(x)

其中 h f ( x ) ∈ R d h_f(x) \in R^d hf(x)∈Rd 表示模型 f f f 在输入 x x x 上的最后一层最后一个 token 的激活值。模型嵌入通过在固定探针数据集 D p r o b e = { x 1 , x 2 , . . . , x N } D_{probe} = \{x_1, x_2, ..., x_N\} Dprobe={x1,x2,...,xN} 上聚合 Delta Activations 得到:

V f = 1 N ∑ i = 1 N Δ f ( x i ) V_f = \frac{1}{N} \sum_{i=1}^{N} \Delta_f(x_i) Vf=N1i=1∑NΔf(xi)

3 实验

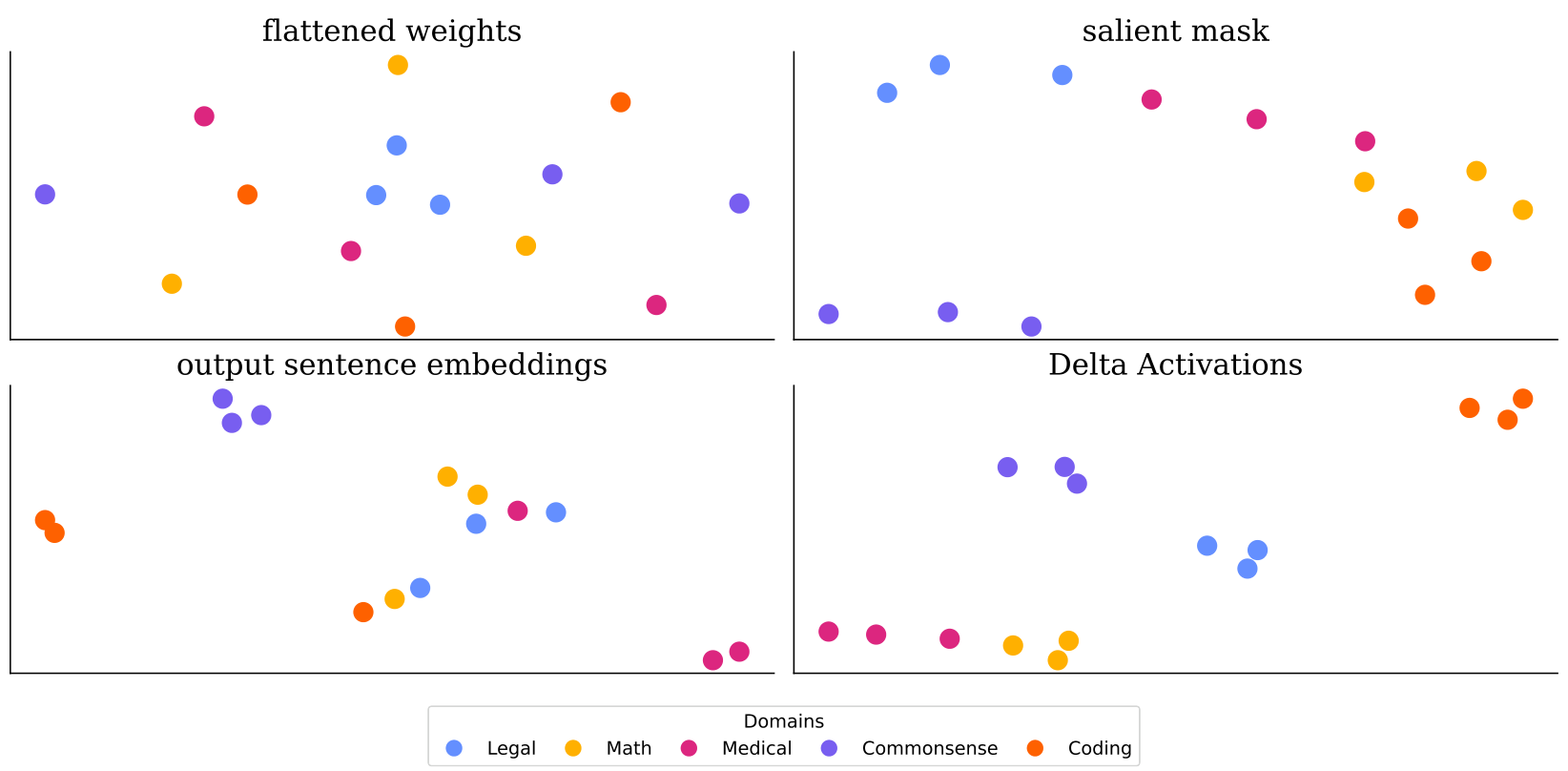

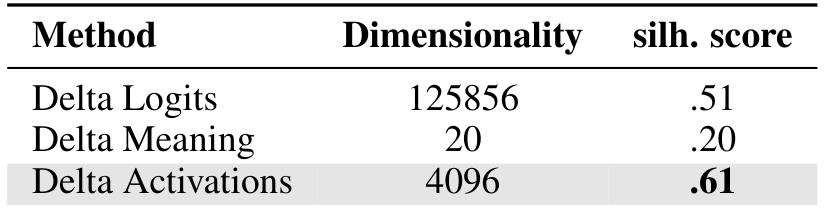

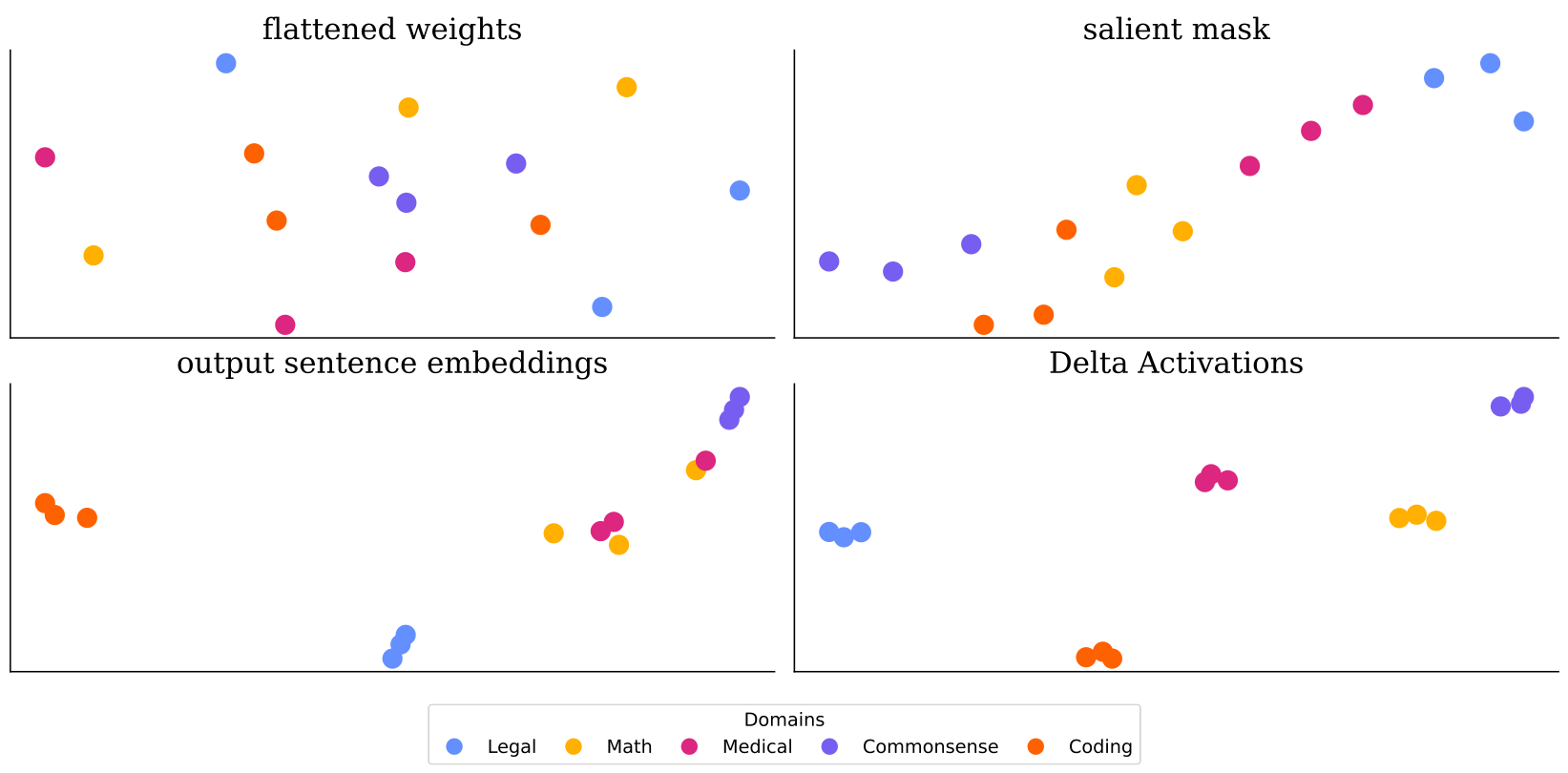

3.1 Delta Activations 作为模型嵌入

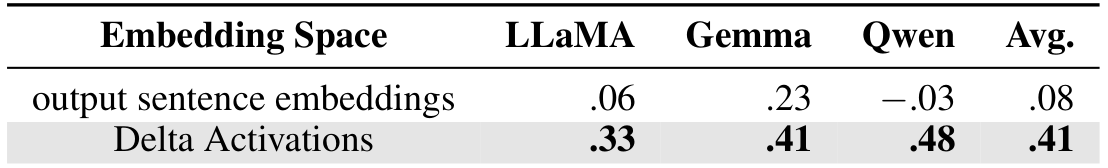

作者构建了三个模型池,分别基于 LLAMA-3.1-8B、GEMMA-2-9B 和 QwEN-2.5-7B,每个池包含 15 个微调模型,覆盖法律、数学、医疗、常识和编程五个领域。实验结果表明,Delta Activations 在所有骨干模型上均实现了最强的聚类性能。

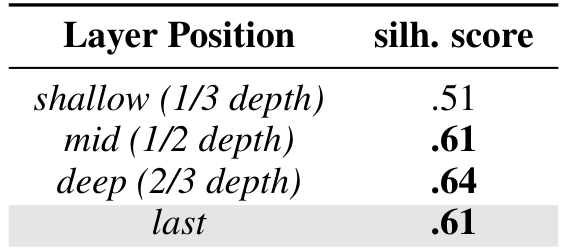

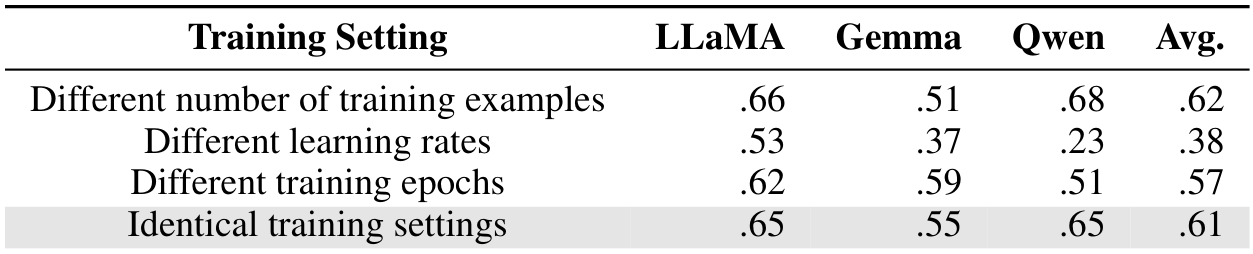

3.2 理解 Delta Activations

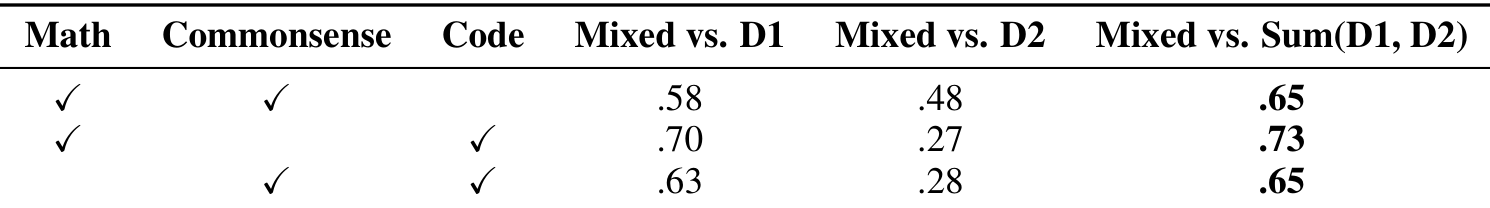

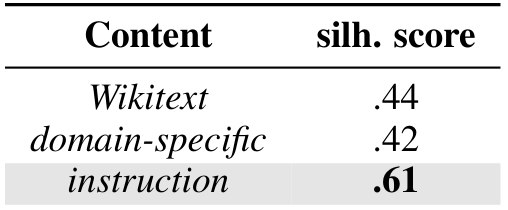

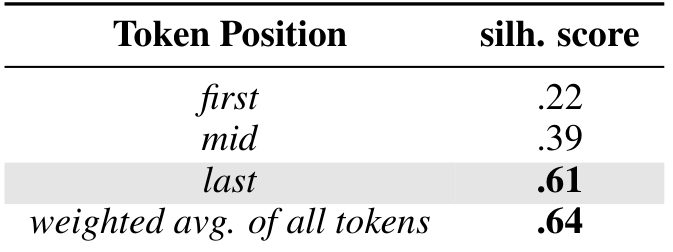

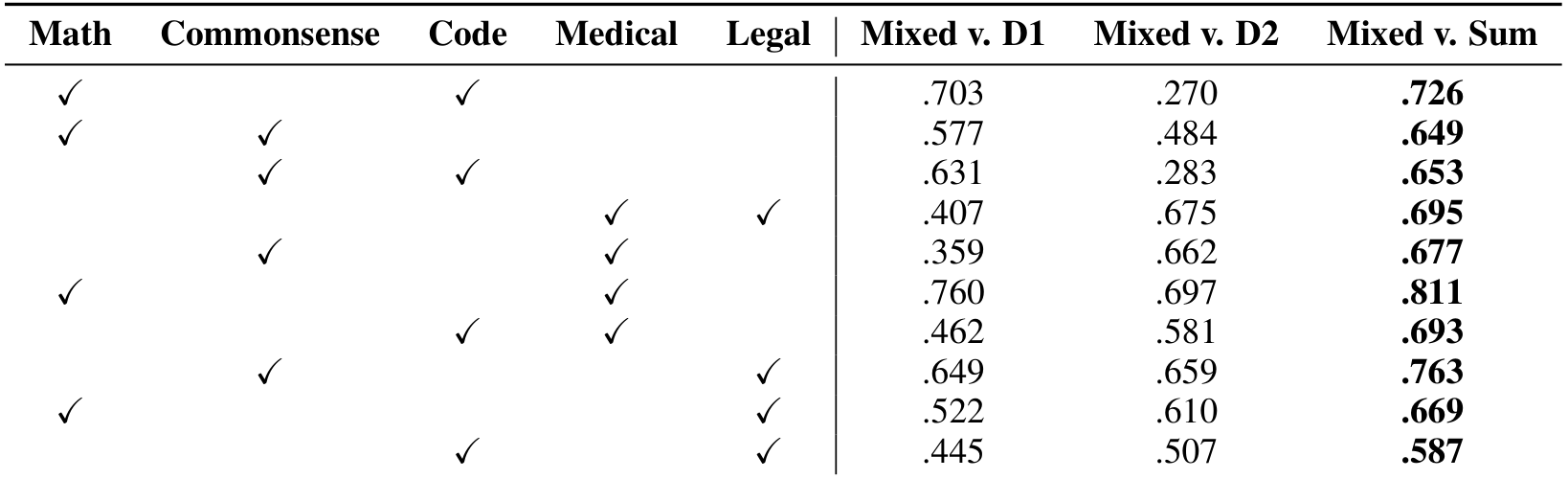

作者研究了 Delta Activations 的属性,包括加性属性、探针数据集的影响以及训练设置的鲁棒性。结果表明,Delta Activations 在不同训练设置下保持稳定,并在混合数据集时表现出加性属性。

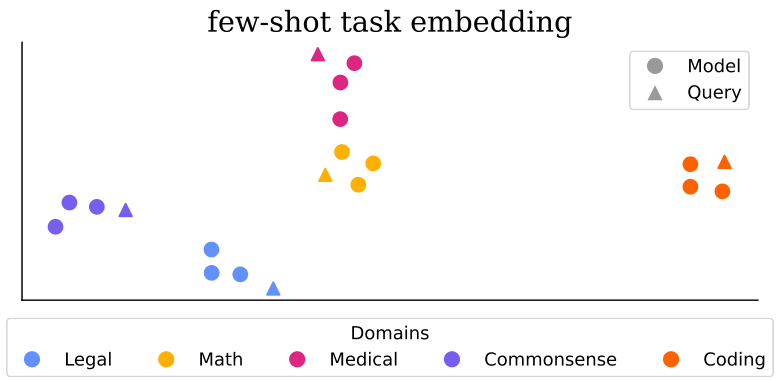

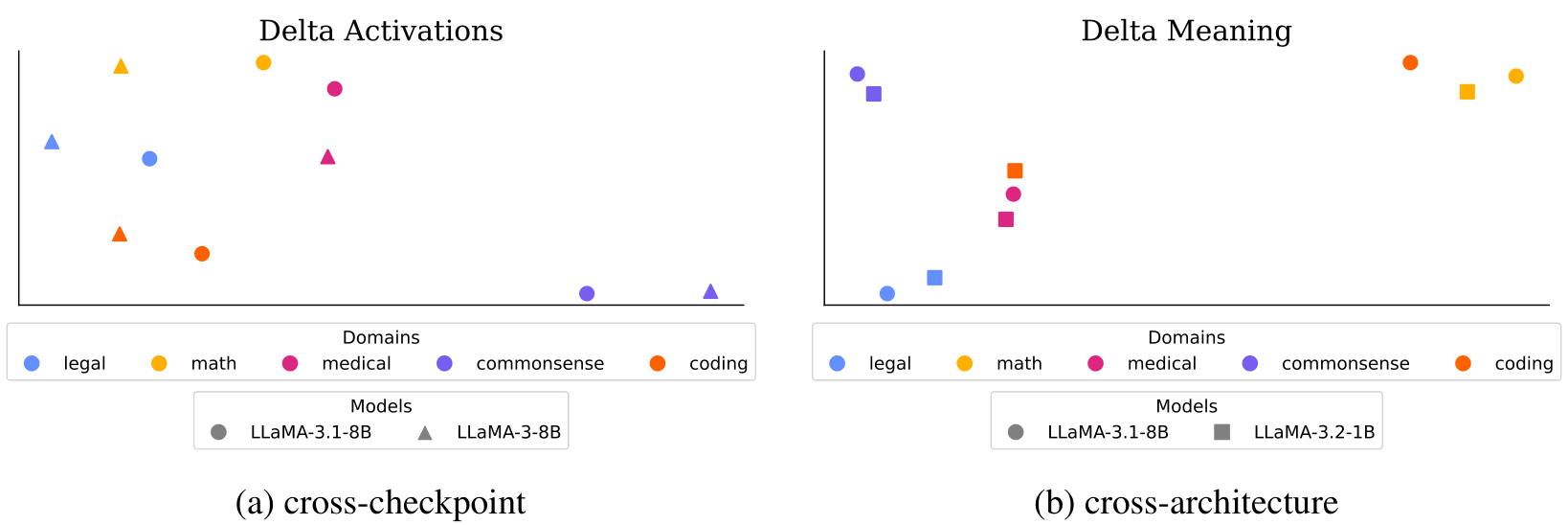

3.3 扩展

作者探索了 Delta Activations 在任务嵌入、跨基础模型聚类和模型选择与合并中的应用。实验表明,Delta Activations 能够通过少样本微调有效嵌入任务,并在跨基础模型和跨架构设置下实现聚类。

论文摘要(中文) - 相关工作与讨论部分

4 相关工作

嵌入模型与任务:Iharco 等人 [23] 发现通过微调得到的任务向量可以合并以实现多任务学习。已有多种尝试使用适配器权重 [48, 60]、评估配置文件 [79] 或依赖训练数据的特性 [77] 来表征大型语言模型(LLMs),但这些方法依赖于可能无法获取的数据或未能反映内部行为。我们的工作通过从内部行为中提取嵌入,无需外部监督或评估,与之不同。

激活:近期研究揭示了 LLMs 隐藏激活中的结构,理解大量激活如何作为偏见引导 LLM 输出 [57, 10]。激活还在训练后压缩中起到核心作用:它们被用于计算权重显著性以进行剪枝 [12, 56, 71],并通过校准集减少量化误差 [13, 34, 76],这启发了我们使用 Delta 激活的探针数据集。此外,学习到的激活偏移已被用于跨模型编辑或转移行为 [36, 32, 39]。

利用已训练模型:研究从重用单一模型演变为利用多个已训练模型。微调 [78] 是一种常见框架,用于在单一预训练模型基础上构建,或用于创建或初始化更高效的模型 [68, 67]。通过检索 [77, 26, 40, 28]、组合 [70, 5, 21, 11] 或路由 [38, 46, 55],有效利用多个已训练模型的努力正在进行中。

构建模型中心:近期研究 [19, 73] 关注公共模型池,并能系统地揭示已训练模型之间的微调关系。Lorahub [21]、LoraRetriever [77] 和 Learnware [60] 创建了包含约 40 到约 200 个模型的模型中心。通过神经网络参数扩散 [65, 33],也可以创建更大的模型中心,尽管实现真正的多样性 [75] 可能需要进一步发展。

5 讨论

Delta 激活:Delta 激活提供了一种简单而有力的方式,通过测量相对于基础 LLM 的内部激活偏移来表征微调后的 LLMs。我们的实验表明,这种表征方式始终形成反映微调领域的不同簇,并具有反映多领域行为的加性属性。Delta 激活在不同微调设置下的稳定性显示了其在模型选择和模型中心合并用例中的可靠性。我们认为,Delta 激活可以作为导航日益扩展的微调模型领域的基石,促进更高效的模型发现和重用。

局限性与未来工作:Delta 激活提出了一种表征微调模型的新方法,但也带来了实际考量。我们的实验集中于三个主要的开源骨干网络,但对其他架构的进一步评估将有助于理解其更广泛的适用性。此外,Delta 激活需要访问内部隐藏状态,这在专有模型上不可行。自然会有人询问我们的方法在远大于我们评估的模型池中的表现如何。如果模型池由具有多样且独特价值的模型组成,这种实际练习将最有意义。虽然这是一个我们打算探索的有趣方向,但我们推测目前此类模型池主要存在于专有设置中(例如微调的 GPT 模型),我们希望我们的方法能在未来促进此类模型的共享。

附录部分 - 训练设置与数据集

A 训练设置

对于 LoRA,我们设置秩 r = 8 r = 8 r=8, Q = 16 Q = 16 Q=16,目标是查询、键、值和 MLP 投影(q-proj, k_proj, v_proj, up-proj, down_proj, gate_proj),不使用 dropout 且无偏置参数。

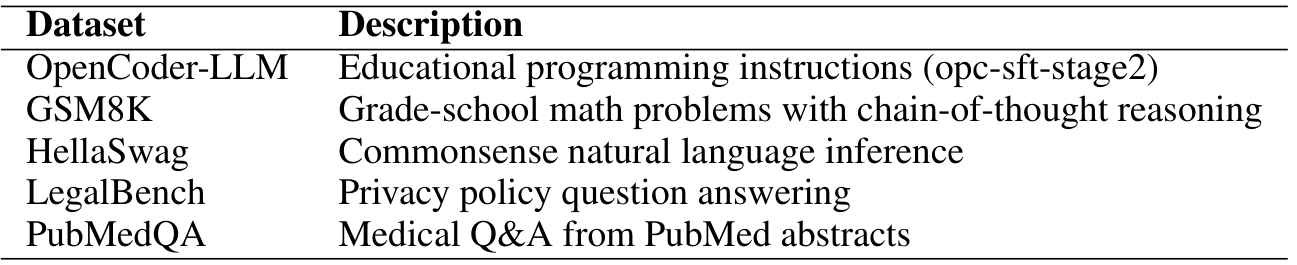

A.1 数据集

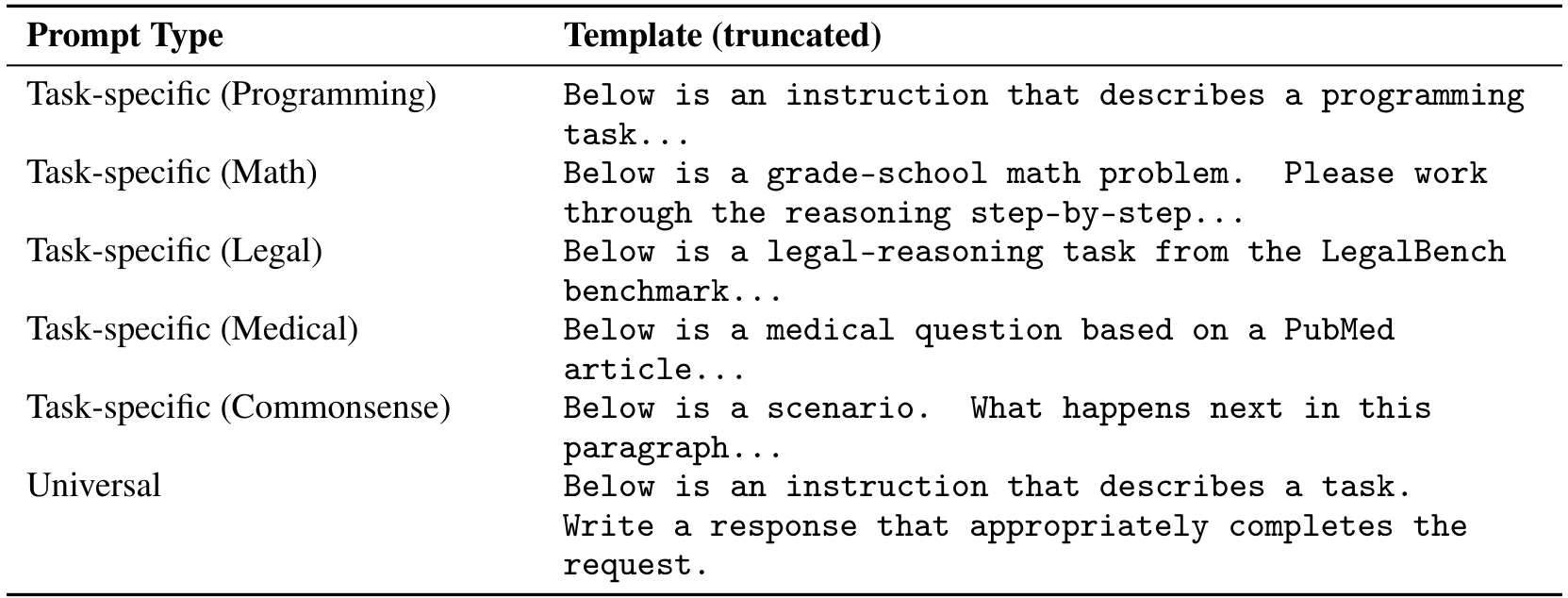

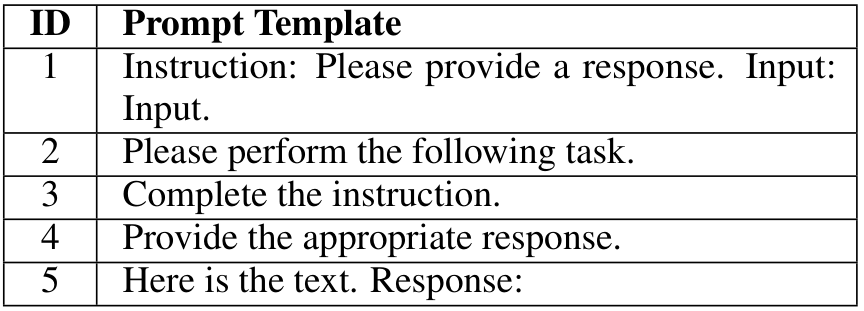

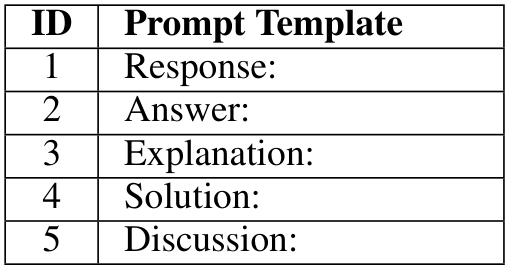

A.2 提示模板

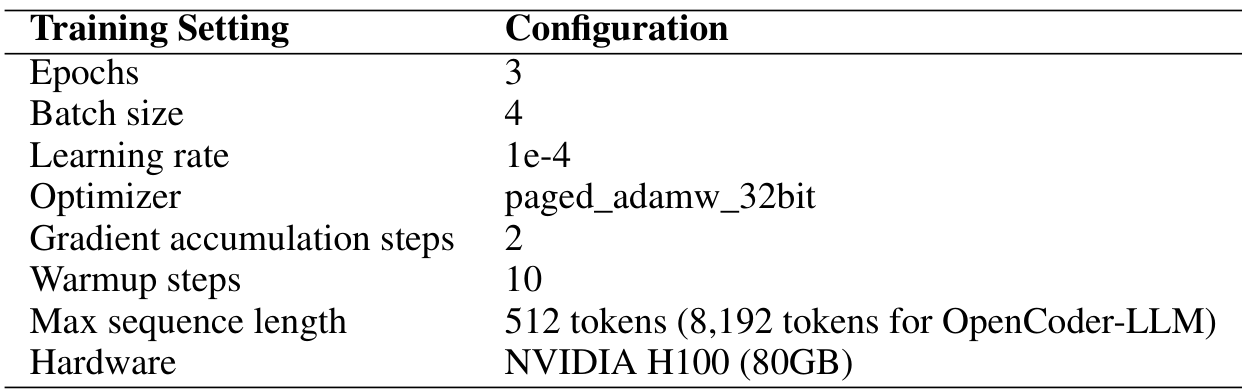

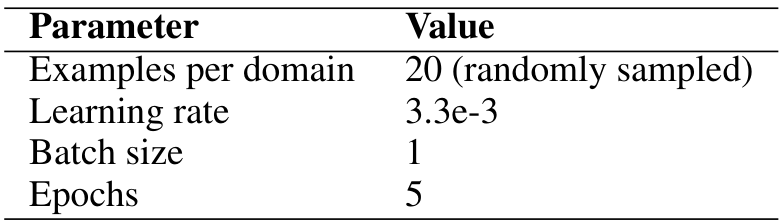

A.3 训练超参数

A.4 少样本任务嵌入配置

A.5 Delta 意义实现

意义表征 :给定一个探针提示,我们首先从基础模型中采样 n n n 个续写 { s 1 , . . . , s n } \{s_1, ..., s_n\} {s1,...,sn}(温度 = 1.0)。对于任何微调模型 f f f,我们通过计算其在 f f f 下的逆困惑度来为每个续写评分:

m f ( x ) i = exp ( − 1 ∣ s i ∣ ∑ t = 1 ∣ s i ∣ log p f ( s i , t ∣ s i , < t , x ) ) . m_{f}(x){i}=\exp\Biggl(-\frac{1}{|s{i}|}\sum_{t=1}^{|s_{i}|}\log p_{f}(s_{i,t}\mid{s_{i,<t}},x)\Biggr)\,. mf(x)i=exp(−∣si∣1t=1∑∣si∣logpf(si,t∣si,<t,x)).

这为每个提示生成一个 n n n 维的"意义向量" m f ( x ) ∈ R n m_f(x) \in \mathbb{R}^n mf(x)∈Rn。

Delta 聚合 :对于微调模型 f f f 及其基础模型 f b a s e f_{base} fbase,我们在提示上的 Delta 意义定义为其意义向量之差:

Δ f ( D ) = m f ( D ) − m f b a s e ( D ) . \Delta_{f}(\mathcal{D}) = m_{f}(\mathcal{D}) - m_{f_{base}}(\mathcal{D}). Δf(D)=mf(D)−mfbase(D).

对所有探针提示 D p r o b e \mathcal{D}_{probe} Dprobe 进行聚合,得到最终的模型嵌入:

v f = 1 ∣ D p r o b e ∣ ∑ x ∈ D p r o b e Δ f ( x ) . v_{f} = \frac{1}{|\mathcal{D}{\mathrm{probe}}|}\sum{x\in \mathcal{D}{\mathrm{probe}}}\Delta{f}(x). vf=∣Dprobe∣1x∈Dprobe∑Δf(x).

B 额外分析

B.1 更多骨干网络的 t-SNE 可视化

B.2 加性属性实验的完整结果

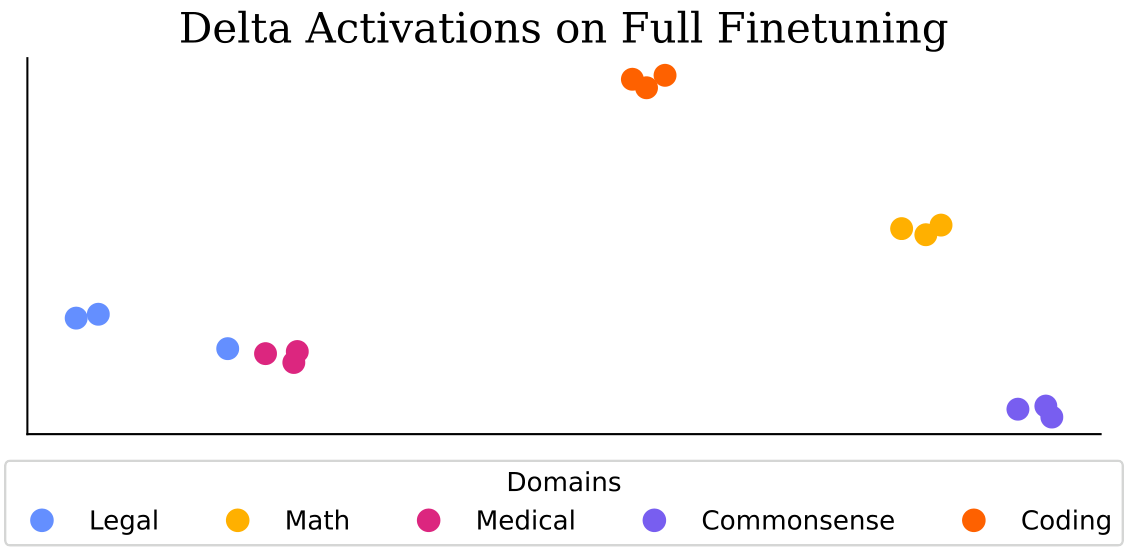

B.3 完整微调

域内聚类

C 提示模板

Original Abstract: The success of powerful open source Large Language Models (LLMs) has enabled

the community to create a vast collection of post-trained models adapted to

specific tasks and domains. However, navigating and understanding these models

remains challenging due to inconsistent metadata and unstructured repositories.

We introduce Delta Activations, a method to represent finetuned models as

vector embeddings by measuring shifts in their internal activations relative to

a base model. This representation allows for effective clustering by domain and

task, revealing structure in the model landscape. Delta Activations also

demonstrate desirable properties: it is robust across finetuning settings and

exhibits an additive property when finetuning datasets are mixed. In addition,

we show that Delta Activations can embed tasks via few-shot finetuning, and

further explore its use for model selection and merging. We hope Delta

Activations can facilitate the practice of reusing publicly available models.

Code is available at https://github.com/OscarXZQ/delta_activations.

PDF Link: 2509.04442v1

部分平台可能图片显示异常,请以我的博客内容为准