目录

缺陷管理与测试文档

在软件测试的实际工作中,除了发现缺陷,如何有效地管理缺陷、编写清晰的测试文档同样至关重要。一个成熟的测试团队不仅要有敏锐的发现问题的能力,更要有系统化的管理和沟通能力。

缺陷生命周期管理

1、缺陷生命周期概述

缺陷生命周期是指从缺陷被发现到最终关闭的完整过程,包含多个状态和角色参与。

标准缺陷状态流转图

发现(New) → 确认(Confirmed) → 分配(Assigned) → 修复(Fixed) → 验证(Verified) → 关闭(Closed)

↓ ↓ ↓ ↓ ↓

拒绝 重新打开 延期处理 验证失败 重新打开

(Rejected) (Reopened) (Deferred) (Reopen) (Reopened)|--------------------|--------------------------------------------------|

| New(新建) | 测试人员首次发现并提交缺陷;状态特点 :待开发人员确认;操作人:测试人员 |

| Confirmed(已确认) | 开发人员确认缺陷的真实性;状态特点 :确认为有效缺陷;操作人:开发人员/项目经理 |

| Assigned(已分配) | 缺陷被分配给具体开发人员;状态特点 :明确责任人;操作人:项目经理/开发主管 |

| Fixed(已修复) | 开发人员完成缺陷修复;状态特点 :代码已修改,待测试验证;操作人:开发人员 |

| Verified(已验证) | 测试人员验证修复效果;状态特点 :确认缺陷已解决;操作人:测试人员 |

| Closed(已关闭) | 缺陷处理完成,正式关闭;状态特点 :生命周期结束;操作人:项目经理/测试经理 |

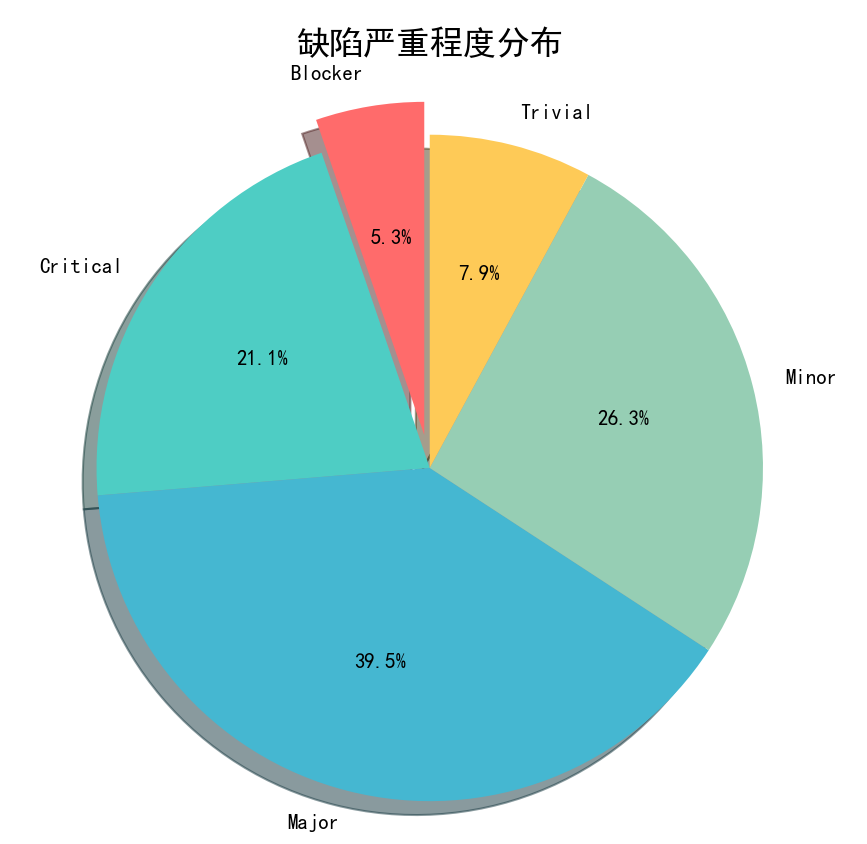

2、缺陷优先级与严重程度

严重程度分级(Severity)

Blocker(阻塞):

- 系统崩溃、无法启动

- 核心功能完全不可用

- 数据丢失或损坏

Critical(严重):

- 主要功能异常

- 影响核心业务流程

- 安全漏洞

Major(一般):

- 次要功能问题

- 用户体验受影响

- 性能问题

Minor(轻微):

- 界面显示问题

- 提示信息错误

- 易用性问题

Trivial(微小):

- 文档错误

- 格式问题

- 建议改进优先级分级(Priority)

P1(紧急):立即修复

P2(高):当前版本修复

P3(中):下个版本修复

P4(低):有时间再修复

P5(最低):可能不修复优先级与严重程度矩阵

| 严重程度\优先级 | P1 | P2 | P3 | P4 | P5 |

|---|---|---|---|---|---|

| Blocker | ✓ | ✓ | |||

| Critical | ✓ | ✓ | ✓ | ||

| Major | ✓ | ✓ | ✓ | ||

| Minor | ✓ | ✓ | ✓ | ||

| Trivial | ✓ | ✓ |

3、缺陷分类体系

按功能模块分类: 分析缺陷是哪一块如 - 登录模块、用户管理、订单处理、系统配置

按缺陷类型分类

|-----------|--------------------|

| 功能缺陷 | 功能实现错误、功能遗漏、业务逻辑错误 |

| 界面缺陷 | 布局错误、样式问题、交互异常 |

| 性能缺陷 | 响应时间长、内存泄漏、并发问题 |

| 兼容性缺陷 | 浏览器兼容性、设备兼容性、系统兼容性 |

| 安全缺陷 | 权限漏洞、数据泄露、注入攻击 |

有效的缺陷报告编写

1、缺陷报告的核心要素

标准缺陷报告模板

【缺陷标题】:简洁明了描述问题

【基本信息】

- 缺陷ID:BUG-2024-001

- 发现人:张三

- 发现时间:2025-09-10 14:30

- 测试环境:测试环境1

- 所属模块:用户管理

- 优先级:P2

- 严重程度:Major

【问题描述】

简要描述问题现象

【复现步骤】

1. 详细的操作步骤1

2. 详细的操作步骤2

3. 详细的操作步骤3

【预期结果】

描述期望的正确行为

【实际结果】

描述实际发生的错误行为

【测试数据】

相关的测试数据

【附件】

- 截图

- 日志文件

- 录屏视频

【补充信息】

- 出现频率:每次/偶现

- 影响范围:全部用户/部分用户

- 相关需求:REQ-0012、缺陷标题编写技巧

好的标题示例

✓ 用户注册时邮箱格式验证失败

✓ 订单支付成功后状态未更新

✓ 管理员删除用户时系统报错500

✓ 商品搜索结果分页显示异常

✓ 首页轮播图在IE11浏览器无法显示不好的标题示例

✗ 系统有问题

✗ 注册不了

✗ 页面显示不对

✗ 功能异常

✗ 测试发现问题标题编写原则

具体性 :明确指出问题的具体位置和现象;准确性 :准确描述问题的本质;简洁性 :控制在20-30个字以内;完整性:包含关键信息但不冗余

3、复现步骤的写作要求

优秀的复现步骤示例

【测试环境】Chrome 96.0.4664.110,Windows 10

【前置条件】

1. 已注册用户账号:test@example.com

2. 账户余额大于100元

【复现步骤】

1. 打开首页 http://test.example.com

2. 点击右上角"登录"按钮

3. 输入用户名:test@example.com

4. 输入密码:123456

5. 点击"登录"按钮

6. 进入用户中心,点击"我的订单"

7. 选择任意一个订单,点击"申请退款"

8. 在退款原因中输入"商品质量问题"

9. 点击"提交申请"按钮

【预期结果】

显示"退款申请提交成功"提示,页面跳转到退款状态页

【实际结果】

页面显示500错误,控制台报错:TypeError: Cannot read property 'status' of undefined复现步骤写作要点

|----------|--------------|

| 环境信息 | 明确测试环境和配置 |

| 前置条件 | 列出必要的前置条件 |

| 详细步骤 | 每个操作步骤都要详细清楚 |

| 数据具体 | 使用具体的测试数据 |

| 可重复 | 任何人按照步骤都能复现 |

4、缺陷报告质量评估

缺陷报告质量检查清单

□ 标题是否简洁明了?

□ 复现步骤是否详细完整?

□ 预期结果是否明确?

□ 实际结果是否准确描述?

□ 优先级和严重程度是否合理?

□ 是否包含必要的截图或日志?

□ 是否提供了足够的环境信息?

□ 描述是否客观,没有主观判断?

□ 是否检查了重复缺陷?测试计划与测试策略

1、测试计划结构

完整测试计划模板

1. 项目概述

1.1 项目背景

1.2 项目目标

1.3 测试目标

2. 测试范围

2.1 测试内容

2.2 不测试内容

2.3 测试边界

3. 测试策略

3.1 测试方法

3.2 测试类型

3.3 测试级别

4. 测试进度

4.1 测试阶段划分

4.2 时间安排

4.3 里程碑

5. 资源安排

5.1 人员安排

5.2 环境需求

5.3 工具需求

6. 风险评估

6.1 技术风险

6.2 进度风险

6.3 资源风险

7. 通过准则

7.1 测试完成标准

7.2 质量验收标准

7.3 发布准则2、测试策略制定

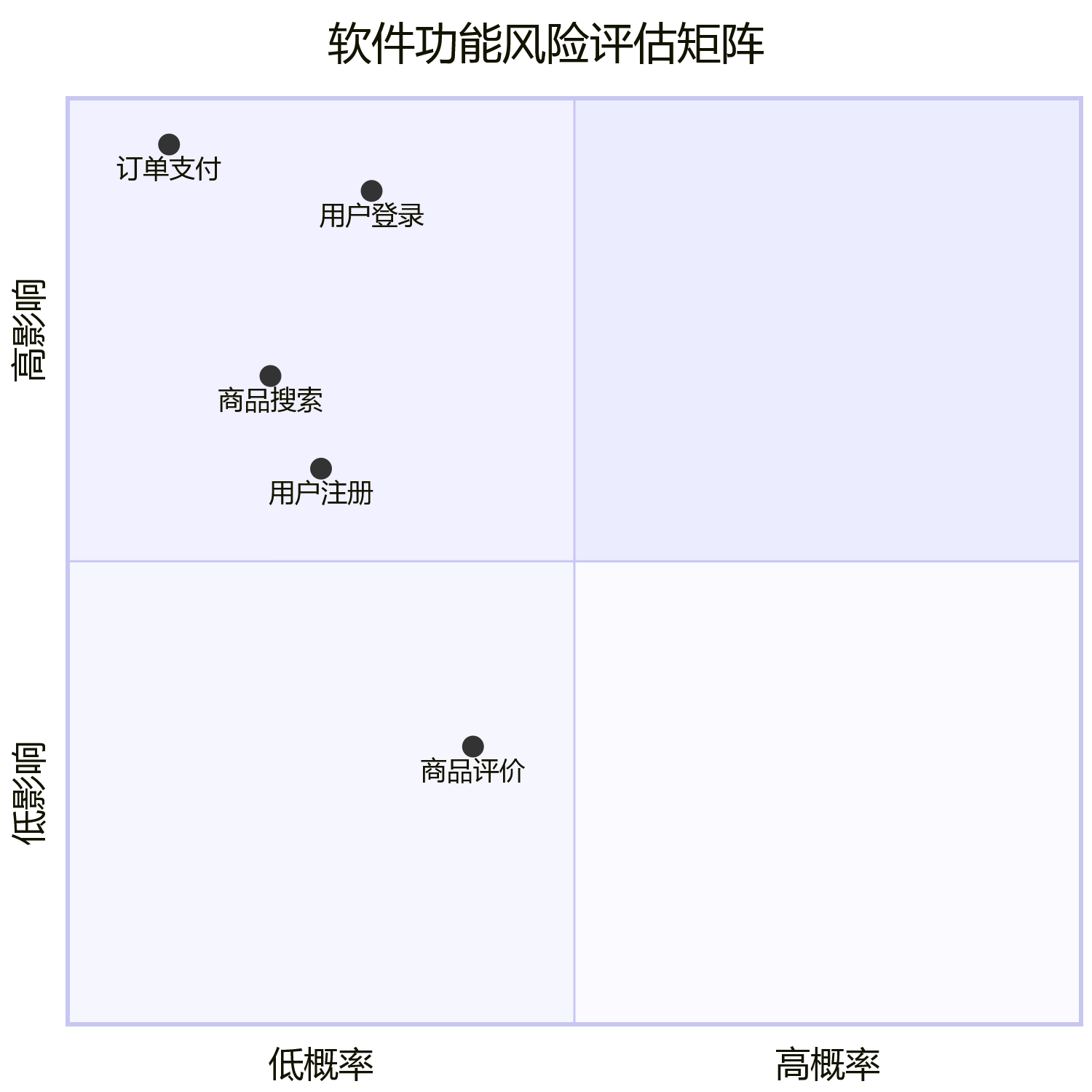

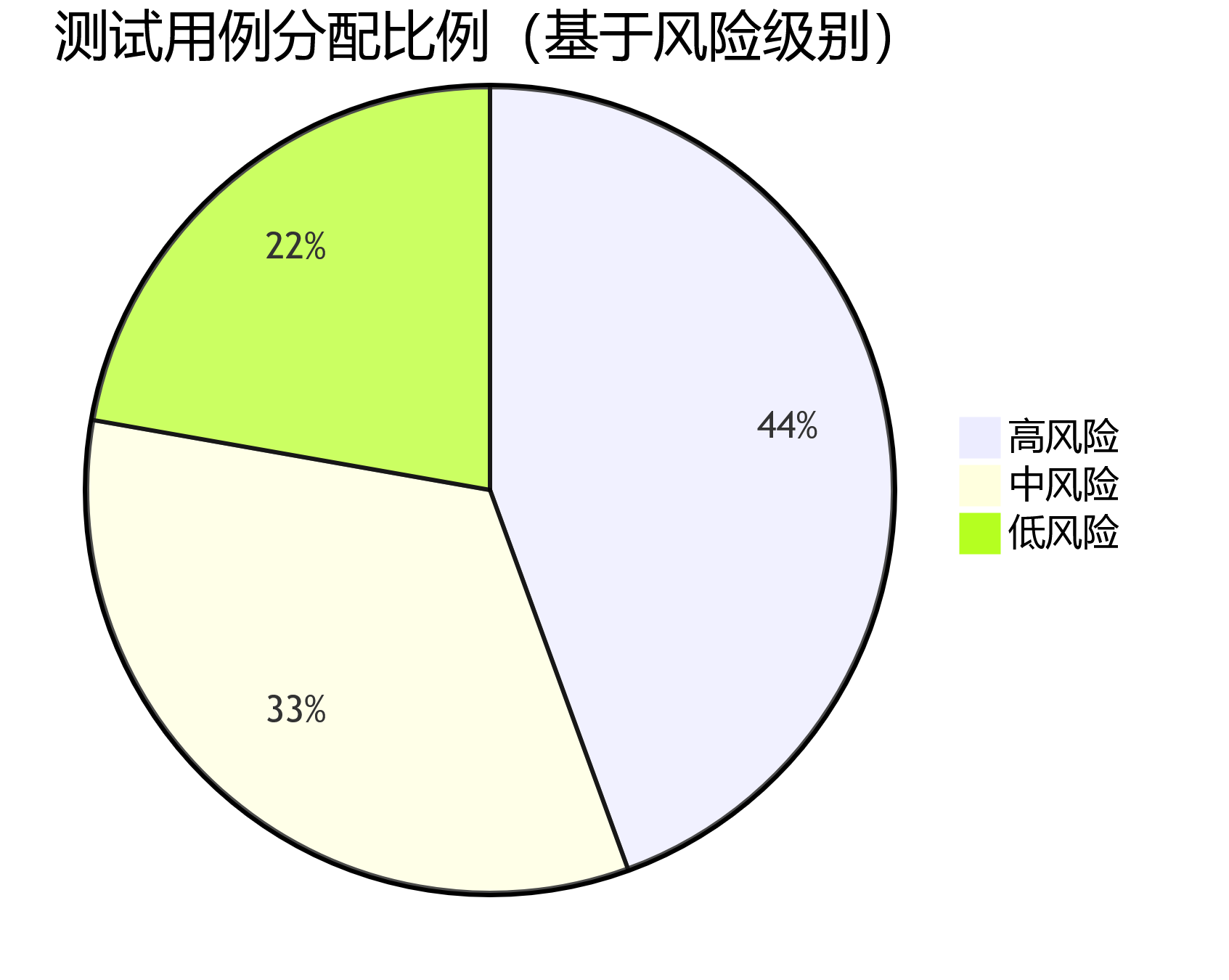

基于风险的测试策略

测试策略选择决策树

业务关键性

├── 高关键性

│ ├── 复杂度高 → 全面测试策略

│ └── 复杂度低 → 重点测试策略

└── 低关键性

├── 复杂度高 → 抽样测试策略

└── 复杂度低 → 基础测试策略3、测试用例设计策略

功能测试用例分布策略

正向测试用例(60%):

- 基本功能验证

- 主流程测试

- 常用场景测试

边界测试用例(25%):

- 边界值测试

- 极限值测试

- 临界条件测试

异常测试用例(15%):

- 错误输入测试

- 异常场景测试

- 容错性测试测试用例优先级分配

def prioritize_test_cases(test_cases):

priority_rules = {

'core_function': 'P1', # 核心功能

'main_workflow': 'P1', # 主要工作流

'business_critical': 'P1', # 业务关键

'common_scenario': 'P2', # 常见场景

'edge_case': 'P2', # 边界情况

'secondary_function': 'P3', # 次要功能

'ui_cosmetic': 'P4', # 界面美化

'nice_to_have': 'P4' # 可有可无

}

prioritized_cases = []

for case in test_cases:

case['priority'] = priority_rules.get(case['category'], 'P3')

prioritized_cases.append(case)

return sorted(prioritized_cases, key=lambda x: x['priority'])测试报告和度量指标

1、测试报告结构

测试执行报告模板

【报告基本信息】

- 项目名称:电商平台v2.0

- 测试版本:v2.0.1

- 测试周期:2024-01-01 ~ 2024-01-15

- 报告日期:2024-01-16

- 报告人:测试团队

【测试概况】

- 测试范围:用户管理、商品管理、订单处理

- 测试环境:测试环境、预生产环境

- 测试人员:5人

- 测试时长:15个工作日

【测试执行情况】

详见执行统计图表

【缺陷统计分析】

详见缺陷分析图表

【风险评估】

- 高风险问题:2个

- 中风险问题:5个

- 低风险问题:8个

【测试结论】

- 测试完成度:95%

- 质量评估:良好

- 发布建议:建议发布

【附录】

- 测试用例清单

- 缺陷清单

- 测试环境配置2、关键测试度量指标

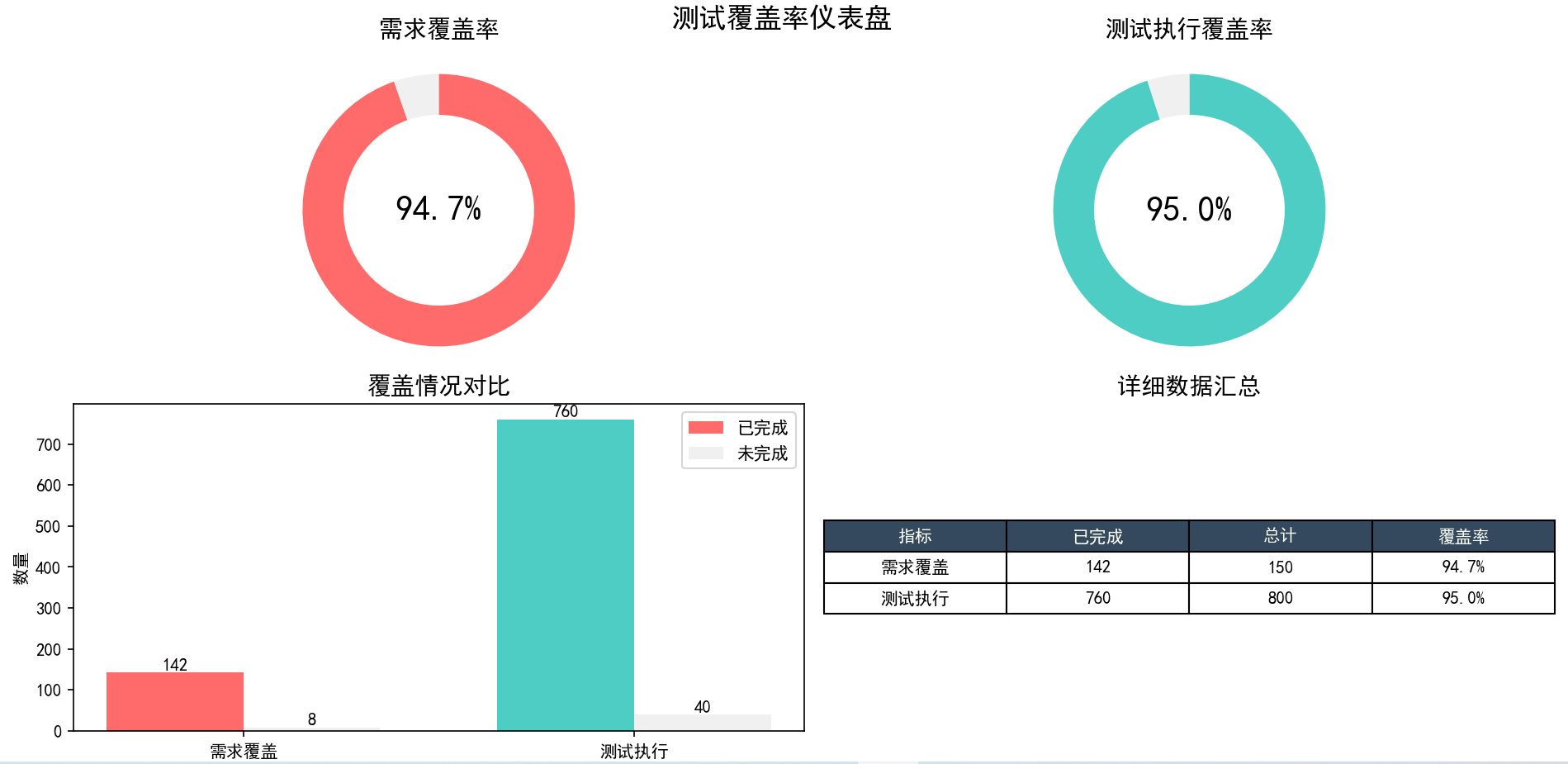

测试覆盖率指标

缺陷密度与质量指标

class DefectMetrics:

def __init__(self):

self.defects_found = 0

self.defects_fixed = 0

self.defects_verified = 0

self.lines_of_code = 0

self.function_points = 0

def defect_density_loc(self):

"""每千行代码缺陷密度"""

if self.lines_of_code == 0:

return 0

return (self.defects_found / self.lines_of_code) * 1000

def defect_density_fp(self):

"""每功能点缺陷密度"""

if self.function_points == 0:

return 0

return self.defects_found / self.function_points

def defect_fix_rate(self):

"""缺陷修复率"""

if self.defects_found == 0:

return 100

return (self.defects_fixed / self.defects_found) * 100

def defect_verification_rate(self):

"""缺陷验证率"""

if self.defects_fixed == 0:

return 0

return (self.defects_verified / self.defects_fixed) * 100

# 质量指标计算示例

defect_metrics = DefectMetrics()

defect_metrics.defects_found = 45

defect_metrics.defects_fixed = 42

defect_metrics.defects_verified = 40

defect_metrics.lines_of_code = 15000

print(f"缺陷密度: {defect_metrics.defect_density_loc():.2f} 缺陷/KLOC")

print(f"缺陷修复率: {defect_metrics.defect_fix_rate():.1f}%")

print(f"缺陷验证率: {defect_metrics.defect_verification_rate():.1f}%")测试效率指标

import datetime

class TestEfficiencyMetrics:

def __init__(self):

self.test_cases_designed = 0

self.test_cases_executed = 0

self.defects_found = 0

self.testing_hours = 0

self.design_hours = 0

self.execution_hours = 0

def test_design_productivity(self):

"""测试设计生产率(用例数/小时)"""

if self.design_hours == 0:

return 0

return self.test_cases_designed / self.design_hours

def test_execution_productivity(self):

"""测试执行生产率(用例数/小时)"""

if self.execution_hours == 0:

return 0

return self.test_cases_executed / self.execution_hours

def defect_detection_efficiency(self):

"""缺陷发现效率(缺陷数/小时)"""

if self.testing_hours == 0:

return 0

return self.defects_found / self.testing_hours

def test_case_effectiveness(self):

"""测试用例有效性(发现缺陷的用例比例)"""

if self.test_cases_executed == 0:

return 0

effective_cases = min(self.defects_found, self.test_cases_executed)

return (effective_cases / self.test_cases_executed) * 100

# 效率指标使用示例

efficiency = TestEfficiencyMetrics()

efficiency.test_cases_designed = 200

efficiency.test_cases_executed = 180

efficiency.defects_found = 25

efficiency.design_hours = 40

efficiency.execution_hours = 60

efficiency.testing_hours = 100

print(f"测试设计生产率: {efficiency.test_design_productivity():.1f} 用例/小时")

print(f"测试执行生产率: {efficiency.test_execution_productivity():.1f} 用例/小时")

print(f"缺陷发现效率: {efficiency.defect_detection_efficiency():.2f} 缺陷/小时")

print(f"测试用例有效性: {efficiency.test_case_effectiveness():.1f}%")3、可视化报告生成

使用Python生成测试报告图表

import matplotlib.pyplot as plt

import pandas as pd

import numpy as np

class TestReportGenerator:

def __init__(self):

plt.rcParams['font.sans-serif'] = ['SimHei'] # 支持中文

plt.rcParams['axes.unicode_minus'] = False

def generate_defect_trend_chart(self, dates, found, fixed, verified):

"""生成缺陷趋势图"""

plt.figure(figsize=(12, 6))

plt.plot(dates, found, marker='o', label='发现缺陷', linewidth=2)

plt.plot(dates, fixed, marker='s', label='修复缺陷', linewidth=2)

plt.plot(dates, verified, marker='^', label='验证缺陷', linewidth=2)

plt.title('缺陷处理趋势图', fontsize=16, fontweight='bold')

plt.xlabel('日期', fontsize=12)

plt.ylabel('缺陷数量', fontsize=12)

plt.legend()

plt.grid(True, alpha=0.3)

plt.xticks(rotation=45)

plt.tight_layout()

plt.savefig('defect_trend.png', dpi=300, bbox_inches='tight')

plt.show()

def generate_defect_distribution_pie(self, severity_data):

"""生成缺陷严重程度分布饼图"""

plt.figure(figsize=(10, 8))

labels = list(severity_data.keys())

sizes = list(severity_data.values())

colors = ['#ff6b6b', '#4ecdc4', '#45b7d1', '#96ceb4', '#feca57']

explode = (0.1, 0, 0, 0, 0) # 突出显示第一个扇形

plt.pie(sizes, explode=explode, labels=labels, colors=colors,

autopct='%1.1f%%', shadow=True, startangle=90)

plt.title('缺陷严重程度分布', fontsize=16, fontweight='bold')

plt.axis('equal')

plt.savefig('defect_distribution.png', dpi=300, bbox_inches='tight')

plt.show()

def generate_test_progress_chart(self, modules, planned, executed, passed):

"""生成测试进度图"""

x = np.arange(len(modules))

width = 0.25

plt.figure(figsize=(12, 8))

plt.bar(x - width, planned, width, label='计划执行', alpha=0.8)

plt.bar(x, executed, width, label='实际执行', alpha=0.8)

plt.bar(x + width, passed, width, label='执行通过', alpha=0.8)

plt.title('各模块测试进度', fontsize=16, fontweight='bold')

plt.xlabel('功能模块', fontsize=12)

plt.ylabel('测试用例数', fontsize=12)

plt.xticks(x, modules, rotation=45)

plt.legend()

plt.grid(True, alpha=0.3)

plt.tight_layout()

plt.savefig('test_progress.png', dpi=300, bbox_inches='tight')

plt.show()

# 使用示例

report_gen = TestReportGenerator()

# 缺陷趋势数据

dates = ['1/1', '1/2', '1/3', '1/4', '1/5', '1/6', '1/7']

found = [5, 12, 18, 25, 30, 35, 38]

fixed = [0, 3, 8, 15, 22, 28, 33]

verified = [0, 2, 6, 12, 18, 25, 30]

# 生成趋势图

report_gen.generate_defect_trend_chart(dates, found, fixed, verified)

# 缺陷分布数据

severity_data = {

'Blocker': 2,

'Critical': 8,

'Major': 15,

'Minor': 10,

'Trivial': 3

}

# 生成分布图

report_gen.generate_defect_distribution_pie(severity_data)

实战:构建完整的测试文档体系

1、测试文档体系架构

分层文档结构

测试文档体系

├── 战略层文档

│ ├── 测试策略文档

│ ├── 测试标准与规范

│ └── 质量保证计划

├── 计划层文档

│ ├── 测试计划

│ ├── 测试方案

│ └── 资源分配计划

├── 设计层文档

│ ├── 测试用例设计说明

│ ├── 测试数据设计

│ └── 测试环境设计

├── 执行层文档

│ ├── 测试用例

│ ├── 测试脚本

│ └── 测试检查清单

└── 总结层文档

├── 测试执行报告

├── 缺陷报告

└── 测试总结报告2、文档管理工具链

推荐工具组合

# 文档管理工具配置

documentation_tools = {

'需求管理': {

'tools': ['Jira', 'Azure DevOps', 'Confluence'],

'purpose': '需求跟踪和变更管理'

},

'测试用例管理': {

'tools': ['TestRail', 'Zephyr', 'qTest'],

'purpose': '测试用例设计、执行和维护'

},

'缺陷管理': {

'tools': ['Jira', 'Bugzilla', 'Mantis'],

'purpose': '缺陷跟踪和生命周期管理'

},

'文档编写': {

'tools': ['Confluence', 'Notion', 'GitBook'],

'purpose': '文档协作编写和版本控制'

},

'报告生成': {

'tools': ['Python + Matplotlib', 'Power BI', 'Tableau'],

'purpose': '自动化报告生成和数据可视化'

}

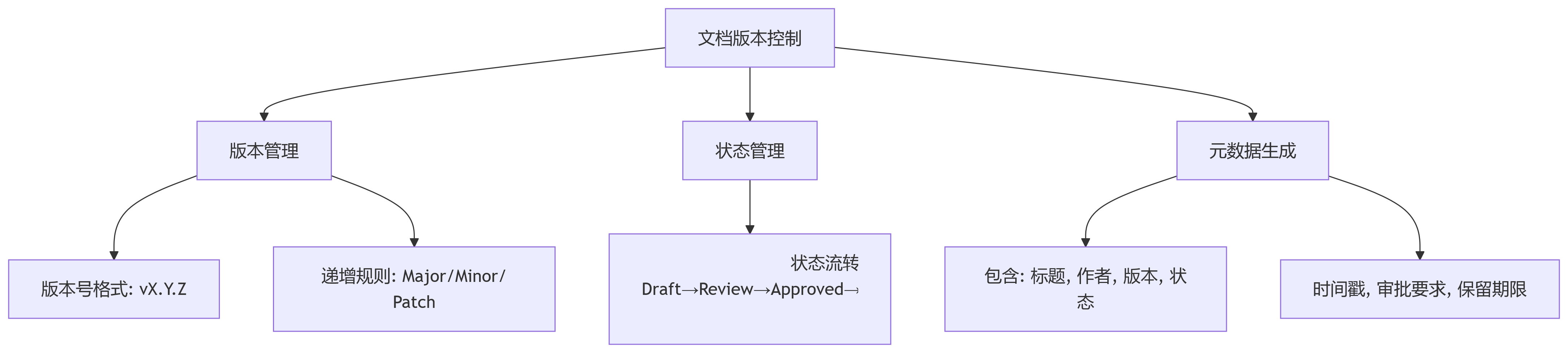

}文档版本控制策略

3、自动化文档生成

测试报告自动生成脚本

import json

import datetime

from jinja2 import Template

class AutoReportGenerator:

def __init__(self):

self.report_template = """

<!DOCTYPE html>

<html>

<head>

<title>{{ project_name }} 测试报告</title>

<style>

body { font-family: Arial, sans-serif; margin: 40px; }

.header { background-color: #f0f0f0; padding: 20px; border-radius: 5px; }

.summary { display: flex; justify-content: space-around; margin: 20px 0; }

.metric-box { text-align: center; padding: 15px; background-color: #e8f4f8; border-radius: 5px; }

.metric-value { font-size: 24px; font-weight: bold; color: #2c3e50; }

.metric-label { font-size: 14px; color: #7f8c8d; }

table { width: 100%; border-collapse: collapse; margin: 20px 0; }

th, td { border: 1px solid #ddd; padding: 12px; text-align: left; }

th { background-color: #f2f2f2; }

.status-pass { color: green; }

.status-fail { color: red; }

.status-block { color: orange; }

</style>

</head>

<body>

<div class="header">

<h1>{{ project_name }} 测试报告</h1>

<p><strong>测试版本:</strong> {{ version }}</p>

<p><strong>测试周期:</strong> {{ test_period }}</p>

<p><strong>报告生成时间:</strong> {{ report_date }}</p>

</div>

<div class="summary">

<div class="metric-box">

<div class="metric-value">{{ test_execution.total }}</div>

<div class="metric-label">总测试用例</div>

</div>

<div class="metric-box">

<div class="metric-value">{{ test_execution.passed }}</div>

<div class="metric-label">通过用例</div>

</div>

<div class="metric-box">

<div class="metric-value">{{ test_execution.failed }}</div>

<div class="metric-label">失败用例</div>

</div>

<div class="metric-box">

<div class="metric-value">{{ test_execution.coverage }}%</div>

<div class="metric-label">测试覆盖率</div>

</div>

</div>

<h2>测试执行详情</h2>

<table>

<thead>

<tr>

<th>功能模块</th>

<th>计划用例</th>

<th>执行用例</th>

<th>通过用例</th>

<th>失败用例</th>

<th>通过率</th>

<th>状态</th>

</tr>

</thead>

<tbody>

{% for module in modules %}

<tr>

<td>{{ module.name }}</td>

<td>{{ module.planned }}</td>

<td>{{ module.executed }}</td>

<td>{{ module.passed }}</td>

<td>{{ module.failed }}</td>

<td>{{ module.pass_rate }}%</td>

<td class="status-{{ module.status }}">{{ module.status_text }}</td>

</tr>

{% endfor %}

</tbody>

</table>

<h2>缺陷统计</h2>

<table>

<thead>

<tr>

<th>严重程度</th>

<th>发现数量</th>

<th>已修复</th>

<th>已验证</th>

<th>修复率</th>

</tr>

</thead>

<tbody>

{% for defect in defects %}

<tr>

<td>{{ defect.severity }}</td>

<td>{{ defect.found }}</td>

<td>{{ defect.fixed }}</td>

<td>{{ defect.verified }}</td>

<td>{{ defect.fix_rate }}%</td>

</tr>

{% endfor %}

</tbody>

</table>

<h2>测试结论</h2>

<div style="background-color: #f9f9f9; padding: 15px; border-radius: 5px;">

<p><strong>整体质量评估:</strong> {{ quality_assessment }}</p>

<p><strong>发布建议:</strong> {{ release_recommendation }}</p>

<p><strong>主要风险:</strong> {{ main_risks }}</p>

</div>

</body>

</html>

"""

def generate_report(self, data):

"""生成HTML测试报告"""

template = Template(self.report_template)

html_content = template.render(**data)

# 保存报告文件

filename = f"test_report_{data['version']}_{datetime.datetime.now().strftime('%Y%m%d_%H%M%S')}.html"

with open(filename, 'w', encoding='utf-8') as f:

f.write(html_content)

return filename

# 使用示例数据生成报告

report_data = {

'project_name': '电商平台',

'version': 'v2.1.0',

'test_period': '20245-01-01 至 2025-01-15',

'report_date': datetime.datetime.now().strftime('%Y-%m-%d %H:%M:%S'),

'test_execution': {

'total': 850,

'passed': 782,

'failed': 68,

'coverage': 92

},

'modules': [

{

'name': '用户管理',

'planned': 120,

'executed': 118,

'passed': 110,

'failed': 8,

'pass_rate': 93.2,

'status': 'pass',

'status_text': '通过'

},

{

'name': '商品管理',

'planned': 200,

'executed': 195,

'passed': 180,

'failed': 15,

'pass_rate': 92.3,

'status': 'pass',

'status_text': '通过'

},

{

'name': '订单处理',

'planned': 300,

'executed': 298,

'passed': 275,

'failed': 23,

'pass_rate': 92.3,

'status': 'fail',

'status_text': '存在问题'

}

],

'defects': [

{'severity': 'Blocker', 'found': 2, 'fixed': 2, 'verified': 2, 'fix_rate': 100},

{'severity': 'Critical', 'found': 8, 'fixed': 7, 'verified': 6, 'fix_rate': 87.5},

{'severity': 'Major', 'found': 25, 'fixed': 22, 'verified': 20, 'fix_rate': 88.0},

{'severity': 'Minor', 'found': 33, 'fixed': 28, 'verified': 25, 'fix_rate': 84.8}

],

'quality_assessment': '良好,主要功能稳定',

'release_recommendation': '建议发布,需修复Critical级别遗留问题',

'main_risks': '订单处理模块存在性能问题,需要监控'

}

generator = AutoReportGenerator()

report_file = generator.generate_report(report_data)

print(f"测试报告已生成: {report_file}")4、文档质量保证

文档审查检查清单

class DocumentQualityChecker:

def __init__(self):

self.quality_criteria = {

'完整性': [

'是否包含所有必需章节',

'是否有目录和页码',

'是否有版本历史记录',

'是否有审批签字栏'

],

'准确性': [

'技术信息是否准确',

'数据是否真实有效',

'引用是否正确',

'计算结果是否准确'

],

'清晰性': [

'语言是否简洁明了',

'结构是否逻辑清晰',

'图表是否清楚易懂',

'术语使用是否一致'

],

'一致性': [

'格式是否统一',

'术语定义是否一致',

'风格是否保持一致',

'引用格式是否规范'

],

'时效性': [

'信息是否最新',

'版本是否最新',

'链接是否有效',

'数据是否过期'

]

}

def check_document_quality(self, document_path):

"""检查文档质量"""

quality_score = 0

total_criteria = sum(len(criteria) for criteria in self.quality_criteria.values())

# 这里应该实现具体的检查逻辑

# 为演示目的,使用模拟数据

passed_checks = 18 # 假设通过了18项检查

quality_score = (passed_checks / total_criteria) * 100

return {

'quality_score': quality_score,

'passed_checks': passed_checks,

'total_checks': total_criteria,

'quality_level': self.get_quality_level(quality_score)

}

def get_quality_level(self, score):

"""根据分数确定质量级别"""

if score >= 90:

return '优秀'

elif score >= 80:

return '良好'

elif score >= 70:

return '合格'

else:

return '需要改进'

# 使用示例

quality_checker = DocumentQualityChecker()

result = quality_checker.check_document_quality('test_plan_v2.1.0.docx')

print(f"文档质量评估: {result}")5、持续改进机制

文档反馈与改进流程

class DocumentImprovementTracker:

def __init__(self):

self.feedback_categories = [

'内容完整性',

'表述清晰度',

'实用性',

'及时性',

'格式规范'

]

self.improvement_actions = []

def collect_feedback(self, document_id, reviewer, category, rating, comments):

"""收集文档反馈"""

feedback = {

'document_id': document_id,

'reviewer': reviewer,

'category': category,

'rating': rating, # 1-5分

'comments': comments,

'timestamp': datetime.datetime.now(),

'status': 'open'

}

return feedback

def analyze_feedback_trends(self, feedbacks):

"""分析反馈趋势"""

category_scores = {}

for feedback in feedbacks:

category = feedback['category']

if category not in category_scores:

category_scores[category] = []

category_scores[category].append(feedback['rating'])

# 计算平均分

category_averages = {}

for category, scores in category_scores.items():

category_averages[category] = sum(scores) / len(scores)

return category_averages

def generate_improvement_plan(self, analysis_results):

"""生成改进计划"""

improvement_plan = []

for category, avg_score in analysis_results.items():

if avg_score < 3.5: # 低于3.5分需要改进

action = {

'category': category,

'current_score': avg_score,

'target_score': 4.0,

'priority': 'high' if avg_score < 3.0 else 'medium',

'actions': self.get_improvement_actions(category),

'deadline': (datetime.datetime.now() + datetime.timedelta(days=30)).date()

}

improvement_plan.append(action)

return improvement_plan

def get_improvement_actions(self, category):

"""获取改进措施"""

action_map = {

'内容完整性': [

'补充缺失的章节内容',

'增加详细的示例说明',

'完善附录和参考资料'

],

'表述清晰度': [

'简化复杂句式',

'统一术语定义',

'增加图表说明'

],

'实用性': [

'增加实际操作步骤',

'提供模板和工具',

'添加最佳实践案例'

],

'及时性': [

'建立定期更新机制',

'设置内容审查周期',

'跟踪最新技术变化'

],

'格式规范': [

'统一文档模板',

'规范化命名约定',

'标准化图表格式'

]

}

return action_map.get(category, ['通用改进措施'])

# 使用示例

tracker = DocumentImprovementTracker()

# 模拟收集反馈

feedbacks = [

tracker.collect_feedback('DOC-001', '张三', '内容完整性', 4, '内容详细'),

tracker.collect_feedback('DOC-001', '李四', '表述清晰度', 3, '有些地方不够清楚'),

tracker.collect_feedback('DOC-001', '王五', '实用性', 2, '缺少实际操作指导')

]

# 分析反馈趋势

analysis = tracker.analyze_feedback_trends(feedbacks)

print(f"反馈分析结果: {analysis}")

# 生成改进计划

improvement_plan = tracker.generate_improvement_plan(analysis)

for plan in improvement_plan:

print(f"改进计划: {plan}")