Hugging Face Hub 无疑是AI模型库的黄金标准,然而,一个众所周知的事实是,由于网络限制,国内开发者访问 Hugging Face 的体验往往是"在漫长的等待中消磨意志"。社区镜像站 hf-mirror.com 虽能解一时之需,但其不稳定的速度和频繁的连接超时令人头痛。

阿里巴巴达摩院的 ModelScope作为一个本土化、网络通畅的模型平台,不仅提供了丰富的中文模型,许多国际上广受欢迎的模型也在其平台上建立了官方镜像。当一个模型同时存在于两个平台时,使用 modelscope 来下载,以换取稳定高速的体验。

然而,huggingface_hub 和 modelscope 的核心下载函数 snapshot_download,在看似孪生的外表下,隐藏着截然不同的设计哲学和行为逻辑。本文将记录一次整的实战探索所遇到的各种坑。

重要前提:知己知彼

在开始之前,必须明确两个基本前提:

- 替换的可行性 :只有当一个模型(例如

IndexTeam/IndexTTS-2)同时在 Hugging Face 和 ModelScope 上拥有官方或可靠的镜像仓库时,本文讨论的替换方案才成立。 - 生态的差异性:Hugging Face 拥有目前世界上最庞大的模型生态。ModelScope 虽然发展迅速,但在模型总量上仍有差距。因此,它是一个"特定情况下的高效替代品",而非"全面的等价物"。

最基础也最致命的语法陷阱

想象一下,你正在将一个使用 Hugging Face 的项目迁移到 ModelScope。你找到了对应的下载代码,并理所当然地认为只需要修改库的导入:

错误示范:

python

# 原始 Hugging Face 代码

# from huggingface_hub import snapshot_download

# snapshot_download(repo_id="IndexTeam/IndexTTS-2", local_dir="checkpoints")

# 尝试迁移到 ModelScope,但只改了库名

from modelscope.hub.snapshot_download import snapshot_download

# 这行代码会立刻抛出致命错误!

# TypeError: snapshot_download() got an unexpected keyword argument 'repo_id'

snapshot_download(repo_id="IndexTeam/IndexTTS-2", local_dir="checkpoints")这个 TypeError 是无数开发者踩的第一个坑。原因很简单:模型标识符的参数名不同。

- Hugging Face 秉承其基于 Git 的仓库(Repository)理念,使用

repo_id。 - ModelScope 则更直观地称之为模型(Model),使用

model_id。

正确修正:

python

# ModelScope 的正确用法

snapshot_download(model_id="IndexTeam/IndexTTS-2", local_dir="checkpoints")这个小细节提醒我们,永远不要想当然地认为不同库的同名函数会共享相同的参数签名。

cache_dir 与 local_dir 参数的行为剖析

这组同名参数是混淆的真正根源。它们的行为差异,是两个库设计哲学差异的最直接体现。

Hugging Face 的清晰职责

在 huggingface_hub 中,这两个参数的职责划分清晰明了:

cache_dir: 全局缓存的守护者 。它定义了所有模型和数据集的中央存储位置(默认为~/.cache/huggingface/hub),旨在"一次下载,全局复用"。你通常不会在代码中频繁设置它。local_dir: 项目的独立副本创建者 。这是日常开发中的首选参数 。它并不会愚蠢地重新下载一遍文件,而是高效地在你指定的路径下,创建指向全局缓存文件的符号链接 (symlink)。这让你既能享受到缓存的速度,又能获得一个干净、隔离的项目目录。

探索 ModelScope

当我们转向 modelscope 时,事情变得复杂起来。

初步尝试与假设: 我首先尝试了 cache_dir 参数,发现它的行为符合"缓存"的直觉:

python

from modelscope.hub.snapshot_download import snapshot_download

snapshot_download(model_id="IndexTeam/IndexTTS-2", cache_dir="checkpoints")执行后,我们发现模型文件被下载到了 './checkpoints/IndexTeam/IndexTTS-2/' 目录下。它为了避免模型间的文件冲突,自动创建了 作者/模型名 的子目录结构。

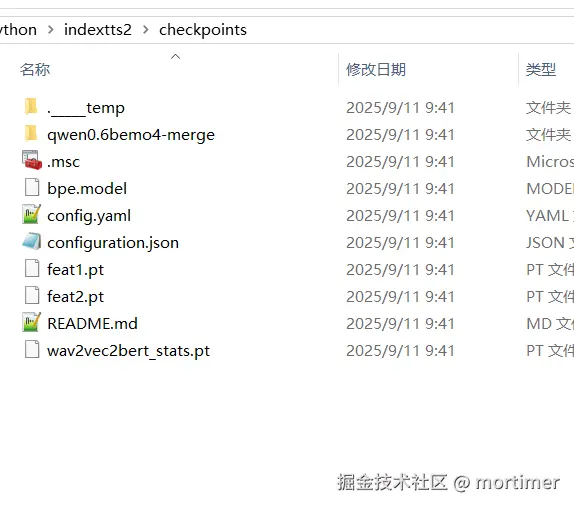

当我将代码中的 cache_dir 替换为 local_dir 后,下面的截图,清晰地记录了运行 snapshot_download(..., local_dir='checkpoints') 后的文件浏览器状态:

截图分析 : 这张截图不言自明。在 checkpoints 目录下,我们看到的不是任何子目录(如 IndexTeam),而是模型仓库的全部内容被直接、扁平地 铺开:bpe.model, config.yaml, configuration.json 等文件赫然在列。

cache_dir: 带子目录的缓存式下载 。当你希望modelscope帮你统一管理所有模型,并自动处理版本和隔离时,使用此参数。local_dir: 扁平化的直接下载。当你需要一个不包含任何额外层级的"纯净"模型文件夹(例如,为了匹配现有项目的目录结构)时,这正是你需要的参数。

速查手册

为了让在实际开发中能够迅速做出正确决策,下表总结了两者关键信息:

| 特性 / 需求 | huggingface_hub.snapshot_download |

modelscope.hub.snapshot_download |

|---|---|---|

| 模型标识符 | repo_id="作者/模型名" |

model_id="作者/模型名" |

| 下载并由库自动管理(带子目录) | 默认行为(下载到全局缓存)或用 cache_dir 指定缓存根目录 |

使用 cache_dir="你的路径" |

| 下载到指定文件夹且不创建额外子目录 | 使用 local_dir="你的路径" (通过符号链接实现) |

使用 local_dir="你的路径" (通过直接下载文件实现) |

| 核心机制差异 | local_dir 是对 cache_dir 的高效视图 (View) |

local_dir 和 cache_dir 是两种不同的下载模式 (Mode) |

拥抱替代方案,但保持审慎

对于国内开发者而言,ModelScope 无疑是解决 Hugging Face 访问难题的一把利器。它提供的稳定高速下载体验,能够实实在在地提升我们的开发效率。

然而,正如本次深度探索所揭示的,从一个生态迁移到另一个生态,绝非轻描淡写。我们必须:

- 尊重差异:认识到即使是同名函数和参数,其背后的设计哲学和行为也可能大相径庭。

- 勤于验证:不要盲目相信假设,一行简单的测试代码或一次文件浏览器的检查,就能避免后续数小时的调试痛苦。

- 明确边界:清晰地知道 ModelScope 是一个在特定场景下的优秀"备胎",而非全盘的替代品。