目录

- [1. 环境搭建](#1. 环境搭建)

- [2. 开始调参](#2. 开始调参)

-

- [2.1 模型配置](#2.1 模型配置)

- [2.2 选择数据集](#2.2 选择数据集)

-

- [2.2.1 使用自定义数据集](#2.2.1 使用自定义数据集)

- [2.3 其他参数](#2.3 其他参数)

- [3. 开始微调](#3. 开始微调)

- [4. 模型评测](#4. 模型评测)

- [5. 模型导出](#5. 模型导出)

1. 环境搭建

环境要求

Python ≥3.9

PyTorch & CUDA

GPU显存>24GB

安装命令

bash

git clone https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

pip install -e ".[torch,metrics]"

llamafactory-cli webui2. 开始调参

浏览器输入http://10.0.0.140:7861/进入调参页

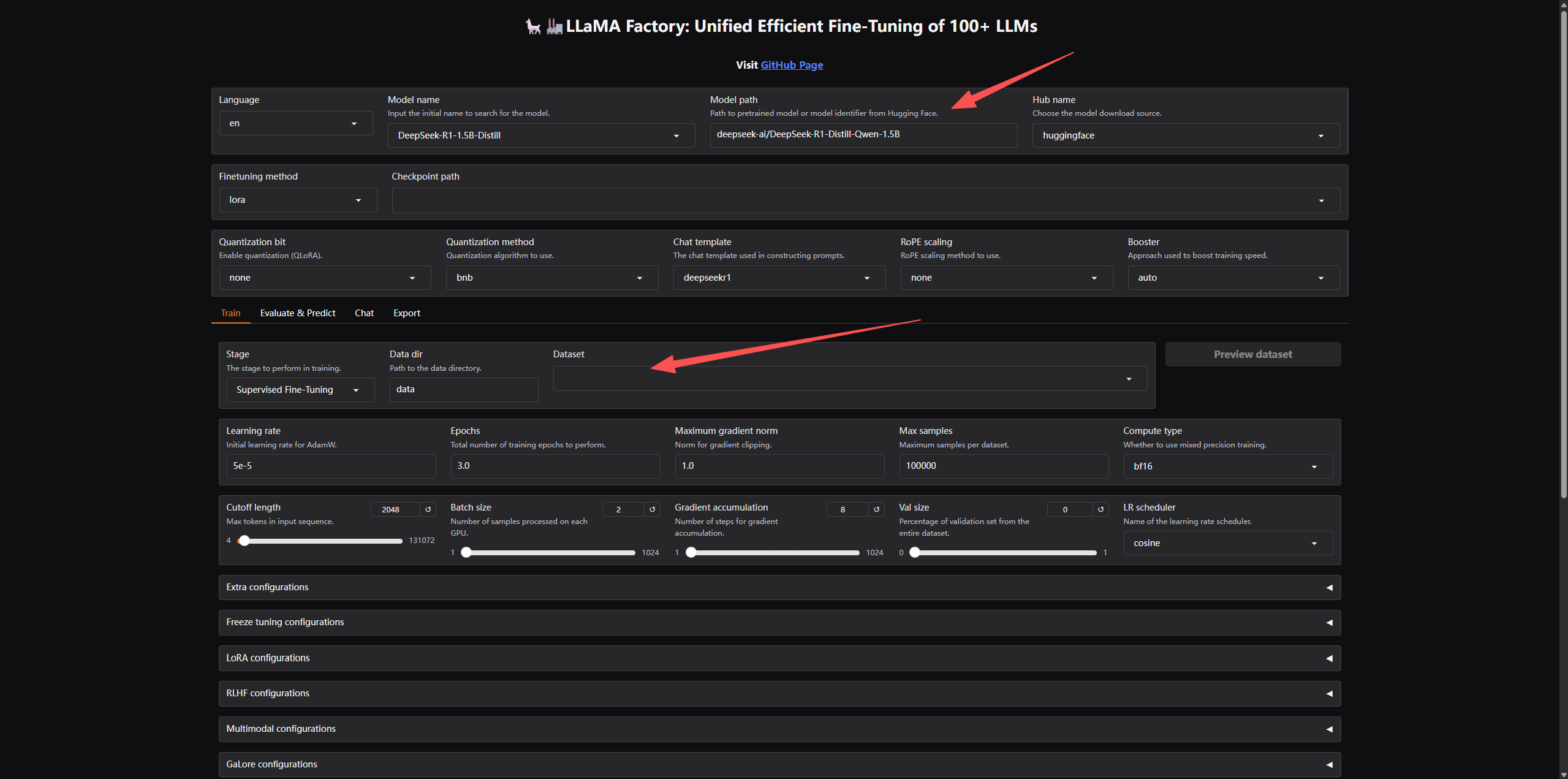

2.1 模型配置

首先要选择要微调的模型,我们这里选择DeepSeek-R1-1.5B-Distill,如果预先没下载好模型,右侧模型下载源选择modelscope

2.2 选择数据集

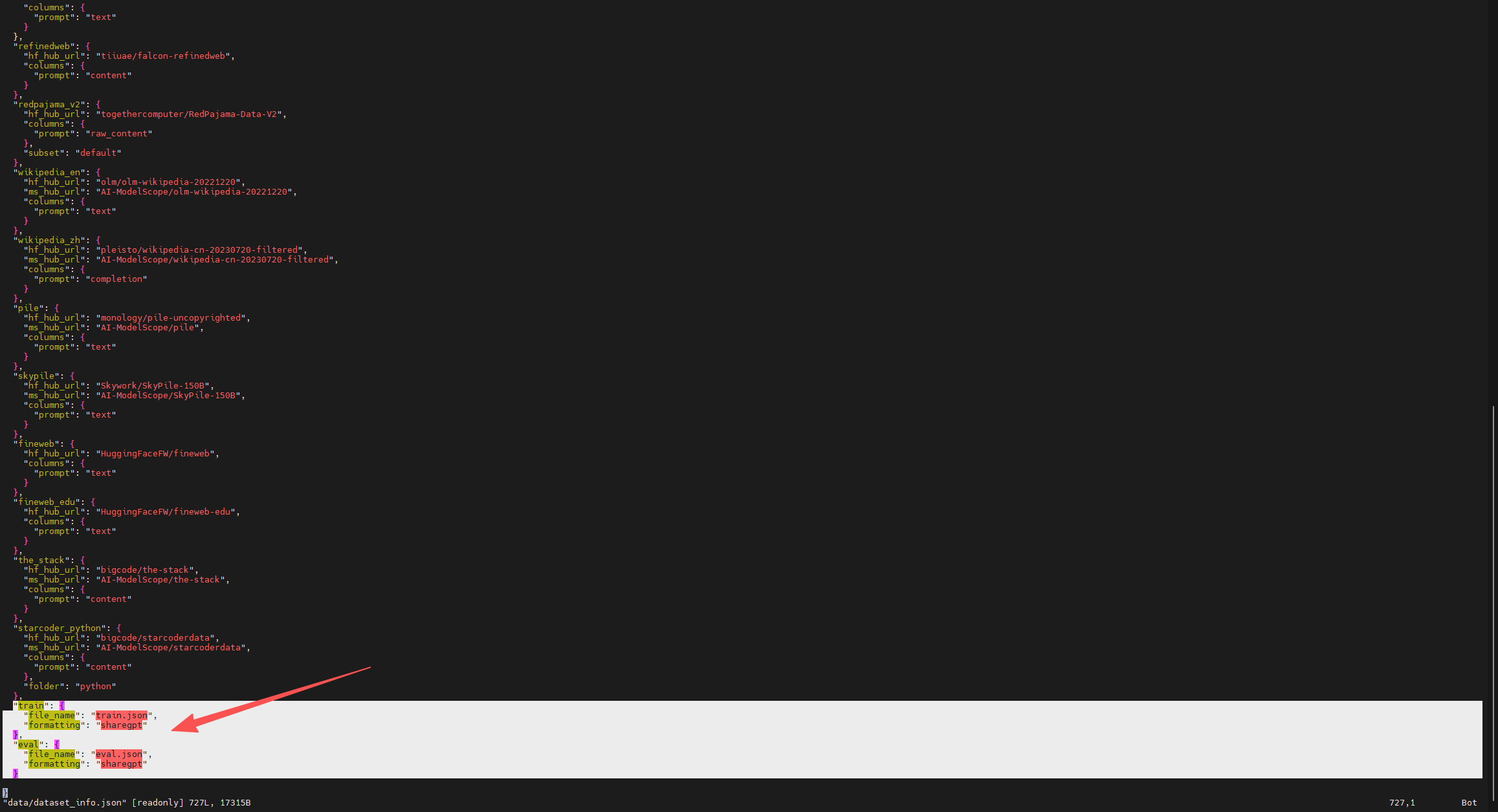

2.2.1 使用自定义数据集

- 下载数据集

wget https://atp-modelzoo-sh.oss-cn-shanghai.aliyuncs.com/release/tutorials/llama_factory/data.zip

unzip data.zip - 修改factory data配置,将下载的数据加到数据集显示列表中

的将下载data目录下dataset_info.json的内容添加到LLaMA-Factory-main/data/dataset_info.json,并将train.json和eval.json拷贝到LLaMA-Factory-main/data/下

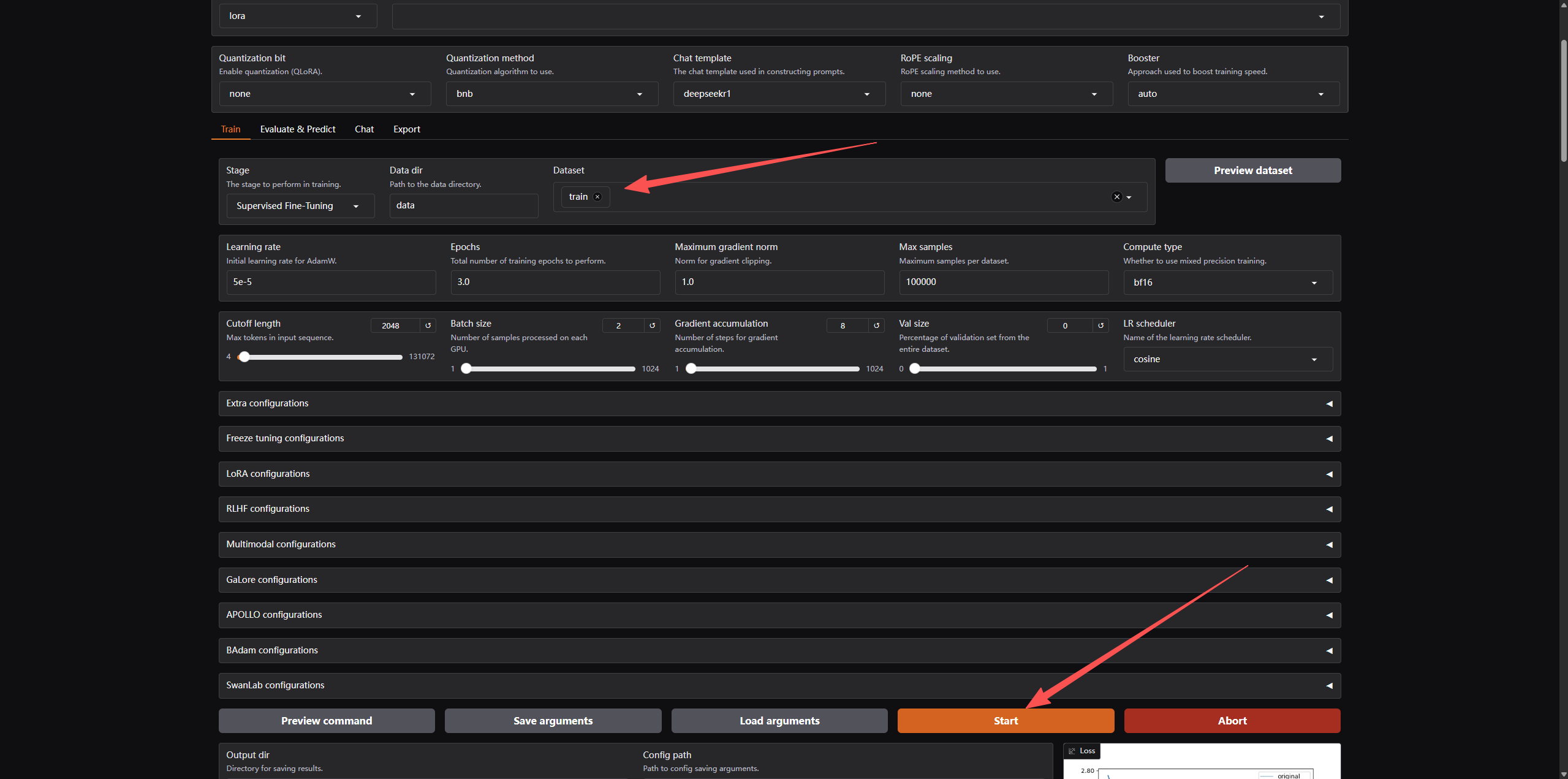

在data下拉列表中选择train即选择了自定义数据集

2.3 其他参数

其他参数根据需要自行调节

3. 开始微调

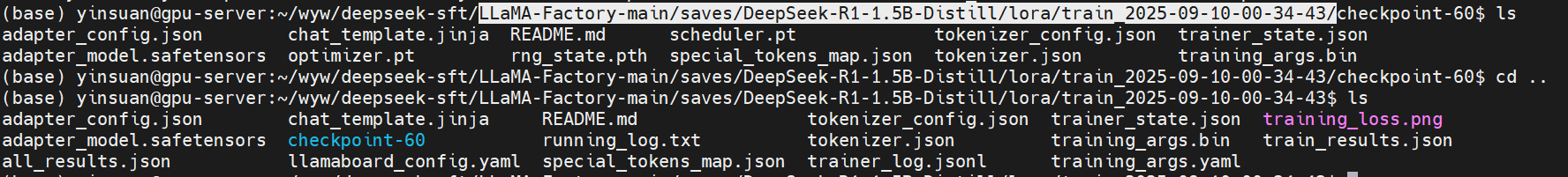

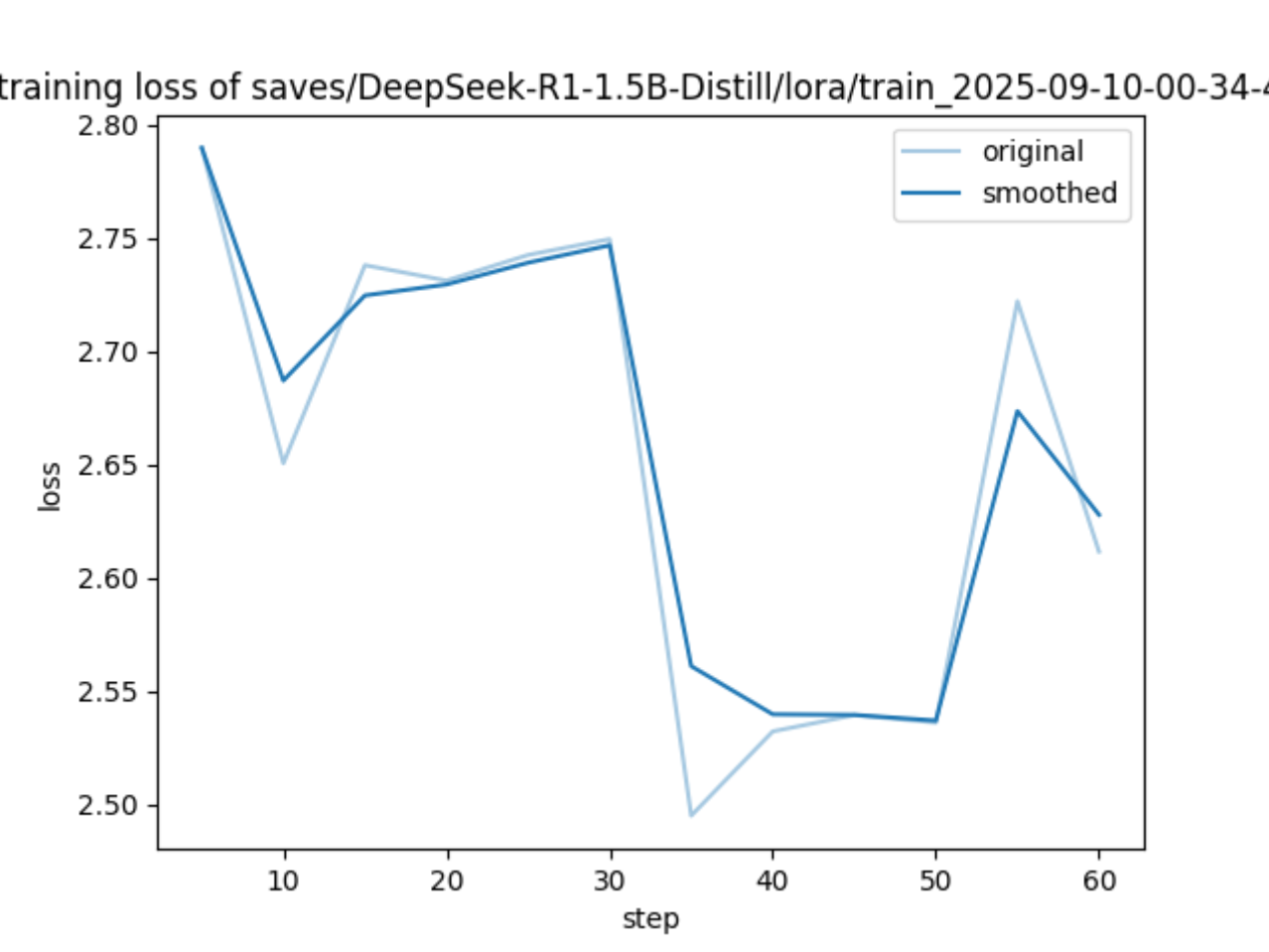

点击start即开始微调训练,训练完成后,可以在LLaMA-Factory-main/saves/DeepSeek-R1-1.5B-Distill/lora/train_2025-09-10-00-34-43/目录下找到微调后的模型即训练loss曲线图

从loss曲线图可以看出,虽然震荡比较厉害,但是整体趋势是一直在下降的

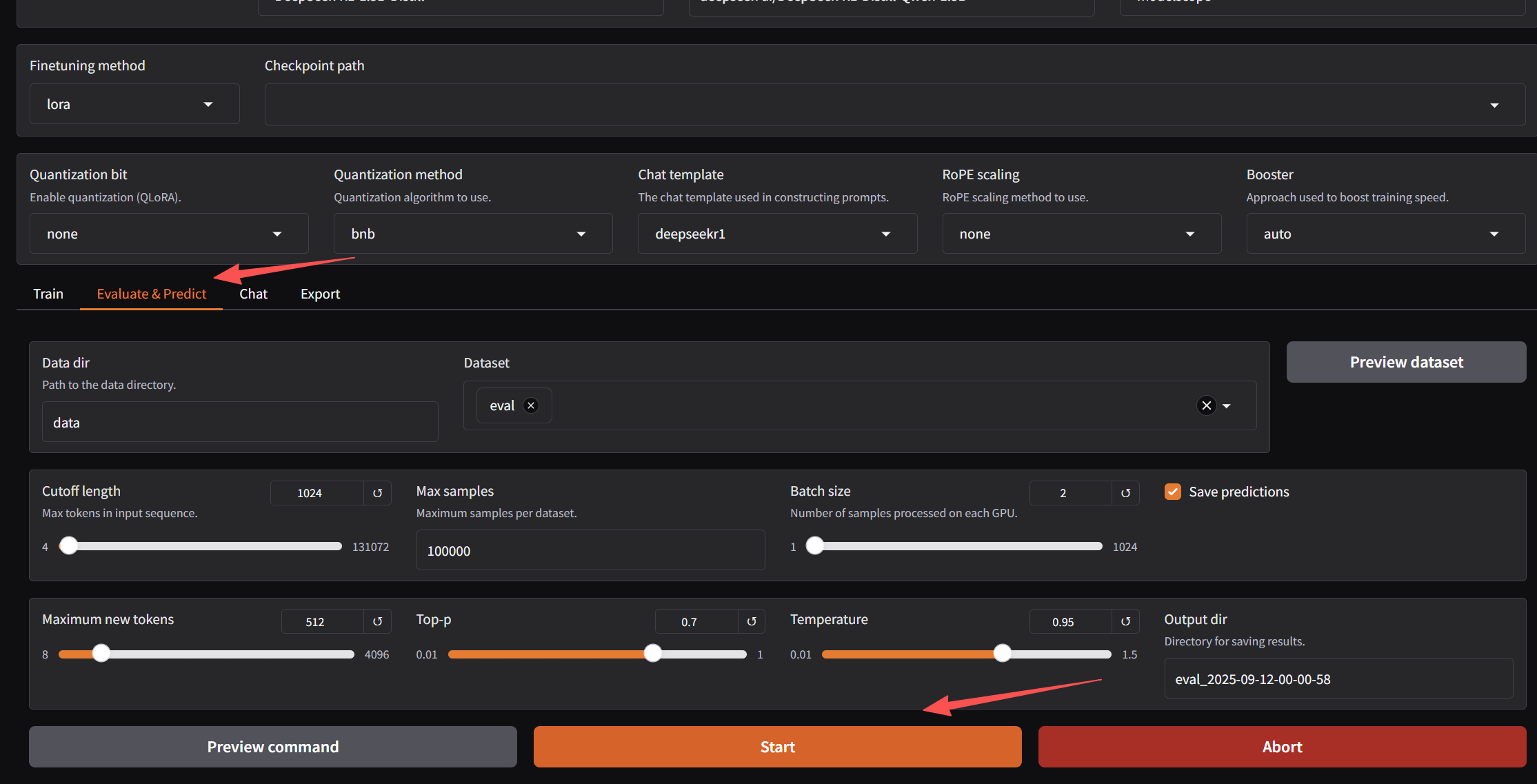

4. 模型评测

模型训练完成后,可以对模型进行评测

调参页选择Evaluate&Predict,然后点击Start即可。

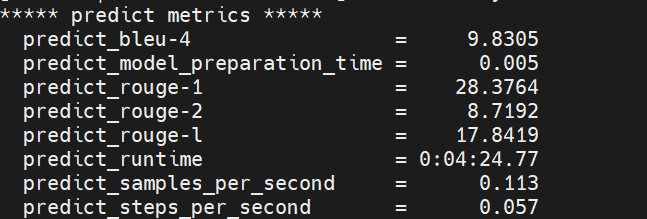

完成后,会输出如下评测结果

5. 模型导出

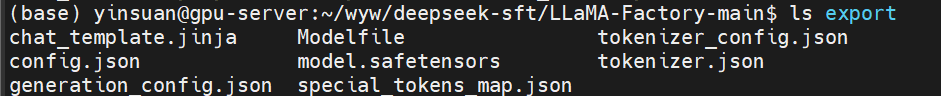

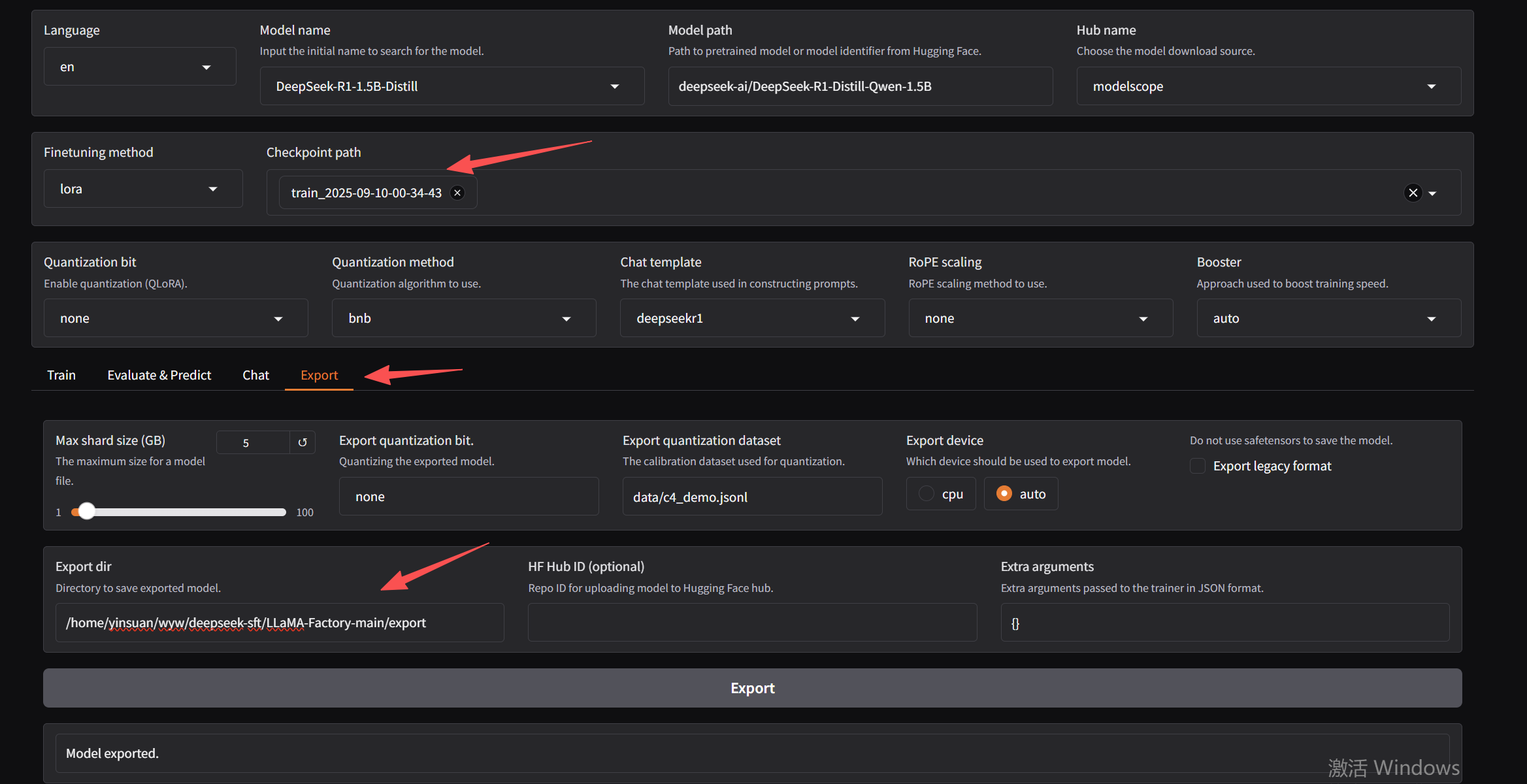

在调参页选择Export,然后选在刚微调的模型,并填写导出路径,点击Export即开始导出。

导出完成后,可以在导出目录看到如下: