本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。

大佬,我的笔记本只有8GB显存,能跑多大的AI模型?

这是我最近被问得最多的问题。每次我都会先反问:"你知道模型参数量和显存的关系吗?"

结果90%的人都是一脸懵逼...

今天就把这个核心计算公式告诉你,让你秒懂自己的笔记本到底能跑什么模型!

第一步:理解模型参数量的含义

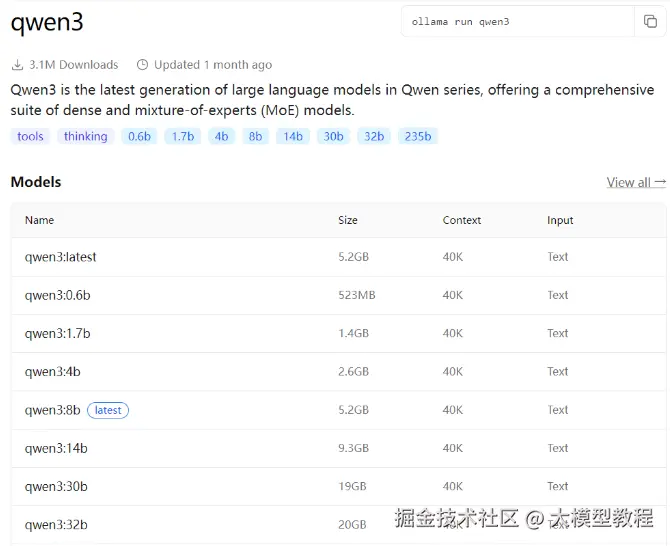

模型参数量有很多种规格:1.5B、7B、8B、14B、32B、70B、671B...

这里的B 是Billion(十亿) 的意思,1B的模型就是有10亿个参数。

第二步:掌握显存计算的核心公式

键公式来了:

-

1个全精度参数 = 4个字节

-

1B的模型 = 40亿字节

-

1GB = 10亿个字节

所以:跑一个1B的参数需要4GB显存

但是!这里有个重要优化:

全精度(FP32)太浪费资源了,实际应用中我们通常使用:

-

半精度(FP16) :1个参数占2个字节

-

INT8量化: 1个参数占1个字节

第三步:实际显存需求计算

使用半精度(FP16)计算:

-

1B模型 = 2GB显存

-

8B模型 = 16GB显存

虽然推理时还需要一定显存做上下文缓存,但加上量化和推理优化,本地8GB显存的笔记本可以流畅运行4B模型,16GB显存笔记本跑8B模型完全OK!

第四步:不同显存配置的笔记本模型推荐

8GB显存笔记本: 可以跑4B模型,能处理基础的代码生成、文案创作,适合AI学习入门用户;

12GB显存笔记本: 可以跑6B模型,胜任中等复杂度的AI任务,适合进阶学习者;

16GB显存笔记本: 完美运行8B模型,胜任代码生成、文案创作等专业级任务,大多数个人用户的最佳选择;

24GB显存笔记本: 可以跑12B模型,支持更复杂的专业任务,适合高级开发者;

第五步:超大模型的现实门槛

70B模型: 展现接近人类的常识推理水平,但需要至少四张H100显卡组成的计算集群

671B模型: 主要用于国家级科研机构和超大规模云服务商,探索AGI的潜在路径

快速自测:你的笔记本能跑什么模型?

计算公式: 你的笔记本显存 ÷ 2 = 能跑的模型参数量(B)

8GB显存笔记本 → 4B模型

12GB显存笔记本 → 6B模型

16GB显存笔记本 → 8B模型

24GB显存笔记本 → 12B模型

实用建议:选择最适合你笔记本的模型

不要盲目追求大参数量!对于大多数笔记本用户,4B-8B模型已经能胜任90%的个人AI应用需求:

-

代码生成和调试

-

文案创作和改写

-

知识问答和总结

-

简单的逻辑推理

关键是找到性能和笔记本资源消耗的最佳平衡点。

学习资源推荐

如果你想更深入地学习大模型,以下是一些非常有价值的学习资源,这些资源将帮助你从不同角度学习大模型,提升你的实践能力。

本文较长,建议点赞收藏。更多AI大模型应用开发学习视频及资料,在智泊AI。