前言

在文本编辑领域,设想一种技术:无需复杂控制信号,只靠字形图像和少量训练数据,就能把文字"无缝"嵌入真实场景------中文招牌、日文海报、韩文标语,多语言统统适用。这就是 TextFlux 带来的全新体验,由bilibili人工智能平台部,联合北京大学王选所提出。

TextFlux 不再依赖 OCR 编码器和繁复的监督信号,而是把渲染好的字形直接贴进场景,让模型型专注学习"如何与周围环境自然融合"。思路直观,架构简洁,却能生成更真实、更快捷、更通用的多语言场景文本编辑效果。相关代码、权重和数据集均已开源。截至目前,该项目已支持ComfyUI,能够在消费级显卡上部署和运行。

图1 TextFlux项目开源页面

相关链接

-

ComfyUI:github.com/yyyyyxie/te...

背景介绍

场景文本编辑需兼顾两方面:一是文本"拼写"精确性,二是与场景视觉的自然融合。传统方法虽强化拼写,却容易产生"贴片"感;或者反之,虽融合逼真,但文本识别失败。借助扩散模型(DiT)优越的上下文推理能力,TextFlux 摒弃了传统方法基于 OCR 编码器的复杂条件注入,将渲染的字形图像与场景图像在空间维度融合,转而让模型专注于"如何将字形自然融入场景",而非"如何认识文字"。在多行生成和单行生成领域,TextFlux都有不俗的表现。

多行生成

TextFlux能够一次性编辑生成多行文本,每一行文字的内容、位置和风格都可以精准调整,文字与场景无缝融合,既真实又具有可读性。

关键特征

-

OCR‑Free 架构:简化模型结构,无需 OCR 编码器。

-

高保真 & 上下文风格一致:渲染精准,风格与场景浑然一体。

-

多语种 & 低资源适配能力:优异的多语言兼容力,新增语言仅需极少样本(如少于 1,000 条)即可快速适配。

-

零样本泛化能力:对训练集中未出现的字符也能准确渲染

-

可控的多行文本生成:灵活合成多行文本,可逐行精确控制排版与内容。

-

数据高效:仅使用其他方法约百分之一的数据量,即可完成训练。

单行生成

针对多行一次性生成时存在小文本生成效果不佳的问题,考虑到单行文本编辑是许多用户的核心使用场景,并且往往能产生更稳定、更高质量的结果。团队发布了针对该场景优化的beta 版权重模型。与原始模型在整幅全尺寸掩码上渲染字形不同,beta 版本采用单行图像条作为字形条件输入。这种方式既减少了不必要的计算开销,又能提供更加稳定且高质量的监督信号,从而直接提升单行和小字体文本的渲染效果。

关键特征

-

显著提升单行文本渲染质量。

-

单行文本推理速度提升约 1.4 倍。

-

大幅提高小尺寸文本的合成准确性。

效果展示

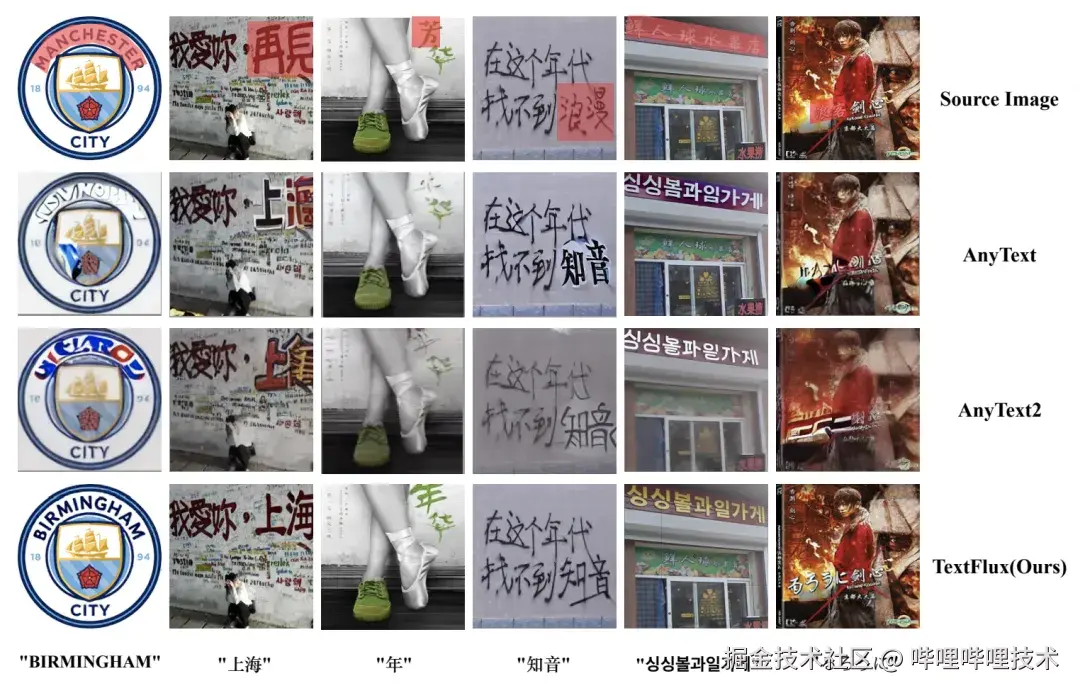

出色的多语言编辑能力

TextFlux 在多语种场景文本编辑任务中表现优异,能够高质量生成不同语言的文本,满足多元化视觉场景编辑需求。即便是新加入的低资源语言,只需少于 1,000 条样本,TextFlux 也可迅速适配并生成高质量文本,极大降低了数据标注和获取门槛。

图2 TextFlux编辑多语言场景文本

优越的视觉保真度和文本准确性

在视觉保真度和文本准确性两个方面,TextFlux 在定量评测和定性对比中均优于现有SOTA的文本编辑方法。尤其对于低分辨率的输入图像,TextFlux能够自适应的生成相对更清晰的文本。在一次性多行生成和单行生成的场景下,TextFlux都具有不俗的表现。甚至在和目前参数量十倍于己的基于LLM的图像生成模型相比较也取得了可比的效果。

与已有基于Diffusion方法的比较

图3 TextFlux与已有基于扩散模型的文字编辑方法的比较

与目前基于LLM的文生图模型的比较

图4 TextFlux与已有基于LLM的文字编辑方法的比较

可扩展性及Zero-Shot能力

得益于其创新的 OCR-Free 架构与视觉融合机制,TextFlux 对训练集中未包含的字符也能实现即时渲染(zero‑shot),有效拓展了应用场景。目前对于训练集中未见到的生僻中文字符及横排小语种,TextFlux有很好的泛化能力。尽管在未经特别挑选的情况下,个别字符有概率出现错误,但依旧证明了架构在OOD问题上强大的泛化能力。值得注意的是,目前生成连笔文字如阿拉伯文上,TextFlux的能力受限,这也是本工作将来的优化和研究方向之一。

图5 TextFlux在未见字集和未见语言上的Zero-shot能力

图6 TextFlux生成连笔文字的能力尚有待加强

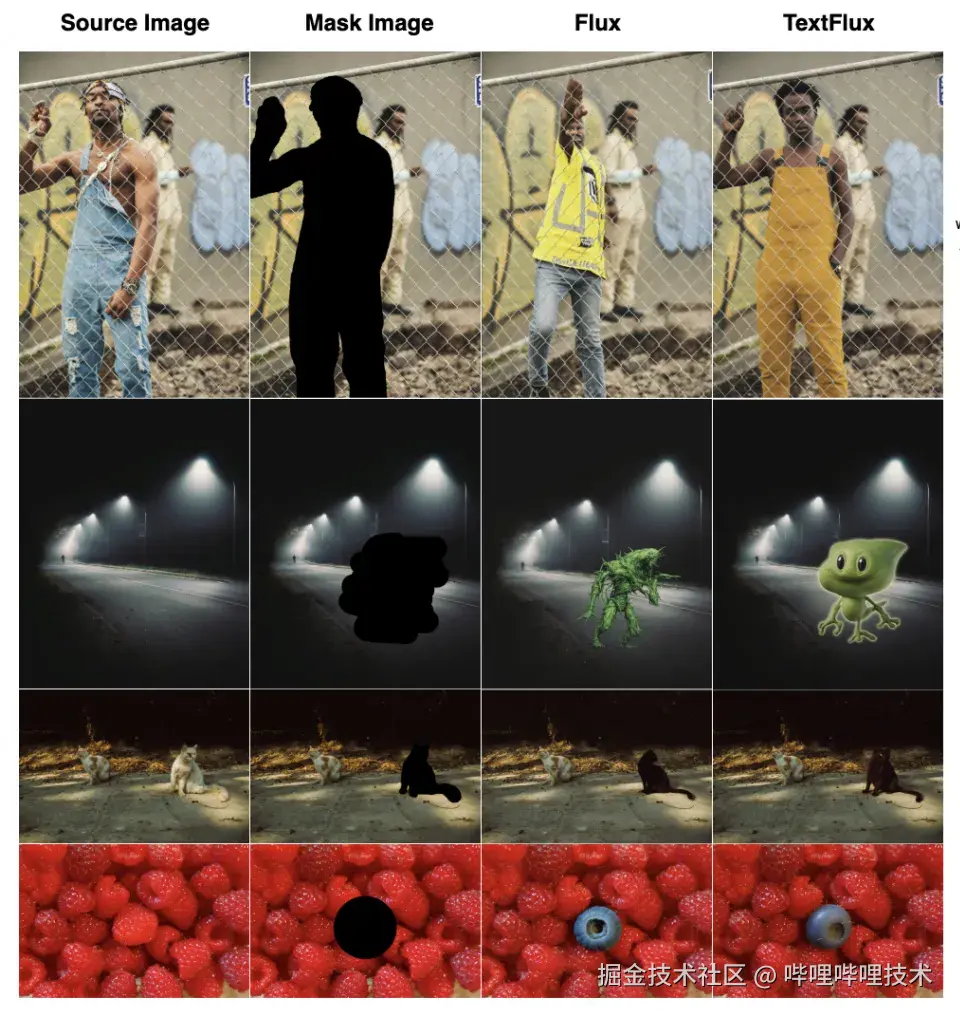

保留原始基座的通用能力

此外,TextFlux不会改变原本基座模型的通用能力,具备良好的可扩展性,基于提供的权重,能够赋予其他基于该基座模型的工作多语言的生成能力。

图7 TextFlux很好的保留了Flux-Fill的通用能力

总结

TextFlux 打破了场景文本编辑的瓶颈,提出一种"OCR-Free"架构:只用字形图像作引导,依托 Diffusion Transformer(DiT)完成生成。相比需要额外视觉-文本控制模块和海量标注的方法,它结构更精简、数据效率更高,支持多语种、多行文本及复杂字形,甚至对未见字符也能零样本泛化。这一新范式不仅提升了视觉真实度和文字准确率,也为多语言文本融合落地提供了可行路径。

-End-

作者丨seasonxy、墨枢、Jerry酱