RabbitMQ核心问题解析:从消息可靠性到高可用架构

在现代分布式系统中,消息队列(MQ)扮演着异步通信、系统解耦和流量削峰填谷的关键角色。RabbitMQ作为一款广泛使用的开源消息代理软件,其核心原理和应对各种异常情况的解决方案是开发者必须掌握的技能。本文将深入探讨五个关键问题:消息不丢失保障、重复消费处理、死信交换机与延迟队列、百万消息堆积应对策略以及高可用机制。

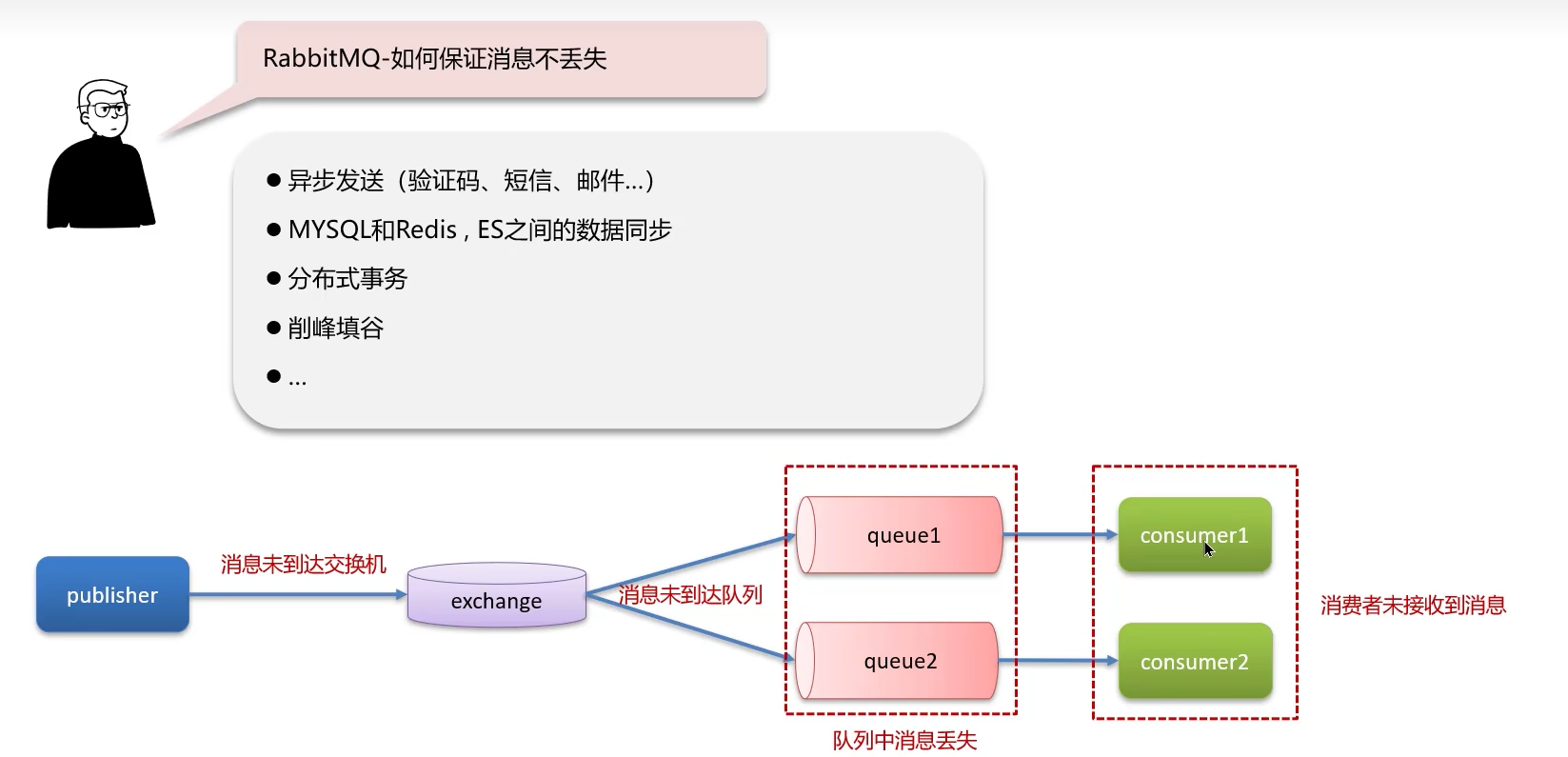

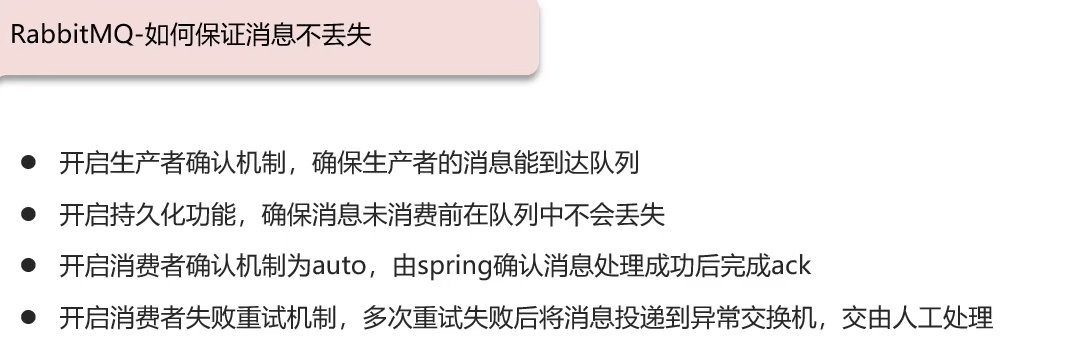

一、如何保证消息不丢失?

消息丢失是MQ中最严重的问题之一。要保证消息不丢失,必须从生产者传送消息到RabbitMQ服务器 、RabbitMQ服务器存储消息 、消费者消费消息这三个环节进行全方位保障。

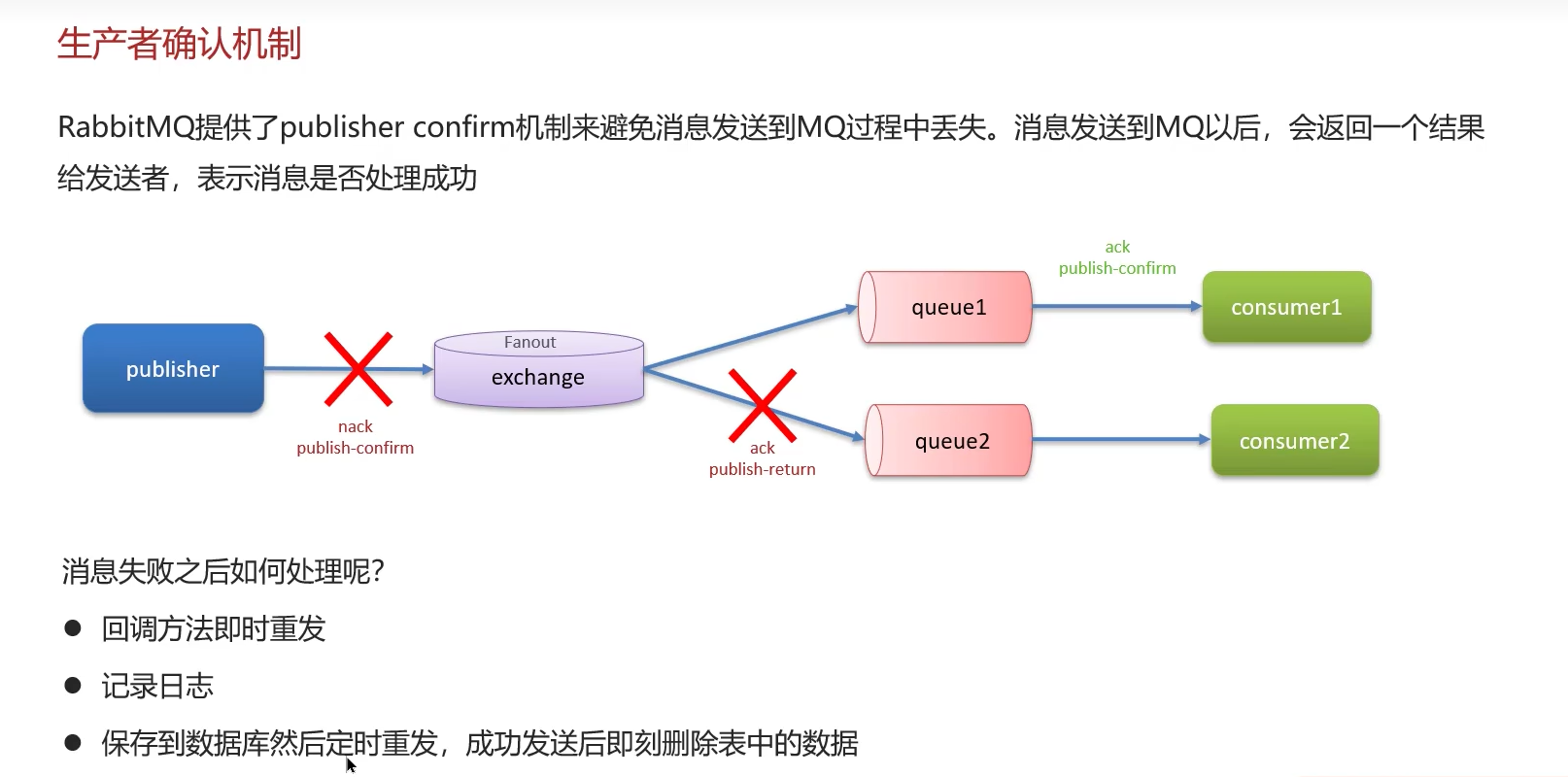

1. 生产者端:确保消息成功投递到Broker 生产者无法确定消息是否真正到达RabbitMQ服务器。为解决此问题,RabbitMQ提供了两种机制:

- 事务机制 (Transactions) : 通过

channel.txSelect(),channel.txCommit(),channel.txRollback()实现。但这是同步操作,会极大降低性能(吞吐量下降250倍左右),不推荐在生产环境中使用。 - 确认机制 (Publisher Confirms) : 这是推荐的异步方案。生产者将信道设置为

confirm模式(channel.confirmSelect()),之后所有在该信道上发布的消息都会被分配一个唯一ID。一旦消息被成功投递到所有匹配的队列,Broker会发送一个ack(确认)给生产者。如果消息是持久化的,会在消息被写入磁盘后 才发送ack,确保了真正的持久化。如果发生内部错误导致消息丢失,Broker会发送一个nack(未确认)信号,生产者可以据此进行重试或日志记录。

2. Broker端:确保消息在RabbitMQ中安全存储 即使消息到达Broker,如果RabbitMQ服务器宕机,内存中的消息依然会丢失。

- 队列和消息的持久化 (Durability) : 必须同时设置两者。

- 队列持久化 : 在声明队列时设置

durable为true。这确保了队列元数据在服务器重启后依然存在。 - 消息持久化 : 在发送消息时,将投递模式(

deliveryMode)设置为2(PERSISTENT)。这告诉RabbitMQ将消息保存到磁盘。 - 注意 : 持久化会对性能造成一定影响(因为涉及磁盘I/O),但为了数据可靠性,这是必要的牺牲。此外,消息在刚到达Broker时是存在于内存缓存中的,有一个短暂的时间窗口可能丢失,通过Publisher Confirms可以确保是在写入磁盘后才得到确认。

- 队列持久化 : 在声明队列时设置

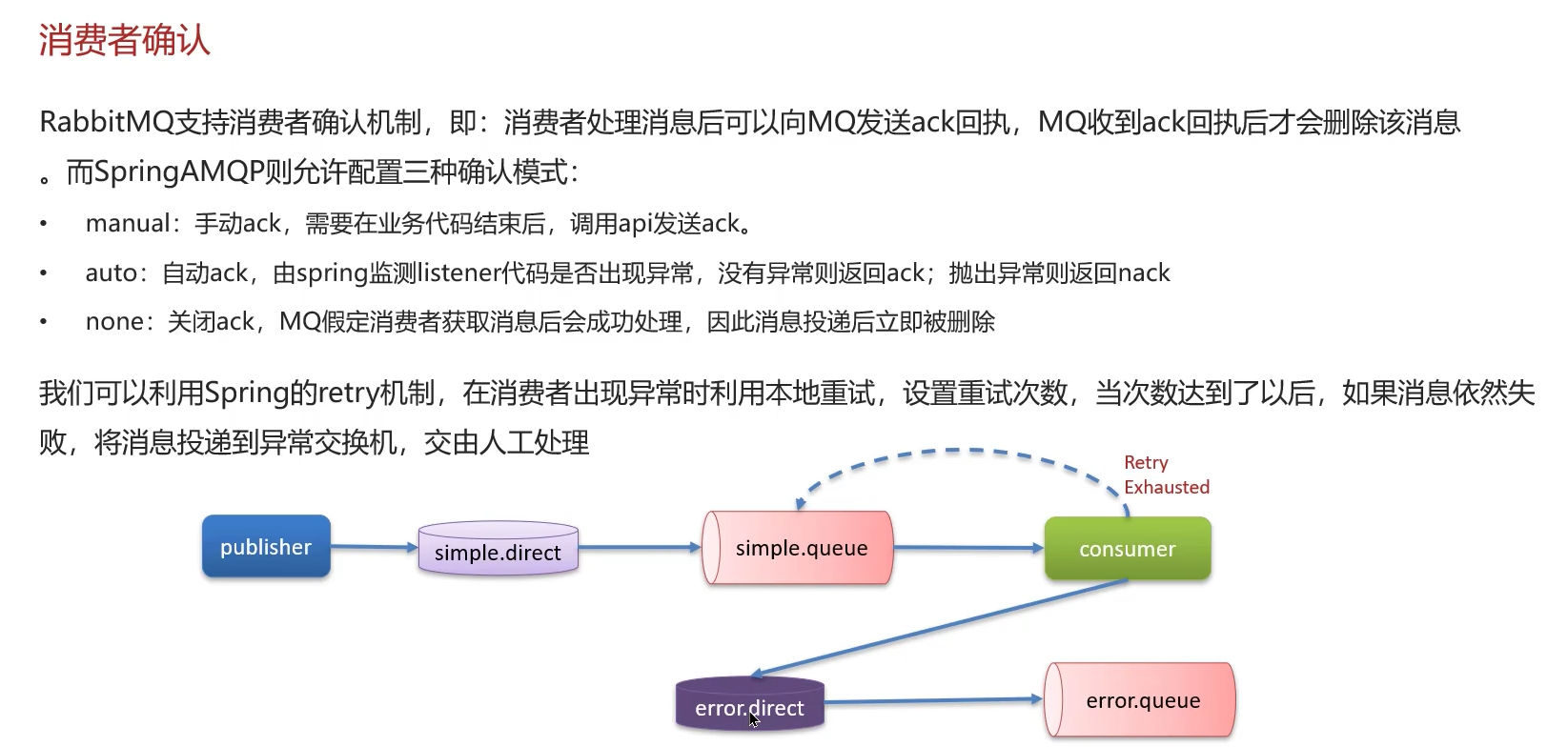

3. 消费者端:确保消息被成功消费 默认情况下,消费者在收到消息后,RabbitMQ会立即将其标记为删除。如果消费者在处理消息过程中发生异常或宕机,消息就会丢失。

- 手动应答 (Manual Acknowledgment) : 关闭自动应答(

autoAck=false),在处理完业务逻辑后,由消费者显式地调用channel.basicAck()向Broker发送一个确认信号。只有在收到这个ack后,Broker才会认为消息已被成功处理,从而将其删除。 - 拒绝和重入队 (Rejection and Requeue) : 如果处理失败,可以调用

channel.basicNack()或channel.basicReject(),并设置requeue为true,将消息重新放回队列,等待再次被消费。

总结保障链路: 生产者确认机制 + 消息与队列持久化 + 消费者手动应答 = 最大程度防止消息丢失。

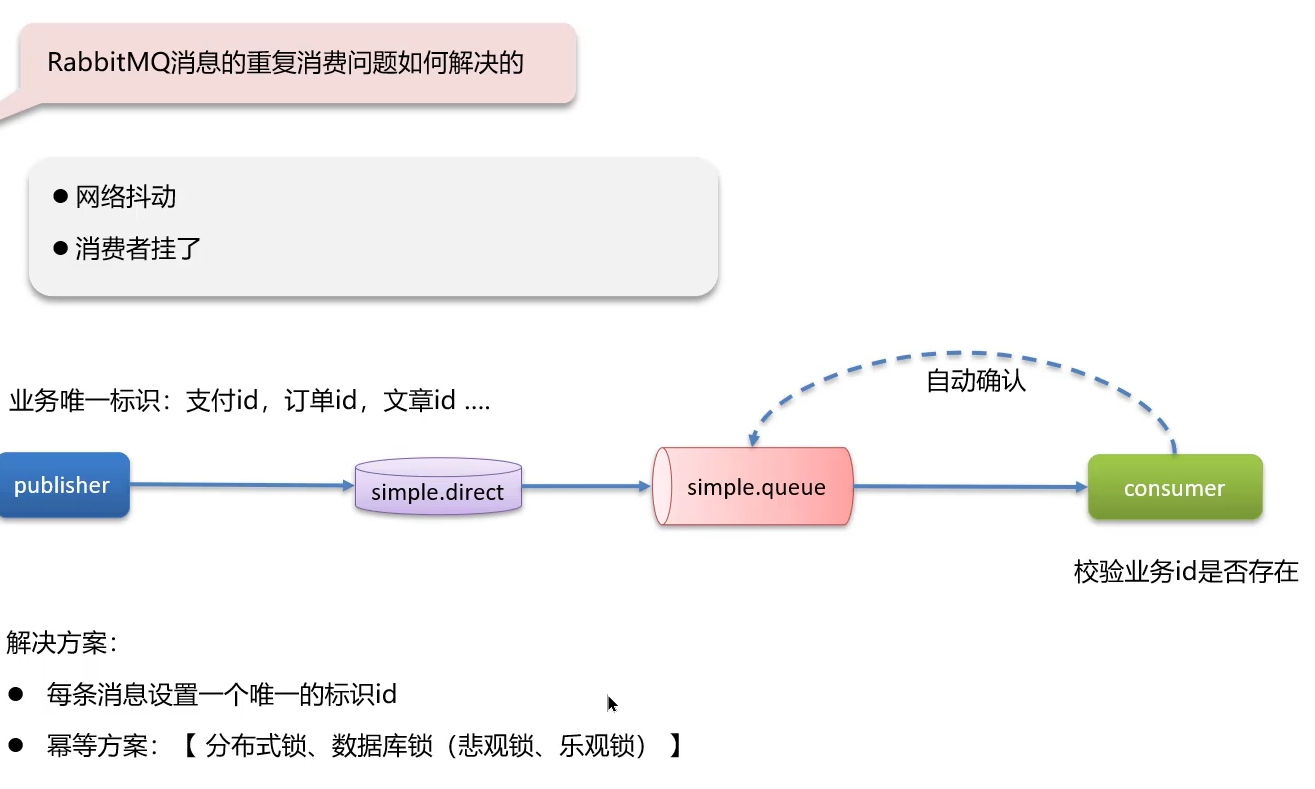

二、消息的重复消费问题如何解决?

导致重复消费的根本原因是:网络波动 和消费者故障 。例如,消费者处理完业务后,在发送ack之前突然宕机或连接断开,Broker未收到确认,会根据机制将消息重新投递给另一个消费者(或重启后的原消费者),从而导致消息被重复处理。

解决方案的核心是:实现消费端的幂等性 (Idempotence)。

幂等性是指一次请求和多次请求对系统资源的影响是一致的。解决重复消费问题需要在业务层面保证逻辑的幂等性,常用策略如下:

- 利用数据库唯一键约束: 最适合做新增操作。例如,消息处理逻辑是插入一条订单数据,可以为订单ID设置唯一索引。即使重复消息到来,第二次插入会失败,从而避免了重复数据。

- 乐观锁机制 : 适合做更新操作。例如,给账户增加余额。可以在消息中带一个版本号或时间戳,更新数据时采用

set balance = balance + 20, version = new_version where id = 1 and version = old_version。如果因为版本号不一致导致更新失败,说明已经是重复请求,直接确认消息即可。 - Token机制或全局ID : 生产者发送消息时,为每条消息赋予一个全局唯一的ID(如雪花算法ID)。消费者在处理消息前,先先检查这个ID是否已经被处理过(可以存入Redis或数据库)。如果已处理,则直接

ack,跳过后续业务逻辑;如果未处理,则进行业务处理并将ID记录下来。

选择哪种方案取决于具体的业务场景。幂等性是需要业务系统自己设计和实现的,RabbitMQ本身不提供此功能。

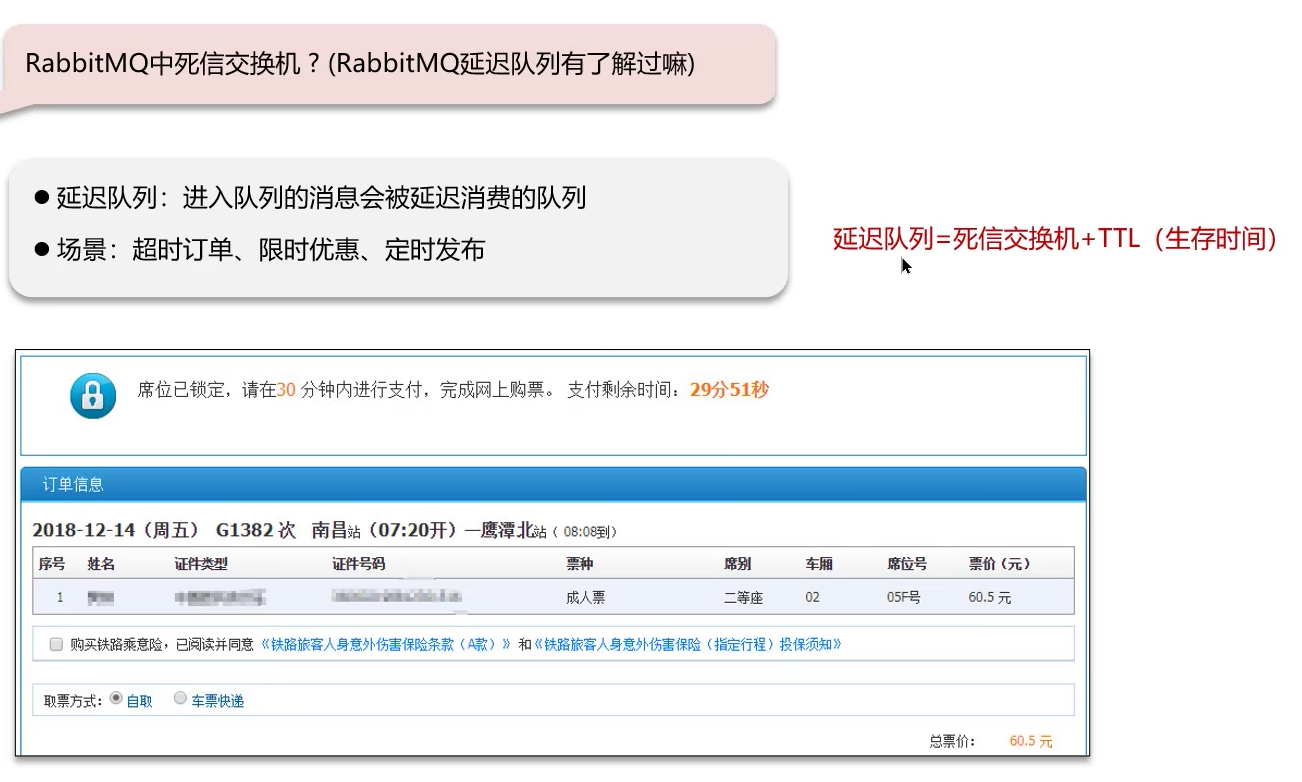

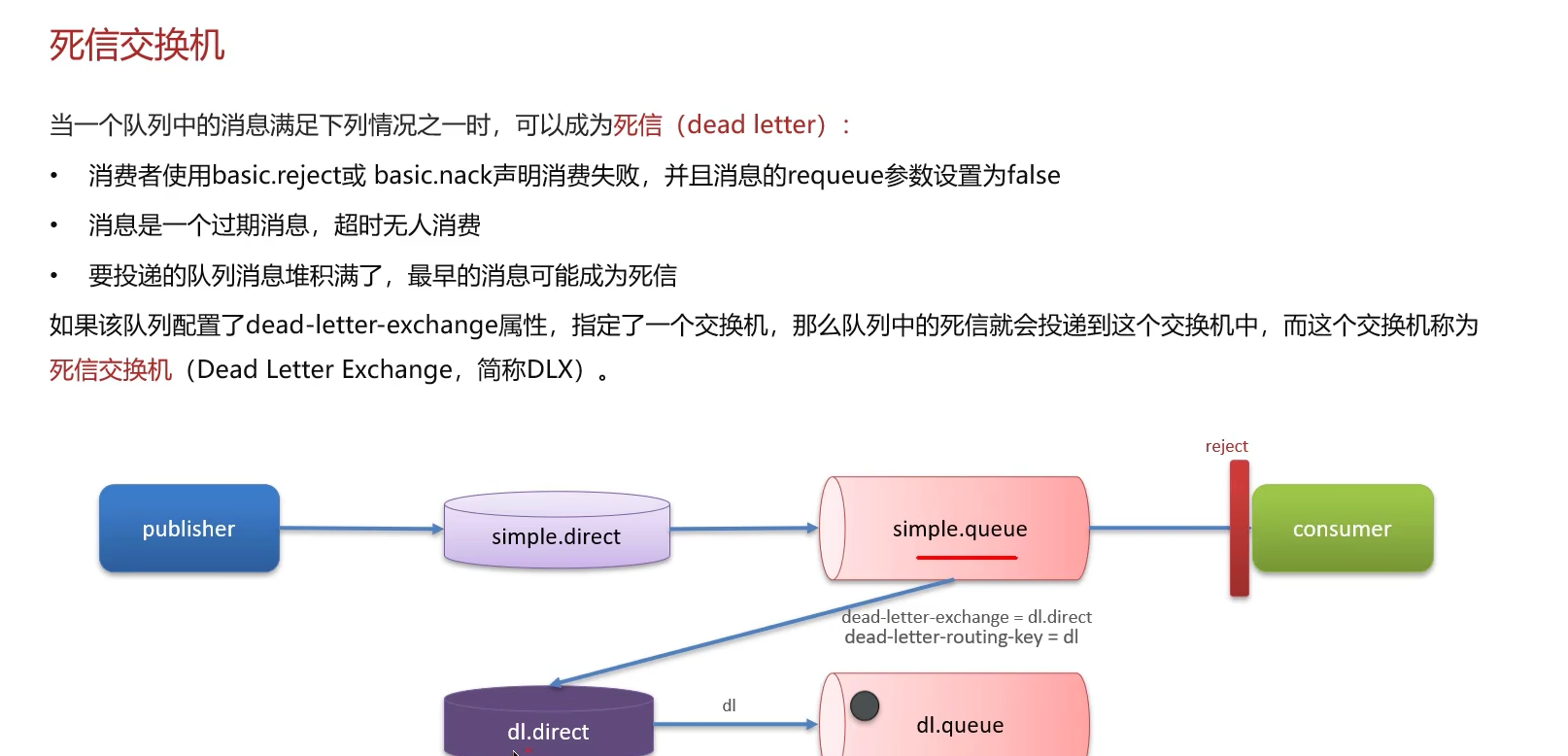

三、死信交换机与延迟队列

1. 死信交换机 (Dead Letter Exchange, DLX) 死信是指那些被拒绝、过期或无法投递的消息。而DLX就是用来接收这些死信的普通交换机。

一个队列在创建时可以配置一个死信交换机,并绑定以下情况:

- 消息被消费者拒绝 : 消费者调用

basic.reject或basic.nack且设置requeue参数为false(不重新入队)。 - 消息过期 (TTL): 消息在队列中的存活时间超过了设置的TTL(Time-To-Live)。

- 队列达到最大长度: 队列中的消息数量超过了设置的最大长度限制。

当上述情况发生时,该队列中的消息就会变成"死信",并被RabbitMQ重新发布到配置的DLX上,进而路由到死信队列(DLQ)中。开发者可以监听这个死信队列,对异常消息进行后续处理,如记录日志、报警、人工干预等。

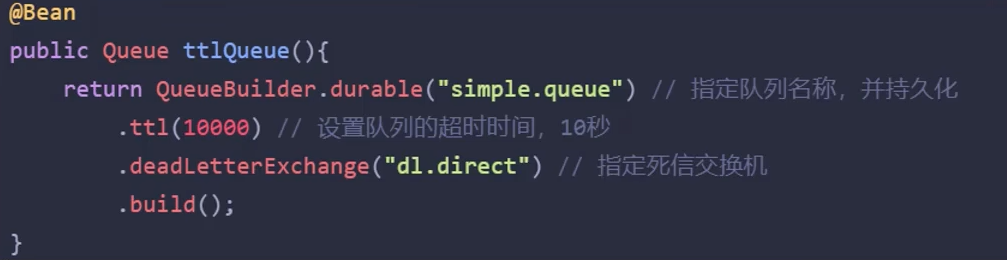

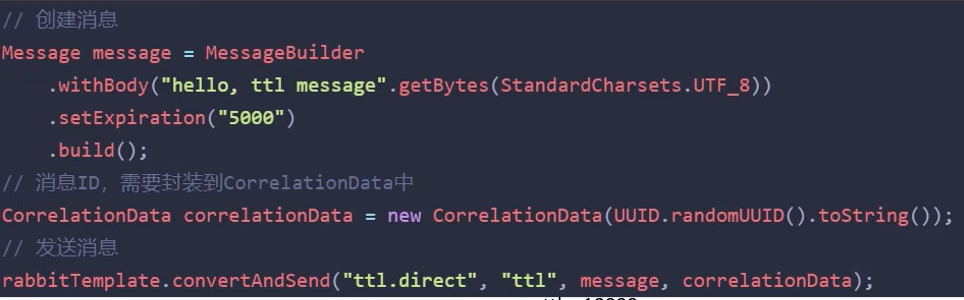

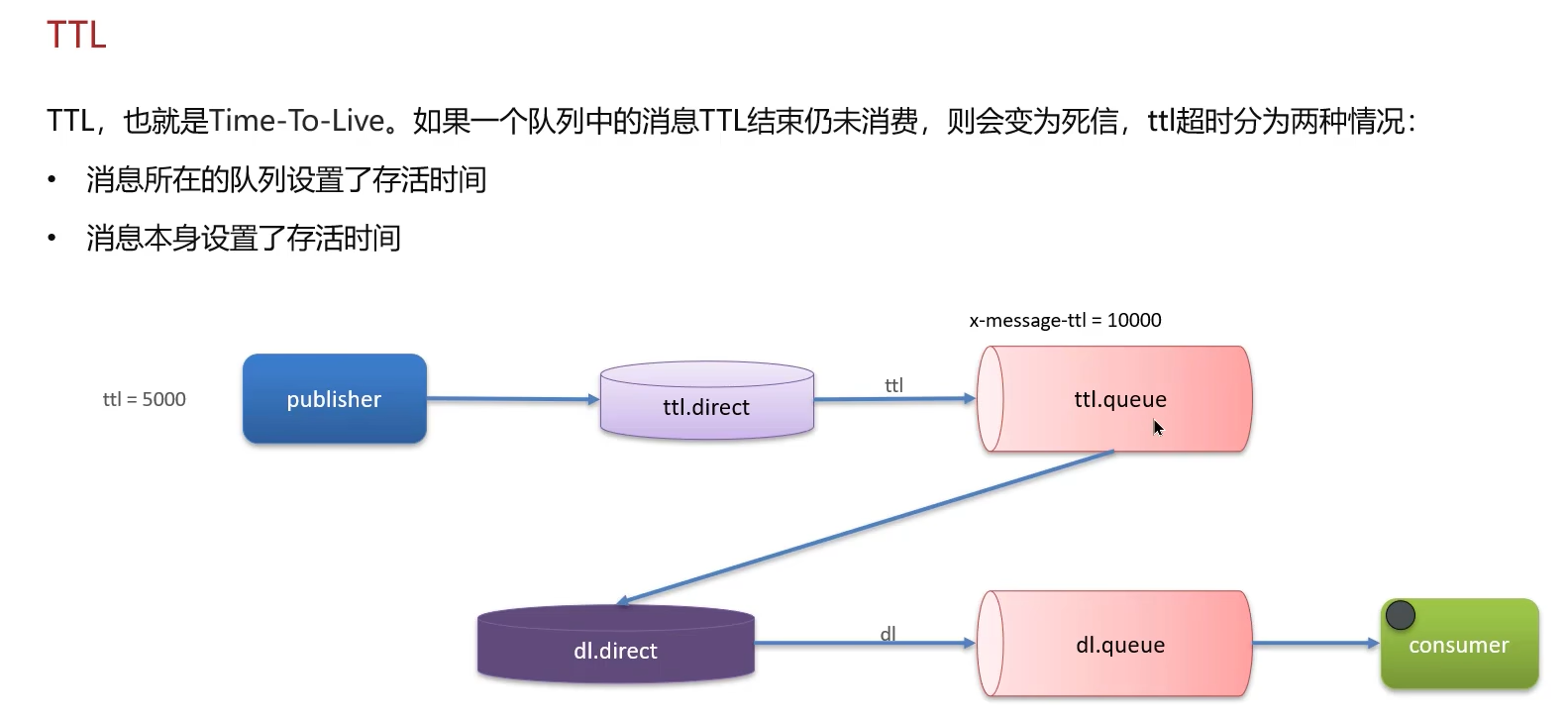

2. 延迟队列 (Delayed Queue) RabbitMQ本身没有直接提供延迟队列功能,但可以通过 DLX + 消息TTL 来模拟实现。

实现原理:

- 创建一个普通业务队列

delay_queue,为其设置两个关键参数:x-dead-letter-exchange(指定死信交换机dlx_exchange)和x-message-ttl(指定所有消息的TTL,例如5000毫秒)。 - 创建一个死信交换机

dlx_exchange和一个死信队列dlq,并将它们绑定(例如路由键为#匹配所有消息)。 - 生产者将消息发送到

delay_queue,这些消息在5秒内无法被任何消费者看到(因为它们还在delay_queue中)。 - 5秒后,消息过期,成为死信,被自动路由到

dlx_exchange,并最终进入死信队列dlq。 - 消费者监听

dlq,就实现了在5秒后收到消息的效果,即延迟队列。

注意 : RabbitMQ有一个官方的延迟消息插件 (rabbitmq-delayed-message-exchange)。它提供了一种更高效的方式,允许你在交换机上定义延迟,消息在到达交换机后会被延迟一定时间再投递到队列,无需使用死信队列迂回方案,性能更好且更直观。

小结:

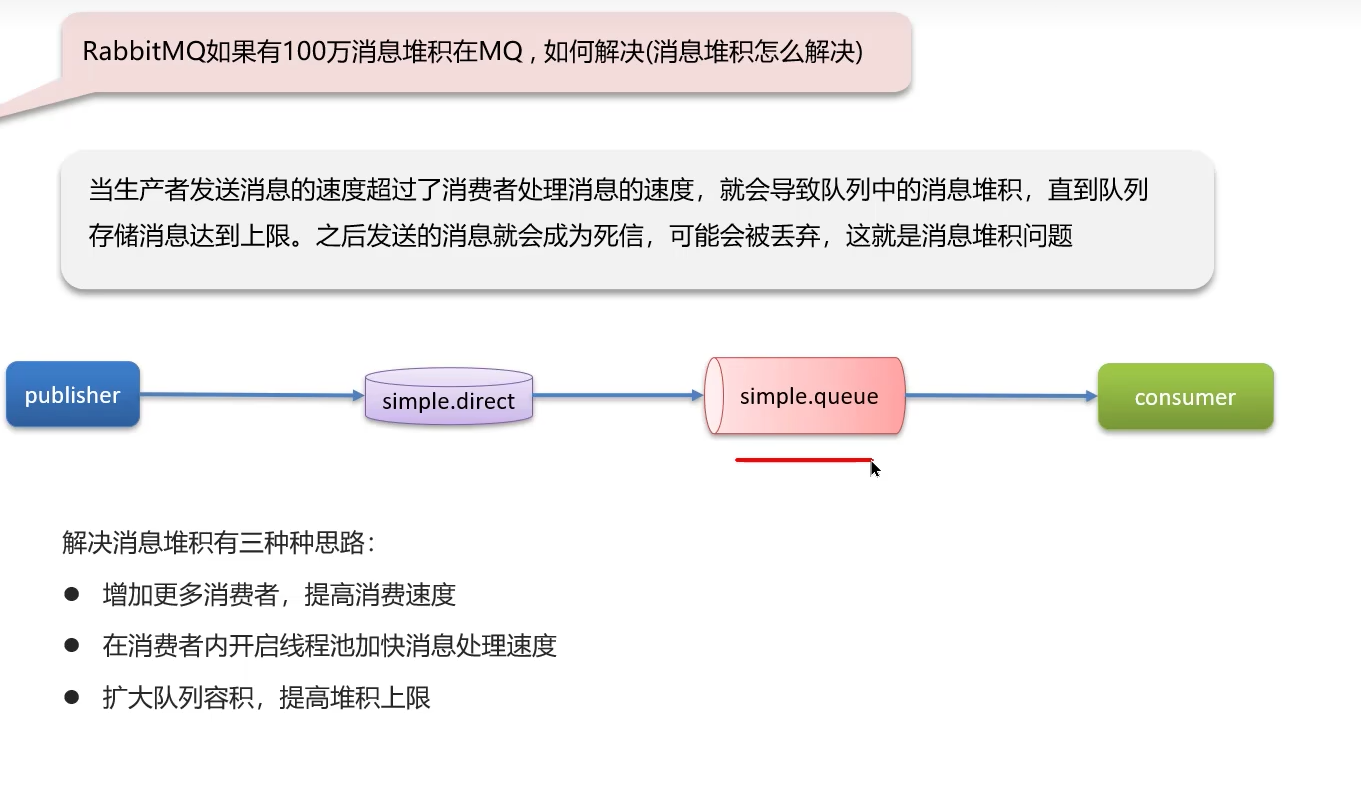

四、百万消息堆积如何解决?

消息堆积的直接原因是:消息的生产速度远远大于消费者的消费速度。解决思路无非是"开源"和"节流"。

-

排查并修复消费者故障 (节流 - 首要任务):

- 检查消费者应用是否宕机或卡死,尽快恢复。

- 检查是否有消费逻辑错误(如死循环、耗时操作)、消费代码性能瓶颈(如慢SQL、未使用缓存),并进行优化。

-

增加消费者数量 (开源):

- 这是最直接有效的方法。部署多个消费者实例,通过增大并发来提升整体消费速率。RabbitMQ的默认工作模式(Work Queues)天然支持竞争消费,只需启动多个相同功能的消费者即可。

-

扩大队列容量,避免被撑爆:

- 在声明队列时,可以设置

x-max-length参数来指定队列能容纳的最大消息数量,避免无限制堆积压垮服务器。但这只是防御措施,不能解决堆积本身。

- 在声明队列时,可以设置

-

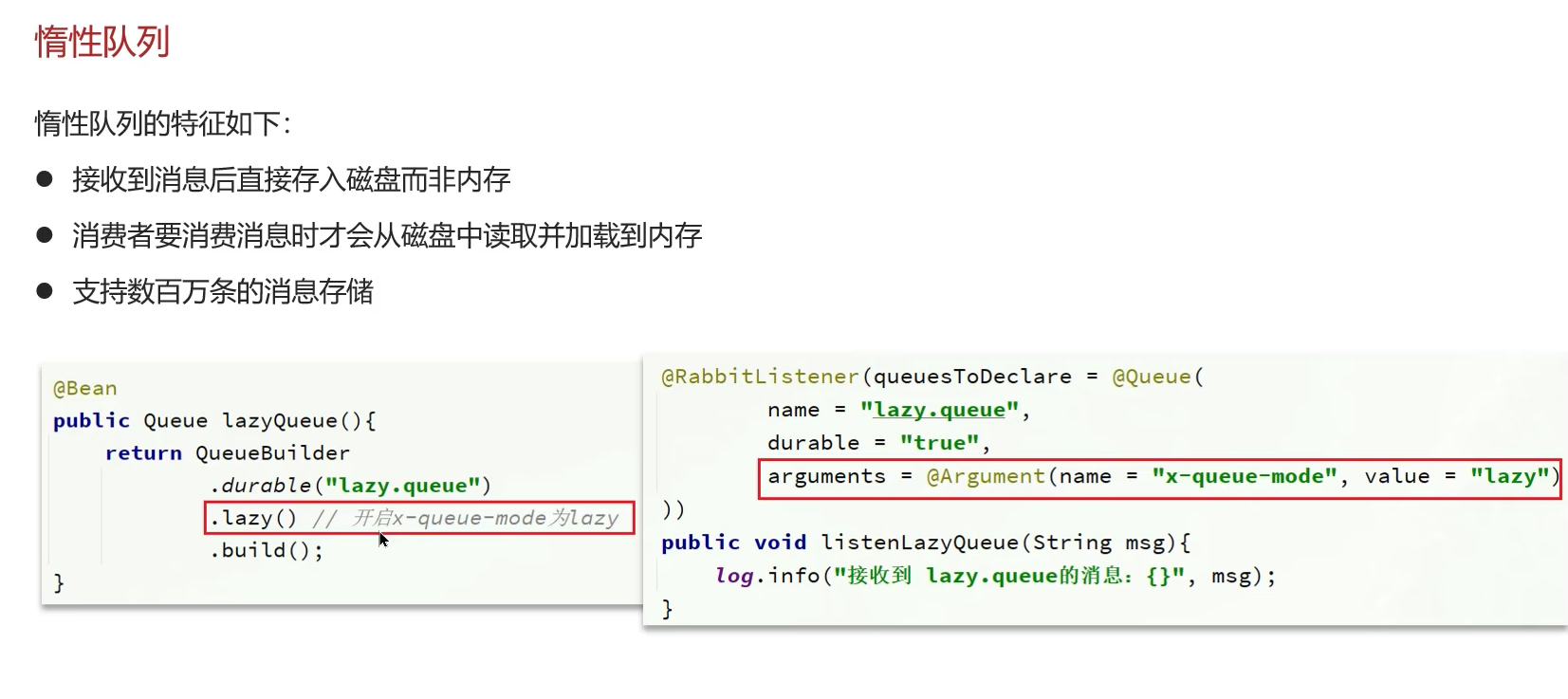

启用惰性队列 (Lazy Queues) - 应对大量堆积:

- 惰性队列将消息直接写入磁盘,而非尽量保存在内存中。这极大地提升了Broker抗堆积的能力(支持数百万条消息),避免了大量消息堆积导致内存耗尽而崩溃的风险。

- 可以在管理界面通过设置队列的

x-queue-mode为lazy来启用,或在声明队列时指定Arguments。

-

服务端扩容:

- 如果硬件资源(CPU、磁盘IO、网络带宽)已成为瓶颈,需要考虑对RabbitMQ服务器本身进行垂直扩容(升级配置)或水平扩容(搭建集群)。

-

事后补救:

- 如果堆积已经发生且消费者一时难以快速处理,可以编写一个临时的消息转移程序,将堆积队列中的消息部分取出,转发到另一个临时 topic/queue(可以设置更多消费者来处理),或者甚至持久化到数据库,再慢慢处理,先让主业务队列恢复工作。

五、RabbitMQ的高可用机制

RabbitMQ通过集群 (Cluster) 和镜像队列 (Mirrored Queues) 来实现高可用,防止单点故障。

-

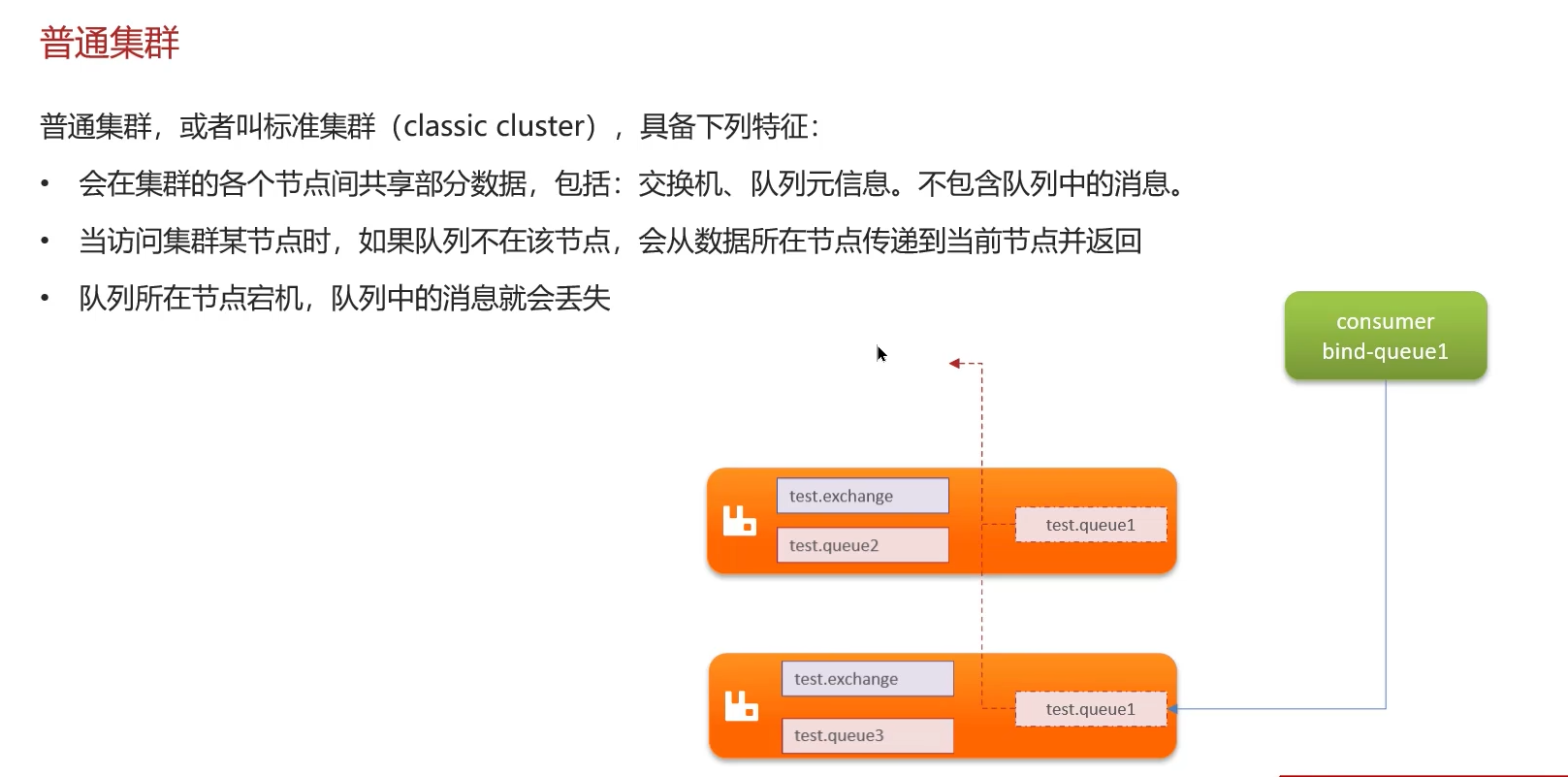

普通集群模式:

- 多个RabbitMQ节点组成一个集群,共享部分数据(队列的元信息),但队列的内容只存在于创建它的那个节点上。

- 消费者连接非主节点时,集群会通过内部链路从主节点拉取消息数据,这存在跨节点传输的开销和风险。

- 缺点: 一个节点宕机,其上的队列内容和元信息都会丢失,无法实现高可用。主要用于分散压力,而非保证可靠性。

-

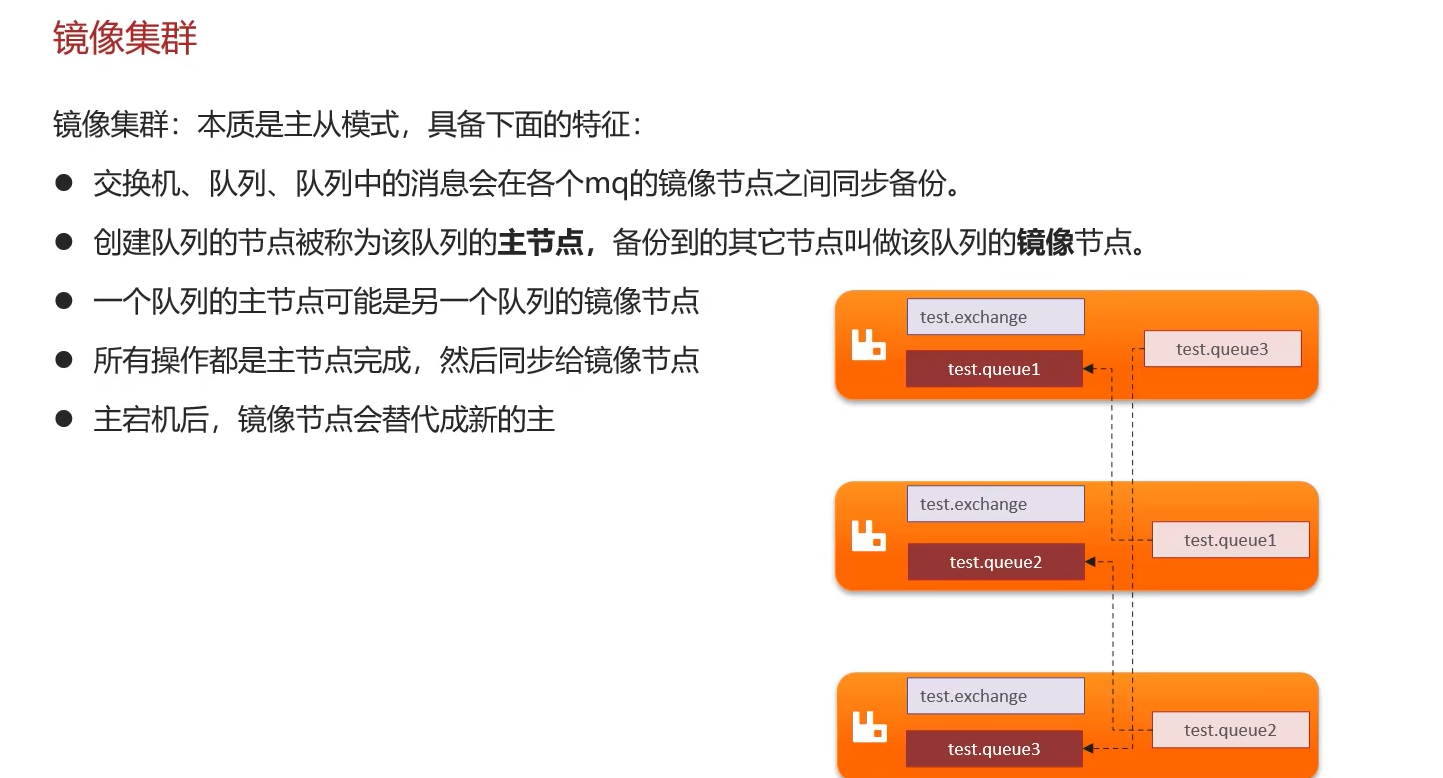

镜像队列模式 (高可用方案):

- 这是真正实现高可用的方案。镜像队列将队列的内容(消息)复制到集群中的多个甚至所有节点上。每个镜像队列都有一个主节点(Master)和若干个从节点(Slave)。

- 消息的读写都在主节点上进行,然后主节点将操作同步给所有从节点。

- 如果主节点宕机,存活时间最长的从节点会自动被提升为新的主节点,继续提供服务,整个过程对客户端基本透明(客户端需要有重连机制)。从而实现了队列的高可用。

- 可以配置策略来定义镜像规则,如

ha-mode: all(镜像到所有节点)、ha-mode: exactly(镜像到指定数量的节点)等。

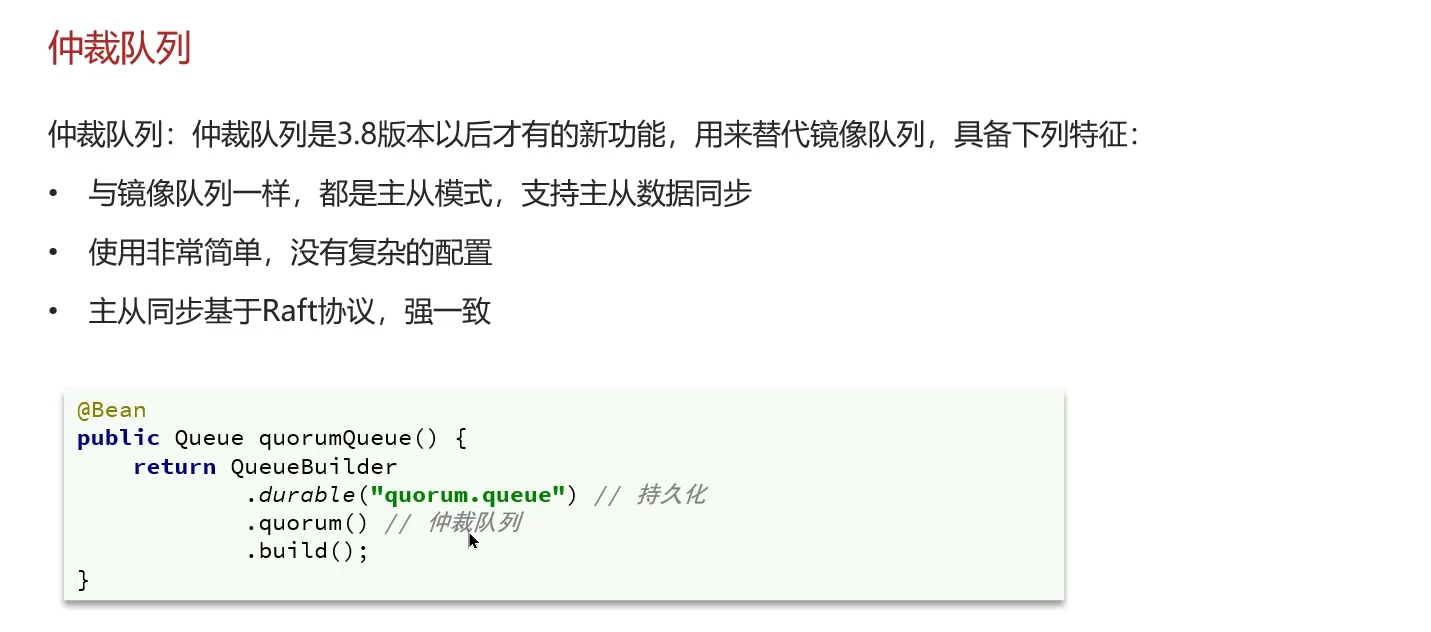

3、仲裁队列,主从同步基于Raft协议。

结论:使用仲裁队列

总结

| 问题 | 核心解决方案 | 关键点 |

|---|---|---|

| 消息不丢失 | 生产者确认 + 持久化 + 消费者手动ACK | 确保消息穿透整个生命周期的可靠性 |

| 重复消费 | 消费端幂等性 | 唯一约束、乐观锁、全局ID |

| 死信/延迟队列 | DLX + TTL | 处理异常消息,模拟延迟任务;或使用官方插件 |

| 消息堆积 | 排查消费者 + 增加并发 + 惰性队列 | "开源节流",优先保证消费者健康与性能 |

| 高可用 | 集群 + 镜像队列 | 通过数据冗余和自动故障转移避免单点故障 |

理解和熟练运用这些机制,能够帮助我们构建出更加稳定、可靠、健壮的基于RabbitMQ的分布式系统。