「【新智元导读】DeepSeek 最新模型 V3.2-Exp 发布,推出全新注意力机制 DeepSeek Sparse Attention(DSA),训练推理提效的同时,API 同步降价达 50% 以上!」

一图看透全球大模型!新智元十周年钜献,2025 ASI 前沿趋势报告 37 页首发

刚刚,DeepSeek 最新模型上线!

代号 DeepSeek-V3.2-Exp,被 DeepSeek 誉为最新的实验性模型!

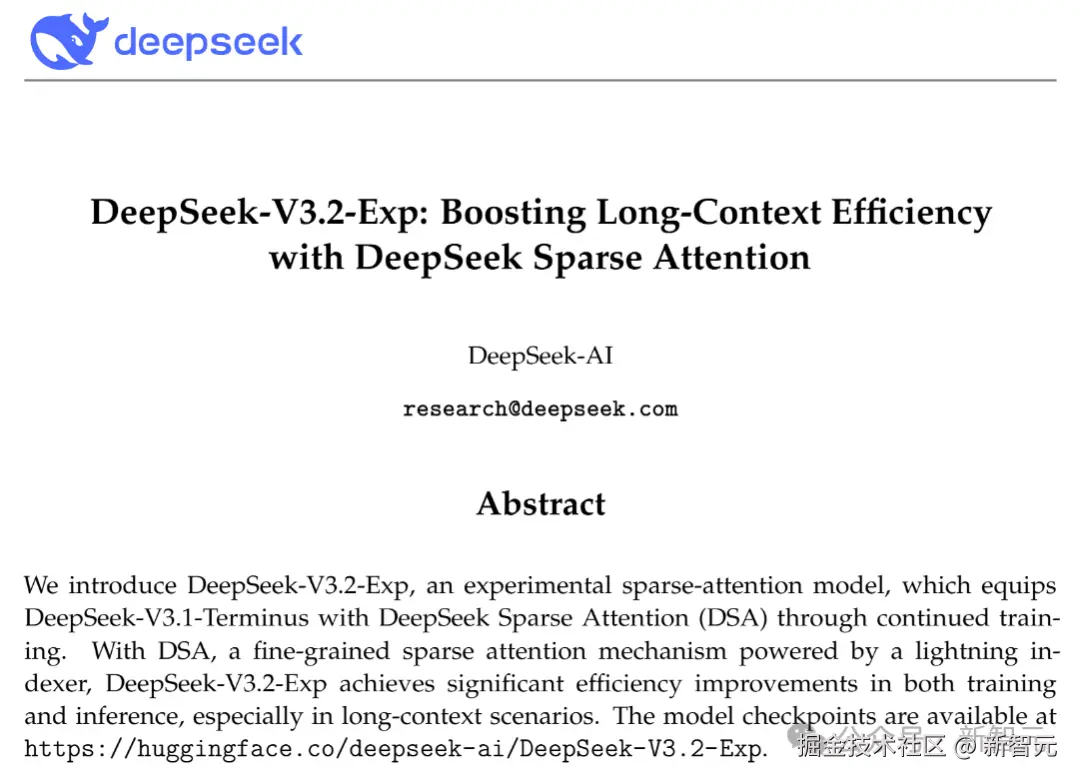

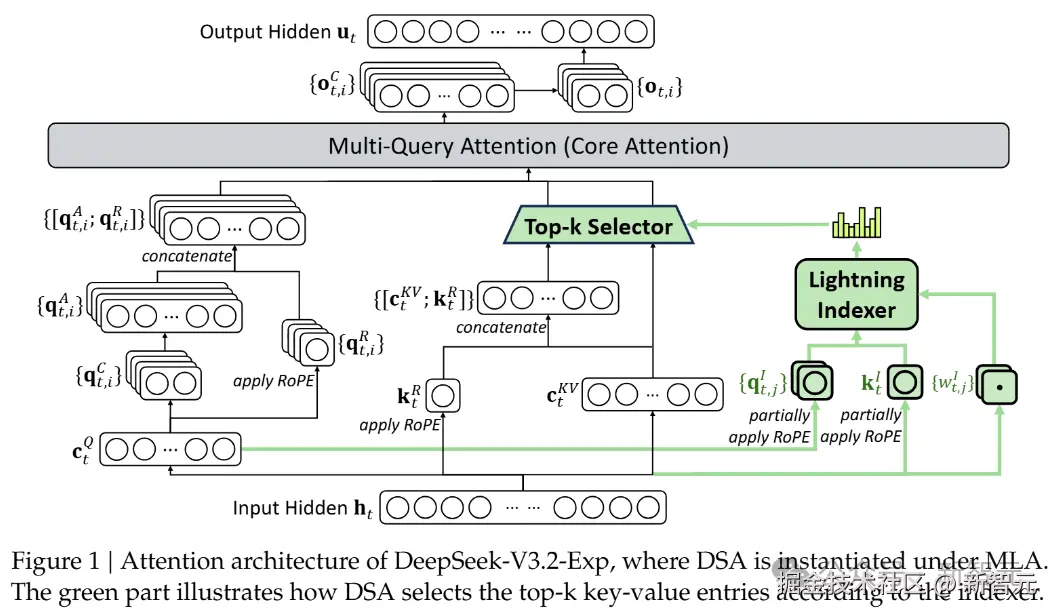

这次 V3.2 主要基于 DeepSeek-V3.1-Terminus,并且首次引入「DeepSeek 稀疏注意力」(DeepSeek Sparse Attention,DSA),在长上下文上实现更快、更高效的训练与推理。

值得注意的是,这是第一个用「DeepSeek」品牌命名的关键技术(注意力机制)!

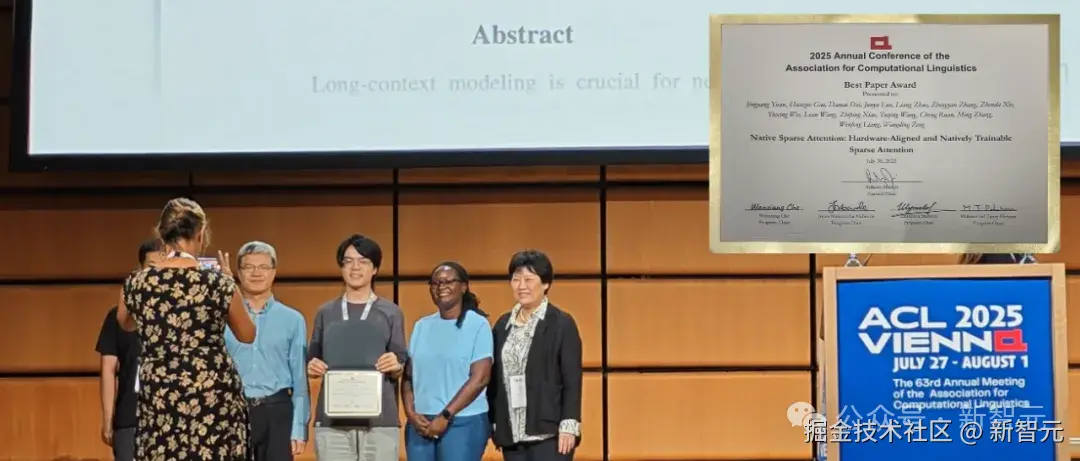

我们注意到,DSA 正是此前与北大合作、梁文锋署名的那篇 ACL 2025 最佳论文中,原生稀疏注意力(Native Sparse Attention,NSA)的改进。

技术报告里的引用

「全新注意力机制」

DeepSeek-V3.2-Exp 的核心武器「DeepSeek 稀疏注意力」,首次实现了细粒度稀疏注意力机制,在几乎不影响模型输出效果的前提下,实现了长文本训练和推理效率的大幅提升。

论文地址:github.com/deepseek-ai...

与之前模型最大的不同是,DSA 不再让每个 Token 关注序列中的所有其他 Token,而是引入了一个名为「闪电索引器」(lightning indexer)的高效组件。

这个索引器能以极快的速度判断,对于当前正在处理的 Token,序列中哪些历史 Token 是最重要的。

随后,模型只从这些最重要的 Token 中选取(Top-k)一小部分(例如 2048 个)进行精细计算。

如此一来,核心注意力的计算复杂度就从 O(L²) 骤降至 O(Lk),其中 k 是一个远小于 L 的固定值。

这在处理长文本时,无疑带来了巨大的效率提升。

更关键的是,这种效率提升并非以牺牲性能为代价。

在 DeepSeek-V3.1 的基础上,团队先用一个简短的「密集预热」阶段来初始化闪电索引器,让它学会模仿原有模型的注意力分布。

随后进入「稀疏训练」阶段,让整个模型适应新的稀疏模式。

最后,再沿用与前代模型完全相同的后训练流程,包括专家蒸馏和混合强化学习(GRPO)。

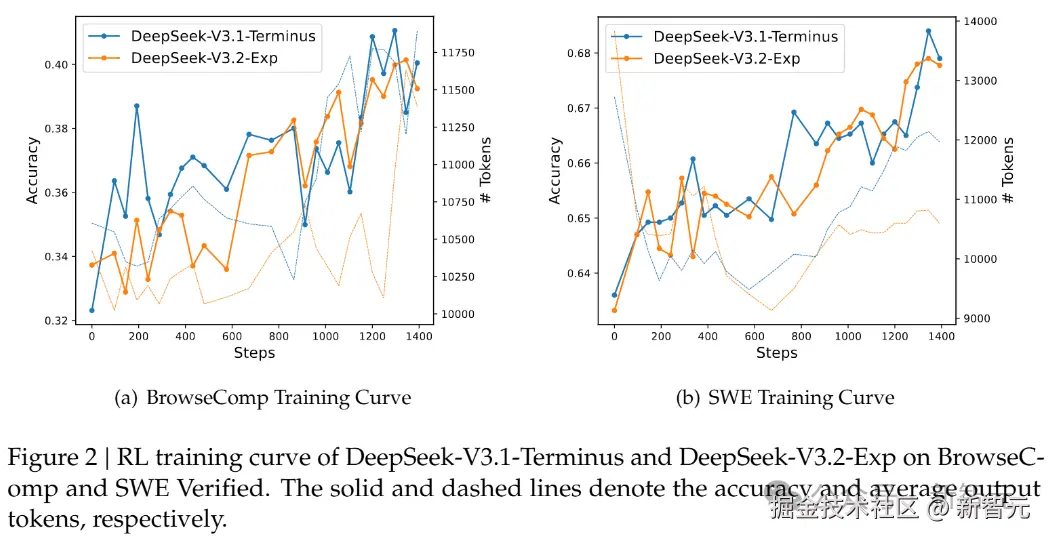

为了严谨地评估引入稀疏注意力带来的影响,DeepSeek 特意把 DeepSeek-V3.2-Exp 的训练设置与 V3.1-Terminus 进行了严格的对齐。

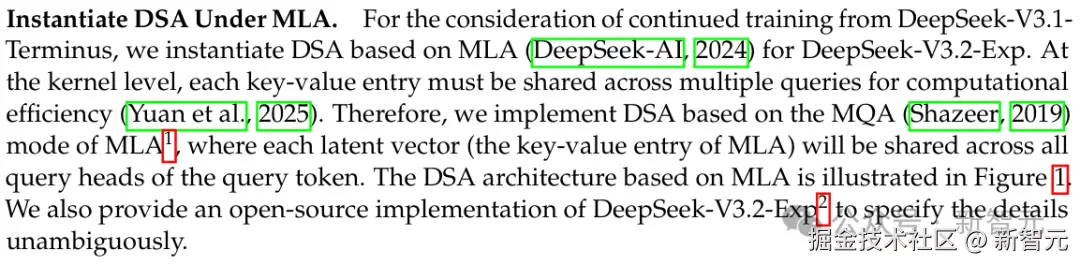

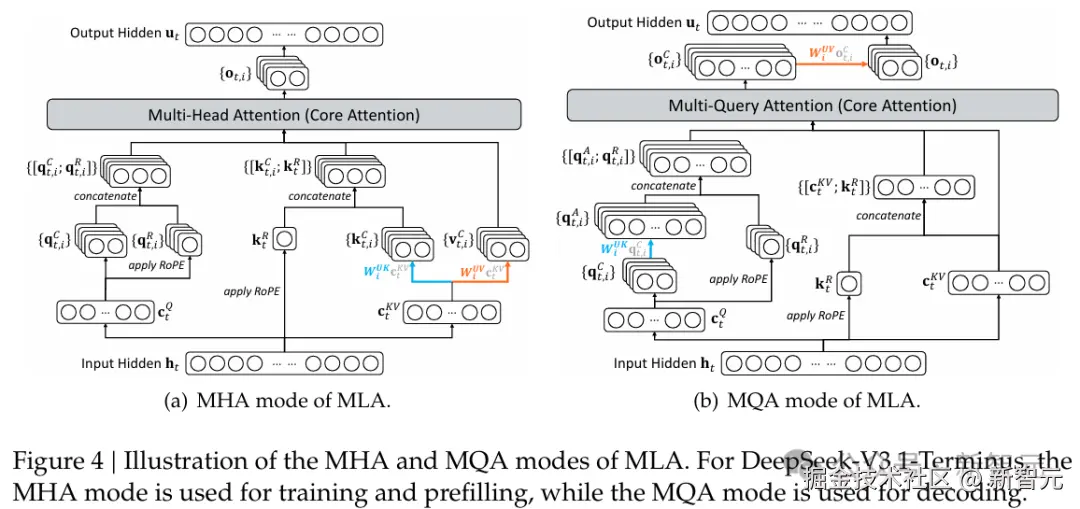

DeepSeek-V3.2-Exp 的架构图,其中 DSA 在 MLA 下实例化。

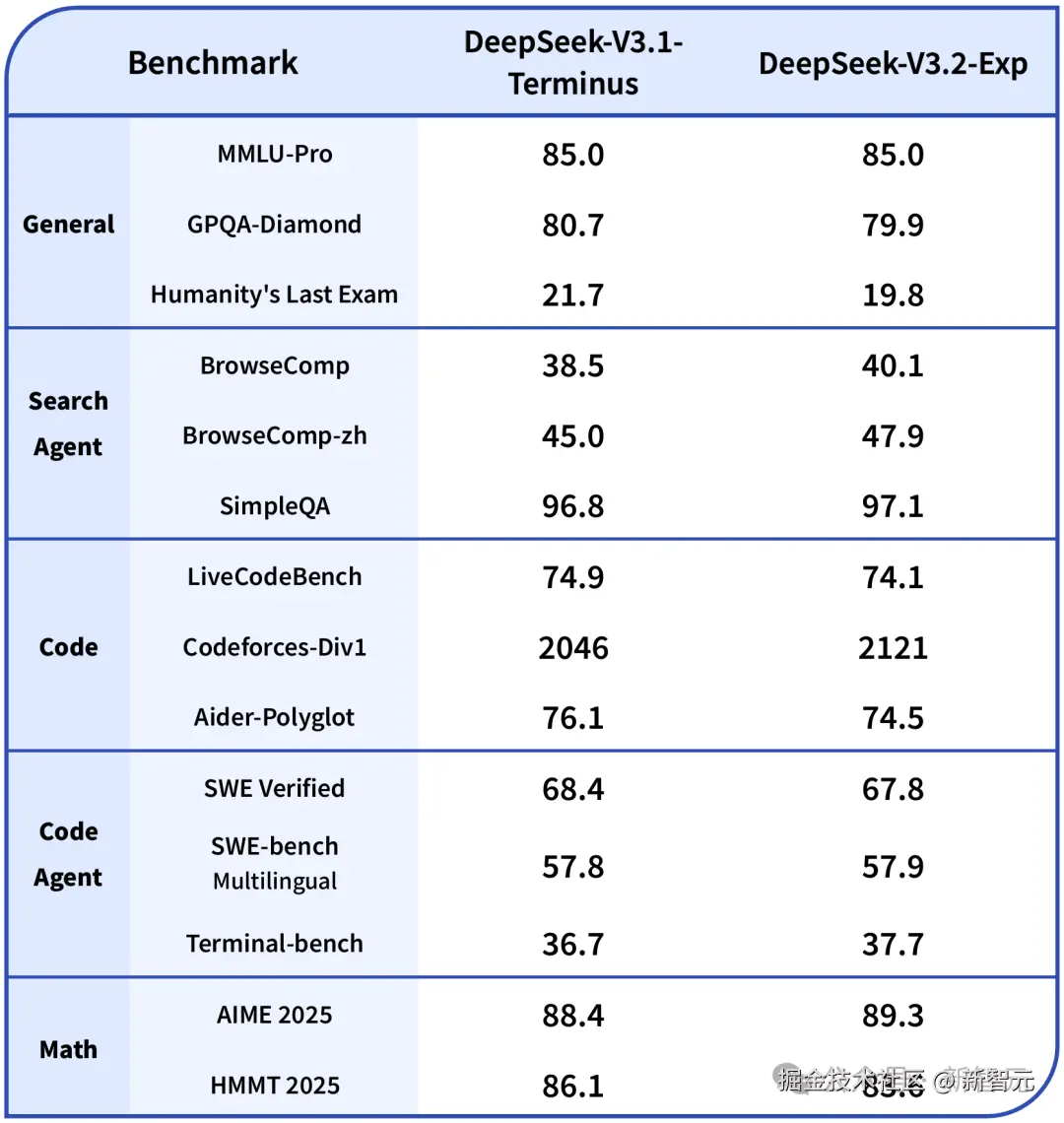

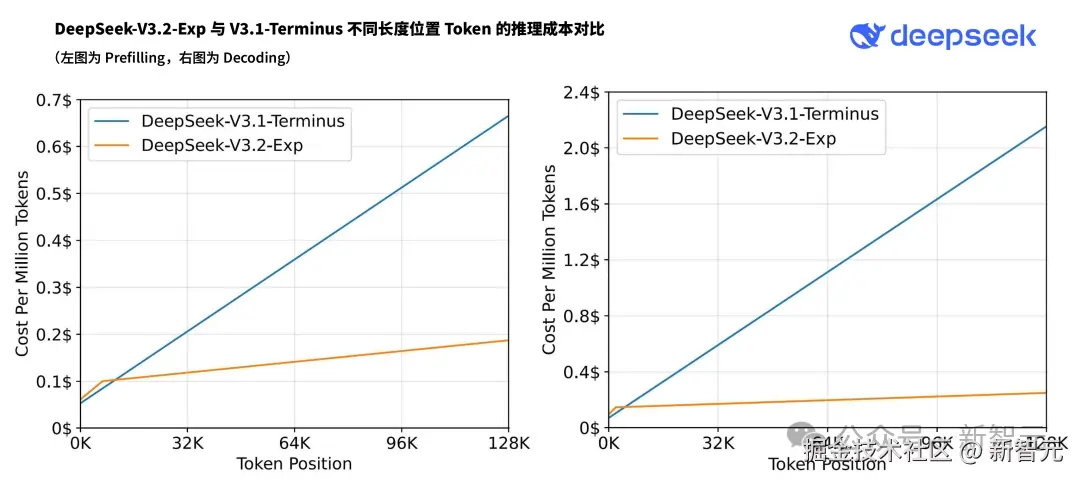

评估结果显示,无论是在短文本还是长文本任务上,DeepSeek-V3.2-Exp 的性能与它的「密集注意力」前身 V3.1-Terminus 相比,都没有出现实质性的性能下降。

与此同时,在实际部署的推理成本测试中,其端到端的加速效果和成本节约非常显著。

虽然 DeepSeek-V3.2-Exp 目前还是一款实验性模型,但它所展示的「性能不降、成本骤减」的特性,为大模型突破长文本瓶颈,指明了一条充满希望的工程路径。

「价格更便宜」

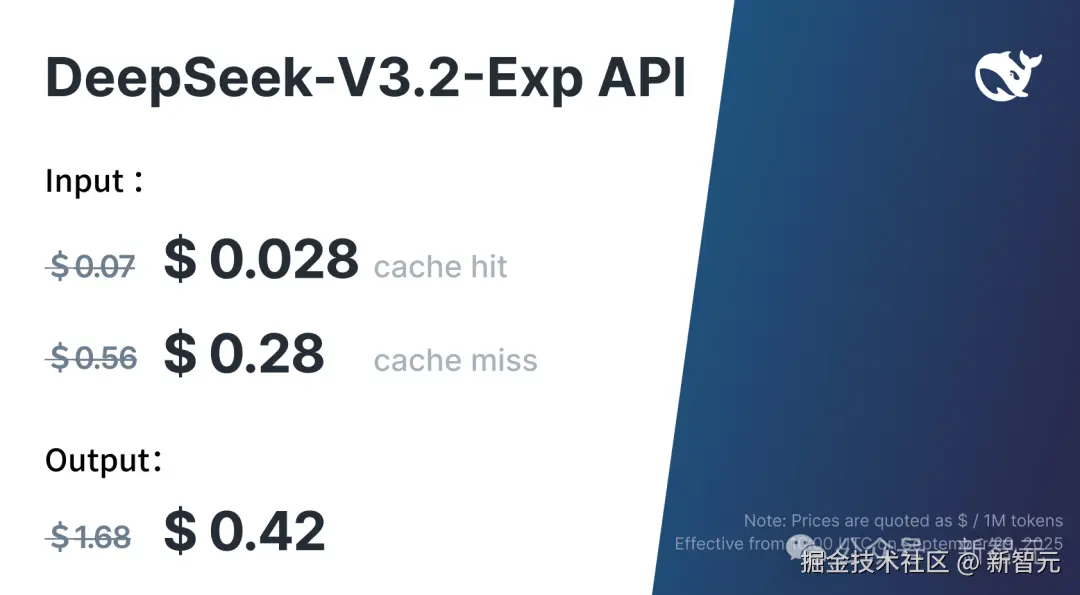

DeepSeek 再一次把模型价格打了下来!

得益于新模型服务成本的大幅降低,官方 API 价格也相应下调,新价格即刻生效。

在新的价格政策下,开发者调用 DeepSeek API 的成本将降低 50% 以上。

目前 API 的模型版本为 DeepSeek-V3.2-Exp,访问方式保持不变。

最后,不得不说,这次 DeepSeek 太仁慈了,「发布节奏」真的听取了网友的建议,给众多 AI 界的朋友们放个好假!

参考资料: