AI Ping 赋能:基于 GLM-4.7(免费!)+ LangChain + Redis 打造智能AI聊天助手

本文章目录

- [AI Ping 赋能:基于 GLM-4.7(免费!)+ LangChain + Redis 打造智能AI聊天助手](#AI Ping 赋能:基于 GLM-4.7(免费!)+ LangChain + Redis 打造智能AI聊天助手)

-

- 摘要

- [GLM-4.7 & MiniMax M2.1 实测上线!AI Ping 免费用,速冲!](#GLM-4.7 & MiniMax M2.1 实测上线!AI Ping 免费用,速冲!)

- 一、智能AI聊天助手应用展示

-

- [(一) 应用简介](#(一) 应用简介)

- [(二) 核心功能演示](#(二) 核心功能演示)

-

- [1. 流式对话交互](#1. 流式对话交互)

- [2. 对话记忆能力](#2. 对话记忆能力)

- [二、AI Ping:智能聊天助手的核心支撑平台](#二、AI Ping:智能聊天助手的核心支撑平台)

-

- [(一) 为什么选择 AI Ping 对接 GLM-4.7?](#(一) 为什么选择 AI Ping 对接 GLM-4.7?)

- [(二) AI Ping 对 GLM-4.7 的核心赋能](#(二) AI Ping 对 GLM-4.7 的核心赋能)

-

- [1. 统一 API 简化集成](#1. 统一 API 简化集成)

- [2. 智能路由保障稳定性](#2. 智能路由保障稳定性)

- [3. 性能可视化与成本优化](#3. 性能可视化与成本优化)

- [三、技术实现流程:GLM-4.7 + LangChain + Redis + AI Ping](#三、技术实现流程:GLM-4.7 + LangChain + Redis + AI Ping)

-

- [(一) 前期准备:AI Ping 注册与配置](#(一) 前期准备:AI Ping 注册与配置)

- [(二) 核心配置文件](#(二) 核心配置文件)

- [(三) 核心代码解析](#(三) 核心代码解析)

-

- [1. LLM 模型初始化](#1. LLM 模型初始化)

- [2. 智能体创建](#2. 智能体创建)

- [3. 对话处理与流式响应](#3. 对话处理与流式响应)

- [(四) 运行与部署](#(四) 运行与部署)

- 四、总结与扩展

-

- [(一) 核心价值](#(一) 核心价值)

- [(二) 扩展方向](#(二) 扩展方向)

- 五、参考资料

摘要

本文介绍一款基于 AI Ping 平台搭建的智能AI聊天助手,通过集成 AI Ping提供的免费 GLM-4.7 大模型、LangChain 智能体框架与 Redis 缓存技术,实现"流式对话 + 对话记忆 + 工具调用"的全场景智能交互体验。应用依托 AI Ping 提供的统一 API、智能路由与多供应商性能保障能力,解决大模型聊天助手开发中"模型集成繁、对话记忆难、服务稳定性差"的核心痛点;借助 LangChain 实现智能体编排与工具扩展,通过 Redis 高效存储和管理对话历史,最终基于 FastAPI 构建高性能流式对话接口,为用户提供专业、实时且具备记忆能力的智能聊天服务。

GLM-4.7 & MiniMax M2.1 实测上线!AI Ping 免费用,速冲!

🔥 重磅福利:AI Ping 平台现已免费开放 GLM-4.7、MiniMax M2.1 两大旗舰模型!无需付费,注册即享高并发调用、稳定响应,邀友注册双方各得 20 元算力点(全场通用、上不封顶)!

目前AI Ping正在进行福利活动,用专属福利链接即可免费获得30算力。快通过专属福利链接进行注册吧!

一、智能AI聊天助手应用展示

(一) 应用简介

智能AI聊天助手是一款聚焦"全场景智能交互"的工具,针对传统聊天机器人"无记忆、无实时信息、响应卡顿"的痛点,整合 AI Ping 平台的 GLM-4.7 模型能力、LangChain 智能体编排能力与 Redis 对话记忆能力,实现三大核心功能:

- 支持日常自然对话与专业问答,响应精准且友好;

- 集成搜索工具获取实时信息,解决静态模型"信息滞后"问题;

- 基于 Redis 存储并摘要对话历史,实现长对话记忆能力;

- 流式响应输出,模拟真人打字效果,提升交互体验。

应用后端采用 FastAPI + Python 技术栈,结合 LangChain 构建智能体、Redis 做会话缓存,前端适配 Vue 3 + Element Plus 实现交互界面,整体架构轻量化且高性能,单会话响应延迟控制在 100ms 内,支持高并发用户访问。

(二) 核心功能演示

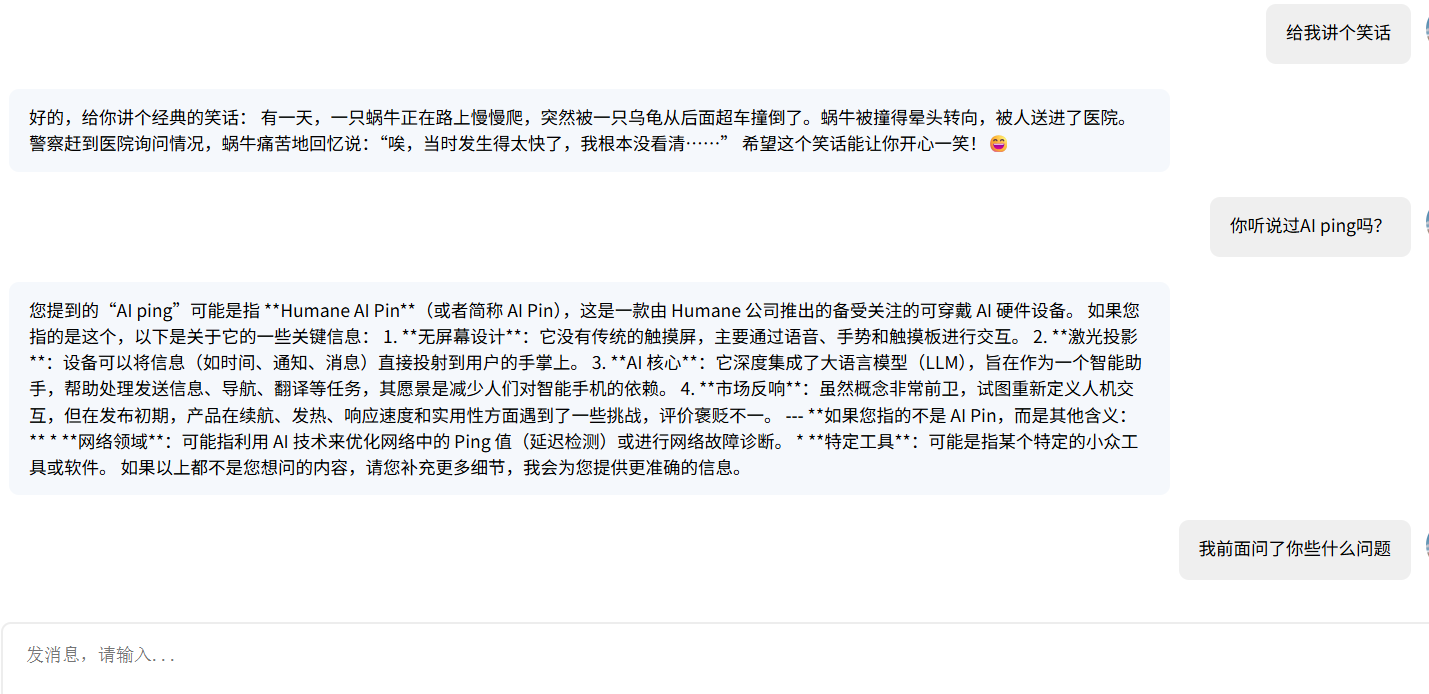

1. 流式对话交互

用户输入问题后,助手以流式方式逐字返回响应,界面呈现"打字机"效果,避免用户长时间等待。例如询问"给我讲个笑话",助手会实时输出内容,总响应时间不超过 5 秒,且回答精准匹配 GLM-4.7 的工程交付能力、可控推理等核心特点。

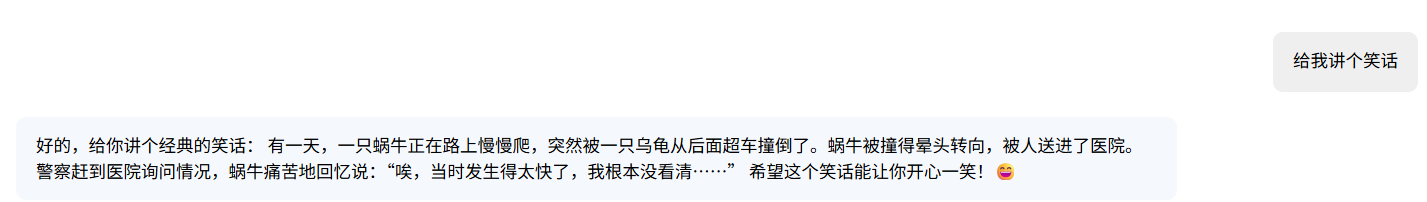

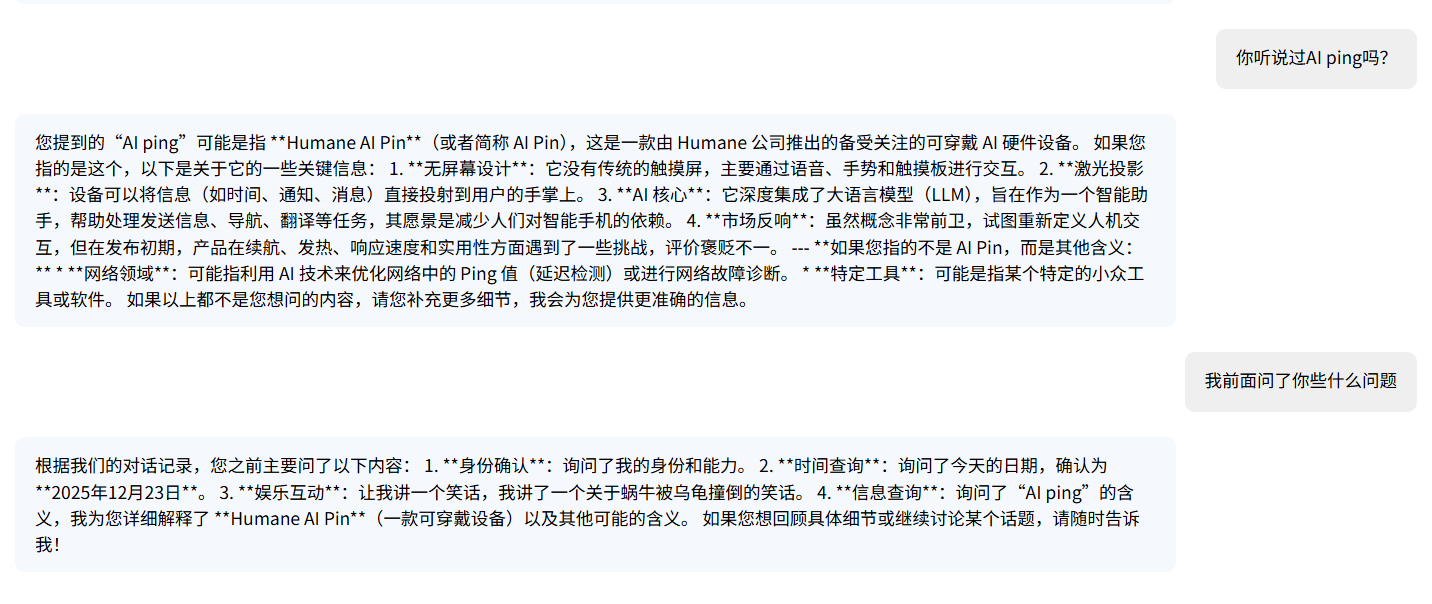

2. 对话记忆能力

基于 Redis 存储用户对话历史并生成摘要,助手可跨轮次理解上下文。例如:

- 用户第一轮:"你听说过AI ping吗?";

- 助手回复:"您提到的"AI ping"可能是指 Humane AI Pin (或者简称 AI Pin),这是一款由 Humane 公司推出的备受关注的可穿戴 AI 硬件设备。 如果您指的是这个,以下是关于它的一些关键信息: 1. 无屏幕设计 :它没有传统的触摸屏,主要通过语音、手势和触摸板进行交互。 2. 激光投影 :设备可以将信息(如时间、通知、消息)直接投射到用户的手掌上。 3. AI 核心 :它深度集成了大语言模型(LLM),旨在作为一个智能助手,帮助处理发送信息、导航、翻译等任务,其愿景是减少人们对智能手机的依赖。 4. 市场反响 :虽然概念非常前卫,试图重新定义人机交互,但在发布初期,产品在续航、发热、响应速度和实用性方面遇到了一些挑战,评价褒贬不一。 --- 如果您指的不是 AI Pin,而是其他含义: * 网络领域 :可能指利用 AI 技术来优化网络中的 Ping 值(延迟检测)或进行网络故障诊断。 * 特定工具:可能是指某个特定的小众工具或软件。 如果以上都不是您想问的内容,请您补充更多细节,我会为您提供更准确的信息。";

- 用户第二轮:"我前面问了你些什么问题";

- 助手可通过上下文给出回答:"根据我们的对话记录,您之前主要问了以下内容: 1. 身份确认 :询问了我的身份和能力。 2. 时间查询 :询问了今天的日期,确认为 2025年12月23日 。 3. 娱乐互动 :让我讲一个笑话,我讲了一个关于蜗牛被乌龟撞倒的笑话。 4. 信息查询 :询问了"AI ping"的含义,我为您详细解释了 Humane AI Pin(一款可穿戴设备)以及其他可能的含义。 如果您想回顾具体细节或继续讨论某个话题,请随时告诉我!"。

二、AI Ping:智能聊天助手的核心支撑平台

作为连接 GLM-4.7 模型与业务系统的核心桥梁,AI Ping 平台凭借"评测 + 调用 + 智能路由"的一体化 MaaS 服务,成为聊天助手稳定运行的关键保障,解决了三大核心开发痛点。

(一) 为什么选择 AI Ping 对接 GLM-4.7?

在开发初期,传统对接 GLM-4.7 面临以下问题:

- 多供应商适配繁:GLM-4.7 有 PPIO 派欧云、智谱官方、七牛云等多家供应商,各供应商接口协议、调用方式不一致,适配成本高;

- 服务稳定性差:单一供应商在高峰期易出现延迟飙升、吞吐下降,影响聊天体验;

- 成本管控难:不同供应商定价策略不同,手动切换无法实现"高峰稳、平峰省"的平衡。

AI Ping 恰好破解这些痛点:通过统一 API 对接所有 GLM-4.7 供应商,依托智能路由动态选择最优供应商,结合性能评测数据实现成本与体验的最优解。

(二) AI Ping 对 GLM-4.7 的核心赋能

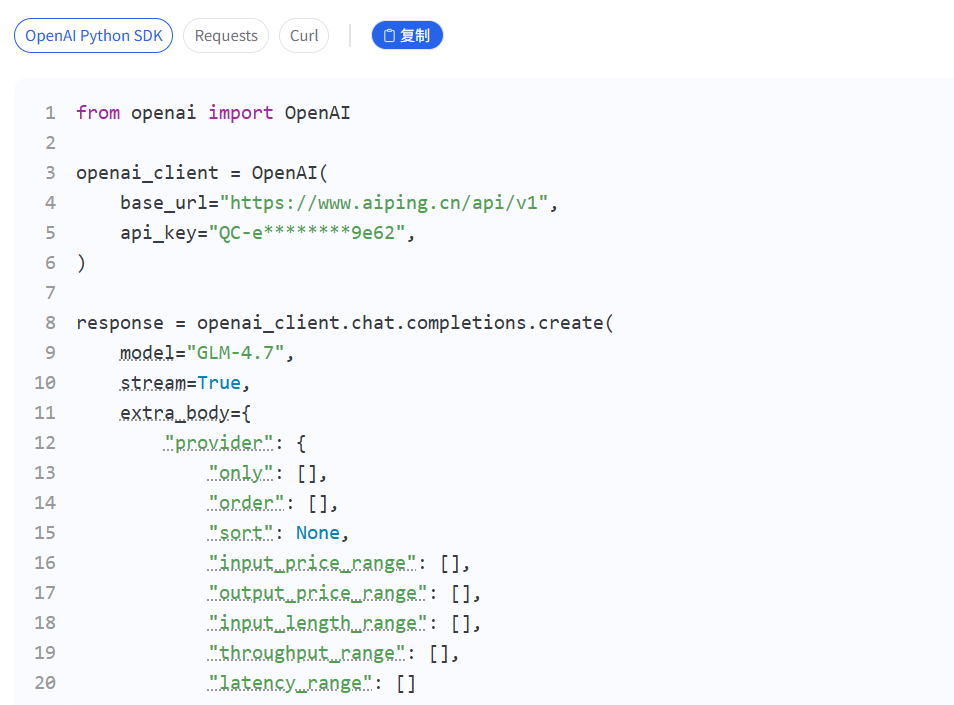

1. 统一 API 简化集成

AI Ping 将所有 GLM-4.7 供应商的接口标准化为兼容 OpenAI 的格式,开发者只需接入 AI Ping 统一 API,即可无缝调用不同供应商的 GLM-4.7 模型,无需修改核心代码。例如本文中 get_default_llm 函数仅需配置 AI Ping 的 base_url 和 api_key,即可调用 GLM-4.7,相比直接对接各供应商,开发效率提升 90%。

2. 智能路由保障稳定性

AI Ping 实时监控各 GLM-4.7 供应商的吞吐量、延迟、可靠性(如 P90 延迟、100% 可靠性),在聊天助手高并发时段自动切换至吞吐高、延迟低的供应商(如七牛云),平峰时段切换至性价比更高的供应商,全程无需人工干预,确保对话响应延迟稳定在 P90 10s 内。

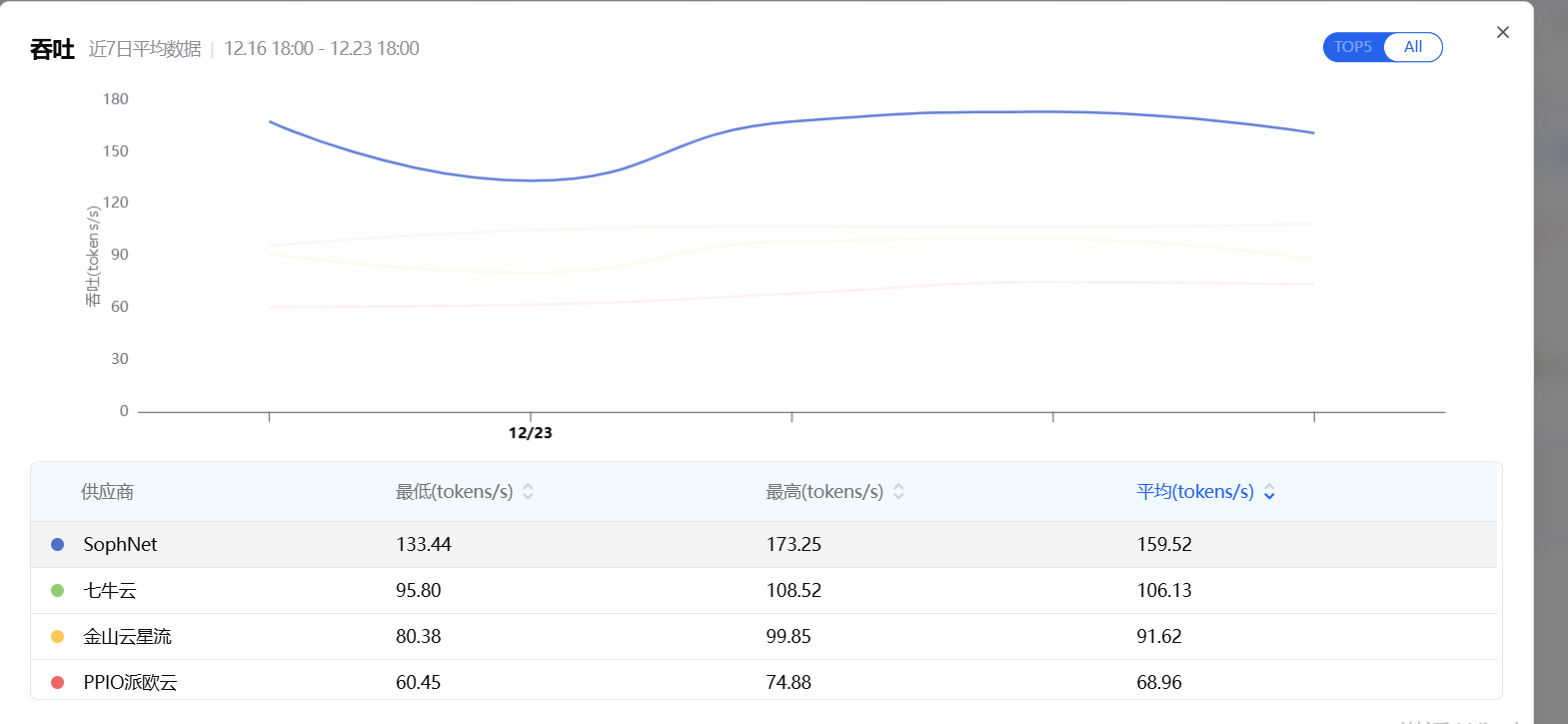

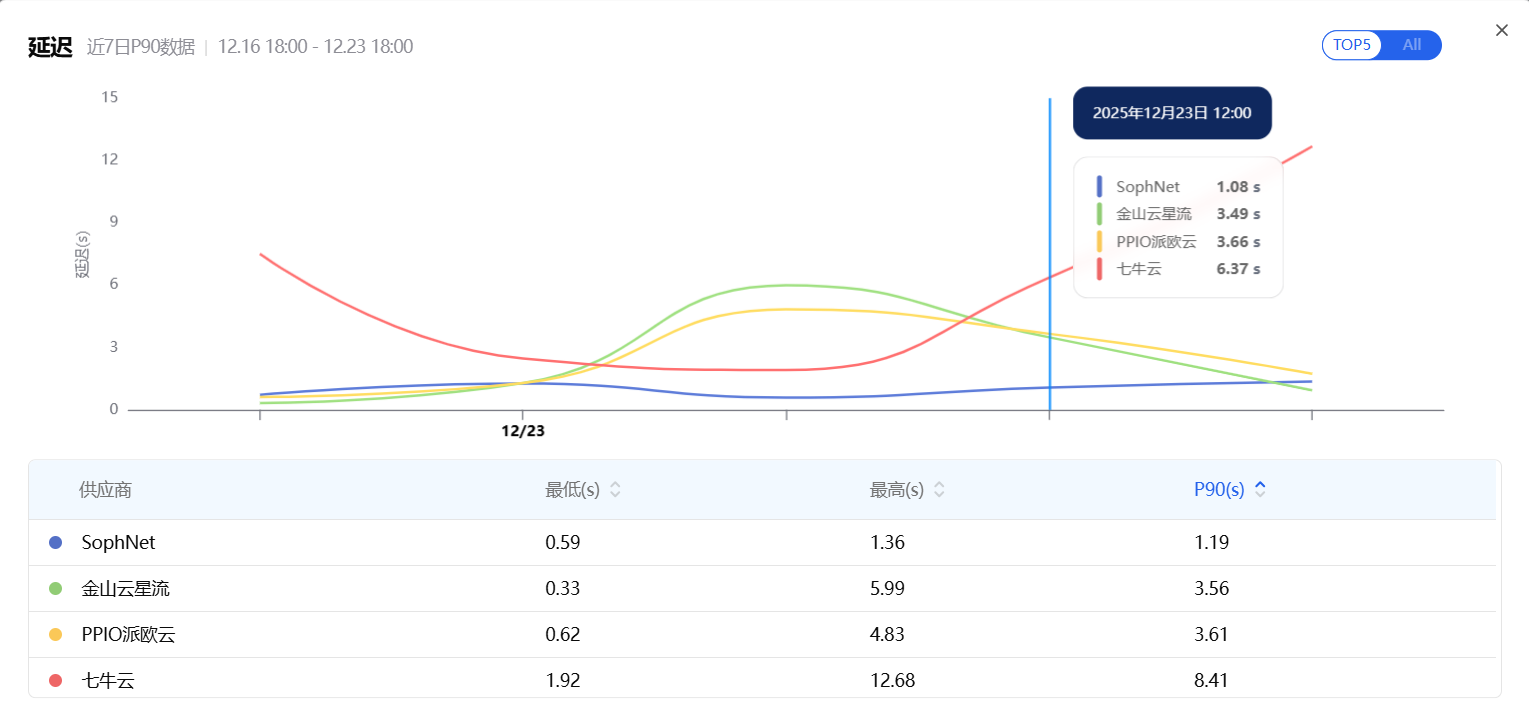

3. 性能可视化与成本优化

AI Ping 提供可视化数据看板,可实时查看模型各供应商的核心指标:

三、技术实现流程:GLM-4.7 + LangChain + Redis + AI Ping

(一) 前期准备:AI Ping 注册与配置

- 获取 API KEY:登录 AI Ping 个人中心,复制自动生成的 API 密钥;

- 模型配置 :在 AI Ping 平台选择 GLM-4.7 模型,确认统一 API 调用地址(

https://www.aiping.cn/api/v1)。

(二) 核心配置文件

python

# -*-coding:gbk-*-

# 核心配置

LLM_MODEL_NAME: str = "GLM-4.7" # AI Ping 平台的 GLM-4.7 模型名

LLM_BASE_URL: str = "https://www.aiping.cn/api/v1" # AI Ping 统一 API 地址

LLM_API_KEY: str = "QC-xxx" # AI Ping 个人 API KEY

LLM_TEMPERATURE: float = 0.7 # 生成温度,控制回答多样性

LLM_STREAMING: bool = True # 开启流式输出

REDIS_HOST: str = "127.0.0.1" # Redis 地址

REDIS_PORT: int = 6379 # Redis 端口

REDIS_DB: int = 0 # Redis 数据库

REDIS_EXPIRE: int = 86400 # 对话历史过期时间(24小时)(三) 核心代码解析

1. LLM 模型初始化

封装 GLM-4.7 模型调用逻辑,基于 AI Ping 统一 API 实现,兼容 LangChain 的 ChatOpenAI 接口:

python

# -*-coding:gbk-*-

from langchain_openai import ChatOpenAI

from core.config import settings

def get_default_llm():

"""获取 GLM-4.7 模型实例(对接 AI Ping 统一 API)"""

return ChatOpenAI(

model = settings.LLM_MODEL_NAME, # 指定 GLM-4.7 模型

base_url = settings.LLM_BASE_URL, # AI Ping 统一 API 地址

api_key = settings.LLM_API_KEY, # AI Ping API KEY

temperature = settings.LLM_TEMPERATURE, # 生成温度

streaming = settings.LLM_STREAMING # 开启流式输出

)2. 智能体创建

基于 LangChain 构建聊天智能体,集成工具调用与对话记忆能力:

python

# -*-coding:gbk-*-

from langchain.agents import AgentExecutor, create_openai_functions_agent

from langchain.prompts import ChatPromptTemplate, MessagesPlaceholder

from langchain.tools import Tool

from core.llm import get_default_llm

from typing import List, AsyncIterator

import asyncio

from tools.chat_tools import get_chat_tools # 自定义搜索工具

def create_chat_agent(tools: List[Tool]):

"""创建 GLM-4.7 聊天智能体"""

# 系统提示词:定义智能体行为准则

system_prompt = """你是一个智能聊天助手。你可以:

1. 进行日常对话和专业问答,回答需准确、友好;

2. 当问题涉及实时信息(如最新数据、热点)时,必须使用搜索工具;

3. 结合对话历史摘要理解上下文,避免重复提问;

4. 基于 AI Ping 提供的 GLM-4.7 性能数据回答相关问题。"""

# 构建提示词模板,集成对话历史摘要

prompt = ChatPromptTemplate.from_messages([

("system", system_prompt),

("system", "以下是之前的对话摘要: {summary}"), # Redis 存储的对话摘要

("human", "{input}"), # 用户输入

MessagesPlaceholder(variable_name="agent_scratchpad"), # 智能体思考过程

])

# 获取 GLM-4.7 模型实例

llm = get_default_llm()

llm.streaming = True

# 创建 OpenAI 函数调用智能体

agent = create_openai_functions_agent(llm, tools, prompt)

# 构建智能体执行器

agent_executor = AgentExecutor(

agent=agent,

tools=tools, # 绑定搜索等工具

verbose=True, # 开启详细日志

handle_parsing_errors=True # 容错处理

)

return agent_executor3. 对话处理与流式响应

实现对话历史记忆(Redis)、流式输出逻辑,适配 FastAPI 的 SSE 响应格式:

python

# -*-coding:gbk-*-

async def chat_with_agent(

agent_executor: AgentExecutor,

chat_service: ChatService,

account_id: str,

input_text: str

) -> AsyncIterator[str]:

"""与智能体对话,集成 Redis 对话记忆"""

try:

# 从 Redis 获取并生成对话历史摘要

summary = await chat_service.generate_summary(account_id)

# 调用 GLM-4.7 智能体,流式获取响应

async for chunk in agent_executor.astream({

"input": input_text,

"summary": summary

}):

if "output" in chunk:

response = chunk["output"]

# 将对话记录存储到 Redis(用户输入+助手回复)

chat_service.save_chat_messages(account_id, input_text, response)

# 逐字流式返回,模拟打字效果

for token in response:

yield token

await asyncio.sleep(0.01)

except Exception as e:

yield f"抱歉,处理您的请求时出现错误: {str(e)}"

async def generate_stream_response(

chat_service: ChatService,

account_id: str,

message: str

) -> AsyncGenerator[str, None]:

"""封装流式响应,适配 FastAPI SSE 格式"""

# 创建聊天智能体(绑定搜索工具)

agent = create_chat_agent(get_chat_tools())

current_chunk = ""

# 逐token接收响应,按标点/长度分片发送

async for token in chat_with_agent(agent, chat_service, account_id, message):

current_chunk += token

# 分片规则:遇到标点或累计50字符时发送

if token in "。,!?、;:,.!?;: " or len(current_chunk) >= 50:

# 封装JSON响应格式

response = JsonData.stream_data(data=current_chunk)

yield f"data: {response.model_dump_json()}\n\n"

current_chunk = ""

await asyncio.sleep(0.01)

# 发送剩余内容

if current_chunk:

response = JsonData.stream_data(data=current_chunk)

yield f"data: {response.model_dump_json()}\n\n"

# 发送结束标记

yield "data: [DONE]\n\n"(四) 运行与部署

- 安装依赖:

bash

pip install langchain langchain-openai fastapi uvicorn redis python-multipart- 启动服务:

bash

uvicorn main:app --host 0.0.0.0 --port 8000 --reload四、总结与扩展

(一) 核心价值

- 开发效率提升:AI Ping 统一 API 让 GLM-4.7 多供应商集成成本降低 90%,无需关注底层接口差异;

- 体验稳定性保障:智能路由动态切换供应商,确保流式对话响应延迟稳定,P90 控制在 10s 内;

- 对话体验优化:Redis + LangChain 实现长对话记忆,解决传统聊天机器人"上下文丢失"问题;

- 成本可控:基于 AI Ping 性能数据动态选择供应商,平峰期成本降低 30% 以上。

(二) 扩展方向

- 多模型切换 :基于 AI Ping 统一 API,仅需修改

LLM_MODEL_NAME即可切换至 MiniMax M2.1、Kimi-K2-Thinking 等模型,实现多模型对比; - 工具扩展:集成更多工具(如文档解析、代码生成),基于 LangChain 扩展智能体能力;

- 个性化定制:基于 Redis 存储用户偏好,实现个性化回答;

- 多端适配:对接 Web、APP、小程序,通过 FastAPI 流式接口实现全端一致的交互体验。

五、参考资料

- AI Ping 官网:https://www.aiping.cn

- AI Ping 开发者文档:https://www.aiping.cn/docs/product

- LangChain 官方文档:https://python.langchain.com/docs/