------从多头注意力机制到 DeepSeek 核心技术体系 (DeepSeek-MoE, MTP, MLA)

1. 执行摘要与引言

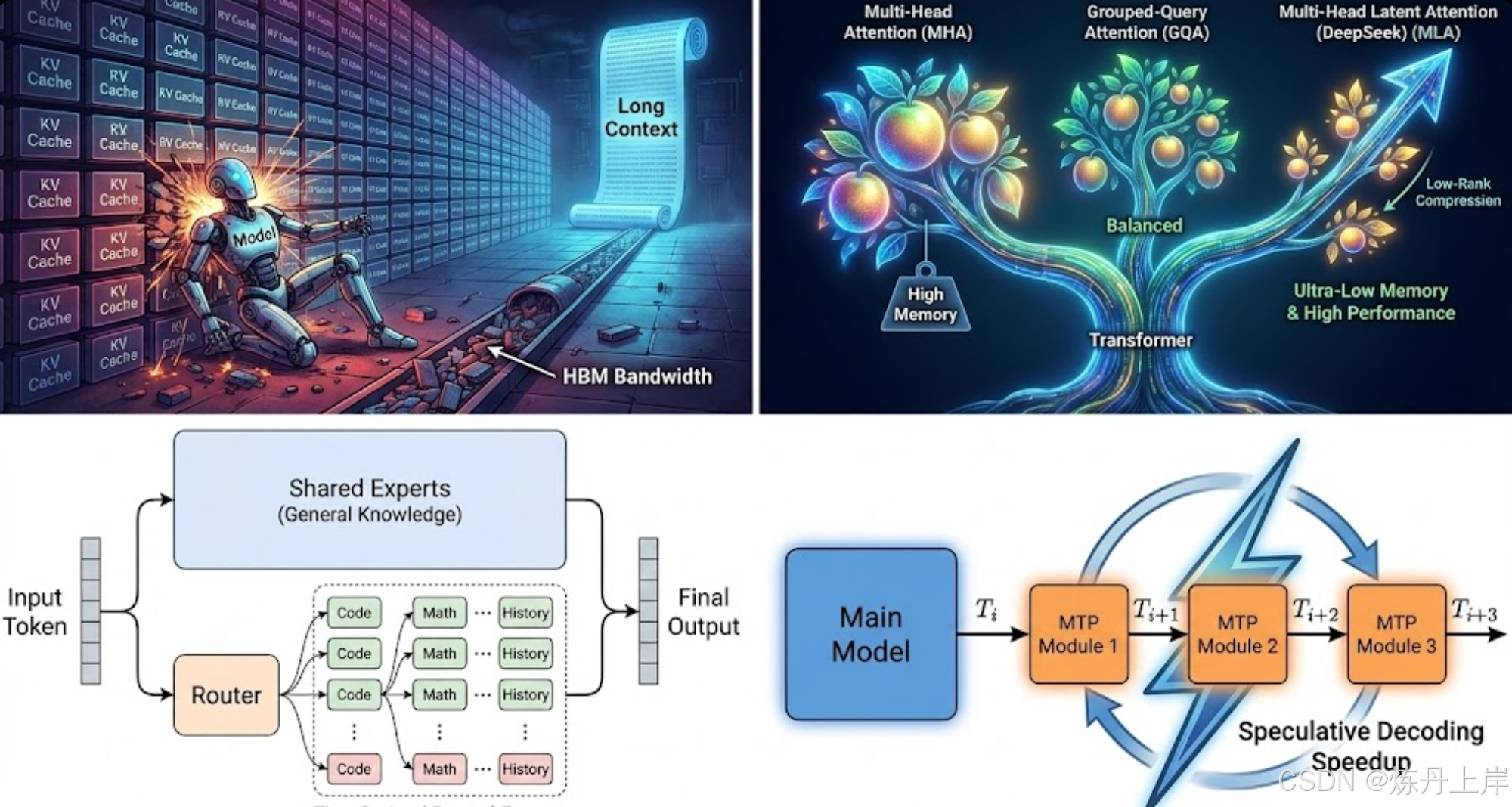

在过去几年中,大语言模型(LLM)的发展轨迹经历了一场深刻的范式转移。早期的竞争主要围绕参数规模的线性扩张(如 GPT-3 的 175B 到 PaLM 的 540B),这被视为提升模型智能涌现能力的主要途径。然而,随着模型规模突破千亿甚至万亿参数,以及上下文窗口(Context Window)扩展至 100k 乃至 1M token 级别,传统的稠密 Transformer 架构遭遇了严峻的物理与经济瓶颈。

三大核心挑战:

- 显存容量限制: KV Cache 瓶颈导致长文本推理显存爆炸。

- 推理延迟: 巨大的计算量导致生成速度缓慢。

- 训练计算成本: 规模扩张带来的算力成本不可持续。

DeepSeek(深度求索) 系列模型,特别是 DeepSeek-V2 和 DeepSeek-V3,通过三项基础性的架构创新,打破了"性能与效率不可兼得"的传统权衡:

- 多头潜在注意力机制 (MLA): 极致优化显存效率。

- DeepSeek-MoE (混合专家模型): 解决知识冗余,提升参数效率。

- 多 Token 预测 (MTP): 增强训练信号与推理加速。

本报告将对上述技术进行原理拆解与对比分析,为 AI 架构师及研究人员提供一份关于现代高效能 LLM 设计的深度指南。

2. 大模型推理的阿喀琉斯之踵:KV Cache 与显存墙

要理解 MLA 的设计初衷,必须深刻理解当前大模型推理面临的核心物理瓶颈:KV Cache(键值缓存)。

2.1 自回归生成的内存物理学

Transformer 模型在进行自回归文本生成时,为了避免重复计算,会将历史 token 的 Key 和 Value 向量存储在 GPU 显存中。KV Cache 的显存占用量公式如下:

- :批处理大小 (Batch Size)

- :上下文长度 (Sequence Length)

- :层数

- :注意力头数

- :每个头的维度

- :参数精度 (通常为 2 或 1 字节)

2.2 显存墙 (Memory Wall) 效应

随着上下文长度 从 4k 扩展到 128k+,KV Cache 呈线性增长。

- 容量瓶颈: 70B 模型在 128k 上下文下,仅 KV Cache 就可能占用超 100GB 显存,限制了 Batch Size 和吞吐量。

- 带宽瓶颈: 解码阶段是典型的 内存受限 (Memory-Bound) 操作。GPU 大部分时间花在将庞大的 KV Cache 从 HBM 搬运到计算核心上。

3. 注意力机制的演进:从 MHA 到 GQA

为了应对 KV Cache 挑战,注意力机制经历了一系列演进。

3.1 多头注意力 (MHA)

-

原理: 每个头独立关注输入序列的不同子空间。

-

评价: 表达能力最强,但显存占用最大。

3.2 多查询注意力 (MQA)

-

原理: 所有注意力头共享同一组 Key 和 Value,仅保留独立的 Query 头。

-

评价: 显存占用降为 ,推理吞吐极高。但属于"有损压缩",在复杂任务上性能下降明显。

3.3 分组查询注意力 (GQA)

- 原理: Llama 2/3 的主流选择。将 Query 头分成 组,每组共享一对 KV 头。

- 评价: MHA 与 MQA 的折中,保留了大部分性能并节省了显存,是开源模型的"黄金标准"。

4. DeepSeek 核心技术一:多头潜在注意力 (MLA)

DeepSeek-V2 引入的 MLA 提出了一种全新思路:不减少头的数量,而是通过低秩矩阵分解来压缩每个头的 KV 表示。

4.1 核心原理:低秩键值联合压缩

MLA 利用 Key 和 Value 矩阵的低秩性 (Low-Rank) ,将其压缩为一个极小的潜在向量 (Latent Vector)。

1. 降维投影 (Down-Projection)

输入 被压缩为潜在向量 (维度 原始 KV 维度):

2. 升维生成 (Up-Projection)

在计算时,通过升维矩阵重构多头的 K 和 V:

4.2 推理时的魔法:矩阵吸收 (Matrix Absorption)

MLA 的精妙之处在于推理时不需要解压。根据线性代数结合律,可以将升维矩阵 "吸收"到 Query 的投影矩阵中。

变换推导:

结论: KV Cache 中只需存储极小的压缩向量 。

4.3 解耦旋转位置编码 (Decoupled RoPE)

为了兼容对位置敏感的 RoPE,DeepSeek 采用了解耦策略:

- 内容部分: 使用低秩压缩,不带位置信息。

- 位置部分: 使用一个独立的、维度很小的向量 承载 RoPE 信息,不压缩。

最终 Cache 结构:

4.4 MLA 与主流架构终极对比

| 特性维度 | MHA (标准) | MQA (多查询) | GQA (分组查询) | MLA (DeepSeek) |

|---|---|---|---|---|

| KV Cache 大小 | 极大 (100%) | 极小 () | 中等 () | 极小 (接近 MQA) |

| 表达能力 | 强 (全秩) | 弱 (单头限制) | 中 (组内共享) | 强 (低秩近似全秩) |

| 推理机制 | 读取完整 KV | 读取共享 KV | 读取组 KV | 读取潜在向量 + 吸收矩阵 |

| RoPE 兼容性 | 原生支持 | 原生支持 | 原生支持 | 需解耦架构设计 |

5. DeepSeek 核心技术二:DeepSeek-MoE 架构

混合专家模型 (MoE) 解决了计算与参数规模的矛盾。DeepSeek-MoE 针对传统 MoE 的知识混合 与冗余痛点进行了改革。

5.1 传统 MoE 的困境

- 专业化不足: 少数大专家被迫学习广泛知识,无法成为真正的"专家"。

- 知识冗余: 通用知识(如语法)被迫复制到所有专家中。

5.2 DeepSeek-MoE 的两大创新

1. 细粒度专家分割 (Fine-Grained Expert Segmentation)

将大专家切分为大量微型专家。例如 DeepSeek-V3 拥有 256 个路由专家。

- 优势: 增加了组合灵活性,使专家能专注于极细分的领域(如"PyTorch 张量操作")。

2. 共享专家隔离 (Shared Expert Isolation)

引入总是被激活的 共享专家 (Shared Experts)。

- 效果: 共享专家负责通用知识,路由专家负责特异性知识,显著提升参数效率。

5.3 无辅助损失的负载均衡

DeepSeek 摒弃了干扰模型性能的传统 Auxiliary Loss,采用 动态偏置 (Dynamic Bias) 策略。

- 机制: 在路由分数上添加仅用于路由选择的偏置 ,根据负载动态调整,但不计入梯度传播的主 Loss。

- 结果: 实现了物理上的负载均衡,同时保持了数学上的"无损"性能。

6. DeepSeek 核心技术三:多 Token 预测 (MTP)

DeepSeek-V3 引入了 MTP (Multi-Token Prediction) 以提升数据效率和推理能力。

6.1 MTP 架构原理

模型在预测 的同时,通过串行的 MTP 模块链并行预测 等。

- 致密化信号: 迫使模型规划未来路径,使每个样本提供的梯度信息量成倍增加。

6.2 训练与推理的二象性

- 训练阶段: 开启 MTP,计算多步 Loss 加权和,增强逻辑推理能力。

- 推理阶段 (标准): 丢弃 MTP 模块,主模型依然享有性能提升。

- 推理阶段 (投机解码): 保留 MTP 模块作为"草稿模型",一次性生成多个候选 Token 并验证,实现 2 倍推理加速。

7. 系统级优化

- FP8 混合精度训练: 首个在 671B 规模上成功应用 FP8 训练。通过细粒度量化和混合精度(关键层保留高精度),计算速度提升近 2 倍,显存带宽压力减半。

- DualPipe 流水线并行: 针对 MoE 设计的双向流水线调度算法,完美重叠了计算与通信,解决了跨节点 All-to-All 通信瓶颈。

8. 结论

DeepSeek 系列模型通过 MLA 攻克了显存墙,通过 DeepSeek-MoE 解决了参数效率与专业化矛盾,通过 MTP 提升了训练密度与推理速度。这些技术组合证明了:通过极致的架构优化,可以在有限算力下训练出匹敌世界最强闭源模型的 AI 系统。