题目(共10小题)

1.(单选)蒙特卡洛(Monte Carlo)算法的主要特点是

A. 总能返回正确结果,但运行时间随机

B. 必须通过概率分析证明正确性

C. 仅用于组合优化问题

D. 可能在有限时间内返回近似解或错误解

2.(单选)对于任意一个线性规划模型来说,其可行解是

A. 一个闭合多面凸集

B. 一个无界集合

C. 一个非凸集合

D. 一个空集

3.(单选)关于决策树中预剪枝和后剪枝的说法,错误的是

A. 后剪枝决策树的训练时间开销较大

B. 后剪枝决策树的欠拟合风险小,泛化能力强

C. 前阈值的设定很敏感,一点点的变动,会引起整颗树非常大的变动,阈值选取难度较大

D. 后剪枝生成比前剪枝简洁的树

4.(单选)与参数检验相比,非参数检验的主要特点是

A. 不依赖于总体的分布

B. 对总体的分布没有任何要求

C. 只考虑总体的位置参数

D. 只考虑总体的分布

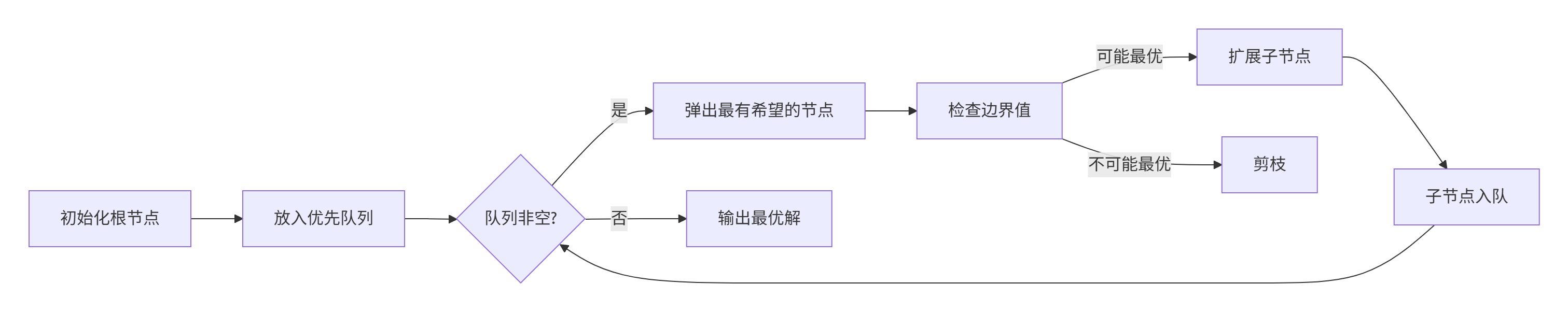

5.(单选)分支限界法的核心思想是

A. 动态规划保存子问题结果

B. 随机生成解并验证

C. 深度优先搜索所有可能解

D. 利用优先队列选择最有希望的节点扩展

6.(单选)P类问题的定义是

A. 无法验证解的问题

B. 可以在多项式时间内被确定型图灵机解决的问题

C. 需要非确定性图灵机在指数时间内解决的问题

D. 所有问题都可以在多项式时间内解决

7.(单选)下列关于生成式模型和判别式模型的说法错误的是

A. 判别模型由数据学习条件概率分布

B. 生成方法由数据学习联合概率分布

C. 判别式模型准确率往往较生成模型高

D. 朴素贝叶斯是一种典型的判别式模型

8.(单选)有两个样本点,第一个点为正样本,它的特征向量是(0,-1),第二个特征点为负样本,它的特征向量是(2,3)。从这两个样本点组成的训练集构建一个线性SVM分类器的分类面方程是

A. 2x+y=4 B. x+2y=5 C. x+2y=3 D. 以上都不对

9.(单选)RFE使用学习器权重评价特征重要性并逐步删除。若采用非线性核SVM作为估计器,RFE相比线性SVM主要局限是

A. 重要性度量不再直接由权重系数给出,需额外计算

B. 会破坏SVM的凸性

C. 递归过程无法并行

D. 不支持交叉验证嵌套

10.(多选)给定中心化输入矩阵 ,岭回归估计量为:

预测值 ,其中平滑矩阵

。数据噪声为同方差(homoscedastic)正态分布

。关于期望训练误差

的相关结论,正确的是

A. 其无偏估计可写作

B. 当时,

;当

时,

C. 可解释为模型的有效自由度(effective d.o.f.)

D. 对病态 X, 调大能同时降低估计方差和偏差

解答

1.【答案】D

【解析】蒙特卡洛算法(Monte Carlo algorithm)是一种基于随机采样的概率算法,其核心特点是:

-

随机性与近似性 :它依赖随机数生成器进行多次采样或模拟,通过统计分析得到结果。但由于随机性,算法不一定返回精确解 ,而是可能在有限时间内输出近似解(如数值估计)或错误解(尤其在单次运行中错误率不为零)。

-

运行时间确定 :算法通常在有限时间内终止(运行时间可预测,不随机),但结果质量(精度或正确性)受采样次数和随机性影响。

-

错误概率可控:通过增加采样次数(迭代),可以降低错误概率(例如,增加模拟次数使近似解更接近真实值),但不能完全消除错误。

选项分析:

-

A. 总能返回正确结果,但运行时间随机 ❌

错误:这描述的是拉斯维加斯算法(Las Vegas algorithm),不是蒙特卡洛算法。蒙特卡洛算法可能返回错误解,而运行时间通常是固定的(不随机)。例如,蒙特卡洛用于估计圆周率π,可能返回的数值有误差。

-

B. 必须通过概率分析证明正确性 ❌

错误:虽然蒙特卡洛算法常结合概率分析来评估其性能(如错误率),但这并非其主要特点。算法本身的主要特征是随机采样和结果不确定性,而非证明过程。

-

C. 仅用于组合优化问题 ❌

错误:蒙特卡洛算法广泛应用于各类问题,包括数值积分(如计算π)、物理模拟、金融风险管理等,不局限于组合优化。组合优化常用启发式算法(如模拟退火),但蒙特卡洛更通用。

-

D. 可能在有限时间内返回近似解或错误解 ✔

正确:这准确捕捉了蒙特卡洛算法的本质:

-

在有限时间内运行(例如,固定迭代次数后停止)。

-

结果可能是近似解(如从样本中估计均值)或错误解(例如在随机决策问题中,以概率输出错误答案)。

-

经典示例:蒙特卡洛积分中,通过随机点采样估算积分值,结果总是近似值;在素数测试(如Fermat测试)中,它可能错误判断一个数为素数(错误解)。

-

2.【答案】A

【解析】在数学优化中,线性规划(Linear Programming)的可行解集合(可行域)具有以下性质:

-

可行性定义:

-

线性规划模型包括目标函数(如最大化或最小化一个线性函数)和线性约束(不等式或等式)。

-

可行解是所有满足所有约束条件的决策变量的点集。

-

-

几何性质:

-

凸性:线性约束定义了半空间(half-spaces)。多个半空间的交集是凸集,因为线性不等式或等式的交集保持凸性(凸集的交集仍是凸集)。

-

闭合性:在标准线性规划模型中,约束通常使用非严格不等式(如 Ax≤b、x≥0)。这些不等式定义的半空间是闭合的,因此它们的交集(可行域)也是闭合的集。

-

多面性:可行域是由有限多个线性约束定义的凸集,因此被称为多面凸集(polyhedral convex set)。如果可行域是非空且有界的,它也称为凸多面体(convex polytope)。

-

-

任意模型的分析:

-

选项 A 正确,因为对于任意线性规划模型,如果可行域非空,它一定是一个闭合多面凸集(闭合的多面体,因为约束确保边界点被包含)。

-

可行域可能为空(如约束矛盾时),但空集在数学上也视为一个退化的闭合凸集(多面性成立),因此选项 A 仍然成立。

-

错误选项原因:

-

B. 一个无界集合:错误,因为可行域可能是有界的(如一个三角形区域)或无界的(如无上限约束),但不总是无界。

-

C. 一个非凸集合:错误,因为线性约束的可行域总是凸集(线性性保证),不可能非凸。

-

D. 一个空集:错误,因为可行域可能非空(如标准问题);只有在约束矛盾时它才为空,但不是任意模型都为空。

-

-

3.【答案】D

**【解析】**在决策树算法中,预剪枝(pre-pruning)和后剪枝(post-pruning)是两种常见的剪枝技术,用于防止过拟合和简化模型。下面逐一分析每个选项,解释为什么A、B、C是正确的说法,而D是错误的。

背景知识复习

-

预剪枝(Pre-pruning): 在决策树构建过程中进行剪枝,例如在节点分裂前评估分裂条件(如信息增益是否达到阈值)。如果未达到阈值,就停止分裂。这可以防止树过深,但可能导致欠拟合(underfitting),因为可能过早停止分裂。

-

后剪枝(Post-pruning): 先完全构建整个决策树,然后从叶节点开始向上剪枝,移除不必要的子树。这通常在树构建后进行,可以减少过拟合风险,并生成泛化能力更强的树。

-

两种方法各有优缺点,核心区别在于:预剪枝时间开销小但可能欠拟合,后剪枝时间开销大但泛化能力强。

选项分析

-

A. 后剪枝决策树的训练时间开销较大(正确说法)

后剪枝需要先构建完整的决策树,然后再进行剪枝操作。构建完整树可能很耗时(尤其在数据量大或树复杂时),而剪枝过程也需要额外的计算资源(如基于验证错误或成本复杂度计算)。因此,训练时间开销确实比预剪枝大。预剪枝在构建过程中就直接限制分裂,时间开销较小。A选项的描述符合标准知识,正确。

-

B. 后剪枝决策树的欠拟合风险小,泛化能力强(正确说法)

后剪枝允许决策树完全生长后再进行剪枝,这使得树能捕捉更多数据模式(减少欠拟合风险),然后通过移除不重要的分支来提高泛化能力(减少过拟合风险)。相对而言,预剪枝由于可能过早停止分裂,更容易忽略重要模式,从而增加欠拟合风险。因此,后剪枝的欠拟合风险较小,泛化能力强。B选项的描述正确。

-

C. 前阈值的设定很敏感,一点点的变动,会引起整颗树非常大的变动,阈值选取难度较大(正确说法)

"前阈值"在这里指预剪枝中的分裂阈值(如信息增益的最小阈值)。预剪枝的阈值设置非常敏感,原因如下:

-

阈值的小变动可能导致树结构剧变:例如,阈值稍高可能导致树过早停止分裂(树变浅),阈值稍低可能导致树过度生长(树变深)。

-

阈值选取难度大:需要反复试验和调参来找到最优值,否则容易影响模型性能。

这是预剪枝的主要缺点之一,C选项的描述准确且正确。

-

-

D. 后剪枝生成比前剪枝简洁的树(错误说法)

-

错误原因: 后剪枝不一定总是生成比预剪枝更简洁的树(即节点更少、结构更简单)。两者的树结构取决于具体参数和数据集:

-

预剪枝:如果阈值设置严格(如信息增益阈值较高),它可能生成一个非常小但可能欠拟合的树,这个树在节点数量上可能比后剪枝更"简洁"(节点更少)。

-

后剪枝:它从完整树开始剪枝,最终树的大小取决于剪枝程度:如果剪枝激进,树可能很简洁;如果剪枝保守,树可能保留较多分支(不如预剪枝的树简洁)。

-

关键点:选项D声称"后剪枝生成比前剪枝简洁的树",这是一个绝对比较,忽略了参数设置的影响。实际上,预剪枝在特定设置下可以生成更小的树,而后剪枝的优势在于泛化能力,而非绝对简洁性。

-

-

标准观点:后剪枝的主要目的是提高泛化能力,而不是保证树比预剪枝更简洁。因此,D选项的说法错误,是本题的正确选择。

-

4.【答案】A

【解析】

-

非参数检验的核心特点:

-

非参数检验(如Mann-Whitney U检验、Wilcoxon符号秩检验)无需假设数据服从特定分布(如正态分布)。

-

它直接基于样本数据的秩或顺序进行推断,适用于任意分布类型(如偏态分布、未知分布)或数据类型(如等级数据、分类数据)。

-

-

与参数检验的关键区别:

-

参数检验(如t检验、ANOVA)必须满足严格假设:

-

数据来自特定分布(如正态分布)。

-

需要估计总体参数(如均值、方差)。

-

-

非参数检验不依赖此类假设,因此更灵活、稳健,尤其适用于:

-

小样本数据。

-

分布未知或非正态的数据。

-

无法满足参数检验假设的场景。

-

-

-

错误选项分析:

-

B. 对总体的分布没有任何要求 ❌

错误原因:虽然非参数检验不要求数据服从特定分布,但它仍可能要求其他条件(如数据独立性)。选项B的"没有任何要求"过于绝对化(例如,秩和检验要求数据可排序)。

-

C. 只考虑总体的位置参数 ❌

错误原因:位置参数(如中位数)只是非参数检验的常见目标之一,但它还能检验分布形状、相关性等(如Kolmogorov-Smirnov检验比较分布形态)。非参数检验的范畴远超位置参数。

-

D. 只考虑总体的分布 ❌

错误原因 :此选项混淆了概念。非参数检验的核心恰恰是不关注总体分布的具体形式,而是通过非参数方法进行推断。参数检验才需要明确指定分布(如正态分布)。

-

5.【答案】D

【解析】分支限界法(Branch and Bound)是求解组合优化问题(如旅行商问题、0-1背包)的核心算法,其核心思想如下:

- 核心思想本质:优化搜索策略

-

✅ D选项正确 :算法通过优先队列(Priority Queue)动态选择"最有希望的节点"扩展。

-

"最有希望":指优先级最高的节点(如目标函数值最优/边界值最接近最优解)。

-

"扩展":生成子节点并计算其边界值(Bound),用于判断是否可能包含最优解。

-

流程示例(以旅行商问题为例):

2. 错误选项分析:

-

❌ A. 动态规划保存子问题结果

→ 描述的是动态规划算法(如Floyd算法),分支限界法不依赖子问题重叠性。

-

❌ B. 随机生成解并验证

→ 描述随机算法(如蒙特卡洛),分支限界法是系统性搜索(非随机)。

-

❌ C. 深度优先搜索所有可能解

→ 描述回溯法/DFS (如八皇后问题),分支限界法使用优先级驱动的搜索(非深度优先)。

- 关键考点总结:

| 特性 | 分支限界法 | 对比算法 |

|---|---|---|

| 数据结构 | 优先队列(Heap) | 动态规划(数组) |

| 搜索策略 | 按优先级扩展(非DFS/BFS遍历) | DFS(回溯法) |

| 优化核心 | 边界值剪枝(Pruning) | 子问题递归分解 |

| 典型应用 | 旅行商/调度问题 | 斐波那契/矩阵链乘法 |

6.【答案】B

【解析】 在计算复杂性理论中,P类问题(P-class)是决策问题的集合,其标准定义是:

-

核心含义:一个问题属于P类,当且仅当存在一个确定性图灵机(Deterministic Turing Machine)在多项式时间内解决它。

-

多项式时间:运行时间是输入大小 n的多项式函数(如 O(nk),其中 k是常数)。

-

确定性图灵机:一种理论计算模型,每一步操作都是确定性的(无随机性)。

-

为什么其他选项错误?

-

A. 无法验证解的问题:

这描述的是不可判定问题(例如停机问题),与P类无关。P类问题是可以解决的(验证和解决在P中通常是等价的),因此错误。

-

C. 需要非确定性图灵机在指数时间内解决的问题:

这混淆了概念:

-

非确定性图灵机 与NP类(Nondeterministic Polynomial time)相关,但NP类是验证在多项式时间内解决(不一定解决在指数时间)。

-

P类是关于确定性图灵机(非非确定性),也不是指"指数时间"(它要求多项式时间),因此错误。

-

-

D. 所有问题都可以在多项式时间内解决:

这是错误的绝对化表述。许多问题(如NP-难问题或不可判定问题)无法在多项式时间内解决。P类是一个子集(如排序、最短路径属于P),但并非所有问题都在P中。

7.【答案】D

【解析】 D 选项 "朴素贝叶斯是一种典型的判别式模型" 的说法错误。

错误原因:

-

朴素贝叶斯的本质是生成式模型:

-

朴素贝叶斯通过先学习联合概率分布 P(X,Y)(即特征 X和标签 Y的联合分布),再利用贝叶斯定理推导出条件概率 P(Y∣X)。

-

例如:在垃圾邮件分类中,它需计算 P(单词1,...,单词n∣Y)和 P(Y)(联合分布),再求 P(Y∣单词1,...,单词n)。

-

-

判别式模型的典型特征:

-

判别式模型(如逻辑回归、SVM、决策树)直接学习条件概率 P(Y∣X)或决策函数,无需对联合分布建模。

-

朴素贝叶斯不符合这一定义,因此不是判别式模型。

-

其他选项分析(均为正确说法):

✅ A. 判别模型由数据学习条件概率分布

-

正确性:判别式模型(如逻辑回归)直接优化 P(Y∣X)。例如,逻辑回归通过Sigmoid函数直接输出类别概率 P(Y=1∣X)。

-

经典应用:文本分类、图像识别中直接学习特征到标签的映射。

✅ B. 生成方法由数据学习联合概率分布

-

正确性:生成式模型(如隐马尔可夫模型、高斯混合模型)需先估计联合分布 P(X,Y),再推导 P(Y∣X)。

-

示例:预测天气时,需计算 P(温度,湿度,...,Y)的联合分布。

✅ C. 判别式模型准确率往往较生成模型高

-

正确性:判别式模型因直接学习决策边界,通常在分类任务中表现更优(如逻辑回归在二分类任务中常优于朴素贝叶斯)。

-

原因:生成式模型需对数据分布强假设(如朴素贝叶斯的"特征独立假设"),若假设不成立,则准确率下降。

总结

| 模型类型 | 学习目标 | 典型算法 | 优点 |

|---|---|---|---|

| 生成式 | 联合分布 P(X,Y) | 朴素贝叶斯、隐马尔可夫模型 | 可生成数据,概率解释性强 |

| 判别式 | 条件分布 P(Y∥X) | 逻辑回归、SVM、决策树 | 分类准确率高,计算效率高 |

8.【答案】C

**【解析】**对于两个样本点,正样本点(0, -1)和负样本点(2, 3),线性SVM的分类面是这两个点连线的垂直平分线,以最大化间隔。

首先,计算中点坐标:

-

x中点 = (0 + 2) / 2 = 1

-

y中点 = (-1 + 3) / 2 = 1

中点为(1, 1)。

然后,计算连线斜率:斜率k = (3 - (-1)) / (2 - 0) = 4 / 2 = 2

垂直平分线的斜率为连线斜率的负倒数:斜率m = -1/2

使用点斜式方程,过中点(1, 1):y - 1 = (-1/2)(x - 1)

因此,分类面方程为x + 2y = 3,对应选项C。

9.【答案】A

【解析】

-

RFE(Recursive Feature Elimination):这是一种特征选择方法,它通过递归移除最不重要的特征(基于学习器的权重或重要性得分)来减少特征数量。简单来说,它依赖于模型提供的特征重要性来逐步删除特征。

-

SVM(Support Vector Machine):支持向量机是一种分类或回归模型。

-

线性SVM :模型有一个明确的权重系数向量(

coef_属性,如scikit-learn中的实现),其中每个特征的权重值(绝对值)直接表示特征重要性(越大越重要)。这使得RFE能直接使用权重来评价和删除特征。 -

非线性核SVM(如使用RBF或多项式核):通过核技巧将数据映射到高维空间,但原始特征的权重系数不再是显式可用的。决策函数依赖于支持向量和核函数,而不是原始特征的直接权重。因此,无法直接从模型获取权重系数来评估特征重要性。

-

为什么A是正确答案?

-

核心局限 :当RFE使用非线性核SVM时,特征重要性度量无法像线性SVM那样直接从权重系数(如

coef_)获得。原因是非线性核的SVM在原始特征空间中没有直接的权重表示。需要额外计算方法来评估特征重要性,例如:-

使用模型输出(如决策函数值的变化)来推断重要性。

-

采用排列重要性(permutation importance)或其他基于代理的指标。

-

在实现中(如scikit-learn的RFE),这可能需要自定义特征重要性函数或额外计算步骤,增加了复杂性和计算成本。

-

-

为什么是"相比线性SVM的主要局限":在线性SVM中,RFE可以直接、高效地使用权重系数,而非线性SVM的额外要求使得过程更繁琐,容易出错,并且可能影响特征选择的准确性。例如,在真实项目中,使用非线性SVM的RFE时,开发者必须手动处理特征重要性,而线性版本则更简单直接。

为什么其他选项不正确?

-

B选项:"会破坏SVM的凸性":SVM的优化问题本质上是凸的(无论是否使用核函数),核方法仅改变特征空间表示,不破坏凸性。RFE本身不涉及修改SVM的优化问题,它只是基于模型输出进行特征删除。因此,这个选项与RFE的局限无关。

-

C选项:"递归过程无法并行":RFE的递归特性使其本质上是顺序的(不能并行处理),但这是RFE的通用缺点,不仅限于非线性SVM。线性SVM的RFE同样可能存在并行问题(除非特别优化),因此这不是非线性SVM相比线性SVM特有的局限。

-

D选项:"不支持交叉验证嵌套":RFE可以与交叉验证嵌套使用(如RFECV在scikit-learn中实现),以选择最优特征子集。这适用于线性和非线性SVM(只要模型支持交叉验证)。非线性SVM的RFE仍可嵌套交叉验证,没有根本性限制。因此,这个选项不符合题目中的"主要局限"。

10.【答案】BC

【解析】 题目涉及岭回归(ridge regression)的期望训练误差(expected training error)的性质。给定中心化输入矩阵 ,岭回归估计量为:

预测值 ,其中平滑矩阵

。数据噪声为同方差(homoscedastic)正态分布

。目标是分析期望训练误差

的相关结论是否正确。

以下针对每个选项进行详细分析。基于岭回归理论和概率论,判断各选项的正确性。注意, 是平滑矩阵的迹(trace),常用于表示模型的有效自由度(effective degrees of freedom)。

A: 其无偏估计可写作 (错误)

该表达式声称是期望训练误差的无偏估计,即:

通过计算,期望训练误差的实际表达式为:

其中 是真实均值(噪声前的信号部分)。

给定表达式的期望为:

这并不等于 ,因为多出了

项(除非特殊情况下,如

且X满秩时,但一般情况不成立)。在岭回归中,训练误差的无偏估计通常需要更复杂的调整(如考虑偏差项),但该表达式不正确。

B: 当时,

;当

时,

(正确)

分析极限行为:

当 时,岭回归退化为普通最小二乘(OLS)。此时,

收敛于投影矩阵

(若

可逆),其迹

(因为投影矩阵的迹等于秩)。

当 时,

,因此

,其元素趋近于 0,故

。 这符合岭回归的渐近性质,且不依赖于噪声分布。

C: 可解释为模型的有效自由度(effective d.o.f.)(正确)

在岭回归和线性平滑器中,有效自由度被定义为 ,用于衡量模型的复杂度和适应性(而非参数个数)。这捕获了正则化强度

的影响:当

增加时,模型自由度减小,反之增加。该定义在统计学习和机器学习中是标准(如 Hastie et al. 的 *Elements of Statistical Learning*)。

D: 对病态 X, 调大能同时降低估计方差和偏差(错误)

病态 X(ill-conditioned X)指 的特征值差异大(某些特征值接近零),导致 OLS 的方差很大。在岭回归中:

增大 会降低方差(因为正则化减小了对噪声的敏感性)。

但增大 会增加偏差(因为估计被收缩向零,偏离真实参数)。

因此, 增加时,方差和偏差不能同时降低;它们存在权衡(bias-variance tradeoff)。优化 **

**是在两者之间平衡,以最小化预测误差(如均方误差)。

补充说明:

核心理论点:期望训练误差 分解为偏差项和方差项:

。而

作为有效自由度,在模型选择和正则化中至关重要(如用于广义交叉验证)。

工程实践:在实际应用中(如使用 scikit-learn 或 TensorFlow),B 和 C 的性质常用于超参数调优(如通过交叉验证选择 )。