仅分享学习使用,若侵权后台联系删除资源

引言:从"点一点"到"聊一聊+做一做"的交互革命

在AI大模型飞速发展的今天,我们与数字设备的交互方式正在经历一场深刻变革------从传统的GUI(图形用户界面)"点按操作",到CUI(对话式用户界面)"语音/文字对话",再到如今支付宝提出的xUI(多模态智能交互)"对话+执行"全流程体验。

支付宝作为国民级应用,承载着亿级用户的生活服务、金融理财、出行医疗等多元需求。面对AI Agent技术的崛起,如何打破设备壁垒、融合多模态交互、实现"既能问能答,又有手有脚"的智能体验?Alipay xUI多模态智能交互引擎应运而生,成为AI时代终端交互的下一代核心框架。

一、AI Agent的演进与支付宝的实践之路

1. AI Agent技术发展三部曲

AI Agent的落地并非一蹴而就,而是经历了从探索到实用的持续迭代:

- 实验性探索(2023):聚焦大模型基础能力,以信息检索、简单对话为核心场景,验证Agent的可行性;

- 探索与实践(2024):Chatbot技术成熟,Prompt工程、RAG(检索增强生成)、Multi-Agent协作等技术落地,形成实用工具;

- 业务高速发展(2025~2026) :AI+服务深度融合,Agent具备自主规划、跨设备协同能力,成为业务增长核心引擎。

2. 支付宝Agent的两大核心应用场景

(1)对话式Agent:让服务"开口即达"

通过自然对话替代传统搜索、导航操作,覆盖生活全场景:

- 财富保险:分析黄金走势、查询持仓结构、定制理财方案;

- 医疗健康:智能导诊、药盒识别、头晕症状分析、饮食营养评估;

- 出行酒旅:查询火车行程、推荐酒店、规划旅行路线;

- 教育民生:作业批改、政策解读、情绪陪伴。

核心价值:升级服务检索方式,同时提升业务转化率与用户体验。

(2)跨设备Agent互联:让体验"无缝流转"

打破手机、车机、智能穿戴、AI玩具等设备边界,实现"一句话搞定跨设备任务":

- 智能车机:语音下达点餐、缴费、查快递指令,调用支付宝小程序与支付功能;

- 智能穿戴:同步健康数据、接收服务提醒,联动手机完成复杂操作;

- 跨厂商协作:通过统一协议实现账号互通、隐私保护,一次接入多场景投放。

核心价值:升级生态合作模式,扩大业务覆盖范围,提升科技体验。

(注:此处截取PPT中跨设备互联架构图,展示"Agent注册→分发→路由→服务发现"的全流程)

二、xUI引擎:多模态交互的"技术底座"

面对全行业Agent产品化的浪潮,大模型能力与工程体系滞后的矛盾日益突出------如何解决多模态内容渲染、实时音视频交互、跨设备通信、多端适配等核心问题?Alipay xUI引擎给出了答案。

xUI的核心定位是:AI时代终端的下一代框架,实现从"Touch&APP"到"Multimodal Chat"再到"AI Intent Interaction"的交互升级,打通AI大模型、多端设备、业务服务的全链路。

xUI引擎的核心技术支柱包括六大模块,共同支撑多模态、实时化、跨设备的智能交互体验:

三、关键技术深度解析:让交互"更自然、更高效、更可靠"

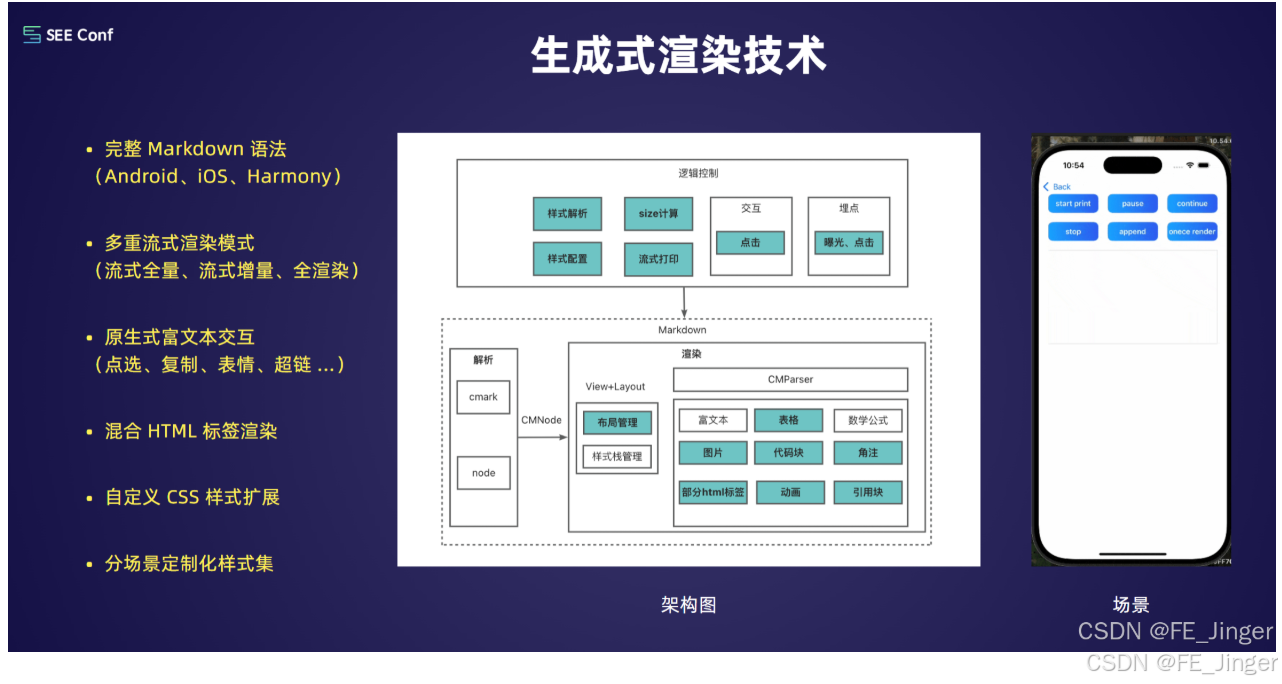

1. 生成式渲染技术:让AI内容"原生呈现"

AI生成的内容(文字、表格、公式、代码块、超链接等)如何在不同系统(Android/iOS/Harmony)、不同场景下快速渲染并支持交互?生成式渲染技术给出了方案:

- 支持完整Markdown语法+混合HTML标签渲染,兼容多端;

- 三种流式渲染模式(全量/增量/全渲染),平衡速度与完整性;

- 原生式富文本交互:支持点选、复制、表情插入、超链跳转等操作;

- 自定义CSS样式扩展,可分场景定制视觉效果。

(注:此处截取PPT中生成式渲染架构图,展示"Markdown解析→样式配置→布局管理→富文本渲染"的流程)

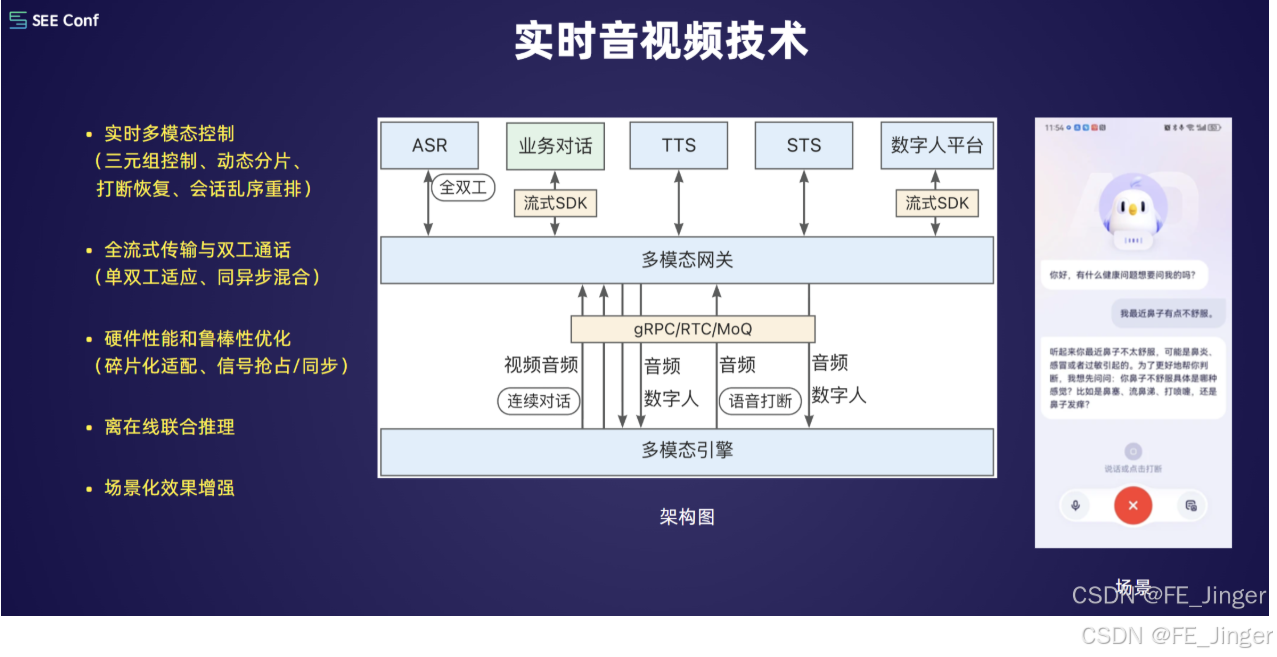

2. 实时音视频技术:让对话"无延迟、可打断"

在医疗咨询、数字人交互等场景中,实时性与交互灵活性至关重要:

- 全流式传输与双工通话:支持单双工自适应、同异步混合,对话无卡顿;

- 多模态控制:实现三元组控制、动态分片、打断恢复、会话乱序重排;

- 硬件碎片化适配:优化Mic/Speaker/Camera/Sensor协同,提升鲁棒性;

- 离在线联合推理:兼顾实时性与准确性。

3. 编解码混合技术:让数据"更紧凑、更清晰"

面对文本、图片、音视频等多模态数据传输,编解码技术直接影响体验:

- 端到端生成式编码:文本/图片压缩率提升60%+,节省带宽;

- 自适应损失偏好对齐:优先保障视觉/听觉主观体验,支持损伤修复;

- 端云协同AI修复:端侧模型计算+后端算法优化,提升前端画质/音质。

(注:此处截取PPT中编解码技术框架图,展示"传统编码→AI+编码→AI+解码→端云修复"的全链路)

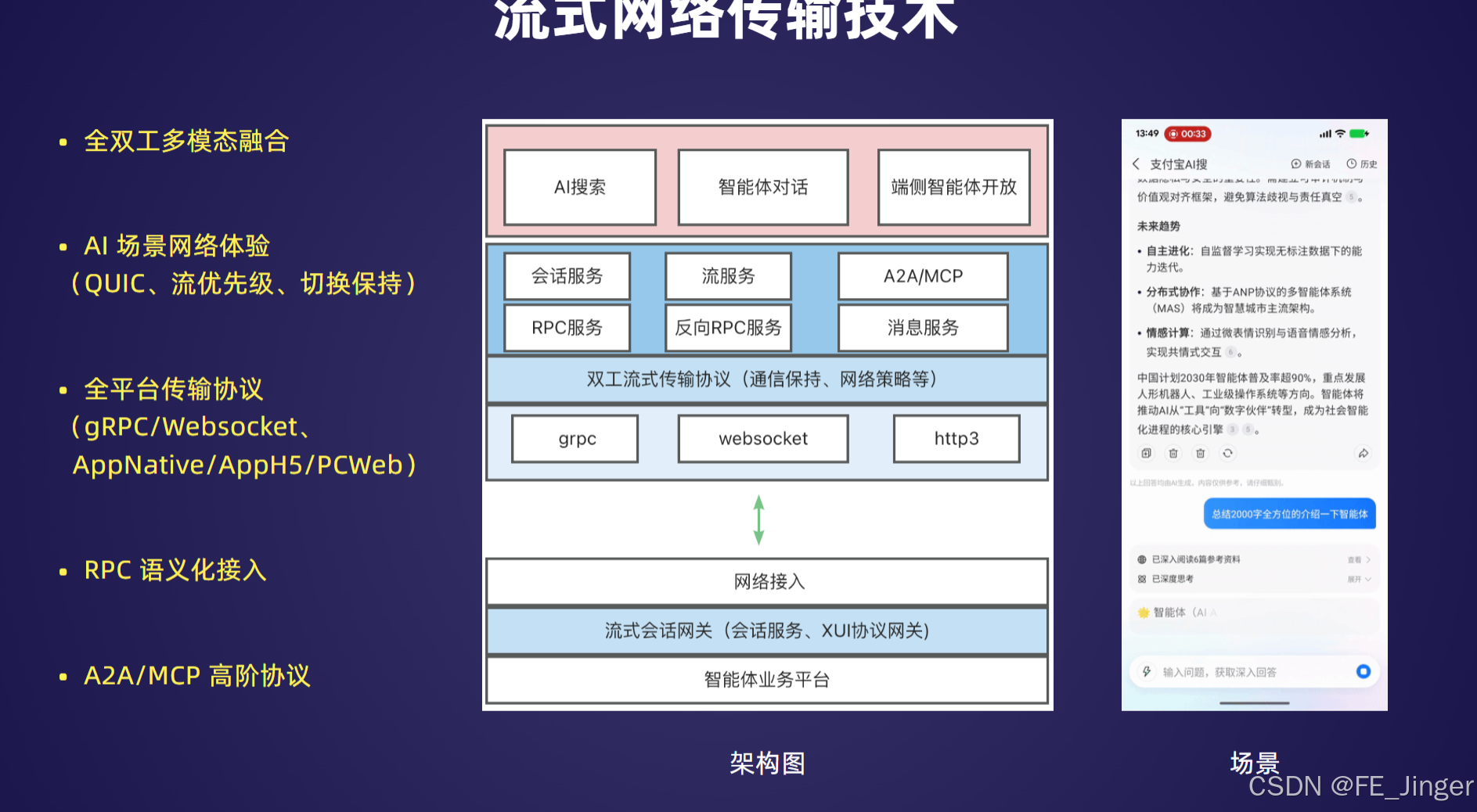

4. 流式网络传输技术:让连接"更稳定、跨平台"

跨设备、多模态交互对网络传输的兼容性与稳定性要求极高:

- 全双工多模态融合:支持QUIC协议、流优先级调度、网络切换保持;

- 全平台传输协议兼容:覆盖gRPC/Websocket/http3,适配AppNative/AppH5/PCWeb;

- RPC语义化接入:简化智能体对话、AI搜索等场景的接入流程。

5. 智能体互联技术:让跨设备"安全、可信、一致"

跨设备交互的核心是解决"身份可信、数据安全、体验一致"三大问题:

- 安全可信架构:蓝鉴安全机制保障身份、行为可信,数据隐私不泄露;

- 跨设备轻量通信:高效实现账号互通、任务流转;

- 跨厂商渲染一致性:一次接入,多场景(手机、车机、智能眼镜)统一体验。

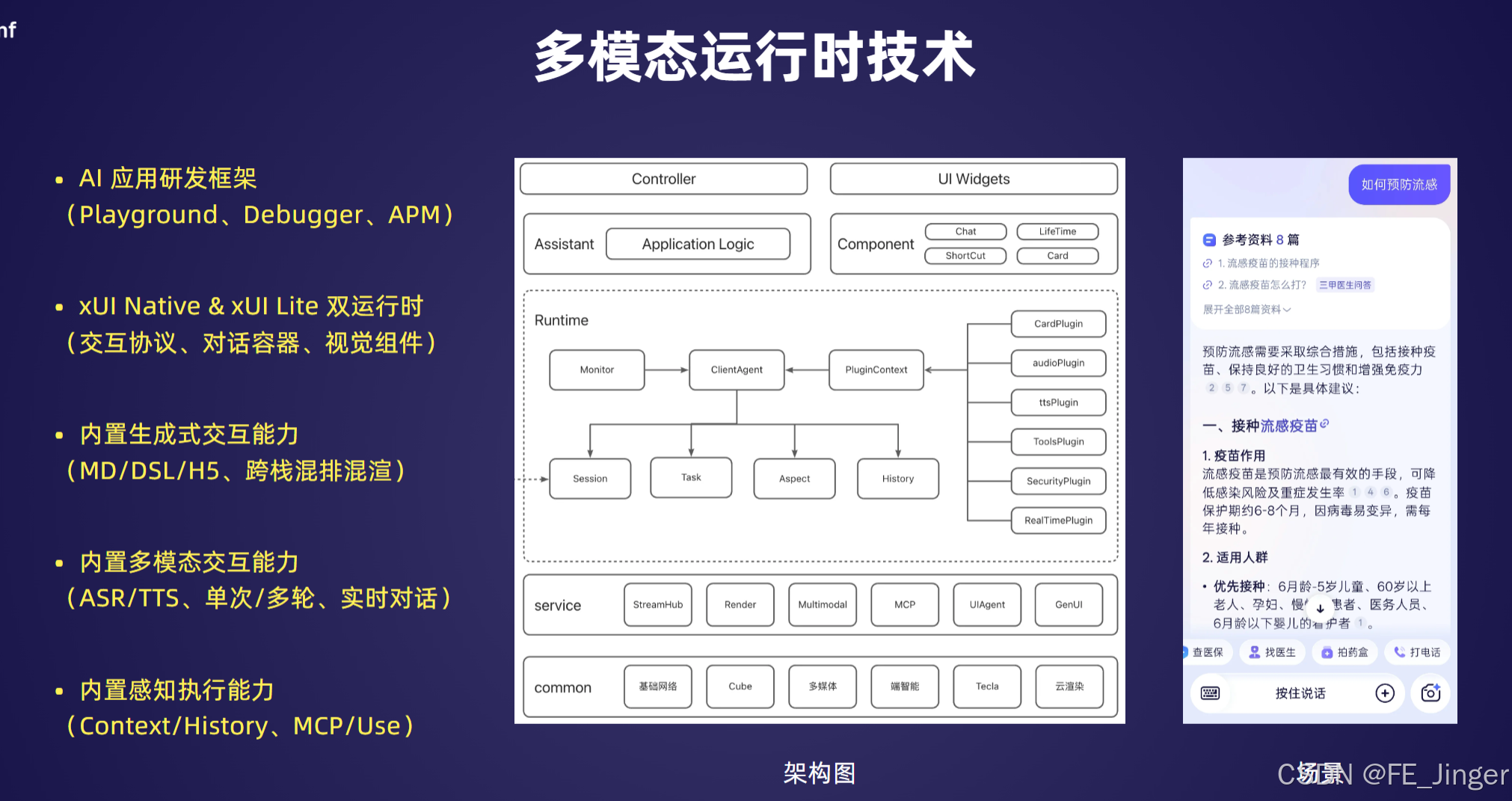

6. 多模态运行时技术:让研发"更高效、更灵活"

为AI应用开发者提供全链路支持,降低研发门槛:

- 双运行时架构:xUI Native(全功能)+ xUI Lite(轻量版),适配不同场景;

- 内置生成式交互能力:支持MD/DSL/H5跨栈混排混渲;

- 完整研发工具链:Playground(实验环境)、Debugger(调试工具)、APM(性能监控);

- 内置多模态交互能力:ASR/TTS、单次/多轮对话、感知执行能力。

四、挑战与探索:让Agent"既有脑,又有手"

1. 移动端Agent自主执行的共性挑战

当前Agent大多停留在"问能答"阶段,要实现"做能成"(比如自动点咖啡、订车票),还面临诸多现实问题:

- 交互范围有限:需覆盖原生页面、小程序、H5等混合技术栈;

- 权限与时机:系统权限管控、操作时机判断(如何时触发支付);

- 性能与体验:模型推理消耗、操作耗时、用户体验平衡;

- 采集与泛化:页面控件采集、跨App/跨系统泛化能力。

2. 支付宝的自主执行探索:GUI Agent

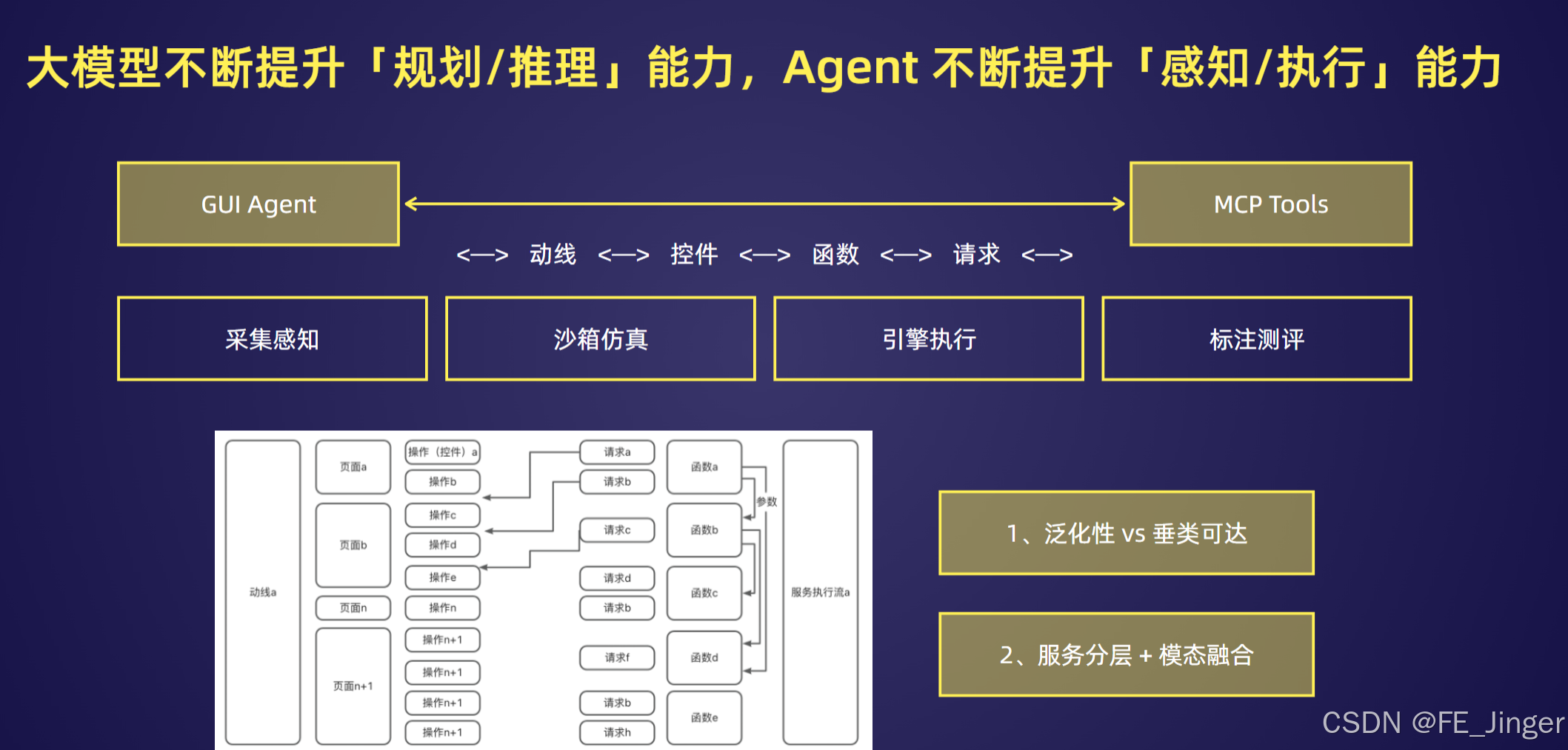

支付宝提出"大模型负责规划/推理,Agent负责感知/执行"的分工模式,通过GUI Agent实现自主操作:

- 核心逻辑:动线(操作流程)→ 控件(页面元素)→ 函数(功能调用)→ 请求(服务交互);

- 关键能力:

- 采集感知:识别页面控件、提取操作路径;

- 沙箱仿真:模拟操作流程,避免真实环境风险;

- 引擎执行:精准触发控件操作、调用业务函数;

- 标注测评:持续优化操作准确性与泛化能力。

五、未来展望:交互无界,体验为本

AI时代的人机交互形态充满不确定性,但"以用户体验为核心"的技术内核不会改变。Alipay xUI引擎的未来方向的是:

- 自主进化:通过自监督学习,实现无标注数据下的能力迭代;

- 情感计算:结合微表情识别与语情感知,实现共情式交互;

- 全场景自主执行:从"辅助操作"到"自主完成",真正实现"一句话搞定所有事";

- 开放生态:通过AHA(Agent Hub Access)平台,赋能更多厂商、开发者,共建多模态交互生态。

结语

从GUI到CUI再到xUI,人机交互的每一次进化,本质上都是"让技术更懂人"。Alipay xUI多模态智能交互引擎,不仅是支付宝应对AI时代的技术答卷,更是对未来交互形态的一次大胆探索------当设备不再是壁垒、交互不再是负担,我们与数字世界的连接,终将变得更自然、更高效、更有温度。

未来已来,交互无界。让我们共同期待xUI引擎带来的更多可能!