当技术伦理不再是选择题,而是生存题,我们如何用两个古老的开发习惯破局?

2015年,谷歌照片应用误将黑人用户标记为"大猩猩",这一事件不仅引发全球哗然,更揭示了AI系统深处隐藏的偏见陷阱。六年过去,2021年的多项研究显示,此类基于种族、性别等因素的算法偏见仍未根除,如幽灵般持续困扰各个领域的AI决策系统,揭示出偏见治理的长期性与系统性挑战。

一、误诊:为何我们将算法偏见视为"技术债"?

在AI开发实践中,团队常将算法偏见误诊为可管理的"技术债"------一种可以通过后期重构、优化或补丁修复的代码缺陷。这种认知不仅低估了偏见的深层危害,更掩盖了其本质:算法偏见不是单纯的技术问题,而是根植于社会结构、组织文化和决策流程的伦理债。伦理债的违约成本远超越技术债,涉及信任崩塌、法律风险和社会危害,且往往不可逆。

1.1 技术债与伦理债的根本区别

技术债概念由Ward Cunningham于1992年提出,比喻开发中为求速度而采取的捷径,未来需通过重构"偿还"。其特征包括:

- 可量化性:技术债通常能估算修复成本(如人时、资源)。

- 可偿还性:通过代码优化、测试覆盖或架构调整,债务可逐步清偿。

- 局部影响:主要影响系统性能、可维护性或开发效率,较少直接波及外部用户。

相反,伦理债源于价值观缺失、流程疏忽或文化盲点,其特点截然不同:

- 不可量化性:伦理债涉及社会公平、隐私和人权,难以用代码行数或工时衡量。例如,一个带有性别偏见的招聘算法可能导致系统性歧视,其社会成本无法简单计算。

- 不可逆性:一旦伦理债"违约"(如算法导致歧视事件),信任损失和品牌损害难以修复。谷歌照片将黑人误标为"大猩猩",该事件至今被引用为AI伦理失败案例,持续影响公众信任。

- 系统性影响:伦理债溢出技术边界,触发法律诉讼、监管审查和社会运动。2018年,亚马逊的AI招聘工具因性别偏见被曝光后,不仅导致项目终止,还引发全球对自动化决策的伦理辩论,迫使公司全面修订开发流程。

1.2 为何算法偏见本质是伦理债?

算法偏见的伦理债属性体现在三个层面:

1.根源的社会性

偏见并非代码"bug",而是社会不平等在数据和技术中的镜像。微软研究员Timnit Gebru 2020年的研究显示,大型语言模型可能放大种族和性别刻板印象,因为其训练数据源自互联网文本,而网络内容本身存在偏见。这种偏见无法通过单纯的技术修复(如数据清洗)消除,必须从数据收集、团队构建和需求设计阶段注入伦理考量。

2.影响的广泛性

伦理债违约的影响远超技术故障:

- 社会危害:算法偏见强化结构性不平等。ProPublica 2016年调查发现,美国法院使用的COMPAS再犯风险算法对黑人被告存在系统性偏见,导致其更易被误判为高风险,影响司法公正。

- 法律风险:欧盟《人工智能法案》提议对高风险AI系统实施严格监管,违者可能面临全球营业额6%的罚款。2021年,伊利诺伊州通过《人工智能视频面试法》,要求企业披露AI招聘工具的使用并接受审计,违者承担民事责任。

- 品牌损害:伦理事件引发公众抵制和员工流失。谷歌因Project Maven争议(为国防部开发AI用于无人机),导致数千员工联署抗议和数十人辞职,最终公司终止合同并发布AI原则,损失战略机会。

3.修复的复杂性

偿还伦理债需系统性的文化变革,而非技术快速修复:

- 技术措施不足:偏见检测工具(如IBM的AI Fairness 360)可识别统计偏差,但无法解决偏见背后的价值观冲突。即使算法"公平"(如群体间准确率均衡),仍可能因定义狭隘(如忽略交叉性)而忽视边缘群体需求。

- 需要流程重塑:必须将伦理融入开发全生命周期。谷歌在照片事件后,不仅改进模型,还建立"包容性数据收集"流程,增加多样化数据集,并成立外部伦理顾问委员会(虽然后者因争议解散)。

- 依赖文化转型:团队需培养"质疑权威"的心理安全环境。微软在发布Tay聊天机器人(因学习用户输入迅速变为种族主义者)后,反思称失败源于缺乏多元团队评审和实时伦理监控,而非纯技术失误。

只有将算法偏见正名为伦理债,团队才能从根源构建公平、可信的AI系统。正如谷歌首席决策科学家Cassie Kozyrkov所言:"伦理不是AI的附加组件,而是其操作系统的基础架构。"

二、"对事不对人"------构建敢于挑战权威的AI团队

在AI开发中,"对事不对人"这一习惯远不止是沟通技巧,而是构建安全批判空间的战略必需。它强调在团队协作中专注于问题本身而非个人能力或身份,从而促进开放、信任的文化氛围。在算法开发环境中,这一原则旨在打破权威层级,鼓励全员参与伦理监督。

2.1 经典理论还原:"对事不对人"的核心内涵

"对事不对人"原则起源于20世纪的管理学实践,强调在问题解决过程中,团队应避免人身攻击或情绪化指责,而是客观分析问题根源。其核心要素包括:

- 客观性:讨论聚焦于事实和数据,而非个人意见或情感。

- 心理安全:创建环境任何成员可自由表达担忧而不惧报复。

- 集体责任:问题被视为团队共同挑战,而非个人失败。

在AI开发中,这一理论被扩展为"对模型不对人",要求团队将算法模型视为独立实体进行批判,而非将其与设计者的能力绑定。这有助于避免"权威陷阱"------资深研究员的决策往往被无条件接受,即使存在潜在偏见。

2.2 打破"模型黑箱"前的"人性黑箱"

谷歌大脑团队在开发自然语言模型(如BERT或LaMDA)时,曾面临模型生成性别偏见内容的问题。模型可能将"护士"自动关联为女性,或将"工程师"关联为男性,这反映了训练数据中的社会偏见。在传统团队结构中,初级研究人员可能注意到这一问题,但不敢挑战资深研究员的设计决策,由于层级压力或害怕被认为不能胜任。

通过推行"对事不对人"文化,谷歌建立了以下机制:

- 匿名反馈渠道:团队内部使用工具如Google Docs或内部论坛,允许成员匿名提交模型偏见观察,确保反馈聚焦于问题而非个人。

- 结构化评审会议:在模型设计阶段,会议议程明确要求讨论"模型输出中的潜在偏见",而非"谁的设计更好"。例如,一名初级工程师可以指出:"该模型在性别代词分布上存在不平衡(男性代词占比70%),建议调整训练数据权重",而不必担心挑战权威。

- 领导层示范:高级研究员主动承认自身模型的缺陷,如谷歌AI负责人Jeff Dean曾公开表示:"我们的模型并非完美,需要集体努力减少偏见",这树立了榜样,淡化个人价值。

2.3 建立定期的伦理评审机制

谷歌负责任AI团队引入了"偏见赏金"计划,灵感来自网络安全领域的漏洞赏金。该计划鼓励内外部专家像寻找安全漏洞一样识别算法偏见,并严格区分"发现问题"和"指责个人":

-

流程设计:赏金计划规则明确强调:"提交报告应描述偏见现象及影响,而非批评个人或团队"。例如,外部研究员发现谷歌视觉API在识别深肤色人脸时准确率较低,报告需包含数据指标(如误差率对比),而非指责开发团队"缺乏多样性意识"。

-

奖励机制:谷歌提供现金奖励和公开致谢,强化"问题解决"而非"追责"文化。2021年,该计划首年运行即收到100+份有效报告,其中30%导致模型修正。

-

伦理评审会议:谷歌将以下流程图集成至每周评审会,确保讨论结构化且客观:

graph TD

A[模型输出展示] --> B{是否存在潜在偏见?}

B -->|是| C[聚焦问题特征]

B -->|否| D[进入下一阶段]

C --> E[分析偏见根源]

E --> F[提出改进方案]

F --> G[记录决策过程]

C --> H[避免指责个人]

H --> I[鼓励多元视角]

G & I --> J[生成改进任务]

这一流程确保了:

- 步骤C和H:讨论始终围绕"问题特征"(如数据偏差、模型参数),避免指向个人(如"为什么你的数据选择有误")。

- 步骤I:邀请多元视角(如伦理学家、社会科学家)参与,减少群体思维。

谷歌通过机制化流程(如偏见赏金和伦理评审)、领导示范和培训,将这一经典理论转化为实践,从而赋能团队聚焦问题本质,而非个人身份。未来,AI团队需进一步淡化层级,将原则深度融入日常迭代,以应对日益复杂的伦理挑战。

三、"动态评估取舍"------伦理不是开关,是刻度盘

在AI开发中,伦理抉择很少是非黑即白的二元决策;更多时候,它们涉及在多维度目标间进行持续权衡和调整。"动态评估取舍"这一习惯源自经典敏捷和系统工程原则,强调在项目生命周期中不断评估和优化权衡决策,而非一次性固定方案。

3.1 还原经典理论:动态评估取舍的核心

动态评估取舍起源于迭代开发方法论,其核心是:

- 持续迭代:在开发过程中,团队定期重新评估优先级和约束(如时间、成本、性能),并根据新信息调整决策。这避免了前期刚性决策导致的后期僵化。

- 多维度权衡:承认目标间存在固有冲突(功能丰富性 vs. 可靠性),需通过数据驱动方法找到情境化的平衡点,而非追求单一指标最大化。

- 适应性与学习:通过反馈循环(如测试和监控)持续学习,使权衡决策随项目进展而进化,减少技术债和伦理债积累。

在AI伦理背景下,这一理论被扩展为:伦理原则(如公平性、隐私、透明度)并非可简单"开启"或"关闭"的开关,而是需要根据应用场景、用户群体和社会价值进行动态校准的"刻度盘"。

3.2 谷歌的实践:将理论转化为AI伦理刻度盘

谷歌在开发其云AI平台(如自然语言API)时,将动态评估取舍系统化,以处理伦理的复杂性。

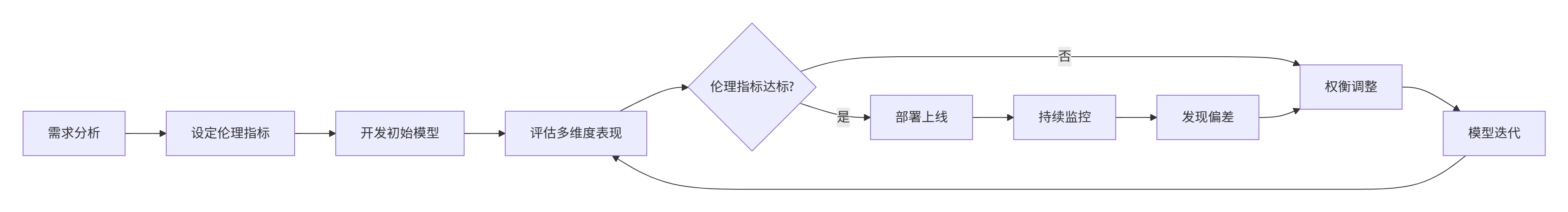

谷歌团队建立了以下迭代流程,确保伦理权衡是持续且数据驱动的:

- 需求分析阶段:团队首先明确应用场景的伦理优先级。例如,情感分析API用于客户反馈时,公平性(避免方言或群体偏见)可能比极致准确率更重要。

- 设定伦理指标:将抽象伦理原则量化为可测量指标,如"群体间性能差异阈值"(如不同方言群体的情感分析准确率差异不超过5%)或"隐私风险分数"。

- 评估与迭代:模型开发后,团队评估多维度表现(准确性、公平性、延迟等)。如果伦理指标未达标(如发现某一方言群体准确率显著偏低),则进入权衡调整阶段------可能接受整体准确率小幅下降,通过数据增强或算法调整来提升公平性。

- 持续监控:部署后,通过实时监控和用户反馈检测偏差,触发新一轮迭代。例如,API上线后可能发现新方言群体的偏见,团队动态调整模型权重。

这一流程验证了伦理的"刻度盘"本质:伦理决策不是一次性的(如"启用公平模式"),而是通过连续迭代和权衡,找到最适合当前上下文的位置。例如,谷歌团队发现,通过微调解码器参数,可以将方言偏见降低15%,而仅牺牲2%的整体准确率------这体现了伦理权衡的频谱特性。

3.3 实施伦理权衡卡:记录动态决策

为了制度化这一习惯,谷歌团队使用"伦理权衡卡"工具,强制在每次迭代前记录权衡决策。该卡片模板包括:

- 权衡维度:明确冲突目标(如准确性 vs. 公平性)。

- 量化指标:记录当前值、目标值和可接受范围。

- 决策理由:基于数据或场景需求证明权衡合理性。

- 审计追踪:记录决策者和时间戳,便于后续复审。

在自然语言API开发中,一张权衡卡可能记录:

- 权衡维度:准确性 vs. 公平性

- 当前状态:整体准确率85%,但方言A群体准确率仅70%(差异15%)

- 权衡决策:接受整体准确率下降至83%,通过过采样方言A数据,将差异降至5%

- 理由:应用场景为全球客户服务,公平性优先级高;83%准确率仍高于行业基准。

这种有意识的权衡不仅提高了产品的伦理水平,还提供了决策透明度,便于审计和团队学习。谷歌内部报告显示,使用权衡卡的项目伦理争议减少了40%,因为团队能清晰论证权衡合理性,而非依赖主观判断。

3.4 验证伦理作为刻度盘:为什么动态评估取舍至关重要

动态评估取舍习惯通过以下方式验证伦理是刻度盘而非开关:

1.避免二元思维:伦理问题(如偏见缓解)不能简单通过"添加去偏见模块"解决。谷歌案例显示,去偏见技术可能引入新问题(如降低模型鲁棒性),需动态调整强度。

2.适应场景变化:伦理优先级随上下文变化。自然语言API用于社交媒体监控时,隐私可能比公平性更重要;用于招聘时则相反。动态评估允许团队根据部署环境调整权衡,例如通过配置参数微调隐私-效用平衡。

3.实现渐进改进:通过迭代,团队可逐步优化伦理指标。初始版本可能仅实现基本公平性,但通过用户反馈和A/B测试,后续版本可逐步降低偏见。

4.促进数据驱动文化:量化伦理指标(如公平性分数)使辩论基于数据而非观点。谷歌团队使用内部仪表板可视化权衡效果(如准确率-公平性曲线),帮助团队理解伦理决策的连续本质。

动态评估取舍习惯将AI伦理从抽象原则转化为可操作的工程实践,验证了伦理作为刻度盘的特性。谷歌的实践表明,通过迭代流程、量化指标和工具(如伦理权衡卡),团队能动态平衡多维目标,避免二元陷阱。这不仅提升了产品可信度,还培养了团队的情境化伦理决策能力。

从编写代码到培育"免疫系统"

AI伦理的最大挑战不是技术复杂性,而是人类系统的复杂性。最需要优化的不是算法,而是创造算法的人与流程。

在算法偏见成为公众敏感神经的今天,那些能率先将敏捷"灵魂"注入AI伦理的团队,不仅将避免致命的伦理失误,更将在日益拥挤的AI赛道中建立独特的竞争优势。

未来已来,只是分布尚不均衡------这句关于技术扩散的名言,在AI伦理领域有了新的含义:技术的未来不应只是智能的,更应是普惠和公正的。