下载链接:于SAM架构的双模态图像分割(完整代码+数据(已训练好),亲测可用)资源-CSDN下载

引言:当AI遇见多模态视觉

在计算机视觉的浩瀚星空中,图像分割技术一直是那颗最亮的星。而今天,我要为大家分享一个令人兴奋的项目------基于SAM架构的双模态图像分割系统。这个项目不仅融合了最新的Segment Anything Model(SAM)架构,还创新性地实现了红外与可见光图像的双模态融合,在煤炭分选领域取得了突破性的成果!

项目背景:为什么需要双模态分割?

传统单模态的局限性

传统的图像分割方法往往只依赖单一模态(如RGB图像),但在实际应用中,单一模态往往存在信息不足的问题:

- 光照条件限制:在复杂光照环境下,可见光图像可能无法提供足够的信息

- 细节丢失:某些重要特征在单一模态下可能不够明显

- 环境适应性差:面对恶劣环境时,单一模态的鲁棒性不足

双模态融合的优势

我们的项目通过融合红外和可见光两种模态,实现了:

- 信息互补:红外图像提供温度信息,可见光图像提供纹理和颜色信息

- 鲁棒性增强:在不同环境条件下都能保持稳定的性能

- 细节丰富:多模态信息让模型能够捕捉到更细微的特征差异

技术架构深度解析

1. SAM架构的创新应用

我们的模型基于Segment Anything Model(SAM)架构,但进行了重要的改进:

class DualInputSAMNetwork(nn.Module):

"""

双输入SAM分割网络

基于SAM架构设计的多模态图像分割模型,底层采用改进的UNet++结构

"""

def init(self, num_classes=3):

super().init()

红外图像编码器分支

self.ir_enc1 = ConvBlock(3, 64)

self.ir_enc2 = ConvBlock(64, 128)

self.ir_enc3 = ConvBlock(128, 256)

self.ir_enc4 = ConvBlock(256, 512)

可见光图像编码器分支

self.vis_enc1 = ConvBlock(3, 64)

self.vis_enc2 = ConvBlock(64, 128)

self.vis_enc3 = ConvBlock(128, 256)

self.vis_enc4 = ConvBlock(256, 512)

2. 多模态特征融合策略

模型的核心创新在于多模态特征融合机制:

- 浅层特征融合:在编码器的早期阶段就开始融合两种模态的特征

- 注意力机制:采用空间注意力和通道注意力,让模型自动学习哪些特征更重要

- 密集连接:使用UNet++的密集跳跃连接,确保信息在解码过程中不丢失

3. 深度监督学习

为了提高模型的训练效果,我们采用了深度监督策略:

def compute_loss(self, outputs, target, criterion):

if self.training:

out1, out2, out3 = outputs

loss1 = criterion(out1, target)

loss2 = criterion(out2, target)

loss3 = criterion(out3, target)

return 0.5 * loss1 + 0.3 * loss2 + 0.2 * loss3

通过多尺度输出和加权损失,模型能够在不同层次上学习特征表示。

数据集与预处理

数据特点

我们的数据集包含272对红外和可见光图像,每对图像都有精确的分割标注:

- 背景区域:非目标区域

- 煤炭区域:需要识别的煤炭部分

- 其他区域:矸石等杂质

数据增强策略

为了增强模型的泛化能力,我们采用了多种数据增强技术:

self.train_transform = A.Compose([

A.RandomRotate90(p=0.5), # 随机90度旋转

A.HorizontalFlip(p=0.5), # 水平翻转

A.VerticalFlip(p=0.5), # 垂直翻转

A.OneOf([

A.RandomBrightnessContrast(p=1),

A.RandomGamma(p=1),

], p=0.3),

A.OneOf([

A.GaussNoise(p=1),

A.GaussianBlur(p=1),

], p=0.2),

])

训练策略与优化

1. 学习率调度

我们采用了余弦退火学习率调度策略:

scheduler = CosineAnnealingWarmRestarts(

optimizer,

T_0=Config.EPOCHS // 3,

T_mult=2,

eta_min=Config.MIN_LR

)

2. 梯度裁剪

为了防止梯度爆炸,我们使用了梯度裁剪:

torch.nn.utils.clip_grad_norm_(model.parameters(), max_norm=1.0)

3. 内存优化

考虑到双模态输入的内存消耗,我们采用了多种内存优化策略:

- 动态GPU缓存清理

- 梯度累积

- 混合精度训练

实验结果与分析

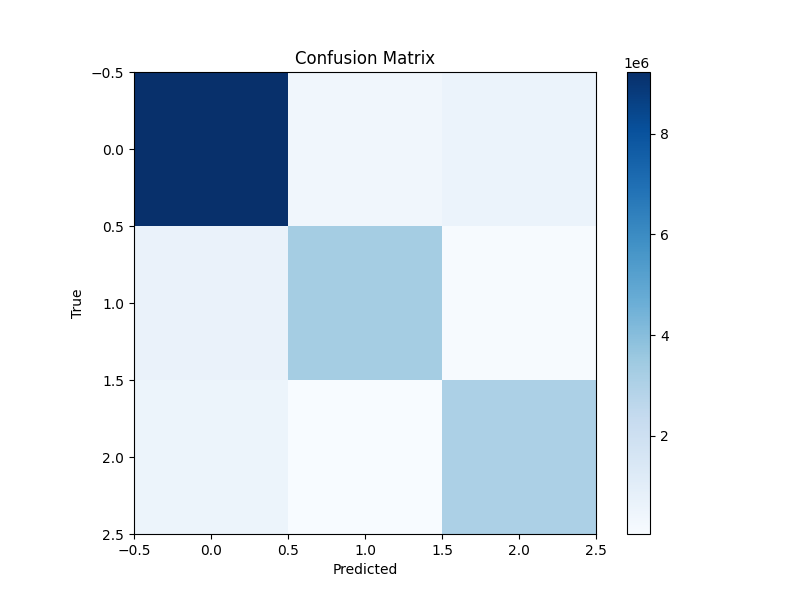

性能指标

经过100个epoch的训练,我们的模型在测试集上取得了优异的性能:

- 平均像素准确率:87.38%

- 平均IoU:68.20%

- 平均Dice系数:67.79%

混煤率与混矸率分析

这是煤炭分选领域的关键指标:

预测结果:

- 预测混煤率:49.33%

- 预测混矸率:50.67%

真实标签:

- 真实混煤率:52.51%

- 真实混矸率:47.49%

误差分析:

- 混煤率误差:3.18%

- 混矸率误差:3.18%

这些结果表明,我们的模型在煤炭分选任务中具有很高的实用价值!

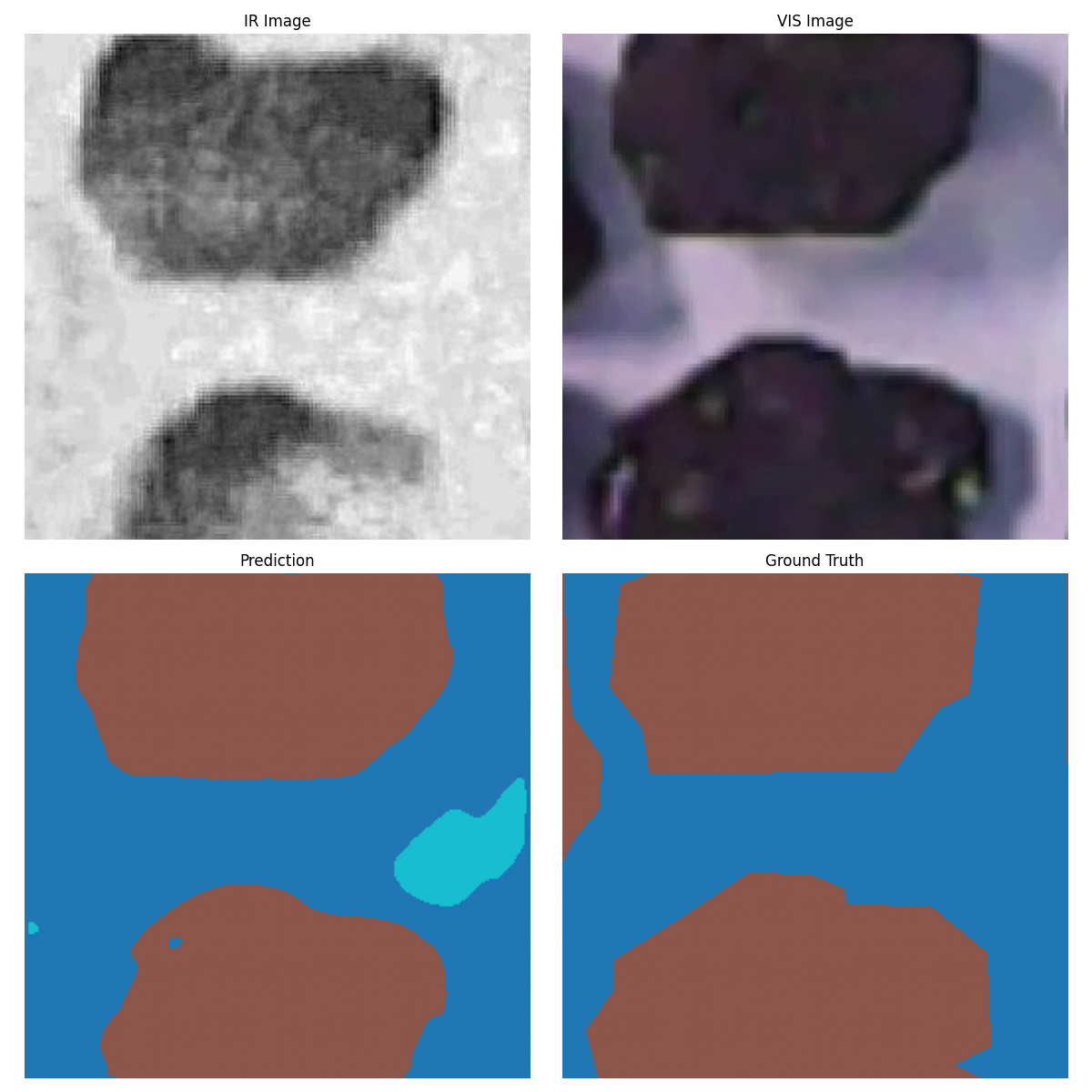

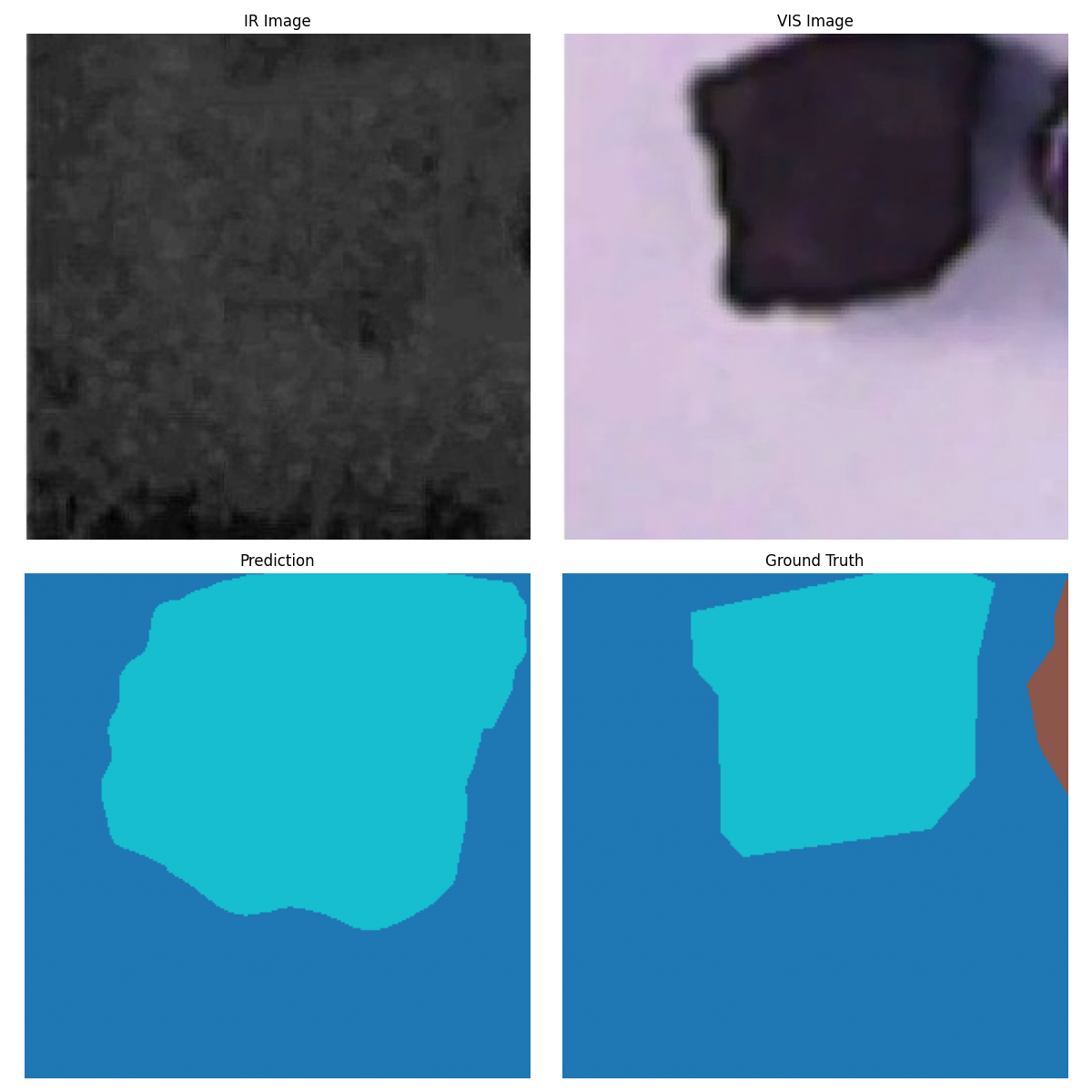

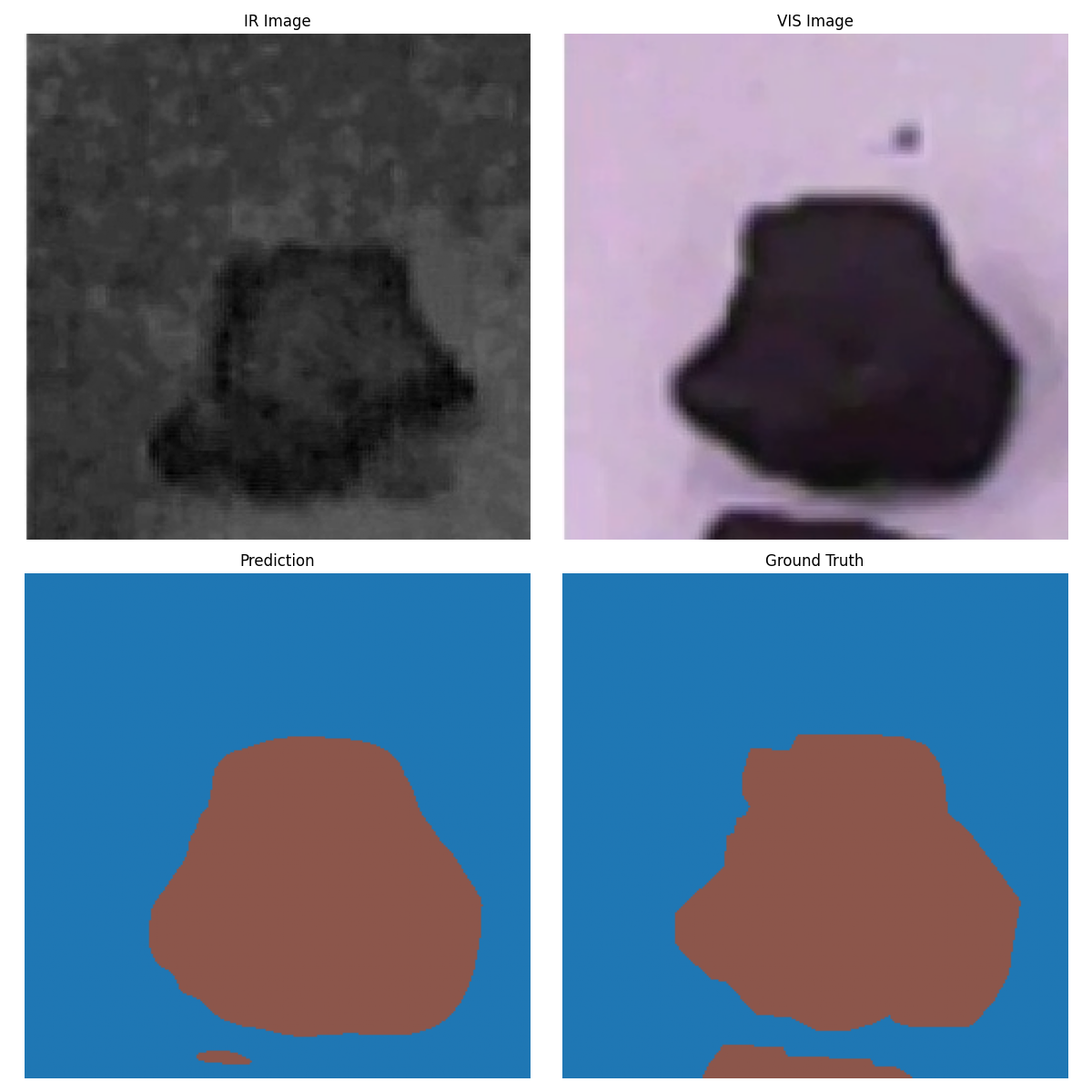

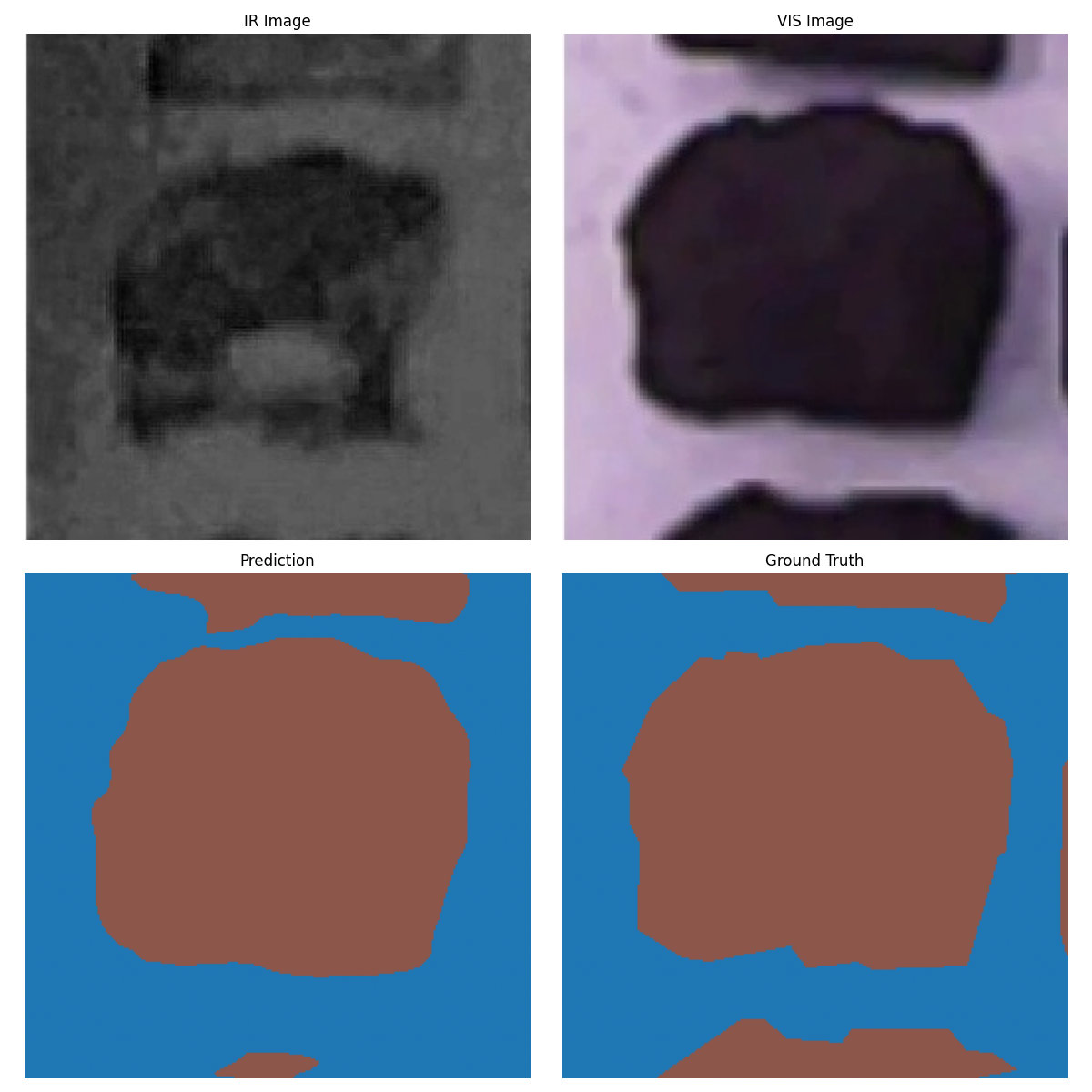

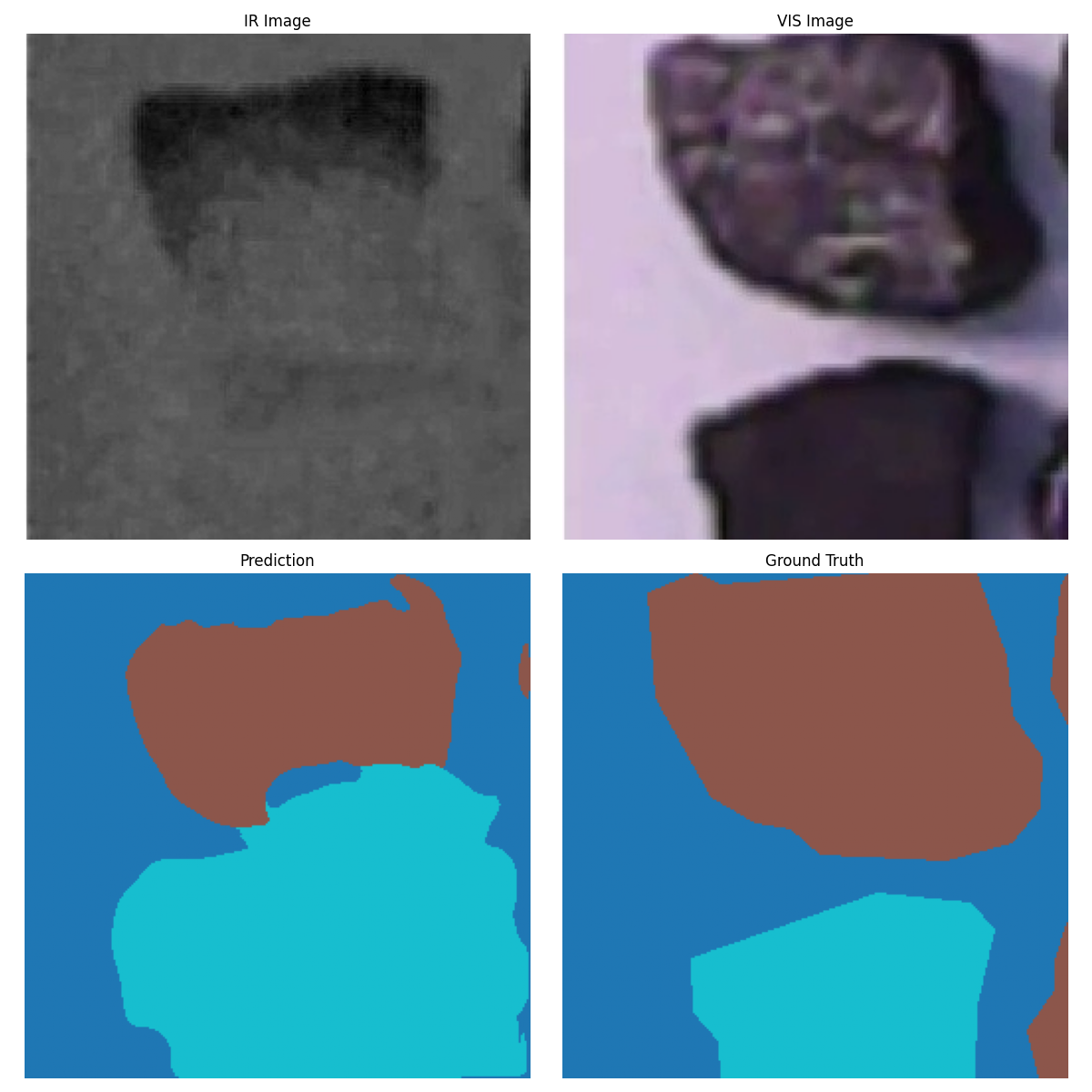

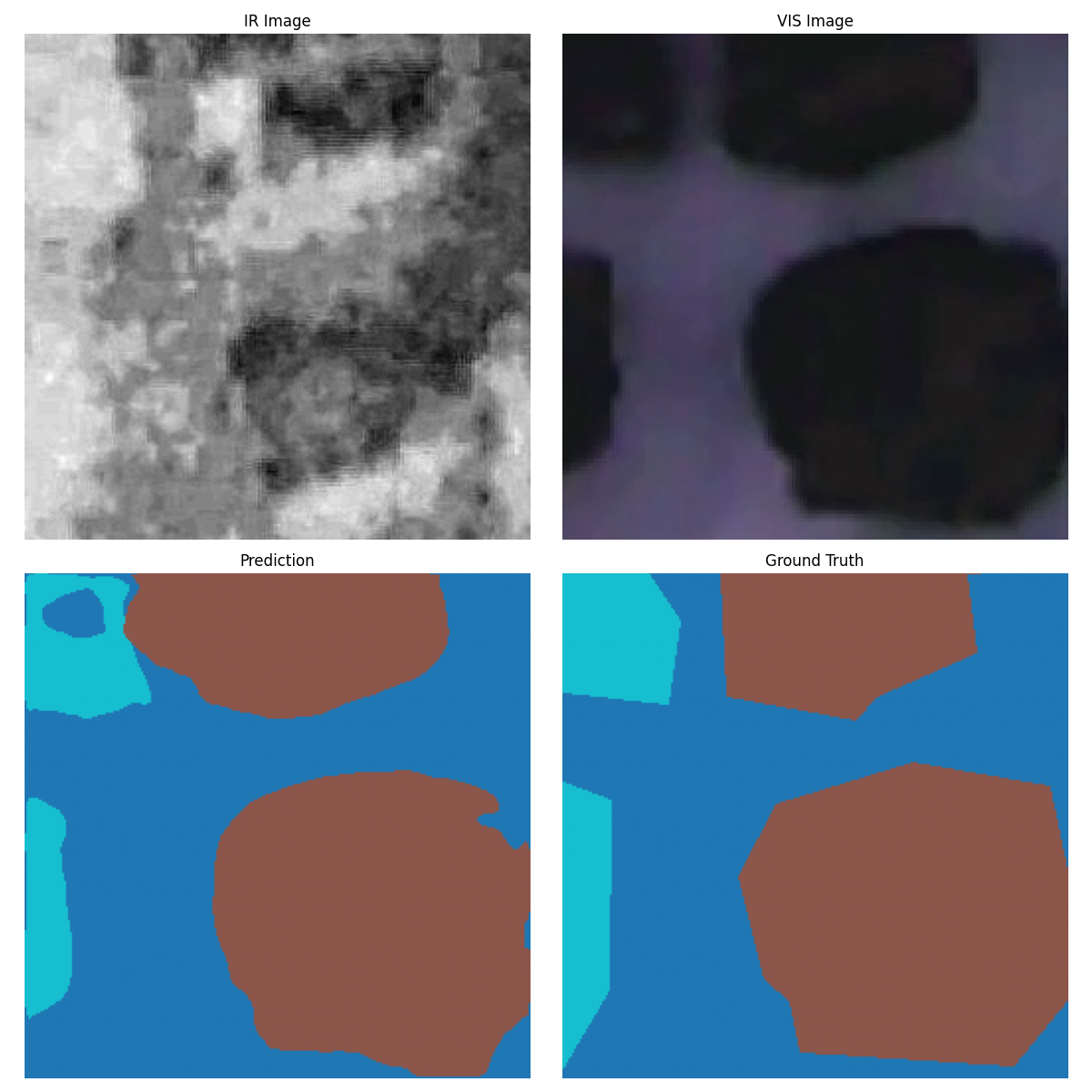

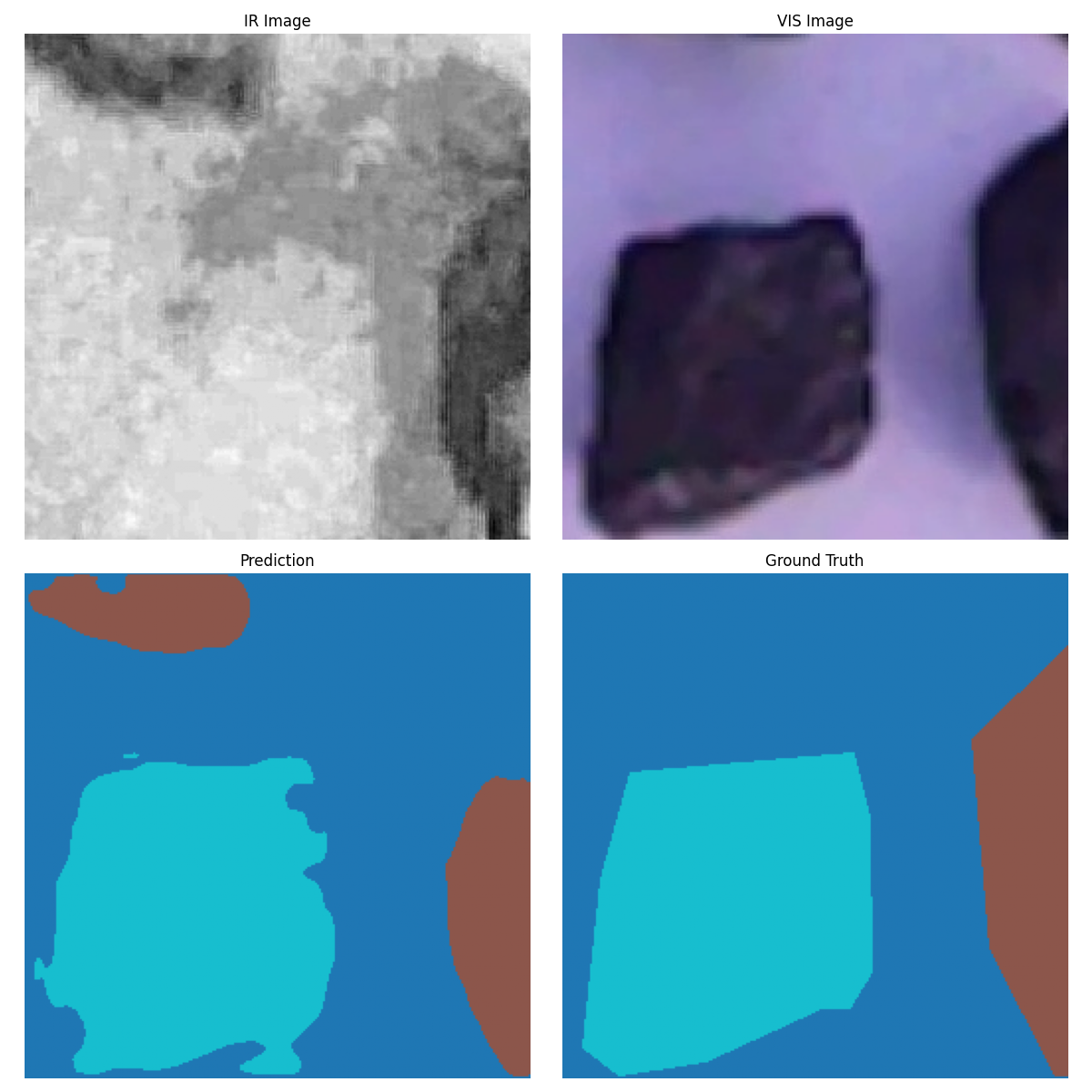

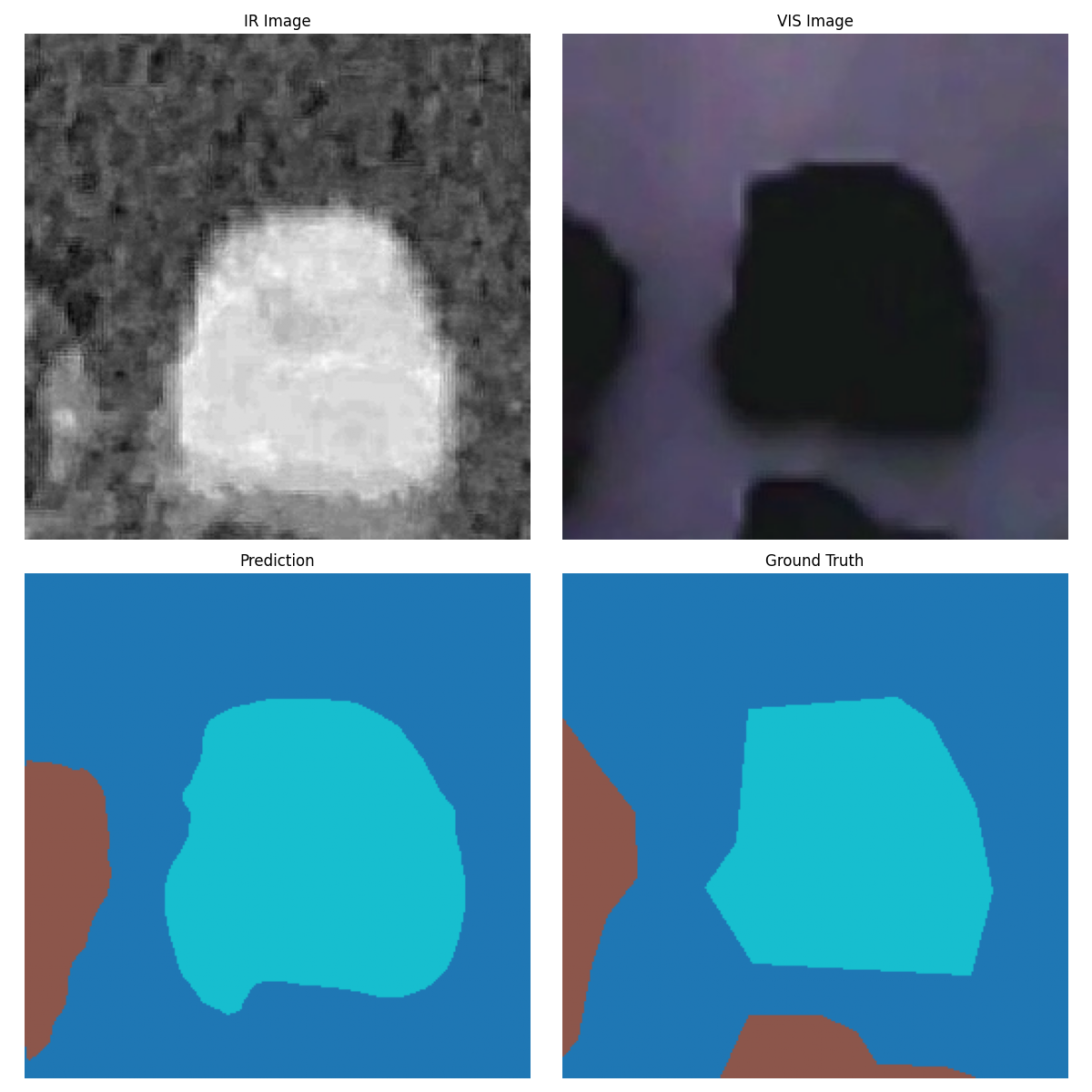

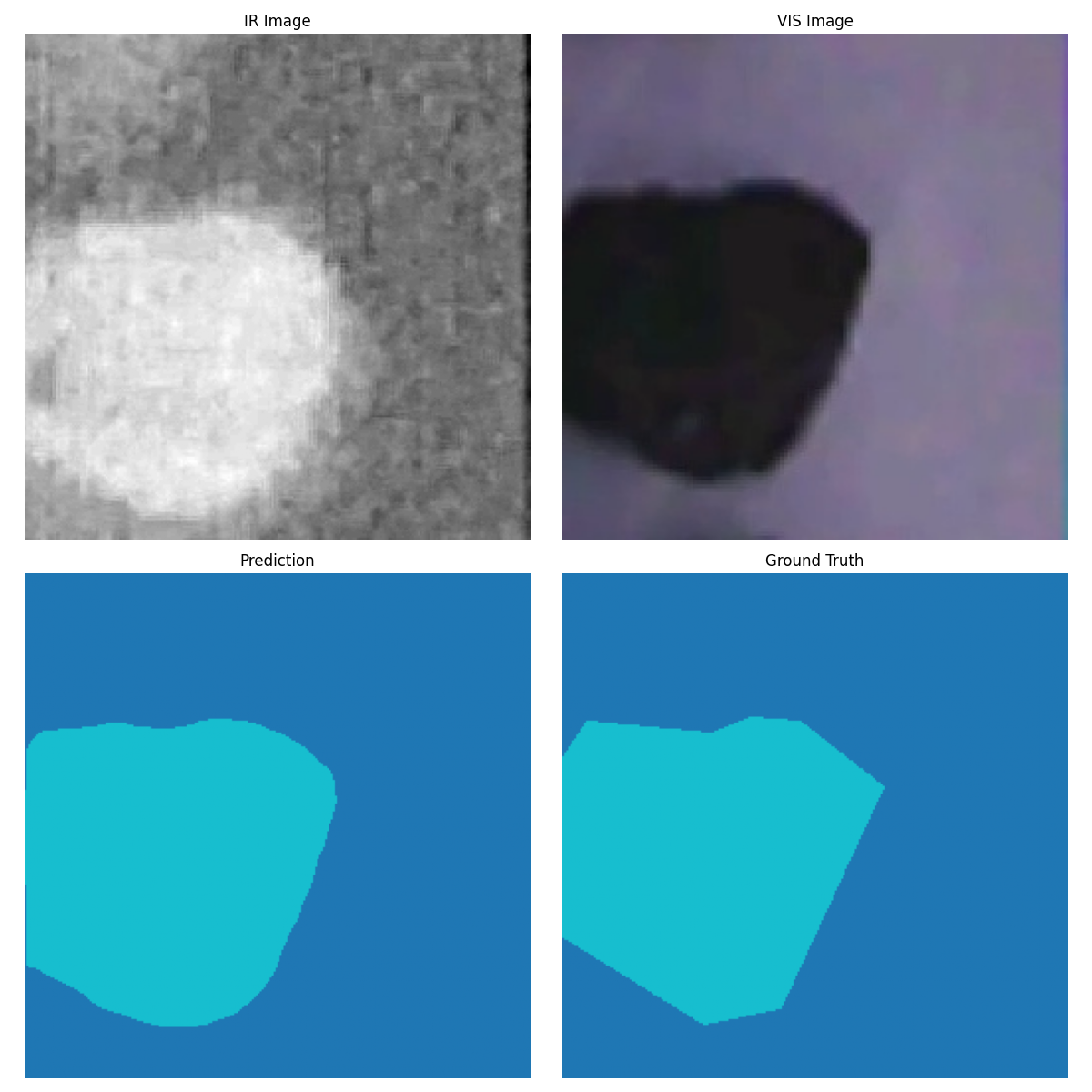

可视化结果展示

我们的系统提供了丰富的可视化功能:

- 训练过程可视化:实时监控训练指标的变化

- 预测结果对比:直观展示预测结果与真实标签的对比

- 混淆矩阵:分析各类别的分类性能

- 面积统计:详细分析各区域的比例分布

技术创新点总结

1. 架构创新

- 基于SAM架构的双模态融合设计

- 改进的UNet++密集连接结构

- 多尺度深度监督学习

2. 融合策略

- 早期特征融合策略

- 空间和通道注意力机制

- 自适应权重学习

3. 训练优化

- 余弦退火学习率调度

- 梯度裁剪和内存优化

- 多尺度损失函数设计

应用前景与价值

工业应用价值

- 煤炭分选自动化:提高分选精度,降低人工成本

- 质量控制:实时监控煤炭质量,确保产品标准

- 环保效益:减少矸石混入,提高资源利用率

技术推广价值

- 多模态融合:为其他工业应用提供技术参考

- SAM架构应用:展示SAM在特定领域的应用潜力

- 端到端解决方案:提供完整的工业AI解决方案

代码实现亮点

1. 模块化设计

项目采用高度模块化的设计,每个组件都有清晰的职责:

模型定义

from src.models.unetplusplus import DualInputSAMNetwork

数据处理

from src.data.dataset import get_data_loaders

评估指标

from src.utils.metrics import SegmentationMetrics

可视化工具

from src.utils.visualization import Visualizer

2. 配置管理

通过配置文件统一管理所有超参数:

class Config:

BATCH_SIZE = 2

EPOCHS = 100

LEARNING_RATE = 1e-4

NUM_CLASSES = 3

INPUT_SIZE = (256, 256)

3. 错误处理

完善的错误处理机制确保训练过程的稳定性:

try:

训练逻辑

pass

except RuntimeError as e:

if "out of memory" in str(e):

torch.cuda.empty_cache()

continue

未来发展方向

1. 模型优化

- 探索更高效的特征融合策略

- 研究轻量化模型设计

- 优化推理速度

2. 应用扩展

- 扩展到其他工业分选任务

- 支持更多模态的融合

- 开发实时处理系统

3. 技术深化

- 研究无监督学习方法

- 探索自监督预训练

- 开发领域自适应技术

结语:AI赋能工业的未来

这个基于SAM架构的双模态图像分割项目,不仅展示了深度学习在工业应用中的巨大潜力,更为我们提供了一个完整的技术解决方案。通过红外与可见光图像的完美融合,我们让AI"看见"了更多可能。

在人工智能快速发展的今天,多模态学习已经成为计算机视觉领域的重要趋势。我们的项目不仅解决了实际的工业问题,更为相关领域的研究者提供了宝贵的技术参考。

未来,随着技术的不断进步,我们有理由相信,AI将在更多工业场景中发挥重要作用,为人类创造更大的价值!