📖标题:SIM-CoT: Supervised Implicit Chain-of-Thought

🌐来源:arXiv, 2509.20317

🌟摘要

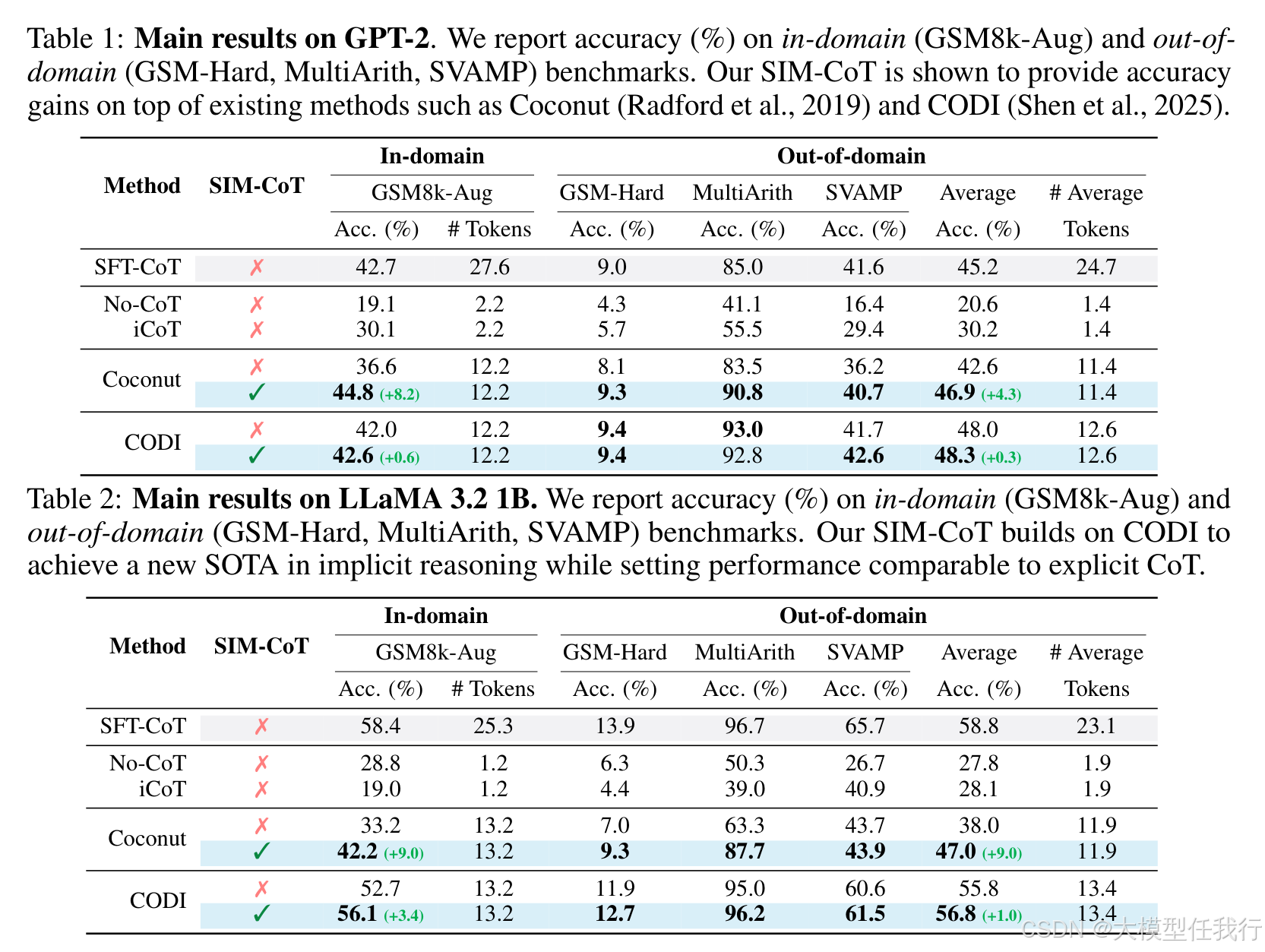

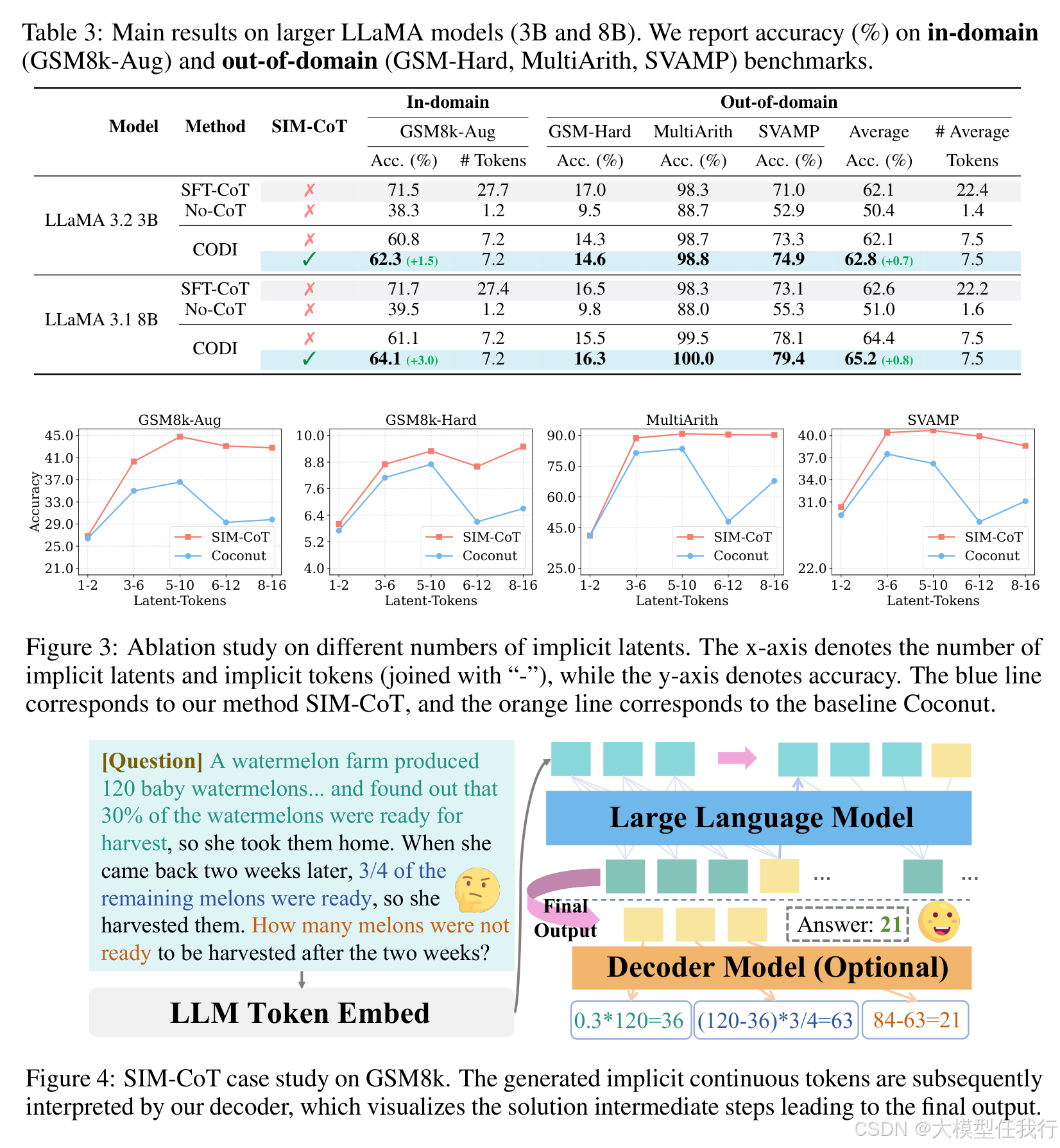

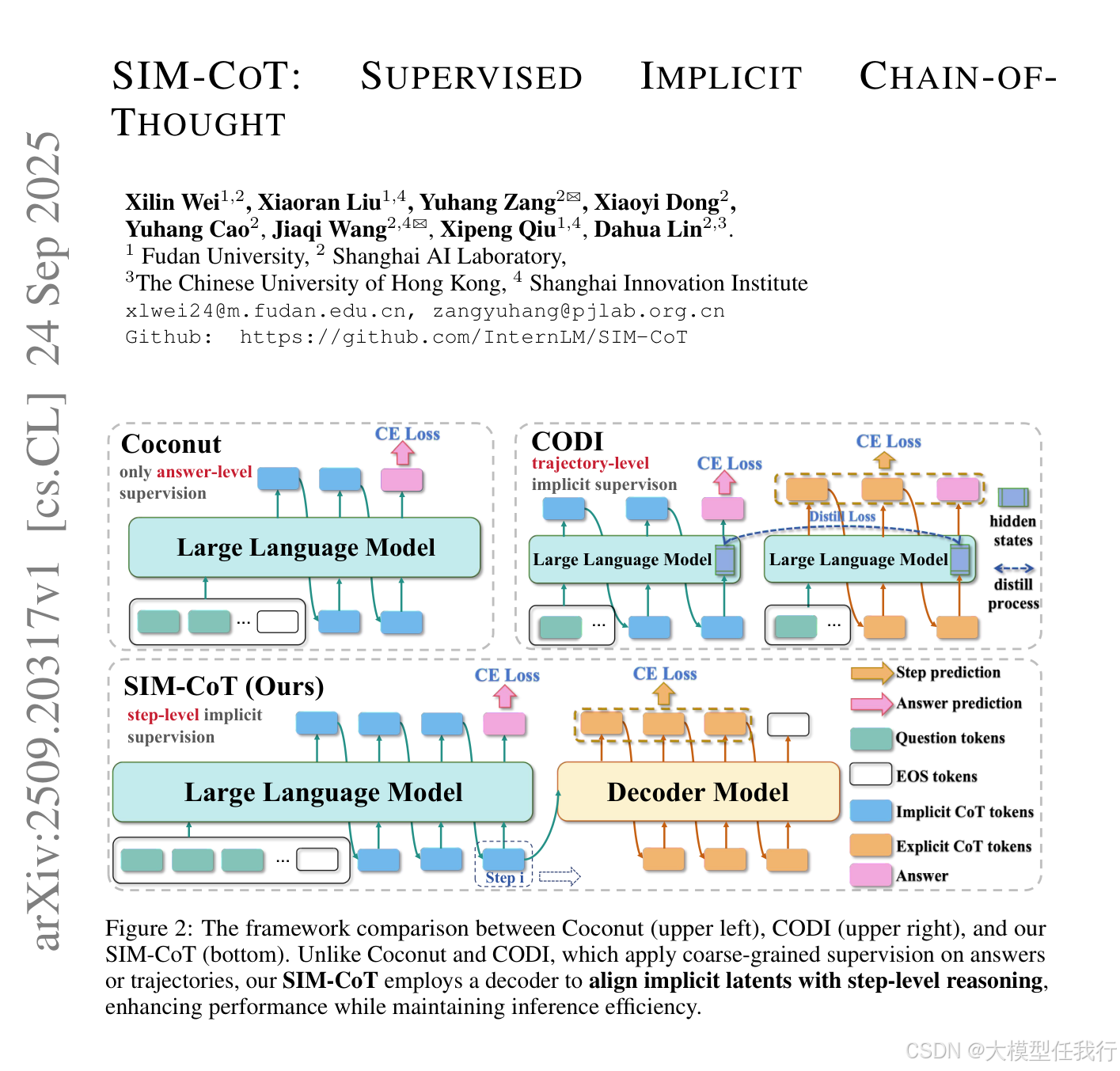

隐式思维链 (CoT) 方法为大型语言模型 (LLM) 中的显式 CoT 推理提供了一种有前途的、令牌高效的替代方案,但持久性能差距限制了隐式 CoT 的应用。我们通过缩放隐式 CoT 方法的计算预算来识别核心潜在不稳定性问题:随着我们增加隐式推理标记的数量以提高性能,训练过程通常变得不稳定和崩溃。我们的分析表明,这种不稳定性源于潜在表示变得同质并失去语义多样性,这是现有隐式 CoT 方法中逐步监督不足造成的失败。为了解决这个问题,我们提出了 SIM-CoT,这是一个即插即用的训练模块,它引入了步骤级监督来稳定和丰富潜在的推理空间。具体来说,SIMCoT 在训练期间使用辅助解码器将每个隐式标记与其对应的显式推理步骤对齐,确保潜在状态捕获不同且有意义的信息。在推理过程中去除所提出的辅助解码器,在不增加开销的情况下保持隐式 CoT 方法的计算效率。此外,辅助解码器通过将每个潜在标记投影到显式推理词汇表中来提供隐式推理的可解释性,从而能够逐步可视化语义角色和诊断。SIMCoT 显着提高了各种隐式 CoT 方法的域内准确性和域外稳定性,将 GPT-2 和 CODI 等基线提高了 +8.2%,LLaMA-3.1 8B 上的 Coconut 提高了 +3.0%。证明了强大的可扩展性,SIM-CoT 在 GPT-2 上也比显式 CoT 基线高出 2.1%,令牌效率提高了 2.3 倍,同时大大缩小了 LLAMA-3.1 8B 等较大模型的性能差距。代码:https://github.com/InternLM/SIM-CoT。

🛎️文章简介

🔸研究问题:如何提高大语言模型(LLM)在推理过程中的灵活性和效率,同时解决显式思维链方法的局限性?

🔸主要贡献:论文提出了一种名为SIM-CoT的隐式推理方法,通过逐步隐式监督来提升推理的稳定性和表达的丰富性,同时保持推理效率。

📝重点思路

🔸论文首先定义了隐式推理的框架,与现有的方法(如Coconut和CODI)进行了比较。

🔸在训练阶段,模型用解码器对每个隐式潜在向量进行逐步监督,将其与相应的推理内容对齐。

🔸引入了K个推理步骤的设计,模型在隐式阶段运行一固定数量的步骤,在最后生成答案时切换回显式解码。

🔸使用GSM8k-Aug数据集进行训练,数据集中保留了结构化的数学表达式以辅助隐式推理学习。

🔎分析总结

🔸研究发现,当隐式潜在向量的数量过多时,模型的准确性会急剧下降,显示出潜在不稳定问题,能够表明隐式推理对潜在向量数量的敏感性。

🔸通过与其他方法(如Coconut和CODI)的对比,SIM-CoT在多种基准测试上展现了更高的准确率,尤其是在看不见的数据集上,也能较好地泛化。

🔸论文数据显示,SIM-CoT通过逐步隐式监督改善了潜在表示的多样性和稳定性,有效降低了推理成本,同时保持高的推理性能。

💡个人观点

论文引入了逐步隐式监督策略,先在隐变量上做了一定程度的推理然后再解码生成,个人理解是通过对齐来完成部分思考工作,降低解码器难度。

🧩附录