在分类任务(如医学诊断、机器学习模型评估、数据标注等)中,两个评估者(或模型)的分类一致性 是衡量结果可靠性的关键指标。Cohen's Kappa系数(κ) 是一种经典的统计方法,用于评估分类一致性,同时校正随机一致的影响,比简单的"一致率"更可靠。本文将详细介绍:

- Kappa系数的原理与计算(公式、解读标准);

- 核心作用(为什么比准确率更可靠?);

- 典型应用场景(医学、机器学习、社会科学等);

- 自然语言处理(NLP)中的实际案例(如数据标注一致性、模型评估);

- 局限性及替代方案(如Fleiss' Kappa、加权Kappa)。

最后,我们将通过NLP数据标注案例(如藏文信息处理、文本分类标注)展示Kappa系数的实际价值,并总结其适用性与改进方向。

1. 为什么需要Kappa系数?------比"一致率"更可靠

在分类任务中,我们常需要评估两个评估者(如医生、标注员)或一个模型与人工标注(ground truth)的一致性。最直观的方法是计算**"一致率"**(即两者分类相同的样本比例)。但这种方法有一个致命缺陷:它无法区分"真实一致"和"随机一致"。

示例:随机一致的影响

假设我们有两个标注员对100个样本进行二分类("猫"/"狗"),其中90个是猫,10个是狗。如果两位标注员都倾向于把所有样本标为"猫"(因为猫更多),那么他们的"一致率"可能高达90%,但实际上他们对"狗"的分类完全不可靠。

此时,Kappa系数通过计算:

- Po(观察一致率):实际一致的比例(如两位标注员都标对"猫"和"狗"的比例);

- Pe(随机一致率):理论上仅凭类别分布应该达成一致的概率(如90%的样本是猫,两位标注员随机猜"猫"的概率是90%×90% + 10%×10% = 82%);

最终给出一个校正后的κ值,反映**"真实一致性"**。

2. Cohen's Kappa的计算与解读

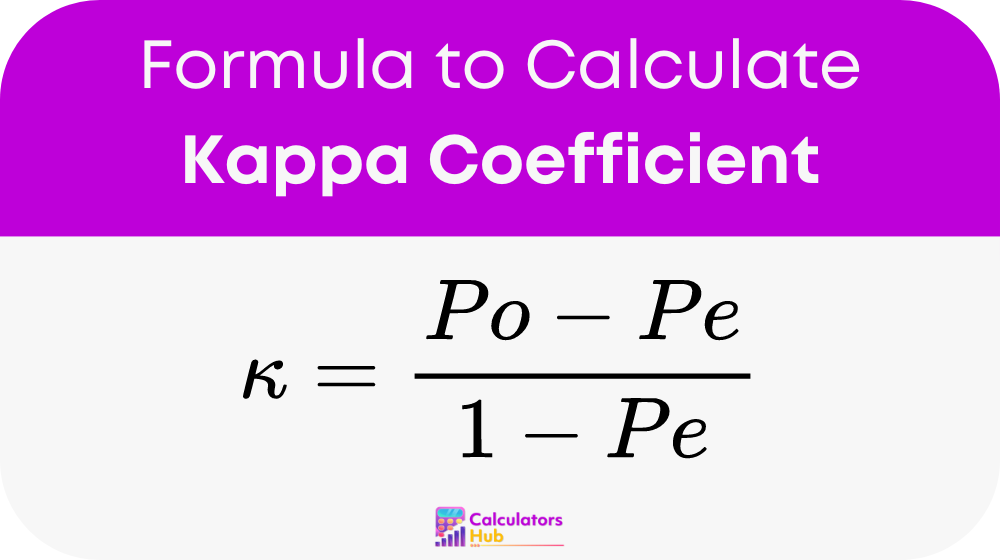

公式

κ=Po−Pe1−Pe κ=\frac{Po−Pe}{1−Pe} κ=1−PePo−Pe

- Po(观察一致率) = 对角线一致样本数 / 总样本数(混淆矩阵主对角线之和 / N);

- Pe(随机一致率) = 各类别行总数×列总数之积的和 / 总样本量²(即"理论上应该一致的概率")。

Kappa值的解读标准(Landis & Koch, 1977)

| κ值范围 | 一致性水平 | 实际意义 |

|---|---|---|

| 0.81--1.00 | 几乎完美一致 | 结果高度可信(如医学诊断、关键NLP标注) |

| 0.61--0.80 | 显著一致 | 适用于大多数任务(如模型评估、常规数据标注) |

| 0.41--0.60 | 中等一致 | 可接受但需改进(如初步标注结果) |

| 0.21--0.40 | 一般一致 | 一致性较弱(需重新校准标注标准) |

| 0.00--0.20 | 轻微一致 | 几乎无实际一致性 |

| < 0 | 低于随机一致 | 评估者分歧严重(需检查标注流程) |

3. 核心作用与应用场景

(1)医学诊断

- 案例 :两位医生对100份病历的"糖尿病"诊断结果进行比对,κ=0.75 → 显著一致,说明诊断标准可靠。

- 意义:确保不同医生的判断一致性,避免误诊。

(2)机器学习模型评估

- 案例 :比较模型预测的"情感倾向"(正面/负面)与人工标注结果,κ=0.65 → 中等偏强一致,模型可用但需优化。

- 意义:比单纯看"准确率"更可靠,尤其适用于类别不平衡数据(如90%正面评论)。

(3)社会科学调查

- 案例 :多个研究员对问卷答案进行编码(如"满意度:高/中/低"),κ=0.50 → 中等一致,需统一编码标准。

(4)自然语言处理(NLP)数据标注

典型案例1:藏文信息处理(参考材料1)

在云藏搜索引擎的藏文数据标注 项目中,研究团队构建了868万词次的藏文语料库,并通过标准化标注体系 (如分词、词性标注)确保数据质量。虽然原文未直接提及Kappa,但这类大规模标注任务通常需要计算标注员间的一致性(如分词边界是否一致),Kappa是核心评估指标之一。

典型案例2:文本分类标注(参考材料3、12)

假设我们让两位标注员对100条新闻文本进行分类("政治/经济/体育"),结果如下:

| 标注员B\标注员A | 政治 | 经济 | 体育 | 总计 |

|---|---|---|---|---|

| 政治 | 30 | 5 | 2 | 37 |

| 经济 | 3 | 25 | 4 | 32 |

| 体育 | 2 | 4 | 20 | 26 |

| 总计 | 35 | 34 | 26 | 95* |

(*注:假设总样本数为95,简化计算)

- Po(观察一致率) = (30 + 25 + 20) / 95 ≈ 0.80

- Pe(随机一致率) = (35×37/95 + 34×32/95 + 26×26/95) / 95 ≈ 0.35 + 0.12 + 0.07 ≈ 0.54

- κ = (0.80 - 0.54) / (1 - 0.54) ≈ 0.57 → 中等偏强一致,说明标注标准较清晰,但仍有优化空间。

NLP中的典型应用:

- 数据标注质量控制:确保不同标注员对"情感倾向""实体识别""文本分类"的判断一致;

- 模型评估:比较模型预测与人工标注的类别一致性(如BERT的文本分类结果);

- 多轮标注校准:当多位标注员结果不一致时,用Kappa分析分歧点并优化指南。

4. 局限性及改进方案

(1)主要问题

- 类别不平衡影响:如果某一类别占比过高(如90%"负面评论"),Kappa可能高估一致性;

- 多分类扩展难 :原始Kappa适用于二分类,多分类需用Fleiss' Kappa (适用于>2个评估者)或加权Kappa(考虑类别顺序);

- 敏感于样本量:小样本时κ值波动较大。

(2)替代方案

- Fleiss' Kappa :用于多个评估者(如10位标注员对同一批数据分类);

- Cohen's Weighted Kappa :适用于有序类别(如"1分-5分"的评分一致性);

- Gwet's AC1:对类别不平衡更鲁棒,适合医学或NLP标注。

5. 总结

Cohen's Kappa系数是评估分类一致性的核心工具,尤其适用于:

✅ 需要校正随机一致的场景(如医学诊断、NLP标注);

✅ 二分类或多分类任务(但多分类需扩展方法);

✅ 数据质量把控(如确保标注员标准统一)。

在**自然语言处理(NLP)**中,Kappa广泛用于:

🔹 数据标注一致性检查(如情感分析、实体识别);

🔹 模型与人工标注的对比评估(如BERT、GPT的分类结果);

🔹 多标注员协作的质量管控(如藏文信息处理、多语言翻译评估)。

未来改进方向:结合加权Kappa、Fleiss' Kappa,或引入深度学习辅助标注(如LLM预标注+人工校验),进一步提升评估可靠性。