Q:要查询的问题

K:不同的解决方法的特征

V:答案

Q,K,V的来源:

普通注意力机制:

K,V:encoder

Q:decoder

自注意力机制:

Q,K,V:本身序列

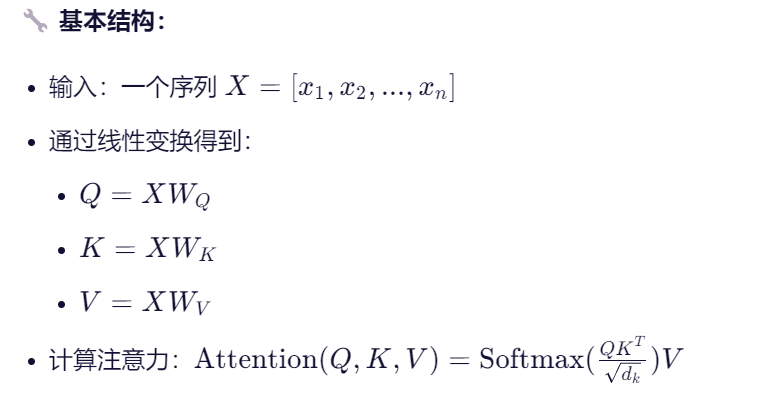

如何提取Q ,K,V?

通过线性层提取,或者说是通过linear,权重矩阵W提取。

如何得到注意力分数:

score:(Q*K的转置)/根号下dk

如何得到注意力权重

softmax(score)

什么是多头注意力机制:

把特征分组

一、注意力机制(Attention Mechanism)

📌 定义:

注意力机制是一种让模型在处理某个信息时,动态地关注输入中更相关的部分的机制。它模仿了人类的注意力行为 ------ 比如你看一张图时,会聚焦在关键区域。

🔧 基本结构(以"Encoder-Decoder Attention"为例):

- Query(查询):来自解码器,表示"我现在在生成什么,我想知道什么"。

- Key(键)和 Value(值):来自编码器,表示"输入中有哪些信息,每个信息是什么"。

- 模型计算 Query 与所有 Key 的相似度,得到注意力权重 ,然后用这些权重对 Value 加权求和,得到一个上下文向量(Context Vector)。

🎯 典型应用场景:

- 机器翻译:Decoder 在生成目标语言单词时,关注源语言句子中相关的词。

- 图像描述生成:生成某个词(如"狗")时,关注图像中狗的区域。

🌰 例子:

翻译 "The cat is on the mat" → "猫在垫子上"

当生成"猫"时,模型会把高注意力权重分配给"The cat"。

✅ 关键词 :跨序列 ,Query 和 Key/Value 来自不同地方。

二、自注意力机制(Self-Attention Mechanism)

📌 定义:

自注意力是注意力机制的一种特例 ,其中 Query、Key、Value 都来自同一个输入序列。也就是说,序列中的每个词都在"关注"序列中的其他词(包括自己)。

🎯 核心作用:

让模型学习序列内部的依赖关系,无论距离多远。比如:

- 在句子 "The cat, which was very lazy, didn't move" 中,模型可以通过自注意力让 "cat" 和 "didn't move" 建立联系。

🌰 例子:

输入句子:"I love deep learning"

自注意力会让:

- "deep" 关注 "learning"

- "I" 关注 "love"

- 每个词都可能关注其他词,形成一个"全连接"的依赖图。

✅ 关键词 :序列内部 ,Q、K、V 来自同一个地方。

三、关键区别总结

| 特性 | 注意力机制(Attention) | 自注意力机制(Self-Attention) |

|---|---|---|

| Query 来源 | 通常是目标序列(如 Decoder 的输出) | 与 Key/Value 相同,来自同一序列 |

| Key/Value 来源 | 通常是源序列(如 Encoder 的输出) | 与 Query 相同,来自同一序列 |

| 作用范围 | 跨序列(如源语言 → 目标语言) | 序列内部(词与词之间的关系) |

| 主要用途 | 实现"对齐"和"信息选择" | 建模长距离依赖、上下文理解 |

| 是否需要掩码 | 通常不需要(但可以有) | Decoder 中需要序列掩码防止看未来 |

| 典型位置 | Decoder 的 Encoder-Decoder Attention 层 | Encoder 和 Decoder 的自注意力层 |

四、形象比喻

-

注意力机制 :

👉 像一个翻译官,一边看中文书(Key/Value),一边写英文作文(Query),时不时抬头看一眼中文原文来决定下一个英文词怎么写。

-

自注意力机制 :

👉 像一个读者在读一句话,他会反复看句子里的不同词,理解它们之间的关系。比如读 "她打他" 时,会思考"她"和"他"是谁,"打"是动词,三者如何关联。

五、在 Transformer 中的应用

| 层 | 使用的注意力类型 | 说明 |

|---|---|---|

| Encoder | 自注意力 | 每个词关注输入序列中所有词 |

| Decoder | 自注意力 + 掩码 | 关注已生成的部分(不能看未来) |

| Decoder | Encoder-Decoder 注意力 | Query 来自 Decoder,Key/Value 来自 Encoder |

🔥 所以,Transformer 的强大,正是源于自注意力 + 注意力的组合。

✅ 一句话总结

注意力机制 是一个通用框架,用于在不同序列之间 选择相关信息;

自注意力机制 是它的特例,用于在同一个序列内部建模词与词之间的依赖关系。

你可以把自注意力看作"自己对自己的注意力",而普通注意力是"我对你的注意力"。

理解这一点,你就掌握了 Transformer 的灵魂!