在机器学习和数据科学领域,处理不平衡数据集是一个常见且具有挑战性的问题。不平衡数据集指的是数据集中不同类别的样本数量存在显著差异,其中某一类别的样本数量远多于其他类别。这种情况在现实世界中比比皆是,例如:

- 股票涨停板(大部分时候不涨停)

- 信用卡欺诈检测(正常交易占比大多)

- 医疗诊断(大多数人是健康的)

当模型面对这些不平衡数据时,它往往会偏向多数类,而忽视少数类 ------ 即使少数类通常是我们更关心的类别(比如欺诈交易或疾病诊断)。

传统的处理方法如随机过采样(简单复制少数类样本)或随机欠采样(删除多数类样本)虽然简单直接,但存在明显缺陷:前者容易导致过拟合,后者则可能丢失重要信息。为了解决这些问题,研究者们开发了多种技术,其中 SMOTE(Synthetic Minority Over-sampling Technique,合成少数类过采样技术)因其有效性和创新性成为处理不平衡数据的主流方法之一。

本文将详细介绍 SMOTE 算法的原理、实现步骤、应用场景、优缺点以及最新发展,并通过实际案例演示其在机器学习中的应用,帮助读者掌握这一重要技术。

SMOTE 算法原理与实现

SMOTE 的基本思想

SMOTE 是一种基于随机过采样算法的改进方案,它通过在少数类样本之间插值来生成新的合成样本,而非简单地复制现有样本。这种方法有效缓解了随机过采样容易产生的模型过拟合问题,使得模型学习到的信息更加泛化 (generalization)。

SMOTE 的核心思想可以概括为:对于每个少数类样本,算法会随机选择其 k 个最近邻,然后在这些邻居之间随机选择一个点,并在这个点和原始点之间的连线上生成新的合成样本。通过这种方式生成的新样本既保留了原始数据的特征关系,又增加了数据的多样性,从而提高了模型的泛化能力。

SMOTE 的数学原理与算法步骤

SMOTE 算法的具体实现步骤如下:

- 确定少数类样本: 首先识别数据集中的少数类样本,即数量较少的类别。

- 计算最近邻: 对于每个少数类样本,使用距离度量(通常是欧氏距离)找到其 k 个最近邻的少数类样本。

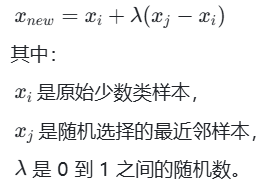

- 生成合成样本: 对于每个少数类样本,随机选择一个最近邻样本,并在这两个样本之间的连线上生成一个新的合成样本。数学上,新样本可以表示为:

这个公式表示在原始样本和其最近邻样本之间的连线上随机选择一个点作为新样本。 - 重复过程: 对所有少数类样本重复上述步骤,直到生成足够数量的合成样本,使数据集达到期望的平衡状态。

SMOTE 的参数与配置

SMOTE 算法有几个关键参数需要配置,这些参数会影响生成样本的质量和算法的效果:

- k_neighbors: 定义了最近邻的数目,默认值通常为 5。它决定了 SMOTE 基于多少个邻居来生成新的合成样本。如果设置过小(如 k=1),则可能导致欠采样的情况;而过大则可能引入噪声。

- sampling_strategy: 控制重采样的策略,可以接受字符串或字典形式输入:

'auto': 默认选项,仅对数量少于多数类一半的类进行上采样。

浮点数: 表示目标比例,例如 0.5 意味着使少数类达到多数类的一半大小。

字典: 明确指定每种类别的期望实例数。 - random_state: 为了确保实验可重复性,可以通过设定随机种子来固定每次运行的结果。这在调试阶段或对比不同方法的效果时尤为重要。

- n_jobs: 指定用于计算的并行作业数,设置为 - 1 表示使用所有可用的处理器,提高计算效率。

SMOTE 与其他过采样方法的比较

| 方法 | 优点 | 缺点 |

|---|---|---|

| 随机过采样 | 简单高效 | 可能导致过拟合,因为只是简单复制现有样本 |

| 随机欠采样 | 减少计算量 | 可能丢失多数类中的重要信息 |

| SMOTE | 生成新的合成样本,减少过拟合风险 | 在高维数据中效果不佳,可能引入类间重叠和噪声 |

随机过采样和欠采样是处理不平衡数据的基础方法,但它们的局限性也很明显。SMOTE 通过生成合成样本而非简单复制,减少了过拟合的风险,同时保留了所有少数类样本的信息。然而,SMOTE 也存在一些缺点,例如可能增加类间重叠和噪声,特别是当少数类样本周围有其他类别的样本时。此外,高维数据中的距离计算可能不准确,影响最近邻的选择,进而影响生成样本的质量。

SMOTE 算法的改进与变种

随着 SMOTE 的广泛应用,研究者们提出了多种改进版本,针对不同的问题和应用场景进行了优化。以下是几种主要的 SMOTE 变种:

边界 SMOTE(Borderline-SMOTE)

Borderline-SMOTE 是针对原始 SMOTE 在类边界处理上的不足而提出的改进算法。该算法首先识别出位于分类边界附近的 "危险" 样本(即容易被错误分类的样本),然后仅对这些边界样本进行过采样。

Borderline-SMOTE 的核心思想是:在分类边界附近的样本对分类器的性能影响更大,因此应该优先对这些样本进行过采样。这种方法可以有效增加用于确定分类边界的少数类样本数量,从而提高分类器的性能。

自适应合成采样(ADASYN)

ADASYN(Adaptive Synthetic Sampling)算法是另一种重要的 SMOTE 变种,它通过自适应地改变不同少数类样本的权重,自动确定每个少数类样本需要合成新样本的数量。

ADASYN 的主要改进在于:它根据样本的困难程度(即样本周围多数类样本的比例)来调整每个少数类样本的权重。样本越难分类(周围多数类样本越多),需要生成的新样本数量就越多。这种方法特别适用于处理分布不均匀的数据集。

安全级 SMOTE(Safe-Level-SMOTE)

Safe-Level-SMOTE(SLSMOTE)是一种考虑最近少数类样本安全级别的过采样技术。该算法在生成合成样本时,会优先考虑安全系数高的少数类样本,使得新合成的样本更加接近安全系数高的样本。

SLSMOTE 的主要优势在于它能够减少生成样本的噪声,特别是在类边界附近的区域。通过引入安全级别的概念,该算法可以生成更加可靠的合成样本,从而提高分类器的性能。

SMOTE 文本(SMOTExT)

SMOTExT 是一种将 SMOTE 思想应用于文本数据的新技术,专门用于处理文本领域中的类别不平衡问题。该方法通过在 BERT-based 嵌入的两个现有示例之间进行插值,然后使用 XRAG 架构将生成的潜在点解码为文本。

SMOTExT 的主要创新点在于:它利用 XRAG 的跨模态检索 - 生成框架,可以有效地将插值向量转换为连贯的文本。初步实验表明,这种方法在少样本设置下的知识蒸馏和数据增强方面显示出强大的潜力。特别值得注意的是,该方法还显示出隐私保护机器学习的前景:在早期实验中,仅在生成数据上训练的模型达到了与在原始数据集上训练的模型相当的性能。

可扩展边界 SMOTE(Expandable Borderline SMOTE)

可扩展边界 SMOTE 是一种新型的过采样方法,专门用于解决类别不平衡问题。该方法结合了边界 SMOTE 的思想和可扩展的边界检测机制,能够更准确地识别和处理位于分类边界附近的样本。

与传统的边界 SMOTE 相比,可扩展边界 SMOTE 能够自适应地调整边界的范围,从而在不同数据集上都能取得较好的效果。这种方法特别适用于处理那些类别边界复杂或不规则的数据集。

SMOTE-CS

SMOTE-CS 是一种基于特征选择紧凑性和可分离性(FS-CS)原则的增强型特征选择算法改进的合成过采样技术。该方法旨在改进 SMOTE 中的噪声问题。

SMOTE-CS 的主要改进在于:它结合了特征选择和过采样技术,通过在生成合成样本之前对特征进行筛选,减少了样本类别之间的重叠率。研究表明,与 SMOTE 的通用版本相比,基于 FS-CS 改进的 SMOTE-CS 方法显著降低了样本类别之间的重叠率,从而提高了分类器的性能。