「【新智元导读】OpenAI 终于官宣了!联手芯片巨头博通下场造 AI 芯片,预计 2029 年底部署 10GW 算力。内部已秘密研发 18 个月,首颗芯片 9 个月后量产,AI 领域的 M1 时刻将至。」

一图看透全球大模型!新智元十周年钜献,2025 ASI 前沿趋势报告 37 页首发

OpenAI 算力的尽头,是自研芯片。

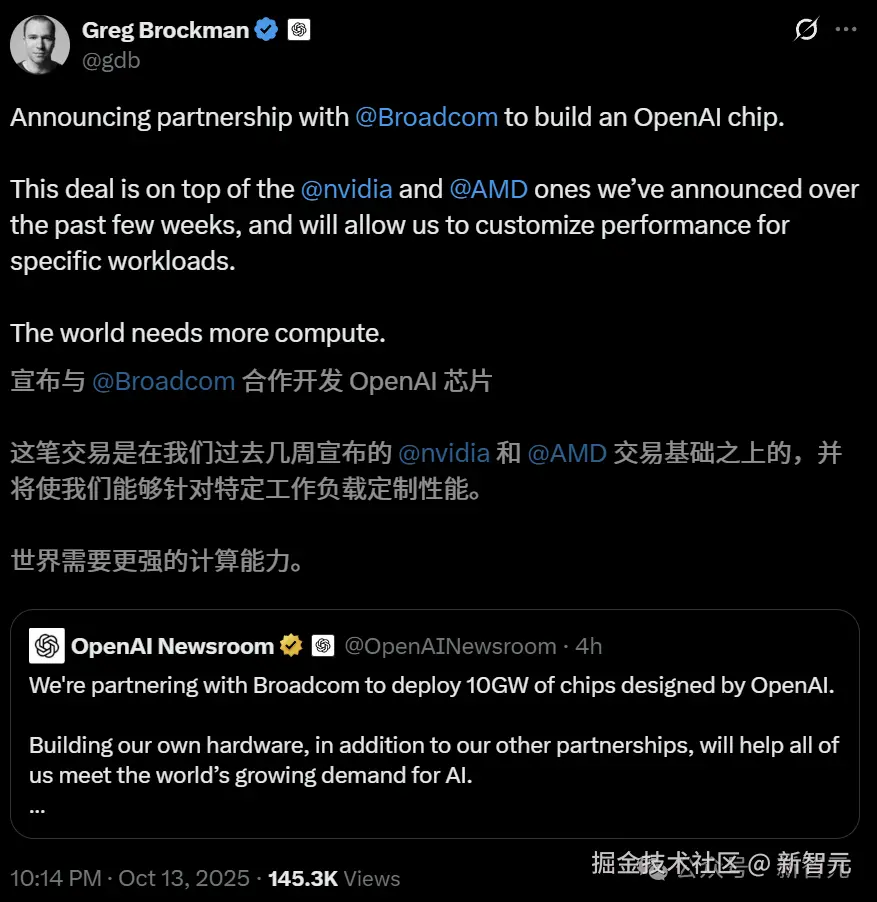

今天,OpenAI 重磅官宣与博通合作,打造新一代 AI 定制加速器,部署规模达 10GW。

10GW=800 多万户美国家庭供电,是胡佛水坝发电量的 5 倍

2026 年下半年,正式开始部署,预计到 2029 年底全部完成。

根据协议,OpenAI 负责设计芯片和系统整体架构,而博通负责机架扩展和互联方案。

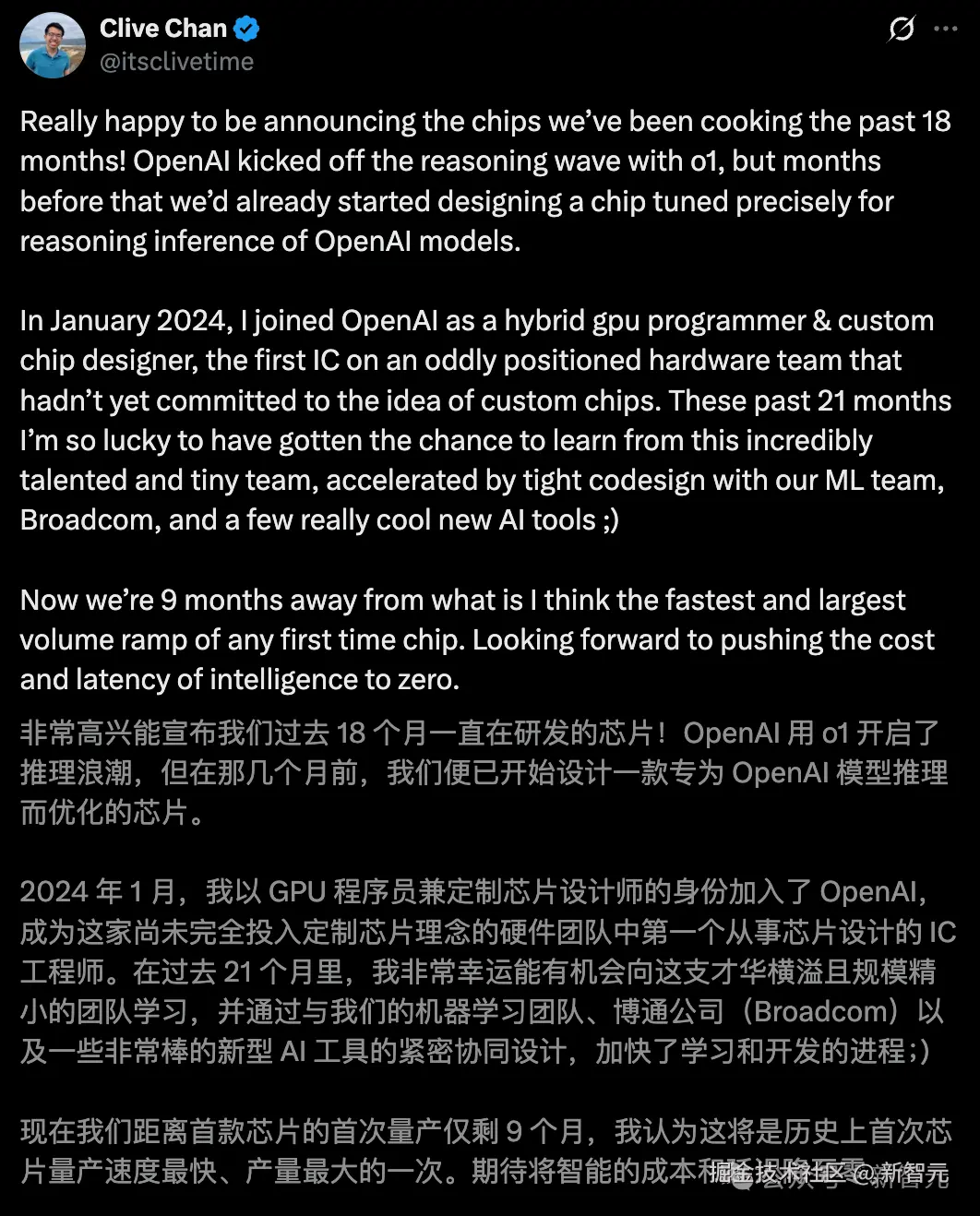

过去一年半,这项芯片「自研计划」已在内部秘密开展,如今,仅剩 9 个月就可以实现量产了!

OpenAI 首颗芯片出世那天,或许堪称整个 AI 行业的「M1 时刻」!

亲手造芯片,等于他们可以把 LLM 需要的特性,直接塞进硬件中,不再受制于英伟达。

结果就是,GPT 模型可以跑的更快、更便宜、更聪明。

在 OpenAI 新一期播客中,奥特曼和总裁 Greg Brockman 同框,共同探讨了 AI 设计芯片与计算的未来。

令人惊呆下巴的是,他们正在用 ChatGPT 设计芯片,并坦言速度更快,效果比人类工程师更好。

AI 设计 AI,真正的闭环实现了!

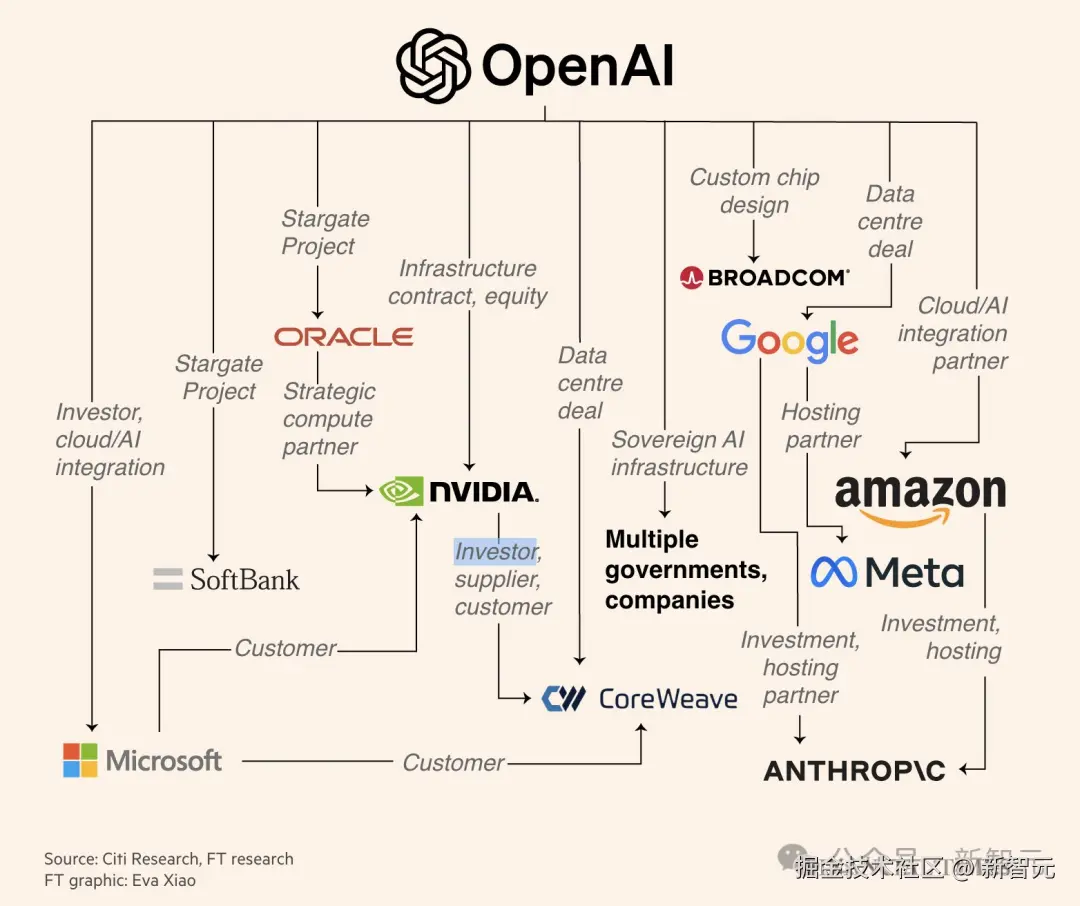

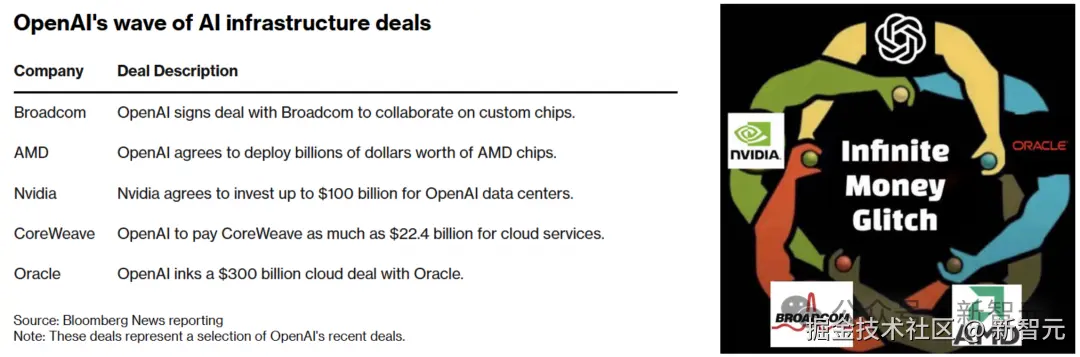

前段时间,OpenAI 一连串高调官宣与甲骨文、CoreWave、英伟达(10GW)、AMD(6GW)建超算的合作。

原来真正的大招,留到了最后。

「光有英伟达不够,OpenAI 下场自研」

消息公布后,博通股价一度大涨近 10%,市值达 1.68 万亿美元。

短短一个月内,OpenAI 已联手三家芯片巨头宣布了重磅交易。

先是 9 月 23 日,英伟斥资 1000 亿美元,要为 OpenAI 部署 10GW 超算系统。

紧接着,OpenAI 于 10 月 6 日官宣,将在未来数年内部署 6GW AMD GPU,同时还购入了 1.6 亿股票。

再加上,此前与云服务巨头甲骨文、CoreWeave 签下的大单,万亿美元算力关系网已悄然形成。

如今,OpenAI 不想仅仅依赖英伟达的 GPU,还要自己造「大脑」。

「自研芯片 + 自研系统 + 自有模型 + 自家软件栈」,这就是闭环生态,可以彻底让 OpenAI 摆脱外部依赖。

正如网友所言,OpenAI 正悄然构建一个星级智能的「神经系统」。

上下滑动查看

「OpenAI「算力觉醒」」

OpenAI 的崛起之路,一直伴随着对「算力」近乎疯狂的渴求。

联合创始人 Greg Brockman 回忆起公司创立之初,他们曾天真地认为,通往通用人工智能(AGI)的道路主要是「想法」和「算法」的比拼。

但现实给了他们最深刻的一课。

「大约在 2017 年,我们发现从扩展(Scaling)中获得了最好的结果,」Greg 说。

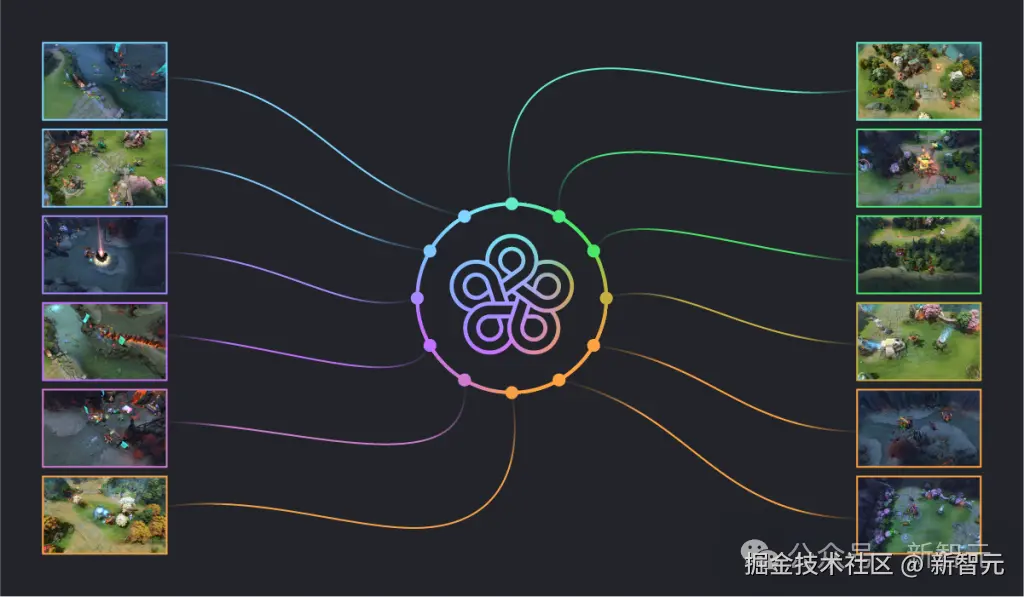

最初的证据来自一个意想不到的领域------电子游戏「Dota2」。

在训练过程中 OpenAI 发现,当你投入的算力翻倍之后,AI 智能体的表现也跟着翻倍。

这个简单的正比关系(俗称大力出奇迹),彻底改变了 OpenAI 的世界观------智能的进化,在很大程度上是用海量计算「喂」出来的。

然而,这种的觉醒也带来了新的烦恼。

庞大的需求虽然让 OpenAI 摇身一变,成为了算力生态系统里的「顶级消费者」,但他们却对上游的「生产工具」(也就是芯片)没有多少话语权。

Greg 坦言,他们曾向许多芯片初创公司提供反馈,描绘自己眼中 AI 未来的形态,但「老实说,很多人根本不听我们的」。

这种眼睁睁看着未来方向,却无法亲自掌舵的挫败感,在 OpenAI 内部埋下了一颗种子:如果世界给不了我们想要的工具,我们为什么不自己造一个?

这个想法在 Sam Altman 看来,则更具战略紧迫性。

当 ChatGPT 的用户数以亿计,当 Sora 的视频生成需求呈指数级增长,他看到了一种永不满足的算力黑洞。

「每当你将效率提升 10 倍,用户的需求往往会增长 20 倍。」Sam Altman 说。

是的,人们对智能的渴望,似乎永无止境。

想要满足全世界对先进智能的需求,依赖通用的 GPU 是不够的。他们需要一把为自己量身定制的「神兵利器」。

于是,在约 18 个月前,OpenAI 开始秘密寻找那个能帮助他们铸造神兵的「铁匠」。

他们的目光,最终落在了博通身上。

「从一颗芯片到一个完整的生态系统」

正如博通 CEO Hock Tan 所说:「如果你们自己做芯片,你们就掌控了自己的命运。」

他认为,OpenAI 代表了生成式 AI 的前沿模型,而要不断攀登通往超级智能(Superintelligence)的高峰,最顶尖、最高效的算力是唯一的阶梯。

「而计算是关键部分,这离不开半导体。」Hock Tan 自信地说,「恕我自夸,我们可能是市面上最好的半导体公司。」

最初的合作始于一个相对具体的点:为 OpenAI 的特定工作负载设计一款定制芯片,或者说 AI 加速器(XPU)。

- OpenAI 拥有对 AI 模型工作方式最深刻的理解,知道在哪里计算是冗余的,在哪里内存带宽是瓶颈。

- 而博通则拥有将这些理解转化为硅片上亿万晶体管的卓越能力。

但很快,双方都意识到,故事远不止于此。

「这些东西已经变得非常复杂,你需要一个整体的解决方案,」Sam Altman 解释道。

一颗强大的芯片,如果被低效的网络、散热或系统架构所拖累,也无法发挥其全部潜力。这就像拥有一台 F1 赛车引擎,却把它装在了一辆家用轿车的底盘上。

好在,博通不仅是顶级的芯片设计师,更是系统架构的大师。

于是,项目从「定制芯片」演变成了「定制完整系统」------从最底层的晶体管蚀刻,到芯片设计,再到机架、网络连接,直至最终输出到用户屏幕上的每一个 Token,整个技术栈将被垂直整合,进行端到端的优化。

这种「从沙子到智能」的垂直整合,其威力是巨大的。

它意味着前所未有的效率提升,最终转化为「更好的性能、更快的模型、更便宜的模型」。

「当 AI 开始设计 AI」

值得一提的是,在这次合作中,有一处颇具未来感的细节:OpenAI 正在用自己的 AI 模型,来辅助设计这款为 AI 服务的芯片。

这听起来像是科幻小说里的情节,但 Greg Brockman 讲述了一个真实发生的故事。

在芯片设计的某个阶段,人类工程师已经对一个组件进行了大量优化。然后,他们把这个设计「喂」给了 OpenAI 的模型,让它继续寻找优化的可能性。

模型会提出它自己的优化方案,并且已经能够实现大幅度的面积缩减。

而且,这些优化方案并非天马行空。

当专家们回头审视时,他们会说:「是的,这个想法在我的待办列表上,但可能排在第 20 位,需要再花一个月才能做到。」

而 AI 做的,便是瞬间探索了人类专家需要耗费大量时间才能触及的可能性。

有趣的是,合作中还出现了一个戏剧性的时刻。

当时,项目面临一个紧迫的截止日期,而 AI 优化程序仍在不断地提出新的改进方案。

「我们面临一个选择,」Greg 回忆道,「是要仔细研究那些优化方案是什么,还是就一直运行到截止日期?」

最终,他们选择了后者,赌了一把 AI 的能力。

这个小插曲,预示着一个全新的设计范式:人类与 AI 智能协同,共同挑战工程极限。

这不仅加速了开发周期,更开启了一个人类设计师或许永远无法独立达到的新境界。

「下一个「人类文明操作系统」」

当 Sam Altman 宣布这个合作的最终目标时,整个谈话的量级被推向了高潮:「我们将从明年年底开始,部署 10 吉瓦由这些系统和我们的芯片组成的机架。」

10 吉瓦(Gigawatts)是什么概念?

一个 1 吉瓦的数据中心,规模「就像一座小城市」。而这次宣布的,是新增 10 吉瓦的算力,这还不包括他们与其他合作伙伴已有的庞大基础设施。

为了更直观地理解,我们可以对比一下:一座大型核电站的输出功率通常在 1-2 吉瓦左右。这相当于 OpenAI 要为 AI 的未来,建设数座专属的「核能级」计算工厂。

对此,Charlie Kawwas 给出了一个更为宏大的定义:「我们正在定义人类文明的下一代操作系统。」

这个「操作系统」的基础设施,其建设规模堪比历史上的任何超级工程------无论是修筑长城、铺设铁路,还是构建互联网。

Hock Tan 补充道,这最终将成为一项关键的公共事业,不是为一万家企业,而是为全球 80 亿人服务。

「我不知道当时修建长城占全球 GDP 的多大比例,」Altman 沉思道,「但你可以说,这是人类历史上最庞大的联合工业项目。」

这不仅仅是关于芯片,就像国家公路项目不只是为了卖沥青,铁路建设也不只是关于钢铁。

真正重要的是,在这庞大的基础设施之上,将诞生怎样的新可能。

「通往算力充裕的未来」

那么,这 10 吉瓦的算力,以及未来可能更多的算力,又将为世界带来什么呢?

Greg Brockman 描绘了一个诱人的场景。

目前,像 ChatGPT Pulse 这样能在后台 24/7 为用户个性化工作的智能体功能,由于算力限制,只能提供给付费用户。

「理想情况下,」他说,「每个人都应该有一个 AI 智能体在幕后为他们运行...... 这意味着有 100 亿人。我们离能够制造 100 亿颗芯片还差得很远。」

这个看似遥远的目标,正是这次合作的北极星。他们要做的,就是将世界从「算力稀缺」推向「算力充裕」。

Sam Altman 用一个具体的例子说明了这种演进的力量。

当 ChatGPT 刚能写一点代码时,人们需要痛苦地复制粘贴。当模型和体验变得更好,Copilot 诞生了,它能以更高的能力水平完成几个小时的工作,需求随之爆炸。

可以想象,当下一代模型能以顶尖工程师的水平完成几天、甚至几周的工作时,那将释放多大的经济价值和创造力?

「智能是经济增长的根本驱动力,」Greg 总结道,「我们用 AI 所做的,实际上是带来更多的智能,并放大每个人的智能。」

而要实现这一点,10 吉瓦甚至都只是个开始。「与我们需要达到的目标相比,这只是沧海一粟,」Greg 说。

Sam Altman 笑着接话:「但这滴水可不小......」

「巨轮启航」

这次合作的初步成果,预计将在明年年底开始部署,并在接下来的三年里迅速扩展。

这不是一个轻松的任务。

Greg Brockman 表示,从设计一款全新芯片到大规模交付一个能端到端工作的系统,「工作量是天文数字」。

但对于这四位站在时代前沿的领导者来说,这艘巨轮已经启航。

他们不仅在构建硬件,更是在为 OpenAI 的使命------「确保通用人工智能造福全人类」------铺设最坚实的基石。

当博通的先进封装技术能将多个计算单元在三维空间中堆叠,当光学技术被直接集成到芯片上,我们看到的将是计算能力以每 6 到 12 个月翻一番的速度持续狂飙。

从 OpenAI 早期的 2 兆瓦集群,到如今迈向 30 吉瓦的宏伟蓝图,这个故事的核心从未改变:对更强大智能的无限追求。

正如 Sam Altman 所说,他们所做的一切,最终都可以简化为一件事------「从每一瓦特电力中,榨取出最多的智能。」

而当这种智能变得前所未有地强大和廉价时,它将被全世界超快地吸收,并找到我们今天难以想象的新用途。

一个由思想驱动、由算力赋能的新时代,正在被这群人亲手铸造。

参考资料: