通常情况下,Dify检索知识库在秒级别,通常需要1-2秒,而部署在T4 GPU上则可以达到毫秒级别,通常在几十毫秒。

部署配置说明一下,这很关键,直接关系到是否可以正常访问milvus。

在.env环境变量中,使用默认的配置,一直连接失败,如:MILVUS_URI=http://host.docker.internal:19530

应该修改为宿主服务的IP,比如:MILVUS_URI=http://172.18.0.8:19530

另外,默认的验证false始终无效,还是要验证MILVUS_USER和MILVUS_PASSWORD,我们设置为默认的值,如:root和Milvus。

docker-compose.yaml配置中,使用的是milvusdb/milvus:v2.5.0-beta-gpu。

XML

milvus-standalone:

container_name: milvus-standalone

image: milvusdb/milvus:v2.5.0-beta-gpu

profiles:

- milvus

command: [ 'milvus', 'run', 'standalone' ]

environment:

ETCD_ENDPOINTS: ${ETCD_ENDPOINTS:-etcd:2379}

MINIO_ADDRESS: ${MINIO_ADDRESS:-minio:9000}

gpu.enalbe: "true"

gpu.device_ids: "0"

gpu.bulid_index_resouces: "16GB"

gpu.search_resources: "16GB"

NVIDIA_VISIBLE_DEVICES: 0

volumes:

- ./volumes/milvus/milvus:/var/lib/milvus

healthcheck:

test: [ 'CMD', 'curl', '-f', 'http://localhost:9091/healthz' ]

interval: 30s

start_period: 90s

timeout: 20s

retries: 3

depends_on:

- etcd

- minio

ports:

- 19530:19530

- 9091:9091

runtime: nvidia

networks:

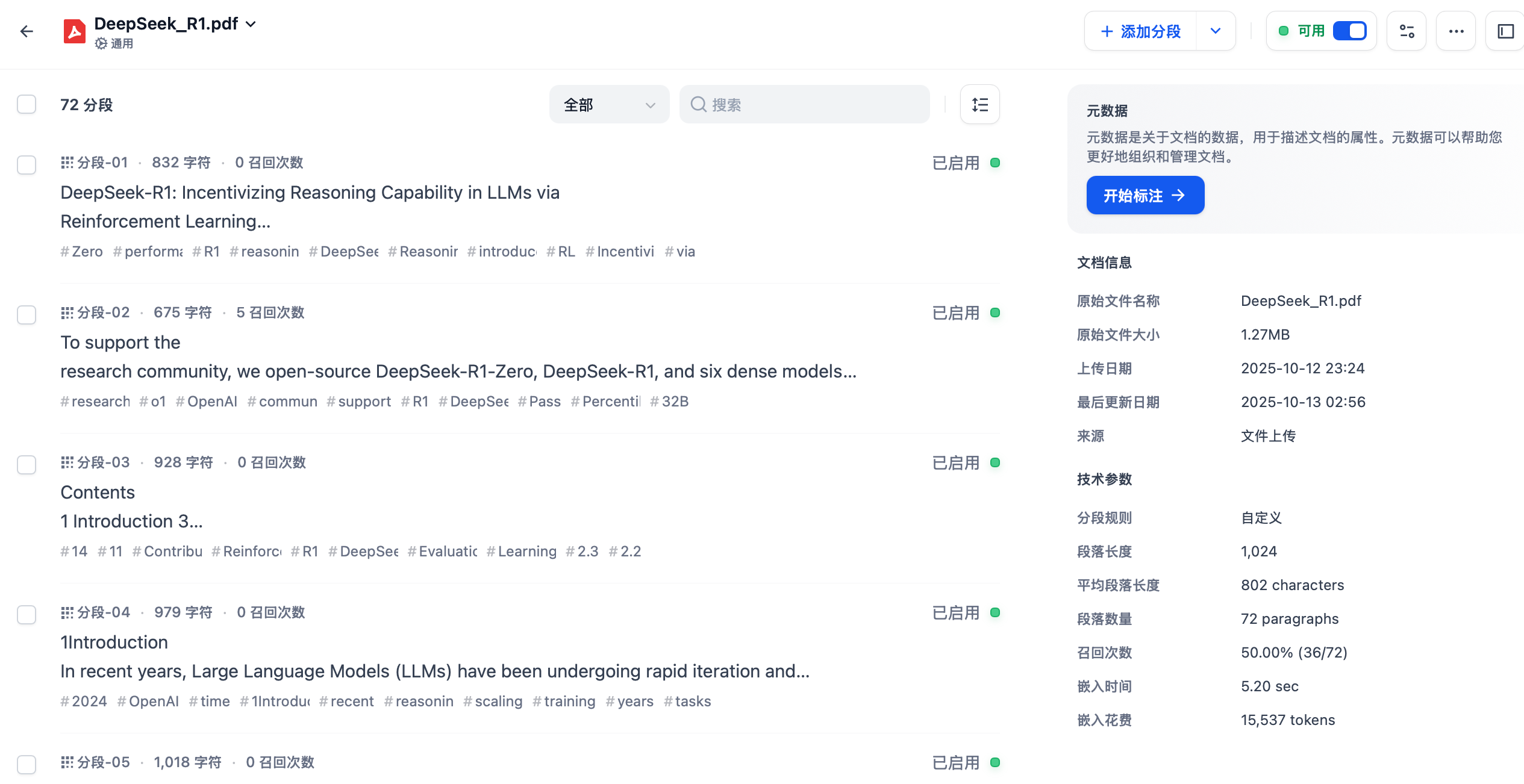

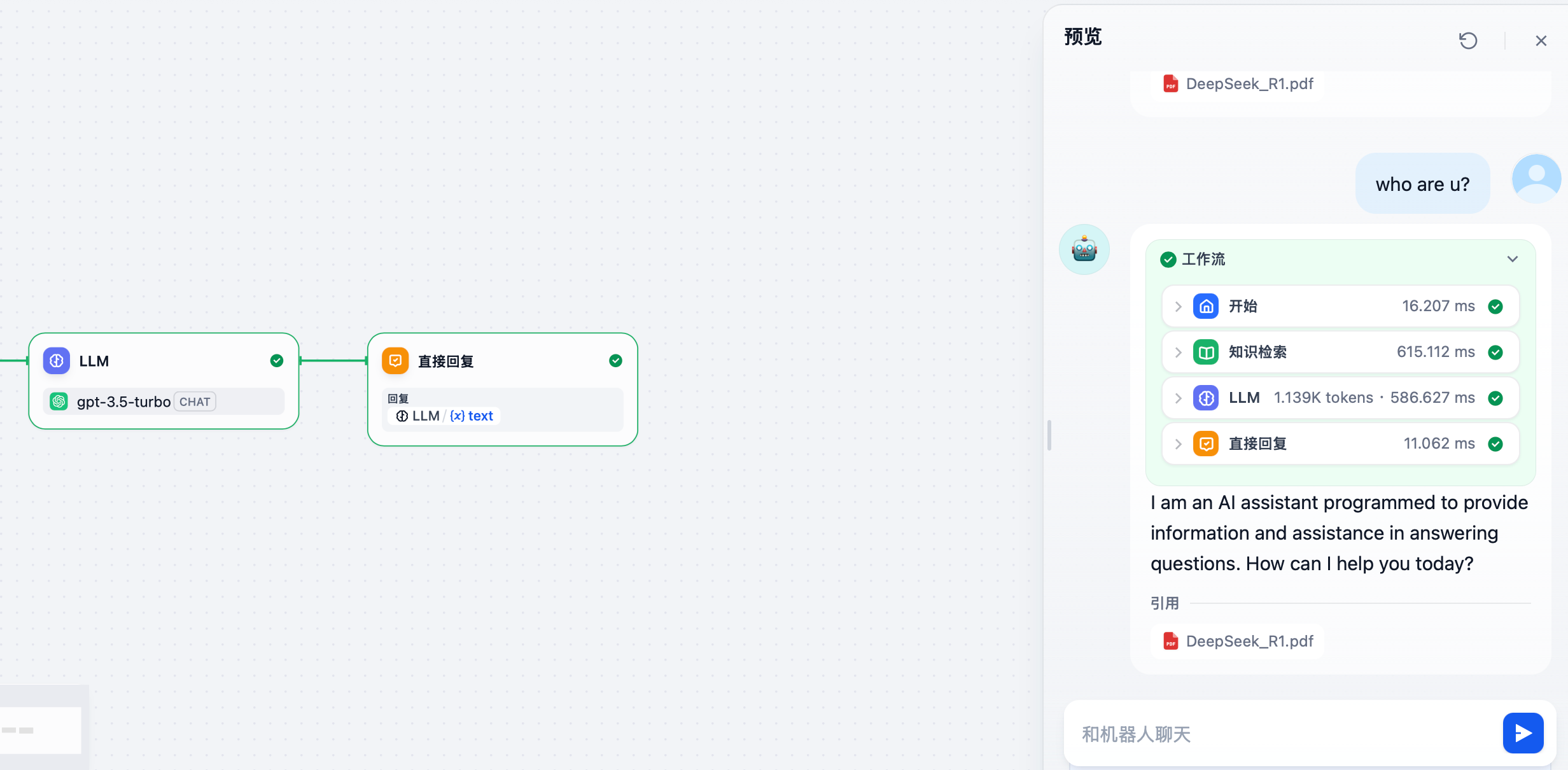

- milvus使用DeepSeek-R1.pdf作为知识库文件进行验证。

创建一个RAG测试工作流,检索topk=7。

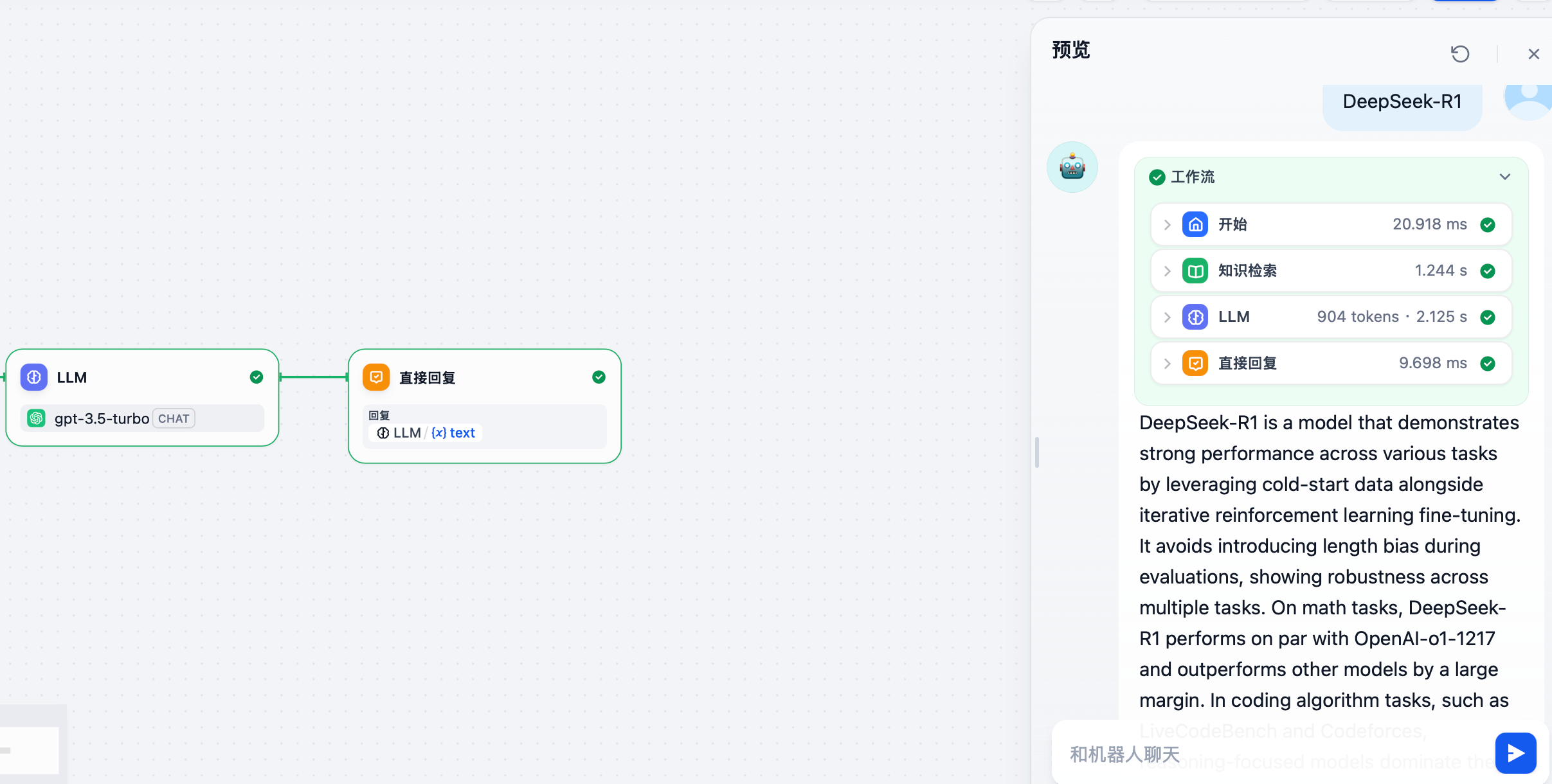

测试一:DeepSeek-R1

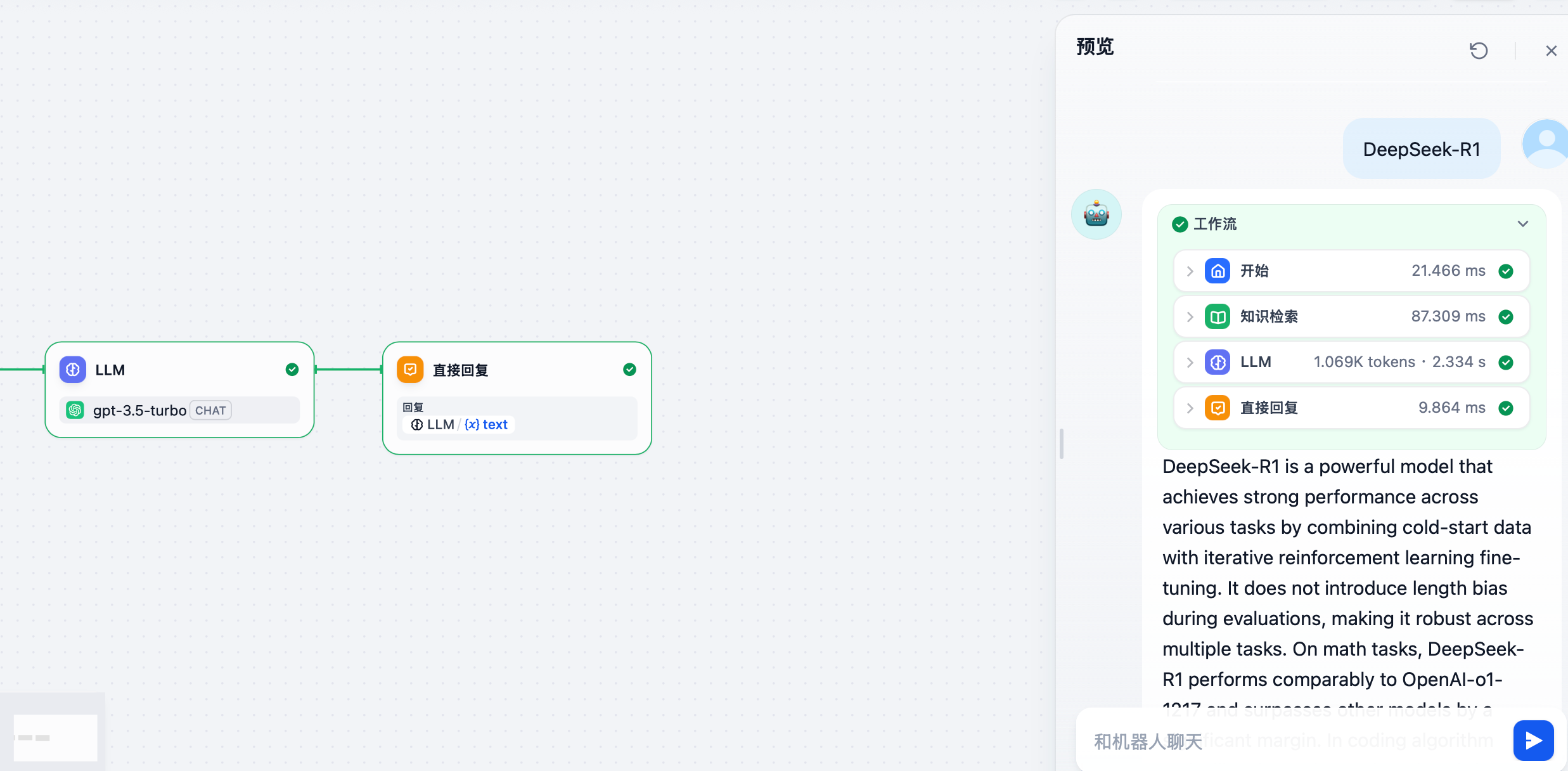

测试二:DeepSeek-R1

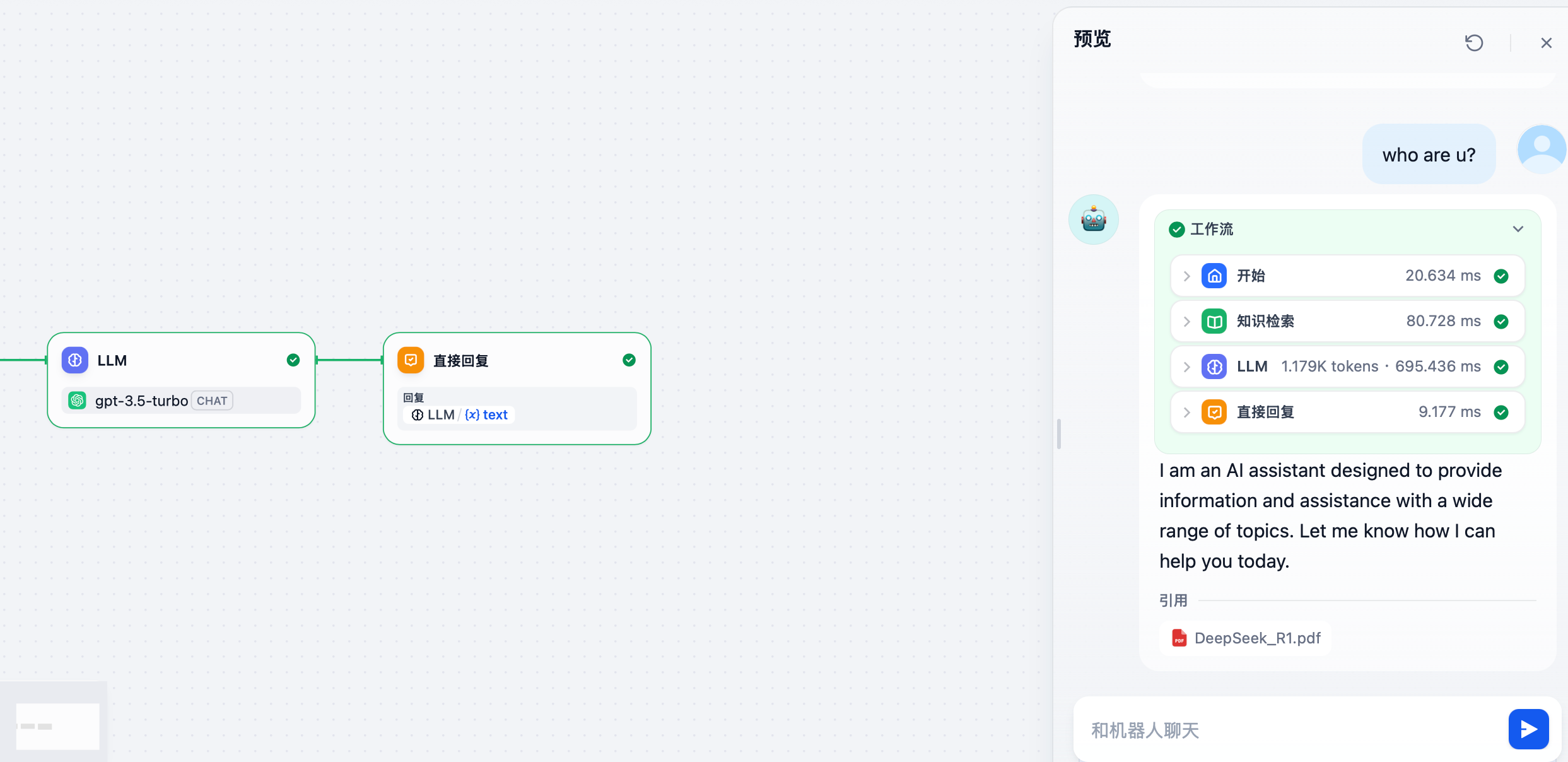

测试三:who are u?

测试四:who are u?